ChatGPT三问:是什么、从哪来、去往哪?

©PaperWeekly 原创 · 作者 | 张燚钧

单位 | 中国移动云能力中心

研究方向 | 预训练大模型

ChatGPT 热潮已经持续月余,目前热度依然不减。根据最新的消息,ChatGPT 的升级版 GPT-4 也已蓄势待发。回首 ChatGPT 的这波热潮,ChatGPT 是什么(定义、能力)、从哪来(如何发展)、去往哪(给行业带来哪些影响)。本文围绕这三点,力求将这几个问题阐述清楚。最后也带来这波热潮的相关思考,与大家分享。

ChatGPT是什么

首先介绍一下 ChatGPT 是什么。

ChatGPT 是人工智能研究机构 OpenAI 在 2022 年 11 月 30 日发布的聊天机器人程序,是一个能够进行连续对话、综合上下文内容进行交流的自然语言处理(NLP)模型。同时能够进行信息检索、写作辅助、问题解答、代码生成等多项工作。

ChatGPT 的全称是 Chat Generative Pre-trained Transformer。是一种可以用于聊天的生成式预训练 Transformer。这里的 Transformer 是目前大模型中的基础结构。可以理解为 ChatGPT 是一个用于聊天的预训练语言大模型。

▲ 图1 ChatGPT界面

▲ 图2 Transformer中的解码器(ChatGPT的基础结构)

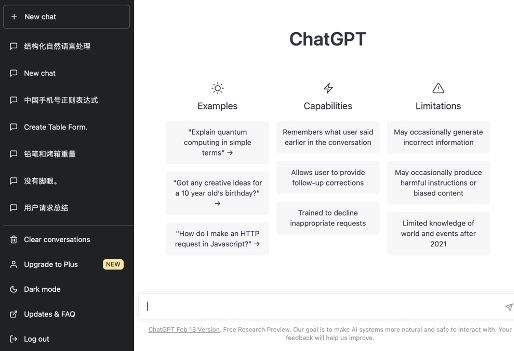

1.1 ChatGPT的能力之信息检索

ChatGPT 可以做信息检索,比如,你可以问她是否了解中国移动云能力中心,他会介绍中国移动云能力中心的主要业务内容;你可以问她 2018 年世界杯的世界杯冠军是哪个国家。

▲ 图3 ChatGPT进行信息检索

1.2 ChatGPT的能力之推理(Excel为例)

ChatGPT 具有超越以往的对话机器人的表现,除了传统的信息检索能力之外,也因为她还具备一定的推理能力。我们以常见的 Excel 处理为例。

首先可以让她生成一个虚拟的信息表格。包含姓名、年龄、出生日期、毕业学校、工作地点。

▲ 图4 ChatGPT处理表格

我要求她写一个 Excel 函数来查找出出生日期在 1996 年之前的人的工作地点。

▲ 图5 ChatGPT函数处理Excel

她会直接告诉你 Excel 函数的写法和适用的情境。而且对函数中的内容进行解释。Office 系列软件也支持 VBA 语言编程。这里你可以进一步要求她,用 VBA 语言来编写上面这个函数。

▲ 图6 ChatGPT将函数转换为VBA编程语言

同时可以看到,函数是对每一部分都加入了中文注释,便于理解、后续修改。

最后她还会给出函数的使用建议和适用情境。

下面再以 Python 编程为例:

要求她写一个匹配中国手机号码格式的 Python 正则化表达式:

▲ 图7 ChatGPT进行Python编程

她不仅能够给出中国手机号码的匹配,而且还考虑到了如果需要匹配其他国家的电话号码,需要修改哪些内容。

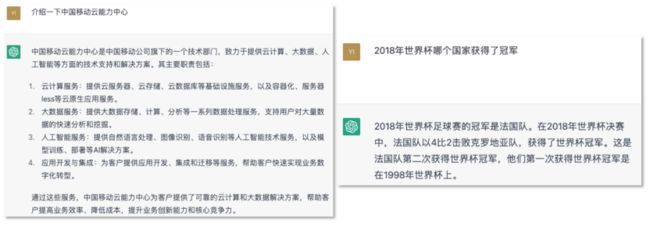

1.3 ChatGPT的能力之写作辅助

ChatGPT 还有一个功能是进行写作辅助,比如你让她写一部分关于结构化研究相关工作介绍

▲ 图8 ChatGPT内容生成

她可以把 NLP 中几个主流的研究方向都列举出来。

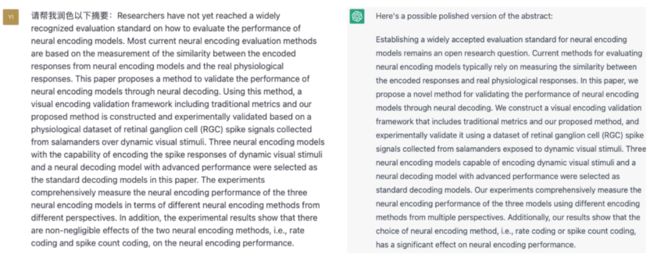

同时也对润色进行了测试。根据 ChatGPT 润色的效果,我们发现 ChatGPT 的修改幅度不会特别大,不会改变原有的专业描述(因为训练语料的原因,ChatGPT 对学术专业领域的知识不是很擅长)。相比之下,目前的一些 AI 写作工具,会出现“为了修改而修改”的现象,反而破坏了原文本的严谨描述。

▲ 图9 ChatGPT文本润色

ChatGPT从哪来?

2.1 ChatGPT如何诞生

促成 ChatGPT 诞生的因素有很多。这里笔者挑选其中认为最重要的两个因素:一个机构:OpenAI 和一个人:Ilya Sutskever。

OpenAI:

OpenAI 于 2015 年由 Alon Mask、PayPal 联合创始人 Peter Thiel、美国科技孵化器 Y combinator 总裁 Samuel Altman 等人联合创立。其成立目的是:通过与其他机构研究者的“自由合作”,向公众开放专利和研究成果,促进人类AI技术的发展。

▲ 图10 OpenAI发展历程

2018 年,OpenAI 研发的 Five 人工智能选手,在 Dota2 游戏中战胜人类选手。同年,OpenAI 发布了 GPT-1。2019 年,微软向 OpenAI 投资 10 亿美元,获得 OpenAI 技术的商业化授权。2020 年 OpenAI 发布 OpenAI API,通过对外提供 AI 能力开始进行商业化运作。2022 年 11 月 30 日,OpenAI 发布 ChatGPT,1 月中旬微软向 OpenAI 追加 100 亿美元投资,2 月 8 日发布集成了 ChatGPT 的 new Bing 新一代搜索引擎。

Ilya Sutskever:

▲ 图11 Ilya Sutskever

Ilya 是 OpenAI 的联合创始人和首席科学家。正是在他的领导下,OpenAI 在开发尖端技术和推动人工智能领域的发展方面取得了重大进展。Ilya 早年师从深度学习泰斗 Geoffery Hinton。2011 年就跟导师合作构想通用人工智能(Artificial General Intelligence, AGI)。2012 年作为共同作者发表了深度学习领域的开创性工作 AlexNet。

2013 年加入谷歌。谷歌作为一个大公司,在 AI 研究领域趋向于保守的作风逐渐让 Ilya 失去吸引力。2015 年 Ilya 拒绝了谷歌开出的三倍薪资,毅然加入刚创立的 OpenAI,为人类实现 AGI 这个愿景而奋斗。在 Ilya 的带领下,OpenAI 相继在 2018、19、20 年迭代研发 GPT-1、2、3,最终2022年发布了 ChatGPT,惊艳了世界。

2.2 ChatGPT进化史

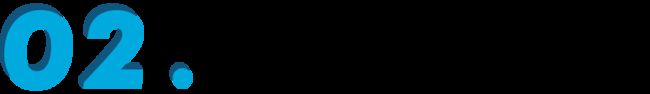

▲ 图12 ChatGPT技术演进

ChatGPT 是由 GPT-1 逐步发展而来。GPT 系列模型的参数量越来越大,以数量级增长,规模由 GPT-1 的 1.17 亿参数,GPT-2 的 15 亿参数,逐步发展到 GPT-3 的 1750 亿参数。而 ChatGPT 可以视为 GPT-3.5。GPT 系列模型属于生成式预训练大模型,其技术范式不同于另一种较为流行的 BERT 语言模型。BERT 语言模型采用的是“预训练+微调”的技术范式。

2.3 ChatGPT核心技术

从自然语言处理的 AI 技术范式演进上来看,2010 年前可以视为传统机器学习时代。2013 年后基于深度神经网络的 NLP 技术开始流行,这个时期出现了以循环神经网络为代表的深度语言模型。2017 年谷歌团队发表论文《Attention is all you need》,奠定了现在大模型的基础模块 Transformer。2018 年 BERT 和 GPT 预训练语言大模型相继发布,大模型技术萌芽。随后几年尤其是 2020 年后,国内外各种预训练大模型相继迭代发布,大模型技术迎来高潮。

ChatGPT 涉及几项关键技术:

● 超大规模预训练模型

Scaling law:大模型研究人员发现,模型能力随着模型参数的对数级增长而增强,只有足够大(大于600 亿参数)的模型才能涌现推理能力。

● Prompt/Instruction learning

各种自然语言任务在 ChatGPT 中统一为 Prompt 的形式;通过 Instruction learning 等方式提高模型零样本任务处理能力。

● 思维链(Chain of Though)

研究发现,通过使用代码数据进行训练,语言模型出现了推理能力。这可能是因为代码实现一般都带有逻辑性(包括代码注释)。模型学到了代码的逻辑处理问题的能力。

● RLHF(Reinforcement Learning from Human Feedback)

ChatGPT 相对 GPT-3 模型的一个能力提升点,就是对话的友好性。研究人员利用人类对答案的排序标注,将这种“人类偏好”通过强化学习的方式灌输到 ChatGPT 中,使得模型的输出更加友好、安全。

2.4 ChatGPT训练过程

▲ 图13 ChatGPT主要训练流程

ChatGPT 的训练工程非常复杂,目前也没有公布详细的步骤。在 OpenAI 公开的论文中,ChatGPT 的训练主要由三个步骤,第一部分,先使用大量数据预训练一个有监督的微调模型,第二步,标注人员按照人类的偏好将同一问题的不同答案排序,然后使用这些数据训练出一个具有人类偏好的奖励模型。

第三步,由监督学习初始化 PPO 模型,使用奖励模型对模型的输出进行打分。再将结果反馈到模型中,进一步优化,最终得到 ChatGPT。

ChatGPT去往哪

3.1 ChatGPT的局限

▲ 图14 信息准确性不足

ChatGPT 目前的信息准确性还不足,比如还是之前的世界杯场景。如果我们紧接着强调:“不,2018 年就是德国队获得了冠军”(给模型灌输错误事实),那么模型会否认自己之前的正确认知,按照提问者的倾向去回答问题。

▲ 图15 信息滞后

ChatGPT 的知识滞后。ChatGPT 中最新的知识是截止于 2021 年 9 月。而目前更新 ChatGPT 模型的算力成本很高,模型本身保证知识的实时性很难。目前一种解决方案是类似 New Bing 的机制。New Bing 应该是将互联网上检索到的信息,通过 ChatGPT 归纳总结,形成易于理解的答案回复给提问者。

ChatGPT 还有一些其他局限。例如,数据安全性问题:ChatGPT 目前可以做一些表格分析、代码生成工作。而很多场景下,此类数据是敏感信息,不允许输入到公开的第三方模型中去。

可解释性问题:ChatGPT 没有规避对深度学习时代就存在的可解释性问题。ChatGPT 生成的答案,其来源依据无法追溯。ChatGPT 本身易受提问者提问内容的影响,特殊情况下会生成一些违规答案。目前微软通过限制一次对话的提问次数,来强行规避这种问题。训练成本、运营成本高:ChatGPT 当前训练成本、运营成本是普通企业无法承受的,未来类 ChatGPT 技术如果要推广,必须降低成本。

3.2 ChatGPT的影响

▲ 图16 ChatGPT应用商业落地

从国际行业巨头的动作看,微软宣布旗下Bing搜索引擎、Office套件全系接入ChatGPT,其云服务Azure为OpenAI独家供应商。亚马逊投资对话大模型初创公司,计划将类ChatGPT机器人接入到自己的云服务平台AWS,提供运维、客服咨询服务。一系列基于文本生成技术的AI产品涌现出来,其中一些获得了巨大的成功。以文本生成服务的初创公司Jasper AI为例,2021年1月上线产品第一个版本,2022年10月融资1.25亿美元,2022年收入7500万美元。

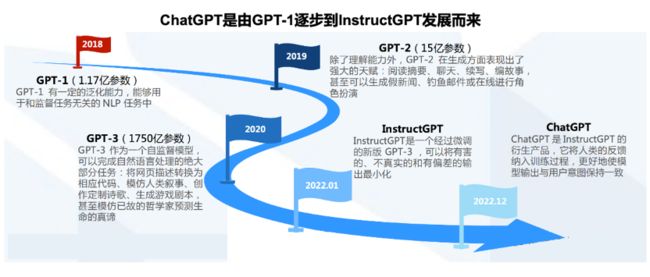

▲ 图17 国内巨头ChatGPT布局

国内行业巨头也纷纷作出了反应。主要互联网巨头宣布在此赛道上布局,国内版 ChatGPT 呼之欲出。

由于工作属性,笔者对 ChatGPT 在算力和云厂商方面的影响格外关注。ChatGPT 带动了算力需求的又一波高潮。据估算,ChatGPT 的运营成本高达 889 万美元每月。不考虑调试,单次训练 ChatGPT 的成本高达 460 万美元。

如果企业私有部署类 ChatGPT 方案,使用 16 张 40GB 显存的 A100 显卡,单次提问响应高达 10 秒。如果将内存提升到 80GB,那么响应时间可以缩短到几百毫秒。

对于中小企业来说,即使是勉强可接受的问答性能,私有部署的成本开支都难以承受。2 月 17 日,OpenAI 推出私有模型运行平台 Foundry,可以私有部署 ChatGPT 实例,预估价格为 26 万美元每年。未来 ChatGPT 的私有部署包括国内类 ChatGPT 产品,都需要云端算力来支撑。

▲ 图18 ChatGPT运营成本高昂

ChatGPT 将大模型研发的入门门槛提到了非常高的水平。目前行业巨头已经储备了相当的算力,大模型生态逐步形成。在国内,能够进行大模型研究的机构屈指可数,除了头部企业,只有少数政府支持、自有算力的研究机构可以参与进来。

▲ 图19 大模型算力生态、平台逐步形成

ChatGPT带来的几点思考

OpenAI为什么成功

OpenAI 的成功并不是一蹴而就的,经过了漫长的默默投入和技术坚持。即使是现在,互联网上也能够检索到对 GPT-3 模型公测时的吐槽。OpenAI 在 NLP 大模型领域,坚持 GPT 的生成式预训练大模型范式,持续迭代了数年。而初代 GPT 在 NLP 基准任务上的性能,并没有超过 BERT 模型。

很多国内研究者就转而投向 BERT 模型的“预训练+微调”范式,放弃了 GPT 的研究路线。Ilya 放弃数百万美元年薪,毅然加入到当时没有任何商业收入的 OpenAI,一些大牛在 OpenAI 创始时加入,中途又因为各种因素离开。Ilya 对技术的执着和信仰令人钦佩。

▲ 图20 网络上对GPT-3效果的吐槽

国内ChatGPT热潮的滞后性

▲ 图21 国内外ChatGPT热潮时间点

从谷歌指数和百度指数上来看,国际上 ChatGPT 自 2022 年 11 月 30 日发布始,热度持续攀升。而 ChatGPT 在国内掀起热潮,主要是在 1 月份微软向 OpenAI 投资 100 亿美元,发布 New Bing,谷歌紧急跟进等资本动作、巨头新闻的时间点开始。国内对新技术的敏感性有待提高。

人工智能时代的我们

近年来人工智能领域的突破,尤其是以大模型技术为代表的通用人工智能的技术落地,让人看到了人工智能技术在我们这一世代取得前所未有的进展。人工智能取代人类绝非痴人说梦。但是随着人工智能技术在越来越多的领域得到普及,我们要注意保持思考的习惯。人工智能应该是辅助、拓展,而不是对我们思考能力的取代。

注:文章整理自笔者在移动云内部技术分享报告,有删改。

更多阅读

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·