GPT-4掀起智能革命浪潮,AI风口下将涌现哪些新机遇?

本文已同步发表至公众号:https://mp.weixin.qq.com/s/kTMhMZQ-nfIbbeeXLnDeyA

编辑:AGI之心

3 月 15 日,OpenAI 发布 GPT-4 多模态大模型,支持文本和图像输入,相比前段时间大火的ChatGPT在字数上限和回答准确度等各方面实现了巨大提升!

正如蒸汽机带领人们进入蒸汽时代,发电机带领人们进入电气时代,计算机带领人们进入信息时代,而以GPT为代表的LLM已经将人们悄然过渡到真正的智能时代,赋能各行各业,这将对我们的生活以及生产方式产生革命性的影响。

本文将直击GPT-4发布,并从以下四点对该模型进行深度介绍,助力大家对GPT-4模型有一个全面的认识。

GPT-4有哪些技术上的优化和突破

GPT-4将带来哪些新的产业应用方向可能性?

GPT-4的到来,会开创哪些新的研究方向?

如何使用GPT-4?

GPT-4有哪些技术上的优化和突破

PDF: https://cdn.openai.com/papers/gpt-4.pdf

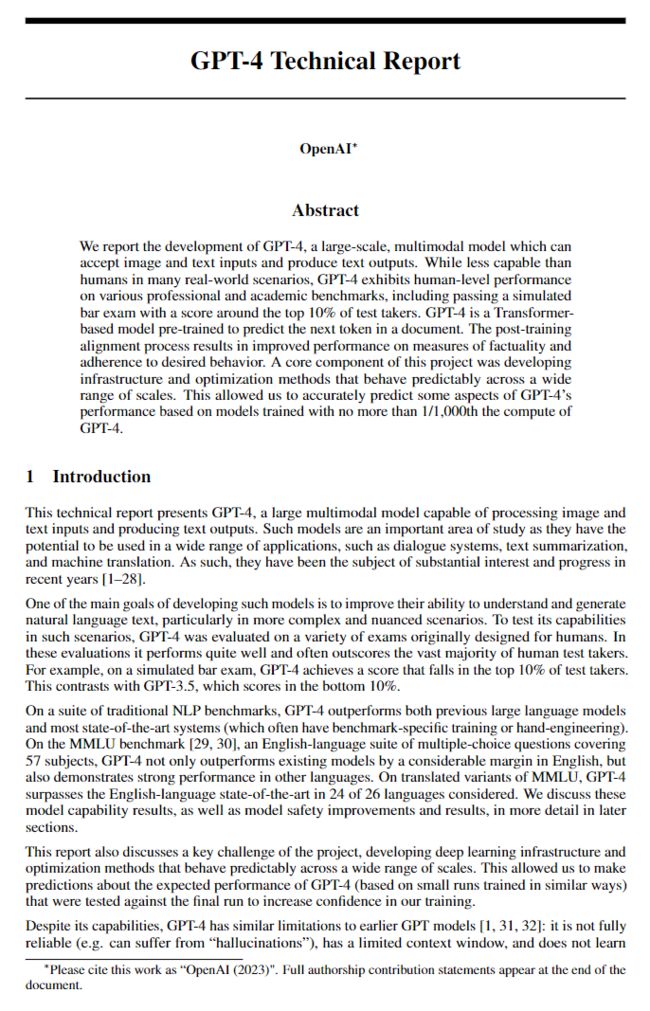

其实OpenAI在发布GPT-4时,就做好了充足的准备资料向观众呈现,其内容量极度爆炸:首先是一篇署名OpenAI的98页的《GPT-4 Technical Report》(PDF见上文链接),然后是一个60页的《View system card》,也给了ChatGPT Plus抢先体验GPT-4的机会《Try on ChatGPT Plus》,同时还有API的《Join API waitlist》,一个震撼的demo视频《Rewatch developer demo livestream》,和一个评估OpenAI模型的全新框架《Contribute OpenAI Eval》。但这些加起来快200页的东西,居然没透露什么技术细节……果真是「CloseAI」无疑 [1]

截图让大家感受下这篇高达98页对GPT-4模型进行介绍的Paper《GPT-4 Technical Report》:

GPT-4 的性能已经逼近人类的水平,并可以在相关的模拟考试中获得前 10% 的成绩。相比ChatGPT这种只能单文本输入的形式,GPT-4接受多模态信息(文本信息 & 图片信息)的输入,并输出更可靠的文本信息。所以GPT-4从单模态过渡到了多模态,并输出的文本内容将更加可信。

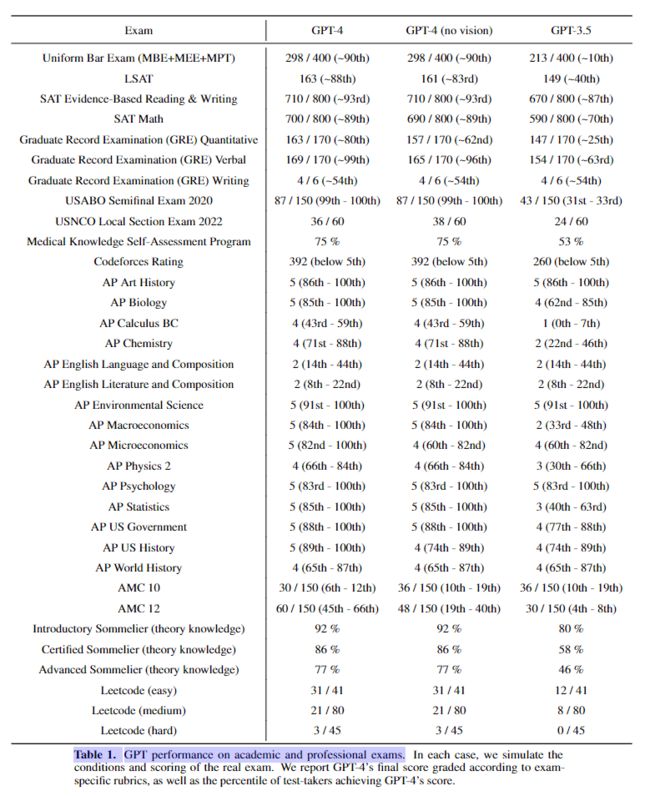

下面带大家看几组数据,感受一下相比于ChartGPT所依托的GPT-3.5,它实现了哪些技术突破和具备哪些能力呢?

学科竞赛能力 & 考试能力 & 编程能力

GPT-4 除了多模态以外,它的核心点是:相比 GPT-3.5,如果只是常规的交流,那估计没太大差,但是如果说遇到非常复杂的指令,GPT-4 的理解能力和创造力远超3.5。OpenAI 做了一大堆实验,来向大家展示 GPT-4 比 ChartGPT 所依赖的GPT-3.5简直强太多太多,咱们直接看下图:

拿GPT-4与GPT3.5做各种学术竞赛和考试得分实验对比

好家伙,连Leetcode(easy,medium,hard)都做上了,相比GPT-3.5,GPT-4在刷Leetcode的easy,medium和hard题目上的准确度都有了极大的提高,至少50%吧(这简直就是程序员强有力的代码代写福音啊!!!)

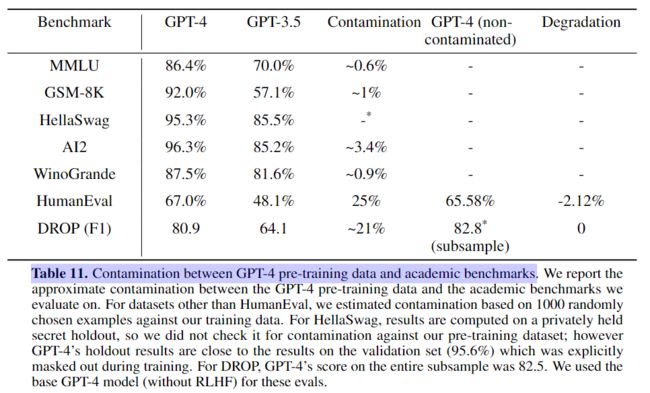

NLP传统任务也给你撸一遍,上来就比GPT-3.5高出十几个点,MMLU打到这水平让人怎么顶。。

GPT-4与GPT3.5在各种NLP学术竞赛上的表现

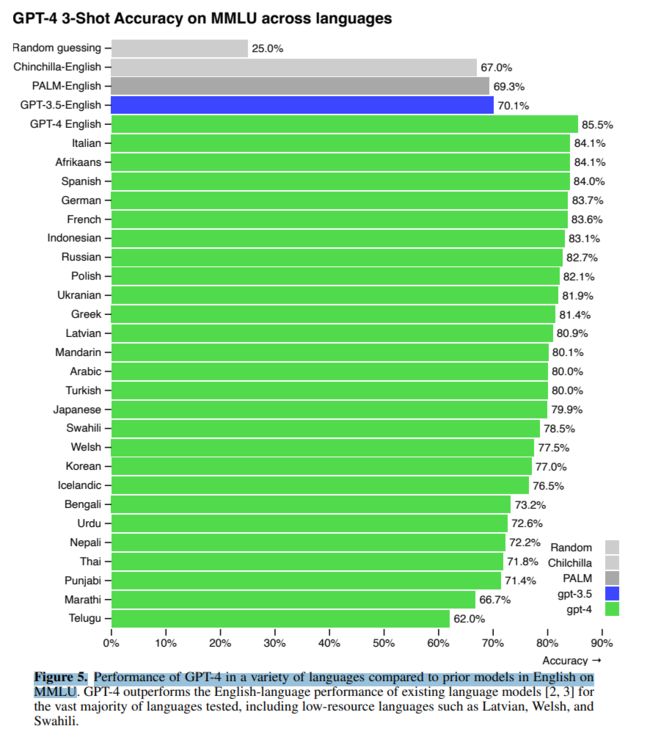

全面爆锤谷歌多语言,把MMLU做个多语言版本,然后继续秀图:

在MMLU上,GPT-4在多种语言中的性能与以前的英语模型相比

视觉信息理解能力 & 推理能力

GPT-4对于视觉信息的处理和理解实在太厉害了,简直超乎我的想象,不禁感叹道:这才是真正的智能

「例子1」 给 GPT-4 输入一个长相奇怪的充电器的图片,让它找出搞笑的梗(如下图1所示)

用户问GPT-4:为什么这很可笑?

GPT-4 回答道:VGA 线充 iPhone

图1

「例子2」 给GPT-4一张格鲁吉亚和西亚的人均每日肉类消费条形图,让它算平均数(如下图2所示)

用户问GPT-4:格鲁吉亚和西亚的平均每日肉类消费量之和是多少?请展示你的计算过程

GPT-4随即给出了非常详细的计算平均数的过程

看起来,现在的 GPT 已经不会在计算上胡言乱语了:

图2

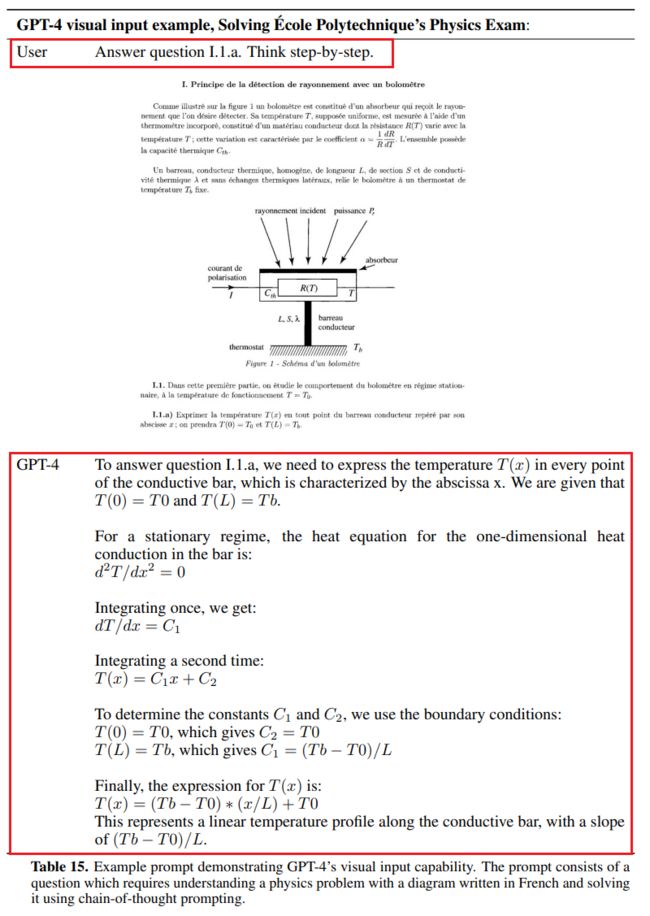

什么?以上两题太简单了?那来点难的,让GPT-4做一道物理题

「例子3」 给GPT-4一道物理题(图片形式),让它回答物理题(如下图3所示)

用户问GPT-4:请回答下面这道物理题的第1题,并展示你的计算过程

GPT-4随即对阅读了图片中的物理题目并给出了非常详细的求解过程

图3

「例子4」 让GPT-4阅读并理解论文,让它总结论文的内容(如下图4.1所示)

用户问GPT-4:

GPT-4随即阅读整篇论文,并综合整篇论文的上下文,给你归纳总结出这篇论文的主要内容

图4.1

用户继续问GPT-4:你能详细解释一下论文Figure 2嘛?(如下图4.2所示)

GPT-4随即综合整篇论文的上下文,对Figure 2进行了详细的阐述

图4.2

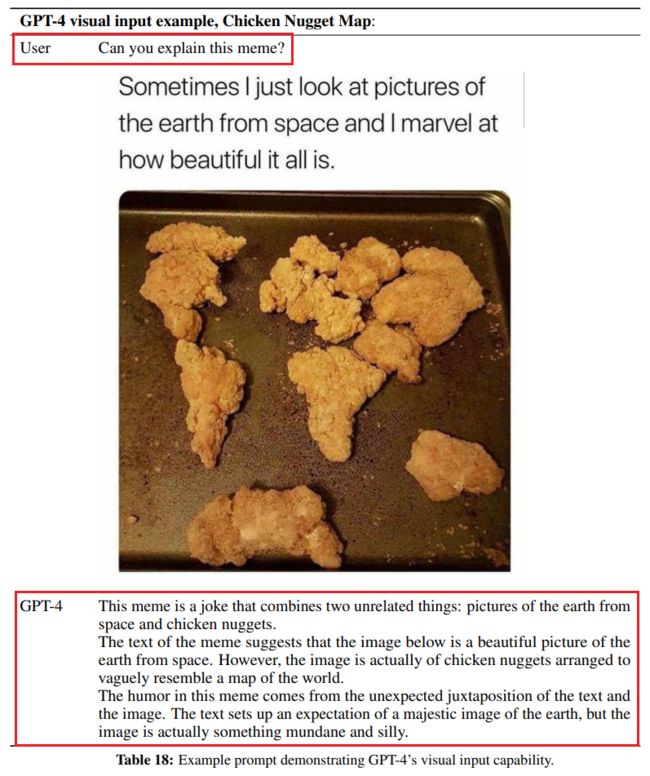

「例子5」 解读图片物体(如下图5所示)

图5

「例子6」 解读漫画(如下图6所示)

图6

大家看了以上6个例子,应该已经能想到GPT-4能用来干嘛了吧?这里我就不多说了

内容可靠性大幅提升

虽然GPT-4很强,但其生成出来的内容并不完全可靠,比如也会产生一些虚假的内容,而这些虚假的内容如果我们人类不加以专业判断,有时候还挺难发现。但值得注意的是,GPT-4 经过多次迭代训练和改进,它相比于前任GPT 模型已经显著减轻了一本正经胡说八道的问题。在 OpenAI 的内部对抗性真实性评估中,GPT-4 的得分比最新的 GPT-3.5 模型高 40%:

GPT-4将带来哪些新的产业应用方向可能性?

论文解读和查重修改工作:运用GPT-4可以实现论文解读,寻找论文创新点,论文修改与攥写等工作,极大缓解广大本硕博论文压力。

文案创作的流水线工作:运用GPT-4可以实现营销文案,新闻,社交媒体文案等流水线工作。

客户支持类型工作:为不同渠道的客户处理复杂的查询工作,为不同的客户提供个性化解答。

为教育行业赋能:可以用GPT-4生成一些不同的测试题,试卷和总结,同时还可以修改作业,为学生作文评分,这极大降低了教师的工作量;借助GPT-4,学生还可以扫描问题图片,获得GPT-4的解答,真正实现哪里不会点哪里,步步高点读机可能都瑟瑟发抖。

辅助应用:残疾人可以获得一个非常不错的语音助手。

类似大量文案工作的法律行业:合同审核,文本分析和案例研究等,律师的效率可以大幅度提升。

赋能医疗健康行业:GPT-4可以给出诊断建议,图片解释和识别,病历报告生成,普通的医生还可以用来做诊断,诊疗方案推荐,病人交流等。

赋能程序员:借助GPT-4强大的编码能力,会造成一部分程序员下岗失业,比如10个程序员能做的事情,借助GPT-4提高编码效率后,或许只需5个程序员就能cover这些工作。[2]

除了以上八点,其实还有很多很多应用值得探索和商业化。。。。此处不一一例举

GPT-4的到来,会开创哪些新的研究方向?

其实《GPT-4 Technical Report》技术报告里很明确地指出了三个新的研究方向

第一,LLM最前沿研究的封闭化或小圈子化。 技术报告里说了,出于竞争以及安全等方面的考虑,未公布模型规模等技术细节。从GPT-2.0的开源,到GPT-3.0的只有论文,再到ChatGPT连论文也没有,直到GPT-4.0的技术报告更像效果评测报告。一个很明显的趋势是,OpenAI做实了CloseAI的名号,之后OpenAI的LLM最前沿研究不会再放出论文。

在这个情形下,其它技术相对领先的公司有两种选择:

一种是做更极致的LLM开源化,比如Meta貌似选择了这条道路,这一般是竞争处于劣势的公司作出的合理选择,但是往往相关技术不会是最前沿的技术

另外一种选择是跟进OpenAI,也选择技术封闭化。Google之前算是LLM的第二梯队,但在“微软+OpenAI”的一顿组合拳下,现在局面有点狼狈不堪。GPT-4.0去年8月就做好了,估计现在GPT-5.0正在炼丹过程中,这么长的时间窗口,结果Google都能落到目前这个局面,想想Transformer、CoT等非常关键的一些研究都是自己做出来的,竟沦落至此,不知一众高层作何感想。Google在后面能快速跟进,维持在第二梯队应该问题不大,很可能比第三名技术也领先很多。出于竞争关系考虑,我猜Google大概率会跟进OpenAI走技术封闭的路线,最先进的LLM技术优先用来炼属于自己的丹,而不是写成论文放出来普惠大众尤其是普惠OpenAI。而这很可能导致LLM最前沿研究的封闭化。

从现在算起,国内在经过一阵时间后(要做到ChatGPT的6到7折应该比较快,要追平估计要较长时间),必然被迫进入自主创新的局面(比如以百度的「文心一言」为代表技术)。从最近三个月国内的各种情况看,将来会如何?大概率不太乐观。当然,这个关肯定很难,但必须得过,只能祝愿有能力且有初心者尽力加油了。

第二,GPT-4技术报告里提到的LLM模型的“能力预测(Capability Prediction)”是个非常有价值的新研究方向。 用小模型来预测某些参数组合下对应大模型的某种能力,如果预测足够精准,能够极大缩短炼丹周期,同时极大减少试错成本,所以无论理论价值还是实际价值巨大,这个绝对是非常值得认真研究具体技术方法。

第三,GPT-4开源了一个LLM评测框架,这也是后面LLM技术快速发展非常重要的方向。 尤其对于中文,构建实用的中文LLM评测数据和框架具备特别重要的意义,好的LLM评测数据可以快速发现LLM目前存在的短板和改进方向,意义重大,但是很明显目前这块基本处于空白状态。这个对于资源要求其实没那么高,适合很多机构去做,不过确实是个辛苦活。

除了GPT-4技术报告里明确指出的三个方向,因为最近LLM各方面新闻比较多,顺手再写两个其它技术方向:

首先,斯坦福大学最近在Meta的7B 开源LLaMA基础上,加上Self Instruct技术构造的Alpaca,也代表了一个技术方向。 如果归纳下,这个方向可以被称为“低成本复现ChatGPT”的方向。所谓Self Instruct,就是采取一定技术手段,不用人工标注Instruct,而是从OpenAI的接口里,好听点叫“蒸馏”出Instruct,也就是不用人标注,而是ChatGPT作为teacher,给你的Instruct打上标注结果。这个把Instruct标注成本直接打到了几百美金的基准,时间成本就更短了。再加上模型7B规模也不大,所以可以看成一种“低成本复现ChatGPT”的技术路线。

我估计国内早就有不少人采取这个技术路线了。毫无疑问,这是一条捷径,但是走捷径有好处有坏处,具体不展开谈了。在追赶ChatGPT的过程中,先把成本打下来去复现ChatGPT到七八成,我个人还是觉得可行也支持的,毕竟穷人有穷人的玩法。当然,追求把模型做小,效果又不怎么往下掉,如果能扎扎实实去做,是非常具有价值的。

另外,具身智能毫无疑问会是LLM下一阶段的重点研究方向。 这方面的代表就是前阵子Google放出来的PaLM-E了。目前的GPT-4,我们可以认为人类创造出了一个超级大脑,但还是把它封锁在GPU集群里。 而这个超级大脑需要一个身体,GPT-4要和物理世界发生联系、交流和互动,并在物理世界中获得真实的反馈,来学会在真实世界里生存,并根据真实世界的反馈,利用比如强化学习来学习在世界游走的能力。这个肯定是最近的将来最热门的LLM研究方向。

「多模态LLM给予了GPT-4以眼睛和耳朵,而具身智能给予GPT-4身体、脚和手。GPT-4和你我发生一些联系,而依托于GPT-4本身强大的学习能力,这个事情估计很快会出现在我们身边。」

如果你细想,其实还有很多其它有前途的方向。我的个人判断是:未来5到10年,将会是AGI最快速发展的黄金十年。如果我们站在未来30年的时间节点,当我们回顾这10年时,我们中一定会有人想起下面的诗句:懂得,但为时太晚,他们使太阳在途中悲伤,也并不温和地走进那个良夜”[3]

如何使用GPT-4?

加入候补名单

注册OpenAI账户:https://platform.openai.com/signup

加入候补名单waitlist:https://openai.com/waitlist/gpt-4-api

注册候补名单后,您必须等待 OpenAI 授予您访问 GPT-4 的权限,这可能需要一些时间。

订阅Chatgpt plus

如果您想使用 GPT-4 模型自由生成文本,则需要付费订阅 ChatGPT+(ChatGPT 的高级版),获取方法如下:

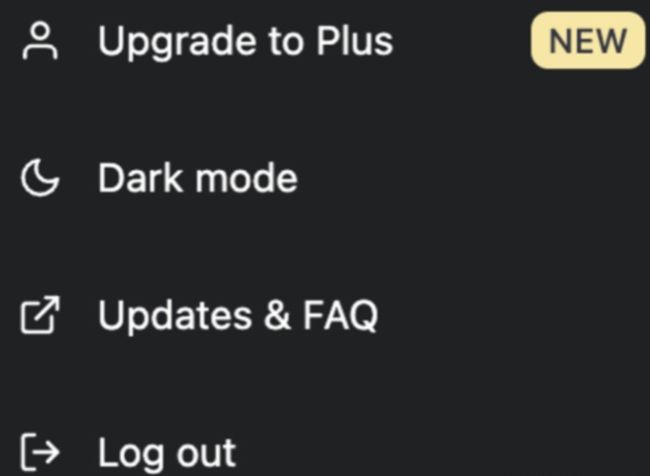

登录您的 OpenAI 帐户后,页面上将有一个显示按钮,可直接将您带到 ChatGPT。如果您是 ChatGPT plus付费用户,则可以直接体验。如果您有免费会员资格,则需要升级。单击上图菜单中的“Upgrade to Plus”按钮,该按钮会跳转到订阅购买页面,这时候你需要输入常用信息,每月支付$20即可。

成为付费用户后,您可以立即通过 ChatGPT 访问新模型。值得一提的是,GPT-4不采用waiting list模式,付费即可体验。[4]

使用最新的Bing Chat

目前还没有免费接入 GPT-4,不过 Bing 用户已经可以接入新的 Bing 聊天机器人,因此他们也可以间接体验 GPT-4。因为 Microsoft 已经确认(在新选项卡中打开)GPT-4 的引入已经为其聊天机器人交互提供了支持。

Reference

[1] https://www.zhihu.com/question/589639535/answer/2936668222

[2] https://www.zhihu.com/question/589641117/answer/2938081105

[3] https://www.zhihu.com/question/589640227/answer/2937925226

[4] https://zhuanlan.zhihu.com/p/614130033