Qt音视频开发28-ffmpeg解码本地摄像头(yuv422转yuv420)

一、前言

一开始用ffmpeg做的是视频流的解析,后面增加了本地视频文件的支持,到后面发现ffmpeg也是支持本地摄像头设备的,只要是原则上打通的比如win系统上相机程序、linux上茄子程序可以正常打开就表示打通,整个解码显示过程完全一样,就是打开的时候要传入设备信息,而且参数那边可以指定分辨率和帧率等,本地摄像机一般会支持多个分辨率,用户需要哪种分辨率都可以指定该分辨率进行采集。

这里要说的一个小插曲就是在linux上测试这个功能的时候,发现编译期间就失败了,这就奇怪了,后面发现是静态库的原因,为了偷懒,一开始编译的ffmpeg静态库,当换成动态库的方式以后,一步跑通不要太完美,完美使用,所以如果有加载本地摄像头设备的需求的时候,尽量用动态库的方式。一鼓作气将代码移植到嵌入式linux板子上,完美,居然也可以,而且实时性挺好,可能内置了部分缓存的原因,比自己用v4l2的方式更流畅一些。

由于本地摄像头设备采集回来的数据默认的yuv422格式,显示数据那边默认是yuv420格式,当然改成绘制yuv422也是可以的,但是有需要更改绘制代码,而且存储那边也要做特殊处理,所以考虑再三决定从源头做转换,用sws_scale转换各种格式都非常方便,本来ffmpeg采集这边就需要将非yuv420格式转到yuv420格式。

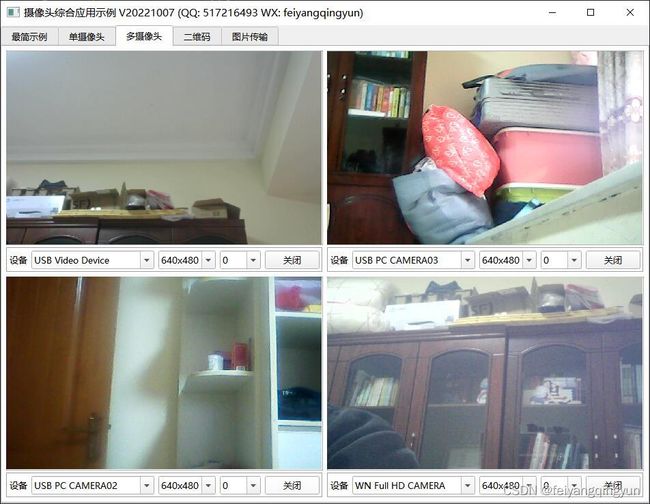

二、效果图

三、体验地址

- 国内站点:https://gitee.com/feiyangqingyun

- 国际站点:https://github.com/feiyangqingyun

- 个人作品:https://blog.csdn.net/feiyangqingyun/article/details/97565652

- 体验地址:https://pan.baidu.com/s/1d7TH_GEYl5nOecuNlWJJ7g 提取码:01jf 文件名:bin_video_demo/bin_linux_video。

四、相关代码

void CameraThreadFFmpeg::initCamera()

{

//https://blog.csdn.net/weixin_37921201/article/details/120357826

//命令行打开 ffplay -f dshow -i video="USB Video Device" -s 1280x720 -framerate 30

//启动计时

timer.restart();

//参数字典

AVDictionary *options = NULL;

//设置分辨率

QString size = QString("%1x%2").arg(videoWidth).arg(videoHeight);

av_dict_set(&options, "video_size", size.toUtf8().constData(), 0);

//设置帧率

if (frameRate > 0) {

av_dict_set(&options, "framerate", QString::number(frameRate).toUtf8().constData(), 0);

}

//设置输入格式(前提是要对应设备对应平台支持)

//av_dict_set(&options, "input_format", "mjpeg", 0);

//设置图像格式(有些设备设置了格式后帧率上不去)

//av_dict_set(&options, "pixel_format", "yuyv422", 0);

//打印设备列表

//FFmpegHelper::showDevice();

//打印设备参数

//FFmpegHelper::showOption(cameraName);

//实例化格式处理上下文

formatCtx = avformat_alloc_context();

AVInputFormatx *ifmt = NULL;

QByteArray url = cameraName.toUtf8();

#if defined(Q_OS_WIN)

//ifmt = av_find_input_format("vfwcap");

ifmt = av_find_input_format("dshow");

url = QString("video=%1").arg(cameraName).toUtf8();

#elif defined(Q_OS_LINUX)

//ifmt = av_find_input_format("v4l2");

ifmt = av_find_input_format("video4linux2");

#elif defined(Q_OS_MAC)

ifmt = av_find_input_format("avfoundation");

#endif

int result = avformat_open_input(&formatCtx, url.data(), ifmt, &options);

av_dict_free(&options);

if (result < 0) {

debug("打开地址", "错误: 打开出错 " + FFmpegHelper::getError(result));

return;

}

//获取流信息

result = avformat_find_stream_info(formatCtx, NULL);

if (result < 0) {

debug("打开地址", "错误: 找流失败 " + FFmpegHelper::getError(result));

return;

}

//获取最佳流索引

AVCodecx *videoCodec;

videoIndex = av_find_best_stream(formatCtx, AVMEDIA_TYPE_VIDEO, -1, -1, NULL, 0);

if (videoIndex < 0) {

debug("打开地址", "错误: 未找到视频流");

return;

}

//获取视频流

AVStream *videoStream = formatCtx->streams[videoIndex];

//查找视频解码器(如果上面av_find_best_stream第五个参数传了则这里不需要)

AVCodecID codecID = FFmpegHelper::getCodecID(videoStream);

videoCodec = avcodec_find_decoder(codecID);

//videoCodec = avcodec_find_decoder_by_name("h264");

if (!videoCodec) {

debug("打开地址", "错误: 查找视频解码器失败");

return;

}

//创建视频流解码器上下文

videoCodecCtx = avcodec_alloc_context3(videoCodec);

if (!videoCodecCtx) {

debug("打开地址", "错误: 创建视频解码器上下文失败");

return;

}

result = FFmpegHelper::copyContext(videoCodecCtx, videoStream, false);

if (result < 0) {

debug("打开地址", "错误: 设置视频解码器参数失败");

return;

}

//设置解码器参数

videoCodecCtx->flags |= AV_CODEC_FLAG_LOW_DELAY;

videoCodecCtx->flags |= AV_CODEC_FLAG_GLOBAL_HEADER;

videoCodecCtx->flags2 |= AV_CODEC_FLAG2_FAST;

//打开视频解码器

result = avcodec_open2(videoCodecCtx, videoCodec, NULL);

if (result < 0) {

debug("打开地址", "错误: 打开视频解码器失败 " + FFmpegHelper::getError(result));

return;

}

//获取实际分辨率大小

FFmpegHelper::getResolution(videoStream, videoWidth, videoHeight);

//如果没有获取到宽高则返回

if (videoWidth <= 0 || videoHeight <= 0) {

debug("打开地址", "错误: 获取宽度高度失败");

return;

}

//获取最终真实的帧率

frameRate = av_q2d(videoStream->r_frame_rate);

QString msg = QString("索引: %1 解码: %2 帧率: %3 宽高: %4x%5").arg(videoIndex).arg(videoCodec->name).arg(frameRate).arg(videoWidth).arg(videoHeight);

debug("视频信息", msg);

openCamera();

}

bool CameraThreadFFmpeg::openCamera()

{

//分配内存

packet = FFmpegHelper::creatPacket(NULL);

videoFrame = av_frame_alloc();

yuvFrame = av_frame_alloc();

imageFrame = av_frame_alloc();

//设置属性以便该帧对象正常

yuvFrame->format = AV_PIX_FMT_YUV420P;

yuvFrame->width = videoWidth;

yuvFrame->height = videoHeight;

//定义及获取像素格式

AVPixelFormat srcFormat = AV_PIX_FMT_YUYV422;

//通过解码器获取解码格式

srcFormat = videoCodecCtx->pix_fmt;

//各种转换速度比对 https://www.cnblogs.com/xumaojun/p/8541634.html

int flags = SWS_FAST_BILINEAR;

//分配视频帧数据(转yuv420)

int yuvSize = av_image_get_buffer_size(AV_PIX_FMT_YUV420P, videoWidth, videoHeight, 1);

yuvData = (quint8 *)av_malloc(yuvSize * sizeof(quint8));

av_image_fill_arrays(yuvFrame->data, yuvFrame->linesize, yuvData, AV_PIX_FMT_YUV420P, videoWidth, videoHeight, 1);

//视频图像转换(转yuv420)

yuvSwsCtx = sws_getContext(videoWidth, videoHeight, srcFormat, videoWidth, videoHeight, AV_PIX_FMT_YUV420P, flags, NULL, NULL, NULL);

//分配视频帧数据(转rgb)

int imageSize = av_image_get_buffer_size(AV_PIX_FMT_RGB24, videoWidth, videoHeight, 1);

imageData = (quint8 *)av_malloc(imageSize * sizeof(quint8));

av_image_fill_arrays(imageFrame->data, imageFrame->linesize, imageData, AV_PIX_FMT_RGB24, videoWidth, videoHeight, 1);

//视频图像转换(转rgb)

imageSwsCtx = sws_getContext(videoWidth, videoHeight, AV_PIX_FMT_YUV420P, videoWidth, videoHeight, AV_PIX_FMT_RGB24, flags, NULL, NULL, NULL);

//打印媒体信息

//av_dump_format(formatCtx, 0, 0, 0);

QString msg = QString("源头: %1 目标: %2").arg(srcFormat).arg(videoMode == VideoMode_Painter ? AV_PIX_FMT_RGB24 : AV_PIX_FMT_YUV420P);

debug("格式信息", msg);

//初始化音频播放

this->initAudioPlayer();

//初始化滤镜

this->initFilter();

int time = timer.elapsed();

debug("打开成功", QString("用时: %1 毫秒").arg(time));

emit receivePlayStart(time);

emit recorderStateChanged(RecorderState_Stopped, fileName);

isOk = true;

return isOk;

}

五、功能特点

5.1 基础功能

- 支持各种音频视频文件格式,比如mp3、wav、mp4、asf、rm、rmvb、mkv等。

- 支持本地摄像头设备,可指定分辨率、帧率。

- 支持各种视频流格式,比如rtp、rtsp、rtmp、http等。

- 本地音视频文件和网络音视频文件,自动识别文件长度、播放进度、音量大小、静音状态等。

- 文件可以指定播放位置、调节音量大小、设置静音状态等。

- 支持倍速播放文件,可选0.5倍、1.0倍、2.5倍、5.0倍等速度,相当于慢放和快放。

- 支持开始播放、停止播放、暂停播放、继续播放。

- 支持抓拍截图,可指定文件路径,可选抓拍完成是否自动显示预览。

- 支持录像存储,手动开始录像、停止录像,部分内核支持暂停录像后继续录像,跳过不需要录像的部分。

- 支持无感知切换循环播放、自动重连等机制。

- 提供播放成功、播放完成、收到解码图片、收到抓拍图片、视频尺寸变化、录像状态变化等信号。

- 多线程处理,一个解码一个线程,不卡主界面。

5.2 特色功能

- 同时支持多种解码内核,包括qmedia内核(Qt4/Qt5/Qt6)、ffmpeg内核(ffmpeg2/ffmpeg3/ffmpeg4/ffmpeg5)、vlc内核(vlc2/vlc3)、mpv内核(mpv1/mp2)、海康sdk、easyplayer内核等。

- 非常完善的多重基类设计,新增一种解码内核只需要实现极少的代码量,就可以应用整套机制。

- 同时支持多种画面显示策略,自动调整(原始分辨率小于显示控件尺寸则按照原始分辨率大小显示,否则等比例缩放)、等比例缩放(永远等比例缩放)、拉伸填充(永远拉伸填充)。所有内核和所有视频显示模式下都支持三种画面显示策略。

- 同时支持多种视频显示模式,句柄模式(传入控件句柄交给对方绘制控制)、绘制模式(回调拿到数据后转成QImage用QPainter绘制)、GPU模式(回调拿到数据后转成yuv用QOpenglWidget绘制)。

- 支持多种硬件加速类型,ffmpeg可选dxva2、d3d11va等,mpv可选auto、dxva2、d3d11va,vlc可选any、dxva2、d3d11va。不同的系统环境有不同的类型选择,比如linux系统有vaapi、vdpau,macos系统有videotoolbox。

- 解码线程和显示窗体分离,可指定任意解码内核挂载到任意显示窗体,动态切换。

- 支持共享解码线程,默认开启并且自动处理,当识别到相同的视频地址,共享一个解码线程,在网络视频环境中可以大大节约网络流量以及对方设备的推流压力。国内顶尖视频厂商均采用此策略。这样只要拉一路视频流就可以共享到几十个几百个通道展示。

- 自动识别视频旋转角度并绘制,比如手机上拍摄的视频一般是旋转了90度的,播放的时候要自动旋转处理,不然默认是倒着的。

- 自动识别视频流播放过程中分辨率的变化,在视频控件上自动调整尺寸。比如摄像机可以在使用过程中动态配置分辨率,当分辨率改动后对应视频控件也要做出同步反应。

- 音视频文件无感知自动切换循环播放,不会出现切换期间黑屏等肉眼可见的切换痕迹。

- 视频控件同时支持任意解码内核、任意画面显示策略、任意视频显示模式。

- 视频控件悬浮条同时支持句柄、绘制、GPU三种模式,非绝对坐标移来移去。

- 本地摄像头设备支持指定设备名称、分辨率、帧率进行播放。

- 录像文件同时支持打开的视频文件、本地摄像头、网络视频流等。

- 瞬间响应打开和关闭,无论是打开不存在的视频或者网络流,探测设备是否存在,读取中的超时等待,收到关闭指令立即中断之前的操作并响应。

- 支持打开各种图片文件,支持本地音视频文件拖曳播放。

- 视频控件悬浮条自带开始和停止录像切换、声音静音切换、抓拍截图、关闭视频等功能。

- 音频组件支持声音波形值数据解析,可以根据该值绘制波形曲线和柱状声音条,默认提供了声音振幅信号。

- 各组件中极其详细的打印信息提示,尤其是报错信息提示,封装的统一打印格式。针对现场复杂的设备环境测试极其方便有用,相当于精确定位到具体哪个通道哪个步骤出错。

- 代码框架和结构优化到最优,性能强悍,持续迭代更新升级。

- 源码支持Qt4、Qt5、Qt6,兼容所有版本。

5.3 视频控件

- 可动态添加任意多个osd标签信息,标签信息包括名字、是否可见、字号大小、文本文字、文本颜色、标签图片、标签坐标、标签格式(文本、日期、时间、日期时间、图片)、标签位置(左上角、左下角、右上角、右下角、居中、自定义坐标)。

- 可动态添加任意多个图形信息,这个非常有用,比如人工智能算法解析后的图形区域信息直接发给视频控件即可。图形信息支持任意形状,直接绘制在原始图片上,采用绝对坐标。

- 图形信息包括名字、边框大小、边框颜色、背景颜色、矩形区域、路径集合、点坐标集合等。

- 每个图形信息都可指定三种区域中的一种或者多种,指定了的都会绘制。

- 内置悬浮条控件,悬浮条位置支持顶部、底部、左侧、右侧。

- 悬浮条控件参数包括边距、间距、背景透明度、背景颜色、文本颜色、按下颜色、位置、按钮图标代码集合、按钮名称标识集合、按钮提示信息集合。

- 悬浮条控件一排工具按钮可自定义,通过结构体参数设置,图标可选图形字体还是自定义图片。

- 悬浮条按钮内部实现了录像切换、抓拍截图、静音切换、关闭视频等功能,也可以自行在源码中增加自己对应的功能。

- 悬浮条按钮对应实现了功能的按钮,有对应图标切换处理,比如录像按钮按下后会切换到正在录像中的图标,声音按钮切换后变成静音图标,再次切换还原。

- 悬浮条按钮单击后都用名称唯一标识作为信号发出,可以自行关联响应处理。

- 悬浮条空白区域可以显示提示信息,默认显示当前视频分辨率大小,可以增加帧率、码流大小等信息。

- 视频控件参数包括边框大小、边框颜色、焦点颜色、背景颜色(默认透明)、文字颜色(默认全局文字颜色)、填充颜色(视频外的空白处填充黑色)、背景文字、背景图片(如果设置了图片优先取图片)、是否拷贝图片、缩放显示模式(自动调整、等比例缩放、拉伸填充)、视频显示模式(句柄、绘制、GPU)、启用悬浮条、悬浮条尺寸(横向为高度、纵向为宽度)、悬浮条位置(顶部、底部、左侧、右侧)。