mahout算法源码分析之Collaborative Filtering with ALS-WR (四)评价和推荐

Mahout版本:0.7,hadoop版本:1.0.4,jdk:1.7.0_25 64bit。

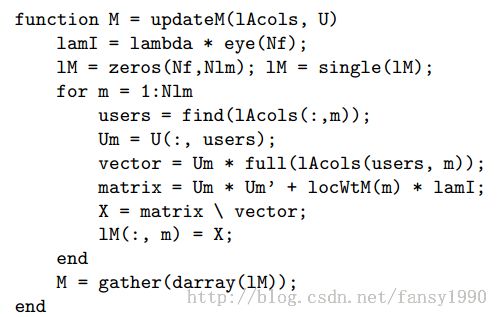

首先来总结一下 mahout算法源码分析之Collaborative Filtering with ALS-WR (三),这个写了三篇,基本都是写QR分解,然后矩阵进过处理得到U或者M的过程,但是还是没有讲出个所以然来。mahout官网上说其是根据这篇文献得来的Large-scale Parallel Collaborative Filtering for the Netflix Prize,本来我是想翻译这篇来着,就是为了想弄清楚这个所谓的QR分解算法,但是感觉好像和mahout中的实现不同。(这篇在csdn上面已经有人翻译了,但是真的只是翻译而已,并没有进行讲解,结果还是自己来看),其中主要的是下面的matlab部分代码:

这里是使用给定的U来更新M,mahout中第一个是用M--1来更新U-0,其实都是一样的。看上面的图,其中的vector其实就是Vi,而matrix其实就是Ai(对应于前篇blog中相应的变量),所以matrix\vector 其实就相当于Ai\Vi = Ai‘*Vi(Ai的逆矩阵和Vi相乘)这样就可以得到M。额,或许这里的mahout代码就是求Ai的逆矩阵?恩,很有可能这样的话,应该是对到了。只是这里求Ai的逆矩阵代码太复杂了。这个有时间还是要慢慢研究下的。

今天本来就不打算纠结这个问题了,没想到又看一遍居然好像有点领悟了(之前一直以为逆矩阵和转置矩阵一样的,导致以为mahout代码和matlab代码不符,哎,还是矩阵没学好。。。)

本篇正文:评价这个算法,在mahout中其实就是使用了一个参数而已,rmse,均方根误差。运行这一步其实就是先使用前面一步获得的U和M来对每个用户应经评价的movies进行重新评价,即评价预测。然后把真是评价分数和预测评价分数的误差写入文件。最后读出误差列,把其求平均得到最后误差结果。在mahout中评价使用的job文件是:org.apache.mahout.cf.taste.hadoop.als.FactorizationEvaluator。打开这个文件,可以看到在run方法中有一个parepareJob的函数,同时这个函数的Mapper是PredictRatingsMapper。打开这个PredictRatingsMapper可以看到它有setup和map函数,setup函数主要是把路径U和M中的数据load到一个变量里面,map是主要操作,源码如下:

protected void map(LongWritable key, Text value, Context ctx) throws IOException, InterruptedException {

String[] tokens = TasteHadoopUtils.splitPrefTokens(value.toString());

int userID = Integer.parseInt(tokens[0]);

int itemID = Integer.parseInt(tokens[1]);

double rating = Double.parseDouble(tokens[2]);

if (U.containsKey(userID) && M.containsKey(itemID)) {

double estimate = U.get(userID).dot(M.get(itemID));

double err = rating - estimate;

ctx.write(new DoubleWritable(err), NullWritable.get());

}

}

额 ,好吧首先说下这个输入数据,格式为:userid,itemid,rating。然后map遍历每条记录,首先把当前记录中的userID、ItemID和rating提取出来,然后从U和M中分别取出userid和itemid对应的行或列向量,取出来后,把这两个向量做点乘即可得到最后的预测评价分数。然后使用是真实的评价分数减去预测的评价分数即可得到误差,进行输出即可。在这个job运行完成后,随机代码就调用了computeRmse函数来对输出文件进行分析,求出最后的rmse:

protected double computeRmse(Path errors) {

RunningAverage average = new FullRunningAverage();

for (Pair<DoubleWritable,NullWritable> entry :

new SequenceFileDirIterable<DoubleWritable, NullWritable>(errors, PathType.LIST, PathFilters.logsCRCFilter(),

getConf())) {

DoubleWritable error = entry.getFirst();

average.addDatum(error.get() * error.get());

}

return Math.sqrt(average.getAverage());

}

然后是推荐,推荐使用的源码是在:org.apache.mahout.cf.taste.hadoop.als.RecommenderJob。这里run方法中的prepareJob中使用的mapper是PredictionMapper。这个mapper中同样含有setup和map函数,其中的setup函数还是获取U和M,不过还额外获取了一个MaxRating变量。map中的处理比较多,先贴源码吧:

protected void map(IntWritable userIDWritable, VectorWritable ratingsWritable, Context ctx)

throws IOException, InterruptedException {

Vector ratings = ratingsWritable.get();

final int userID = userIDWritable.get();

final OpenIntHashSet alreadyRatedItems = new OpenIntHashSet(ratings.getNumNondefaultElements());

final TopK<RecommendedItem> topKItems = new TopK<RecommendedItem>(recommendationsPerUser, BY_PREFERENCE_VALUE);

Iterator<Vector.Element> ratingsIterator = ratings.iterateNonZero();

while (ratingsIterator.hasNext()) {

alreadyRatedItems.add(ratingsIterator.next().index());

}

M.forEachPair(new IntObjectProcedure<Vector>() {

@Override

public boolean apply(int itemID, Vector itemFeatures) {

if (!alreadyRatedItems.contains(itemID)) {

double predictedRating = U.get(userID).dot(itemFeatures);

topKItems.offer(new GenericRecommendedItem(itemID, (float) predictedRating));

}

return true;

}

});

List<RecommendedItem> recommendedItems = Lists.newArrayListWithExpectedSize(recommendationsPerUser);

for (RecommendedItem topItem : topKItems.retrieve()) {

recommendedItems.add(new GenericRecommendedItem(topItem.getItemID(), Math.min(topItem.getValue(), maxRating)));

}

if (!topKItems.isEmpty()) {

ctx.write(userIDWritable, new RecommendedItemsWritable(recommendedItems));

}

}

先说下这个输入格式吧:<key,vlaue> --> <userid,[itemid:rating,itemid,rating,...],针对当前的输入,首先获取用户userid和这个用户所有评价过的item(放在alreadyRatedItems) 。然后遍历所有M中的item如果这个item不存在于alreadyRatedItems那么就对这个item进行评分预测,预测使用的还是在U中和M中取出分别对应userid和itemid的行、列向量进行点乘即可得到预测分数,然后把这个预测的分数加入到topKItems中,看下这个变量的定义:

final TopK<RecommendedItem> topKItems = new TopK<RecommendedItem>(recommendationsPerUser, BY_PREFERENCE_VALUE);

这里的BY_PREFERENCE_VALUE实现了comparator接口,所以加入到这个变量中的会按照一定的顺序来排列,即按照value(即预测的分数)从大到小来排列。然后就是输出了。这样这个系列就全部分析完毕了。

额,还有一点,关于matlab代码部分的算法其实是和mahout源码中的一致的,具体下篇分析。

分享,成长,快乐

转载请注明blog地址:http://blog.csdn.net/fansy1990