AI人工智能学习之回归分析

回归分析

在统计学中,回归分析(regression analysis)指的是确定两种或两种以上变量间相互依赖的定量关系的一种统计分析方法。回归分析按照涉及的变量的多少,分为一元回归和多元回归分析;按照因变量的多少,可分为简单回归分析和多重回归分析;按照自变量和因变量之间的关系类型,可分为线性回归分析和非线性回归分析。

回归分析的主要内容为:

①从一组数据出发,确定某些变量之间的定量关系式,即建立数学模型并估计其中的未知参数。估计参数的常用方法是最小二乘法。

②对这些关系式的可信程度进行检验。

③在许多自变量共同影响着一个因变量的关系中,判断哪个(或哪些)自变量的影响是显著的,哪些自变量的影响是不显著的,将影响显著的自变量加入模型中,而剔除影响不显著的变量,通常用逐步回归、向前回归和向后回归等方法。

④利用所求的关系式对某一生产过程进行预测或控制。回归分析的应用是非常广泛的,统计软件包使各种回归方法计算十分方便。

在回归分析中,把变量分为两类。一类是因变量,它们通常是实际问题中所关心的一类指标,通常用Y表示;而影响因变量取值的的另一类变量称为自变量,用X来表示。

回归分析研究的主要问题是:

(1)确定Y与X间的定量关系表达式,这种表达式称为回归方程;

(2)对求得的回归方程的可信度进行检验;

(3)判断自变量X对因变量Y有无影响;

(4)利用所求得的回归方程进行预测和控制。

一元线性回归

在一元线性回归中只有两个变量,一个是因变量,另一个是自变量,其回归方程可以表示为:

![]() (理论回归方程)

(理论回归方程)

式中y为因变量;x为自变量;α是常数项或截距项;β是自变量x的回归系数; ε 是随机误差项,通常假设是随机的,服从正太分布 ε∼N(0,![]() ) ,并且,假设 ε 与自变量x无关。式中将实际问题中变量y与x之间的关系用两个部分描述:一部分是由于x的变化引起的y的线性变化,即 α+βx ;另一部分是由其他一切随机因素引起的,记为 ε 。

) ,并且,假设 ε 与自变量x无关。式中将实际问题中变量y与x之间的关系用两个部分描述:一部分是由于x的变化引起的y的线性变化,即 α+βx ;另一部分是由其他一切随机因素引起的,记为 ε 。

多元线性回归

很多事件的发生不是相互独立的,而是相互作用、相互影响的。一种结果的出现往往是多个因素、多个环节共同作用的结果。需要同时考虑多个因素对同一结果的影响。

设有p个自变量( ![]() ),有n个观察对象,第i个(i=1,2,3,…,n)观察对象的一组观察值为(

),有n个观察对象,第i个(i=1,2,3,…,n)观察对象的一组观察值为(![]() ) 。当因变量与自变量组之间存在多重线性关系时,用多重线性回归模型表示为:

) 。当因变量与自变量组之间存在多重线性关系时,用多重线性回归模型表示为:

![]()

由上式我们可以知道,每个因变量的实测值 ![]() 由两部分组成:

由两部分组成:

一部分是其估计值,用 ![]() 表示,即给定各自变量取值时因变量

表示,即给定各自变量取值时因变量 ![]() 的估计值,它表示因变量的变异中能由自变量决定的部分。

的估计值,它表示因变量的变异中能由自变量决定的部分。

![]() 为残差,是因变量实测值

为残差,是因变量实测值 ![]() 与其估计值

与其估计值 ![]() 的差值,表示不由自变量决定的部分。残差是建模过程中非常重要的一部分。

的差值,表示不由自变量决定的部分。残差是建模过程中非常重要的一部分。

残差 (![]() )不是一元线性回归模型里面的随机误差项( ε )。随机误差项是误差的一种,与观测者,测量工具,被观测物体的性质有关,只能尽量减小,却不能避免。残差与预测有关,残差大小可以衡量预测的准确性。残差越大表示预测越不准确,残差与数据本身的分布特性,回归方程的选择有关。

)不是一元线性回归模型里面的随机误差项( ε )。随机误差项是误差的一种,与观测者,测量工具,被观测物体的性质有关,只能尽量减小,却不能避免。残差与预测有关,残差大小可以衡量预测的准确性。残差越大表示预测越不准确,残差与数据本身的分布特性,回归方程的选择有关。

对一般情况下含有p个自变量的多元线性回归而言, ![]() 表示在回归方程中其他自变量保持不变的情况下,自变量

表示在回归方程中其他自变量保持不变的情况下,自变量 ![]() 每增加一个单位时因变量 y 的平均增加幅度。我们称

每增加一个单位时因变量 y 的平均增加幅度。我们称 ![]() 为偏回归系数(因为其他自变量保持不变,即取固定值)。

为偏回归系数(因为其他自变量保持不变,即取固定值)。

使用多重线性回归进行统计分析时,数据需满足以下条件:

- 自变量与因变量之间存在线性关系。

- 各观测间相互独立。

- 残差

服从正态分布。其方差

服从正态分布。其方差  反映了回归模型的精度, σ 越小,用所得到的回归方程模型预测y的精度就越高。

反映了回归模型的精度, σ 越小,用所得到的回归方程模型预测y的精度就越高。  的离散程度不随所有变量取值水平的改变而改变,即方差齐性。

的离散程度不随所有变量取值水平的改变而改变,即方差齐性。- 为了保证参数估计稳定,还要注意模型对样本量的要求。样本量应该为自变量个数的20倍以上。

做回归分析得具体分析步骤和具体操作方法:

- 绘制散点图,观察变量间的趋势。绘制散点图是线性回归分析之前的必要步骤。

- 考察数据分布,进行必要的预处理。即分析变量的正态性、方差齐性等问题。

- 进行直线回归分析。这一步相当于检验数据的过程,包括变量的初步筛选,变量选择方法等。

回归方程的拟合度检验

复相关系数 ![]()

复相关系数又称多元相关系数,表示模型中所有自变量(![]() )与因变量y之间线性回归关系的密切程度。取值范围(0,1),没有负值。R值越大,说明线性回归关系越密切。不过用复相关系数评价多重线性回归模型好坏时存在不足,即使向模型中增加的变量没有统计学意义,

)与因变量y之间线性回归关系的密切程度。取值范围(0,1),没有负值。R值越大,说明线性回归关系越密切。不过用复相关系数评价多重线性回归模型好坏时存在不足,即使向模型中增加的变量没有统计学意义,![]() 值也会增大。

值也会增大。

决定系数 ![]()

决定系数 ![]() 是一个反应回归直线与样本观测值拟合度的相对指标,是因变量的变异中能用自变量解释的比例。其取值范围在(0,1),可以用百分数表示。如果决定系数

是一个反应回归直线与样本观测值拟合度的相对指标,是因变量的变异中能用自变量解释的比例。其取值范围在(0,1),可以用百分数表示。如果决定系数 ![]() 越接近1,说明因变量不确定性的绝大部分能由回归方程解释,回归方程拟合度越好。反之,如果

越接近1,说明因变量不确定性的绝大部分能由回归方程解释,回归方程拟合度越好。反之,如果 ![]() 不大,说明 回归方程的效果不好,应该进行修改,可以考虑增加新的自变量或者使用曲线回归。

不大,说明 回归方程的效果不好,应该进行修改,可以考虑增加新的自变量或者使用曲线回归。

回归方程的显著性检验,

回归方程的显著性检验有两个部分:回归方程显著性的 ![]() 检验;另一个是回归系数的

检验;另一个是回归系数的 ![]() 检验。

检验。

回归方程显著性的 ![]() 检验

检验

对多元线性回归方程的显著性检验就是要看自变量 ![]() 从整体上对随机变量

从整体上对随机变量 ![]() 是否有显著影响。为此提出原假设:

是否有显著影响。为此提出原假设:

![]()

如果接受 ![]() ,即,当

,即,当 ![]() 时,接受原假设,则表明随机变量

时,接受原假设,则表明随机变量 ![]() 与

与 ![]() 之间的关系由线性回归模型表示不合适。反之,当

之间的关系由线性回归模型表示不合适。反之,当 ![]() 时,拒绝原假设,则表明随机变量

时,拒绝原假设,则表明随机变量 ![]() 与

与 ![]() 之间的关系由线性回归模型表示合适。

之间的关系由线性回归模型表示合适。

回归系数的 ![]() 检验

检验

在多元线性回归分析中,回归方程显著不意味着每个自变量对 ![]() 的影响显著,想从回归方程中剔除那些次要的、可有可无的变量,重新建立更为简单的回归方程,所以需要对每个自变量进行显著性检验。

的影响显著,想从回归方程中剔除那些次要的、可有可无的变量,重新建立更为简单的回归方程,所以需要对每个自变量进行显著性检验。

如果某个自变量 ![]() 对

对 ![]() 的作用不显著,那么在回归模型中,它的系数

的作用不显著,那么在回归模型中,它的系数 ![]() 就取0。因此,检验变量

就取0。因此,检验变量 ![]() 是否显著,等价于检验假设

是否显著,等价于检验假设

![]()

当原假设 ![]() 成立时,即接受原假设时,认为自变量

成立时,即接受原假设时,认为自变量 ![]() 对因变量

对因变量 ![]() 的线性效果不显著。反之,则拒绝原假设,认为自变量

的线性效果不显著。反之,则拒绝原假设,认为自变量 ![]() 对因变量

对因变量 ![]() 的 线性效果显著。

的 线性效果显著。

常用回归分析方法 :

有各种各样的回归技术用于预测。这些技术主要有三个度量(自变量的个数,因变量的类型以及回归线的形状)。

线性回归(Linear Regression)

它是最为人熟知的建模技术之一。线性回归通常是人们在学习预测模型时首选的技术之一。在这种技术中,因变量是连续的,自变量可以是连续的也可以是离散的,回归线的性质是线性的。

线性回归使用最佳的拟合直线(也就是回归线)在因变量(Y)和一个或多个自变量(X)之间建立一种关系。

用一个方程式来表示它,即 Y=a+b*X + e,其中a表示截距,b表示直线的斜率,e是误差项。这个方程可以根据给定的预测变量(s)来预测目标变量的值。

一元线性回归和多元线性回归的区别在于,多元线性回归有(>1)个自变量,而一元线性回归通常只有1个自变量。现在的问题是:我们如何得到一个最佳的拟合线呢?

这个问题可以使用最小二乘法轻松地完成。最小二乘法也是用于拟合回归线最常用的方法。对于观测数据,它通过最小化每个数据点到线的垂直偏差平方和来计算最佳拟合线。因为在相加时,偏差先平方,所以正值和负值没有抵消。

逻辑回归(Logistic Regression)

逻辑回归是用来计算“事件=Success”和“事件=Failure”的概率。当因变量的类型属于二元(1 / 0,真/假,是/否)变量时,我们就应该使用逻辑回归。这里,Y的值从0到1,它可以用下方程表示

![]()

上述式子中,p表述具有某个特征的概率。我们为什么要在公式中使用对数log呢?

因为在这里我们使用的是的二项分布(因变量),需要选择一个对于这个分布最佳的连结函数。它就是Logit函数。在上述方程中,通过观测样本的极大似然估计值来选择参数,而不是最小化平方和误差(如在普通回归使用的)。

要点:

- 它广泛的用于分类问题。

- 逻辑回归不要求自变量和因变量是线性关系。它可以处理各种类型的关系,因为它对预测的相对风险指数OR使用了一个非线性的log转换。

为了避免过拟合和欠拟合,应该包括所有重要的变量。有一个很好的方法来确保这种情况,就是使用逐步筛选方法来估计逻辑回归。它需要大的样本量,因为在样本数量较少的情况下,极大似然估计的效果比普通的最小二乘法差。

自变量不应该相互关联的,即不具有多重共线性。然而,在分析和建模中,我们可以选择包含分类变量相互作用的影响。

- 如果因变量的值是定序变量,则称它为序逻辑回归

- 如果因变量是多类的话,则称它为多元逻辑回归

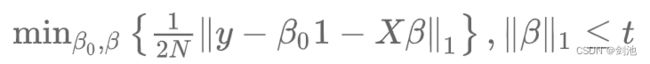

套索回归(Lasso Regression)

Lasso 也会惩罚回归系数的绝对值大小。此外,它能够减少变化程度并提高线性回归模型的精度。看看下面的公式:

Lasso 回归与Ridge回归有一点不同,它使用的惩罚函数是绝对值,而不是平方。这导致惩罚(或等于约束估计的绝对值之和)值使一些参数估计结果等于零。使用惩罚值越大,进一步估计会使得缩小值趋近于零。这将导致我们要从给定的n个变量中选择变量。

要点:

- 除常数项以外,这种回归的假设与最小二乘回归类似

- 它收缩系数接近零(等于零),确实有助于特征选择

- 这是一个正则化方法,使用的是L1正则化

如果预测的一组变量是高度相关的,Lasso 会选出其中一个变量并且将其它的收缩为零。

通过回归分析进行预测的大致步骤:

- 收集数据,判断是否可预测

数据收集是按照确定的数据分析和框架内容,有目的的收集、整合相关数据的一个过程。需要收集的数据,就是与需要预测的目标相关的数据,而且目标也是可预测的。使数据能够在后续的各分析中使用。

- 数据清洗

收集到的原始数据,往往是不能直接利用的,需要对数据进行一些处理与加工。数据清洗一般包含清除不必要的数据,清除错误的数据,填补缺失的数据,转换数据,提取或合并数据,计算与分组分类等等。数据会包含多个属性,即多个影响因素。

- 列出所有的变量

数据收集并清洗后,需要根据数据,列出所有有效的变量。

- 确定有效变量,进行相关分析,确定纳入回归方程的自变量

明确预测的具体目标,也就确定了因变量。如预测具体目标是下一年度的销售量,那么销售量Y就是因变量。通过市场调查和查阅资料,寻找与预测目标的相关影响因素,即自变量,并从中选出主要的影响因素。拿到数据后,可初步判断两个指标是否有关系,是何种关系,从而选择合适的模型。

判断关系最简单快捷的方法就是:散点图。因此拿到数据以后,可以先做散点图。初步判断因变量和自变量之间是否有明显线性关系的,是否可以用线性回归来预测。也可以采取Excel的函数CORREL计算因变量与自变量的相关系数,一般相关系数在[+0.3,-0.3]之间时,认为不相干,那么该自变量将不纳入回归方程的自变量中。

- 确定并消除多重共线性

可以使用方差膨胀因子(VIF)来判定回归方程存不存在多重共线性。判断如果存在多重共线性话,就需要进行消除多重共线性。一般如果自变量VIF小于5,表明自变量之间不存在多重共线性,不需要进行消除多重共线性的操作。

- 求解回归方程,建立预测模型

收集数据,依据自变量和因变量的历史统计资料进行计算,在此基础上建立回归分析方程,即回归分析预测模型。对于一元线性回归,列出一元线性回归方程:![]() ,进行求解。简单的话,可以通过采用Excel函数LINEST求解回归系数和截距。

,进行求解。简单的话,可以通过采用Excel函数LINEST求解回归系数和截距。

- 计算预测误差

回归预测模型是否可用于实际预测,取决于对回归预测模型的检验和对预测误差的计算。回归方程只有通过各种检验,且预测误差较小,才能将回归方程作为预测模型进行预测。

求出回归方程后,需要对回归方程进行一系列评价和评估,首先做的是确认回归方程的精度。一般使用![]() 和调整后的

和调整后的![]() 来衡量回归方程精度。一般按下面步骤进行计算:

来衡量回归方程精度。一般按下面步骤进行计算:

一般模型本身预测准不准,主要看 ![]() , 一般来说

, 一般来说![]() 越接近1,越准确;

越接近1,越准确;

- 显著性验证

显著性验证的方法一般有两种,一是测算回归方程总体显著性的F检验,二是测算回归系数个体显著性的 t 检验。

F检验测算的是回归方程的总体显著性,可以使用Excel中的数据分析工具来进行F-检验 双样本方差分析。用Excel函数FINV来计算标准的F统计值。

使用Excel函数TINV来计算标准的 t 统计值。使用函数STDEVA计算标准差。

- 计算置信区间

经过回归方程的显著性验证,然后进行计算置信区间。可以使用用Excel函数TINV+STDEVA+ SQRT来计算置信区间。用TINV函数计算t值。用STDEVA函数计算预测数据的标准差。将以上数据套入置信区间的计算公式,计算置信区间。

置信区间u=![]() ,其中t为t检验统计值,

,其中t为t检验统计值,![]() 为数据的标准差,n为数据的数量。

为数据的标准差,n为数据的数量。

- 确定预测值

利用回归预测模型计算预测值,并对预测值进行综合分析,确定最后的预测值。

根据自变量的值,代入回归方程,即可算出预测的基准结果y。如果引入置信区间u,则可以计算预测区间值y+u。