LINUX学习------Linux自动化运维——Kubernetes网络

一、k8s网络通信简介

k8s通过CNI接口接入其他插件来实现网络通讯。目前比较流行的插件有flannel,calico等。CNI插件存放位置:# cat /etc/cni/net.d/10-flannel.conflist

插件使用的解决方案如下:

虚拟网桥,虚拟网卡,多个容器共用一个虚拟网卡进行通信。

多路复用:MacVLAN,多个容器共用一个物理网卡进行通信。

硬件交换:SR-LOV,一个物理网卡可以虚拟出多个接口,这个性能最好。

- 容器间通信:同一个pod内的多个容器间的通信,通过lo即可实现;

- pod之间的通信: 同一节点的pod之间通过cni网桥转发数据包。 不同节点的pod之间的通信需要网络插件支持。

- pod和service通信: 通过iptables或ipvs实现通信,ipvs取代不了iptables,因为ipvs只能做负载均衡,而做不了nat转换。

- pod和外网通信:iptables的MASQUERADE。

- Service与集群外部客户端的通信;(ingress、nodeport、loadbalancer)

二、flannel配置

2.1、flannel网络简介

Flannel是CoreOS团队针对Kubernetes设计的一个网络规划服务,简单来说,它的功能是让集群中的不同节点主机创建的Docker容器都具有全集群唯一的虚拟IP地址。

在默认的Docker配置中,每个节点上的Docker服务会分别负责所在节点容器的IP分配。这样导致的一个问题是,不同节点上容器可能获得相同的内外IP地址。并使这些容器之间能够之间通过IP地址相互找到,也就是相互ping通。

Flannel的设计目的就是为集群中的所有节点重新规划IP地址的使用规则,从而使得不同节点上的容器能够获得“同属一个内网”且”不重复的”IP地址,并让属于不同节点上的容器能够直接通过内网IP通信。

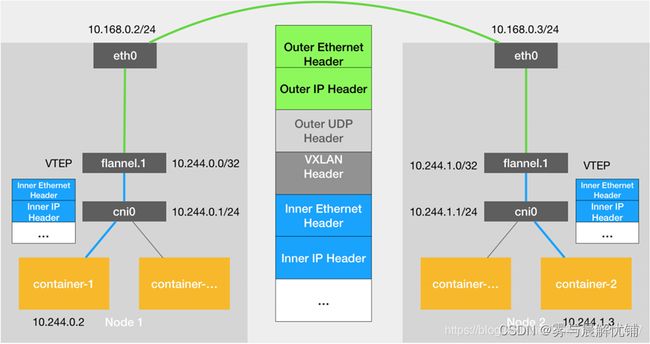

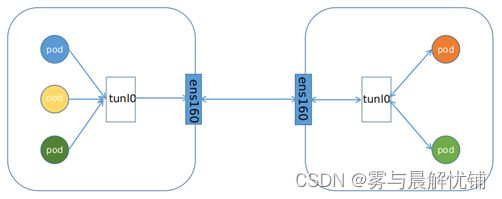

- VXLAN,即Virtual Extensible LAN(虚拟可扩展局域网),是Linux本身支持的一网种网络虚拟化技术。VXLAN可以完全在内核态实现封装和解封装工作,从而通过“隧道”机制,构建出覆盖网络(OverlayNetwork)。

- VTEP:VXLAN Tunnel End Point(虚拟隧道端点),在Flannel中VNI的默认值是1,这也是为什么宿主机的VTEP设备都叫flannel.1的原因。

- Cni0: 网桥设备,每创建一个pod都会创建一对 vethpair。其中一端是pod中的eth0,另一端是Cni0网桥中的端口(网卡)。

- Flannel.1:TUN设备(虚拟网卡),用来进行 vxlan报文的处理(封包和解包)。不同node之间的pod数据流量都从overlay设备以隧道的形式发送到对端。

- Flanneld:flannel在每个主机中运行flanneld作为agent,它会为所在主机从集群的网络地址空间中,获取一个小的网段subnet,本主机内所有容器的IP地址都将从中分配。同时Flanneld监听K8s集群数据库,为flannel.1设备提供封装数据时必要的mac、ip等网络数据信息。

2.2、flannel网络原理

- 当容器发送IP包,通过veth pair发往cni网桥,再路由到本机的flannel.1设备进行处理。

- VTEP设备之间通过二层数据帧进行通信,源VTEP设备收到原始IP包后,在上面加上一个目的MAC地址,封装成一个内部数据帧,发送给目的VTEP设备。

- 内部数据桢,并不能在宿主机的二层网络传输,Linux内核还需要把它进一步封装成为宿主机的一个普通的数据帧,承载着内部数据帧通过宿主机的eth0进行传输。

- Linux会在内部数据帧前面,加上一个VXLAN头,VXLAN头里有一个重要的标志叫VNI,它是VTEP识别某个数据桢是不是应该归自己处理的重要标识。

- flannel.1设备只知道另一端flannel.1设备的MAC地址,却不知道对应的宿主机地址是什么。在linux内核里面,网络设备进行转发的依据,来自FDB的转发数据库,这个flannel.1网桥对应的FDB信息,是由flanneld进程维护的。

- linux内核在IP包前面再加上二层数据帧头,把目标节点的MAC地址填进去,MAC地址从宿主机的ARP表获取。

- 此时flannel.1设备就可以把这个数据帧从eth0发出去,再经过宿主机网络来到目标节点的eth0设备。目标主机内核网络栈会发现这个数据帧有VXLAN

Header,并且VNI为1,Linux内核会对它进行拆包,拿到内部数据帧,根据VNI的值,交给本机flannel.1设备处理,flannel.1拆包,根据路由表发往cni网桥,最后到达目标容器。

2.3、flannel配置

flannel支持多种后端:

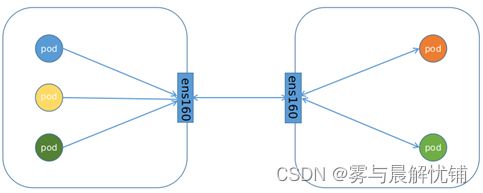

Vxlan:

vxlan ##报文封装,默认

Directrouting ##直接路由,跨网段使用vxlan,同网段使用host-gw模式。

host-gw: ##主机网关,性能好,但只能在二层网络中,不支持跨网络, 如果有成千上万的Pod,容易产生广播风暴,不推荐

UDP: ##性能差,不推荐

server2

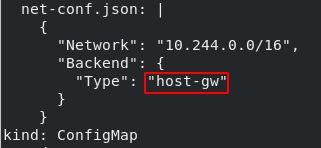

kubectl -n kube-system edit cm kube-flannel-cfg ## 查找并修改kube-flannel-cfg配置文件,将type由vxlan改为host-gw直连模式

net-conf.json: |

{

"Network": "10.244.0.0/16",

"Backend": {

"Type": "host-gw"

}

}

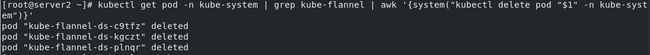

kubectl get pod -n kube-system | grep kube-flannel | awk '{system("kubectl delete pod "$1" -n kube-system")}' ## 删除节点副本,重新生成的节点会读取修改后的配置文件并生效。

vim deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: deployment-nginx

spec:

replicas: 3

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: myapp:v1

readinessProbe:

httpGet:

path: /hostname.html

port: 80

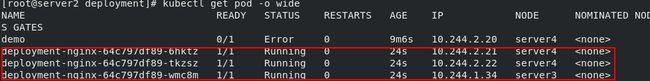

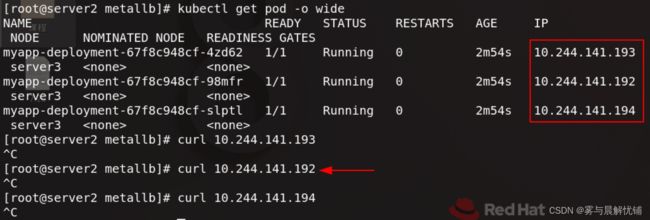

kubectl get pod -o wide

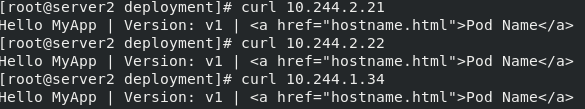

pod访问pod

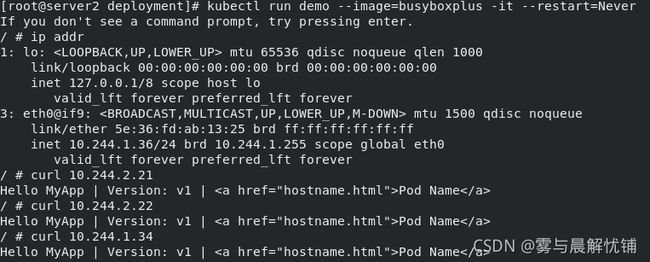

kubectl run demo --image=busyboxplus -it --restart=Never

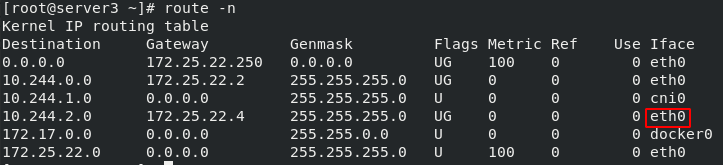

查看server3目的地是10.244.0.0/24网段的数据由server2作为网关,目的地是10.244.2.0/24网段的数据由server4作为网关

route -n

三、metallb

3.1、metallb简介

参考网址:https://metallb.universe.tf/

为什么使用metallb?

Kubernetes不提供网络负载均衡器的实现(LoadBalancer类型的服务)用于裸机集群。Kubernetes附带的Network

LB的实现都是调用各种IaaS平台(GCP,AWS,Azure等)的粘合代码。如果您未在受支持的IaaS平台(GCP,AWS,Azure等)上运行,则LoadBalancers在创建时将无限期保持“待处理”状态。

裸机集群运营商只剩下两个较小的工具,即“ NodePort”和“ externalIPs”服务,可将用户流量引入其集群。这两个选项在生产用途上都有很大的缺点,这使裸金属集群成为Kubernetes生态系统中的二等公民。

MetalLB旨在通过提供与标准网络设备集成的Network LB实现来解决这种不平衡问题,从而使裸机群集上的外部服务也尽可能“正常运行”。

3.2、metallb部署

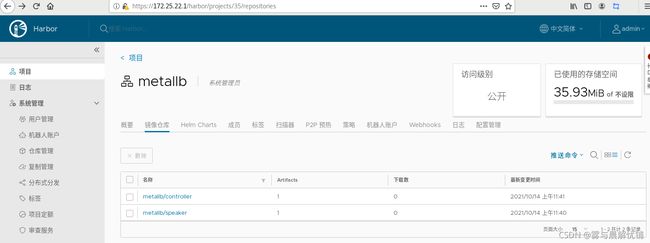

我们需要提前将镜像下载好,平且上传至私有仓库

server1

docker load -i metallb-v0.10.3.tar

wget https://raw.githubusercontent.com/metallb/metallb/v0.10.3/manifests/namespace.yaml ##官网获取配置文件

wget https://raw.githubusercontent.com/metallb/metallb/v0.10.3/manifests/metallb.yaml

docker push reg.westos.org/metallb/speaker:v0.10.3

docker push reg.westos.org/metallb/controller:v0.10.3

server2

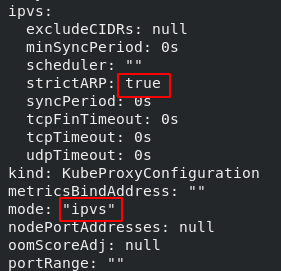

如果您在IPVS模式下使用kube-proxy,则从Kubernetes v1.14.2开始,您必须启用严格的ARP模式。

请注意,如果您将kube-router用作服务代理,则不需要此设置,因为默认情况下它启用了严格的arp。

您可以通过在当前集群中编辑kube-proxy配置来实现:

kubectl edit configmaps -n kube-system kube-proxy

ipvs:

excludeCIDRs: null

minSyncPeriod: 0s

scheduler: ""

strictARP: true

syncPeriod: 0s

tcpFinTimeout: 0s

tcpTimeout: 0s

udpTimeout: 0s

kind: KubeProxyConfiguration

metricsBindAddress: ""

mode: "ipvs"

kubectl get pod -n kube-system | grep kube-proxy | awk '{system("kubectl delete pod "$1" -n kube-system")}' ##更新kube-proxy pod

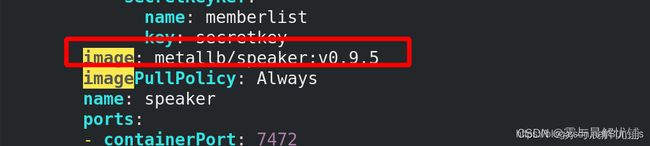

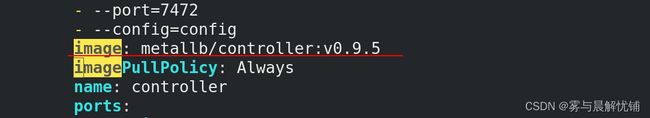

vim metallb.yaml

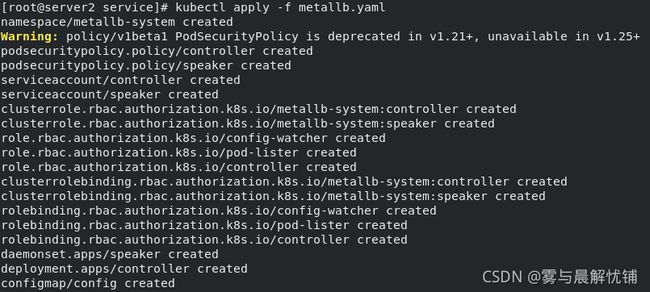

kubectl apply -f metallb.yaml

[root@server2 metallb]# vim config.yml

apiVersion: v1

kind: ConfigMap

metadata:

namespace: metallb-system

name: config

data:

config: |

address-pools:

- name: default

protocol: layer2

addresses:

- 172.25.1.100-172.25.1.200

[root@server2 metallb]# kubectl apply -f config.yml

创建一个svc进行测试

kubectl apply -f lb-svc.yaml

vim lb-svc.yaml

apiVersion: v1

kind: Service

metadata:

name: lb-nginx

spec:

ports:

- name: http

port: 80

targetPort: 80

selector:

app: nginx

type: LoadBalancer

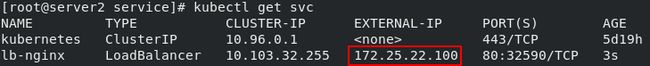

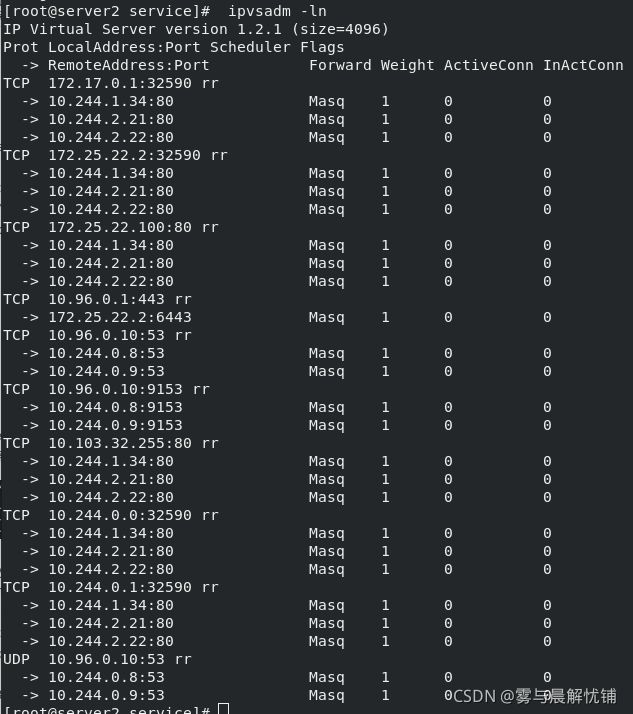

kubectl get svc

curl 172.25.22.100

curl 172.25.22.100/hostname.html ##负载均衡

四、Ingress

4.1、ingress简介

单独用service暴露服务的方式,在实际生产环境中不太合适

ClusterIP的方式只能在集群内部访问。 NodePort方式的话,测试环境使用还行,当有几十上百的服务在集群中运行时,NodePort的端口管理是灾难。 LoadBalance方式受限于云平台,且通常在云平台部署ELB还需要额外的费用。

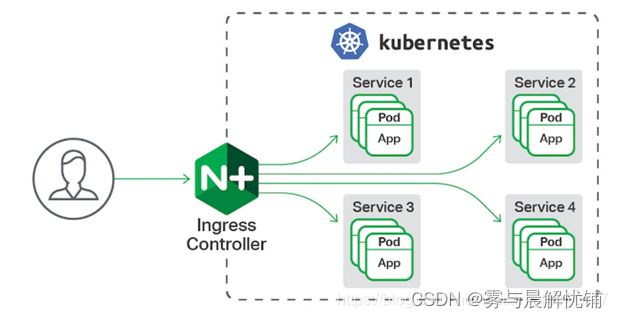

ingress可以简单理解为service的service,他通过独立的ingress对象来制定请求转发的规则,把请求路由到一个或多个service中。这样就把服务与请求规则解耦了,可以从业务维度统一考虑业务的暴露,而不用为每个service单独考虑。

Kubernetes 里的Ingress 服务是一种全局的、为了代理不同后端Service 而设置的负载均衡服务。Ingress由两部分组成:Ingress controller和Ingress服务。 Ingress Controller会根据你定义的Ingress 对象,提供对应的代理能力。业界常用的各种反向代理项目,比如Nginx、HAProxy、Envoy、Traefik 等,都已经为Kubernetes 专门维护了对应的IngressController。

4.2、ingress部署

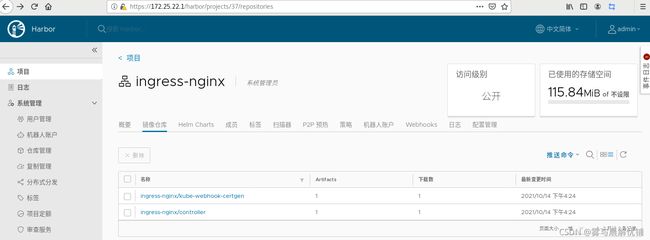

server1

docker load -i ingress-nginx-v1.0.3.tar

docker push reg.westos.org/ingress-nginx//controller:v1.0.3

docker push reg.westos.org/ingress-nginx/kube-webhook-certgen:v1.0

server2

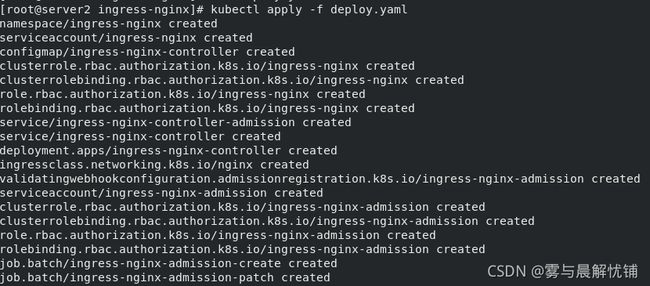

wget https://raw.githubusercontent.com/kubernetes/ingress-nginx/controller-v1.0.4/deploy/static/provider/cloud/deploy.yaml

vim /root/ingress-nginx/deploy.yaml

image: ingress-nginx/controller:v1.0.3

image: ingress-nginx/kube-webhook-certgen:v1.0

kubectl apply -f deploy.yaml

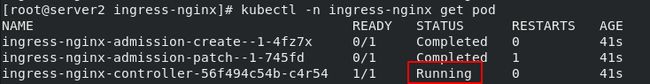

kubectl get pod -n ingress-nginx

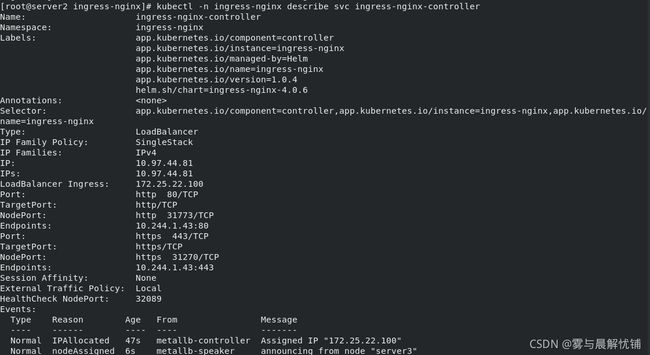

kubectl -n ingress-nginx describe svc ingress-nginx-controller

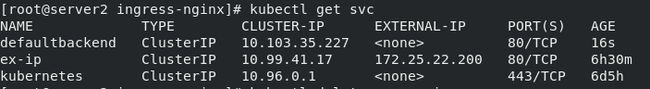

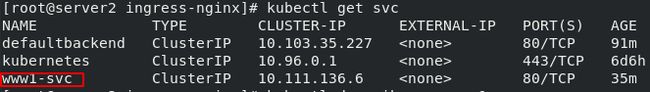

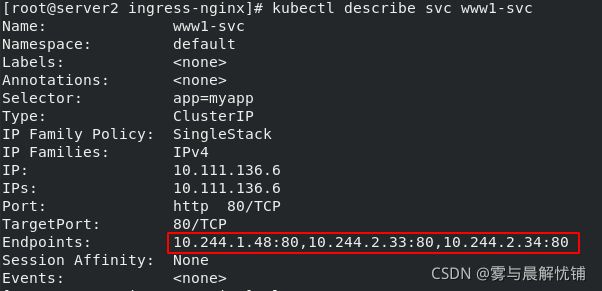

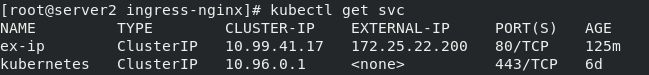

kubectl get svc

kubectl get svc

vim backend.yaml

kubectl apply -f backend.yaml

kubectl get svc

kubectl apply -f inress-default.yaml

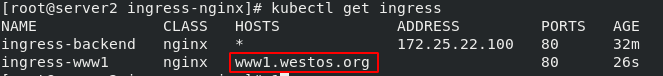

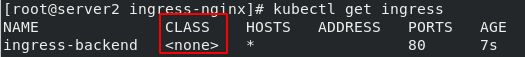

kubectl get ingress

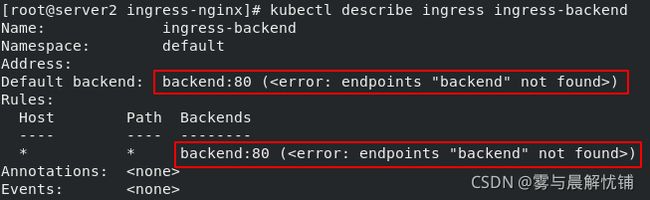

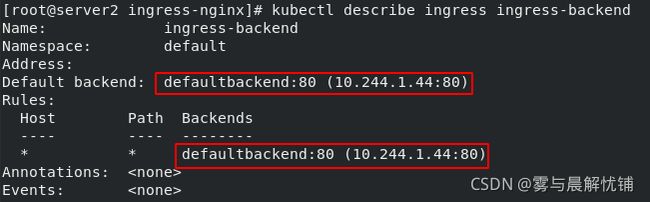

kubectl describe ingress ingress-backend

vim inress-default.yaml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: ingress-backend

spec:

#ingressClassName: nginx

defaultBackend:

service:

name: defaultbackend

port:

number: 80

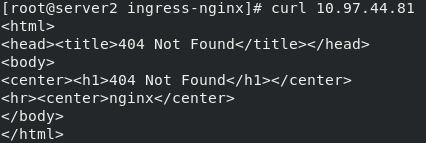

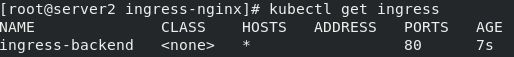

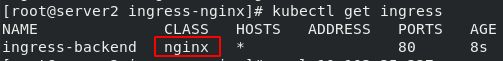

kubectl get ingress

kubectl describe ingress ingress-backend

kubectl -n ingress-nginx get svc

kubectl -n ingress-nginx get svc

vim inress-default.yaml

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: ingress-backend

spec:

ingressClassName: nginx

defaultBackend:

service:

name: defaultbackend

port:

number: 80

kubectl delete -f inress-default.yaml

kubectl apply -f inress-default.yaml

kubectl get ingress

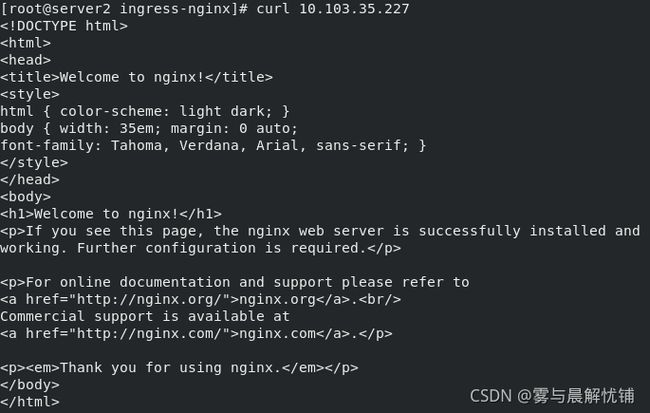

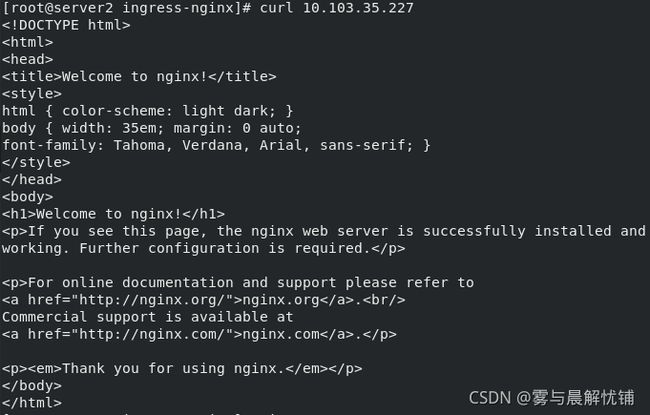

curl 10.103.35.227

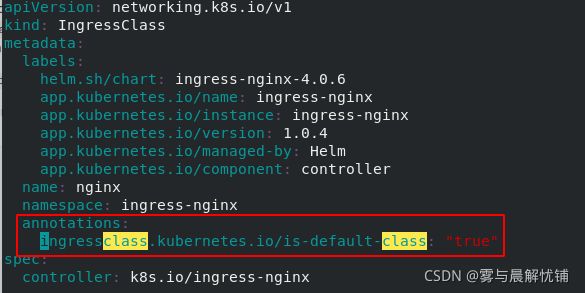

vim deploy.yaml

annotations:

ingressclass.kubernetes.io/is-default-class: “true”

vim inress-default.yaml

kubectl apply -f inress-default.yaml

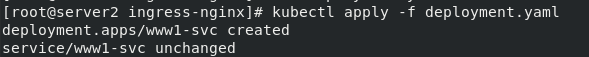

vim deployment.yaml

kubectl apply -f deployment.yaml

vim ingress-www1.yaml

kubectl apply -f ingress-www1.yaml

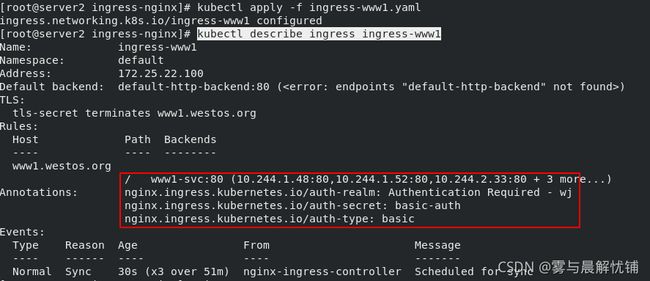

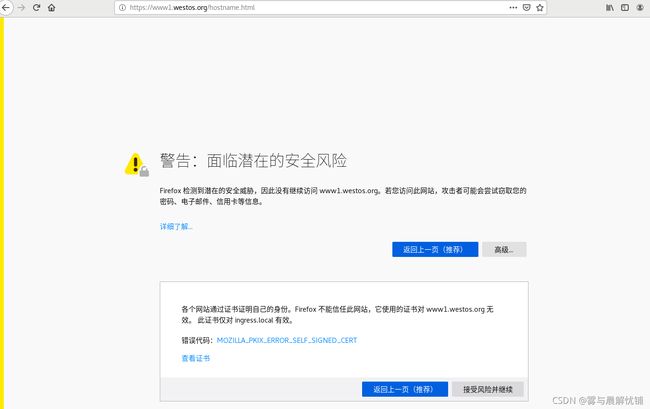

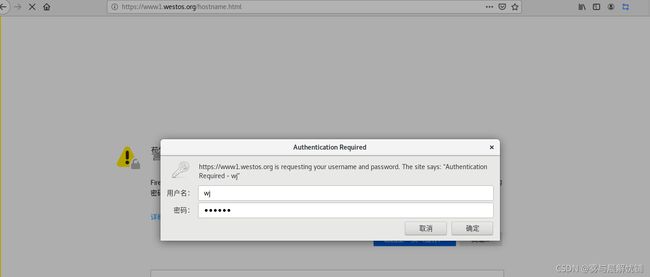

4.3、Ingress 认证

yum install -y httpd-tools

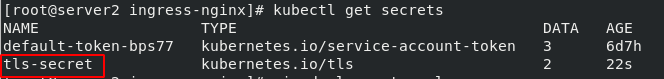

openssl req -x509 -sha256 -nodes -days 365 -newkey rsa:2048 -keyout tls.key -out tls.crt -subj “/CN=nginxsvc/O=nginxsvc”

kubectl create secret tls tls-secret --key tls.key --cert tls.crt

htpasswd -c auth wj

vim deployment.yaml

kubectl apply -f ingress-www1.yaml

kubectl describe ingress ingress-www1

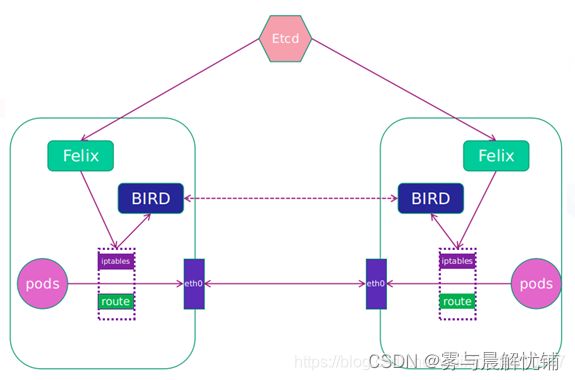

五、calico网络插件

5.1、calico简介

- flannel实现的是网络通信,calico的特性是在pod之间的隔离。

- 通过BGP路由,但大规模端点的拓扑计算和收敛往往需要一定的时间和计算资源。

- 纯三层的转发,中间没有任何的NAT和overlay,转发效率最好。

- Calico 仅依赖三层路由可达。Calico 较少的依赖性使它能适配所有 VM、Container、白盒或者混合环境场景。

网络架构:

Felix:监听ECTD中心的存储获取事件,用户创建pod后,Felix负责将其网卡、IP、MAC都设置好,然后在内核的路由表里面写一条,注明这个IP应该到这张网卡。同样如果用户制定了隔离策略,Felix同样会将该策略创建到ACL中,以实现隔离。

BIRD:一个标准的路由程序,它会从内核里面获取哪一些IP的路由发生了变化,然后通过标准BGP的路由协议扩散到整个其他的宿主机上,让外界都知道这个IP在这里,路由的时候到这里来。

工作模式:

- IPIP工作模式:适用于互相访问的pod不在同一个网段中,跨网段访问的场景。

5.2、calico的安装部署

官网:https://docs.projectcalico.org/getting-started/kubernetes/self-managed-onprem/onpremises

获取calico.yaml和calico的压缩包

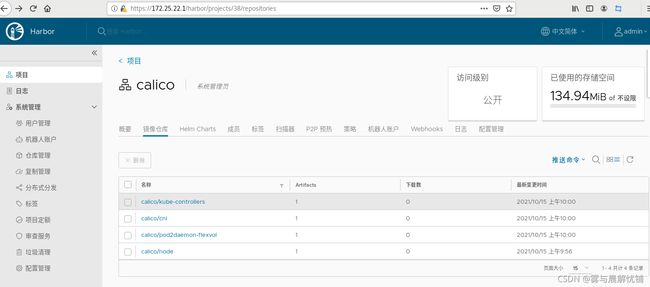

**server1**

docker load -i calico-v3.20.2.tar

docker images | grep calico | awk '{system("docker tag "$1":"$2" reg.westos.org/"$1":"$2"")}'

docker push reg.westos.org/calico/pod2daemon-flexvol:v3.20.2

docker push reg.westos.org/calico/node:v3.20.2

docker push reg.westos.org/calico/kube-controllers:v3.20.2

docker push reg.westos.org/calico/cni:v3.20.2

cd /etc/cni/net.d/ ##server1 server2 server3

rm -fr *

kubectl -n kube-system delete pod --all

kubectl delete svc --all

kubectl delete ingress --all

ubectl delete deployments.apps --all

kubectl delete -f .kube-flannel.yml

将镜像路径设置为自己的harbor仓库的路径,把CALICO_IPV4POOL_IPIP功能关闭

vim calico.yaml

- name: CALICO_IPV4POOL_IPIP

value: "off" ##关闭隧道模式

# Enable or Disable VXLAN on the default IP pool.

- name: CALICO_IPV4POOL_VXLAN

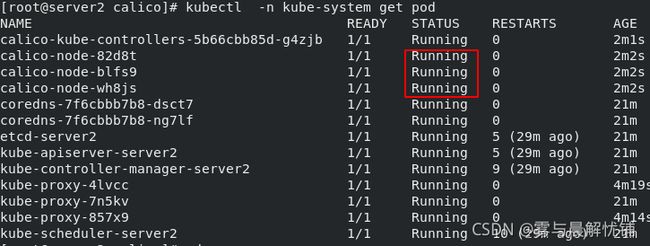

kubectl apply -f calico.yaml

kubectl -n kube-system get pod

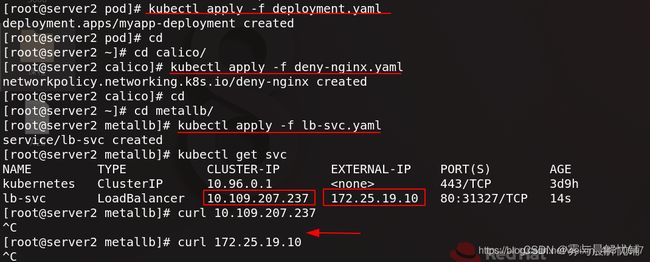

5.3、实验

1、限制访问指定服务

编辑deny-nginx.yaml配置文件

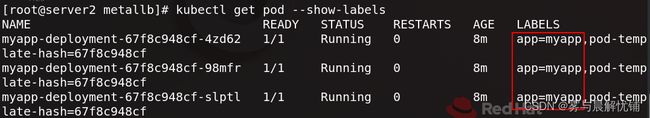

要进行限制访问的是标签为myapp的pod容器

vim nginx-policy.yml

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: deny-nginx

spec:

podSelector:

matchLabels:

app: myapp

应用下列yaml配置文件,查看服务,看到lb-svc的集群ip和外部访问ip,对这两个地址测试访问,发现访问失败

kubectl apply -f deployment.yaml

查看pod信息并输出所在的节点,访问pod所在节点的ip地址,依然访问失败

2、禁止 namespace 中所有 Pod 之间的相互访问

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: default-deny

namespace: default

spec:

podSelector: {}

3、允许外网访问服务

vim policy2.yaml

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: default-deny

namespace: default

spec:

podSelector:

matchLables:

ingress:

- from:

- podSelector: {}

---

kind: NetworkPolicy

apiVersion: networking.k8s.io/v1

metadata:

name: web-allow-external

spec:

podSelector:

matchLabels:

app: myapp

ingress:

- ports:

- port: 80

from: []

kubectl apply -f policy2.yaml

真机访问 curl 172.25.22.101

4、除了 172.25.0.0/24 之外的所有 172.25.0.0/16可访问

vim policy2.yaml

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: default-deny

namespace: default

spec:

podSelector:

matchLables:

ingress:

- from:

- podSelector: {}

---

kind: NetworkPolicy

apiVersion: networking.k8s.io/v1

metadata:

name: web-allow-external

spec:

podSelector:

matchLabels:

app: myapp

ingress:

- from:

- ipBlock:

cidr: 172.25.0.0/16

except:

- 172.25.0.0/24

ports:

- port: 80

5、 禁止其他 namespace 访问服务

kind: NetworkPolicy

apiVersion: networking.k8s.io/v1

metadata:

name: deny-namespace

spec:

podSelector:

matchLabels:

ingress:

- from:

- podSelector: {}

6、只允许指定namespace访问服务

kind: NetworkPolicy

apiVersion: networking.k8s.io/v1

metadata:

name: access-namespace

spec:

podSelector:

matchLabels:

app: myapp

ingress:

- from:

- namespaceSelector:

matchLabels:

role: prod