《Kubernetes监控篇:Kubernetes集群blackbox-exporter监控实战(方案一)》

文章目录

- 一、简介

- 二、部署方案

- 三、部署blackbox-exporter

-

- 3.1、资源下载

- 3.2、资源说明

- 3.3、部署blackbox-exporter

- 四、部署prometheus

-

- 4.1、资源下载

- 4.2、资源说明

- 4.3、部署prometheus

- 五、测试用例说明

- 六、部署blackbox-exporter数据源

- 六、导入Grafana模板

- 七、钉钉告警通知

- 总结:整理不易,如果对你有帮助,可否点赞关注一下?

一、简介

blackbox_exporter是Prometheus官方提供的exporter 之一,可以提供 http、dns、tcp、icmp的监控数据采集。

1、HTTP测试

定义Request Header信息

判断Http status/Http Respones Header/Http Body内容

2、TCP测试

业务组件端口状态监听

应用层协议定义与监听

3、ICMP测试

主机探活机制

4、POST测试

接口联通性

5、SSL证书过期时间

二、部署方案

1、针对小型K8S环境集群环境,监控的目标范围比较小,可以使用 static_configs静态配置的方式来获取数据。

2、针对大型K8S环境集群环境,监控的目标范围比较大,建议使用 file_sd_configs文件自动发现或者 kubernetes_sd_configs以service的方式自动采集数据。

3、file_sd_configs方式可以监控非K8S集群环境的服务。

部署前请参考如下链接,这里的部署文档是基于上述环境。

请参考:《Kubernetes监控篇:Prometheus+Grafana+Alertmanager监控K8S集群实战》

这里主要介绍 kubernetes_sd_configs的方式来采集监控指标数据。

三、部署blackbox-exporter

3.1、资源下载

K8S监控blackbox-exporter镜像及资源清单文件

亲自整理手动编写,资源列表如下所示:

![]()

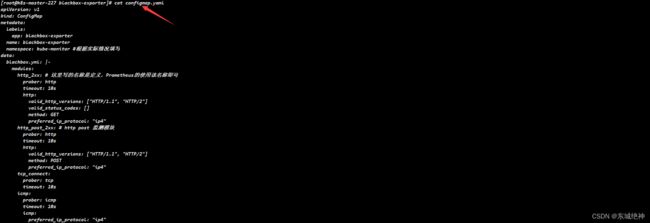

configmap文件部分类容如下所示:

说明:资源里的yaml文件里花了大量时间整理并做了详细的注释,这里由于文件内容过多,无法一一展示,仅部分内容展示,如果需要全部资料,请通过上述链接下载。

3.2、资源说明

说明:部署前请仔细查看yaml文件,并根据自己环境实际情况对一些参数进行修改。

1、修改service.yaml文件中的nodePort: 31003字段,可以根据自己K8S集群环境定义的service端口范围设置。

2、针对不同环境,建议对deploymeng.yaml文件中定义的resource.limits和resource.requests的cpu和内存进行合理化配置。

3.3、部署blackbox-exporter

#1、将镜像导入到所有K8S集群主机上,master节点和worker节点

[root@k8s-master-227 blackbox-exporter]# docker load -i blackbox-exporter.tar.gz

#2、在master节点上执行yaml文件部署

[root@k8s-master-227 blackbox-exporter]# kubectl apply -f .

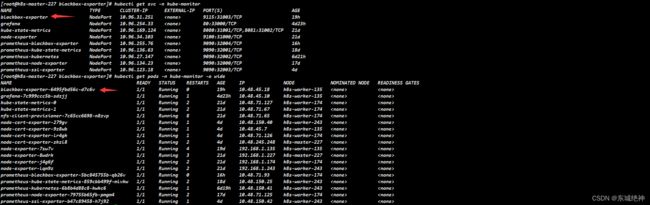

如下图所示:

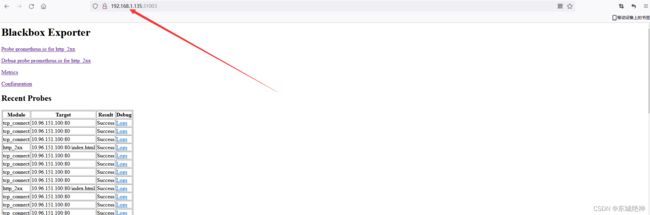

说明:通过上述截图可以看到blackbox-exporter调度到k8s-worker-135主机上,映射宿主机端口为31003。可以在浏览器上输入http://192.168.1.135:31003/查看,如下图所示:

四、部署prometheus

4.1、资源下载

K8S主机Prometheus监控blackbox-exporter(kubernetes_sd_files)资源清单及镜像文件

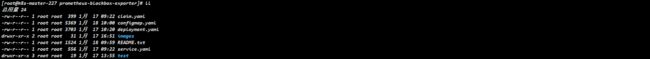

亲自整理手动编写,资源列表如下所示:

configmap文件部分类容如下所示:

说明:资源里的yaml文件里花了大量时间整理并做了详细的注释,这里由于文件内容过多,无法一一展示,仅部分内容展示,如果需要全部资料,请通过上述链接下载。

4.2、资源说明

说明:部署前请仔细查看yaml文件,并根据自己环境实际情况对一些参数进行修改。

1、修改claim.yaml文件中的storage: 20Gi,建议根据实际情况填写存储大小空间,nfs不支持pvc在线扩容,生成环境一定要谨慎评估,条件允许情况下建议使用分布式存储ceph,支持在线扩容pvc。

2、修改configmap.yaml文件,[“192.168.1.227:9001”,“192.168.1.227:9002”,“192.168.1.227:9003”],这里配置的是alertmanager服务的ip和监听端口,当前环境因为是服务器有限,部署为同一台主机,建议生成环境分三台主机部署alertmanager,并根据实际情况填写。

3、默认nodePort: 32004,根据实际情况修改,这里采用NodePort方式暴露端口让prometheus服务可以被集群外部访问

4、yaml文件定义的namespace是kube-monitor,如果你不太会修改yaml文件,建议不要修改,因为涉及到的不仅仅是prometheus-ssl-exporter,其它所有的服务我这里都是统一放到kube-monitor名称空间下的,方便查看及统一标准。

5、告警规则文件参考https://awesome-prometheus-alerts.grep.to/rules,可直接搜索node-exporter会出现关于node-exporter指标的监控规则内容。

4.3、部署prometheus

1、执行yaml文件

![]()

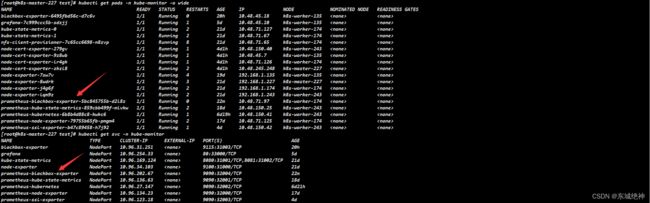

2、查看prometheus服务

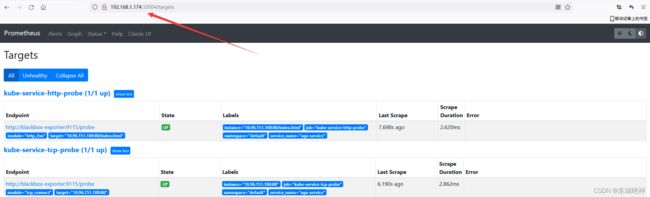

3、浏览器输入http://192.168.1.174:32004/targets,查看target

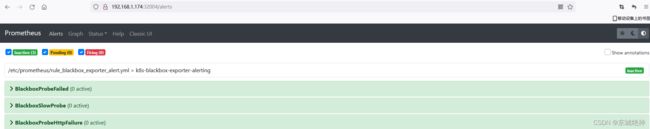

4、查看Alerts

5、alert指标参数详解

BlackboxProbeFailed 探测是否成功

BlackboxSlowProbe 探测返回时间

probe_http_status_code 探测返回状态码

6、查看监控数据

说明:如上所示则表明Prometheus已经采集到了blackbox-exporter相关数据。

五、测试用例说明

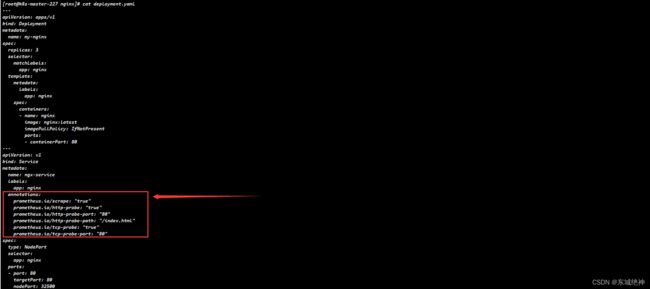

如果你希望能自动发现自定义服务的监控目标,应用侧的service的annotation段需要进行配置,如下图所示:

如果需要监控http和tcp,则只需添加如下内容

prometheus.io/scrape: "true"

prometheus.io/http-probe: "true"

prometheus.io/http-probe-port: "80" #监控服务的端口,根据实际情况填写

prometheus.io/http-probe-path: "/index.html" #监控服务接口的地址,如果域名上下文不是为/的话,则写为/index.html

prometheus.io/tcp-probe: "true"

prometheus.io/tcp-probe-port: "80" #监控服务的探测端口,根据实际情况填写,这里监控的是nginx,定义的service port为80

如果只需要监控http,则只需添加如下内容

prometheus.io/scrape: "true"

prometheus.io/http-probe: "true"

prometheus.io/http-probe-port: "80" #监控服务的端口,根据实际情况填写

prometheus.io/http-probe-path: "/index.html" #监控服务接口的地址,如果域名上下文不是为/的话,则写为/index.html

如果只需要监控tcp,则只需添加如下内容

prometheus.io/scrape: "true"

prometheus.io/tcp-probe: "true"

prometheus.io/tcp-probe-port: "80" #监控服务的探测端口,根据实际情况填写,这里监控的是nginx,定义的service port为

六、部署blackbox-exporter数据源

说明:在Grafana中添加 DataSource,域名使用service name prometheus-blackbox-exporter即可,这样可以通过内网去访问,即使prometheus-blackbox-exporter调度到另外一台主机也不影响数据的接入。

service name如下图红色箭头所示:

http url如下图所示:

六、导入Grafana模板

K8S集群服务接口监控模板

七、钉钉告警通知

总结:整理不易,如果对你有帮助,可否点赞关注一下?

更多详细内容请参考:企业级K8s集群运维实战