Hadoop伪分布式集群的搭建

一、准备虚拟机

1.从网上将VMware下载下来

https://www.vmware.com/content/dam/digitalmarketing/vmware/en/images/gallery/banners/content/hero-generic-1400x350.jpg

2.下载centos

https://mirrors.tuna.tsinghua.edu.cn/centos/7.9.2009/isos/x86_64/

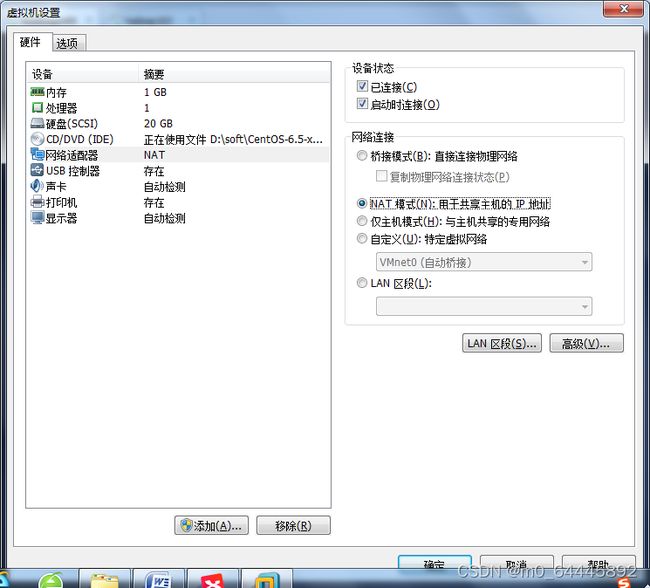

二、配置网络,设置网卡

1.将下载好的centos安装好后,点击左上角上的编辑->找到虚拟网络编辑器并进行点击

1)内存一般选用2GB

2)处理器根据自身的PC机而定,不能超过16

3)CD/DVD选择安装的镜像

2.设置防火墙

systemctl status firewalld.service ### 查看防火墙状态

systemctl stop firewalld.service ### 关闭防火墙

systemctl disable firewalld.service ####开机关闭防火墙

systemctl status firewalldservice ####查看防火墙状态,能看到(dead)说明设置成功

3.设置网卡

1.查看IP地址

ip addr

2.设置网卡

vi /etc/sysconfig/network-scripts/ifcfg-ens33

将BOOTPROTO=dhcp和ONBOOT = no改成

BOOTPROTO=static

ONBOOT = yes

并在下边添加

IPADDR=192.168.30.104

NETMASK=255.255.255.0

GATEWAY=192.168.30.2

DNS1=119.29.29.29

DNS2=8.8.8.8

3.设置网卡成功后需重启网卡,并检查

systemctl restart network #重启网卡

ip addr ## 检查是否配置成功

4.设置主机

1.更改主机名

vi /etc/hostname

修改成你想改成的名称

对其添加

vi /etc/hosts ##回车后对其后边添加

192.168.30.104 hadoop104

保存。

主机名需要保存才能重启。

如果需要安装桌面的话能用命令

ping www.baidu.com ###检查是否连接网络,Ctrl+C退出

yum groupinstall -y "GNOME Desktop" # 安装桌面

如果yum命令不能使用,将ONBOOT = no改为yes即可

重启命令

reboot

三、安装jdk和Hadoop

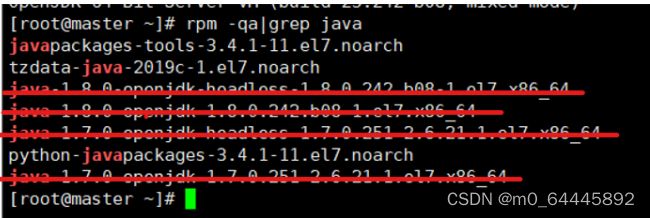

1.删除系统自带的jdk

查询版本,

rpm -qa | grep java

将Java的四个文件删除即可

使用下面命令进行删除

rpm -e --nodeps java____

2.安装jdk

在网上下载jdk-Linux版本的jdk

将下载过的jdk上传到Linux系统上

进入/opt文件夹下,创建两个文件夹

cd /opt/ ###进入/opt文件夹目录下

mkdir source ####创建source文件夹,放置源文件

mkdir module #### 创建module文件夹,放置解压后的文件

#使用这个命令进行上传

rz

对上传的文件进行解压使用命令

tar -zxvf 文件名

3.安装Hadoop

和安装jdk同理,先用rz进行文件上传,再使用tar -zxvf 文件名。进行解压得到安装后的文件

4.移动

将jdk移动到module中

mv jdk1.8.0.131/ jdk1.8 #修改文件名为jdk1.8

mvv jdk1.8 ../module #将文件jdk1.8移动到module文件中

mv hadoop2.7.2 ../module ##将解压后的文件hadoop2.7.2移动到文件module中

四、配置文件

1.对安装后的hadoop和jdk进行文件配置

修改profile文件

vi /etc/profile

在其下面添加

export PATH

export JAVA_HOME=/opt/module/jdk1.8

export PATH=$JAVA_HOME/bin:$PATH

export HADOOP_HOME=/opt/module/hadoop-2.7.2

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

使用命令

source /etc/profile #使配置为文件立即生效

2.对安装后的hadoop进行检测

先进入hadoop2.7.2文件夹下

mkdir input

cp etc/hadoop/*.xml input

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar grep input output 'dfs[a-z.]+'

cat output/*

以上执行的代码输出结果为

1 dfsadmin

到这里hadoop安装并启动成功

3.配置集群

1.配置五个文件

现需要进入hadoop2.7.2/etc/hadoop目录下

1)修改JAVA_HOME路径,在前面已经修改过了,不在过多阐述。

2)获取jdk的安装路径

echo $JAVA_HOME

结果为

/opt/module/jdk1.8

3)配置hadoop-env.sh文件

在The java implementation to use.下面改为:将#去掉并,

export JAVA_HOME=/opt/module/jdk1.8

4)配置core-site.xml文件

vi core-site.xml

在其下面添加

fs.defaultFS

hdfs://hadoop104:9000

hadoop.tmp.dir

/opt/module/hadoop-2.7.2/data/tmp

5)配置hdfs-site.xml 文件

vi hdfs-site.xml

在其下面添加

dfs.replication

1

五、设置自身免密登录

登录自身节点

[root@master ~]# ssh root@192.168.30.104 #需要输入密码

[root@master ~]# cd .ssh #进入节点

[root@master ssh]# ssh-keygen -t rsa # 生成公匙和私匙

执行上面命令后,敲击三个回车,中间不输入任何内容,在.ssh目录下会生成两个文件id_rsa(私匙),id_rsa.put(公匙)

将生成的公匙创建并拷贝到authorized_keys文件中,实现了免密登录。

cat id_rsa.pub >>authorized_keys

ssh hadoop104 #实现自身的登录

exit ##退出自身的登录

六、启动集群

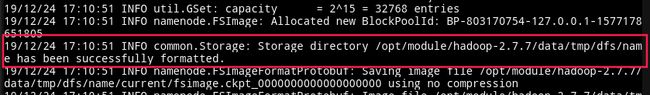

格式化namenode(第一次启动时格式化,以后不能经常格式化)

格式化命令

[root@hadoop104 hadoop-2.7.2]# bin/hdfs namenode -format

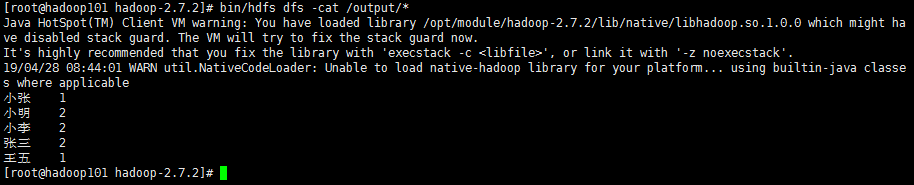

七、在集群上测试一个包,单词统计的功能

1.进入/hadoop2.7.2/目录下,创建word.txt文件

touch word.txt

vi word.txt #编写文件

输入

小明 小张 小李 小明

张三 王五 张三 小李

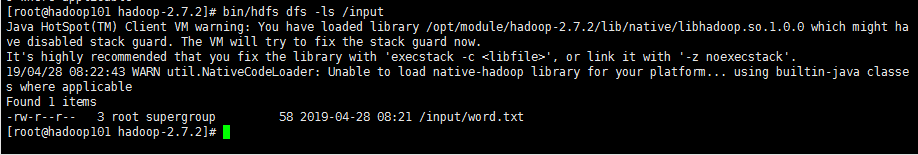

2.在hadoop2.7.2目录下创建一个input文件夹启动dfs

start-dfs.sh

jps

bin/hdfs dfs -mkdir /input

把word.txt上传到服务器中的input文件夹中

bin/hdfs dfs -mkdir /input

查看是否上传成功

bin/hdfs dfs -ls /input

bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount /input /output

在服务器就创建了一个output文件夹,查看文件bin/hdfs dfs -ls /output

输出output文件的内容

bin/hdfs dfs -cat /output/*

bin/hdfs dfs -rm -r /output

删除ouput文件夹的件part-r-00000文件:

bin/hdfs dfs -rm /output/ part-r-00000

若不能删除part-r-00000文件,可以在output文件夹里面找到part-r-00000,再执行删除命令。

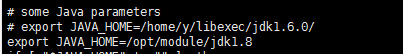

八、在YANG上运行MapReduce程序

1.配置yarn-env.sh文件。

温馨提示:这些步骤需要进入hadoop2.7.2/etc/hadoop/目录下。

vi yarn-env.sh

将some Java parameters下面的内容改为

2.配置yarn-site.xml文件

在添加内容添加:

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.hostname

hadoop104

3.配置mapred- site.sh文件

hadoop目录下没有这个文件需要修改一下

cp mapred-site.xml.template mapred-site.xml ### 拷贝并命名

vi mapred-site.xml

在添加内容添加:

mapreduce.framework.name

yarn

4.配置mapred-env.sh

vi mapred-env.sh

配置为:

export JAVA_HOME=/opt/module/jdk1.8

九、启动集群

在hadoop2.7.2目录下启动

sbin/start-yarn.sh

jps

到这里hadoop的伪分布式搭建已基本完成,谢谢您的观看!