【一起啃书】《机器学习》第一章 绪论 + 第二章 模型评估与选择

第一章 绪论

1.机器学习:研究如何通过计算的手段,利用经验来改善系统自身的性能。在计算机系统中,”经验“通常以“数据”的形式存在,所以机器学习研究的主要内容也是如何通过这些数据产生一个模型,进而通过这个模型为我们提供相应的判断。

2.基本术语:数据集、示例(样本)、属性(特征)、属性值、属性空间(样本空间、输入空间)、特征向量、学习(训练)、训练数据(训练集)、训练样本、学习器、标记空间(输出空间)、分类、回归、聚类、监督学习、无监督学习、正类、反类、多分类、测试集、泛化能力、假设空间、版本空间。

3.归纳偏好:机器学习算法在学习过程中对某种类型假设的偏好。任何一个有效的机器学习算法必有其归纳偏好,否则它将被假设空间中看似在训练集上“等效”的假设所迷惑,而无法产生确定的学习结果。

4.奥卡姆剃刀原则:若有多个假设与观察一致,则选最简单的那个。

5.没有免费的午餐:对于基于迭代的最优化算法,不存在某种算法对所有问题(有限的搜索空间内)都有效。如果一个算法对某些问题有效,那么它一定在另外一些问题上比纯随机搜索算法更差。

6.训练集、测试集和验证集的区别与联系

在机器学习任务中,训练集、测试集和验证集是将数据集划分为三个部分的一种方法。训练集用于训练模型内部参数,验证集用于选择模型(选择超参数),测试集用于测试所选模型的结果。其中,训练集和测试集是必须的,而验证集是可选的,如果没有设置验证集,通常得等到测试集才可以知道训练之后的模型效果如何,然后再来调整超参数,这样时间代价较高,通过验证集可以训练几个epoch后查看模型的训练效果,然后决定怎么调整超参数。所以,训练集用于训练模型,测试集用于评估模型的性能,验证集用于调整模型的超参数。

7.假设空间与版本空间的区别

【机器学习】假设空间与版本空间

第二章 模型评估与选择

1.基本术语:错误率、精度、误差、训练误差(经验误差)、泛化误差。

2.欠拟合与过拟合

- 欠拟合:相较于数据而言,模型参数过少或者模型结构过于简单,以至于无法捕捉到数据中的规律的现象。

- 过拟合:模型过于紧密或精确地匹配特定数据集,以致于无法良好地拟合其他数据或预测未来的观察结果的现象。

3.评估方法

(1)留出法

- 直接将数据集 D D D划分为两个互斥的集合,其中一个集合作为训练集 S S S,另一个集合作为测试集 T T T。

- 训练集和测试集的划分要尽可能保持数据分布的一致性,测试集一般占比1/5~1/3。

- 单次使用留出法得到的估计结果往往不够稳定可靠,一般采用若干次随机划分、重复进行实验评估后取平均值作为评估结果。

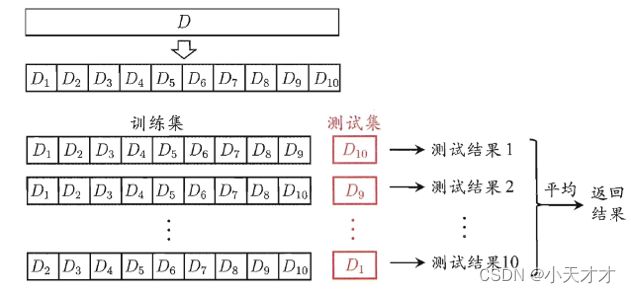

(2)交叉验证法

首先将训练集均匀分成 k k k份,每份均保证数据分布的一致性,每次取其中一份作为测试集,剩下部分作为新的训练集,从而得到在该测试集的测试结果,重复 k k k次,得到平均结果,下面为10折交叉验证的例子(若 k k k等于数据集样本数 m m m,则此时为留一法)。

(3)自助法

留出法和交叉验证法中,由于保留了一部分样本用于测试,因此实际评估的模型所使用的训练集比 D D D小,这也就意味着我们没有用 D D D中的所有数据来训练模型,模型可能没有充分地学习到 D D D中的信息,因此我们用测试集评估的模型性能,可能会比用 D D D训练的模型性能要低一些,这也是因为训练样本规模不同而导致的估计偏差。

自助法以自助采样法为基础,假定给定包含 m m m个样本的数据集 D D D,每次随机从 D D D中挑选一个样本,将其拷贝放入 D ′ D' D′,然后再将该样本放回初始数据集 D D D中,使得该样本在下次采样时仍有可能被采到,上述过程重复执行 m m m次,即可得到包含 m m m个样本的数据集 D ′ D' D′,把 D ′ D' D′作为训练集, D D D \ D ′ D' D′作为测试集(初始数据集 D D D中约有 36.8 36.8 36.8%的样本未出现在采样的数据集 D ′ D' D′中)。

(4)适用场景

留出法和交叉验证法适用于初始数据量充足时,自助法适用于数据集较小、难以有效划分训练集和测试集。

4.性能度量

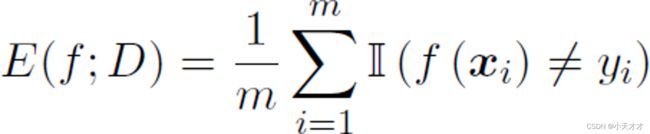

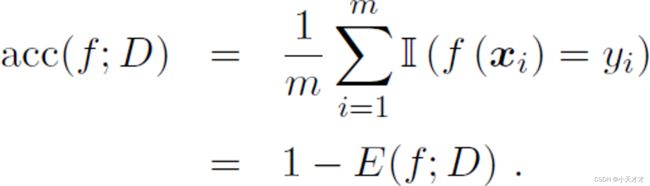

(1)错误率和精度

错误率是分类错误的样本数占样本总数的比例,精度则是分类正确的样本数占样本总数的比例,如下所示:

|

|

(2)查准率、查全率和 F 1 F1 F1

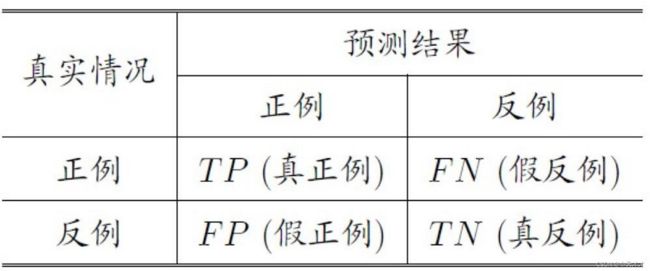

对于二分类问题,可将样例根据其真实类别与学习器预测类别的组合划分为真正例(TP)、假正例(FP)、真反例(TN)、假反例(FN),分类结果混淆矩阵与查准率(准确率)、查全率(召回率)计算如下所示:

|

|

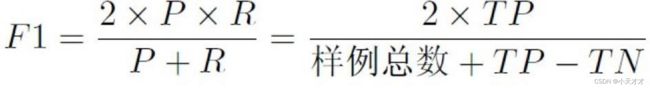

F1度量是基于查准率和查全率的调和平均,如下所示:

查准率反映了模型的预测结果是否准确,查全率反映了模型的预测结果是否完整,F1值越高,表示模型的查准率和查全率都较高。一般来说,如果需要尽可能地把所需的类别检测出来,而不在乎结果是否准确,那么就应该关注查全率;如果需要尽可能地把所需的类别检测准确,而不在乎这些类别是否都被检测出来,那么就应该关注查准率;如果对查准率和查全率都有同样高的要求,那么就应该关注F1值。举例如下:

- 在病情诊断时,我们希望查准率越高越好,减少病情误判。

- 在逃犯搜捕过程中,我们希望不放过任何一个漏网之鱼,所以就希望查全率越高越好。

- 在垃圾邮件检测中,我们希望检测出的垃圾邮件肯定是垃圾邮件,而不希望把正常邮件归为垃圾邮件,因为这样有可能会给客户造成很大的损失,这时候需要同时关注查准率和查全率,可以用F1值来衡量。

(3) R O C ROC ROC和 A U C AUC AUC

ROC(Receiver Operating Characteristic)曲线是一种用来评价二分类模型性能的图形工具,它可以显示模型在不同阈值下的真阳性率(TPR)和假阳性率(FPR)之间的关系。AUC(Area Under ROC Curve)值是ROC曲线下的面积,反映了模型对正负样本的区分能力。AUC值越大,表示模型越好。AUC值为1时,表示模型完美分类;AUC值为0.5时,表示模型随机猜测;AUC值小于0.5时,表示模型比随机猜测还差。

(4)代价敏感错误率和代价曲线

为权衡不同类型错误所造成的不同损失,可为错误赋予“非均等代价”,而引入了非均等代价的错误率,就是代价敏感错误率。在非均等代价下,ROC曲线不能直接反映出学习器的期望总体代价,所以要用到代价曲线,其中横轴为正例概率代价,纵轴为归一化代价。