2022年最值得关注的十篇论文,你都看了吗?来卷来学习

2023

点击蓝字 关注我们

关注并星标

从此不迷路

计算机视觉研究院

计算机视觉研究院专栏

作者:Edison_G

年关将至,威斯康星大学助理教授 Sebastian Raschka 盘点了 2022 年他最看好的十大论文。

公众号ID|ComputerVisionGzq

学习群|扫码在主页获取加入方式

2022 年 1 月,扩散模型第一次吸引了我的眼球。当时我判断到将会有某些大事发生,然而却未曾预料到几个月后会出现什么:DALLE-2、Imagen、Stable Diffusion 以及其它许多模型。

对于大型语言模型来说,2022 也是非常重要的一年,最近面世的 ChatGPT 更是锦上添花,抢尽了风头。

在回顾今年发表的十篇值得关注的论文前,我们可以先看看 12 月的 AI 要闻以及麦肯锡的一份人工智能全景报告和行业调查综述。

昨天,今天,明天

简单来说,有两篇论文引起了我的注意。

第一篇:视觉 Transformer(ViT)学习什么?

论文链接:https://arxiv.org/pdf/2212.06727.pdf

关于视觉的探索显示,ViT 学习的归纳偏置或特征与卷积神经网络(CNN)学习的那些相似。例如,ViT 的 early layers 捕捉边缘和纹理,而 later layers 学习更复杂的表征以捕捉更广泛的概念。

视觉 Transformer 从 early layers(左)到 deeper layers(右)的可视化特征过程。

关于生成建模,ViT 倾向于生成比 CNN 更高质量的背景,这就提出了 ViT 如何处理预测任务中的背景和前景的这一问题。当背景被消除时,ViT 似乎比 CNN 更善于预测目标类别,并且在前景被消除时它们也依然表现得更好。这表明,ViT 在依赖基于其存在的某些特征时可能更具选择性,或者说,总体更为鲁棒。

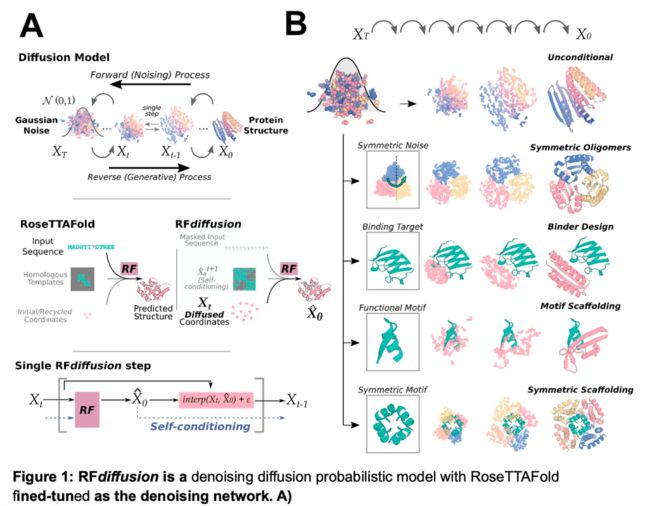

第二篇:一种生成蛋白质的扩散模型

论文链接:https://www.biorxiv.org/content/10.1101/2022.12.09.519842v1

在图像生成领域,扩散模型已经带来了突破性的性能,那么生成蛋白质结构呢?研究人员开发了一种新的蛋白质合成扩散模型,称为 RoseTTAFold Diffusion(RFDiffusion),这种蛋白质是从零开始创造的,而非来自于自然界中早已存在的蛋白质。

区分 de novo 蛋白质(在实验室中使用没有进化历史的氨基酸序列合成)与诸如 AlphaFold、 AlphaFold2 等系统(使用现有氨基酸序列数据预测蛋白质 3D 结构)十分重要。但值得注意的是,AlphaFold2 曾被用于验证 RDiffusion 研究的结果。

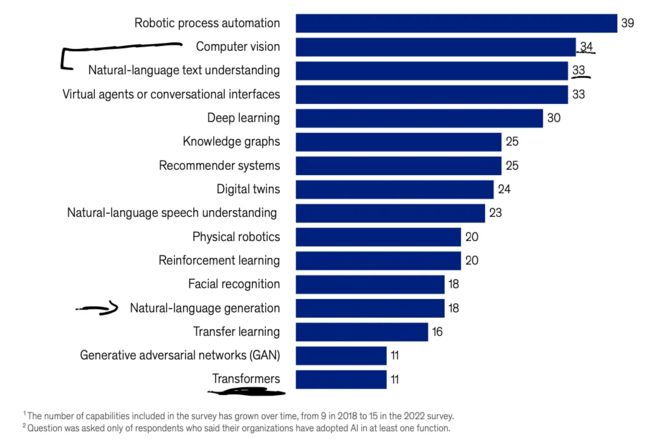

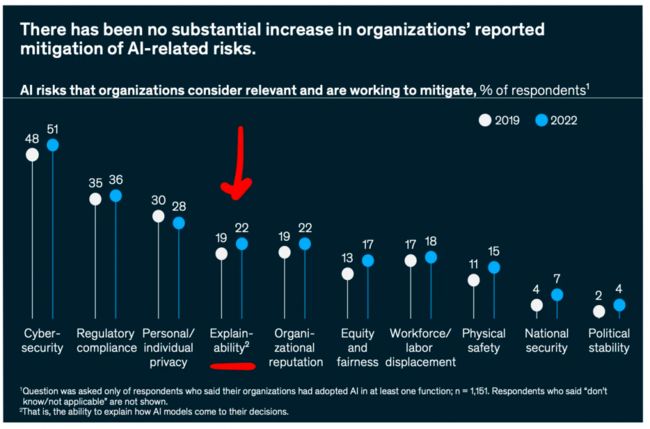

然后再谈谈最近的行业趋势。今天,在产业中实际使用的技术是什么?根据麦肯锡最近的 AI 全景报告 —— 并不是大型语言模型(Transformer)。特别说明,由于样本规模和代表性的限制,该报告中的调查结果可能无法准确反映所有公司的经验。

图源:麦肯锡 2022 年全景报告。

自然语言处理在行业内一直受到追捧,但其受欢迎程度经常被计算机视觉应用超越。但现在,我们第一次看到计算机视觉和自然语言处理几乎总是紧密联系在一起。

与此同时,自然语言文本理解(可能指文本分类)的受欢迎程度几乎是自然语言「生成」的两倍。请注意,自然语言生成的新闻通常会占据热点首页:如 GPT-3、Galactica、ChatGPT 等。(文本理解可能包括摘要,摘要也是「生成」的,所以我假设它在这里主要指的是类似分类的任务。那么反过来说,类别(categories)也是可以重叠的。)

值得注意的是,Transformer 的排名垫底。

似乎许多公司尚未采用类似 BERT 的语言模型编码器来进行文本理解和分类。相反,他们可能仍在使用基于词袋模型( bag-of-word-based)的分类器或递归神经网络。同样,类似 GPT 的模型解码器似乎还没有广泛应用于语言生成,因而文本生成可能仍严重依赖循环神经网络和其他传统方法。

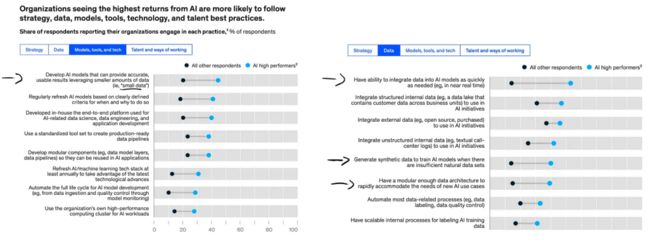

基于下图,我发现了一些有趣的其他见解:

图源:2022 年麦肯锡 AI 全景报告。

能够利用「小数据」非常重要。当数据不可用时,生成合成数据的能力非常有用。

尽快将数据集成到 AI 模型中的能力是在竞争中脱颖而出的关键。那么,良好的软件框架和基础设备设置可能起到举足轻重的作用。

不幸的是,大多数高绩效公司迄今仍不关心模型的可解释性。

十大年度论文

以下将介绍我在 2022 年阅读到的排名前三的论文。当然,今年发表的论文中还有很多其他主题是更令人兴奋、永恒且具有影响力的。

2022 年,保持前三名的成绩显然具有挑战性,因而下面还附了一个扩展列表,列出了我排名前十榜单中的其余七篇论文。

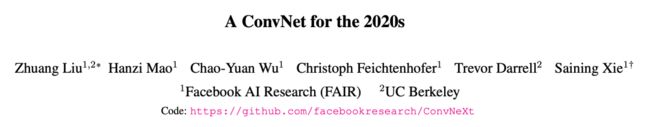

一、ConvNeXt

论文链接:https://arxiv.org/pdf/2201.03545.pdf

《A ConvNet for the 2020s》这篇论文我愿称之为全年最佳,因为作者们能够设计出一种纯卷积架构,其性能优于诸如 Swin Transformer 等流行的视觉 Transformer(当然,也优于在它之前出现的所有卷积神经网络)。

当卷积神经网络不仅应用于分类,还用于目标检测和实例分割时,这种所提到的 ConvNeXt 架构很可能成为新的默认架构 —— 例如,它可以用作 Mask R-CNN 的骨干网络(backbone)。

正如作者们在论文中所述,他们受到了当前视觉 Transformer 训练机制以及 Swin Transformer 混合架构表明卷积层仍然相关的事实启发。这均是因为纯视觉 Transformer 架构缺乏有用的归纳偏置,例如平移同变性和参数共享(即卷积中的「滑动窗口」)。

为了开发 ConvNeXt,作者们从 ResNet-50 基础架构出发,并采用了从现代 ViT 训练机制中运用的架构修改和训练机制。即使是赋予在卷积神经网络的背景,这些本来也没什么新奇。然而,新颖之处却在于作者们有效地使用、分析和组合了这些技术。

他们采用了哪些技术?这可以列一个很长的清单,包括深度卷积、反向瓶颈层设计、AdamW、LayerNorm 技术等等,具体的汇总你可以在下图中找到。此外,作者还使用了数据增强技术,如 Mixup、Cutmix 等。

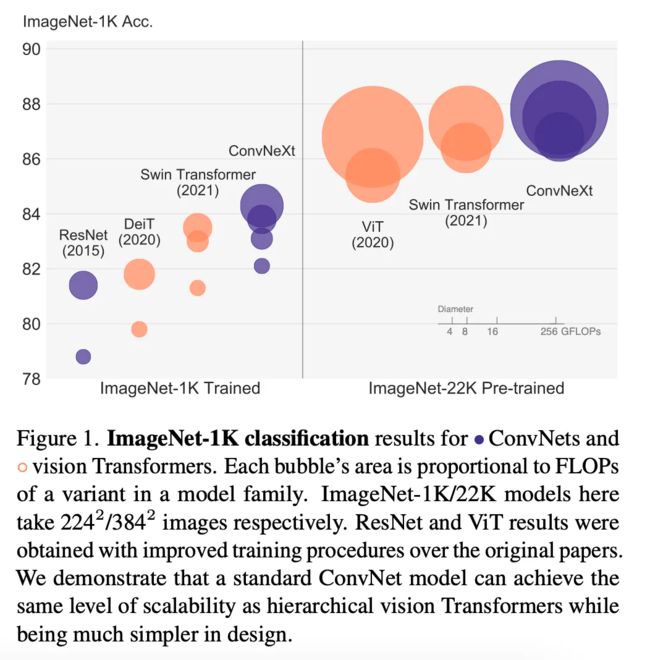

二、MaxViT

尽管随着上述的 ConvNext 出世,卷积神经网络再度受到欢迎,但目前来说 ViT 仍然抢尽风头(并非刻意双关)。

MaxViT:多轴视觉 Transformer 突出显示了近年来视觉 Transformer 的发展。虽然早期的视觉 Transformer 具有二次复杂度,但已经可以通过许多手段来将视觉 Transformer 应用于具有线性缩放复杂度的更大图像中。

2022 年 9 月发布的 MaxViT,目前是 ImageNet 基准测试中的 SOTA 模型。

在 MaxViT 中,这是通过将注意力块(attention block)分解为具有局部 - 全局交互的两个部分来实现的:

局部注意力(「块注意力」);

全局注意力(「网格注意力」)。

值得一提的是,MaxViT 是一种也具备卷积层特征的卷积 Transformer 混合模型。它可以用于预测建模(包括分类、目标检测和实例分割)以及生成建模。

顺便提一句,在谷歌学术上搜索「视觉 Transformer」,仅 2022 年就产出了 5000 多个结果。这个结果虽然可能包括误报,但仍可表明人们对于视觉 Transformer 的广泛欢迎程度和感兴趣程度。

不过不用担心,视觉 Transformer 不会完全取代我们喜爱的卷积神经网络。相反,正如 MaxViT 所强调的,当前的趋势是将视觉 Transformer 和卷积网络一起整合到混合架构中。

三、Stable Diffusion

在 ChatGPT 成为最先进的模型之前,Stable Diffusion 早已在互联网和社交媒体上普及。这个概念其实最早来源于 2021 年 12 月上传的论文《High-Resolution Image Synthesis with Latent Diffusion Models》。

由于这篇论文在 2022 年 CVPR 会议上发表,并在 2022 年 8 月凭借 Stable Diffusion 受到高度关注,我认为将其列入 2022 年的 TOP3 论文名单是公平合理的。

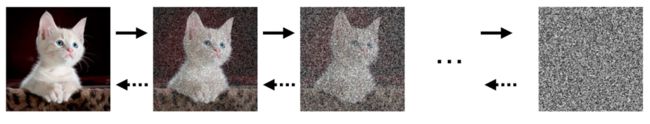

扩散模型是一种概率模型,被设计用于通过逐渐对正态分布变量进行去噪来学习数据集分布。这个过程对应于学习长度为 T 的固定的马尔可夫链(Markov Chain)的逆过程。

扩散模型的图示。

与使用生成器 (Generator) 和鉴别器 (Discriminator) 之间的极大极小博弈(minimax game)训练的 GAN 不同,扩散模型是使用最大似然估计(MLE)训练的基于似然的模型。这有助于避免模式坍塌和其他训练不稳定性。

扩散模型已经存在了一段时间,但众所周知,在训练和推理过程中,从中取样仍非常昂贵。上述 2022 年论文的作者提到过,5 天的运行时间仅能采样 50k 张图像。

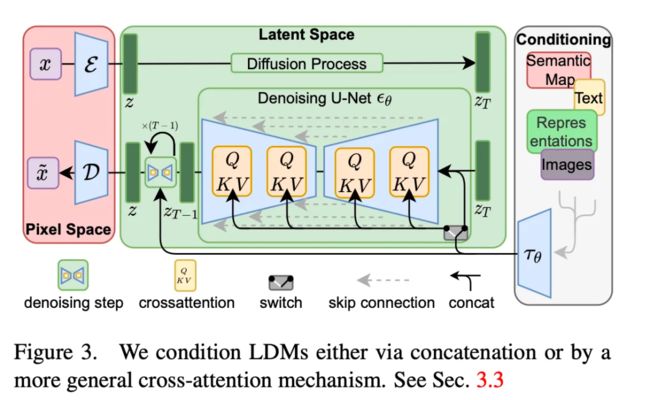

《High-Resolution Image Synthesis with Latent Diffusion Models》一文的新颖之处在于人们可以使用预训练的自编码器在潜在空间中应用扩散,而非直接使用原始图像的全分辨率原始像素输入空间。

上文提到的训练过程可以分为两个阶段:首先,对自编码器进行预处理,将输入图像编码到较低维度的潜在空间中,以降低复杂性。第二,在预训练的自动编码器隐层表征上训练扩散模型。

在潜在空间中进行运算,降低了用于训练和推理的扩散模型的计算成本和复杂性,并可以生成高质量的结果。

本文的另一个贡献是一般条件下的交叉注意力机制( cross-attention mechanism)。因此,除了无条件图像生成之外,所提出的潜在扩散模型还能够进行图像修复、类条件图像合成、超分辨率图像重建以及文本到图像合成 —— 后者正是 DALLE-2 和 Stable Diffusion 闻名的原因。

接下来介绍我的排名榜前十论文中后七篇论文的概述:

四、《「通才」智能体》(A Generalist Agent)。在本文中,研究人员介绍了 Gato,它能够执行从玩游戏到控制机器人等 600 多种不同任务。

论文链接:https://arxiv.org/abs/2205.06175

五、《训练最优计算的大型语言模型》(Training Compute-Optimal Large Language Models)。为了在训练期间实现最优计算,研究人员认为通过相同的因子来缩放模型大小和训练 token 的数量都很有必要。他们创建了一个名为 Chinchilla 的模型,例如,该模型的性能优于 Gopher,可以使用比 Gopher 四分之一的参数输出四倍之多的数据。

论文链接:https://arxiv.org/abs/2203.15556

六、《PaLM:使用 Pathways 缩放语言模型》(PaLM: Scaling Language Modeling with Pathways):文中提出的 PaLM 模型在各种 BIG-bench 任务上都展示了令人惊叹的自然语言理解和生成能力。在某种程度上,它甚至能识别出因果关系。

论文链接:https://arxiv.org/abs/2204.02311

七、《基于大规模弱监督方法的鲁棒语音识别》(Robust Speech Recognition via Large-Scale Weak Supervision)。本文介绍了 Whisper 模型,该模型在多语言任务上接受了 68 万小时的训练,并表现出了对各种基准数据集(benchmarks)的鲁棒泛化性。本文介绍的 Whisper 模型给我留下了深刻的印象。我用它来为我的两门课程深度学习基础 —— 运用现代开源栈学习深度学习以及深度学习引言(Deep Learning Fundamentals – Learning Deep Learning With a Modern Open Source Stack)生成字幕。

论文链接:https://arxiv.org/abs/2212.04356

八、《再论表格深度学习的预训练目标》(Revisiting Pretraining Objectives for Tabular Deep Learning)。我喜欢阅读大量有关 Tabular 数据的深度学习论文。但我尤其钟爱这篇论文,因为它强调并提醒我们在附加(通常未标记)数据上进行模型预训练是多么重要。(使用如 XGBoost 等基于树模型无法轻松做到这一点。)

论文链接:https://arxiv.org/abs/2207.03208

九、《为什么基于树的模型在表格数据上的性能仍然优于基于深度学习的模型?》 (Why do tree-based models still outperform deep learning on tabular data?)。该文的主要收获是基于树的模型(随机森林和 XGBoost)的性能优于在中型数据集(10k 训练示例)上应用表格数据的深度学习方法。但是随着数据集大小的增加(这里:10k → 50k),基于树的模型和深度学习之间的差距变得越来越小。遗憾的是,这篇论文没有包含特别多最先进的深度表格网络,不过它进行了鲁棒性分析和有趣的讨论,绝对值得一读。

论文链接:https://arxiv.org/abs/2207.08815

十、《用语言模型预测原子级蛋白质结构的进化程度》(Evolutionary-scale prediction of atomic level protein structure with a language model)。该论文提出了迄今为止预测蛋白质三维结构的最大语言模型,它也比以前的方法运算更快,同时还保持着同样的准确性。该模型创建了 ESM 宏基因组图谱,是宏基因组蛋白质的第一个大规模结构表征,具有超过 6.17 亿个蛋白质结构。

论文链接:https://www.biorxiv.org/content/10.1101/2022.07.20.500902v3

原文链接:https://magazine.sebastianraschka.com/p/ahead-of-ai-4-a-big-year-for-ai

© THE END

转载请联系本公众号获得授权

计算机视觉研究院学习群等你加入!

计算机视觉研究院主要涉及深度学习领域,主要致力于人脸检测、人脸识别,多目标检测、目标跟踪、图像分割等研究方向。研究院接下来会不断分享最新的论文算法新框架,我们这次改革不同点就是,我们要着重”研究“。之后我们会针对相应领域分享实践过程,让大家真正体会摆脱理论的真实场景,培养爱动手编程爱动脑思考的习惯!

扫码关注

计算机视觉研究院

公众号ID|ComputerVisionGzq

学习群|扫码在主页获取加入方式

往期推荐

CVPR21最佳检测:不再是方方正正的目标检测输出(附源码)

Sparse R-CNN:稀疏框架,端到端的目标检测(附源码)

利用TRansformer进行端到端的目标检测及跟踪(附源代码)

细粒度特征提取和定位用于目标检测(附论文下载)

特别小的目标检测识别(附论文下载)

目标检测 | 基于统计自适应线性回归的目标尺寸预测

目标检测干货 | 多级特征重复使用大幅度提升检测精度(文末附论文下载)

SSD7-FFAM | 对嵌入式友好的目标检测网络,为幼儿园儿童的安全保驾护航

目标检测新方式 | class-agnostic检测器用于目标检测(附论文下载链接)

干货 | 利用手持摄像机图像通过卷积神经网络实时进行水稻检测(致敬袁老)