已解决Python爬虫报错<Response [403]>

已解决Python爬虫报错<Response [403]>

文章目录

- 报错代码

- 报错翻译

- 报错原因

- 解决方法

-

- 1. 发送带headers参数请求

- 2. proxies代理参数的使用

- 千人全栈VIP答疑群联系博主帮忙解决报错

报错代码

粉丝群里面的一个粉丝在用Python爬取网页源码,但是发生了报错(跑来找我求助,然后顺利帮助他解决了,顺便记录一下希望可以帮助到更多遇到这个bug不会解决的小伙伴),报错信息和代码如下:

报错翻译

报错信息翻译:

<响应[403]>

报错原因

报错原因:

403错误是一种在网站访问过程中,常见的错误提示,表示资源不可用。服务器理解客户的请求,但拒绝处理它,通常由于服务器上文件或目录的权限设置导致的WEB访问错误。简单来说了被服务器看出来是爬虫了,小伙伴们按下面的方法解决即可!!!

解决方法

1. 发送带headers参数请求

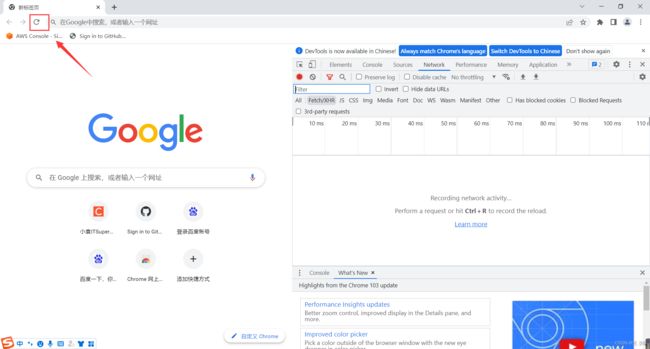

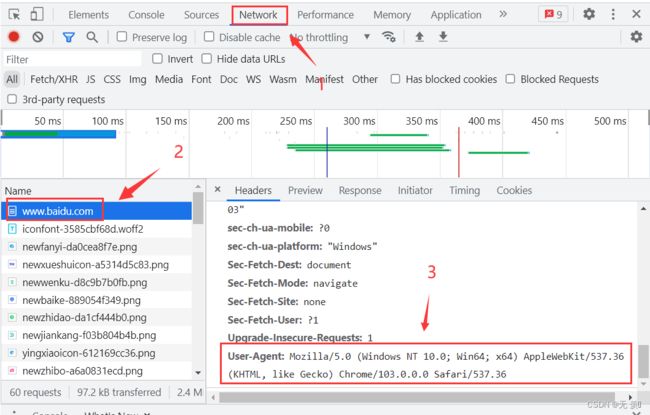

1)查看浏览器请求头

- 1. 打开谷歌浏览器 》右键检查 》点击左上角刷新网页

- 2. 点击Network 》找到对应的网址 》往下翻找到User-Agent并复制

2)代码说明

requests.get(ur1, headers=headers)

- headers参 数接收字典形式的请求头

- 请求头字段名作为key,字段对应的值作为value

3)代码实现:

import requests

# 目标网址

url = "http://www.baidu.com/"

# 构建请求头字典,最重要的就是User-Agent

# 如果需要其他请求头,就在headers字典中加上

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/103.0.0.0 Safari/537.36'}

# 发送请求获取响应

response = requests.get(url,headers=headers)

print(response.text)

运行结果:整个网页源码:

![]()

2. proxies代理参数的使用

为了让服务器以为不是同一个客户端在请求;为了防止频繁向一个域名发送请求被封ip,所以我们需要使用代理ip

![]()

语法:

response = requests.get(url, proxies=proxies)

proxies的形式: 字典

proxies = {

"http": "http://12.34.5679:9527",

"https": "https://12.34.5679:9527",

}

注意:如果proxies字典中包含有多个键值对,发送请求时将按照ur地址的协议来选择使用相应的代理ip

以上是此问题报错原因的解决方法,欢迎评论区留言讨论是否能解决,如果有用欢迎点赞收藏文章谢谢支持,博主才有动力持续记录遇到的问题!!!

千人全栈VIP答疑群联系博主帮忙解决报错

由于博主时间精力有限,每天私信人数太多,没办法每个粉丝都及时回复,所以优先回复VIP粉丝,可以通过订阅限时9.9付费专栏《100天精通Python从入门到就业》进入千人全栈VIP答疑群,获得优先解答机会(代码指导、远程服务),白嫖80G学习资料大礼包,专栏订阅地址:https://blog.csdn.net/yuan2019035055/category_11466020.html

-

优点:作者优先解答机会(代码指导、远程服务),群里大佬众多可以抱团取暖(大厂内推机会),此专栏文章是专门针对零基础和需要进阶提升的同学所准备的一套完整教学,从0到100的不断进阶深入,后续还有实战项目,轻松应对面试!

-

专栏福利:简历指导、招聘内推、每周送实体书、80G全栈学习视频、300本IT电子书:Python、Java、前端、大数据、数据库、算法、爬虫、数据分析、机器学习、面试题库等等

-

注意:如果希望得到及时回复,订阅专栏后私信博主进千人VIP答疑群

![]()

![已解决Python爬虫报错<Response [403]>_第1张图片](http://img.e-com-net.com/image/info8/7cf89018439d49f589e89af3762443be.jpg)

![已解决Python爬虫报错<Response [403]>_第2张图片](http://img.e-com-net.com/image/info8/cc0b8f69d64946b790d7bcd8c52f43e1.jpg)