TensorFlow Lite,ML Kit 和 Flutter 移动深度学习:6~11

原文:Mobile Deep Learning with TensorFlow Lite, ML Kit and Flutter

协议:CC BY-NC-SA 4.0

译者:飞龙

本文来自【ApacheCN 深度学习 译文集】,采用译后编辑(MTPE)流程来尽可能提升效率。

不要担心自己的形象,只关心如何实现目标。——《原则》,生活原则 2.3.c

六、构建人工智能认证系统

认证是任何应用中最突出的功能之一,无论它是本机移动软件还是网站,并且自从保护数据的需求以及与机密有关的隐私需求开始以来,认证一直是一个活跃的领域。 在互联网上共享的数据。 在本章中,我们将从基于 Firebase 的简单登录到应用开始,然后逐步改进以包括基于人工智能(AI)的认证置信度指标和 Google 的 ReCaptcha。 所有这些认证方法均以深度学习为核心,并提供了一种在移动应用中实现安全性的最新方法。

在本章中,我们将介绍以下主题:

- 一个简单的登录应用

- 添加 Firebase 认证

- 了解用于认证的异常检测

- 用于认证用户的自定义模型

- 实现 ReCaptcha 来避免垃圾邮件

- 在 Flutter 中部署模型

技术要求

对于移动应用,需要具有 Flutter 的 Visual Studio Code 和 Dart 插件以及 Firebase Console

GitHub 网址。

一个简单的登录应用

我们将首先创建一个简单的认证应用,该应用使用 Firebase 认证对用户进行认证,然后再允许他们进入主屏幕。 该应用将允许用户输入其电子邮件和密码来创建一个帐户,然后使他们随后可以使用此电子邮件和密码登录。

以下屏幕快照显示了应用的完整流程:

该应用的小部件树如下:

现在让我们详细讨论每个小部件的实现。

创建 UI

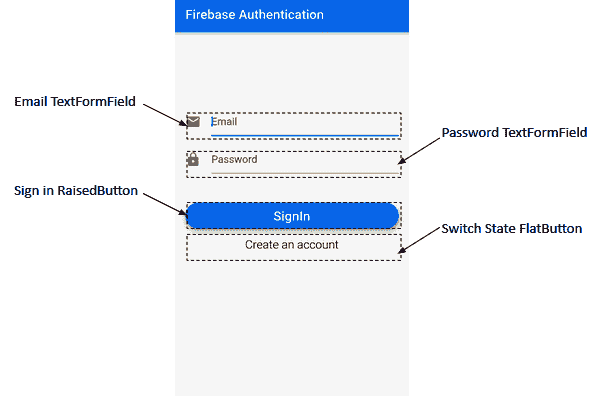

让我们从创建应用的登录屏幕开始。 用户界面(UI)将包含两个TextFormField来获取用户的电子邮件 ID 和密码,RaisedButton进行注册/登录,以及FlatButton进行注册和登录操作之间的切换。

以下屏幕快照标记了将用于应用的第一个屏幕的小部件:

现在让我们创建应用的 UI,如下所示:

- 我们首先创建一个名为

signup_signin_screen.dart的新 dart 文件。 该文件包含一个有状态的小部件–SignupSigninScreen。 - 第一个屏幕中最上面的窗口小部件是

TextField,用于获取用户的邮件 ID。_createUserMailInput()方法可帮助我们构建窗口小部件:

Widget _createUserMailInput() {

return Padding(

padding: const EdgeInsets.fromLTRB(0.0, 100.0, 0.0, 0.0),

child: new TextFormField(

maxLines: 1,

keyboardType: TextInputType.emailAddress,

autofocus: false,

decoration: new InputDecoration(

hintText: 'Email',

icon: new Icon(

Icons.mail,

color: Colors.grey,

)),

validator: (value) => value.isEmpty ? 'Email can\'t be empty' : null,

onSaved: (value) => _usermail = value.trim(),

),

);

}

首先,我们使用EdgeInsets.fromLTRB()为小部件提供了填充。 这有助于我们在四个基本方向的每个方向(即左,上,右和下)上创建具有不同值的偏移量。 接下来,我们使用maxLines(输入的最大行数)创建了TextFormField,其值为1作为子级,它接收用户的电子邮件地址。 另外,根据输入类型TextInputType.emailAddress,我们指定了将在属性keyboardType中使用的键盘类型。 然后,将autoFocus设置为false。 然后,我们在装饰属性中使用InputDecoration提供hintText "Email"和图标Icons.mail。 为了确保用户在没有输入电子邮件地址或密码的情况下不要尝试登录,我们添加了一个验证器。 当尝试使用空字段登录时,将显示警告“电子邮件不能为空”。 最后,我们通过使用trim()删除所有尾随空格来修剪输入的值,然后将输入的值存储在_usermail字符串变量中。

- 与“步骤 2”中的

TextField相似,我们定义了下一个方法_createPasswordInput(),以创建用于输入密码的TextFormField():

Widget _createPasswordInput() {

return Padding(

padding: const EdgeInsets.fromLTRB(0.0, 15.0, 0.0, 0.0),

child: new TextFormField(

maxLines: 1,

obscureText: true,

autofocus: false,

decoration: new InputDecoration(

hintText: 'Password',

icon: new Icon(

Icons.lock,

color: Colors.grey,

)),

validator: (value) => value.isEmpty ? 'Password can\'t be empty' : null,

onSaved: (value) => _userpassword = value.trim(),

),

);

}

我们首先使用EdgeInsets.fromLTRB()在所有四个基本方向上提供填充,以在顶部提供15.0的偏移量。 接下来,我们创建一个TextFormField,其中maxLines为1,并将obscureText设置为true,将autofocus设置为false。 obscureText用于隐藏正在键入的文本。 我们使用InputDecoration提供hintText密码和一个灰色图标Icons.lock。 为确保文本字段不为空,使用了一个验证器,当传递空值时,该警告器会发出警告Password can't be empty,即用户尝试在不输入密码的情况下登录/注册。 最后,trim()用于删除所有尾随空格,并将密码存储在_userpassword字符串变量中。

- 接下来,我们在

_SignupSigninScreenState外部声明FormMode枚举,该枚举在两种模式SIGNIN和SIGNUP之间运行,如以下代码片段所示:

enum FormMode { SIGNIN, SIGNUP }

我们将对该按钮使用此枚举,该按钮将使用户既可以登录又可以注册。 这将帮助我们轻松地在两种模式之间切换。 枚举是一组用于表示常量值的标识符。

使用enum关键字声明枚举类型。 在enum内部声明的每个标识符都代表一个整数值; 例如,第一标识符具有值0,第二标识符具有值1。 默认情况下,第一个标识符的值为0。

- 让我们定义一个

_createSigninButton()方法,该方法返回按钮小部件以使用户注册并登录:

Widget _createSigninButton() {

return new Padding(

padding: EdgeInsets.fromLTRB(0.0, 45.0, 0.0, 0.0),

child: SizedBox(

height: 40.0,

child: new RaisedButton(

elevation: 5.0,

shape: new RoundedRectangleBorder(borderRadius: new BorderRadius.circular(30.0)),

color: Colors.blue,

child: _formMode == FormMode.SIGNIN

? new Text('SignIn',

style: new TextStyle(fontSize: 20.0, color: Colors.white))

: new Text('Create account',

style: new TextStyle(fontSize: 20.0, color: Colors.white)),

onPressed: _signinSignup,

),

));

}

我们从Padding开始,将45.0的按钮offset置于顶部,然后将SizedBox和40.0的height作为子项,并将RaisedButton作为其子项。 使用RoundedRectangleBorder()为凸起的按钮赋予圆角矩形形状,其边框半径为30.0,颜色为blue。 作为子项添加的按钮的文本取决于_formMode的当前值。 如果_formMode的值(FormMode枚举的一个实例)为FormMode.SIGNIN,则按钮显示SignIn,否则创建帐户。 按下按钮时将调用_signinSignup方法,该方法将在后面的部分中介绍。

- 现在,我们将第四个按钮添加到屏幕上,以使用户在

SIGNIN和SIGNUP表单模式之间切换。 我们定义返回FlatButton的_createSigninSwitchButton()方法,如下所示:

Widget _createSigninSwitchButton() {

return new FlatButton(

child: _formMode == FormMode.SIGNIN

? new Text('Create an account',

style: new TextStyle(fontSize: 18.0, fontWeight: FontWeight.w300))

: new Text('Have an account? Sign in',

style:

new TextStyle(fontSize: 18.0, fontWeight: FontWeight.w300)),

onPressed: _formMode == FormMode.SIGNIN

? _switchFormToSignUp

: _switchFormToSignin,

);

}

如果_formMode的当前值为SIGNIN并按下按钮,则应更改为SIGNUP并显示Create an account。 否则,如果_formMode将SIGNUP作为其当前值,并且按下按钮,则该值应切换为由文本Have an account? Sign in表示的SIGNIN。 使用三元运算符创建RaisedButton的Text子级时,添加了在文本之间切换的逻辑。 onPressed属性使用非常相似的逻辑,该逻辑再次检查_formMode的值以在模式之间切换并使用_switchFormToSignUp和_switchFormToSignin方法更新_formMode的值。 我们将在“步骤 7”和 8 中定义_switchFormToSignUp和_switchFormToSignin方法。

- 现在,我们定义

_switchFormToSignUp()如下:

void _switchFormToSignUp() {

_formKey.currentState.reset();

setState(() {

_formMode = FormMode.SIGNUP;

});

}

此方法重置_formMode的值并将其更新为FormMode.SIGNUP。 更改setState()内部的值有助于通知框架该对象的内部状态已更改,并且 UI 可能需要更新。

- 我们以与

_switchFormToSignUp()非常相似的方式定义_switchFormToSignin():

void _switchFormToSignin() {

_formKey.currentState.reset();

setState(() {

_formMode = FormMode.SIGNIN;

});

}

此方法重置_formMode的值并将其更新为FormMode.SIGNIN。 更改setState()内部的值有助于通知框架该对象的内部状态已更改,并且 UI 可能需要更新。

- 现在,让我们将所有屏幕小部件

Email TextField,Password TextFied,SignIn Button和FlatButton切换为在单个容器中进行注册和登录。 为此,我们定义了一种方法createBody(),如下所示:

Widget _createBody(){

return new Container(

padding: EdgeInsets.all(16.0),

child: new Form(

key: _formKey,

child: new ListView(

shrinkWrap: true,

children: <Widget>[

_createUserMailInput(),

_createPasswordInput(),

_createSigninButton(),

_createSigninSwitchButton(),

_createErrorMessage(),

],

),

)

);

}

此方法返回一个以Form作为子元素的新Container并为其填充16.0。 表单使用_formKey作为其键,并添加ListView作为其子级。 ListView的元素是我们在前述方法中创建的用于添加TextFormFields和Buttons的小部件。 shrinkWrap设置为true,以确保ListView仅占用必要的空间,并且不会尝试扩展和填充整个屏幕

Form类用于将多个FormFields一起分组和验证。 在这里,我们使用Form将两个TextFormFields,一个RaisedButton和一个FlatButton包装在一起。

- 这里要注意的一件事是,由于进行认证,因此用户最终将成为网络操作,因此可能需要一些时间来发出网络请求。 在此处添加进度条可防止在进行网络操作时 UI 的死锁。 我们声明

boolean标志_loading,当网络操作开始时将其设置为true。 现在,我们定义一种_createCircularProgress()方法,如下所示:

Widget _createCircularProgress(){

if (_loading) {

return Center(child: CircularProgressIndicator());

} return Container(height: 0.0, width: 0.0,);

}

仅当_loading为true并且正在进行网络操作时,该方法才返回CircularProgressIndicator()。

- 最后,让我们在

build()方法内添加所有小部件:

@override

Widget build(BuildContext context) {

return new Scaffold(

appBar: new AppBar(

title: new Text('Firebase Authentication'),

),

body: Stack(

children: <Widget>[

_createBody(),

_createCircularProgress(),

],

));

}

从build()内部,添加包含应用标题的AppBar变量后,我们返回一个支架。 支架的主体包含一个带有子项的栈,这些子项是_createBody()和_createCircularProgress() 函数调用返回的小部件。

现在,我们已经准备好应用的主要 UI 结构。

可以在这个页面中找到SignupSigninScreen的完整代码。

在下一部分中,我们将介绍将 Firebase 认证添加到应用中涉及的步骤。

添加 Firebase 认证

如前所述,在“简单登录应用”部分中,我们将使用用户的电子邮件和密码通过 Firebase 集成认证。

要在 Firebase 控制台上创建和配置 Firebase 项目,请参考“附录”。

以下步骤详细讨论了如何在 Firebase Console 上设置项目:

- 我们首先在 Firebase 控制台上选择项目:

- 接下来,我们将在

Develop菜单中单击Authentication选项:

这将带我们进入认证屏幕。

- 迁移到登录标签并启用登录提供者下的“电子邮件/密码”选项:

这是设置 Firebase 控制台所需的全部。

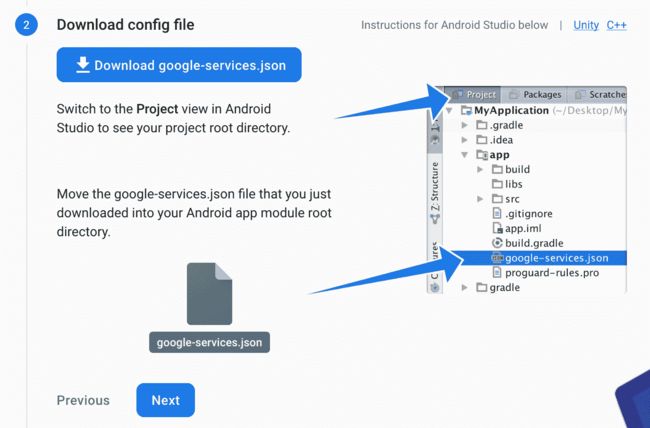

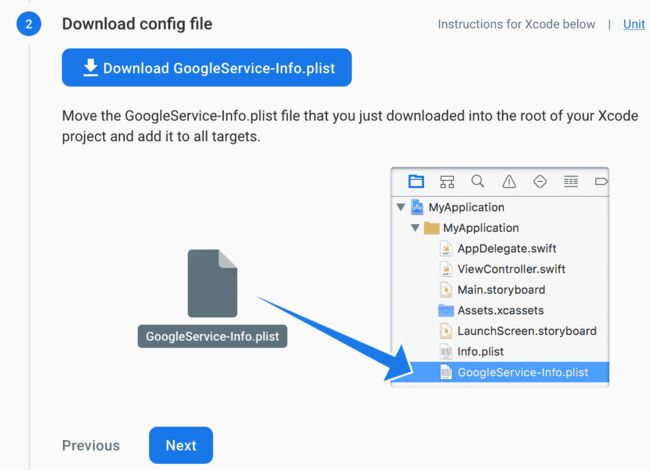

接下来,我们将 Firebase 集成到代码中。 这样做如下:

- 迁移到 Flutter SDK 中的项目,然后将

firebase-auth添加到应用级别build.gradle文件中:

implementation 'com.google.firebase:firebase-auth:18.1.0'

- 为了使

FirebaseAuthentication在应用中正常工作,我们将在此处使用firebase_auth插件。 在pubspec.yaml文件的依赖项中添加插件依赖项:

firebase_auth: 0.14.0+4

确保运行flutter pub get以安装依赖项。

现在,让我们编写一些代码以在应用内部提供 Firebase 认证功能。

创建auth.dart

现在,我们将创建一个 Dart 文件auth.dart。 该文件将作为访问firebase_auth插件提供的认证方法的集中点:

- 首先,导入

firebase_auth插件:

import 'package:firebase_auth/firebase_auth.dart';

- 现在,创建一个抽象类

BaseAuth,该类列出了所有认证方法,并充当 UI 组件和认证方法之间的中间层:

abstract class BaseAuth {

Future<String> signIn(String email, String password);

Future<String> signUp(String email, String password);

Future<String> getCurrentUser();

Future<void> signOut();

}

顾名思义,这些方法将使用认证的四个主要函数:

signIn():使用电子邮件和密码登录已经存在的用户signUp():使用电子邮件和密码为新用户创建帐户getCurrentUser():获取当前登录的用户signOut():注销已登录的用户

这里要注意的重要一件事是,由于这是网络操作,因此所有方法都异步操作,并在执行完成后返回Future值。

- 创建一个实现

BaseAuth的Auth类:

class Auth implements BaseAuth {

//. . . . .

}

在接下来的步骤中,我们将定义BaseAuth中声明的所有方法。

- 创建

FirebaseAuth的实例:

final FirebaseAuth _firebaseAuth = FirebaseAuth.instance;

signIn()方法实现如下:

Future<String> signIn(String email, String password) async {

AuthResult result = await _firebaseAuth.signInWithEmailAndPassword(email: email, password: password);

FirebaseUser user = result.user;

return user.uid;

}

此方法接收用户的电子邮件和密码,然后调用signInWithEmailAndPassword(),并传递电子邮件和密码以登录已经存在的用户。 登录操作完成后,将返回AuthResult实例。 我们将其存储在result中,还使用result.user,它返回FirebaseUser.。它可用于获取与用户有关的信息,例如他们的uid,phoneNumber和photoUrl。 在这里,我们返回user.uid,它是每个现有用户的唯一标识。 如前所述,由于这是网络操作,因此它异步运行,并在执行完成后返回Future。

- 接下来,我们将定义

signUp()方法以添加新用户:

Future<String> signUp(String email, String password) async {

AuthResult result = await _firebaseAuth.createUserWithEmailAndPassword(email: email, password: password);

FirebaseUser user = result.user;

return user.uid;

}

前面的方法接收在注册过程中使用的电子邮件和密码,并将其值传递给createUserWithEmailAndPassword。 类似于上一步中定义的对象,此调用还返回AuthResult对象,该对象还用于提取FirebaseUser。 最后,signUp方法返回新创建的用户的uid。

- 现在,我们将定义

getCurrentUser():

Future<String> getCurrentUser() async {

FirebaseUser user = await _firebaseAuth.currentUser();

return user.uid;

}

在先前定义的函数中,我们使用_firebaseAuth.currentUser()提取当前登录用户的信息。 此方法返回包装在FirebaseUser对象中的完整信息。 我们将其存储在user变量中。 最后,我们使用user.uid返回用户的uid。

- 接下来,我们执行

signOut():

Future<void> signOut() async {

return _firebaseAuth.signOut();

}

此函数仅在当前FirebaseAuth实例上调用signOut()并注销已登录的用户。

至此,我们已经完成了用于实现 Firebase 认证的所有基本编码。

可以在这个页面中查看auth.dart中的整个代码。

现在让我们看看如何在应用内部使认证生效。

在SignupSigninScreen中添加认证

在本节中,我们将在SignupSigninScreen中添加 Firebase 认证。

我们在signup_signin_screen.dart文件中定义了_signinSignup()方法。 当按下登录按钮时,将调用该方法。 该方法的主体如下所示:

void _signinSignup() async {

setState(() {

_loading = true;

});

String userId = "";

if (_formMode == FormMode.SIGNIN) {

userId = await widget.auth.signIn(_usermail, _userpassword);

} else {

userId = await widget.auth.signUp(_usermail, _userpassword);

}

setState(() {

_loading = false;

});

if (userId.length > 0 && userId != null && _formMode == FormMode.SIGNIN) {

widget.onSignedIn();

}

}

在上述方法中,我们首先将_loading的值设置为true,以便进度条显示在屏幕上,直到登录过程完成。 接下来,我们创建一个userId字符串,一旦登录/登录操作完成,该字符串将存储userId的值。 现在,我们检查_formMode的当前值。 如果等于FormMode.SIGNIN,则用户希望登录到现有帐户。 因此,我们使用传递到SignupSigninScreen构造器中的实例来调用Auth类内部定义的signIn()方法。

这将在后面的部分中详细讨论。 否则,如果_formMode的值等于FormMode.SIGNUP,则将调用Auth类的signUp()方法,并传递用户的邮件和密码以创建新帐户。 一旦成功完成登录/注册,userId变量将用于存储用户的 ID。 整个过程完成后,将_loading设置为false,以从屏幕上删除循环进度指示器。 另外,如果在用户登录到现有帐户时userId具有有效值,则将调用onSignedIn(),这会将用户定向到应用的主屏幕。

此方法也传递给SignupSigninScreen的构造器,并将在后面的部分中进行讨论。 最后,我们将整个主体包裹在try-catch块中,以便在登录过程中发生的任何异常都可以捕获而不会导致应用崩溃,并可以在屏幕上显示。

创建主屏幕

我们还需要确定认证状态,即用户在启动应用时是否已登录,如果已经登录,则将其定向到主屏幕。如果尚未登录,则应显示SignInSignupScreen 首先,在完成该过程之后,将启动主屏幕。 为了实现这一点,我们在新的 dart 文件main_screen.dart中创建一个有状态的小部件MainScreen,然后执行以下步骤:

- 我们将从定义枚举

AuthStatus开始,该枚举表示用户的当前认证状态,可以登录或不登录:

enum AuthStatus {

NOT_SIGNED_IN,

SIGNED_IN,

}

- 现在,我们创建

enum类型的变量来存储当前认证状态,其初始值设置为NOT_SIGNED_IN:

AuthStatus authStatus = AuthStatus.NOT_SIGNED_IN;

- 初始化小部件后,我们将通过覆盖

initState()方法来确定用户是否已登录:

@override

void initState() {

super.initState();

widget.auth.getCurrentUser().then((user) {

setState(() {

if (user != null) {

_userId = user;

}

authStatus =

user == null ? AuthStatus.NOT_SIGNED_IN : AuthStatus.SIGNED_IN;

});

});

}

使用在构造器中传递的类的实例调用Auth类的getCurrentUser()。 如果该方法返回的值不为null,则意味着用户已经登录。因此,_userId字符串变量的值设置为返回的值。 另外,将authStatus设置为AuthStatus.SIGNED_IN.,否则,如果返回的值为null,则意味着没有用户登录,因此authStatus的值设置为AuthStatus.NOT_SIGNED_IN。

- 现在,我们将定义另外两个方法

onSignIn()和onSignOut(),以确保将认证状态正确存储在变量中,并相应地更新用户界面:

void _onSignedIn() {

widget.auth.getCurrentUser().then((user){

setState(() {

_userId = user;

});

});

setState(() {

authStatus = AuthStatus.SIGNED_IN;

});

}

void _onSignedOut() {

setState(() {

authStatus = AuthStatus.NOT_SIGNED_IN;

_userId = "";

});

}

_onSignedIn()方法检查用户是否已经登录,并将authStatus设置为AuthStatus.SIGNED_IN.。 _onSignedOut()方法检查用户是否已注销,并将authStatus设置为AuthStatus.SIGNED_OUT。

- 最后,我们重写

build方法将用户定向到正确的屏幕:

@override

Widget build(BuildContext context) {

if(authStatus == AuthStatus.SIGNED_OUT) {

return new SignupSigninScreen(

auth: widget.auth,

onSignedIn: _onSignedIn,

);

} else {

return new HomeScreen(

userId: _userId,

auth: widget.auth,

onSignedOut: _onSignedOut,

);

}

}

如果authStatus为AuthStatus.SIGNED_OUT,则返回SignupSigninScreen,并传递auth实例和_onSignedIn()方法。 否则,将直接返回HomeScreen,并传递已登录用户的userId,Auth实例类和_onSignedOut()方法。

可以在此处查看main_screen.dart的完整代码。

在下一部分中,我们将为应用添加一个非常简单的主屏幕。

创建主屏幕

由于我们对认证部分更感兴趣,因此主屏幕(即成功登录后指向用户的屏幕)应该非常简单。 它仅包含一些文本和一个注销选项。 正如我们对所有先前的屏幕和小部件所做的一样,我们首先创建一个home_screen.dart文件和一个有状态的HomeScreen小部件。

主屏幕将显示如下:

此处的完整代码位于重写的build()方法内部:

@override

Widget build(BuildContext context) {

return new Scaffold(

appBar: new AppBar(

title: new Text('Firebase Authentication'),

actions: <Widget>[

new FlatButton(

child: new Text('Logout',

style: new TextStyle(fontSize: 16.0, color: Colors.white)),

onPressed: _signOut

)

],

),

body: Center(child: new Text('Hello User',

style: new TextStyle(fontSize: 32.0))

),

);

}

我们在此处返回Scaffold,其中包含标题为Text Firebase Authentication的AppBar和actions属性的小部件列表。 actions用于在应用标题旁边添加小部件列表到应用栏中。 在这里,它仅包含FlatButton,Logout,在按下时将调用_signOut。

_signOut()方法显示如下:

_signOut() async {

try {

await widget.auth.signOut();

widget.onSignedOut();

} catch (e) {

print(e);

}

}

该方法主要是调用Auth类中定义的signOut()方法,以将用户从应用中注销。 回忆传入HomeScreen的MainScreen的_onSignedOut()方法。 当用户退出时,该方法在此处用作widget.onSignedOut()来将authStatus更改为SIGNED_OUT。 同样,它包装在try-catch块中,以捕获并打印此处可能发生的任何异常。

可以在此处查看home_screen.dart的整个代码。

至此,应用的主要组件已经准备就绪,现在让我们创建最终的材质应用。

创建main.dart

在main.dart内部,我们创建Stateless Widget,App,并覆盖build()方法,如下所示:

@override

Widget build(BuildContext context) {

return new MaterialApp(

title: 'Firebase Authentication',

debugShowCheckedModeBanner: false,

theme: new ThemeData(

primarySwatch: Colors.blue,

),

home: new MainScreen(auth: new Auth()));

}

该方法从主屏幕返回MaterialApp,以提供标题,主题。

可以在此处查看main.dart文件。

了解用于认证的异常检测

异常检测是机器学习的一个备受关注的分支。 该术语含义简单。 基本上,它是用于检测异常的方法的集合。 想象一袋苹果。 识别并挑选坏苹果将是异常检测的行为。

异常检测以几种方式执行:

- 通过使用列的最小最大范围来识别数据集中与其余样本非常不同的数据样本

- 通过将数据绘制为线形图并识别图中的突然尖峰

- 通过围绕高斯曲线绘制数据并将最末端的点标记为离群值(异常)

一些常用的方法是支持向量机,贝叶斯网络和 K 最近邻。 在本节中,我们将重点介绍与安全性相关的异常检测。

假设您通常在家中登录应用上的帐户。 如果您突然从数千英里外的位置登录帐户,或者在另一种情况下,您以前从未使用过公共计算机登录帐户,那将是非常可疑的,但是突然有一天您这样做。 另一个可疑的情况可能是您尝试 10-20 次密码,每次在成功成功登录之前每次都输入错误密码。 当您的帐户遭到盗用时,所有这些情况都是可能的行为。 因此,重要的是要合并一个能够确定您的常规行为并对异常行为进行分类的系统。 换句话说,即使黑客使用了正确的密码,企图破坏您的帐户的尝试也应标记为异常。

这带给我们一个有趣的观点,即确定用户的常规行为。 我们如何做到这一点? 什么是正常行为? 它是针对每个用户的还是一个通用概念? 问题的答案是它是非常特定于用户的。 但是,行为的某些方面对于所有用户而言都可以相同。 一个应用可能会在多个屏幕上启动登录。 单个用户可能更喜欢其中一种或两种方法。 这将导致特定于该用户的特定于用户的行为。 但是,如果尝试从未由开发人员标记为登录屏幕的屏幕进行登录,则无论是哪个用户尝试登录,都肯定是异常的。

在我们的应用中,我们将集成一个这样的系统。 为此,我们将记录一段时间内我们应用的许多用户进行的所有登录尝试。 我们将特别注意他们尝试登录的屏幕以及它们传递给系统的数据类型。 一旦收集了很多这些样本,就可以根据用户执行的任何操作来确定系统对认证的信心。 如果系统在任何时候认为用户表现出的行为与他们的惯常行为相差很大,则该用户将未经认证并被要求验证其帐户详细信息。

让我们从创建预测模型开始,以确定用户认证是常规的还是异常的。

用于认证用户的自定义模型

我们将本节分为两个主要子节:

- 构建用于认证有效性检查的模型

- 托管自定义认证验证模型

让我们从第一部分开始。

构建用于认证有效性检查的模型

在本部分中,我们将构建模型来确定是否有任何用户正在执行常规登录或异常登录:

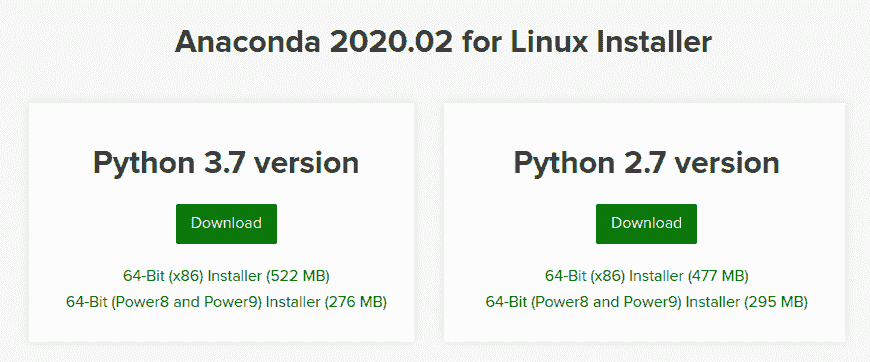

- 我们首先导入必要的模块,如下所示:

import sys

import os

import json

import pandas

import numpy

from keras.models import Sequential

from keras.layers import LSTM, Dense, Dropout

from keras.layers.embeddings import Embedding

from keras.preprocessing import sequence

from keras.preprocessing.text import Tokenizer

from collections import OrderedDict

- 现在,我们将数据集导入到项目中。 可以在这里中找到该数据集:

csv_file = 'data.csv'

dataframe = pandas.read_csv(csv_file, engine='python', quotechar='|', header=None)

count_frame = dataframe.groupby([1]).count()

print(count_frame)

total_req = count_frame[0][0] + count_frame[0][1]

num_malicious = count_frame[0][1]

print("Malicious request logs in dataset: {:0.2f}%".format(float(num_malicious) / total_req * 100))

前面的代码块将 CSV 数据集加载到项目中。 它还会打印一些与数据有关的统计信息,如下所示:

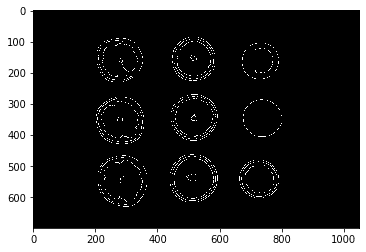

- 我们在上一步中加载的数据目前尚无法使用,无法进行深度学习。 在此步骤中,我们将其分为特征列和标签列,如下所示:

X = dataset[:,0]

Y = dataset[:,1]

- 接下来,我们将删除数据集中包含的某些列,因为我们不需要所有这些列来构建简单的模型:

for index, item in enumerate(X):

reqJson = json.loads(item, object_pairs_hook=OrderedDict)

del reqJson['timestamp']

del reqJson['headers']

del reqJson['source']

del reqJson['route']

del reqJson['responsePayload']

X[index] = json.dumps(reqJson, separators=(',', ':'))

- 接下来,我们将在剩余的请求正文上执行分词。 分词是一种用于将大文本块分解为较小文本的方法,例如将段落分成句子,将句子分成单词。 我们这样做如下:

tokenizer = Tokenizer(filters='\t\n', char_level=True)

tokenizer.fit_on_texts(X)

- 分词之后,我们将请求正文中的文本转换为单词向量,如下一步所示。 我们将数据集和

DataFrame标签分为两部分,即 75%-25%,以进行训练和测试:

num_words = len(tokenizer.word_index)+1

X = tokenizer.texts_to_sequences(X)

max_log_length = 1024

train_size = int(len(dataset) * .75)

X_processed = sequence.pad_sequences(X, maxlen=max_log_length)

X_train, X_test = X_processed[0:train_size], X_processed[train_size:len(X_processed)]

Y_train, Y_test = Y[0:train_size], Y[train_size:len(Y)]

- 接下来,我们基于长短期记忆(LSTM)创建基于循环神经网络(RNN)的学习方法,来识别常规用户行为。 将单词嵌入添加到层中,以帮助维持单词向量和单词之间的关系:

model = Sequential()

model.add(Embedding(num_words, 32, input_length=max_log_length))

model.add(Dropout(0.5))

model.add(LSTM(64, recurrent_dropout=0.5))

model.add(Dropout(0.5))

model.add(Dense(1, activation='sigmoid'))

我们的输出是单个神经元,在正常登录的情况下,该神经元保存0;在登录异常的情况下,则保存1。

- 现在,我们以精度作为度量标准编译模型,而损失则作为二进制交叉熵来计算:

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

print(model.summary())

- 现在,我们准备进行模型的训练:

model.fit(X_train, Y_train, validation_split=0.25, epochs=3, batch_size=128)

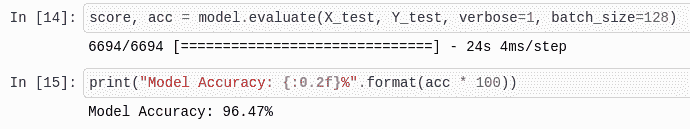

- 我们将快速检查模型所达到的准确率。 当前模型的准确率超过 96%:

score, acc = model.evaluate(X_test, Y_test, verbose=1, batch_size=128)

print("Model Accuracy: {:0.2f}%".format(acc * 100))

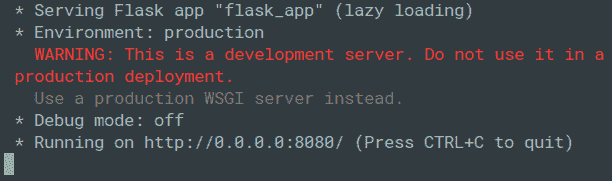

下面的屏幕快照显示了前面代码块的输出:

- 现在,我们保存模型权重和模型定义。 我们稍后将它们加载到 API 脚本中,以验证用户的认证:

model.save_weights('lstm-weights.h5')

model.save('lstm-model.h5')

现在,我们可以将认证模型作为 API 进行托管,我们将在下一部分中进行演示。

托管自定义认证验证模型

在本节中,我们将创建一个 API,用于在用户向模型提交其登录请求时对其进行认证。 请求标头将被解析为字符串,并且模型将使用它来预测登录是否有效:

- 我们首先导入创建 API 服务器所需的模块:

from sklearn.externals import joblib

from flask import Flask, request, jsonify

from string import digits

import sys

import os

import json

import pandas

import numpy

import optparse

from keras.models import Sequential, load_model

from keras.preprocessing import sequence

from keras.preprocessing.text import Tokenizer

from collections import OrderedDict

- 现在,我们实例化一个

Flask应用对象。 我们还将从上一节“构建用于认证有效性检查的模型”中加载保存的模型定义和模型权重。然后,我们重新编译模型,并使用_make_predict_function( )方法创建其预测方法,如以下步骤所示:

app = Flask(__name__)

model = load_model('lstm-model.h5')

model.load_weights('lstm-weights.h5')

model.compile(loss = 'binary_crossentropy', optimizer = 'adam', metrics = ['accuracy'])

model._make_predict_function()

- 然后,我们创建一个

remove_digits()函数,该函数用于从提供给它的输入中去除所有数字。 这将用于在将请求正文文本放入模型之前清除它:

def remove_digits(s: str) -> str:

remove_digits = str.maketrans('', '', digits)

res = s.translate(remove_digits)

return res

- 接下来,我们将在 API 服务器中创建

/login路由。 该路由由login()方法处理,并响应GET和POST请求方法。 正如我们对训练输入所做的那样,我们删除了请求标头中的非必要部分。 这可以确保模型将对数据进行预测,类似于对其进行训练的数据:

@app.route('/login', methods=['GET, POST'])

def login():

req = dict(request.headers)

item = {}

item["method"] = str(request.method)

item["query"] = str(request.query_string)

item["path"] = str(request.path)

item["statusCode"] = 200

item["requestPayload"] = []

## MORE CODE BELOW THIS LINE

## MORE CODE ABOVE THIS LINE

response = {'result': float(prediction[0][0])}

return jsonify(response)

- 现在,我们将代码添加到

login()方法中,该方法将标记请求正文并将其传递给模型以执行有关登录请求有效性的预测,如下所示:

@app.route('/login', methods=['GET, POST'])

def login():

...

## MORE CODE BELOW THIS LINE

X = numpy.array([json.dumps(item)])

log_entry = "store"

tokenizer = Tokenizer(filters='\t\n', char_level=True)

tokenizer.fit_on_texts(X)

seq = tokenizer.texts_to_sequences([log_entry])

max_log_length = 1024

log_entry_processed = sequence.pad_sequences(seq, maxlen=max_log_length)

prediction = model.predict(log_entry_processed)

## MORE CODE ABOVE THIS LINE

...

最后,应用以 JSON 字符串的形式返回其对用户进行认证的信心。

- 最后,我们使用

app的run()方法启动服务器脚本:

if __name__ == '__main__':

app.run(host='0.0.0.0', port=8000)

- 将此文件另存为

main.py。 要开始执行服务器,请打开一个新终端并使用以下命令:

python main.py

服务器监听其运行系统的所有传入 IP。 通过在0.0.0.0 IP 上运行它,可以实现这一点。 如果我们希望稍后在基于云的服务器上部署脚本,则需要这样做。 如果不指定0.0.0.0主机,则默认情况下会使它监听127.0.0.1,这不适合在公共服务器上进行部署。 您可以在此处详细了解这些地址之间的区别。

在下一节中,我们将看到如何将 ReCaptcha 集成到迄今为止在该项目中构建的应用中。 之后,我们将把本节中构建的 API 集成到应用中。

实现 ReCaptcha 来保护垃圾邮件

为了为 Firebase 认证增加另一层安全性,我们将使用 ReCaptcha。 这是 Google 所支持的一项测试,可帮助我们保护数据免受垃圾邮件和滥用行为的自动 bot 攻击。 该测试很简单,很容易被人类解决,但是却阻碍了漫游器和恶意用户的使用。

要了解有关 ReCaptcha 及其用途的更多信息,请访问这里。

ReCAPTCHA v2

在本节中,我们将把 ReCaptcha 版本 2 集成到我们的应用中。 在此版本中,向用户显示一个简单的复选框。 如果刻度变为绿色,则表明用户已通过验证。

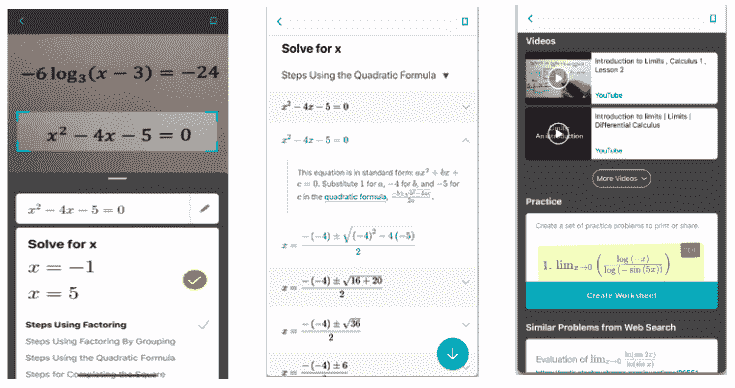

另外,还可以向用户提出挑战,以区分人和机器人。 这个挑战很容易被人类解决。 他们要做的就是根据说明选择一堆图像。 使用 ReCaptcha 进行认证的传统流程如下所示:

一旦用户能够验证其身份,他们就可以成功登录。

获取 API 密钥

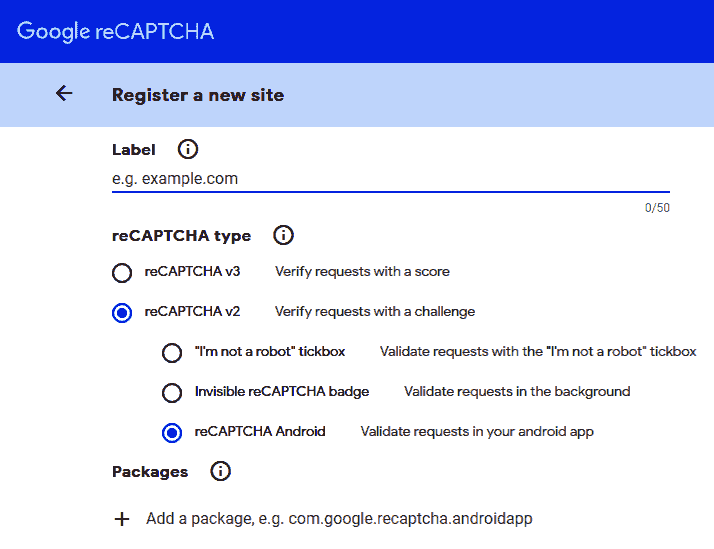

要在我们的应用内部使用 ReCaptcha,我们需要在reCAPTCHA管理控制台中注册该应用,并获取站点密钥和秘密密钥。 为此,请访问这里并注册该应用。 您将需要导航到“注册新站点”部分,如以下屏幕截图所示:

我们可以通过以下两个简单步骤来获取 API 密钥:

- 首先提供一个域名。 在这里,我们将在 reCAPTCHA v2 下选择 reCAPTCHA Android。

- 选择 Android 版本后,添加项目的包名称。 正确填写所有信息后,单击“注册”。

这将引导您到显示站点密钥和秘密密钥的屏幕,如以下屏幕快照所示:

将站点密钥和秘密密钥复制并保存到安全位置。 我们将在编码应用时使用它们。

代码整合

为了在我们的应用中包含 ReCaptcha v2,我们将使用 Flutter 包flutter_recaptcha_v2。 将flutter_recaptcha_v2:0.1.0依赖项添加到pubspec.yaml文件中,然后在终端中运行flutter packages get以获取所需的依赖项。 以下步骤详细讨论了集成:

- 我们将代码添加到

signup_signin_screen.dart。 首先导入依赖项:

import 'package:flutter_recaptcha_v2/flutter_recaptcha_v2.dart';

- 接下来,创建一个

RecaptchaV2Controller实例:

RecaptchaV2Controller recaptchaV2Controller = RecaptchaV2Controller();

- reCAPTCHA 复选框将添加为小部件。 首先,让我们定义一个返回小部件的

_createRecaptcha()方法:

Widget _createRecaptcha() {

return RecaptchaV2(

apiKey: "Your Site Key here",

apiSecret: "Your API Key here",

controller: recaptchaV2Controller,

onVerifiedError: (err){

print(err);

},

onVerifiedSuccessfully: (success) {

setState(() {

if (success) {

_signinSignup();

} else {

print('Failed to verify');

}

});

},

);

}

在上述方法中,我们仅使用RecaptchaV2()构造器,即可为特定属性指定值。 添加您先前在apiKey和apiSecret属性中注册时保存的站点密钥和秘密密钥。 我们使用先前为属性控制器创建的recaptcha控制器recaptchaV2Controller的实例。 如果成功验证了用户,则将调用_signinSignup()方法以使用户登录。如果在验证期间发生错误,我们将打印错误。

- 现在,由于在用户尝试登录时应显示

reCaptcha,因此我们将createSigninButton()中的登录凸起按钮的onPressed属性修改为recaptchaV2Controller:

Widget _createSigninButton() {

. . . . . . .

return new Padding(

. . . . . . .

child: new RaisedButton(

. . . . . .

//Modify the onPressed property

onPressed: recaptchaV2Controller.show

)

)

}

- 最后,我们将

_createRecaptcha()添加到build()内部的主体栈中:

@override

Widget build(BuildContext context) {

. . . . . . .

return new Scaffold(

. . . . . . .

body: Stack(

children: <Widget>[

_createBody(),

_createCircularProgress(),

//Add reCAPTCHA Widget

_createRecaptcha()

],

));

}

这就是一切! 现在,我们具有比 Firebase 认证更高的安全级别,可以保护应用的数据免受自动机器人的攻击。 现在让我们看一下如何集成定制模型以检测恶意用户。

在 Flutter 中部署模型

至此,我们的 Firebase 认证应用与 ReCaptcha 保护一起运行。 现在,让我们添加最后的安全层,该层将不允许任何恶意用户进入应用。

我们已经知道该模型位于以下端点。 我们只需从应用内部进行 API 调用,传入用户提供的电子邮件和密码,并从模型中获取结果值。 该值将通过使用阈值结果值来帮助我们判断登录是否是恶意的。

如果该值小于 0.20,则认为该登录名是恶意的,并且屏幕上将显示以下消息:

现在,让我们看一下在 Flutter 应用中部署模型的步骤:

- 首先,由于我们正在获取数据并且将使用网络调用(即 HTTP 请求),因此我们需要向

pubspec.yaml文件添加http依赖项,并按以下方式导入:

import 'package:http/http.dart' as http;

- 首先在

auth.dart:内部定义的BaseAuth抽象类中添加以下函数声明

Future<double> isValidUser(String email, String password);

- 现在,让我们在

Auth类中定义isValidUser()函数:

Future<double> isValidUser(String email, String password) async{

final response = await http.Client()

.get('http://34.67.160.232:8000/login?user=$email&password=$password');

var jsonResponse = json.decode(response.body);

var val = '${jsonResponse["result"]}';

double result = double.parse(val);

return result;

}

此函数将用户的电子邮件和密码作为参数,并将它们附加到请求 URL,以便为特定用户生成输出。 get request响应存储在变量响应中。 由于响应为 JSON 格式,因此我们使用json.decode()对其进行解码,并将解码后的响应存储在另一个变量响应中。 现在,我们使用‘${jsonResponse["result"]}'访问jsonResponse中的结果值,使用double.parse()将其转换为双精度类型整数,并将其存储在结果中。 最后,我们返回结果的值。

- 为了激活代码内部的恶意检测,我们从

SigninSignupScreen调用了isValidUser()方法。 当具有现有帐户的用户选择从if-else块内部登录时,将调用此方法:

if (_formMode == FormMode.SIGNIN) {

var val = await widget.auth.isValidUser(_usermail, _userpassword);

. . . .

} else {

. . . .

}

isValidUser返回的值存储在val变量中。

- 如果该值小于 0.20,则表明登录活动是恶意的。 因此,我们将异常抛出并在 catch 块内抛出

catch并在屏幕上显示错误消息。 这可以通过创建自定义异常类MalicousUserException来完成,该类在实例化时返回一条错误消息:

class MaliciousUserException implements Exception {

String message() => 'Malicious login! Please try later.';

}

- 现在,我们将在调用

isValidUser()之后添加if块,以检查是否需要抛出异常:

var val = await widget.auth.isValidUser(_usermail, _userpassword);

//Add the if block

if(val < 0.20) {

throw new MaliciousUserException();

}

- 现在,该异常已捕获在

catch块内,并且不允许用户继续登录。此外,我们将_loading设置为false以表示不需要进一步的网络操作:

catch(MaliciousUserException) {

setState(() {

_loading = false;

_errorMessage = 'Malicious user detected. Please try again later.';

});

这就是一切! 我们之前基于 Firebase 认证创建的 Flutter 应用现在可以在后台运行智能模型的情况下找到恶意用户。

总结

在本章中,我们了解了如何使用 Flutter 和由 Firebase 支持的认证系统构建跨平台应用,同时结合了深度学习的优势。 然后,我们了解了如何将黑客攻击尝试归类为一般用户行为中的异常现象,并创建了一个模型来对这些异常现象进行分类以防止恶意用户登录。最后,我们使用了 Google 的 ReCaptcha 来消除对该应用的垃圾邮件使用,因此,使其在自动垃圾邮件或脚本化黑客攻击方面更具弹性。

在下一章中,我们将探索一个非常有趣的项目–使用移动应用上的深度学习生成音乐成绩单。

七、语音/多媒体处理 - 使用 AI 生成音乐

鉴于人工智能(AI)的应用越来越多,将 AI 与音乐结合使用的想法已经存在了很长时间,并且受到了广泛的研究。 由于音乐是一系列音符,因此它是时间序列数据集的经典示例。 最近证明时间序列数据集在许多预测领域中非常有用–股市,天气模式,销售模式以及其他基于时间的数据集。 循环神经网络(RNN)是处理时间序列数据集的最多模型之一。 对 RNN 进行的流行增强称为长短期记忆(LSTM)神经元。 在本章中,我们将使用 LSTM 处理音符。

多媒体处理也不是一个新话题。 在本项目系列的早期,我们在多章中详细介绍了图像处理。 在本章中,我们将讨论并超越图像处理,并提供一个带有音频的深度学习示例。 我们将训练 Keras 模型来生成音乐样本,每次都会生成一个新样本。 然后,我们将此模型与 Flutter 应用结合使用,以通过 Android 和 iOS 设备上的音频播放器进行部署。

在本章中,我们将介绍以下主题:

- 设计项目的架构

- 了解多媒体处理

- 开发基于 RNN 的音乐生成模型

- 在 Android 和 iOS 上部署音频生成 API

让我们首先概述该项目的架构。

设计项目的架构

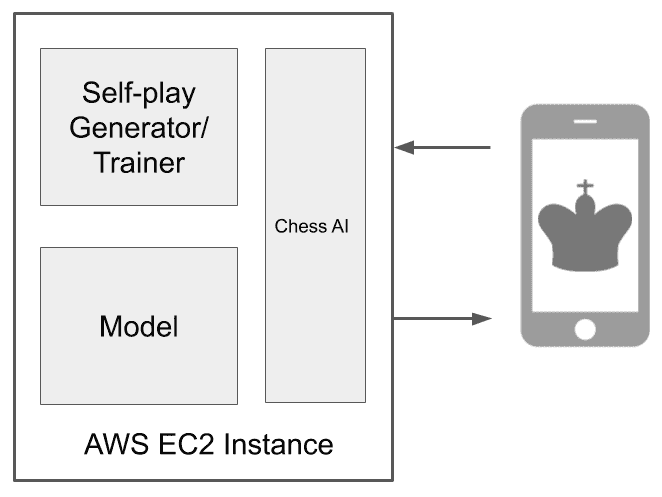

该项目的架构与作为应用部署的常规深度学习项目略有不同。 我们将有两组不同的音乐样本。 第一组样本将用于训练可以生成音乐的 LSTM 模型。 另一组样本将用作 LSTM 模型的随机输入,该模型将输出生成的音乐样本。 我们稍后将开发和使用的基于 LSTM 的模型将部署在 Google Cloud Platform(GCP)上。 但是,您可以将其部署在 AWS 或您选择的任何其他主机上。

下图总结了将在本项目中使用的不同组件之间的交互:

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-pw7KUWRD-1681785128417)(https://gitcode.net/apachecn/apachecn-dl-zh/-/raw/master/docs/mobi-dl-tflite/img/50f17dc4-2658-4211-a7ff-9c41daafd884.png)]

移动应用要求部署在服务器上的模型生成新的音乐样本。 该模型使用随机音乐样本作为输入,以使其通过预先训练的模型来生成新的音乐样本。 然后,新的音乐样本由移动设备获取并播放给用户。

您可以将此架构与我们之前介绍的架构进行比较,在该架构中,将有一组用于训练的数据样本,然后将模型部署在云上或本地,并用于作出预测。

我们还可以更改此项目架构,以在存在为 Dart 语言编写的 midi 文件处理库的情况下在本地部署模型。 但是,在撰写本文时,还没有与我们在开发模型时使用的 Python midi 文件库的要求兼容的稳定库。

让我们从学习多媒体处理的含义以及如何使用 OpenCV 处理多媒体文件开始。

了解多媒体处理

多媒体是几乎所有形式的视觉,听觉或两者兼有的内容的总称。 术语多媒体处理本身非常模糊。 讨论该术语的更精确方法是将其分解为两个基本部分-视觉或听觉。 因此,我们将讨论多媒体处理的术语,即图像处理和音频处理。 这些术语的混合产生了视频处理,这只是多媒体的另一种形式。

在以下各节中,我们将以单独的形式讨论它们。

图像处理

图像处理或计算机视觉是迄今为止人工智能研究最多的分支之一。 在过去的几十年中,它发展迅速,并在以下几种技术的进步中发挥了重要作用:

- 图像过滤器和编辑器

- 面部识别

- 数字绘画

- 自动驾驶汽车

我们在较早的项目中讨论了图像处理的基础知识。 在这个项目中,我们将讨论一个非常流行的用于执行图像处理的库-OpenCV。 OpenCV 是开源计算机视觉的缩写。 它由 Intel 开发,并由 Willow Garage 和 Itseez(后来被 Intel 收购)推动。 毫无疑问,由于它与所有主要的机器学习框架(例如 TensorFlow,PyTorch 和 Caffe)兼容,因此它是执行图像处理的全球大多数开发人员的首要选择。 除此之外,OpenCV 还可以使用多种语言,例如 C++,Java 和 Python。

要在 Python 环境中安装 OpenCV,可以使用以下命令:

pip install opencv-contrib-python

前面的命令将同时安装主 OpenCV 模块和contrib模块。 您可以在此处找到更多模块供您选择。 有关更多安装说明,如果前面的链接不符合您的要求,则可以在此处遵循官方文档。

让我们为您介绍一个非常简单的示例,说明如何使用 OpenCV 执行图像处理。 创建一个新的 Jupyter 笔记本,并从以下步骤开始:

- 要将 OpenCV 导入笔记本,请使用以下代码行:

import cv2

- 我们还要将 matplotlib 导入笔记本,因为如果您尝试使用本机 OpenCV 图像显示功能,Jupyter 笔记本将会崩溃:

from matplotlib import pyplot as plt

%matplotlib inline

- 让我们使用 matplotlib 为 OpenCV 的本机图像显示功能创建一个替代函数,以方便在笔记本中显示图像:

def showim(image):

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

plt.imshow(image)

plt.show()

请注意,我们将图像的配色方案从蓝色绿色红色(BGR)转换为红色绿色蓝色(RGB)。 这是由于默认情况下 OpenCV 使用 BGR 配色方案。 但是,matplotlib 在显示图片时会使用 RGB 方案,并且如果不进行这种转换,我们的图像就会显得奇怪。

- 现在,让我们将图像读取到 Jupyter 笔记本中。 完成后,我们将能够看到加载的图像:

image = cv2.imread("Image.jpeg")

showim(image)

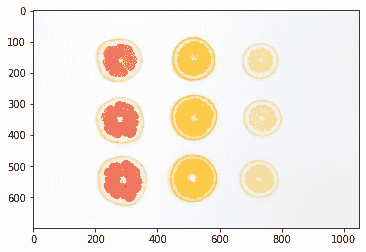

前面代码的输出取决于您选择加载到笔记本中的图像:

在我们的示例中,我们加载了柑橘类水果切片的图像,这是艾萨克·奎萨达(Isaac Quesada)在“Unsplash”上拍摄的惊人照片。

您可以在这里找到上一张图片。

- 让我们通过将之前的图像转换为灰度图像来进行简单的操作。 为此,我们就像在声明的

showim()函数中那样简单地使用转换方法:

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

showim(gray_image)

这将产生以下输出:

- 现在让我们执行另一种常见的操作,即图像模糊。 在图像处理中通常采用模糊处理,以消除图像中信息的不必要的细节(此时)。 我们使用高斯模糊过滤器,这是在图像上创建模糊的最常见算法之一:

blurred_image = cv2.GaussianBlur(image, (7, 7), 0)

showim(blurred_image)

这将产生以下输出:

请注意,前面的图像不如原始图像清晰。 但是,它很容易达到愿意计算此图像中对象数量的目的。

- 为了在图像中定位对象,我们首先需要标记图像中的边缘。 为此,我们可以使用

Canny()方法,该方法是 OpenCV 中可用的其他选项之一,用于查找图像的边缘:

canny = cv2.Canny(blurred_image, 10, 50)

showim(canny)

这将产生以下输出:

请注意,在上图中找到的边缘数量很高。 虽然这会显示图像的细节,但是如果我们尝试对边缘进行计数以尝试确定图像中的对象数量,这将无济于事。

- 让我们尝试计算上一步生成的图像中不同项目的数量:

contours, hierarchy= cv2.findContours(canny, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

print("Number of objects found = ", len(contours))

上面的代码将产生以下输出:

Number of objects found = 18

但是,我们知道前面的图像中没有 18 个对象。 只有 9。因此,在寻找边缘时,我们将在canny方法中处理阈值。

- 让我们在 canny 方法中增加边缘发现的阈值。 这使得更难检测到边缘,因此仅使最明显的边缘可见:

canny = cv2.Canny(blurred_image, 50, 150)

showim(canny)

这将产生以下输出:

请注意,在柑橘类水果体内发现的边缘急剧减少,仅清晰可见其轮廓。 我们希望这会在计数时产生较少的对象。

- 让我们再次运行以下代码块:

contours, hierarchy= cv2.findContours(canny, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

print("Number of objects found = ", len(contours))

这将产生以下输出:

Number of objects found = 9

这是期望值。 但是,只有在特殊情况下,该值才是准确的。

- 最后,让我们尝试概述检测到的对象。 为此,我们绘制了

findContours()方法的上一步中确定的轮廓:

_ = cv2.drawContours(image, contours, -1, (0,255,0), 10)

showim(image)

这将产生以下输出:

请注意,我们已经在拍摄的原始图像中非常准确地识别出了九片水果。 我们可以进一步扩展此示例,以在任何图像中找到某些类型的对象。

要了解有关 OpenCV 的更多信息并找到一些可供学习的示例,请访问以下存储库。

现在让我们学习如何处理音频文件。

音频处理

我们已经看到了如何处理图像以及可以从中提取信息。 在本节中,我们将介绍音频文件的处理。 音频或声音是吞没您周围环境的东西。 在许多情况下,您仅能从该区域的音频剪辑中正确预测该区域或环境,而无需实际看到任何视觉提示。 声音或语音是人与人之间交流的一种形式。 安排良好的节奏模式形式的音频称为音乐,可以使用乐器制作。

音频文件的一些流行格式如下:

- MP3:一种非常流行的格式,广泛用于共享音乐文件。

- AAC:是对 MP3 格式的改进,AAC 主要用于 Apple 设备。

- WAV:由 Microsoft 和 IBM 创建,这种格式是无损压缩,即使对于小的音频文件也可能很大。

- MIDI:乐器数字接口文件实际上不包含音频。 它们包含乐器音符,因此体积小且易于使用。

音频处理是以下技术的增长所必需的:

- 用于基于语音的界面或助手的语音处理

- 虚拟助手的语音生成

- 音乐生成

- 字幕生成

- 推荐类似音乐

TensorFlow 团队的 Magenta 是一种非常流行的音频处理工具。

您可以通过这里访问 Magenta 主页。 该工具允许快速生成音频和音频文件的转录。

让我们简要地探讨 Magenta。

Magenta

Magenta 是 Google Brain 团队参与研究的一部分,该团队也参与了 TensorFlow。 它被开发为一种工具,可允许艺术家借助深度学习和强化学习算法来增强其音乐或艺术创作渠道。 这是 Magenta 的徽标:

让我们从以下步骤开始:

- 要在系统上安装 Magenta,可以使用 Python 的 pip 存储库:

pip install magenta

- 如果缺少任何依赖项,则可以使用以下命令安装它们:

!apt-get update -qq && apt-get install -qq libfluidsynth1 fluid-soundfont-gm build-essential libasound2-dev libjack-dev

!pip install -qU pyfluidsynth pretty_midi

- 要将 Magenta 导入项目中,可以使用以下命令:

import magenta

或者,按照流行的惯例,仅加载 Magenta 的音乐部分,可以使用以下命令:

import magenta.music as mm

您可以使用前面的导入在线找到很多样本。

让我们快速创作一些音乐。 我们将创建一些鼓声,然后将其保存到 MIDI 文件:

- 我们首先需要创建一个

NoteSequence对象。 在 Magenta 中,所有音乐都以音符序列的格式存储,类似于 MIDI 存储音乐的方式:

from magenta.protobuf import music_pb2

drums = music_pb2.NoteSequence()

- 创建

NoteSequence对象后,该对象为空,因此我们需要向其添加一些注解:

drums.notes.add(pitch=36, start_time=0, end_time=0.125, is_drum=True, instrument=10, velocity=80)

drums.notes.add(pitch=38, start_time=0, end_time=0.125, is_drum=True, instrument=10, velocity=80)

drums.notes.add(pitch=42, start_time=0, end_time=0.125, is_drum=True, instrument=10, velocity=80)

drums.notes.add(pitch=46, start_time=0, end_time=0.125, is_drum=True, instrument=10, velocity=80)

.

.

.

drums.notes.add(pitch=42, start_time=0.75, end_time=0.875, is_drum=True, instrument=10, velocity=80)

drums.notes.add(pitch=45, start_time=0.75, end_time=0.875, is_drum=True, instrument=10, velocity=80)

请注意,在前面的代码中,每个音符都有音高和力度。 再次类似于 MIDI 文件。

- 现在让我们为音符添加节奏,并设置音乐播放的总时间:

drums.total_time = 1.375

drums.tempos.add(qpm=60)

完成此操作后,我们现在准备导出 MIDI 文件。

- 我们首先需要将 Magenta

NoteSequence对象转换为 MIDI 文件:

mm.sequence_proto_to_midi_file(drums, 'drums_sample_output.mid')

前面的代码首先将音符序列转换为 MIDI,然后将它们写入磁盘上的drums_sample_output.mid文件。 您现在可以使用任何合适的音乐播放器播放midi文件。

继续前进,让我们探索如何处理视频。

视频处理

视频处理是多媒体处理的另一个重要部分。 通常,我们需要弄清楚移动场景中发生的事情。 例如,如果我们要生产自动驾驶汽车,则它需要实时处理大量视频才能平稳行驶。 这种情况的另一个实例可以是将手语转换为文本以帮助与语音障碍者互动的设备。 此外,需要视频处理来创建电影和动作效果。

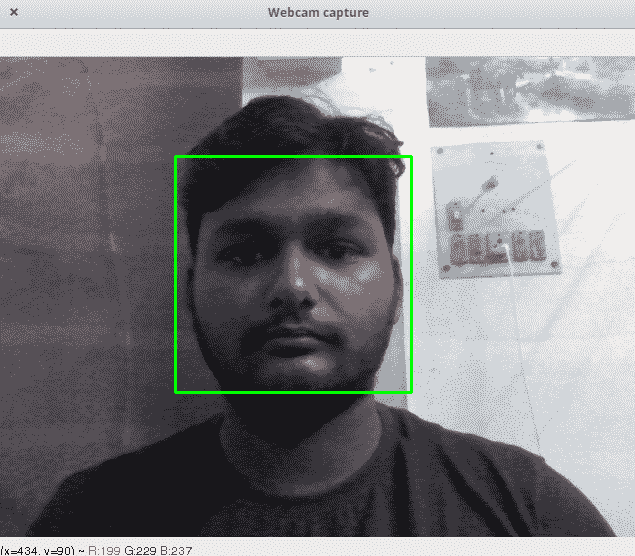

我们将在本节中再次探讨 OpenCV。 但是,我们将演示如何在 OpenCV 中使用实时摄像机供稿来检测面部。

创建一个新的 Python 脚本并执行以下步骤:

- 首先,我们需要对脚本进行必要的导入。 这将很简单,因为我们只需要 OpenCV 模块:

import cv2

- 现在,让我们将 Haar 级联模型加载到脚本中。 Haar 级联算法是一种用于检测任何给定图像中的对象的算法。 由于视频不过是图像流,因此我们将其分解为一系列帧并检测其中的人脸:

faceCascade = cv2.CascadeClassifier("haarcascade_frontalface_default.xml")

您将不得不从以下位置获取haarcascade_frontalface_default.xml文件。

Haar 级联是一类使用级联函数执行分类的分类器算法。 保罗·维奥拉(Paul Viola)和迈克尔·琼斯(Michael Jones)引入了它们,以试图建立一种对象检测算法,该算法足够快以在低端设备上运行。 级联函数池来自几个较小的分类器。

Haar 级联文件通常以可扩展标记语言(XML)的格式找到,并且通常执行一项特定功能,例如面部检测,身体姿势检测, 对象检测等。 您可以在此处阅读有关 Haar 级联的更多信息。

- 现在,我们必须实例化摄像机以进行视频捕获。 为此,我们可以使用默认的笔记本电脑摄像头:

video_capture = cv2.VideoCapture(0)

- 现在让我们从视频中捕获帧并显示它们:

while True:

# Capture frames

ret, frame = video_capture.read()

### We'll add code below in future steps

### We'll add code above in future steps

# Display the resulting frame

cv2.imshow('Webcam Capture', frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

这样您就可以在屏幕上显示实时视频供稿。 在运行此程序之前,我们需要释放相机并正确关闭窗户。

- 要正确关闭实时捕获,请使用以下命令:

video_capture.release()

cv2.destroyAllWindows()

现在,让我们对脚本进行测试运行。

您应该会看到一个窗口,其中包含您的脸部实时捕捉的图像(如果您不害羞的话)。

- 让我们向该视频提要添加面部检测。 由于用于面部检测的 Haar 级联在使用灰度图像时效果更好,因此我们将首先将每个帧转换为灰度,然后对其进行面部检测。 我们需要将此代码添加到

while循环中,如以下代码所示:

### We'll add code below in future steps

gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

faces = faceCascade.detectMultiScale(

gray,

scaleFactor=1.1,

minNeighbors=5,

minSize=(30, 30),

flags=cv2.CASCADE_SCALE_IMAGE

)

### We'll add code above in future steps

这样,我们就可以检测到人脸了,因此让我们在视频供稿中对其进行标记!

- 我们将简单地使用 OpenCV 的矩形绘制函数在屏幕上标记面孔:

minNeighbors=5,

minSize=(30, 30),

flags=cv2.CASCADE_SCALE_IMAGE

)

for (x, y, w, h) in faces:

cv2.rectangle(frame, (x, y), (x+w, y+h), (0, 255, 0), 2)

### We'll add code above in future steps

现在让我们再次尝试运行脚本。

转到终端并使用以下命令运行脚本:

python filename.py

在这里,文件名是您保存脚本文件时的名称。

您应该获得类似于以下屏幕截图的输出:

要退出实时网络摄像头捕获,请使用键盘上的Q键(我们已在前面的代码中进行了设置)。

我们已经研究了多媒体处理的三种主要形式的概述。 现在,让我们继续前进,构建基于 LSTM 的模型以生成音频。

开发基于 RNN 的音乐生成模型

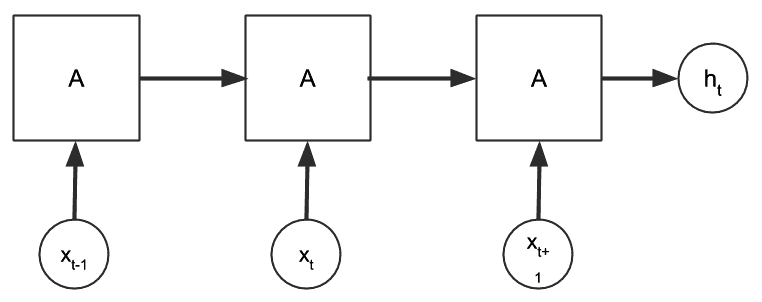

在本节中,我们将开发音乐生成模型。 我们将为此使用 RNN,并使用 LSTM 神经元模型。 RNN 与简单的人工神经网络(ANN)有很大的不同-允许在层之间重复使用输入。

虽然在 ANN 中,我们希望输入到神经网络的输入值向前移动,然后产生基于错误的反馈,并将其合并到网络权重中,但 RNN 使输入多次循环返回到先前的层。

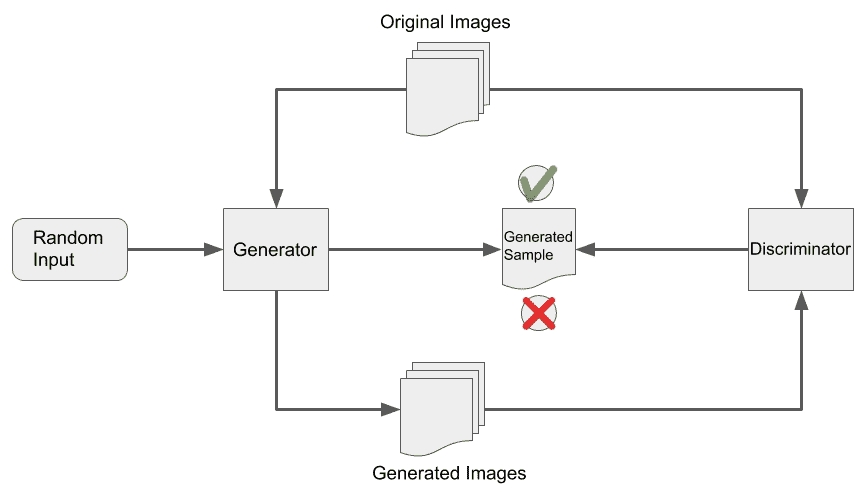

下图表示 RNN 神经元:

从上图可以看到,通过神经元激活函数后的输入分为两部分。 一部分在网络中向前移动到下一层或输出,而另一部分则反馈到网络中。 在时间序列数据集中,可以相对于给定样本在t的时间标记每个样本,我们可以扩展前面的图,如下所示:

但是,由于通过激活函数反复暴露值,RNN 趋向于梯度消失,其中 RNN 的值逐梯度小到可以忽略不计(或在梯度爆炸的情况下变大)。 为避免这种情况,引入了 LSTM 单元,该单元通过将信息存储在单元中而允许将信息保留更长的时间。 每个 LSTM 单元由三个门和一个存储单元组成。 三个门(输入,输出和遗忘门)负责确定哪些值存储在存储单元中。

因此,LSTM 单元变得独立于 RNN 其余部分的更新频率,并且每个单元格都有自己的时间来记住它所拥有的值。 就我们而言,与其他信息相比,我们忘记了一些随机信息的时间要晚得多,这更自然地模仿了自然。

您可以在以下链接中找到有关 RNN 和 LSTM 的详细且易于理解的解释。

在开始为项目构建模型之前,我们需要设置项目目录,如以下代码所示:

├── app.py

├── MusicGenerate.ipynb

├── Output/

└── Samples/

├── 0.mid

├── 1.mid

├── 2.mid

└── 3.mid

请注意,我们已经在Samples文件夹中下载了四个 MIDI 文件样本。 然后,我们创建了要使用的MusicGenerate.ipynb Jupyter 笔记本。 在接下来的几个步骤中,我们将仅在此 Jupyter 笔记本上工作。 app.py脚本当前为空,将来,我们将使用它来托管模型。

现在让我们开始创建基于 LSTM 的用于生成音乐的模型。

创建基于 LSTM 的模型

在本节中,我们将在 Jupyter 笔记本环境中研究MusicGenerate.ipynb笔记本:

- 在此笔记本中,我们将需要导入许多模块。 使用以下代码导入它们:

import mido

from mido import MidiFile, MidiTrack, Message

from tensorflow.keras.layers import LSTM, Dense, Activation, Dropout, Flatten

from tensorflow.keras.preprocessing import sequence

from tensorflow.keras.models import Sequential

from tensorflow.keras.optimizers import Adam

from sklearn.preprocessing import MinMaxScaler

import numpy as np

我们使用了mido库。 如果您的系统上未安装它,则可以使用以下命令来安装它:

pip install mido

注意,在前面的代码中,我们还导入了 Keras 模块和子部件。 该项目中使用的 TensorFlow 版本为 2.0。 为了在您的系统上安装相同版本或升级当前的 TensorFlow 安装,可以使用以下命令:

pip install --upgrade pip

pip install --upgrade tensorflow

现在,我们将继续阅读示例文件。

- 要将 MIDI 文件读入项目笔记本,请使用以下代码:

notes = []

for msg in MidiFile('Samples/0.mid') :

try:

if not msg.is_meta and msg.channel in [0, 1, 2, 3] and msg.type == 'note_on':

data = msg.bytes()

notes.append(data[1])

except:

pass

这将在notes列表中加载通道0,1,2和3的所有开头音符。

要了解有关注解,消息和频道的更多信息,请使用以下文档。

- 由于音符处于大于 0–1 范围的可变范围内,因此我们将使用以下代码将其缩放以适合公共范围:

scaler = MinMaxScaler(feature_range=(0,1))

scaler.fit(np.array(notes).reshape(-1,1))

notes = list(scaler.transform(np.array(notes).reshape(-1,1)))

- 我们基本上拥有的是随时间变化的笔记列表。 我们需要将其转换为时间序列数据集格式。 为此,我们使用以下代码转换列表:

notes = [list(note) for note in notes]

X = []

y = []

n_prev = 20

for i in range(len(notes)-n_prev):

X.append(notes[i:i+n_prev])

y.append(notes[i+n_prev])

我们已将其转换为一个集合,其中每个样本都带有未来的 20 个音符,并且在数据集的末尾具有过去的 20 个音符。这可以通过以下方式进行:如果我们有 5 个样本,例如M[1],M[2],M[3],M[4]和M[5],然后我们将它们安排在大小为 2 的配对中(类似于我们的 20),如下所示:

M[1] M[2]M[2] M[3]M[3] M[4],依此类推

- 现在,我们将使用 Keras 创建 LSTM 模型,如以下代码所示:

model = Sequential()

model.add(LSTM(256, input_shape=(n_prev, 1), return_sequences=True))

model.add(Dropout(0.3))

model.add(LSTM(128, input_shape=(n_prev, 1), return_sequences=True))

model.add(Dropout(0.3))

model.add(LSTM(256, input_shape=(n_prev, 1), return_sequences=False))

model.add(Dropout(0.3))

model.add(Dense(1))

model.add(Activation('linear'))

optimizer = Adam(lr=0.001)

model.compile(loss='mse', optimizer=optimizer)

随意使用此 LSTM 模型的超参数。

- 最后,我们将训练样本适合模型并保存模型文件:

model.fit(np.array(X), np.array(y), 32, 25, verbose=1)

model.save("model.h5")

这将在我们的项目目录中创建model.h5文件。 每当用户从应用发出生成请求时,我们都会将此文件与其他音乐样本一起使用,以随机生成新的乐曲。

现在,让我们使用 Flask 服务器部署此模型。

使用 Flask 部署模型

对于项目的这一部分,您可以使用本地系统,也可以在其他地方的app.py中部署脚本。 我们将编辑此文件以创建 Flask 服务器,该服务器生成音乐并允许下载生成的 MIDI 文件。

该文件中的某些代码与 Jupyter 笔记本类似,因为每次加载音频样本并将其与我们生成的模型一起使用时,音频样本始终需要进行类似的处理:

- 我们使用以下代码将所需的模块导入此脚本:

import mido

from mido import MidiFile, MidiTrack, Message

from tensorflow.keras.models import load_model

from sklearn.preprocessing import MinMaxScaler

import numpy as np

import random

import time

from flask import send_file

import os

from flask import Flask, jsonify

app = Flask(__name__)

请注意,我们进行的最后四次导入与之前在 Jupyter 笔记本中导入的内容不同。 同样,我们不需要将几个 Keras 组件导入此脚本,因为我们将从已经准备好的模型中加载。

在上一个代码块的最后一行代码中,我们实例化了一个名为app的 Flask 对象。

- 在此步骤中,我们将创建函数的第一部分,当在 API 上调用

/generate路由时,该函数将生成新的音乐样本:

@app.route('/generate', methods=['GET'])

def generate():

songnum = random.randint(0, 3)

### More code below this

- 一旦我们随机决定在音乐生成过程中使用哪个样本文件,我们就需要像 Jupyter 笔记本中的训练样本那样对它进行类似的转换:

def generate():

.

.

.

notes = []

for msg in MidiFile('Samples/%s.mid' % (songnum)):

try:

if not msg.is_meta and msg.channel in [0, 1, 2, 3] and msg.type == 'note_on':

data = msg.bytes()

notes.append(data[1])

except:

pass

scaler = MinMaxScaler(feature_range=(0, 1))

scaler.fit(np.array(notes).reshape(-1, 1))

notes = list(scaler.transform(np.array(notes).reshape(-1, 1)))

### More code below this

在前面的代码块中,我们加载了示例文件,并从训练过程中使用的相同通道中提取了其注解。

- 现在,我们将像在训练期间一样缩放音符:

def generate():

.

.

.

notes = [list(note) for note in notes]

X = []

y = []

n_prev = 20

for i in range(len(notes) - n_prev):

X.append(notes[i:i + n_prev])

y.append(notes[i + n_prev])

### More code below this

我们也将这些笔记列表转换为适合模型输入的形状,就像我们在训练过程中对输入所做的一样。

- 接下来,我们将使用以下代码来加载 Keras 模型并从该模型创建新的注解列表:

def generate():

.

.

.

model = load_model("model.h5")

xlen = len(X)

start = random.randint(0, 100)

stop = start + 200

prediction = model.predict(np.array(X[start:stop]))

prediction = np.squeeze(prediction)

prediction = np.squeeze(scaler.inverse_transform(prediction.reshape(-1, 1)))

prediction = [int(i) for i in prediction]

### More code below this

- 现在,我们可以使用以下代码将此音符列表转换为 MIDI 序列:

def generate():

.

.

.

mid = MidiFile()

track = MidiTrack()

t = 0

for note in prediction:

vol = random.randint(50, 70)

note = np.asarray([147, note, vol])

bytes = note.astype(int)

msg = Message.from_bytes(bytes[0:3])

t += 1

msg.time = t

track.append(msg)

mid.tracks.append(track)

### More code below this

- 现在,我们准备将文件保存到磁盘。 它包含从模型随机生成的音乐:

def generate():

.

.

.

epoch_time = int(time.time())

outputfile = 'output_%s.mid' % (epoch_time)

mid.save("Output/" + outputfile)

response = {'result': outputfile}

return jsonify(response)

因此,/generate API 以 JSON 格式返回生成的文件的名称。 然后,我们可以下载并播放此文件。

- 要将文件下载到客户端,我们需要使用以下代码:

@app.route('/download/' , methods=['GET'])

def download(fname):

return send_file("Output/"+fname, mimetype="audio/midi", as_attachment=True)

请注意,前面的函数在/download/filename路由上起作用,在该路由上,客户端根据上一代 API 调用的输出提供文件名。 下载的文件的 MIME 类型为audio/midi,它告诉客户端它是 MIDI 文件。

- 最后,我们可以添加将执行此服务器的代码:

if __name__ == '__main__':

app.run(host="0.0.0.0", port=8000)

完成此操作后,我们可以在终端中使用以下命令来运行服务器:

python app.py

如果代码中产生任何警告,您将从控制台获得一些调试信息。 完成此操作后,我们准备在下一节中为我们的 API 构建 Flutter 应用客户端。

在 Android 和 iOS 上部署音频生成 API

成功创建和部署模型后,现在开始构建移动应用。 该应用将用于获取和播放由先前创建的模型生成的音乐。

它将具有三个按钮:

- 生成音乐:生成新的音频文件

- 播放:播放新生成的文件

- 停止:停止正在播放的音乐

另外,它的底部将显示一些文本,以显示应用的当前状态。

该应用将显示如下:

该应用的小部件树如下所示:

![]()

现在开始构建应用的 UI。

创建 UI

我们首先创建一个新的 Dart 文件play_music.dart和一个有状态的小部件PlayMusic。 如前所述,在该文件中,我们将创建三个按钮来执行基本功能。 以下步骤描述了如何创建 UI:

- 定义

buildGenerateButton()方法以创建RaisedButton变量,该变量将用于生成新的音乐文件:

Widget buildGenerateButton() {

return Padding(

padding: EdgeInsets.only(left: 16, right: 16, top: 16),

child: RaisedButton(

child: Text("Generate Music"),

color: Colors.blue,

textColor: Colors.white,

),

);

}

在前面定义的函数中,我们创建一个RaisedButton,并添加Generate Music文本作为子元素。 color属性的Colors.blue值用于为按钮赋予蓝色。 另外,我们将textColor修改为Colors.white,以使按钮内的文本为白色。 使用EdgeInsets.only()给按钮提供左,右和顶部填充。 在后面的部分中,我们将在按钮上添加onPressed属性,以便每次按下按钮时都可以从托管模型中获取新的音乐文件。

- 定义

buildPlayButton()方法以播放新生成的音频文件:

Widget buildPlayButton() {

return Padding(

padding: EdgeInsets.only(left: 16, right: 16, top: 16),

child: RaisedButton(

child: Text("Play"),

onPressed: () {

play();

},

color: Colors.blue,

textColor: Colors.white,

),

);

}

在前面定义的函数中,我们创建一个RaisedButton,并添加"Play"文本作为子元素。 color属性的Colors.blue值用于为按钮赋予蓝色。 另外,我们将textColor修改为Colors.white,以使按钮内的文本为白色。 使用EdgeInsets.only()给按钮提供左,右和顶部填充。 在后面的部分中,我们将在按钮上添加onPressed属性,以在每次按下按钮时播放新生成的音乐文件。

- 定义

buildStopButton()方法以停止当前正在播放的音频:

Widget buildStopButton() {

return Padding(

padding: EdgeInsets.only(left: 16, right: 16, top: 16),

child: RaisedButton(

child: Text("Stop"),

onPressed: (){

stop();

},

color: Colors.blue,

textColor: Colors.white,

)

);

}

在前面定义的函数中,我们创建一个RaisedButton,并添加"Stop"文本作为子元素。 color属性的Colors.blue值用于为按钮赋予蓝色。 另外,我们将textColor修改为Colors.white,以使按钮内的文本为白色。 使用EdgeInsets.only()给按钮提供左,右和顶部填充。 在下一节中,我们将向按钮添加onPressed属性,以在按下按钮时停止当前播放的音频。

- 覆盖

PlayMusicState中的build()方法,以创建先前创建的按钮的Column:

@override

Widget build(BuildContext context) {

return Scaffold(

appBar: AppBar(

title: Text("Generate Play Music"),

),

body: Column(

crossAxisAlignment: CrossAxisAlignment.stretch,

children: <Widget>[

buildGenerateButton(),

buildPlayButton(),

buildStopButton(),

],

)

);

}

在前面的代码片段中,我们返回Scaffold。 它包含一个AppBar,其中具有[Generate Play Music]作为title。 Scaffold的主体是Column。 列的子级是我们在上一步中创建的按钮。 通过调用相应方法将按钮添加到该列中。 此外,crossAxisAlignment属性设置为CrossAxisAlignment.stretch,以便按钮占据父容器(即列)的总宽度。

此时,该应用如下所示:

![]()

在下一节中,我们将添加一种在应用中播放音频文件的机制。

添加音频播放器

创建应用的用户界面后,我们现在将音频播放器添加到应用中以播放音频文件。 我们将使用audioplayer插件添加音频播放器,如下所示:

- 我们首先将依赖项添加到

pubspec.yaml文件中:

audioplayers: 0.13.2

现在,通过运行flutter pub get获得包。

- 接下来,我们将插件导入

play_music.dart。

import 'package:audioplayers/audioplayers.dart';

- 然后,在

PlayMusicState内创建AudioPlayer的实例:

AudioPlayer audioPlayer = AudioPlayer();

- 现在,让我们定义一个

play()方法来播放远程可用的音频文件,如下所示:

play() async {

var url = 'http://34.70.80.18:8000/download/output_1573917221.mid';

int result = await audioPlayer.play(url);

if (result == 1) {

print('Success');

}

}

最初,我们将使用存储在url变量中的样本音频文件。 通过传递url中的值,使用audioPlayer.play()播放音频文件。 另外,如果从url变量成功访问和播放了音频文件,则结果将存储在结果变量中,其值将为1。

- 现在,将

onPressed属性添加到buildPlayButton内置的播放按钮中,以便每当按下该按钮时就播放音频文件:

Widget buildPlayButton() {

return Padding(

padding: EdgeInsets.only(left: 16, right: 16, top: 16),

child: RaisedButton(

....

onPressed: () {

play();

},

....

),

);

}

在前面的代码片段中,我们添加onPressed属性并调用play()方法,以便每当按下按钮时就播放音频文件。

- 现在,我们将定义

stop()以停止正在播放的音乐:

void stop() {

audioPlayer.stop();

}

在stop()方法内部,我们只需调用audioPlayer.stop()即可停止正在播放的音乐。

- 最后,我们为

buildStopButton()中内置的停止按钮添加onPressed属性:

Widget buildStopButton() {

return Padding(

padding: EdgeInsets.only(left: 16, right: 16, top: 16),

child: RaisedButton(

....

onPressed: (){

stop();

},

....

)

);

}

在前面的代码片段中,我们向onPressed中的stop()添加了一个调用,以便一旦按下停止按钮就停止音频。

现在开始使用 Flutter 应用部署模型。

部署模型

在为应用成功添加基本的播放和停止功能之后,现在让我们访问托管模型以每次生成,获取和播放新的音频文件。 以下步骤详细讨论了如何在应用内部访问模型:

- 首先,我们定义

fetchResponse()方法来生成和获取新的音频文件:

void fetchResponse() async {

final response =

await http.get('http://35.225.134.65:8000/generate');

if (response.statusCode == 200) {

var v = json.decode(response.body);

fileName = v["result"] ;

} else {

throw Exception('Failed to load');

}

}

我们首先使用http.get()从 API 获取响应,然后传入托管模型的 URL。 get()方法的响应存储在response变量中。 get()操作完成后,我们使用response.statusCode检查状态码。 如果状态值为200,则获取成功。 接下来,我们使用json.decode()将响应的主体从原始 JSON 转换为Map,以便可以轻松访问响应主体中包含的键值对。 我们使用v["result"]访问新音频文件的值,并将其存储在全局fileName变量中。 如果responseCode不是200,我们只会抛出一个错误。

- 现在让我们定义

load()以对fetchResponse()进行适当的调用:

void load() {

fetchResponse();

}

在前面的代码行中,我们仅定义一个load()方法,该方法用于调用fetchResponse()来获取新生成的音频文件的值。

- 现在,我们将修改

buildGenerateButton()中的onPressed属性,以每次生成新的音频文件:

Widget buildGenerateButton() {

return Padding(

....

child: RaisedButton(

....

onPressed: () {

load();

},

....

),

);

}

根据应用的功能,每当按下生成按钮时,都应生成一个新的音频文件。 这直接意味着无论何时按下“生成”按钮,我们都需要调用 API 以获取新生成的音频文件的名称。 因此,我们修改buildGenerateButton()以添加onPressed属性,以便每当按下按钮时,它都会调用load(),该调用随后将调用fetchResponse()并将新音频文件的名称存储在输出中。

- 托管的音频文件有两个部分,

baseUrl和fileName。baseUrl对于所有调用均保持不变。 因此,我们声明一个存储baseUrl的全局字符串变量:

String baseUrl = 'http://34.70.80.18:8000/download/';

回想一下,我们已经在“步骤 1”中将新音频文件的名称存储在fileName中。

- 现在,让我们修改

play()以播放新生成的文件:

play() async {

var url = baseUrl + fileName;

AudioPlayer.logEnabled = true;

int result = await audioPlayer.play(url);

if (result == 1) {

print('Success');

}

}

在前面的代码片段中,我们修改了前面定义的play()方法。 我们通过附加baseUrl和fileName创建一个新的 URL,以便url中的值始终与新生成的音频文件相对应。 我们在调用audioPlayer.play()时传递 URL 的值。 这样可以确保每次按下播放按钮时,都会播放最新生成的音频文件。

- 此外,我们添加了

Text小部件以反映文件生成状态:

Widget buildLoadingText() {

return Center(

child: Padding(

padding: EdgeInsets.only(top: 16),

child: Text(loadText)

)

);

}

在前面定义的函数中,我们创建了一个简单的Text小部件,以反映提取操作正在运行以及何时完成的事实。 Text小部件具有顶部填充,并与Center对齐。 loadText值用于创建窗口小部件。

全局声明该变量,其初始值为'Generate Music':

String loadText = 'Generate Music';

- 更新

build()方法以添加新的Text小部件:

@override

Widget build(BuildContext context) {

return Scaffold(

....

body: Column(

....

children: <Widget>[

buildGenerateButton(),

....

buildLoadingText()

],

)

);

}

现在,我们更新build()方法以添加新创建的Text小部件。 该窗口小部件只是作为先前创建的Column的子级添加的。

- 当用户想要生成一个新的文本文件时,并且在进行提取操作时,我们需要更改文本:

void load() {

setState(() {

loadText = 'Generating...';

});

fetchResponse();

}

在前面的代码段中,loadText值设置为'Generating...',以反映正在进行get()操作的事实。

- 最后,获取完成后,我们将更新文本:

void fetchResponse() async {

final response =

await http.get('http://35.225.134.65:8000/generate').whenComplete((){

setState(() {

loadText = 'Generation Complete';

});

});

....

}

提取完成后,我们将loadText的值更新为'Generation Complete'。 这表示应用现在可以播放新生成的文件了。

可以在此处查看play_music.dart的整个代码。

在使应用的所有部分正常工作之后,现在让我们通过创建最终的材质应用将所有内容放在一起。

创建最终的材质应用

现在创建main.dart文件。 该文件包含无状态窗口小部件MyApp。 我们重写build()方法并将PlayMusic设置为其子级:

@override

Widget build(BuildContext context) {

return MaterialApp(

title: 'Flutter Demo',

theme: ThemeData(

primarySwatch: Colors.blue,

),

home: PlayMusic(),

);

}

在覆盖的build()方法中,我们简单地将home创建为PlayMusic()的MaterialApp。

整个项目可以在这里查看。

总结

在本章中,我们通过将多媒体处理分解为图像,音频和视频处理的核心组件来进行研究,并讨论了一些最常用的处理工具。 我们看到了使用 OpenCV 执行图像或视频处理变得多么容易。 另外,我们看到了一个使用 Magenta 生成鼓音乐的简单示例。 在本章的下半部分,我们介绍了 LSTM 如何与时间序列数据一起使用,并构建了一个 API,该 API 可以从提供的样本文件生成器乐。 最后,我们将此 API 与 Flutter 应用结合使用,该应用是跨平台的,可以同时部署在 Android,iOS 和 Web 上。

在下一章中,我们将研究如何使用深度强化学习(DRL)来创建可以玩棋盘游戏(例如国际象棋)的智能体。

八、基于强化神经网络的国际象棋引擎

在几个在线应用商店以及几乎每个软件商店中,游戏都提供了自己的完整版块。 游戏的重要性和热情不容忽视,这就是为什么全世界的开发人员都在不断尝试开发出更好,更吸引人的游戏的原因。

在流行的棋盘游戏世界中,国际象棋是全世界最有竞争力和最复杂的游戏之一。 已经尝试了一些强大的自动化程序来下棋和与人类竞争。 本章将讨论 DeepMind 的开发人员所使用的方法,他们创建了 Alpha Zero,这是一种自学算法,可以自学下棋,从而能够以一个单打击败市场上当时最好的国际象棋 AI,Stockfish 8。 在短短 24 小时的训练中得分较高。

在本章中,我们将介绍您需要理解的概念,以便构建这种深度强化学习算法,然后构建示例项目。 请注意,该项目将要求您具有 Python 和机器学习的丰富知识。

我们将在本章介绍以下主题:

- 强化学习导论

- 手机游戏中的强化学习

- 探索 Google 的 DeepMind

- 适用于 Connect 4 的 Alpha 类零 AI

- 基础项目架构

- 为国际象棋引擎开发 GCP 托管的 REST API

- 在 Android 上创建简单的国际象棋 UI

- 将国际象棋引擎 API 与 UI 集成

让我们从讨论增强学习智能体在手机游戏中的用法和普及程度开始。

强化学习导论

在过去的几年中,强化学习已成为机器学习研究人员中一个重要的研究领域。 人们越来越多地使用它来构建能够在任何给定环境中表现更好的智能体,以寻求对他们所执行行为的更好回报。 简而言之,这为我们提供了强化学习的定义–在人工智能领域,这是一种算法,旨在创建虚拟的智能体,它可在任何给定条件下,在环境中执行动作,在执行一系列动作后,取得最佳的奖励。

让我们尝试通过定义与通用强化学习算法关联的变量来赋予此定义更多的结构:

- 智能体:执行动作的虚拟实体。 是替换游戏/软件的指定用户的实体。

- 操作(

a):智能体可以执行的可能操作。 - 环境(

e):在软件/游戏中可用的一组场景。 - 状态(

S):所有方案的集合,以及其中可用的配置。 - 奖励(

R):对于智能体执行的任何操作返回的值,然后智能体尝试将其最大化。 - 策略(

π):智能体用来确定接下来必须执行哪些操作的策略。 - 值(

V):R是短期每动作奖励,而值是在一组动作结束时预期的总奖励。V[π](s)通过遵循状态S下的策略π来定义预期的总回报。

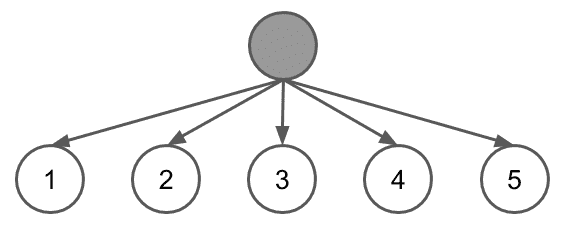

下图显示了该算法的流程:

尽管我们在前面的定义列表中没有提到观察者,但必须有观察者或评估者才能产生奖励。 有时,观察者本身可能是一个复杂的软件,但是通常,这是一个简单的评估函数或指标。

要获得关于强化学习的更详细的想法,您可以阅读这个页面上的 Wikipedia 文章。 有关正在使用的强化学习智能体的快速样本,请阅读以下 DataCamp 文章。

在下一部分中,我们将学习强化学习在手机游戏中的地位。

手机游戏中的强化学习

出于各种原因而希望构建具有游戏性的 AI 的开发人员中,强化学习已变得越来越流行-只需检查 AI 的功能,建立可以帮助专业人士改善游戏水平的训练智能体等等。 从研究人员的角度来看,游戏为强化学习智能体提供了最佳的测试环境,可以根据经验做出决策并学习在任何给定环境中的生存/成就。 这是因为可以使用简单而精确的规则设计游戏,从而可以准确预测环境对特定动作的反应。 这使得更容易评估强化学习智能体的表现,从而为 AI 提供良好的训练基础。 考虑到在玩游戏的 AI 方面的突破,也有人表示,我们向通用 AI 的发展速度比预期的要快。 但是强化学习概念如何映射到游戏?

让我们考虑一个简单的游戏,例如井字棋。 另外,如果您觉得古怪,只需使用 Google 搜索井字棋,您就会在搜索结果中看到一个游戏!

考虑您正在用计算机玩井字棋。 这里的计算机是智能体。 在这种情况下,环境是什么? 您猜对了–井字棋板以及在环境中管理游戏的一组规则。 井字棋盘上已经放置的标记可以确定环境所在的状态。座席可以在棋盘上放置的X或O是他们可以执行的动作,即输掉,赢得比赛或平局。 或朝着损失,胜利或平局前进是他们执行任何行动后回馈给智能体的奖励。 智能体赢得比赛所遵循的策略是遵循的策略。

因此,从该示例可以得出结论,强化学习智能体非常适合构建学习玩任何游戏的 AI。 这导致许多开发人员想出了象围棋,跳棋,反恐精英等国际象棋以外的几种流行游戏的游戏 AI。 甚至 Chrome Dino 之类的游戏也发现开发人员试图使用 AI 进行游戏。

在下一部分中,我们将简要概述 Google 的 DeepMind,它是游戏 AI 制造商领域中最受欢迎的公司之一。

探索 Google 的 DeepMind

当您谈论自学习人工智能的发展时,DeepMind 可能是最著名的名称之一,这是由于它们在该领域的开创性研究和成就。 自 2015 年 Google 重组以来,DeepMind 在 2014 年被 Google 收购,目前是 Alphabet 的全资子公司。DeepMind 最著名的作品包括 AlphaGo 及其继任者 Alpha Zero。 让我们更深入地讨论这些项目,并尝试了解是什么使它们在当今如此重要。

AlphaGo

2015 年,AlphaGo 成为第一个在19x19棋盘上击败职业围棋选手 Lee Sedol 的计算机软件。 突破被记录下来并作为纪录片发行。 击败李·塞多尔的影响如此之大,以至于韩国 Baduk 协会授予了荣誉 9 丹证书,这实际上意味着围棋选手的游戏技能与神性息息相关。 这是围棋历史上第一次提供 9 荣誉荣誉证书,因此提供给 AlphaGo 的证书编号为 001。ELO 等级为 3,739。

AlphaGo Master 的继任者 AlphaGo Master 在三场比赛中击败了当时统治世界的游戏冠军 Ke Jie。 为了表彰这一壮举,它获得了中国围棋协会颁发的 9 丹证书。 该软件当时的 ELO 等级为 4,858。

但是,这两款软件都被其继任者 AlphaGo Zero 压倒了,后者在 3 天的自学式学习中,能够在 21 分之后以 100:0 的游戏得分击败 AlphaGo,在 89:11 的游戏得分下击败 AlphaGo Master。 天的训练。 40 天后,它的 ELO 评分达到了 5,185,超过了以前所有 Go AI 的技能。

AlphaGo 基于蒙特卡洛树搜索算法,并采用了对生成的和人类玩家游戏日志进行的深度学习。 该模型的初始训练是通过人类游戏进行的。 然后,计算机将与自己对战并尝试改善其游戏性。 树搜索将被设置为一定的深度,以避免巨大的计算开销,在这种开销下,计算机将尝试达到所有可能的动作,然后再进行任何动作。

总而言之,遵循以下过程:

- 最初,该模型将在人类游戏日志上进行训练。

- 一旦在基线上进行了训练,计算机将使用在先前步骤中训练过的模型与自己竞争,并使用有上限的蒙特卡洛树搜索来确保进行移动而不会长时间停滞该软件。 这些游戏的日志已生成。

- 然后对生成的游戏进行了训练,从而改善了整体模型。

现在,让我们讨论 Alpha Zero。

Alpha Zero

Alpha Zero 是 AlphaGo Zero 的后继产品,它是对算法进行泛化的尝试,以便也可以用于其他棋盘游戏。 Alpha Zero 经过训练可以下棋,将棋(类似于棋的日式游戏)和围棋,其表现与相应游戏的现有 AI 相当。 经过 34 小时的训练,Alpha Zero for Go 击败了经过 3 天训练的 AlphaGo Zero,得分为 60:40。 这导致 ELO 等级为 4,430。

经过约 9 个小时的训练,Alpha Zero 击败了 TCEC 竞赛 2016 年冠军的 Stockfish 8。 因此,它仍然是迄今为止最强大的国际象棋 AI,尽管有人声称最新版本的 Stockfish 将能够击败它。

AlphaGo Zero 和 Alpha Zero 变体之间的主要区别如下:

- 出现平局的可能性:在围棋中,保证有一名选手获胜,而对于象棋则不是这样。 因此,对 Alpha Zero 进行了修改,以允许并列游戏。

- 对称性:AlphaGo Zero 利用了电路板的对称性。 但是,由于国际象棋不是非对称游戏,因此必须对 Alpha Zero 进行修改以使其工作。

- 硬编码的超参数搜索:Alpha Zero 具有用于超参数搜索的硬编码规则。

- 在 Alpha Zero 的情况下,神经网络会不断更新。

此时,您可能会想,“什么是蒙特卡罗树搜索?”。 让我们尝试回答这个问题!

蒙特卡洛树搜索

当我们谈论象棋,围棋或井字棋等基于当前场景的战略游戏时,我们所谈论的是大量可能的场景和可以在任何情况下在其中的给定点执行的动作。 尽管对于井字棋等较小的游戏,可能的状态和动作的数量在现代计算机可以计算的范围内,但对于游戏可以生成的状态数量,更复杂的游戏(如国际象棋和围棋)呈指数增长。

蒙特卡洛树搜索尝试找到在给定环境下赢得任何游戏或获得更好奖励所需要的正确动作序列。 之所以将其称为树搜索是因为它创建了游戏中所有可能状态的树,并通过创建每个状态的分支来实现其中的所有可能动作。 表示为树中的节点。

让我们考虑以下简单的游戏示例。 假设您正在玩一个游戏,要求您猜一个三位数的数字,每个猜中都有一个相关的奖励。 可能的数字范围是 1 到 5,您可以猜测的次数是 3。 如果您做出准确的猜测,即正确猜测任意给定位置的数字,则将获得 5 分。但是,如果您做出错误的猜测,将得到正确数字两边的线性差值的分数。

例如,如果要猜测的数字是 2,则可能获得以下奖励分数:

- 如果您猜 1,则得分为 4

- 如果您猜 2,则得分为 5

- 如果您猜 3,则得分为 4

- 如果您猜 4,则得分为 3

- 如果您猜 5,则得分为 2

因此,游戏中的最佳总得分为 15,即每个正确的猜测为 5 分。 鉴于此,您可以在每个步骤中的五个选项中进行选择,游戏中可能的状态总数为5 * 5 * 5 = 125,只有一个状态会给出最佳分数。

让我们尝试在树上描绘前面的游戏。 假设您要猜测的数字是 413。在第一步中,您将具有以下树:

做出选择后,您将获得奖励,再次有五个选项可供选择-换句话说,每个节点中有五个分支可以遍历。 在最佳游戏玩法中,将获得以下树:

现在,让我们考虑以下事实:围棋游戏共有3^361个可能状态。 在 AI 采取行动之前尝试计算每种可能性变得不切实际。 这是蒙特卡罗树搜索与上限可信度算法相结合的地方,它比其他方法更具优势,因为它可以终止到任何搜索深度,并且可以产生趋向于最佳分数的结果。 因此,算法不需要遍历树的每个分支。 一旦树形搜索算法意识到任何特定分支的表现不佳,就可以停止沿该路径前进,而专注于表现更好的路径。 而且,它可以尽早终止任何路径并在该点返回预期的回报,从而可以调整 AI 采取任何行动所需的时间。

更确切地说,蒙特卡罗树搜索遵循以下步骤:

-

选择:从树的当前节点中选择最佳回报分支。 例如,在前面的游戏树中,选择除 4 以外的任何分支将产生较低的分数,因此选择了 4。

-

扩展:一旦选择了最佳回报节点,该节点下的树将进一步扩展,从而创建具有该节点可用的所有可能选项(分支)的节点。 这可以理解为从游戏的任何位置布局 AI 的未来动作。

-

模拟:现在,由于事先不知道在扩展阶段创建的哪个未来选项最有回报,因此我们使用强化学习逐个模拟游戏的每个选项。 请注意,与上限可信度上限算法结合使用时,直到结束游戏才算重要。 计算任何

n个步骤的奖励也是一种不错的方法。 -

更新:最后,更新节点和父节点的奖励分数。 尽管不可能回到游戏中,并且由于任何节点的值都已减小,但如果在以后的游戏中的那个阶段找到了更好的替代方案,那么 AI 将不会遵循这条路径,从而通过多次迭代来改善其游戏玩法。

接下来,我们将构建一个系统,该系统的工作原理类似于 Alpha Zero,并尝试学习玩 Connect 4 游戏,该游戏比 Tic-Tac-Toe 游戏要复杂得多,但对我们来说足够大,来解释如何构建类似的国际象棋引擎。

适用于 Connect 4 的类似 Alpha Zero 的 AI

在开始研究可玩 Connect4 的 AI 之前,让我们简要了解一下游戏及其动态。 Connect 4,有时也称为连续四人,连续四人,四人以上,等等,是全世界儿童中最受欢迎的棋盘游戏之一。 我们也可以将它理解为井字棋的更高级版本,在其中您必须水平,垂直或对角放置三个相同类型的标记。 棋盘通常是一个6x7的网格,两个玩家各自玩一个标记。

Connect 4 的规则可能会有所不同,因此让我们为 AI 将学习的规则版本制定一些具体规则:

- 该游戏被模拟为在具有七个空心列和六行的垂直板上玩。 每列在板的顶部都有一个开口,可以在其中插入片段。可以查看已放入板的片段。

- 两位玩家都有 21 个形状像不同颜色硬币的硬币。

- 将硬币放在板上构成一个动作。

- 碎片从顶部的开口下降到最后一行,或者堆积在该列的最后一块。

- 第一个以任意方向连接其任意四枚硬币的玩家,因此彼此之间不会存在任何间隙或其他玩家的硬币获胜。

现在,让我们分解将 Connect 4 播放式自学 AI 分解为子问题的问题:

- 首先,我们需要创建棋盘的虚拟表示。

- 接下来,我们必须创建允许根据游戏规则移动的函数。

- 然后,为了保存游戏状态,我们需要一个状态管理系统。

- 接下来,我们将简化游戏玩法,其中将提示用户进行移动并宣布游戏终止。

- 之后,我们必须创建一个脚本,该脚本可以生成示例游戏玩法,供系统学习。

- 然后,我们必须创建训练函数来训练系统。

- 接下来,我们需要蒙特卡洛树搜索(MCTS)实现。

- 最后,我们需要一个神经网络的实现。

- 除了前面的具体步骤之外,我们还需要为系统创建许多驱动脚本以使其更加可用。

让我们依次移至前面的要点,一次覆盖系统的每个部分。 但是,首先,我们将快速浏览该项目中存在的目录结构和文件,这在本书的 GitHub 存储库中也可以找到。 让我们来看看:

command/:__init__.py:此文件使我们可以将此文件夹用作模块。arena.py:此文件获取并解析用于运行游戏的命令。generate.py:此文件接受并分析自玩招式生成系统的命令。newmodel.py:此文件用于为智能体创建新的空白模型。train.py:此文件用于训练基于增强学习的神经网络如何玩游戏。util/:__init__.py:此文件使我们可以将此文件夹用作模块。arena.py:此文件创建并维护玩家之间进行的比赛的记录,并允许我们在轮到谁之间切换。compat.py:此文件是用于使程序与 Python 2 和 Python 3 兼容的便捷工具。如果您确定正在开发的版本并希望在其上运行,则可以跳过此文件。generate.py:此文件播放一些随机移动的游戏,再加上 MCTS 移动,以生成可用于训练目的的游戏日志。 该文件存储每个游戏的获胜者以及玩家做出的动作。internal.py:此文件创建棋盘的虚拟表示并定义与棋盘相关的函数,例如将棋子放置在棋盘上,寻找获胜者或只是创建新棋盘。keras_model.py:此文件定义充当智能体大脑的模型。 在本项目的后面,我们将更深入地讨论该文件。mcts.py:此文件提供 MCTS 类,该类实质上是蒙特卡罗树搜索的实现。nn.py:此文件提供 NN 类,它是神经网络的实现,以及与神经网络相关的函数,例如拟合,预测,保存等。player.py:此文件为两种类型的播放器提供了类-MCTS 播放器和人工播放器。 MCTS 玩家是我们将训练的智能体,以玩游戏。state.py:这是internal.py文件的包装,提供了用于访问电路板和与电路板相关的函数的类。trainer.py:这使我们可以训练模型。 这与nn.py中提供的内容不同,因为它更专注于涵盖游戏的训练过程,而nn.py中的内容主要是围绕此功能的包装。

接下来,我们将继续探索这些文件中每个文件的一些重要部分,同时遵循我们先前为构建 AI 制定的步骤。

创建棋盘的虚拟表示

您将如何代表 Connect 4 棋盘? 代表 Connect 4 棋盘的两种常用方法以及游戏状态。 让我们来看看:

- 人类可读的长格式:在这种形式中,木板的行和列分别显示在 x 和 y 轴上,并且两个玩家的标记都显示为

x和o, 分别(或任何其他合适的字符)。 可能如下所示:

|1 2 3 4 5 6 7

--+--------------

1|. . . . . . .

2|. . . . . . .

3|. . . . . . .

4|. . . . o x .

5|x o x . o o .

6|o x x o x x o

但是,这种形式有点冗长并且在计算上不是很友好。

- 计算有效的形式:在此形式中,我们将板存储为 2D NumPy 数组:

array([[1, 1, 0, 0, 0, 0, 0],

[0, 0, 0, 0, 0, 0, 0],

[0, 0, 0, 0, 0, 0, 0],

[0, 0, 0, 0, 0, 0, 0],

[0, 0, 0, 0, 1, 0, 0],

[0, 0, 0, 0, 0, 0, 0]], dtype=int8)

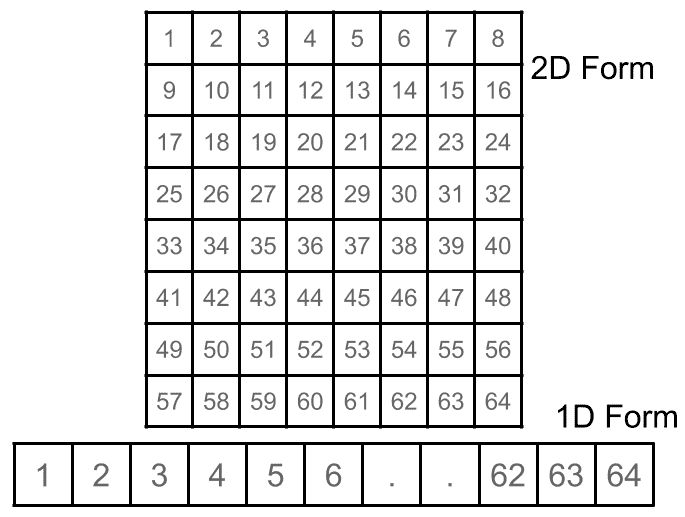

以这种方式创建该数组,当将其展平为一维数组时,板位置按顺序排列,就好像该数组实际上是一维数组一样。 前两个位置分别编号为 0 和 1,而第 5 个位置位于第 5 行和第 5 列,编号为 32。通过将前一个代码块中的矩阵与给定的表进行映射,可以轻松理解此条件。 在下图中:

这种形式适合于进行计算,但不适合玩家在游戏过程中观看,因为对于玩家而言很难解密。

- 一旦决定了如何表示电路板及其部件,就可以开始在

util/internal.py文件中编写代码,如下所示:

BOARD_SIZE_W = 7

BOARD_SIZE_H = 6

KEY_SIZE = BOARD_SIZE_W * BOARD_SIZE_H

前几行设置了板子的常数,在这种情况下,是板子上的行数和列数。 我们还通过将它们相乘来计算板上的按键或位置的数量。

- 现在,让我们准备在板上生成获胜位置的代码,如下所示:

LIST4 = []

LIST4 += [[(y, x), (y + 1, x + 1), (y + 2, x + 2), (y + 3, x + 3)] for y in range(BOARD_SIZE_H - 3) for x in range(BOARD_SIZE_W - 3)]

LIST4 += [[(y, x + 3), (y + 1, x + 2), (y + 2, x + 1), (y + 3, x)] for y in range(BOARD_SIZE_H - 3) for x in range(BOARD_SIZE_W - 3)]

LIST4 += [[(y, x), (y, x + 1), (y, x + 2), (y, x + 3)] for y in range(BOARD_SIZE_H) for x in range(BOARD_SIZE_W - 3)]

NO_HORIZONTAL = len(LIST4)

LIST4 += [[(y, x), (y + 1, x), (y + 2, x), (y + 3, x)] for y in range(BOARD_SIZE_H - 3) for x in range(BOARD_SIZE_W)]

LIST4变量存储任何玩家赢得比赛时可以实现的可能组合。

我们不会在此文件中讨论整个代码。 但是,重要的是要了解以下函数及其作用:

get_start_board():此函数以 NumPy 数组的形式返回电路板的空白 2D 数组表示形式。clone_board(board):此函数用于按板级克隆整个 NumPy 数组。get_action(board):此函数返回播放器已修改的数组中的位置。action_to_string(action):此函数将玩家执行的动作的内部数字表示形式转换为可以以易于理解的形式显示给用户的字符串。 例如place_at(board, pos,。player):执行为任何给定玩家在板上放置一块棋子的动作。 它还会更新板。def get_winner(board):此函数确定棋盘当前状态下的游戏是否有赢家。 如果是,则返回获胜玩家的标识符,该标识符将为 1 或 -1。def to_string(board):此函数将板的 NumPy 数组表示形式转换为字符串,该字符串为人类可读的格式。

接下来,我们将研究如何对 AI 进行编程,使其根据游戏规则进行并仅接受有效的动作。

允许根据游戏规则移动

为了确定玩家(无论是人还是机器)做出的动作的有效性,我们需要建立一种机制,在机器的情况下,该机制连续不断地只生成有效的动作,或者不断验证任何人类玩家的输入。 让我们开始吧:

- 可以在

util/generator.py文件的_selfplay(self, state, args)函数中找到一个这样的实例,如以下代码所示:

turn = 0

hard_random_turn = args['hard_random'] if 'hard_random' in args else 0

soft_random_turn = (args['soft_random'] if 'soft_random' in args else 30) + hard_random_turn

history = []

首先,我们将移动切换设置为0,指示游戏开始时尚未进行任何移动。 我们还考虑了用户在其 AI 自行生成的游戏中想要的硬性和软性随机回合的数量。 然后,我们将移动的历史记录设置为空白。

- 现在,我们可以开始为 AI 生成动作,如下所示:

while state.getWinner() == None:

if turn < hard_random_turn:

# random action

action_list = state.getAction()

index = np.random.choice(len(action_list))

(action, key) = action_list[index]

前面的代码说,直到没有游戏的获胜者,都必须生成招式。 在前面的案例中,我们可以看到,只要进行一次随机随机转弯的可能性为真,AI 就会选择一个完全随机的位置来放置其棋子。

- 通过在前面的

if语句中添加else块,我们告诉 AI,只要它需要进行柔和转弯,它就可以检查是否有任何随机位置将其放置在其中,但只能在 MCTS 算法所建议的移动范围内,如下所示:

else:

action_list = self.mcts.getActionInfo(state, args['simulation'])

if turn < soft_random_turn:

# random action by visited count

visited = [1.0 * a.visited for a in action_list]

sum_visited = sum(visited)

assert(sum_visited > 0)

p = [v / sum_visited for v in visited]

index = np.random.choice(len(action_list), p = p)

else:

# select most visited count

index = np.argmax([a.visited for a in action_list])

请注意,如果既不进行硬转弯也不进行软转弯,则坐席会在游戏的那一刻进行最常用的动作,这有望使它朝着胜利迈进。

因此,在非人类玩家的情况下,智能体只能在任何给定阶段在一组填充的有效动作之间进行选择。 对于人类玩家而言,情况并非如此,根据他们的创造力,他有可能尝试做出无效的举动。 因此,当人类玩家做出动作时,需要对其进行验证。

- 可以在

util/player.py文件的getNextAction(self, state)函数中找到验证人类玩家移动的方法,如下所示:

action = state.getAction()

available_x = []

for i in range(len(action)):

a, k = action[i]

x = a % util.BOARD_SIZE_W + 1

y = a // util.BOARD_SIZE_W + 1

print('{} - {},{}'.format(x, x, y))

available_x.append(x)

- 首先,我们现在计算人类玩家可能采取的合法行动,并将其显示给用户。 然后,我们提示用户输入一个动作,直到他们做出有效的动作为止,如下所示:

while True:

try:

x = int(compat_input('enter x: '))

if x in available_x:

for i in range(len(action)):

if available_x[i] == x:

select = i

break

break

except ValueError:

pass

因此,我们根据填充的一组有效动作来验证用户所做的动作。 我们还可以选择向用户显示错误。

接下来,我们将研究程序的状态管理系统,您肯定已经注意到,到目前为止,我们一直在看该代码。

状态管理系统

游戏的状态管理系统是整个程序中最重要的部分之一,因为它控制着所有的游戏玩法,并在 AI 的自学习过程中促进了游戏玩法。 这样可以确保向玩家展示棋盘,并在进行有效的移动。 它还存储了几个与状态有关的变量,这些变量对于游戏进行很有用。 让我们来看看:

- 让我们讨论

util/state.py文件中提供的State类中最重要的特性和函数:

import .internal as util

此类使用util/internal.py文件中定义的名称为util的变量和函数。

__init__(self, prototype = None):此类在启动时,会继承现有状态或创建新状态。 该函数的定义如下:

def __init__(self, prototype = None):

if prototype == None:

self.board = util.get_start_board()

self.currentPlayer = 1

self.winner = None

else:

self.board = util.clone_board(prototype.board)

self.currentPlayer = prototype.currentPlayer

self.winner = prototype.winner

在这里,您可以看到该类可以使用游戏的现有状态启动,并作为参数传递给该类的构造器; 否则,该类将创建一个新的游戏状态。

getRepresentativeString(self):此函数返回可以由人类玩家读取的游戏状态的格式正确的字符串表示形式。 其定义如下:

def getRepresentativeString(self):

return ('x|' if self.currentPlayer > 0 else 'o|') + util.to_oneline(self.board)

状态类中的许多其他重要方法如下:

getCurrentPlayer(self):此方法返回游戏的当前玩家; 也就是说,应该采取行动的玩家。getWinner(self):如果游戏结束,则此方法返回游戏获胜者的标识符。getAction(self):此方法检查游戏是否结束。 如果没有,它将在任何给定状态下返回一组下一个可能的动作。getNextState(self, action):此方法返回游戏的下一个状态; 也就是说,在将当前正在移动的棋子放在棋盘上并评估游戏是否结束之后,它将执行从一种状态到另一种状态的切换。getNnInput(self):此方法返回玩家到目前为止在游戏中执行的动作,并为每个玩家的动作使用不同的标记。

现在,让我们看一下如何改善程序的游戏玩法。

实现游戏玩法

负责控制程序中游戏玩法的文件是util/arena.py文件。

它在Arena类中定义了以下两种方法:

def fight(self, state, p1, p2, count):

stats = [0, 0, 0]

for i in range(count):

print('==== EPS #{} ===='.format(i + 1))

winner = self._fight(state, p1, p2)

stats[winner + 1] += 1

print('stats', stats[::-1])

winner = self._fight(state, p2, p1)

stats[winner * -1 + 1] += 1

print('stats', stats[::-1])

前面的fight()函数管理玩家的胜利/损失或平局的状态。 它确保在每个回合中进行两场比赛,其中每位玩家只能先玩一次。

此类中定义的另一个_fight()函数如下:

def _fight(self, state, p1, p2):

while state.getWinner() == None:

print(state)

if state.getCurrentPlayer() > 0:

action = p1.getNextAction(state)

else:

action = p2.getNextAction(state)

state = state.getNextState(action)

print(state)

return state.getWinner()

此函数负责切换棋盘上的玩家,直到找到赢家为止。

现在,让我们看一下如何生成随机的游戏玩法以使智能体自学。

生成示例游戏

到目前为止,我们已经讨论了util/gameplay.py文件,以演示该文件中与移动规则相关的代码-特别是该文件的自播放函数。 现在,我们来看看这些自玩游戏如何在迭代中运行以生成完整的游戏玩法日志。 让我们开始吧:

- 请考虑此文件提供的

Generator类的generate()方法的代码:

def generate(self, state, nn, cb, args):

self.mcts = MCTS(nn)

iterator = range(args['selfplay'])

if args['progress']:

from tqdm import tqdm

iterator = tqdm(iterator, ncols = 50)

# self play

for pi in iterator:

result = self._selfplay(state, args)

if cb != None:

cb(result)

本质上,此函数负责运行该类的_selfplay()函数,并确定一旦完成自播放后必须执行的操作。 在大多数情况下,您会将输出保存到文件中,然后将其用于训练。

- 这已在

command/generate.py文件中定义。 该脚本可以作为具有以下签名的命令运行:

usage: run.py generate [-h]

[--model, default='latest.h5', help='model filename']

[--number, default=1000000, help='number of generated states']

[--simulation, default=100, help='number of simulations per move']

[--hard, default=0, help='number of random moves']

[--soft, default=1000, help='number of random moves that depends on visited node count']

[--progress, help='show progress bar']

[--gpu, help='gpu memory fraction']

[--file, help='save to a file']

[--network, help='save to remote server']

- 该命令的示例调用如下:

python run.py generate --model model.h5 --simulation 100 -n 5000 --file selfplay.txt --progress

现在,让我们看一下一旦生成自播放日志就可以训练模型的函数。

系统训练

要训练智能体,我们需要创建util/trainer.py文件,该文件提供train()函数。 让我们来看看:

- 签名如下:

train(state, nn, filename, args = {})

该函数接受State类,神经网络类和其他参数。 它还接受文件名,该文件名是包含生成的游戏玩法的文件的路径。 训练后,我们可以选择将输出保存到另一个模型文件中,如command/train.py文件的train()函数所提供的。

- 此命令具有以下签名:

usage: run.py train [-h]

[--progress, help='show progress bar']

[--epoch EPOCH, help='training epochs']

[--batch BATCH, help='batch size']

[--block BLOCK, help='block size']

[--gpu GPU, help='gpu memory fraction']

history, help='history file'

input, help='input model file name'

output, help='output model file name'

历史参数是存储生成的游戏玩法的文件。 输入文件是当前保存的模型文件,而输出文件是将新训练的模型保存到的文件。

- 该命令的示例调用如下:

python run.py train selfplay.txt model.h5 newmodel.h5 --epoch 3 --progress

现在我们已经有了一个训练系统,我们需要创建 MCTS 和神经网络实现。

实现蒙特卡罗树搜索

util/mcts.py文件中提供了完整的 MCTS 算法实现。 该文件提供了 MCTS 类,该类具有以下重要函数:

getMostVisitedAction:此函数返回将状态传递给访问次数最多的操作。getActionInfo:执行任何操作后,此函数返回状态信息。_simulation:此函数执行单个游戏模拟,并返回有关在模拟过程中玩过的游戏的信息。

最后,我们需要创建一个神经网络实现。

实现神经网络

在最后一节中,我们将了解为智能体进行训练而创建的神经网络。 我们将探索util/nn.py文件,该文件提供NN类以及以下重要方法:

__init__(self, filename):如果磁盘上不存在此函数,则使用util/keras_model.py函数创建新模型。 否则,它将模型文件加载到程序中。util/keras_model.py文件中定义的模型是残差 CNN,它与 MCTS 和 UCT 结合使用,表现得像深度强化学习神经网络。 形成的模型具有以下配置:

input_dim: (2, util.BOARD_SIZE_H, util.BOARD_SIZE_W),

policy_dim: util.KEY_SIZE,

res_layer_num: 5,

cnn_filter_num: 64,

cnn_filter_size: 5,

l2_reg: 1e-4,

learning_rate: 0.003,

momentum: 0.9

默认情况下,模型具有五个残差卷积层块。 我们先前在util/internal.py文件中定义了BOARD_SIZE_H,BOARD_SIZE_W和KEY_SIZE常量:

save(self, filename):此函数将模型保存到提供的文件名中。predict(self, x):提供了板状态以及已经进行的移动,此函数输出可以下一步进行的单个移动。fit(self, x, policy, value, batch_size = 256, epochs = 1):此函数用于将新样本拟合到模型并更新权重。

除了上述脚本之外,我们还需要一些驱动脚本。 您可以在该项目的存储库中查找它们,以了解它们的用法。

要运行已完成的项目,您需要执行以下步骤:

- 使用以下命令创建新模型:

python run.py newmodel model.h5

这将创建一个新模型并打印出其摘要。

- 生成示例游戏日志:

python run.py generate --model model.h5 --simulation 100 -n 5000 --file selfplay.txt --progress

在仿真过程中,上一行为 MCTS 生成了 5,000 个示例游戏,深度为 100。

- 训练模型:

python run.py train selfplay.txt model.h5 newmodel.h5 --epoch 3 --progress

前面的命令在游戏文件上训练模型三个时间,并将训练后的模型另存为newmodel.h5。

- 与 AI 对抗:

python run.py arena human mcts,newmodel.h5,100

前面的命令开始与 AI 进行游戏。 在这里,您将在终端中看到一个面板和游戏选项,如下所示:

现在,我们已经成功创建了一个基于 Alpha Zero 的程序来学习玩棋盘游戏,现在我们可以将其推论到国际象棋 AI 上了。 但是,在这样做之前,我们将简要地介绍项目架构。

基础项目架构

为了创建国际象棋引擎,将其作为 REST API 托管在 GCP 上,我们将遵循常规项目架构:

虽然上图提供了该项目的非常简化的概述,但它可以用于更复杂的系统,这些系统可以产生更好的自学习象棋引擎。

GCP 上托管的模型将放置在 EC2 VM 实例中,并将包装在基于 Flask 的 REST API 中。

为国际象棋引擎开发 GCP 托管的 REST API

现在我们已经看到了如何继续进行此项目,我们还需要讨论如何将 Connect 4 的游戏映射到国际象棋,以及如何将国际象棋 RL 引擎部署为 API。

您可以在这个页面上找到我们为该象棋引擎创建的文件。 在将这些文件与 Connect 4 项目中的文件映射之前,让我们快速了解一些最重要的文件:

src/chess_zero/agent/:player_chess.py:此文件描述ChessPlayer类,该类保存有关在任何时间点玩游戏的玩家的信息。 它为与使用蒙特卡洛树搜索来搜索新动作,更改玩家状态以及每个用户在玩游戏期间所需的其他功能的相关方法提供了包装。model_chess.py:此文件描述了此系统中使用的剩余 CNN。src/chess_zero/config/:mini.py:此文件定义国际象棋引擎学习或玩的配置。 您将需要在此处有时调整这些参数,以降低在低端计算机上进行训练期间的批量大小或虚拟 RAM 消耗。src/chess_zero/env/:chess_env.py:此文件描述棋盘的设置,游戏规则以及执行游戏操作所需的函数。 它还包含检查游戏状态和验证移动的方法。src/chess_zero/worker/:evaluate.py:此文件负责与当前最佳模型和下一代模型玩游戏。 如果下一代模型的表现优于 100 款游戏,则它将替代以前的模型。optimize.py:此文件加载当前最佳模型,并在其上执行更多监督的基于学习的训练。self.py:引擎与自己对战并学习新的游戏玩法。sl.py:监督学习的缩写,此文件将来自其他玩家的游戏的 PGN 文件作为输入,并对其进行监督学习。src/chess_zero/play_game/:uci.py:此文件提供了通用国际象棋界面(UCI)标准环境,可以与引擎进行交互。flask_server.py:该文件创建一个 Flask 服务器,该服务器使用国际象棋游戏的 UCI 表示法与引擎进行通信。

现在我们知道每个文件的作用,让我们建立这些文件与 Connect 4 游戏中文件的映射。

还记得我们在讨论 Connect 4 AI 时制定的步骤吗? 让我们看看国际象棋项目是否也遵循相同的步骤:

- 创建棋盘的虚拟代表。 这是在

src/chess_zero/env/chess_env.py文件中完成的。 - 创建允许根据游戏规则进行移动的函数。 这也可以在

src/chess_zero/env/chess_env.py文件中完成。 - 原地的状态管理系统:此功能在许多文件上维护,例如

src/chess_zero/agent/player_chess.py和src/chess_zero/env/chess_env.py。 - 简化游戏:这是通过

src/chess_zero/play_game/uci.py文件完成的。 - 创建一个可以生成示例游戏玩法的脚本,以供系统学习。 尽管此系统未将生成的游戏玩法明确地存储为磁盘上的文件,但该任务由

src/chess_zero/worker/self_play.py执行。 - 创建训练函数来训练系统。 这些训练函数位于

src/chess_zero/worker/sl.py和src/chess_zero/worker/self.py处。 - 现在,我们需要一个 MCTS 实现。 可以在

src/chess_zero/agent/player_chess.py的文件的移动搜索方法中找到该项目的 MCTS 实现。 - 神经网络的实现:

src/chess_zero/agent/model_chess.py中定义了项目的神经网络。

除了前面的映射之外,我们还需要讨论 Universal Chess Interface 和 Flask 服务器脚本,这两个都是游戏性和 API 部署所必需的。

了解通用国际象棋界面

/src/chess_zero/play_game/uci.py上的文件为引擎创建了通用国际象棋界面。 但是,UCI 到底是什么?

UCI 是 Rudolf Huber 和 Stefan Meyer-Kahlen 引入的一种通信标准,它允许在任何控制台环境中使用国际象棋引擎进行游戏。 该标准使用一小组命令来调用国际象棋引擎,以搜索并输出板子任何给定位置的最佳动作。

通过 UCI 进行的通信与标准输入/输出发生,并且与平台无关。 在我们程序的 UCI 脚本中可用的命令如下:

uci:打印正在运行的引擎的详细信息。isready:这查询引擎是否准备好进行对抗。ucinewgame:这将启动带有引擎的新游戏。position [fen | startpos] moves:此设置板的位置。 如果用户从非起始位置开始,则用户需要提供 FEN 字符串来设置板。go:这要求引擎进行搜索并提出最佳建议。quit:这将结束游戏并退出界面。

以下代码显示了带有 UCI 引擎的示例游戏玩法:

> uci

id name ChessZero

id author ChessZero

uciok

> isready

readyok

> ucinewgame

> position startpos moves e2e4

> go

bestmove e7e5

> position rnbqkbnr/pppp1ppp/8/4p3/4P3/8/PPPP1PPP/RNBQKBNR w KQkq - 0 1 moves g1f3

> go

bestmove b8c6

> quit

要快速生成任何板位置的 FEN 字符串,可以使用板编辑器。

现在,让我们讨论一下 Flask 服务器脚本以及如何在 GCP 实例上部署它。

在 GCP 上部署

该国际象棋引擎程序需要存在 GPU。 因此,我们必须遵循其他步骤,才能在 GCP 实例上部署脚本。

大致的工作流程如下:

- 请求增加帐户可用的 GPU 实例的配额。

- 创建基于 GPU 的计算引擎实例。

- 部署脚本。

我们将在以下各节中详细介绍这些步骤。

请求增加 GPU 实例的配额

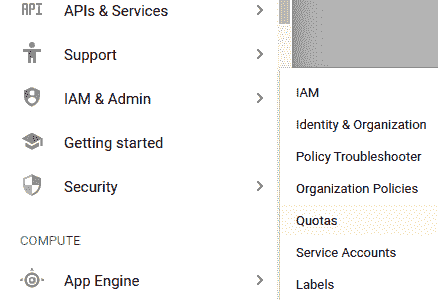

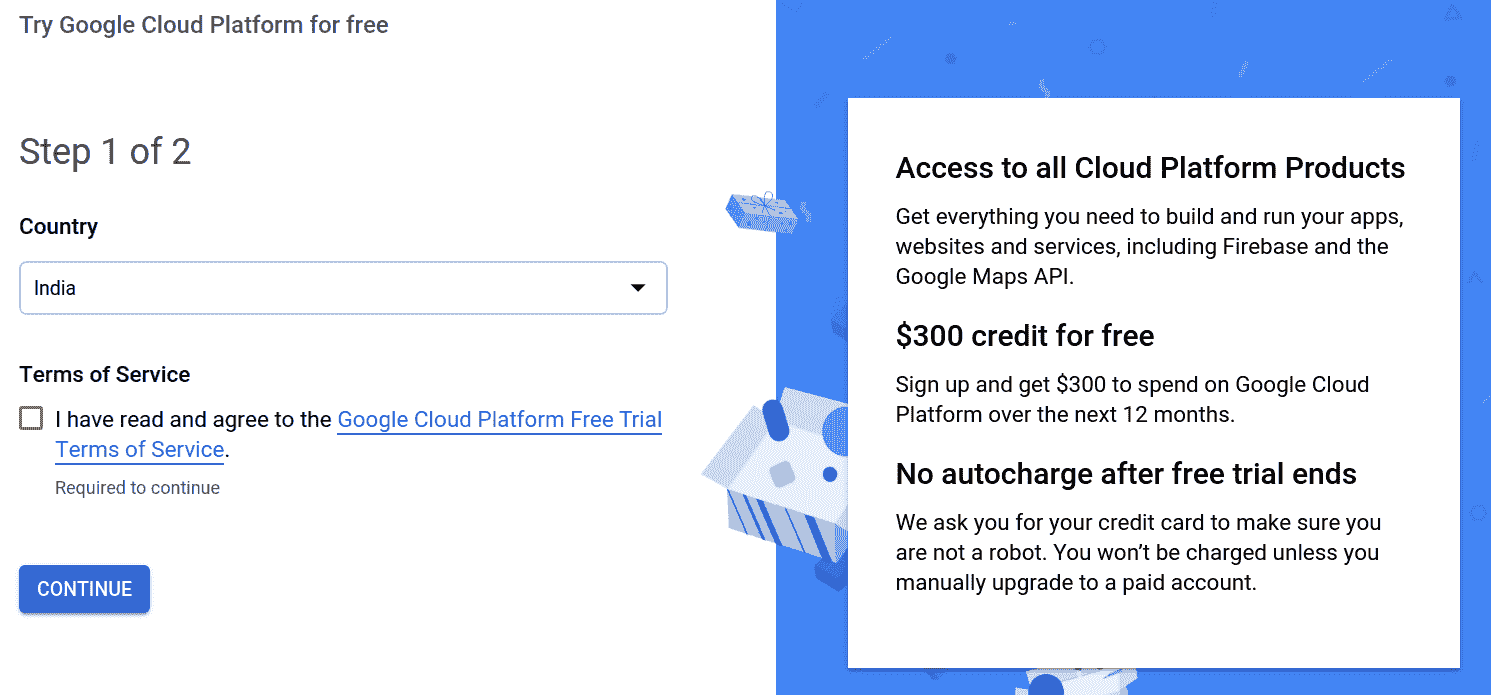

第一步将是请求增加 GPU 实例的配额。 默认情况下,您的 GCP 帐户上可拥有的 GPU 实例数为 0。此限制由您的帐户的配额配置设置,您需要请求增加。 这样做,请按照下列步骤操作:

- 通过这里打开 Google Cloud Platform 控制台。

- 在左侧菜单上,单击“IAM&Admin | 配额”,如以下屏幕截图所示:

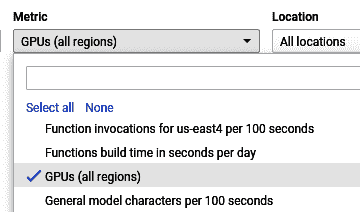

- 单击

Metrics过滤器,然后键入 GPU 以找到读取 GPU(所有区域)的条目,如以下屏幕截图所示:

- 选择条目,然后单击“编辑配额”。

- 系统将要求您提供身份证明,包括您的电话号码。 填写详细信息,然后单击“下一步”。

- 输入您想要将 GPU 配额设置为的限制(最好是

1,以避免滥用)。 另外,请提供您提出要求的理由,例如学术研究,机器学习探索或任何适合您的东西! - 单击“提交”。

提出要求后,大约需要 10 到 15 分钟才能将您的配额增加/设置为您指定的数量。 您将收到一封电子邮件,通知您有关此更新。 现在,您准备创建一个 GPU 实例。

创建一个 GPU 实例

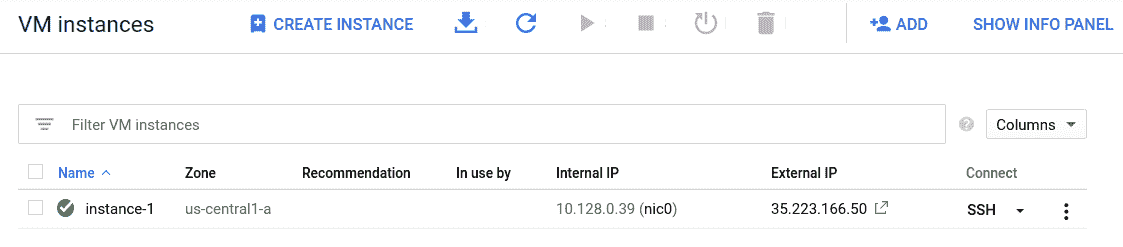

下一步是创建 GPU 实例。 创建 GPU 实例的过程与创建非 GPU 实例的过程非常相似,但是需要额外的步骤。 让我们快速完成所有这些步骤:

- 在您的 Google Cloud Platform 仪表板上,单击左侧导航菜单中的“Compute Engine | VM 实例”。

- 单击“创建实例”。

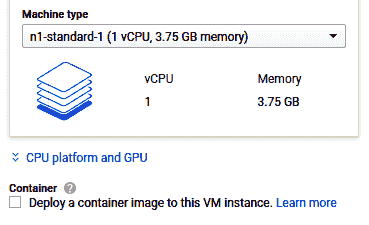

- 单击“计算机类型选择”部分正下方的 CPU 平台和 GPU,如以下屏幕截图所示:

- 单击“添加 GPU”(大加号(

+)按钮)。 选择要附加到此 VM 的 GPU 类型和 GPU 数量。 - 将启动盘操作系统更改为 Ubuntu 版本 10.10。

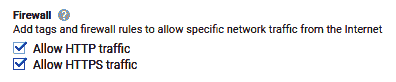

- 在“防火墙”部分中,检查 HTTP 和 HTTPS 通信权限,如以下屏幕截图所示:

- 单击表单底部的“创建”。

几秒钟后,您的实例将成功创建。 如果遇到任何错误,例如超出了区域资源限制,请尝试更改要在其中创建实例的区域/区域。这通常是一个临时问题。

现在,我们可以部署 Flask 服务器脚本。

部署脚本

现在,我们将部署 Flask 服务器脚本。 但是在我们这样做之前,让我们先看一下该脚本的作用:

- 脚本的前几行导入了必要的模块,脚本才能正常工作:

from flask import Flask, request, jsonify

import os

import sys

import multiprocessing as mp

from logging import getLogger

from chess_zero.agent.player_chess import ChessPlayer

from chess_zero.config import Config, PlayWithHumanConfig

from chess_zero.env.chess_env import ChessEnv

from chess_zero.agent.model_chess import ChessModel

from chess_zero.lib.model_helper import load_best_model_weight

logger = getLogger(__name__)

- 其余代码放入

start()函数中,该函数由config对象实例化:

def start(config: Config):

## rest of the code

- 以下几行创建了引擎和人类玩家的实例,并在脚本开始运行时重置了游戏环境:

def start(config: Config):

...

PlayWithHumanConfig().update_play_config(config.play)

me_player = None

env = ChessEnv().reset()

...

- 将创建模型,并使用以下代码将模型的最佳权重加载到其中:

def start(config: Config):

...

model = ChessModel(config)

if not load_best_model_weight(model):

raise RuntimeError("Best model not found!")

player = ChessPlayer(config, model.get_pipes(config.play.search_threads))

...

- 前面代码中的最后一行创建具有指定配置和模型知识的国际象棋引擎玩家实例:

def start(config: Config):

...

app = Flask(__name__)

@app.route('/play', methods=["GET", "POST"])

def play():

data = request.get_json()

print(data["position"])

env.update(data["position"])

env.step(data["moves"], False)

bestmove = player.action(env, False)

return jsonify(bestmove)

...

前面的代码创建了 Flask 服务器应用的实例。 定义/play路由,使其可以接受位置并移动参数,这与我们先前在 UCI 游戏中使用的命令相同。

- 游戏状态将更新,并且要求象棋引擎计算下一个最佳移动。 这以 JSON 格式返回给用户:

def start(config: Config):

...

app.run(host="0.0.0.0", port="8080")

脚本的最后一行在主机0.0.0.0处启动 Flask 服务器,这意味着脚本将监听其运行所在设备的所有打开的 IP。 指定的端口为8080。

-

最后,我们将脚本部署到我们创建的 VM 实例。 为此,请执行以下步骤:

-

打开 GCP 控制台的 VM 实例页面。

-

输入在上一节中创建的 VM 后,单击

SSH按钮。 -

SSH 会话激活后,通过运行以下命令来更新系统上的存储库:

sudo apt update

- 接下来,使用以下命令克隆存储库:

git clone https://github.com/PacktPublishing/Mobile-Deep-Learning-Projects.git

- 将当前工作目录更改为

chess文件夹,如下所示:

cd Mobile-Deep-Learning-Projects/Chapter8/chess

- 为 Python3 安装 PIP:

sudo apt install python3-pip

- 安装项目所需的所有模块:

pip3 install -r requirements.txt

- 为最初的监督学习提供训练 PGN。 您可以从这里下载示例 PGN。

ficsgamesdb2017.pgn文件包含 5,000 个已存储的游戏。 您需要将此文件上传到data/play_data/文件夹。 - 运行监督学习命令:

python3 src/chess_zero/run.py sl

- 运行自学习命令:

python3 src/chess_zero/run.py self

当您对程序可以自行播放的时间感到满意时,请使用Ctrl + C/Z停止脚本。

- 运行以下命令以启动服务器:

python3 src/chess_zero/run.py server

现在,您应该能够将职位和移动发送到服务器并获得响应。 让我们快速测试一下。 使用 Postman 或其他任何用于 API 测试的工具,我们将使用 FEN 字符串向 API 发出请求,以设置位置和正在进行的移动。

假设您的 VM 实例正在公共 IP 地址上运行(在 VM 实例仪表板的实例条目上可见)1.2.3.4。 在这里,我们发送以下POST请求:

endpoint: http://1.2.3.4:8080/play

Content-type: JSON

Request body:

{

"position": "r1bqk2r/ppp2ppp/2np1n2/2b1p3/2B1P3/2N2N2/PPPPQPPP/R1B1K2R w KQkq - 0 1",

"moves": "f3g5"

}

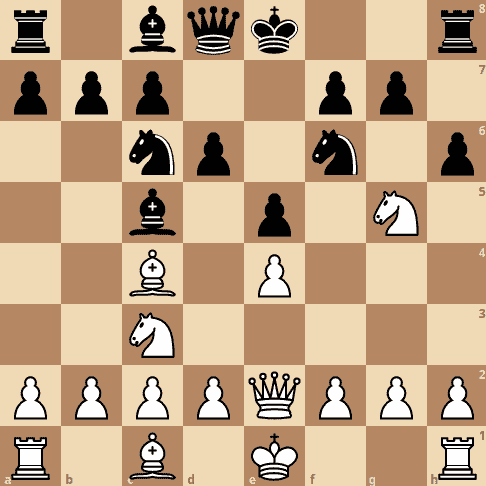

先前代码的输出为"h7h6"。 让我们直观地了解这种交互。 FEN 中定义的板看起来如下: