Linux--ServerProgramming--(7)IPC

1.管道

2.信号量

2.1 概念

信号量 是一个计数器,用于实现进程间互斥和同步。

信号量的取值可以是任何自然数。

最简单的信号量是只能取 0 和 1 的变量,这也是信号量最常见的一种形式,叫做二进制信号量(Binary Semaphore)。

而可以取多个正整数的信号量被称为通用信号量。

2.2 特点

1. 信号量用于进程间同步,若要在进程间传递数据需要结合共享内存。

2. 信号量基于操作系统的 PV 操作,程序对信号量的操作都是 原子操作。

3. 每次对信号量的 PV 操作不仅限于对信号量值加 1 或减 1,而且可以加减任意正整数。

4. 支持信号量组。

2.3 原型

2.3.1 semget 创建或获取一个信号量集函数

#include 2.3.1.1 semget 特殊参数 IPC_PRIVATE

可以给 semget 函数传一个特殊的键值 IPC_PRIVATE(其值为 0),

这样无论信号量是否已存在, semget 都将创建一个新的信号量。

注意,不要因为这个名字就认为这个创建的信号量就是私有的,

其他进程,尤其是子进程,也有方法来访问这个信号量。

如下例,父、子进程间使用一个 IPC_PRIVATE 信号量来同步:

#include 2.3.2 semop 对信号量集操作函数

与信号量关联的一些重要内核变量:

unsigned short semval; //信号量的值

unsigned short semzcnt; //等待信号量值变为 0 的进程数量

unsigned short semncnt; //等待信号量值增加的进程数量

pid_t sempid; //最后一次执行 semop 操作的进程 ID

// 对信号量集进行操作(就是改变上面的内核变量),改变信号量的值,即执行 P、V 操作,

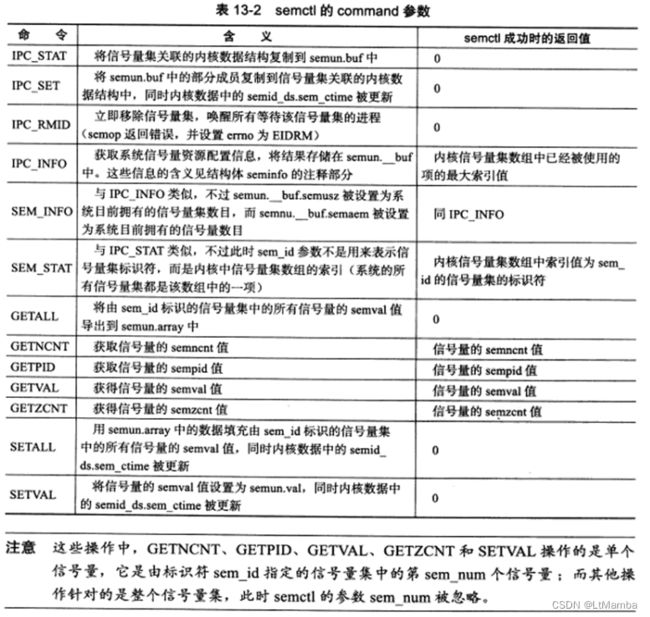

#include 2.3.3 semctl 对信号量集操作函数

#include 2.共享内存

2.1 概念

共享内存 是最高效的 IPC 机制,因为 不涉及进程之间任何数据传输。

但需要辅助手段来同步进程对共享内存的访问,否则会产生竟态条件。

Linux 共享内存包含 4 个系统调用:

shmget、shmat、shmdt、shmctl。

2.2 shmget 系统调用

//创建一段新的共享内存,或者获取一段已经存在的共享内存

#include 2.3 shmat 和 shmdt 系统调用

共享内存创建完后,

1.不能立即访问,而是首先将它关联到进程地址空间(shmat 实现)

2.使用完后,必须将它从进程地址空间中分离(shmdt 实现)

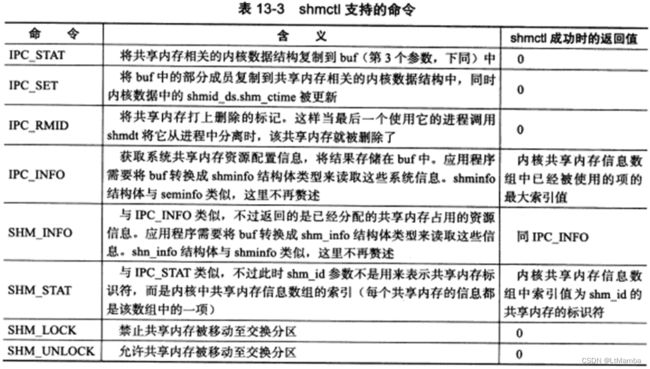

#include 2.4 shmctl 系统调用

//控制共享内存某些属性

#include 2.5 POSIX 的共享内存方法

注意:

使用如下 POSIX 共享内存函数,编译时需要指定链接选项 -lrt

//创建或打开一个 POSIX 共享内存对象

#include 2.6 共享内存实例

/*注意点:

1.每个子进程只会往自己所处理连接所对应的那一部分读缓存中写入数据,所以使用共享内存的目的是“共享读”。

因此,每个子进程在使用共享内存时都无需加锁,这样符合“聊天室服务器”的应用场景,同时提高性能。

2.程序启动时给 users 分配了足够的空间,使他可以存储所有可能的客户连接的相关数据。

同时,sub_process 也分配了足够的空间。

这是牺牲空间换时间的例子。

*/

//一个子进程处理一个客户连接

//所有客户 socket 连接的读缓冲设计为一块共享内存

#include 3. 消息队列

消息队列在两个进程间传递 二进制块数据 的方式。

每个数据块都有一个类型,接收方可以根据类型来有选择的接收数据。

而不像管道 和 命名管道那样必须先进先出的接收数据。

Linux消息队列 API 定义在 sys/msg.h 头文件中,

包括 4 个系统调用:

msgget、msgsnd、msgrcv、msgctl。

3.1 msgget 系统调用

//创建一个消息队列或者获取一个消息队列

#include 3.2 msgsnd 系统调用

//把一条消息添加到消息队列

#include 3.3 msgrcv 系统调用

//从消息队列中获取消息

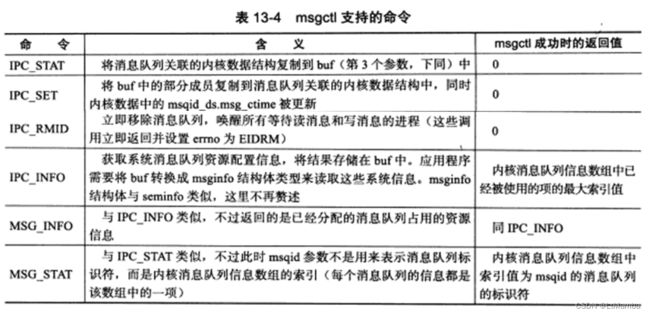

#include 3.4 msgctl 系统调用

//控制消息队列某些属性

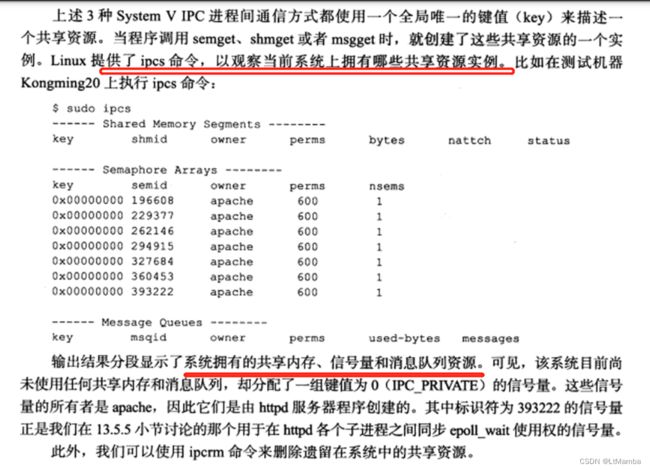

#include 4. IPC 命令

5.进程间传递文件描述符

fork 后,父进程中打开的文件描述符在子进程中仍然保持打开。

传递文件描述符是要在接收进程中创建一个新的文件描述符,并且该文件描述符和发送进程中被传递的文件描述符指向内核中相同文件表项。

示例:

#include