云存储,为 AI 创新提速

当下,如火如荼的 AI 大模型对算力和数据存储提出了更高的要求。在 6 月 1 日结束的“阿里云峰会·粤港澳大湾区”上,阿里云智能资深产品专家彭亚雄在 AI 新范式与商业创新论坛上做了《云存储,为 AI 创新提速》的主题分享。彭亚雄认为,在 AIGC 大模型的浪潮中,云存储作为数据基础设施,将在数据准备、训练与推理、应用部署、内容审核与协同等多个关键环节,发挥重要作用,助力 AI 创新加速。

一、AIGC 持续火热,存储系统面临大考

当前,AIGC 已经成为新的热点,很多人认为,AIGC 将会大幅提升整个社会的生产效率。这里面,一些很有意思的趋势正在发生。

首先,是获取大模型的成本开始大幅降低。以 GPT 3.5 为例,一千个 Token 的价格大概是 0.002 美金,这意味着 ChatGPT 输出 100 万个单词文本,花费不到 3 美金。基于如此低廉的成本,大众获取大模型能力的门槛在快速下降,这无疑有助于应用层的持续创新。

其次,杀手级应用(Killer App)将持续涌现,未来在社会生产中的每一个环节、每一个 APP 都有机会接入 AI 大模型进行升级改造,不仅可以大幅降低内容创作的门槛,同时也会持续提升内容创作的速度。海量高质量数据的生产效率,将会提升到一个前所未有的高度。

再次,高质量的数据将是大模型持续迭代的核心要素。众所周知,算法、算力、数据是 AI 的三大基石,而存储作为 IT 基础设施中的重要一环,本质是数据服务。

这些机遇与挑战也对存储提出了更高的要求:如何高效存储与管理海量多模态数据集; 如何在模型的开发和推理阶段提升训练效率; 如何保障 AI 生成内容合规安全; 如何便捷实现数据流转与分发; 如何保障 AI 业务永续。

二、因地制宜,云存储加速 AI 产业创新发展

面对这些挑战,云存储需要因地制宜、逐一击破:减少数据孤岛,持续降低成本,统一存储底座;持续提升存储性能,减少 GPU 等待时间;面向海量 AIGC 内容,提供一站式检测与处理能力;管理数据资产,让数据分享与协作更简单;构建高可用架构,让 AI 永远在线。阿里云存储正是从这五个方面入手,为 AI 产业创新发展加速。

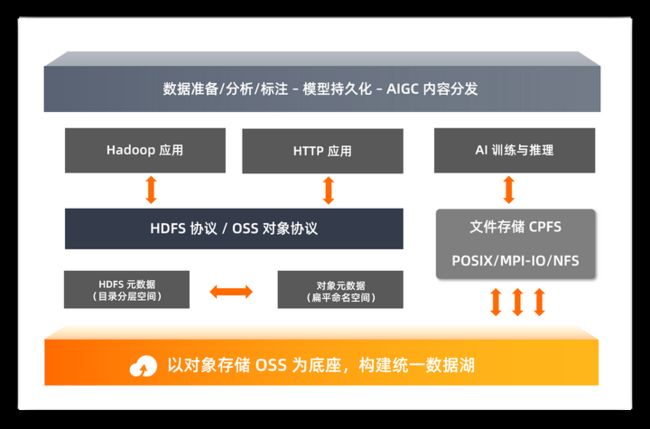

1、智能数据湖,为多模态数据集与模型提供统一存储底座

AI 训练的数据集,通常具有以海量小文件为主的特点,以 LAION-5B 为例,200TB 的数据规模,文件数量高达百亿量级。因此,在数据准备阶段,为了更有效地管理海量半结构化、非结构化数据,建议采用对象存储作为统一的数据底座,构建智能数据湖。

首先,对象存储 OSS 本身就是为海量数据而设计,可存储任意规模的数据,同时支持 Tbps 级吞吐,便于数据的上传与下载。

其次,海量 AIGC 内容、大模型,在持久化存储时,需要持续优化存储成本。对象存储 OSS 有 5 种存储类型可供选择,深度冷归档类型低至 0.75分/GB/月。客户可以把长期低频访问的数据放到 OSS 深度冷归档类型中,从而在数据增长的情况下,能够持续降低 TCO。

再次,AI 和大数据一体化已经成为趋势,以 OSS 为底座,一份数据对接多种不同计算引擎,可以很好地通过 HDFS 协议和 OSS 对象协议去对接传统的 Hadoop 应用和 HTTP 应用。

最后,对象存储 OSS 支持与高性能并行文件存储 CPFS 打通,对象存储 OSS 中的数据通过数据流动可以合并入 CPFS,实现统一命名空间的元数据管理。您可以手动或者通过自动 Lazy-load 能力,将 OSS 中的数据复制到 CPFS 中,实现通过 POSIX 文件接口高速访问 OSS 中的数据。

2、高性能文件存储,加速 AI 训练与推理效率

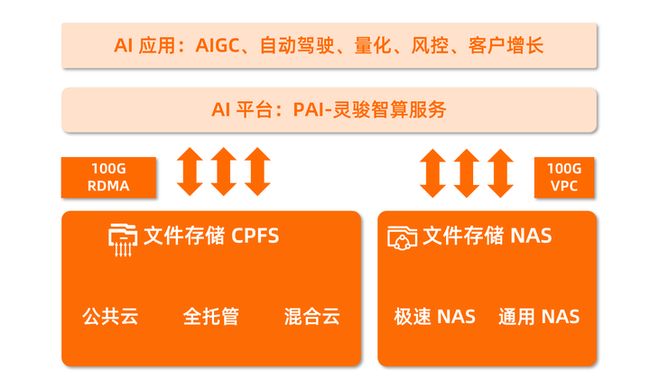

数据完成预处理后,再进行 AI 训练和推理,为了提高整体作业效率,建议采用高性能文件存储搭配 PAI-灵骏智算服务。

对于中大型规模的客户,推荐使用并行文件存储 CPFS,CPFS 基于端到端的 RDMA 网络、全对称的元数据服务器架构,单集群能力可以达到 2TB/s 吞吐、3000 万 IOPS,能很好地满足海量小文件处理需求。并且 CPFS 和灵骏智算一样支持多种售卖形态,包括公共云 CPFS、CPFS 全托管(灵骏智算)、CPFS 混合云等。在不同的业务场景下,既可以选择资产自持的模式,也可以选择公共云和智算模式,将 CAPEX 转换成 OPEX,以云的方式,按量付费灵活使用。

弹性文件客户端(Elastic File Client,简称“EFC”),通过计算端元数据缓存和创新的 lease 机制,提升 ls\du 等常见元数据操作速度 10 倍,可媲美本地 EXT4 性能,且多个客户端的数据保持强一致。弹性文件客户端与 Fluid 配合,在数据集训练场景下,相较 NFS 客户端,整体训练耗时缩短 87%。

面向一些小规模业务场景,尤其是面向 serverless 场景、从小的数据集开始训练的客户,我们也有极速型 NAS 可供选择。为了更好地服务这些客户,提升训练效率,阿里云存储将会把极速 NAS 吞吐性能提升 330%,其中小规格起步高吞吐从 150MBps 提升至 500MBps,整体吞吐上限从 1200MBps 提升至 4000MBps。

3、智能媒体管理,一站式完成 AIGC 内容处理

得益于 AI 模型的不断精进,AI 正大步迈入数字内容生产领域。目前,AIGC 已在写作、绘画、作曲多项领域达到“类人”表现。在 AI 模型部署和应用阶段,厂商必须在安全合规的基础上稳步实现 AIGC 应用落地、推进产品迭代。海量的 AIGC 内容,可以通过智能媒体管理 IMM 来做预处理和审核。

智能媒体管理 IMM 是一个与云存储原生集成的平台,这意味着无需移动数据就可以自动地进行处理。比如,IMM 支持一键关联对象存储,用户无需额外开发,即可支持文档处理、内容识别与检测等多种能力。IMM 具备完备的内容审核能力,无论是文本、图片还是视频,能够面向多模态数据进行多种内容审核,帮助企业更好地应对监管需求。

同时,IMM 提供面向场景的元数据管理能力,简化客户场景应用的设计复杂度,以便快速构建应用。最为关键的一点是,IMM 是一个 serverless 的服务,无需运维,让客户可以更加专注自己的业务。

4、网盘与相册服务,让 AIGC 内容协同与分享更简单

AIGC 生成的海量数据,在经过内容审核后需要流转起来,在组织和组织之间、人与人之间进行协同和分享,方能产生更大的价值。

通过网盘与相册服务 PDS,可以让 AIGC 内容协同、数据资产管理和内容分享更为简单。PDS 包含企业版和开发者版本,是为客户提供的面向企业、团队与个人的数据资产管理开放平台,提供一站式数据存储、分析、协同、分享和 AI 处理的能力。时至今日,PDS 在云上支撑了十亿级别的客户管理,具备管理百 EB 级别的数据规模的能力。深度集成 AI 能力的 PDS,支持数千种图片标签分类,加速 AIGC 内容预处理。

同时,PDS 支持开箱即用,用户既可以基于企业网盘这种 SaaS 服务,在企业内部快速构建简单高效易用的数据资产管理平台,也可以通过网盘的中间件去构建面向 C 端的个人网盘。所有的功能支持 OpenAPI 开放,帮助用户快速构建和设计适合自身的产品形态。

PDS 支持组织内外分享,冷热数据分发自动路由,所以对于拥有海量数据的企业而言,当需要数据在组织内部和外部进行流转、打通不同云盘之间数据时,PDS 会是一个非常好的选择。

今年阿里云存储也会在 PDS 中集成更多的大模型能力,我们希望让存储在 PDS 里的数据更加智能化,提升数据管理效率,为企业办公和个人开发者提供更多开箱即用的 AI 能力。

5、高可用 SLA 与容灾能力,让 AI 一直在线

随着 AI 能力的普及,可以预见的是,AI 将成为 7*24 小时的在线服务,如何保证它一直在线,是所有负责系统架构的人都要考虑的关键问题。在数据存储底座这一块,OSS 同城冗余存储类型,提供了业界领先的 99.995% 服务可用性 SLA,每十万次请求,失败次数不超过 5 次,OSS 的标准、低频、归档存储,都支持同城冗余的产品形态。

OSS 同城冗余存储类型,在全球 11 个地域提供服务,在 6 月底,OSS 将发布本地冗余 Bucket 产品化升级到同城冗余 Bucket 的能力。客户可以以服务化的方式,将原来本地冗余的 Bucket 自助升级到同城冗余的 Bucket,从而提升整个系统架构的可用性。

如果客户担心同城冗余的 Bucket,数据仍然在同一个地域,难以抵御地域级别的灾害,阿里云存储也提供了跨地域复制的容灾能力。OSS 跨区域复制 RTC 能力,可以让 99.99% 的数据在 10 分钟内,在不同地域之间完成复制,保持近实时同步。在实际线上生产环境中,有一家游戏厂商通过灵活运用 RTC 的能力,99.999% 的数据在 10 秒内完成了不同地域间的数据复制,相当于在对象存储层面,构建了跨地域秒级 RPO 的一个容灾架构,对提升业务连续性起到非常关键的作用。

前面提到的这些能力,无论是数据湖、高性能文件存储,还是智能媒体管理、网盘与相册服务以及容灾高可用能力,都已经在 AIGC 业务场景中,得到了广泛的客户认可和使用。中国某 AIGC 艺术创意灵感平台,使用对象存储 OSS 构建统一数据湖底座,存算解耦带来计算与存储的弹性扩展能力,一份数据对接不同计算引擎,通过 CPFS 与 OSS 数据流动,在训练效率提速 300% 的同时,持续为客户优化存储成本。

面向 AI 时代的云存储,必须要服务于数据全生命周期,贯穿 AI 业务全流程,在数据准备、模型训练与部署、应用与内容生成、内容分发与协作每一个关键环节,提供稳定、安全、高性能、低成本的存储能力。在新的 AI 浪潮下,阿里云存储将继续努力,帮助客户实现 AI 创新加速,助力客户业务持续增长。

点击立即免费试用云产品 开启云上实践之旅!

原文链接

本文为阿里云原创内容,未经允许不得转载。