- k8s:安装 Helm 私有仓库ChartMuseum、helm-push插件并上传、安装Zookeeper

云游

dockerhelmhelm-push

ChartMuseum是Kubernetes生态中用于存储、管理和发布HelmCharts的开源系统,主要用于扩展Helm包管理器的功能核心功能集中存储:提供中央化仓库存储Charts,支持版本管理和权限控制。跨集群部署:支持多集群环境下共享Charts,简化部署流程。离线部署:适配无网络环境,可将Charts存储在本地或局域网内。HTTP接口:通过HTTP协议提供服务,用户

- ZooKeeper架构及应用场景详解

走过冬季

学习笔记zookeeper架构分布式

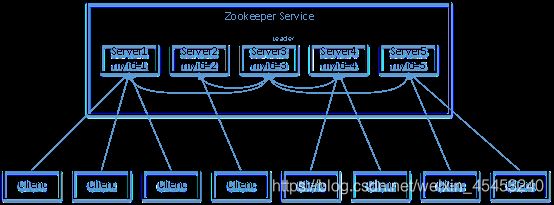

ZooKeeper是一个开源的分布式协调服务,由Apache软件基金会维护。它旨在为分布式应用提供高性能、高可用、强一致性的基础服务,解决分布式系统中常见的协调难题(如配置管理、命名服务、分布式锁、服务发现、领导者选举等)。核心软件架构ZooKeeper的架构设计围绕其核心目标(协调)而优化,主要包含以下关键组件:集群模式(Ensemble):ZooKeeper通常部署为集群(称为ensemble

- zookeeper etcd区别

sun007700

zookeeperetcd分布式

ZooKeeper与etcd的核心区别体现在设计理念、数据模型、一致性协议及适用场景等方面。ZooKeeper基于ZAB协议实现分布式协调,采用树形数据结构和临时节点特性,适合传统分布式系统;而etcd基于Raft协议,以高性能键值对存储为核心,专为云原生场景优化,是Kubernetes等容器编排系统的默认存储组件。12架构与设计目标差异ZooKeeper。设计定位:专注于分

- Apache Dubbo实战:JavaSDK使用

秃了也弱了。

Dubboapachedubbo

文章目录一、写在前面二、基于zookeeper:快速创建dubbo应用1、maven包(客户端+服务端)(注意spring版本)2、application.yml配置文件(客户端+服务端)3、定义公共接口4、启动类添加注解@EnableDubbo5、服务端6、客户端7、启动试试吧8、拓展:使用JavaConfig代替注解三、拓展配置1、注册中心2、版本与分组3、传递调用参数4、泛化调用5、泛化实现

- SpringBoot集成LangChain4j:构建智能AI应用全解析

java干货仓库

八股文汇总Spring大模型springboot人工智能后端

在企业级应用中融入大语言模型(LLM)能力已成为趋势,而LangChain4j作为专为Java设计的LLM集成框架,与SpringBoot的结合为开发者提供了强大而灵活的解决方案。本文将从基础概念到高级应用,全面解析如何利用这一组合构建智能AI应用。一、LangChain4j概述1.1什么是LangChain4j?LangChain4j是一个开源Java框架,灵感来源于Python的LangCha

- Kafka系列之:安装具有安全认证的kafka-2.8.2分布式集群

快乐骑行^_^

大数据Kafka系列安全认证kafka-2.8.2分布式集群

Kafka系列之:安装具有安全认证的kafka-2.8.2分布式集群一、下载Zookeeper3.7.1和Kafka2.8.2二、解压Zookeeper3.7.1和Kafka2.8.2三、安装Zookeeper3.7.1详细步骤1.修改zookeeper配置文件2.创建zookeeper数据目录3.zookeeper创建myid4.设置zookeeper访问kafka认证5.拷贝zookeeper

- 千亿级消息引擎 Apache Pulsar 深度剖析:架构原理、设计哲学与实战实践

北漂老男人

Pulsarapache架构学习方法运维

千亿级消息引擎ApachePulsar深度剖析:架构原理、设计哲学与实战实践Pulsar不止是消息队列,更是下一代云原生流平台。本文将深入剖析其底层架构、核心特性、关键差异、源码细节、调优技巧与企业级实践路径,力求做到“知其然,知其所以然”。一、架构哲学:分层解耦+IO隔离1.1三层架构模型(Broker+BookKeeper+ZooKeeper)Pulsar基于分布式系统经典设计范式:计算与存储

- 服务注册和发现组件的详细对比与选型建议(详细版)

古龙飞扬

springcloudspring后端

服务注册和发现组件Eureka、Consul、ZooKeeper、Etcd和Nacos的区别与选型建议在微服务架构中,服务注册与发现是一个核心组件,它解决了服务实例的动态管理和自动发现的问题。目前,市场上存在多种服务注册与发现组件,其中Eureka、Consul、ZooKeeper、Etcd和Nacos较为常见。作为资深的软件架构师,本文将详细分析这些组件的区别,并提供选型建议。一、EurekaE

- Kafka浅学

文文Tao

kafkajava分布式

Kafka应用场景?异步解耦流量消锋Kafka消息队列特点?Kafka吞吐量高:因为他存储数据时,磁盘顺序存储,磁盘的顺序存储速度很快。Kafka持久化消息:这些消息日志可以被重复读取和永久保留可以运行时动态扩展伸缩:Kafka是分布式系统:它以集群的方式运行,早期依赖Zookeeper对于Kafka的作用是什么?Zookeeper是分布式协调服务。Zookeeper作用:用于在Kafka集群中不

- Zookeeper的典型应用场景?

大家好,我是锋哥。今天分享关于【Zookeeper的典型应用场景?】面试题。希望对大家有帮助;Zookeeper的典型应用场景?超硬核AI学习资料,现在永久免费了!Zookeeper是一个开源的分布式协调服务,它被广泛应用于需要分布式系统协调的场景。以下是Zookeeper的一些典型应用场景:1.分布式锁在分布式系统中,多个节点可能需要对共享资源进行访问,这时就需要确保访问的排他性。Zookeep

- 分布式生成 ID 策略的演进和最佳实践,含springBoot 实现(Java版本)

一、背景在单体架构中,ID通常使用数据库自增或UUID即可满足需求。但在微服务、分布式环境中,这些方式存在性能瓶颈、重复冲突、时序不全等问题。因此,分布式ID生成策略应运而生,用于确保在高并发、跨节点、异地部署的系统中,生成全局唯一、趋势递增、高性能的ID。二、演进历程单机自增ID(如数据库自增)Java原生UUID工具类生成(如雪花算法、KeyUtil等)中间件分布式协调(如Zookeeper、

- 【容器】优质文章分享

文章目录加速器Docker教程安装坑volumn网络配置踩坑其他dockerfiledocker-compose手册教程网络坑docker使用dockermysqldockermongoredisdocker-rabbitmqnginxtomcatnacoszookeeperelasticsearch加速器现在docker镜像站真的不好找了。阿里什么的加速目前只能给阿里自己的容器用了。且用且珍惜D

- Java学习第二十二部分——了解框架

慕y274

java学习开发语言

目录一.概述二.分类1.Web开发框架2.持久层框架3.依赖注入框架4.安全框架5.微服务框架三.优势四.建议一.概述Java框架是一种用于简化Java开发过程的工具,它提供了一组预定义的类和接口,帮助开发者更高效地构建应用程序。二.分类1.Web开发框架-**SpringMVC**-**特点**:它是Spring框架的一部分,用于构建Web应用程序。它支持多种视图技术,如JSP、Thymelea

- ShardingSphere-JDBC 详解

csdn_tom_168

ApacheShardingSphere数据库ShardingSphereJDBC学习

ShardingSphere-JDBC(原Sharding-JDBC)是ApacheShardingSphere的核心模块之一,定位为轻量级Java框架,在Java的JDBC层提供分库分表、读写分离、数据加密、影子库等分布式数据库增强能力。它直接操作JDBC接口,对应用透明,集成成本极低。以下是ShardingSphere-JDBC的详解:一、核心功能数据分片:分库分表:将逻辑上的大表(库)拆分成

- Kafka Controller 元数据解析与故障恢复实战指南

磐基Stack专业服务团队

Kafkakafkalinq分布式

#作者:张桐瑞文章目录1生产案例:Controller选举在故障恢复中的关键作用1.1问题背景1.2核心操作原理:2Controller元数据全景:从ZooKeeper到内存的数据镜像2.1元数据核心载体:ControllerContext类2.2核心元数据深度解析1生产案例:Controller选举在故障恢复中的关键作用1.1问题背景某Kafka集群部分核心主题分区一直处于“不可用”状态,通过k

- Zookeeper异常ConnectionLossException: KeeperErrorCode = ConnectionLoss for / 问题解决大全

takmehand

Javajavazookeeper

zookeeper报ConnectionLossException:KeeperErrorCode=ConnectionLossfor异常我的开发环境是Windows开发zookeeper客户端程序,zookeeper集群安装在本地虚拟机上centos7经过自己踩坑和查找博客,发现报此异常有三种原因一是:zookeeper服务没有启动,这是最low的错误二是:centos防火墙未关闭,导致连接不上

- 【Note】《Kafka: The Definitive Guide》 第二章 Installing Kafka:Kafka 安装与运行

《Kafka:TheDefinitiveGuide》第二章InstallingKafka:Kafka安装与运行本章核心目标是教读者如何在本地搭建Kafka,包括依赖安装、启动服务、测试运行等操作。一、Kafka的依赖与基本结构1.Kafka的核心组成Kafka并不是一个单独运行的进程,它依赖以下两个核心组件:组件作用ZooKeeperKafka用于存储元数据(如broker注册信息、control

- 利用已有的 PostgreSQL 和 ZooKeeper 服务,启动dolphinscheduler-standalone-server3.1.9 镜像

云游

大数据平台zookeeperdockerpostgresql工作流任务调度

ApacheDolphinScheduler是一个分布式易扩展的可视化DAG工作流任务调度开源系统。适用于企业级场景,提供了一个可视化操作任务、工作流和全生命周期数据处理过程的解决方案。ApacheDolphinScheduler旨在解决复杂的大数据任务依赖关系,并为应用程序提供数据和各种OPS编排中的关系。解决数据研发ETL依赖错综复杂,无法监控任务健康状态的问题。DolphinSchedule

- RPC--zookeeper服务提供类

ZKServiceProviderImpl实现类:下面三个属性,第一个serviceMap,key是服务名称,value是Object也就是服务对象,用于快速查找服务实例第二个registeredService,是已经注册的服务名称,防止重复注册服务第三个serviceRegistry是一个服务注册组件,负责将服务元数据写入Zookeeper接口方法:添加服务、获取服务、发布服务1、addServ

- OneCode图表组件深度解析:注解驱动的Java可视化方案

低代码老李

领域设计低代码软件行业java开发语言

在数据驱动决策的时代,企业级应用对可视化的需求日益复杂。OneCode作为专注于企业级开发的Java框架,其可视化引擎通过创新的设计理念和技术实现,为开发者带来了截然不同的图表开发体验。本文将深入剖析OneCode在可视化领域的五大独特优势。一、注解驱动的零前端代码开发模式OneCode彻底颠覆了传统图表开发需要编写JavaScript的模式,创新性地将所有图表配置通过Java注解完成:@FCha

- 解决Windows下C++编译ZooKeeper时的`__imp_zookeeper_init`错误

本文还有配套的精品资源,点击获取简介:在Windows环境中使用C++编译ZooKeeper客户端库时,可能会遇到__imp_zookeeper_init错误,这通常是由于动态链接库(DLL)导入问题导致的。文章解释了如何处理这个错误,包括获取ZooKeeper开发库、配置编译器、链接ZooKeeper库、拷贝DLL文件以及正确使用API。此外,也提到了如何从源代码编译ZooKeeper,以确保所

- ZooKeeper应用场景和实现方案详解:从分布式协调到微服务架构的全场景实践

一切皆有迹可循

微服务注册中心分布式技术分布式架构zookeeper后端云原生微服务java

前言在分布式系统中,协调与一致性是构建可靠服务的核心挑战。ApacheZooKeeper作为高性能分布式协调服务,提供了一套通用的分布式原语,被广泛应用于服务注册发现、分布式锁、配置管理等关键场景。本文将深入解析ZooKeeper的典型应用场景,结合具体代码示例展示实现方案,帮助开发者快速掌握其核心用法。一、服务注册与发现:构建弹性微服务架构1.1场景需求微服务架构中,服务实例动态上下线,需要一个

- SpringBoot教程(二十二) | SpringBoot实现分布式定时任务之elastic-job

Slow菜鸟

#SpringBoot学习篇springboot分布式后端

SpringBoot教程(二十二)|SpringBoot实现分布式定时任务之elastic-job简介适用场景前置条件:需要ZooKeeper配合1、引入相关依赖2、application.yml中配置注册中心和作业调度巨坑(配置修改无效)3、job实例4、ElasticJob-UI监控平台(相当于管理端页面)参考文章:【1】SpringBoot整合分布式任务调度Elastic-Job【2】Ela

- 分布式作业: Elastic-Job

赤橙红的黄

Spring分布式

1.背景介绍Spring框架自带的定时任务scheduled如果部署多台机器时,同一个任务会执行多次,比如给用户计算收益定时任务,每天定时给用户计算收益,如果部署了多台,同一个用户将重复计算多次收益(业务错误),但如果只部署一台机器,无法保证高可用性,如果定时任务机器宕机,无法故障转移;Elastic-Job基于Zookeeper、Quartz开发的Java分布式定时任务解决方案。2.优点高可用性

- 分布式定时任务:Elastic-Job-Lite

Elastic-Job-Lite是一款由Apache开源的轻量级分布式任务调度框架,属于ShardingSphere生态体系的一部分。它专注于分布式任务调度,支持弹性伸缩、分片处理、高可用等特性,且不依赖中心化架构。一、基础(一)核心特性分布式协调通过ZooKeeper实现作业的分布式调度和协调,确保任务在集群环境中不重复、不遗漏地执行。分片机制支持将任务拆分为多个分片(Sharding)并行执行

- 【Java面试】RocketMQ的设计原理

用心分享技术

Java面试题java面试rocketmq

一、核心架构设计原因NameServer轻量级无状态问题:传统注册中心(如ZooKeeper)强一致性(CP)设计复杂,且在高并发场景下性能瓶颈明显。解决:NameServer采用无状态+最终一致性(AP),节点间不通信,仅通过Broker心跳(30s/次)更新路由,降低复杂度并提升吞吐量。容忍分钟级不一致(如Broker宕机需120s剔除),适合消息路由这种非强一致场景。Broker主从架构与文

- 基于 SASL/SCRAM 让 Kafka 实现动态授权认证

zlt2000

Javajavaspringbootkafka

一、说明在大数据处理和分析中ApacheKafka已经成为了一个核心组件。然而在生产环境中部署Kafka时,安全性是一个必须要考虑的重要因素。SASL(简单认证与安全层)和SCRAM(基于密码的认证机制的盐化挑战响应认证机制)提供了一种方法来增强Kafka集群的安全性。本文将从零开始部署ZooKeeper和Kafka并通过配置SASL/SCRAM和ACL(访问控制列表)来增强Kafka的安全性。二

- 大数据集群架构hadoop集群、Hbase集群、zookeeper、kafka、spark、flink、doris、dataeas(二)

争取不加班!

hadoophbasezookeeper大数据运维

zookeeper单节点部署wget-chttps://dlcdn.apache.org/zookeeper/zookeeper-3.8.4/apache-zookeeper-3.8.4-bin.tar.gz下载地址tarxfapache-zookeeper-3.8.4-bin.tar.gz-C/data/&&mv/data/apache-zookeeper-3.8.4-bin//data/zoo

- Nacos与Eureka、ZooKeeper的区别?

leijmdas

java

Nacos、Eureka和ZooKeeper是分布式系统中常用的服务注册与发现组件,但它们在功能定位、一致性模型、性能特性及适用场景上存在显著差异。以下从核心维度进行对比分析:一、功能定位对比特性NacosEurekaZooKeeper核心功能服务注册发现+动态配置管理仅服务注册发现分布式协调(含服务发现)健康检查多模式(心跳+服务端主动探测)仅客户端心跳临时节点会话机制管理界面功能丰富,支持配置

- JT808教程:设置/查询终端参数

REDISANT提供互联网与物联网开发测试套件#互联网与中间件:RedisAssistantZooKeeperAssistantKafkaAssistantRocketMQAssistantRabbitMQAssistantPulsarAssistantHBaseAssistantNoSqlAssistantEtcdAssistantGarnetAssistant工业与物联网:MQTTAssist

- java杨辉三角

3213213333332132

java基础

package com.algorithm;

/**

* @Description 杨辉三角

* @author FuJianyong

* 2015-1-22上午10:10:59

*/

public class YangHui {

public static void main(String[] args) {

//初始化二维数组长度

int[][] y

- 《大话重构》之大布局的辛酸历史

白糖_

重构

《大话重构》中提到“大布局你伤不起”,如果企图重构一个陈旧的大型系统是有非常大的风险,重构不是想象中那么简单。我目前所在公司正好对产品做了一次“大布局重构”,下面我就分享这个“大布局”项目经验给大家。

背景

公司专注于企业级管理产品软件,企业有大中小之分,在2000年初公司用JSP/Servlet开发了一套针对中

- 电驴链接在线视频播放源码

dubinwei

源码电驴播放器视频ed2k

本项目是个搜索电驴(ed2k)链接的应用,借助于磁力视频播放器(官网:

http://loveandroid.duapp.com/ 开放平台),可以实现在线播放视频,也可以用迅雷或者其他下载工具下载。

项目源码:

http://git.oschina.net/svo/Emule,动态更新。也可从附件中下载。

项目源码依赖于两个库项目,库项目一链接:

http://git.oschina.

- Javascript中函数的toString()方法

周凡杨

JavaScriptjstoStringfunctionobject

简述

The toString() method returns a string representing the source code of the function.

简译之,Javascript的toString()方法返回一个代表函数源代码的字符串。

句法

function.

- struts处理自定义异常

g21121

struts

很多时候我们会用到自定义异常来表示特定的错误情况,自定义异常比较简单,只要分清是运行时异常还是非运行时异常即可,运行时异常不需要捕获,继承自RuntimeException,是由容器自己抛出,例如空指针异常。

非运行时异常继承自Exception,在抛出后需要捕获,例如文件未找到异常。

此处我们用的是非运行时异常,首先定义一个异常LoginException:

/**

* 类描述:登录相

- Linux中find常见用法示例

510888780

linux

Linux中find常见用法示例

·find path -option [ -print ] [ -exec -ok command ] {} \;

find命令的参数;

- SpringMVC的各种参数绑定方式

Harry642

springMVC绑定表单

1. 基本数据类型(以int为例,其他类似):

Controller代码:

@RequestMapping("saysth.do")

public void test(int count) {

}

表单代码:

<form action="saysth.do" method="post&q

- Java 获取Oracle ROWID

aijuans

javaoracle

A ROWID is an identification tag unique for each row of an Oracle Database table. The ROWID can be thought of as a virtual column, containing the ID for each row.

The oracle.sql.ROWID class i

- java获取方法的参数名

antlove

javajdkparametermethodreflect

reflect.ClassInformationUtil.java

package reflect;

import javassist.ClassPool;

import javassist.CtClass;

import javassist.CtMethod;

import javassist.Modifier;

import javassist.bytecode.CodeAtt

- JAVA正则表达式匹配 查找 替换 提取操作

百合不是茶

java正则表达式替换提取查找

正则表达式的查找;主要是用到String类中的split();

String str;

str.split();方法中传入按照什么规则截取,返回一个String数组

常见的截取规则:

str.split("\\.")按照.来截取

str.

- Java中equals()与hashCode()方法详解

bijian1013

javasetequals()hashCode()

一.equals()方法详解

equals()方法在object类中定义如下:

public boolean equals(Object obj) {

return (this == obj);

}

很明显是对两个对象的地址值进行的比较(即比较引用是否相同)。但是我们知道,String 、Math、I

- 精通Oracle10编程SQL(4)使用SQL语句

bijian1013

oracle数据库plsql

--工资级别表

create table SALGRADE

(

GRADE NUMBER(10),

LOSAL NUMBER(10,2),

HISAL NUMBER(10,2)

)

insert into SALGRADE values(1,0,100);

insert into SALGRADE values(2,100,200);

inser

- 【Nginx二】Nginx作为静态文件HTTP服务器

bit1129

HTTP服务器

Nginx作为静态文件HTTP服务器

在本地系统中创建/data/www目录,存放html文件(包括index.html)

创建/data/images目录,存放imags图片

在主配置文件中添加http指令

http {

server {

listen 80;

server_name

- kafka获得最新partition offset

blackproof

kafkapartitionoffset最新

kafka获得partition下标,需要用到kafka的simpleconsumer

import java.util.ArrayList;

import java.util.Collections;

import java.util.Date;

import java.util.HashMap;

import java.util.List;

import java.

- centos 7安装docker两种方式

ronin47

第一种是采用yum 方式

yum install -y docker

- java-60-在O(1)时间删除链表结点

bylijinnan

java

public class DeleteNode_O1_Time {

/**

* Q 60 在O(1)时间删除链表结点

* 给定链表的头指针和一个结点指针(!!),在O(1)时间删除该结点

*

* Assume the list is:

* head->...->nodeToDelete->mNode->nNode->..

- nginx利用proxy_cache来缓存文件

cfyme

cache

user zhangy users;

worker_processes 10;

error_log /var/vlogs/nginx_error.log crit;

pid /var/vlogs/nginx.pid;

#Specifies the value for ma

- [JWFD开源工作流]JWFD嵌入式语法分析器负号的使用问题

comsci

嵌入式

假如我们需要用JWFD的语法分析模块定义一个带负号的方程式,直接在方程式之前添加负号是不正确的,而必须这样做:

string str01 = "a=3.14;b=2.71;c=0;c-((a*a)+(b*b))"

定义一个0整数c,然后用这个整数c去

- 如何集成支付宝官方文档

dai_lm

android

官方文档下载地址

https://b.alipay.com/order/productDetail.htm?productId=2012120700377310&tabId=4#ps-tabinfo-hash

集成的必要条件

1. 需要有自己的Server接收支付宝的消息

2. 需要先制作app,然后提交支付宝审核,通过后才能集成

调试的时候估计会真的扣款,请注意

- 应该在什么时候使用Hadoop

datamachine

hadoop

原帖地址:http://blog.chinaunix.net/uid-301743-id-3925358.html

存档,某些观点与我不谋而合,过度技术化不可取,且hadoop并非万能。

--------------------------------------------万能的分割线--------------------------------

有人问我,“你在大数据和Hado

- 在GridView中对于有外键的字段使用关联模型进行搜索和排序

dcj3sjt126com

yii

在GridView中使用关联模型进行搜索和排序

首先我们有两个模型它们直接有关联:

class Author extends CActiveRecord {

...

}

class Post extends CActiveRecord {

...

function relations() {

return array(

'

- 使用NSString 的格式化大全

dcj3sjt126com

Objective-C

格式定义The format specifiers supported by the NSString formatting methods and CFString formatting functions follow the IEEE printf specification; the specifiers are summarized in Table 1. Note that you c

- 使用activeX插件对象object滚动有重影

蕃薯耀

activeX插件滚动有重影

使用activeX插件对象object滚动有重影 <object style="width:0;" id="abc" classid="CLSID:D3E3970F-2927-9680-BBB4-5D0889909DF6" codebase="activex/OAX339.CAB#

- SpringMVC4零配置

hanqunfeng

springmvc4

基于Servlet3.0规范和SpringMVC4注解式配置方式,实现零xml配置,弄了个小demo,供交流讨论。

项目说明如下:

1.db.sql是项目中用到的表,数据库使用的是oracle11g

2.该项目使用mvn进行管理,私服为自搭建nexus,项目只用到一个第三方 jar,就是oracle的驱动;

3.默认项目为零配置启动,如果需要更改启动方式,请

- 《开源框架那点事儿16》:缓存相关代码的演变

j2eetop

开源框架

问题引入

上次我参与某个大型项目的优化工作,由于系统要求有比较高的TPS,因此就免不了要使用缓冲。

该项目中用的缓冲比较多,有MemCache,有Redis,有的还需要提供二级缓冲,也就是说应用服务器这层也可以设置一些缓冲。

当然去看相关实现代代码的时候,大致是下面的样子。

[java]

view plain

copy

print

?

public vo

- AngularJS浅析

kvhur

JavaScript

概念

AngularJS is a structural framework for dynamic web apps.

了解更多详情请见原文链接:http://www.gbtags.com/gb/share/5726.htm

Directive

扩展html,给html添加声明语句,以便实现自己的需求。对于页面中html元素以ng为前缀的属性名称,ng是angular的命名空间

- 架构师之jdk的bug排查(一)---------------split的点号陷阱

nannan408

split

1.前言.

jdk1.6的lang包的split方法是有bug的,它不能有效识别A.b.c这种类型,导致截取长度始终是0.而对于其他字符,则无此问题.不知道官方有没有修复这个bug.

2.代码

String[] paths = "object.object2.prop11".split("'");

System.ou

- 如何对10亿数据量级的mongoDB作高效的全表扫描

quentinXXZ

mongodb

本文链接:

http://quentinXXZ.iteye.com/blog/2149440

一、正常情况下,不应该有这种需求

首先,大家应该有个概念,标题中的这个问题,在大多情况下是一个伪命题,不应该被提出来。要知道,对于一般较大数据量的数据库,全表查询,这种操作一般情况下是不应该出现的,在做正常查询的时候,如果是范围查询,你至少应该要加上limit。

说一下,

- C语言算法之水仙花数

qiufeihu

c算法

/**

* 水仙花数

*/

#include <stdio.h>

#define N 10

int main()

{

int x,y,z;

for(x=1;x<=N;x++)

for(y=0;y<=N;y++)

for(z=0;z<=N;z++)

if(x*100+y*10+z == x*x*x

- JSP指令

wyzuomumu

jsp

jsp指令的一般语法格式: <%@ 指令名 属性 =”值 ” %>

常用的三种指令: page,include,taglib

page指令语法形式: <%@ page 属性 1=”值 1” 属性 2=”值 2”%>

include指令语法形式: <%@include file=”relative url”%> (jsp可以通过 include