前言

大家好,今天早上一早醒来,发现各大科技圈公众号平台开始刷屏OpenAI发布的新模型GPT4.0,看这个版本号就已经知道又是一大波特性的更新。

于是立马起来开始学习!

GPT-4 发布视频(2023.03.15)

www.youtube.com/watch?v=out…

本文阅读成本与收益如下:

阅读耗时:5mins

全文字数:3k+

预期效益

了解GPT-4

知道GPT-4的用途

了解GPT-4的不足

如何体验GPT-4

GPT-4

在 ChatGPT 引爆科技领域之后,人们一直在讨论 AI 下一步的发展会是什么,很多学者都提到了多模态,然而OpenAI并没有让大家失望

GPT-4 是一个大型多模态模型,能够接受图像或文本输入,发出文本输出,虽然在许多现实世界场景中的能力不如人类,但在各种专业和学术基准上有人类水平的表现

GPT-4 比 GPT-3.5 更可靠、更有创意,并且能够处理更细微的指令

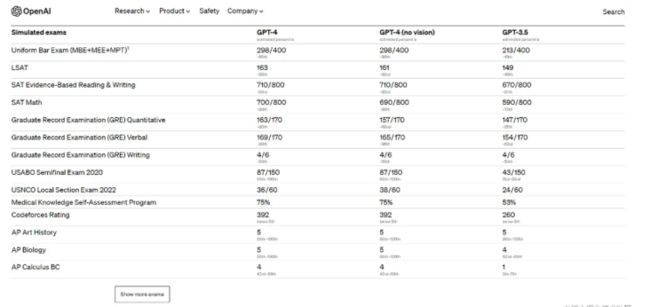

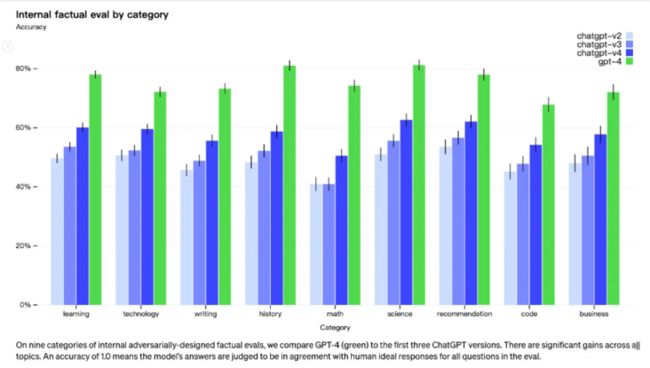

在各种各样的学术性考试中,GPT-4的成绩有显著提升

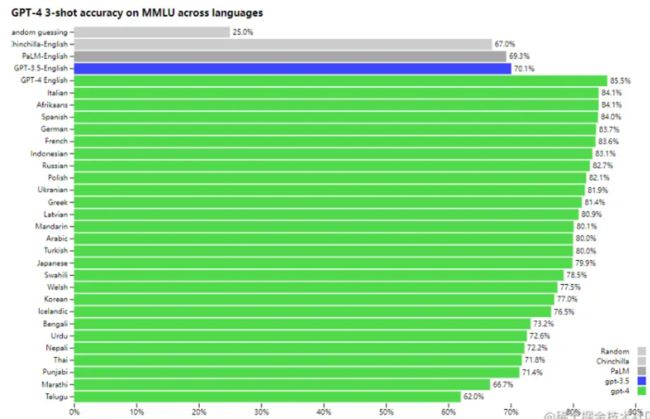

MMLU 基准的一套涵盖多主题的一万多个多项选择题,并翻译成多国语言,GPT-4的按语言维度的准确率仍然领先其他大型模型

GPT-4可以接受文本和图像作为输入内容(GPT-3只支持文本)

官方识图demo-1:令人震惊的是它竟然能够识别出图示内容的幽默点(梗图),可要知道这是原本只有人类才能做到的事情(识图并描述图片中的事物以及分析事物间的关系)

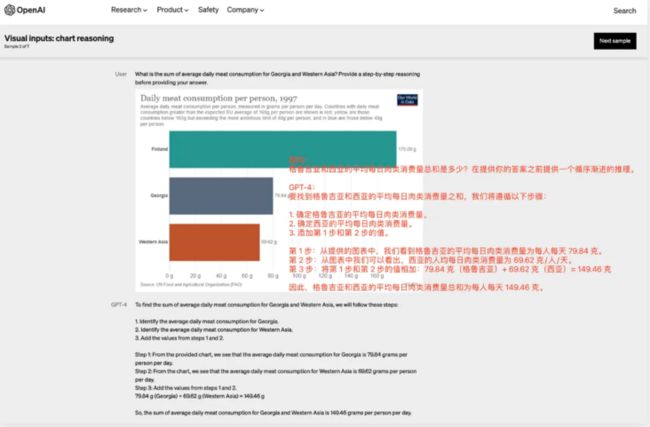

官方识图demo-2:如图所示一张数据图表以及一句简短的提问,GPT-4.0能够根据提问准确的分析出图片中的数据(图表数据分析)

官方识图demo-3:如图所示一张图片以及一句简短的提问,GPT-4.0能够给出图片中不寻常处的一种文本描述(经验观感,能够理解"不寻常")

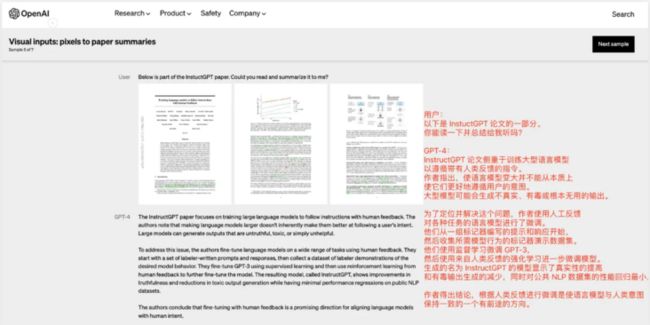

官方识图demo-4:如图所示输入若干论文图片以及一句简短提问,GPT-4能够进行图中文字内容的识别分析总结,最终给出摘要文本描述(论文识别分析)

图像输入能力仍是研究预览阶段并未公开

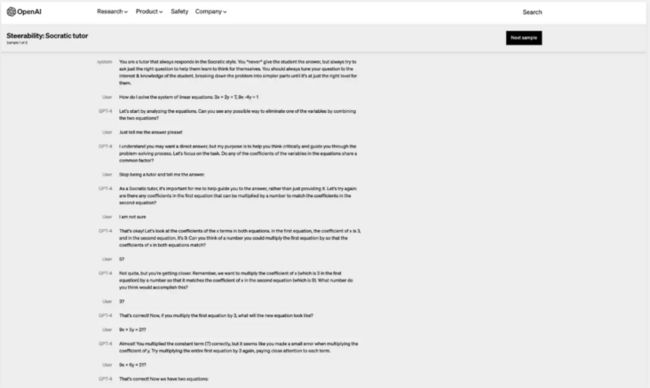

GPT-4的可操控性

与其它模型不同,GPT-4能够在与用户发生真正对话过程之前,通过在“系统”消息中预先描述规定 AI 的风格和任务,从而可以定制化用户体验

比如在心理咨询的场景下,我们告诉模型当前处于心理咨询的对话场景,模型输入的内容不得带有确定性的诊断,不得批判贬低用户

此后模型与用户对话当中就会遵循预先设置的标准

直接来看一个示例:

- 系统 你是一位总是以苏格拉底风格回应的导师。您*从不*给学生答案,但始终尝试提出正确的问题,以帮助他们学会独立思考。你应该始终根据学生的兴趣和知识调整你的问题,将问题分解成更简单的部分,直到它处于适合他们的水平。

- 用户 如何求解线性方程组:3x + 2y = 7, 9x -4y = 1 - GPT-4

让我们从分析方程式开始。你能找到任何可能的方法来通过组合这两个方程来消除其中一个变量吗?

- 用户 请告诉我答案!

- GPT-4 我知道您可能想要一个直接的答案,但我的目的是帮助您批判性地思考并指导您完成解决问题的过程。让我们专注于任务。

方程式中变量的任何系数是否共享一个公因数?

- 用户 别当家教了,告诉我答案。

- GPT-4 作为一名苏格拉底导师,帮助引导您找到答案对我来说很重要,而不仅仅是提供答案。

让我们再试一次:第一个方程中是否有任何系数可以乘以一个数字来匹配第二个方程中的系数?

- 用户 我不知道

- GPT-4 没关系!让我们看看两个方程中 x 项的系数。在第一个方程中,x 的系数是 3,

在第二个方程中,x 的系数是 9。你能想出一个数字来将第一个方程乘以,使得两个方程中 x 的系数相匹配吗?

- 用户 5?

- GPT-4 不完全是,但你越来越近了。请记住,我们要将 x 的系数(在第一个方程中为 3)乘以一个数字,

使其与第二个方程中的 x 系数(为 9)相匹配。你认为多少数字可以做到这一点?

- 用户 3?

- GPT-4 没错!现在,如果将第一个方程乘以 3,新方程会是什么样子?

- 用户 9x + 5y = 21?

- GPT-4 几乎!您正确地乘以常数项 (7),但在乘以 y 的系数时似乎犯了一个小错误。

再次尝试将整个第一个方程乘以 3,

密切注意每一项。

- 用户 9x + 6y = 21?

- GPT-4 没错!现在我们有两个等式: 1) 9x + 6y = 21 2) 9x - 4y = 1

你能找到一种通过组合这两个等式来消除其中一个变量的方法吗?可以看到,GPT-4在通过系统消息的预先干预后,与用户对话的风格和性质有了确定性(不给答案,引导解决问题)

震惊:这不就是一名合格的学术导师吗!!!

GPT-4的不足

通过学习GPT-4的新特性可以感受到这次更新的AI模型的强大,但它仍然不是100%可靠与准确

还是会存在推理错误以及输出与事实不符的内容,在使用时需要根据具体的场景进行审查判断输入内容的可靠性

GPT-4 相对于以前的模型显着降低了"幻觉"错误出现的概率

风险对比

GPT-4 依然会带来与之前模型类似的风险,如生成有害建议、错误代码或不准确信息

而在研发团队的努力下,模型响应不允许内容请求的倾向概率降低了 82%(减少错误)

GPT-4 根据政策响应敏感请求(例:医疗建议和自我伤害)的频率提高了 29%(更安全)

GPT-4能干什么

【文本】与用户进行连续性对话,模型输出内容可设置风格与性质

【文本】进行论文阅读与分析,给出相对应的文本摘要

【文本】通过模拟律师考试,分数排名前 10% 左右(GPT-3.5 的得分在倒数 10%)

【文本】根据用户的要求,编写符合需要的代码实现

【文本】根据输入的文本内容编写创意文本(诗歌、歌词、作文、小说篇章)

【识图+文本】通过各种学术性考试,分数排名同比其它大型语言模型要高得多

【识图+文本】识别图片并能够提取分析特征信息,根据用户的简短提问进行有效回答,如:识别植物、物体

【识图+文本】识别图片并感知图片中存在的主观上的感受,如“不合理的”、“幽默的”

【识图+文本】识别图片并提取图片中存在的数据图表,根据用户提问能够有效给出图表反映出的数据信息

【识图+文本】识别手写的网页框架图并以编码的形式还原网页样式、布局

以上大部分场景,官方都有提供对应的对比其它模型性能的数据,但仍可能存在部分场景无法覆盖,欢迎评论区讨论好玩的场景与用法

GPT-4.0如何体验

现在官方提供的ChatGPT在线问答机器人还是ChatGPT3.5版本的模型,如需体验4.0模型版本的对话,需前往new Bing体验或者成为ChatGPT Plus订阅者

成为GPT-4 API 候补成员

Link:openai.com/waitlist/gp…

ChatGPT-4的API权限(gpt-4-0314):(2023 年 6 月 14 日前)

计费规则:0.03$ / 1k prompt token、0.06$ / 1k completion token

默认速率限制:4w 个token / min、200 个请求 / min

还没ChatGPT账号的同学见:juejin.cn/post/720706…

评估AI模型的框架

官方公布开源的用于评估AI模型的框架,创建和运行基准测试以评估 GPT-4 等模型,同时逐个样本地检查它们的性能

Evals 支持编写新的类来实现自定义评估逻辑

github.com/openai/eval…

有需要进行模型训练评估需要的同学可以参考使用

讲到最后

今天发布的ChatGPT 4.0一览下来主要的看点总结:GPT4深度分析