Docker部署ELK

一、拉取镜像

docker pull elasticsearch:7.2.0

docker pull mobz/elasticsearch-head:5

docker pull kibana:7.2.0

docker pull logstash:7.2.0

二、 运行容器

-p (小写)映射端口号,主机端口:容器端口

-P(大写)随机为容器指定端口号

-v 进行容器的挂载

–name 指定容器别名

–net 连接指定网络

-e 指定启动容器时的环境变量

-d 后台运行容器

–privileged=true 使容器有权限挂载目录

ElasticSearch 的默认端口是 9200,把宿主环境 9200 端口映射到 Docker 容器中的 9200 端口,容器命名为 es。

docker run -d --restart=always --name es -p 9200:9200 -p 9300:9300 -e "discovery.type=single-node" elasticsearch:7.2.0

三、 配置跨域

3.1 进入容器

docker exec -it es /bin/bash

3.2 进行配置

# 进入配置文件夹

cd config

# 修改配置文件

vi elasticsearch.yml

# 加入跨域配置

http.cors.enabled: true

http.cors.allow-origin: "*"

3.3 重启容器

由于修改了配置,因此需要重启 ElasticSearch 容器。

docker restart es

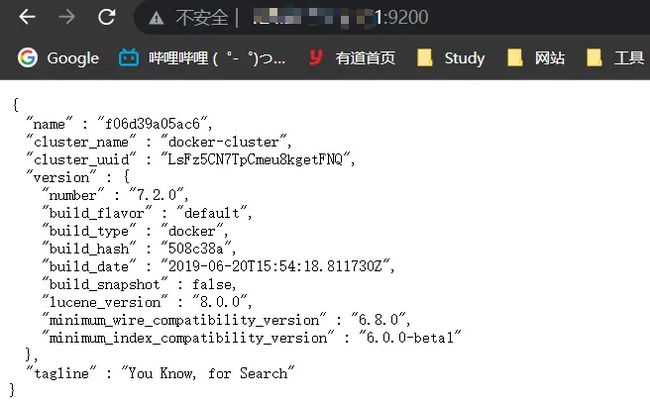

3.4 访问

四、 运行 kibana 容器

docker run -d --restart=always --name kibana --link es:elasticsearch -p 5601:5601 kibana:7.2.0

4.1 设置中文

# 进入容器

docker exec -it kibana /bin/bash

# 进入配置文件夹

cd config

# 修改配置文件

vi kibana.yml

# 修改elasticsearch连接(如果是本机部署,ip需填写内网ip)

elasticsearch.hosts: [ "http://elasticsearch的ip地址:端口号" ]

# 加入中文配置(保存后重启kibana)

i18n.locale: "zh-CN"

4.2 安装ik分词器

安装ik分词器,下载ik.zip(

版本必须和elasticsearch相同)

https://github.com/medcl/elasticsearch-analysis-ik/releases

# 下载ik分词器

https://github.com/medcl/elasticsearch-analysis-ik/releases/download/v7.2.0/elasticsearch-analysis-ik-7.2.0.zip

# 解压后通过ftp上传到服务器下

# 将这个文件夹拷贝到elasticsearch中

docker cp /home/silence/elk/ik es:/usr/share/elasticsearch/plugins

# 查看是否拷贝成功,进入elasticsearch/plugins/ik中:

docker exec -it es /bin/bash

cd /usr/share/elasticsearch/plugins

ls

cd ik

ls

# 重新启动elasticsearch容器

docker restart es

五、 运行 Head 容器

docker run -d --restart=always --name es_head -p 9100:9100 mobz/elasticsearch-head:5

转载:Docker 简单部署 ElasticSearch

六、 安装 LogStash

docker pull logstash:7.2.0

docker run -d --restart=always --name logstash -p 5044:5044 -p 9600:9600 logstash:7.2.0

6.1 进入容器

docker exec -it logstash /bin/bash

6.2 修改 config 下的 logstash.yml 文件,主要修改 es 的地址(如果是本机部署,ip需填写内网ip):

vi config/logstash.yml

http.host: "0.0.0.0"

xpack.monitoring.elasticsearch.hosts: [ "http://elasticsearch的ip:端口号" ]

# 保存退出

:wq

6.3 修改 pipeline 下的 logstash.conf 文件:

vi pipeline/logstash.yml

input {

tcp {

mode => "server"

host => "0.0.0.0" # 允许任意主机发送日志

port => 5044

codec => json_lines # 数据格式

}

}

output {

elasticsearch {

hosts => ["http://elasticsearch的ip:端口号"] # ElasticSearch 的地址和端口(如果是本机部署,ip需填写内网ip)

index => "elk" # 指定索引名

codec => "json"

}

stdout {

codec => rubydebug

}

}

# 保存退出

:wq

6.4 查看日志

docker logs -f logstash

6.5 重新启动elasticsearch容器

docker restart logstash

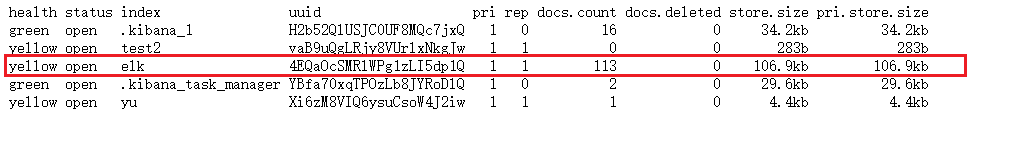

6.6 查看es是否获取数据

http://localhost:9200/_cat/indices?v

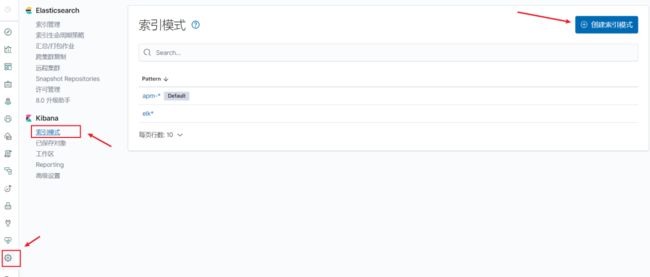

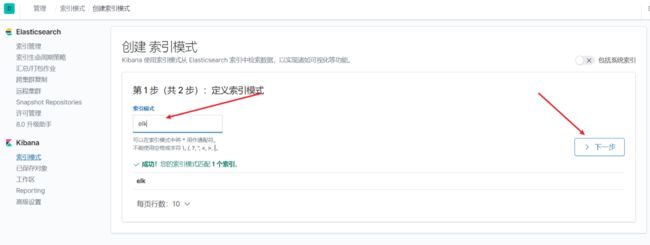

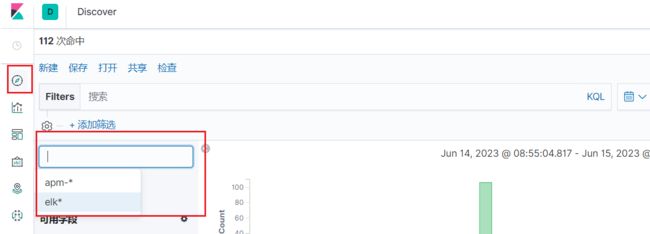

6.7 Kibana新建索引模式

转载:Docker快速搭建部署ELK实战详解

转载:Docker安装ELK详细步骤

七、Springboot通过log4j2+logstash整合日志

7.1 pom.xml文件中增加log4j2相关依赖

org.springframework.boot

spring-boot-starter-web

org.springframework.boot

spring-boot-starter-logging

org.springframework.boot

spring-boot-starter-log4j2

7.2 application-dev.yml引入log4j2.xml日志配置文件

# log4j2日志配置文件

logging:

config: classpath:config/log4j2-dev.xml

7.3 log4j2-dev.xml文件配置

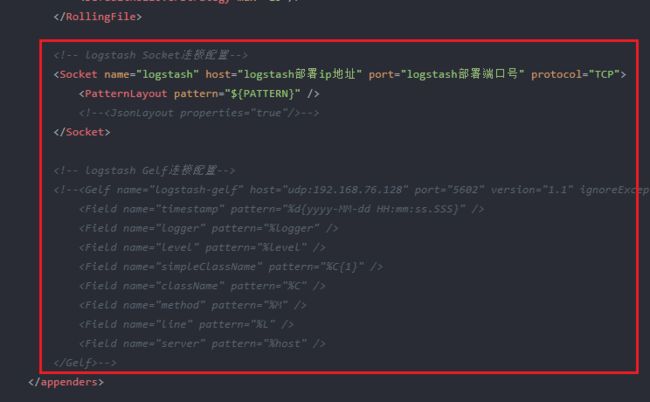

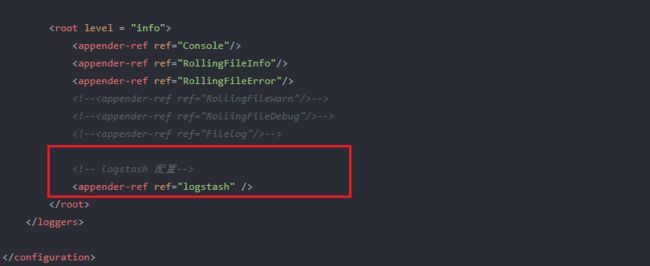

logstash两种连接方式:Socket连接/Gelf连接

{"host": "%host", "logger": "%logger", "level": "%level", "message": "[%thread] [%c:%L] --- %message"}%n

转载:springboot集成log4j2 + logstash 异步输出日志

转载:Springboot通过log4j2+logstash整合日志到Elasticsearch中

记部署过程中遇到的问题以及解决方法

- **问题1:**Kibana 在config/kibana.yaml 中修改host ,把默认的

http://elasticsearch:9200改为http://localhost:9200,启动报错,查看日志:

# docker logs 容器ID, 查看的日志信息:

2023-06-14 16:15:32 {"type":"log","@timestamp":"2023-06-14T08:15:32Z","tags":["warning","elasticsearch","admin"],"pid":1,"message":"No living connections"}

2023-06-14 16:15:32 {"type":"log","@timestamp":"2023-06-14T08:15:32Z","tags":["warning","task_manager"],"pid":1,"message":"PollError No Living connections"}

解决办法:

把kibana.yaml里面的host改为主机的真实IP(内网172网段ip)

- **问题2:**logstash 修改文件:

config/logstash.yml、pipeline/logstash.yml文件时,把elasticsearch的hosts中的IP地址改为localhost/127.0.0.1时,启动报错,查看日志:

2023-06-14 16:01:53 [2023-06-14T08:01:53,270][WARN ][logstash.outputs.elasticsearch] Attempted to resurrect connection to dead ES instance, but got an error. {:url=>"http://127.0.0.1:9200/", :error_type=>LogStash::Outputs::ElasticSearch::HttpClient::Pool::HostUnreachableError, :error=>"Elasticsearch Unreachable: [http://127.0.0.1:9200/][Manticore::SocketException] Connection refused (Connection refused)"}

解决办法:

把config/logstash.yml、pipeline/logstash.yml文件里面elasticsearch的hostsIP地址改为主机的真实IP(内网172网段ip)

filebeat未完善内容

docker pull docker.elastic.co/beats/filebeat:7.2.0

docker run -d --restart=always --name filebeat docker.elastic.co/beats/filebeat:7.2.0