ChatGPT之深度强化学习DRL理解

参考文献:Part 1: Key Concepts in RL — Spinning Up documentation

In a nutshell, RL is the study of agents and how they learn by trial and error. (RL是对agent如何试错的一个研究)It formalizes the idea that rewarding or punishing an agent for its behavior makes it more likely to repeat or forego that behavior in the future.

RL 是Reinforcement Learning的简称. DRL 是 Deep Reinforcement Learning的缩写,是深度学习和强化学习的合并体.

强化学习的研究是针对一个智能体(agent)不断试错的过程. 通过不断奖励或惩罚智能体,确保它在未来可以最大化的重复有利的行为,放弃不利的行为.

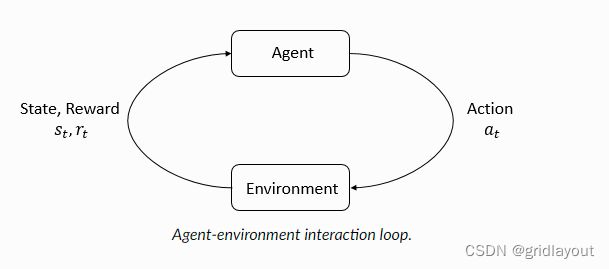

RL中两个主要角色就是 agent(智能体)和enviroment. enviroment 是agent的主要生活和交互的世界. 在每一步agent和environment的交互步骤中, agent 根据环境状态的观测数据,然后决定采取的行动action. 当action被实施, enviroment会发生变化,agent 也会随之改变.

agent 会从enviroment中获取到奖励信号,一个数字, 来告诉agent,enviroment的状态是好还是坏。 agent的目标是最大化累计奖励值,也称为收益率。 RL 方法是一种方式让agent 学习行为达到自己的目标。

主要概念:

States and Observations

state s, 是一个对environment状态的完整描述。 observation o 是对state的部分描述,有可能省略掉部分信息。

当agent 观察一个完整的全部的environment的状态时,我们说这个environment是一个完全观察环境.

当agent观察部分environment的状态时, 我们说这个environment是部分观察.

Action Spaces

不同的环境需要不同类型的行为. 对环境有效的行为的集合被称为Action Spaces. (行为空间).

根据不同的场景区分为离散行为空间集合, discrete action spaces 离散行为空间. 就是行为没有规律,不连续.

持续的行为空间,continuous action spaces. 在持续的空间中, 行为就是真实的向量. 比如机器人的移动.这个区别对DRL的算法会产生深刻重大的后果. 不同的行为空间类型,对应不同的DRL算法.

Policies 策略

policies 是agent决定行为的具体规则. policies 在尝试最大化agent的收益率.

parameterized policies 参数化策略: 策略结果是一个可计算的函数,此函数依赖一些列参数, 通过最优化的算法去改变行为.

Deterministic Policies 确定性策略:

Stochastic [stə'kæstɪk] Policies 随机策略:

深度RL中最常见的两种随机策略是分类策略和对角高斯策略。

分类策略可用于离散行为空间. 对角高斯策略用于持续行为空间.

Trajectories [trəˈdʒektəri] 轨迹,轨道,弹道.

Trajectories 是 states 和 actions在environment中的连续的一系列的序列。

Trajectories are also frequently called episodes (一集)or rollouts.

Reward and Return 奖励和收益

infinite-horizon discounted return (无限期折现收益) 无限时间窗口累计收益.

finite-horizon undiscounted return (有限期未贴现收益) 一定时间窗口的累计收益.

Value Functions 价值函数

了解状态或状态-行为对的价值是非常有用的。 通过价值函数,我们可以预测出基于某个状态或者策略行为的期望回报率。价值函数value function ,在几乎每一个RL算法中,以各种方式被使用。

有4类主要的价值函数:

1. On-Policy Value Function 如果从state s开始,并且总是根据策略π执行行为,回给出预期回报率.

2. On-Policy Action-Value Function 如果从state s开始, 执行一个任意的action a, 一直沿用策略π, 计算出的回报率.

3. Optimal Value Function 最优价值函数.

总是跟随根据最优策略,从状态s 开始,计算出期望收益率.

4. Optimal Action-Value Function. 从状态s开始, 执行一个任意的action a, 一直跟随最优策略, 然后计算出期望回报率.

The Optimal Q-Function and the Optimal Action (最优Q函数和最优行为)

Q-Function, 从状态s开始,采取一个任意的行为, 然后遵循最优策略,获取最佳回报率.

Bellman Equations 贝尔曼方程

The value of your starting point is the reward you expect to get from being there, plus the value of wherever you land next.

你出发点的价值是你期望从那里获得的回报,再加上你下一站的价值。

value funcion的贝尔曼方程和optimal value function的贝尔曼方程最大的区别是否对action执行max的处理. 反应了一个事实是, 无论agent 何时去选择它的行为,为了最优化行为,它不得不选择一个可以导致更高价值的行为.

Bellman backup 在RL描述中出频率较高的词汇。RL文献中经常出现“Bellman备份”一词。一个状态或状态-动作对的Bellman备份是Bellman方程的右手边:奖励加上下一个值。

Advantage Functions 优势函数

获取到action的相对优势.

优势函数对于策略梯度方法至关重要。

Formalism 形式主义

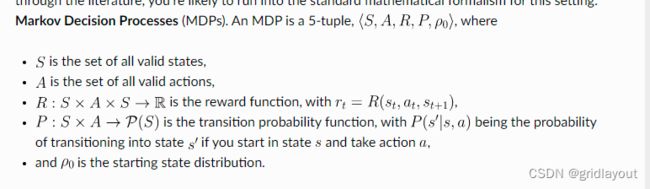

到目前为止,我们已经以非正式的方式讨论了agent的环境,但如果你试图深入研究文献,你很可能会遇到这种设置的标准数学形式:马尔可夫决策过程(MDPs)。MDP是一个5元组,\langle S、a、R、P、\rho_0\rangle,其中

S是所有有效状态的集合,

A是所有有效动作的集合,

R:是奖励函数,其中R_t=R(S_t,A_t,S_{t+1}),

P:是转移概率函数,其中P(S’|S,A)是如果您在状态S中开始并采取动作A,则转移到状态S’的概率,

Po是起始状态分布。

马尔可夫决策过程这一名称指的是系统遵循马尔可夫特性的事实:转变只取决于最近的状态和动作,而不取决于先前的历史。