自洽性改善语言模型中的思维链推理

自洽性改善语言模型中的思维链推理

- 摘要

- 介绍

- 对多样化路径的自洽

- 实验

-

- 实验设置

- 主要结果

- 当CoT影响效率时候,SC会有所帮助

- 与现有方法进行比较

- 附加研究

- 相关工作

- 总结

摘要

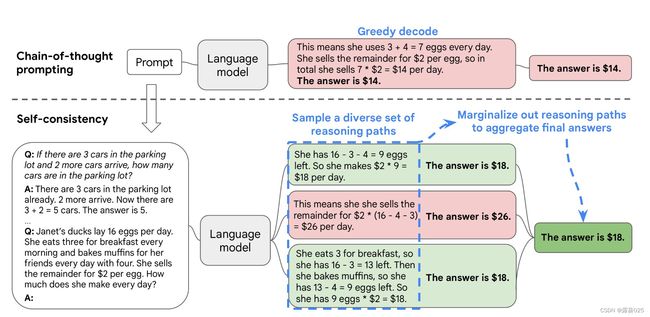

本篇论文提出了一种新的编码策略——自洽性,来替换思维链中使用的 贪婪解码(Naive greedy decoding) 。

Naive greedy decoding一种简单而直接的解码方式,常用于生成型任务。

在这种解码方法中,模型会根据当前的输入和已生成的部分输出,选择概率最高的下一个单词或符号作为预测结果。换句话说,它总是选择当前最可能的输出,而不考虑后续可能的选择。

虽然简单,但可能会导致生成的结果缺乏多样性,因为只关注当前可能的选项,而忽略了其他可能的选择。另外,他也无法处理一些复杂的语言结构或长期依赖关系,因为它没有考虑到全局的上下文信息。

该策略首先对一组不同的推理路径进行采样,然后通过 边缘化采样(marginalizing out the sampled reasoning paths) 的推理路径来选择最一致的答案。

marginalizing out the sampled reasoning paths

指的是采样推理路径时进行边际化处理的过程。

边际化处理指将多个推理路径的结果进行合并,得到最终的推理结果。这样可以避免对每个路径进行单独计算和评估,从而减少计算的复杂度。

具体而言,在采样推理路径的过程中,可以计算每个路径的概率,并将其乘以对应路径的结果,然后将所有路径的结果相加,并进行归一化,得到最终的推理结果。

Self-Consistency 利用 一个复杂的推理问题通常具有允许多种不同的思维方式,从而产生其独特的正确答案。

实践表明:自洽性提升了思维链提示在一系列流行的算数和常识推理基准上的表现。

介绍

本文介绍了一种新的解码方式——自洽性,来替换思维链中使用的Naive greedy decoding,以进一步完善大语言模型的推理能力。该策略首先对一组不同的推理路径进行采样,然后通过边缘化采样(marginalizing out the sampled reasoning paths)的推理路径来选择最一致的答案。问题越需要深思熟虑的思考和分析,找到答案的推理途径就越多样。

首先用CoT来提示语言模型,不采用CoT的Naive greedy decoding解码,而使用“Self-Consistency ”解码,过程如下:

首先,从语言模型的 解码器(decoder) 中采样,生成一组不同的推理路径,每条推理路径可能会产生不同的最终答案,因此需要通过边缘化采样的推理路径来确定最终答案,以在最终答案集中找到最一致的答案。

解码器(decoder)是语言模型的一部分,它负责根据语言模型的内部表示和当前的上下文生成输出文本。

解码器通常使用一种称为“生成算法”的方法,根据模型的输出概率分布选择最后可能的下一个词语或句子。这个过程可以通过不同的算法来实现,例如贪婪搜索等。解码器的目标是生成具有高度流畅和语义连贯性的句子。

这种方法类似于人类的经验,如在思考问题时,如果多种不同的思考法而得出了相同的答案,人们会更确信最终的答案是正确的。

自洽解码消除了困然贪婪解码的重复性和局部最优性,同时也减轻了单采样生成的不稳定性。

自洽方法比之前的方法简单得多,先前的方法要么训练额外的验证器,要么在给定额外人工注释的情况下训练(re-ranker)重新排序器以提高生成质量。

re-ranker

指对已经生成的候选列表或排序结果进行重新排序或重新打分的过程。

可以根据更多的特征或者使用更复杂的及其学习模型来重新评估和打分搜索结果,以更好满足用户需求。

相反,自洽法是一种完全无监督的,作用在现成的语言模型上,不需要额外的人工注释,避免了任何额外训练、辅助模型或微调。

自洽方法也不同于典型的集成方法(训练多个模型并聚合每个模型的输出),它的行为更像是在单个语言模型之上工作的“自集成”。

对多样化路径的自洽

人类的一个突出方面是人们思维方式的不同。人们很自然的认为,在需要深思熟虑的任务中,可能有多个方法来解决这个问题。这样一个过程可以通过语言模型解码器在语言模型中进行。

对一个数学问题来说,一个模型可以产生多种合理的反应从而都能够得到正确的答案。因为语言模型的推理并不完美,所以模型可能产生错误的推理路径或者在其中一个推理步骤中出错,但是这些解答并不太可能得到相同的答案。

所以我们假设:正确的推理过程(即使是多样的)在最终的结果中往往比不正确的过程有更大的一致性。

我们通过提出以下自洽性方法来利用这种直觉。

首先,用一组手动编写的思维链示例提示语言模型;下一步,对来自语言模型的解码器的一组候选输出进行采样,产生一套多样化的候选推理路径;最后,通过边缘化抽样推理路径和选择生成答案最一致的那个答案来聚合答案。

更具体来说:假设生成的答案ai来自固定答案集A,ai ∈A,i=1,…,m,ai即对从解码器中所采样的m个候选输出进行索引。给出一个提示和一个问题,自洽性给出了一个额外的潜在变量ri,代表在第i个输出中推理路径的记号序列,然后耦合生成(ri,ai),ri —>ai,生成的推理路径ri是可选择的,并且仅用于得到最终答案ai。

在对来自模型解码器的多路采样之后,SC通过对ai进行多票通过,对ri进行边缘化,或者我们将其定义为最终答案集中最“一致”的答案。

实验

实验设置

主要结果

当CoT影响效率时候,SC会有所帮助

与现有方法进行比较

附加研究

相关工作

总结

本文采用的思想类似于,对于一个问题,人们通过不同的思考方式得到了相同的答案,这个答案往往就是正确的。

解码器通常使用一种称为“生成算法”的方法,根据模型的输出概率分布选择最后可能的下一个词语或句子。解码器的目标是生成具有高度流畅和语义连贯性的句子。

思维链中使用了贪婪解码的方法,这种方法总是选择当前概率最大的一个单词或符号作为预测结果,它总是选择当前最可能的输出,而不考虑后续可能的选择,可能会导致生成的结果缺乏多样性。

所以我们提出了更具有多样性的方法——自洽解码。

自洽解码的步骤:假设生成的答案ai来自固定答案集A,ai ∈A,i=1,…,m,ai即对从解码器中所采样的m个候选输出进行索引。给出一个提示和一个问题,SC给了一个额外的潜在变量ri,代表在第i个输出中推理路径的记号序列,然后耦合生成(ri,ai),生成的推理路径ri是可选择的,并且仅用于得到最终答案ai,在对来自模型解码器的多路采样之后,SC通过对ai进行多票通过,对ri进行边缘化,或者我们将其定义为最终答案集中最“一致”的答案。

接着文章进行了一系列实验,介绍了实验的数据集和任务、语言模型和提示以及采样的方案。并且对算数推理、常识和符号推理分别作了对照实验,对照的是使用贪婪解码的CoT。

文章又表明,当CoT性能受损时,SC会有帮助。

又将SC与现有方法进行了比较。

自洽方法不仅在四个不同规模的大型语言模型中显著提高了一系列算数和常识推理任务的准确性。除了准确性提高了之外,自洽还能用于在使用语言模型执行推理任务时收集推理依据,以及提供不准确性评估和改进语言模型输出的校准。