树莓派下部署NCNN

树莓派下部署NCNN

安装树莓派

树莓派的烧录,网上的教程有很多,这里就不赘述了,比如该博客树莓派(4B)镜像烧录及环境配置保姆级教程

安装依赖

首先需要安装下git和cmake依赖、其他依赖。

sudo apt-get install git cmake

sudo apt-get install -y gfortran

sudo apt-get install -y libprotobuf-dev libleveldb-dev libsnappy-dev libopencv-dev libhdf5-serial-dev protobuf-compiler

sudo apt-get install --no-install-recommends libboost-all-dev

sudo apt-get install -y libgflags-dev libgoogle-glog-dev liblmdb-dev libatlas-base-dev

这里有可能下载不成功,报503的错误,那需要换apt-get的源:

选输入下面命令查看你的树莓派对应的系统版本,比如“buster”

lsb_release -a

之后执行脚本

sudo vim /etc/apt/sources.list

将里面的两行注释#,加上下面两句换成清华源

deb http://mirrors.tuna.tsinghua.edu.cn/raspbian/raspbian/ buster main contrib non-free rpi

deb-src http://mirrors.tuna.tsinghua.edu.cn/raspbian/raspbian/ buster main contrib non-free rpi

主要是这个网址换掉原来的那个网址,其他保持不变

最后更新一下

sudo apt update

有可能所有些没更新,要你用旧的,但是问题不大.

只要上面的依赖都能成功安装,那就没问题了

编译ncnn

下载ncnn源码

https://github.com/Tencent/ncnn.git

cd ncnn

编译源码,在ncnn目录下

mkdir build

cd build

cmake ../

make -j4

make install

部署resnet18

这里只要需要用到精简化后的onnx文件,可以参考我的上一篇博客在windows下使用ncnn部署加速神经网络(以resnet18为例)_TTao9的博客-CSDN博客里面会教怎么导出精简化后的onnx文件,之后跟上一篇博客一样,进入编译后的build文件夹下的\install\bin下,其实可以单独吧这个文件夹下的exe都复制到另外一个文件夹,制作成ncnn转换工具

之后打开ncnn的转换工具,具体路径在编译完的ncnn工程目录下的\install\bin下,其实可以单独吧这个文件夹下的exe都复制到另外一个文件夹,制作成ncnn转换工具。将onnx文件复制到该文件夹下,运行

./onnx2ncnn resnet18_imagenet_sim.onnx resnet18_imagenet_sim.param resnet18_imagenet_sim.bin

运行之后文件夹下会多出resnet18_imagenet_sim.param和resnet18_imagenet_sim.bin文件,之后将这两个文件放到ncnn工程下的ncnn/examples文件夹下,并且新建一个resnet18_imagenet_sim.cpp,输入以下的代码:

#include "net.h"

#include "benchmark.h"

#include 这个cpp是模仿ncnn给的示例写的,所以在example文件夹下的CMakeLists.txt还需要将这个文件链接到cmake中,添加这一行就行

进入到ncnn下的build文件夹,在终端输入

cmake -DCMAKE_BUILD_TYPE=Release -DNCNN_VULKAN=OFF -DNCNN_BUILD_EXAMPLES=ON ..

make -j4

这里的DNCNN_VULKAN是关闭vulkan,因为树莓派的vulkan驱动不稳定,不一定的用上加速,DNCNN_BUILD_EXAMPLES是对例子进行编译,默认是OFF,make -j4是编译的进程,可以按照自己的树莓派配置来修改大小

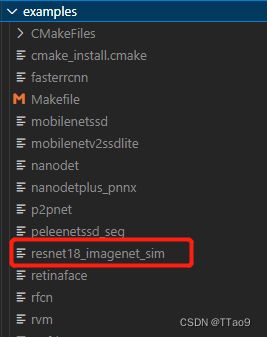

编译后会在ncnn/build_example/examples下生成resnet18_imagenet_sim可执行文件,

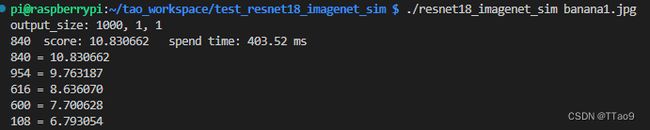

将这个可执行文件连同上面的resnet18_imagenet_sim.param和resnet18_imagenet_sim.bin文件和待测试的图片,复制到同一个文件夹,

终端出现

就是成功了。