深度学习算法训练和部署流程介绍--让初学者一篇文章理解算法训练和部署流程

目录

1 什么是深度学习算法

2 算法训练

2.1 训练的原理

2.2 名词解释

3 算法C++部署

3.1 嵌入式终端板子部署

3.3.1 tpu npu推理

3.3.2 cpu推理

3.2 服务器部署

3.2.1 智能推理

3.2.2 CPU推理

1 什么是深度学习算法

这里不去写复杂的概念,也不讲人工智能、机器学习、深度学习的关系,就用通俗的话说一下现在常用的分类和检测这种深度学习算法是怎么一回事,现在常用的分类和检测算法其实就用的卷积神经网络,神经网络的原理可以看这篇文章,我当初就是看了这篇文章:CNN笔记:通俗理解卷积神经网络_cnn卷积神经网络_v_JULY_v的博客-CSDN博客

其实我的理解深度学习算法就和教小孩认字一样,一个孩子你老是给他写1 2 3 4 5,然后跟他说这是1,这是2,这样孩子就学会1 2 3 4 5了,同样,比如一个猫狗分类的算法网络模型,你不断的用猫和狗的图片数据去训练,然后算法模型也就知道什么是猫,什么是狗了,这是简单理解。

分类算法:什么是分类算法,分类就是你只需要知道图片里面的是啥就行了,比如猫狗分类算法,那么给你一张图片,能够知道这张图片里面是猫还是狗就行了。

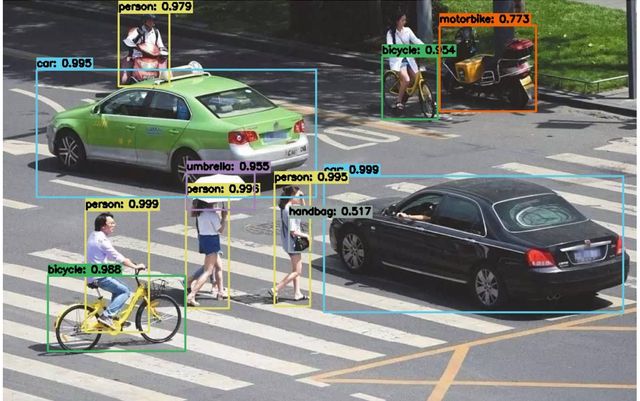

检测算法:检测算法是给你一张图片,你不仅需要知道这张图片的物体是什么,你还需要知道物体在图片中的坐标是多少,比如下面的图片,你不仅需要检测出来哪个是车,你还需要知道这个车的矩形检测框的坐标。

然后初学者想知道深度学习的流程,其实流程可以分为

- 算法训练

- 算法部署

2 算法训练

算法训练就是用图片数据和深度学习框架在有显卡的服务器上进行训练,得到算法模型。下面解释下这句话。

2.1 训练的原理

这里也用通俗易懂的语言解释,不整学术名词,其实我们的算法模型不就是神经网络吗,那神经网络里面含有很多神经元,其实一个神经元就是一个方程

那么我们的算法模型是由很多个神经元组成的,一个神经元是一个方程,那其实我们的算法模型就是一个方程组,我们训练的过程其实就是用图片数据去求方程组的系数,求出系数后,你给模型一张图片,模型方程组根据系数就能算出来模型输出也就是图片推理结果,比如一张图片,带入到方程组中,计算发现,奥,这张图片是猫。

2.2 名词解释

图片数据:如果想让算法准确率高,那么要包含足够丰富的图片数据,还是拿前面小孩学1 2 3 4 5举例子,如果你平时教小孩每次写1 2 3 4 5都是用正楷,哪天你写的歪一点潦草一点孩子就不认识了,那算法训练的时候比如猫狗分类,那要包含各种场景,比如猫狗正面的图片,侧面的图片,白天拍的图片,晚上拍的图片,这个如果是在公司里面会有专门的数据人员,负责图片的采集工作,然后如果采集不到数据集,那么你可以自己用python去网上自己下载一些图片用作训练。比如这个python脚本:利用python批量下载百度图片_陈 洪 伟的博客-CSDN博客

图片标注:采集了图片之后要对图片进行标注,这样算法训练的时候,算法才知道这个图片是什么,一般分类算法不需要标注,比如猫狗分类,你只需要把猫的图片单独放到一个文件夹,狗的图片单独放到一个文件夹,然后就可以训练,但是检测算法,需要进行图片标注,标注的时候每张图片会对应从产生一个txt或者xml文件,里面包含这张图片中的类别和位置坐标,比如一个检测行人、机动车的算法,那么一个标注文件里面会用来说明这张图里面是人还是车,还有就是人或者车在图片中的位置坐标。

深度学习框架:这个有pytorch,TensorFlow,paddle,caffe,darknet等这些框架,训练的时候需要用这些框架去训练,首先要在电脑上安装相应框架需要的环境,然后才能去训练。

显卡:我们训练要在有显卡的服务器上进行训练,至于显卡的性能要求,那当然是性能越高越好,这样训练算法越快,那么没有显卡行不行,也行,那就是用CPU训练,但是很慢。当然还有一个选择,那就是现在网上出现了一些出租算力的,可以花钱租用算力用于训练自己的算法。

python:算法训练都是用python脚本去做的,所以需要先学习python,但是初学者如果你想快速入门你不用再从零学python,因为python语法很简单,初学者基本上也是修改python脚本,甚至不用自己写脚本,所以这时候先不学也行,会修改脚本,后面有时间再学。

其实初学者想更快的入门,那直接找一个算法训练的步骤文章,然后一步步的跟着跑一遍,也就更容易理解了,可以去github上搜yolov5然后跟着步骤做一遍,也可以看我的文章:https://cumtchw.blog.csdn.net/article/details/115064641

3 算法C++部署

前面我们得到了算法模型,那么我们要把模型部署到机器上,然后用他来做推理,完成工作,工程部署一般都是用C++做部署,那么部署分为服务器部署和嵌入式终端板子部署。

3.1 嵌入式终端板子部署

3.3.1 tpu npu推理

嵌入式板子有很多厂家,比如瑞芯微的,比特大陆的(BM1684),寒武纪的(思元220),华为的(HISI3559,Atlas系列),英伟达的(xavier),那么我们首先要把我们前面训练得到的模型转换成不同厂家的模型,这时候,每个厂家都会提供相应的转换工具或转换脚本,把我们的训练模型转成不同厂家格式的模型,然后再利用不同厂家提供的推理demo完成算法模型的C++推理。

比如我们以瑞芯微的为例吧,我们训练得到了算法模型,然后我们先在电脑上安装瑞芯微的模型转换工具toolkit,然后用python脚本把我们的模型转成xxxx.rnkk格式的模型,然后厂家还会提供C++demo,然后再用C++demo完成模型的推理。其他的比特大陆/寒武纪/华为/英伟达都一个道理,只不过转换和推理的工具包不一样。

例如瑞芯微的推理部署:https://blog.csdn.net/u013171226/category_11410227.html

例如英伟达xavier的推理:https://cumtchw.blog.csdn.net/article/details/118788059

3.3.2 cpu推理

其实上面说的tpu npu情况是说我们用了现在的一些智能芯片,这些芯片内部都有专门的做深度学习推理的npu/tpu,那么如果是我们一块普通的ARM板子能跑深度学习算法吗,也是可以的,那就是用cpu推理,只不过慢而已,cpu推理的流程就和上面不一样了,这时候我们需要利用onnx/mnn/ncnn框架,我们先把训练得到的算法模型转换成onnx/mnn/ncnn模型,然后利用onnx库区做推理。例如:https://cumtchw.blog.csdn.net/article/details/128249155

又或者在一个普通的安卓手机上,你可以用ncnn框架去部署有关算法。

3.2 服务器部署

3.2.1 智能推理

这里说的智能推理我是指,我们的服务器安装了相应的智能卡,这时候服务器部署的流程就和上面板子的tpu npu推理流程一样,比如你服务器上安装了英伟达的显卡,那么我们一般就用tensorRT(TensorRT 是由英伟达公司推出的一款用于高性能深度学习模型推理的软件开发工具包)做推理,这时候我们先把训练得到的模型转成TensorRT要求的模型格式,然后再用tensorRT做算法推理。其他厂家的比如比特大陆和寒武纪还有华为,他们也有针对服务器的板卡,把它插到服务器上,然后这些厂家也会提供一些推理的工具包,然后就可以做算法的推理部署。

3.2.2 CPU推理

同样的道理,我们就一个普通电脑,没有显卡,那么这时候我们想做算法推理怎么弄,可以用onnx,也是把模型转成onnx模型,然后利用onnx库做推理。例如:https://cumtchw.blog.csdn.net/article/details/128220318

以上介绍的东西基本都能在我的博客文章里面找到具体的介绍或操作步骤。