【python】async异步编程

1.协程

协程不是计算机提供的(计算机提供线程和进程),是程序员人为创造的。

协程(Coroutine),也可以被称为微线程,是一种用户态内的上下文切换技术,简而言之,就是通过一个线程实现代码块相互切换执行。例如:

def func1():

print(1)

...

print(2)

def func2():

print(3)

...

print(4)

func1()

func2()

一般思路先执行func1,再执行func2

协程会让两个函数来回切换

实现协程方法:

- greenlet 早期模块

- yield关键字

- asyncio装饰器(python3.4引入)

- async、await关键字(python3.5)【推荐】

1.1 greenlet实现协程

pip install greenlet

from greenlet import greenlet

def func1():

print(1) # 第2步:输出1

gr2.switch() # 第3步:切换到func2函数

print(2) # 第6步:输出2

gr2.switch() # 第7步:切换到func2函数,从上一次执行的位置继续向后执行

def func2():

print(3) # 第4步:输出3

gr1.switch() # 第5步:切换到func1函数,从上一次执行的位置继续向后执行

print(4) # 第8步:输出4

gr1 = greenlet(func1)

gr2 = greenlet(func2)

gr1.switch # 第1步:去执行func1函数

1.2 yield关键字

def func1():

yield 1

yield from func2()

yield 2

def func2():

yield 3

yield 4

f1 = func1()

for item in f1:

print(item)

1.3 asyncio模块

python3.4及之后版本

import asyncio

@asyncio.coroutine # 加上装饰器可以理解为普通函数成为协程函数

def func1():

print(1)

yield from asyncio.sleep(2) # 遇到IO耗时操作,自动切换到tasks中的其他任务

print(2)

@asyncio.coroutine

def func2():

print(3)

yield from asyncio.sleep(2) # 遇到IO耗时操作,自动切换到tasks中的其他任务

print(4)

# 协程函数不能直接func1()执行,通过以下方式执行

# loop = asyncio.get_event_loop()

# loop.run_until_complete(func1())

tasks = [

asyncio.ensure_future(func1()),

asyncio.ensure_future(func2())

]

loop = asyncio.get_event_loop()

loop.run_until_complete(asyncio.wait(tasks))

1.4 async&await关键字

python3.5及之后版本

import asyncio

async def func1(): # async关键字替换修饰器

print(1)

await asyncio.sleep(2) # await关键字替换yield from

print(2)

async def func2():

print(3)

await asyncio.sleep(2) # 遇到IO耗时操作,自动切换到tasks中的其他任务

print(4)

tasks = [

asyncio.ensure_future(func1()),

asyncio.ensure_future(func2())

]

loop = asyncio.get_event_loop()

loop.run_until_complete(asyncio.wait(tasks))

2. 协程意义

在一个线程中如果遇到IO等待时间,线程不会一直等待,利用空闲时间做其他事情。

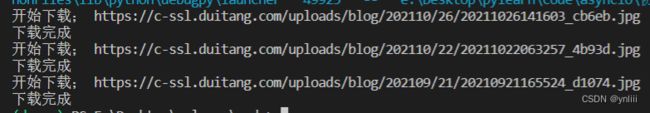

案例:下载三张图片(网络IO)

- 普通方式 (同步)

""" pip install requests """

import requests

def download_image(url):

print("开始下载:",url)

# 发送网络请求,下载图片

response = requests.get(url)

print("下载完成")

# 图片保存到本地文件

file_name = url.rsplit('_')[-1]

with open(file_name, mode='wb') as file_object:

file_object.write(response.content)

if __name__ == '__main__':

url_list = [

'https://c-ssl.duitang.com/uploads/blog/202110/26/20211026141603_cb6eb.jpg',

'https://c-ssl.duitang.com/uploads/blog/202110/22/20211022063257_4b93d.jpg',

'https://c-ssl.duitang.com/uploads/blog/202109/21/20210921165524_d1074.jpg'

]

for item in url_list:

download_image(item)

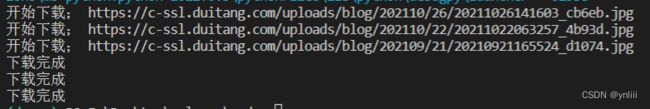

- 协程方式(异步)

"""

下载图片使用第三方模块aiohttp,请提前安装:pip install aiohttp

"""

#!/usr/bin/env python

# -*- coding:utf-8 -*-

import aiohttp

import asyncio

async def fetch(session, url):

print("开始下载:", url)

async with session.get(url, verify_ssl=False) as response:

content = await response.content.read()

file_name = url.rsplit('_')[-1]

with open(file_name, mode='wb') as file_object:

file_object.write(content)

print('下载完成')

async def main():

async with aiohttp.ClientSession() as session:

url_list = [

'https://c-ssl.duitang.com/uploads/blog/202110/26/20211026141603_cb6eb.jpg',

'https://c-ssl.duitang.com/uploads/blog/202110/22/20211022063257_4b93d.jpg',

'https://c-ssl.duitang.com/uploads/blog/202109/21/20210921165524_d1074.jpg'

]

tasks = [asyncio.create_task(fetch(session, url)) for url in url_list]

await asyncio.wait(tasks)

if __name__ == '__main__':

asyncio.run(main())

3. 异步编程

3.1 事件循环

可以理解成为一个死循环,去检测执行某些代码

# 伪代码

任务列表 = [ 任务1, 任务2, 任务3,... ]

while True:

可执行的任务列表,已完成的任务列表 = 去任务列表中检查所有的任务,将'可执行'和'已完成'的任务返回

for 就绪任务 in 已准备就绪的任务列表:

执行已就绪的任务

for 已完成的任务 in 已完成的任务列表:

在任务列表中移除 已完成的任务

如果 任务列表 中的任务都已完成,则终止循环

import asyncio

# 生成或获取一个事件循环

loop = asyncio.get_event_loop()

# 将任务放到任务列表

loop.run_until_complete(任务)

3.2 快速上手

协程函数:定义形式为 async def 的函数

协程对象:调用 协程函数 返回的对象

# 定义一个协程函数

async def func():

pass

# 调用协程函数,返回一个协程对象(result)

result = func() # 创建一个协程对象,内部代码不会执行

运行协程函数内部代码必须将协程对象交给事件循环处理

import asyncio

async def func():

print("协程内部代码")

# 调用协程函数,返回一个协程对象。

result = func()

# 方式一

# loop = asyncio.get_event_loop() # 创建一个事件循环

# loop.run_until_complete(result) # 将协程当做任务提交到事件循环的任务列表中,协程执行完成之后终止。

# 方式二

# 本质上方式一是一样的,内部先 创建事件循环 然后执行 run_until_complete,一个简便的写法。

# asyncio.run 函数在 Python 3.7 中加入 asyncio 模块,

asyncio.run(result)

3.3 await关键字

await + 可等待的对象(协程对象、Future、Task对象 -> IO等待)

示例一:

import asyncio

async def func():

print("执行协程函数内部代码")

# 遇到IO操作挂起当前协程(任务),等IO操作完成之后再继续往下执行。

# 当前协程挂起时,事件循环可以去执行其他协程(任务)。

response = await asyncio.sleep(2)

print("IO请求结束,结果为:", response)

result = func()

asyncio.run(result)

示例二:

import asyncio

async def others():

print("start")

await asyncio.sleep(2)

print('end')

return '返回值'

async def func():

print("执行协程函数内部代码")

# 遇到IO操作挂起当前协程(任务),等IO操作完成之后再继续往下执行。当前协程挂起时,事件循环可以去执行其他协程(任务)。

response = await others()

print("IO请求结束,结果为:", response)

asyncio.run( func() )

示例三:

import asyncio

async def others():

print("start")

await asyncio.sleep(2)

print('end')

return '返回值'

async def func():

print("执行协程函数内部代码")

# 遇到IO操作挂起当前协程(任务),等IO操作完成之后再继续往下执行。当前协程挂起时,事件循环可以去执行其他协程(任务)。

response1 = await others()

print("IO请求结束,结果为:", response1)

response2 = await others()

print("IO请求结束,结果为:", response2)

asyncio.run( func() )

await 等待对象的值返回后再继续执行

3.4 Task对象

Tasks are used to schedule coroutines concurrently.

When a coroutine is wrapped into a Task with functions like

asyncio.create_task()the coroutine is automatically scheduled to run soon。

在事件循环中添加多个任务

Tasks用于并发调度协程,通过

asyncio.create_task(协程对象)的方式创建Task对象,这样可以让协程加入事件循环中等待被调度执行。除了使用asyncio.create_task()函数以外,还可以用低层级的loop.create_task()或ensure_future()函数。不建议手动实例化 Task 对象。

注意:asyncio.create_task() 函数在 Python 3.7 中被加入。在 Python 3.7 之前,可以改用低层级的 asyncio.ensure_future() 函数。

示例一:

import asyncio

async def func():

print(1)

await asyncio.sleep(2)

print(2)

return "返回值"

async def main():

print("main开始")

# 创建协程,将协程封装到一个Task对象中并立即添加到事件循环的任务列表中,等待事件循环去执行(默认是就绪状态)。

task1 = asyncio.create_task(func())

# 创建协程,将协程封装到一个Task对象中并立即添加到事件循环的任务列表中,等待事件循环去执行(默认是就绪状态)。

task2 = asyncio.create_task(func())

print("main结束")

# 当执行某协程遇到IO操作时,会自动化切换执行其他任务。

# 此处的await是等待相对应的协程全都执行完毕并获取结果

ret1 = await task1

ret2 = await task2

print(ret1, ret2)

asyncio.run(main())

示例二:

import asyncio

async def func():

print(1)

await asyncio.sleep(2)

print(2)

return "返回值"

async def main():

print("main开始")

# 创建协程,将协程封装到Task对象中并添加到事件循环的任务列表中,等待事件循环去执行(默认是就绪状态)。

# 再调用

task_list = [

asyncio.create_task(func(), name="n1"),

asyncio.create_task(func(), name="n2")

]

print("main结束")

# 当执行某协程遇到IO操作时,会自动化切换执行其他任务。

# 此处的await是等待所有协程执行完毕,并将所有协程的返回值保存到done

# 如果设置了timeout值,则意味着此处最多等待的秒,完成的协程返回值写入到done中,未完成则写到pending中。

done, pending = await asyncio.wait(task_list, timeout=None)

print(done, pending)

asyncio.run(main())

示例三:

import asyncio

async def func():

print("执行协程函数内部代码")

# 遇到IO操作挂起当前协程(任务),等IO操作完成之后再继续往下执行。当前协程挂起时,事件循环可以去执行其他协程(任务)。

response = await asyncio.sleep(2)

print("IO请求结束,结果为:", response)

coroutine_list = [func(), func()]

# 错误:coroutine_list = [ asyncio.create_task(func()), asyncio.create_task(func()) ]

# 此处不能直接 asyncio.create_task,因为将Task立即加入到事件循环的任务列表,

# 但此时事件循环还未创建,所以会报错。

# 使用asyncio.wait将列表封装为一个协程,并调用asyncio.run实现执行两个协程

# asyncio.wait内部会对列表中的每个协程执行ensure_future,封装为Task对象。

done,pending = asyncio.run( asyncio.wait(coroutine_list) )

3.5 asyncio.Future对象

A

Futureisa special low-level awaitable object that represents an

eventual result of an asynchronous operation.

Task继承Future,Task对象内部await结果的处理基于Future对象

示例一:

async def main():

# 获取当前事件循环

loop = asyncio.get_running_loop()

# # 创建一个任务(Future对象),这个任务什么都不干。

fut = loop.create_future()

# 等待任务最终结果(Future对象),没有结果则会一直等下去。

await fut

asyncio.run(main())

示例二:

import asyncio

async def set_after(fut):

await asyncio.sleep(2)

fut.set_result("666")

async def main():

# 获取当前事件循环

loop = asyncio.get_running_loop()

# 创建一个任务(Future对象),没绑定任何行为,则这个任务永远不知道什么时候结束。

fut = loop.create_future()

# 创建一个任务(Task对象),绑定了set_after函数,函数内部在2s之后,会给fut赋值。

# 即手动设置future任务的最终结果,那么fut就可以结束了。

await loop.create_task(set_after(fut))

# 等待 Future对象获取 最终结果,否则一直等下去

data = await fut

print(data)

asyncio.run(main())

Future对象本身函数进行绑定,所以想要让事件循环获取Future的结果,则需要手动设置。而Task对象继承了Future对象,其实就对Future进行扩展,他可以实现在对应绑定的函数执行完成之后,自动执行set_result,从而实现自动结束。

虽然,平时使用的是Task对象,但对于结果的处理本质是基于Future对象来实现的。

扩展:支持 await 对象语法的对象课成为可等待对象,所以 协程对象、Task对象、Future对象都可以被成为可等待对象。

扩充: futures.Future对象

concurrent.futures模块中的Future对象,和上面的Future对象没有关系(后面会结合)。

使用线程池、进程池实现异步操作时用到的对象。

import time

from concurrent.futures import Future

from concurrent.futures.thread import ThreadPoolExecutor

from concurrent.futures.process import ProcessPoolExecutor

def func(value):

time.sleep(1)

print(value)

# return 123

# 创建线程池

pool = ThreadPoolExecutor(max_workers=5)

# 创建进程池

# pool = ProcessPoolExecutor(max_workers=5)

for i in range(10):

fut = pool.submit(func, i)

print(fut)

以后可能会交叉使用(一部分协程一部分进程池/线程池)。例如:crm项目80%是基于协程异步编程+MySQL(不支持协程)【线程/进程做异步编程】

一般在程序开发中我们要么统一使用 asycio 的协程实现异步操作、要么都使用进程池和线程池实现异步操作。但如果 协程的异步和 进程池/线程池的异步 混搭时,那么就会用到此功能了。

import time

import asyncio

import concurrent.futures

def func1():

# 某个耗时操作

time.sleep(2)

return "SC"

async def main():

loop = asyncio.get_running_loop()

# 1. Run in the default loop's executor ( 默认ThreadPoolExecutor )

# 第一步:内部会先调用 ThreadPoolExecutor 的 submit 方法去线程池中申请一个线程去执行func1函数,并返回一个concurrent.futures.Future对象

# 第二步:调用asyncio.wrap_future将concurrent.futures.Future对象包装为asycio.Future对象。

# 因为concurrent.futures.Future对象不支持await语法,所以需要包装为 asycio.Future对象 才能使用。

fut = loop.run_in_executor(None, func1)

result = await fut

print('default thread pool', result)

# 2. Run in a custom thread pool:

# with concurrent.futures.ThreadPoolExecutor() as pool:

# result = await loop.run_in_executor(

# pool, func1)

# print('custom thread pool', result)

# 3. Run in a custom process pool:

# with concurrent.futures.ProcessPoolExecutor() as pool:

# result = await loop.run_in_executor(

# pool, func1)

# print('custom process pool', result)

asyncio.run(main())

案例:asyncio+不支持异步的模块

import asyncio

import requests

async def download_image(url):

# 发送网络请求,下载图片(遇到网络下载图片的IO请求,自动化切换到其他任务)

print("开始下载:", url)

loop = asyncio.get_event_loop()

# requests模块默认不支持异步操作,所以就使用线程池来配合实现了。

future = loop.run_in_executor(None, requests.get, url)

response = await future

print('下载完成')

# 图片保存到本地文件

file_name = url.rsplit('_')[-1]

with open(file_name, mode='wb') as file_object:

file_object.write(response.content)

if __name__ == '__main__':

url_list = [

'https://c-ssl.duitang.com/uploads/blog/202110/26/20211026141603_cb6eb.jpg',

'https://c-ssl.duitang.com/uploads/blog/202110/22/20211022063257_4b93d.jpg',

'https://c-ssl.duitang.com/uploads/blog/202109/21/20210921165524_d1074.jpg'

]

tasks = [download_image(url) for url in url_list]

loop = asyncio.get_event_loop()

loop.run_until_complete( asyncio.wait(tasks) )

3.6 异步迭代器

什么是异步迭代器?

实现了

__aiter__()和__anext__()方法的对象。__anext__必须返回一个awaitable对象。async for会处理异步迭代器的__anext__()方法所返回的可等待对象,直到其引发一个StopAsyncIteration异常。由PEP 492引入。什么是异步可迭代对象?

可在

async for语句中被使用的对象。必须通过它的__aiter__()方法返回一个asynchronous iterator。由PEP 492引入。

import asyncio

class Reader(object):

""" 自定义异步迭代器(同时也是异步可迭代对象) """

def __init__(self):

self.count = 0

async def readline(self):

# await asyncio.sleep(1)

self.count += 1

if self.count == 100:

return None

return self.count

def __aiter__(self):

return self

async def __anext__(self):

val = await self.readline()

if val == None:

raise StopAsyncIteration

return val

async def func():

# 创建异步可迭代对象

async_iter = Reader()

# async for 必须要放在async def函数内,否则语法错误。

async for item in async_iter:

print(item)

asyncio.run(func())

3.7 异步上下文管理器

此种对象通过定义

__aenter__()和__aexit__()方法来对async with语句中的环境进行控制。由PEP 492引入。

import asyncio

class AsyncContextManager:

def __init__(self):

self.conn = conn

async def do_something(self):

# 异步操作数据库

return 666

async def __aenter__(self):

# 异步链接数据库

self.conn = await asyncio.sleep(1)

return self

async def __aexit__(self, exc_type, exc, tb):

# 异步关闭数据库链接

await asyncio.sleep(1)

async def func():

async with AsyncContextManager() as f:

result = await f.do_something()

print(result)

asyncio.run(func())

4. uvloop

是asyncio事件循环的替代方案。事件循环效率 > 默认asyncio事件循环效率。

pip install uvloop

在项目中想要使用uvloop替换asyncio的事件循环也非常简单,只要在代码前添加以下代码:

import asyncio

import uvloop

asyncio.set_event_loop_policy(uvloop.EventLoopPolicy())

# 编写asyncio的代码,与之前写的代码一致。

# 内部的事件循环自动化会变为uvloop

asyncio.run(...)

5. 实战案例

5.1 异步redis

当通过python去操作redis时,链接、设置值、获取值 这些都涉及网络IO请求,使用asycio异步的方式可以在IO等待时去做一些其他任务,从而提升性能。

安装Python异步操作redis模块

pip install aioredis

示例一:异步操作redis

#!/usr/bin/env python

# -*- coding:utf-8 -*-

import asyncio

import aioredis

async def execute(address, password):

print("开始执行", address)

# 网络IO操作:创建redis连接

redis = await aioredis.create_redis(address, password=password)

# 网络IO操作:在redis中设置哈希值car,内部在设三个键值对,即: redis = { car:{key1:1,key2:2,key3:3}}

await redis.hmset_dict('car', key1=1, key2=2, key3=3)

# 网络IO操作:去redis中获取值

result = await redis.hgetall('car', encoding='utf-8')

print(result)

redis.close()

# 网络IO操作:关闭redis连接

await redis.wait_closed()

print("结束", address)

asyncio.run(execute('redis://47.93.4.198:6379', "root12345"))

示例二:连接多个redis做操作(遇到IO会切换其他任务,提供了性能)

import asyncio

import aioredis

async def execute(address, password):

print("开始执行", address)

# 网络IO操作:先去连接 47.93.4.197:6379,遇到IO则自动切换任务,去连接47.93.4.198:6379

redis = await aioredis.create_redis_pool(address, password=password)

# 网络IO操作:遇到IO会自动切换任务

await redis.hmset_dict('car', key1=1, key2=2, key3=3)

# 网络IO操作:遇到IO会自动切换任务

result = await redis.hgetall('car', encoding='utf-8')

print(result)

redis.close()

# 网络IO操作:遇到IO会自动切换任务

await redis.wait_closed()

print("结束", address)

task_list = [

execute('redis://47.93.4.197:6379', "root12345"),

execute('redis://47.93.4.198:6379', "root12345")

]

asyncio.run(asyncio.wait(task_list))

5.2 异步MySQL

当通过python去操作MySQL时,连接、执行SQL、关闭都涉及网络IO请求,使用asycio异步的方式可以在IO等待时去做一些其他任务,从而提升性能。

安装Python异步操作redis模块

pip install aiomysql

示例一:

import asyncio

import aiomysql

async def execute():

# 网络IO操作:连接MySQL

conn = await aiomysql.connect(host='127.0.0.1', port=3306, user='root', password='root', db='mysql', )

# 网络IO操作:创建CURSOR

cur = await conn.cursor()

# 网络IO操作:执行SQL

await cur.execute("SELECT Host,User FROM user")

# 网络IO操作:获取SQL结果

result = await cur.fetchall()

print(result)

# 网络IO操作:关闭链接

await cur.close()

conn.close()

asyncio.run(execute())

示例二:

#!/usr/bin/env python

# -*- coding:utf-8 -*-

import asyncio

import aiomysql

async def execute(host, password):

print("开始", host)

# 网络IO操作:先去连接 47.93.40.197,遇到IO则自动切换任务,去连接47.93.40.198:6379

conn = await aiomysql.connect(host=host, port=3306, user='root', password=password, db='mysql')

# 网络IO操作:遇到IO会自动切换任务

cur = await conn.cursor()

# 网络IO操作:遇到IO会自动切换任务

await cur.execute("SELECT Host,User FROM user")

# 网络IO操作:遇到IO会自动切换任务

result = await cur.fetchall()

print(result)

# 网络IO操作:遇到IO会自动切换任务

await cur.close()

conn.close()

print("结束", host)

task_list = [

execute('47.93.40.197', "root"),

execute('47.93.41.197', "root")

]

asyncio.run(asyncio.wait(task_list))

5.3 FastAPI框架

FastAPI是一款用于构建API的高性能web框架,框架基于Python3.6+的 type hints搭建。

接下里的异步示例以FastAPI和uvicorn来讲解(uvicorn是一个支持异步的asgi)。

安装FastAPI web 框架:

pip install fastapi

安装uvicorn,本质上为web提供socket server的支持的asgi(一般支持异步称asgi、不支持异步称wsgi):

pip install uvicorn

示例:

#!/usr/bin/env python

# -*- coding:utf-8 -*-

import asyncio

import uvicorn

import aioredis

from aioredis import Redis

from fastapi import FastAPI

app = FastAPI()

# 创建redis连接池

REDIS_POOL = aioredis.ConnectionsPool('redis://47.193.14.198:6379', password="root123", minsize=1, maxsize=10)

@app.get("/")

def index():

""" 普通操作接口 """

return {"message": "Hello World"}

@app.get("/red")

async def red():

""" 异步操作接口 """

print("请求来了")

await asyncio.sleep(3)

# 连接池获取一个连接

conn = await REDIS_POOL.acquire()

redis = Redis(conn)

# 设置值

await redis.hmset_dict('car', key1=1, key2=2, key3=3)

# 读取值

result = await redis.hgetall('car', encoding='utf-8')

print(result)

# 连接归还连接池

REDIS_POOL.release(conn)

return result

if __name__ == '__main__':

uvicorn.run("luffy:app", host="127.0.0.1", port=5000, log_level="info")

5.4 爬虫

在编写爬虫应用时,需要通过网络IO去请求目标数据,这种情况适合使用异步编程来提升性能,接下来我们使用支持异步编程的aiohttp模块来实现。

安装aiohttp模块

pip install aiohttp

示例:

import aiohttp

import asyncio

async def fetch(session, url):

print("发送请求:", url)

async with session.get(url, verify_ssl=False) as response:

text = await response.text()

print("得到结果:", url, len(text))

async def main():

async with aiohttp.ClientSession() as session:

url_list = [

'https://python.org',

'https://www.baidu.com ',

'https://www.pythonav.com'

]

tasks = [asyncio.create_task(fetch(session, url)) for url in url_list]

await asyncio.wait(tasks)

if __name__ == '__main__':

asyncio.run(main())

总结

意义:通过一个线程,利用其IO等待时间做其他事。