论文笔记|AAAI2023:ESPT: A Self-Supervised Episodic Spatial Pretext Task for Improving Few-Shot Learning

这篇论文的题目是 ESPT: A Self-Supervised Episodic Spatial Pretext Task for Improving Few-Shot Learning,提出了用于改善小样本学习的自监督episodic 空间代理任务

论文接收:AAAI2023

论文地址:https://arxiv.org/abs/2304.13287

代码地址:https://github.com/Whut-YiRong/ESPT

1 Motivation

1.在FSL的episode训练过程中,目前自监督方法无法捕捉和充分利用图像样本中的局部视觉信息和整个episode的数据结构信息。

2.大多数 SSL pretext 任务都是基于全局图像嵌入构建的,往往会忽略包含更丰富和更可迁移的低级视觉信息的局部空间图像特征

3.现有的 SSL 方法通常单独处理每个输入样本,无法充分利用 few-shot episode 中多个图像样本的相互关系,这将导致整个 episode 的数据结构信息丢失

2 Idea

提出了一种用于小样本图像分类的新型自监督Episodic Spatial Pretext Task(ESPT),其中监督信息来自在每个episode中多个图像样本的局部空间特征之间的关系。

1.利用局部特征以及从每个episode中多个图像的局部空间关系寻找自监督信号来获得与episode相关的信息,也就说与任务相关的信息

2.提出双分支网络,以提取原始episode和变换后episode中图像的局部特征

3.Episodic 空间代理任务,以建立支持图像和查询图像之间的局部空间关系。

3 Related works

3.1 小样本学习

基于度量学习的方法,将输入样本投影到一个判别嵌入空间,然后计算它们与待分类类别的距离。

基于优化的方法,通常元学习一个优化器或一个模型,可以快速适应看不见的新类。

基于生成的方法,旨在通过数据生成和扩充来增加训练样本的数量。

3.2 自监督增强的FSL

目前很多代理任务不是专门为小样本分类问题设计的,因此在 FSL 模型的episodic训练过程中,它们可能无法捕获和利用特定episode的信息。

ESPT 方法从每一个episode中多个图像之间的局部空间关系中寻找自监督信号。它可以捕获和利用图像样本的低级视觉特征和整个事件的数据结构信息,以学习更具泛化性的特征表示。

4 Method

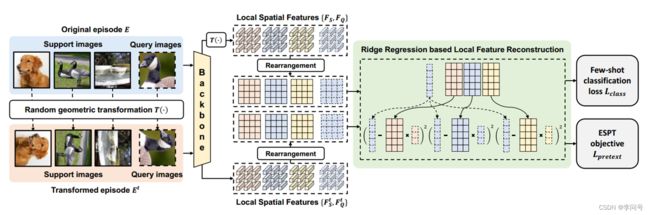

给定一个输入episode E,我们首先使用随机几何变换 T(·) 从中生成一个变换片段 E t E_t Et;

然后我们将这两个episodes中的图像样本输入到一个双分支网络中,以提取它们的局部空间特征;

这两个分支共享相同的特征提取器 f θ f_\theta fθ

在本文提出的Episodic 空间代理任务中,使用支持样本的空间特征来重建查询图像的局部特征向量,通过脊回归来实现的,从而在每一个episode中建立支持图像和查询图像之间的局部空间关系。

具体来说,对于每个类 c ∈ C e c ∈C_e c∈Ce,我们首先将其 k 个支持样本 ( y s = c ) (y_s = c) (ys=c) 的特征图重新排列为单个空间特征矩阵 X c ∈ R k h w × d X_c\in R^{khw\times d} Xc∈Rkhw×d

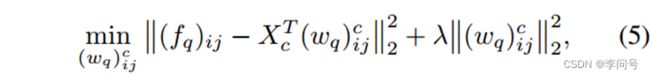

然后,通过求解以下线性最小二乘问题重建查询图像 x q x_q xq 的每个局部特征向量 ( f q ) i j ∈ R d \left(f_q\right)_{ij}\in R^d (fq)ij∈Rd:

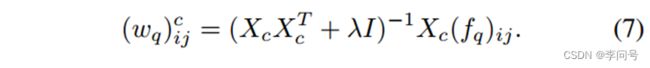

等式(5)中的优化问题也称为脊回归问题,它有一个可微分的封闭形式解,可以快速计算为:

所得到的重建系数 ( w q ) i j c {\left(w_q\right)}^c_{ij} (wq)ijc 可以用来表示查询图像的局部特征 ( f q ) i j \left(f_q\right)_{ij} (fq)ij与第c类支持图像之间的局部空间关系

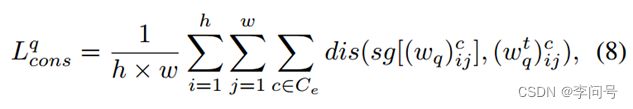

对于变换后的 e p i s o d e E t episodeE^t episodeEt,通过应用相同的操作,我们还可以获得相同查询图像 x q x_q xq 的局部特征向量 ( f q t ) i j \left(f_q^t\right)_{ij} (fqt)ij 的重建系数 ( w q t ) i j c \left(w_q^t\right)_{ij}^c (wqt)ijc。

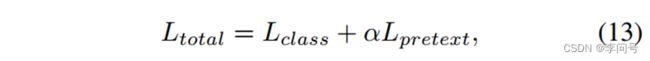

然后通过最小化两个重建系数来提升了原始episode中每个查询图像与变换episode之间的空间关系一致性,这就是代理任务的损失:

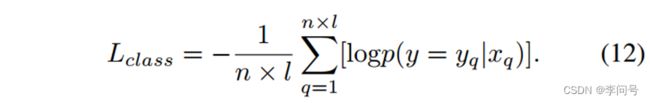

利用代理任务建立起来的支持图像和查询图像之间的局部空间关系,在分类任务的损失使用标准的交叉熵损失,利用同类支持样本 y s = c y_s=c ys=c重建查询图像的残差应该比使用与查询图像不同类的支持样本残差要小得多的思想,计算每个查询图像 x q x_q xq的所有特征图位置上的重建误差,得到其在所有类别的预测概率:

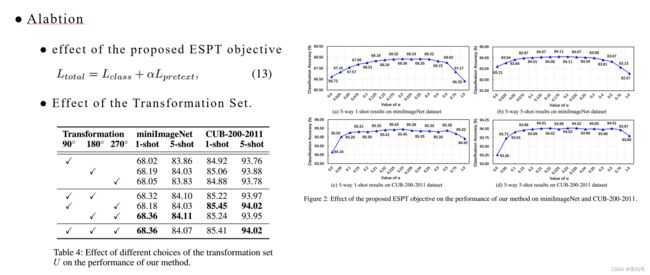

5 实验

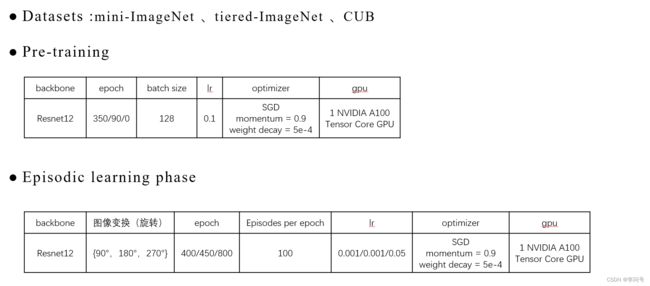

5.1 实验细节

所提出的 ESPT 方法没有引入任何额外的网络结构和额外的可训练参数。因此它不会增加模型的复杂性和数据过拟合的风险,这对于解决训练样本有限的少样本学习问题尤为重要。

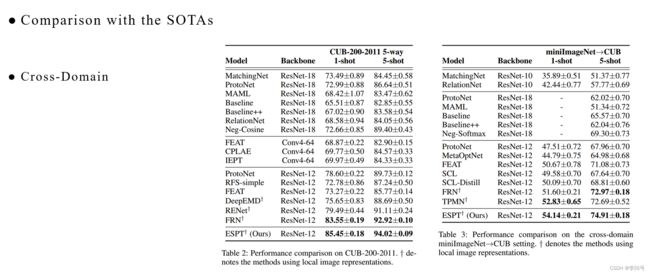

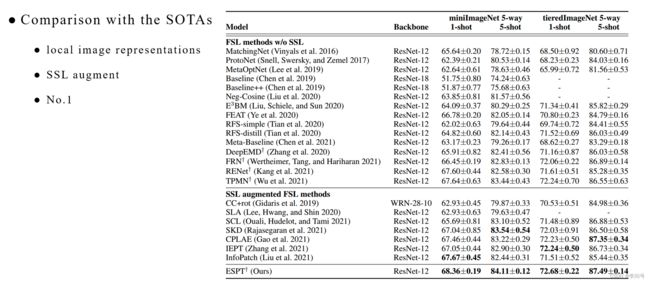

5.2 与SOTAs比较

(1) 在所有不带 SSL 的 FSL 方法中,使用局部图像表示的方法优于其他方法,证明了捕获局部空间信息对于 FSL 的重要性。

(2) SSL 增强 FSL 方法通常比没有 SSL 的 FSL 方法实现更好的分类性能,表明 SSL 可以促进 FSL 学习更多可转移的特征表示。

(3) 所提出的 ESPT 方法在 miniImageNet 数据集上实现了最高的 1shot 和 5-shot 分类精度,分别为 68.36%、84.11% 和 tieredImageNet 数据集上的 72.66%、87.49%。