Vmware vSphere 5.0系列

Vmware vSphere 5.0

我们都用过 vmware workstation 这款产品,可以使我们安装很多虚拟机,但是 vmware 的核心产品远非局限于 workstation。

vSphere 是 VMware 推出的基于云的新一代数据中心虚拟化套件,提供了虚拟化基础架构、高可用性、集中管理、监控等一整套解决方案。

1 vmware vSphere 兼容性

如何判断当前的硬件设备是否支持 vSphere?主要影响的硬件,CPU,网卡。

HCL 兼容性网站支持的 CPU 列表查询网址:http://www.vmware.com/resources/compatibility/search.php

推荐服务器配置如下:

服务器:Dell R900,IBM,x3650,HP DL 380。

CPU:至少 2 个,4 内核以上

内存 16GB DDR3 1333 16 插槽 至少支持 128GB

网卡:最少 4 个,GB 或者 10GB 级别

硬盘:15K SAS 硬盘 6 个

2 VMware vSphere 组件和功能

-

Vmware ESXi

vSphere 去掉了原来的 ESX,因保留了 ESXi。一个在物理服务器上运行的虚拟化层,它将处理器、内存、存储器和资源虚拟化为多个虚拟机。 -

Vmware vCenter Server

配置、置备和管理虚拟化 IT 环境的中央点。它提供基本的数据中心服务,如访问控制、性能监控和警报管理功能。 -

VMware vSphere Client

一个允许用户从任何 Windows PC 远程连接到 vCenter Server 或 ESXi 的界面。 -

VMware vSphere Web Client

一个允许用户从各种 Web 浏览器和操作系统远程连接到 vCenter Server 的 Web 界面。 -

vSphere 虚拟机文件系统 (VMFS)

一个针对 ESXi 虚拟机的高性能群集文件系统。 -

vSphere Virtual SMP

可使单一的虚拟机同时使用多个物理处理器。 -

vSphere vMotion

可以将打开电源的虚拟机从一台物理服务器迁移到另一台物理服务器,同时保持零停机时间、连续的服务可用性和事务处理完整性。但不能将虚拟机从一个数据中心移至另一个数据中心。 -

vSphere Storage vMotion

可以在数据存储之间迁移虚拟机文件而无需中断服务。可以将虚拟机及其所有磁盘放置在同一位置,或者为虚拟机配置文件和每个虚拟磁盘选择单独的位置。虚拟机在 Storage vMotion 期间保留在同一主机上。通过 Storage vMotion 迁移的功能,使您能够在虚拟机运行时将虚拟机的虚拟磁盘或配置文件移动到新数据存储。通过 Storage vMotion 迁移,可以在不中断虚拟机可用性的情况下,移动虚拟机的存储器。 -

vSphere High Availability (HA)

可为虚拟机提供高可用性的功能。如果服务器出现故障,受到影响的虚拟机会在其他拥有多余容量的可用服务器上重新启动。 -

vSphere Distributed Resource Scheduler (DRS)

通过为虚拟机收集硬件资源,动态分配和平衡计算容量。此功能包括可显著减少数据中心功耗的 Distributed Power Management (DPM) 功能。 -

vSphere 存储 DRS

在数据存储集合之间动态分配和平衡存储容量和 I/O。该功能包括管理功能,将降低虚拟机性能的空间不足风险和 I/O 瓶颈风险降到最低。 -

vSphere Fault Tolerance

通过使用副本保护虚拟机,可以提供连续可用性。为虚拟机启用此功能后,即会创建原始或主虚拟机的辅助副本。在主虚拟机上完成的所有操作也会应用于辅助虚拟机。如果主虚拟机不可用,则辅助虚拟机将立即成为活动虚拟机。 -

vSphere Distributed Switch (VDS)

虚拟交换机可以跨多个 ESXi 主机,使当前网络维护活动显著减少并提高网络容量。效率获得提升,可使虚拟机在跨多个主机进行迁移时确保其网络配置保持一致。

3 关于 vCenter Server接口

- ESXi服务器管理:与vCenter 代理的连接,用于管理ESXi主机

- 数据库接口:与DB连接,用于存储信息

- vSphere API:与VMware管理客户端和第三方解决方案的连接。

- 活动目录接口:与AD连接以获得用户访问控制信息

4 安装 ESXI 5

ESXi 只是vSphere里的一个组件,vSphere 的两个核心组件是 ESXi 和 vCenter Server

ESXi 5 的可以免费试用 60 天。ESXi 5 可以直接安装在服务器上,这里我们用测试环境来安装,使用 vm workstation 安装 ESXi 5。

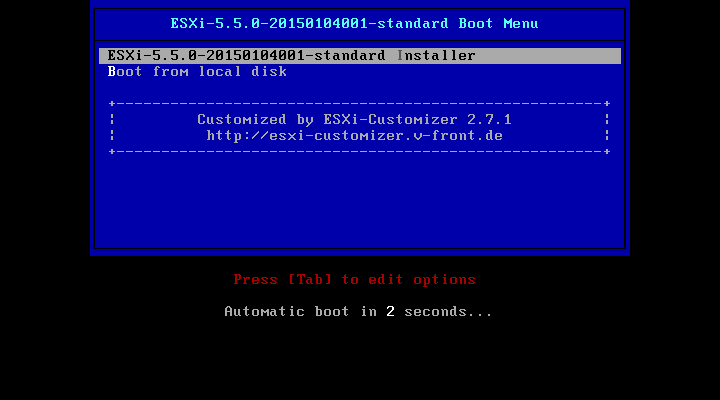

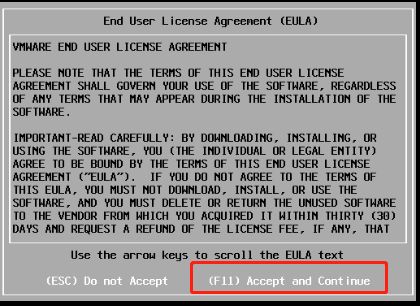

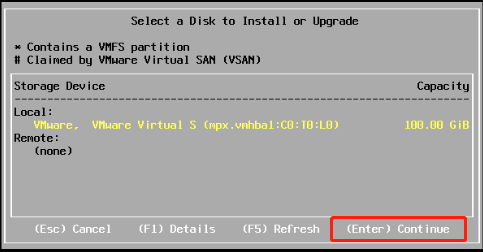

下面是安装的基本界面,请注意,如果是使用服务器安装,需要确定服务器的 CPU 处于 ESXi 5 的 HCL 当中;如果服务器有连接存储的话,同时需要关闭存储。

![]()

可以看到 CPU 是 AMD 四核的,内存是 4GB

接下来是检查兼容性,VMware ESXI 5.5.0 安装在大多数系统上,但只支持 VMware 可支持清单上的系统。

这个也就是我们之前说的 HCL 的网站,如果我们没有去网站上查,这里系统也会为我们自动检测。

网卡信息,官方的建议其实是 6 块网卡

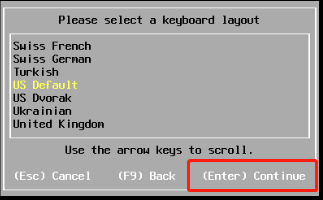

默认键盘即可

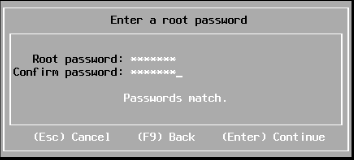

设置 root 账户的密码,最少需要 7 位数

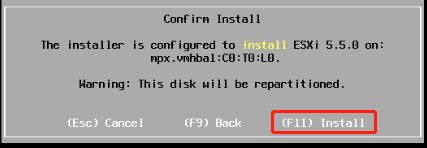

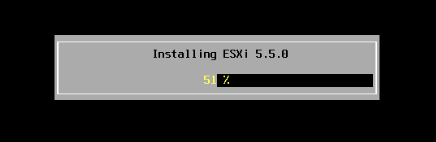

开始安装

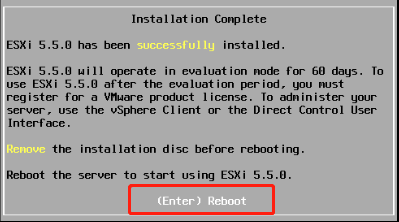

完成后重启

这个是系统的主界面,ESXi 是个基于 linux 的系统,但是我们可以通过 vSphere Client 来连接,并且使用图形化界面来管理。

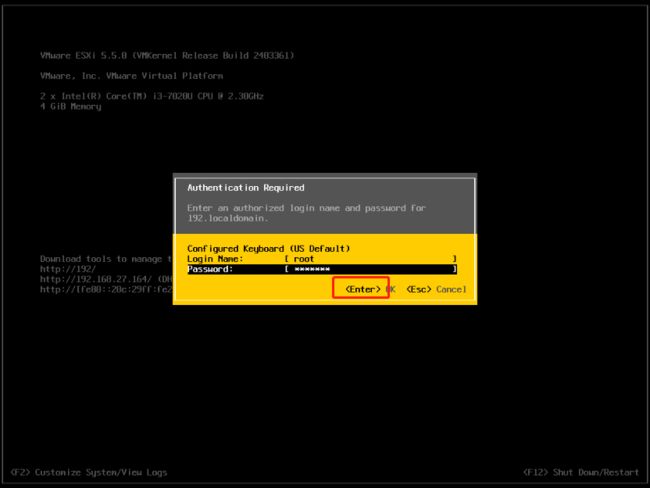

系统默认的使用 DHCP 来获取 IP 地址,我们也可以手动配置 IP 地址。在 ESXi 系统界面按 F2,输入 root 的密码(密码要求最少 7 位数),可以配置 ESXi 服务器

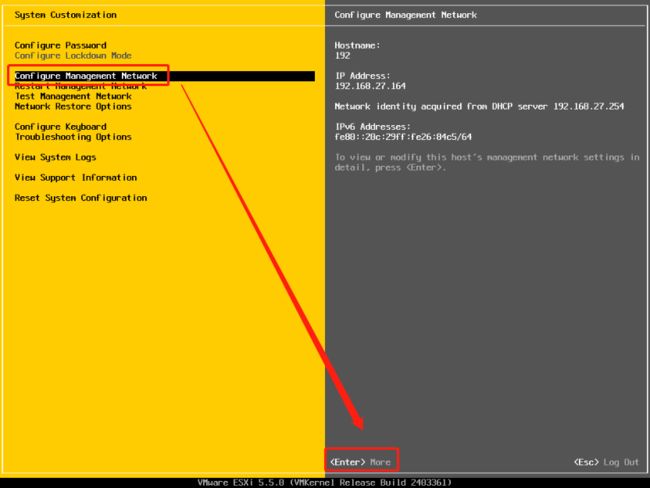

我们可以配置多个选项,这里我们选项配置管理网络,需要配置静态网络

设置静态网络

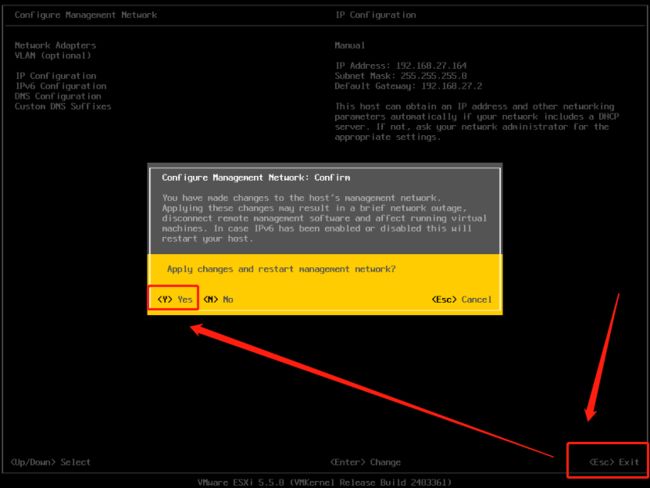

询问是否保存更改

ESXI 5 安装到这里就结束了,可以使用 vCenter Server 连接 ESXi

5 vCenter 介绍及安装配置

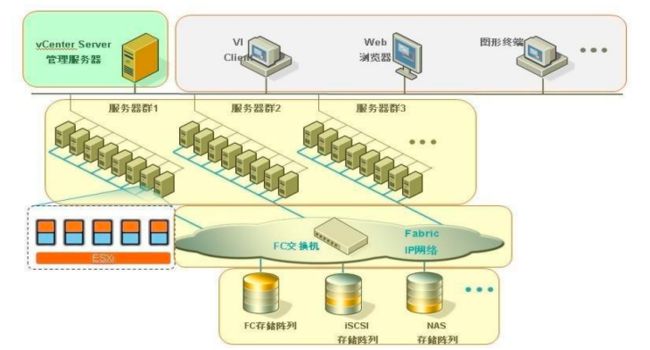

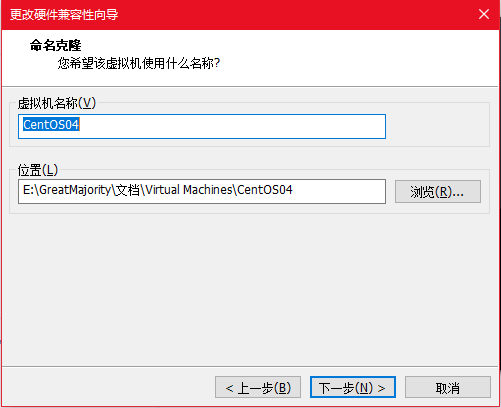

1)vCenter Server 及 Client 的管理拓扑图:

三组 ESXi 服务器组通过光纤交换机或者 IP 网络连接到共享存储,每个 ESXi 服务器组中安装了大量的虚拟机,我们可以通过安装 vCenter 套件来管理 ESXi 服务器以及其中安装的 vm 虚拟机。

通过 vSphere Client 可以直接管理单台 ESXi 服务器,但是管理有限,也不能 vMotion 等操作,因此,通常我们都是使用 vSphere Client 或者 web Client,通过连接 vCenter Server 服务器来实现对多台 ESXi 服务器的管理。

VMware vCenter 是 VMware vSphere 套件中一个强大的主机和虚拟机集中管理组件,vSphere 许多高级功能,只有在 vCenter 下才可以配置实现,并且 vSphere 许多 管理模块只能集成安装在 vCenter 环境中,无法独立安装运行,通过对 vCenter 的管理可以对一台或者多台VMware vSphere 进行管理配置,因此 VMware vCenter 是VMware vSphere 的主要管理平台。

- VMware vCenter 安装软硬件需求

硬件要求:建议内存 4G 以上

系统要求:Window Server 2003(R2)、Window Server 2008(R2)、Window XP ,必须是 64 位的系统,不然无法安装。

服务器建议可以使用单独的服务器,或者在 ESXi 上新建一个虚拟机安装 vCenter Server。安装之前建议将vCenter Server 的服务器加入到网域当中,这样做的好处是以后可以通过 AD 控制 ESXi 的访问权限。Windows server 2008 安装 vCenter Server

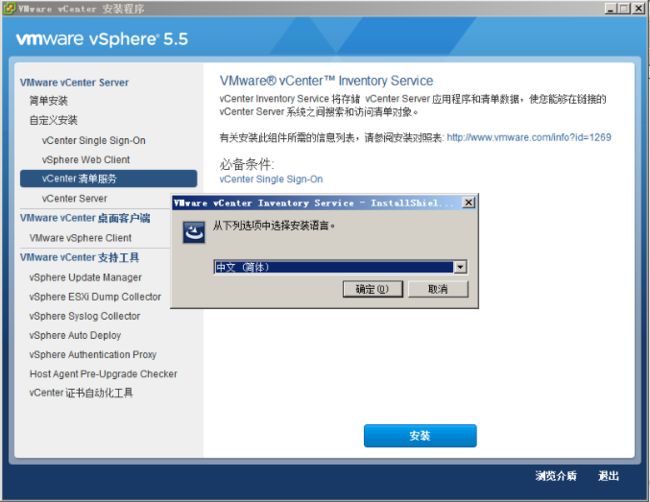

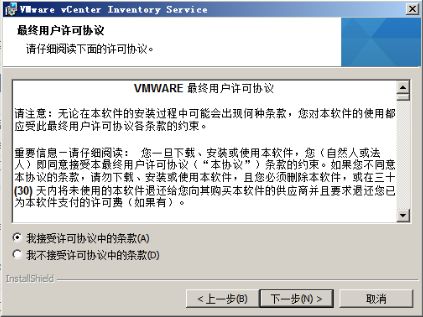

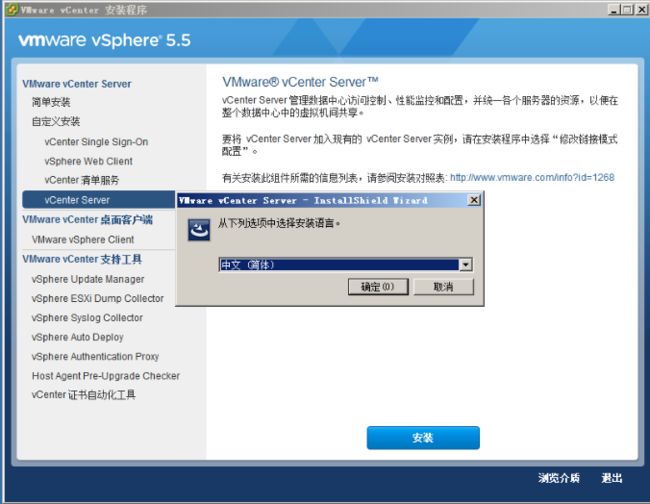

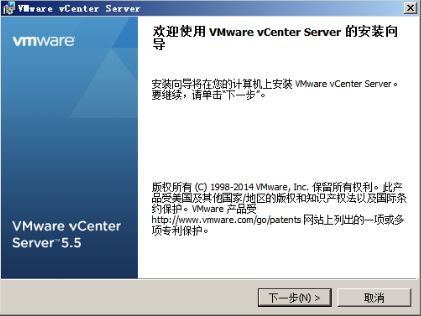

2)在 Window Server 2008 上安装 vCenter

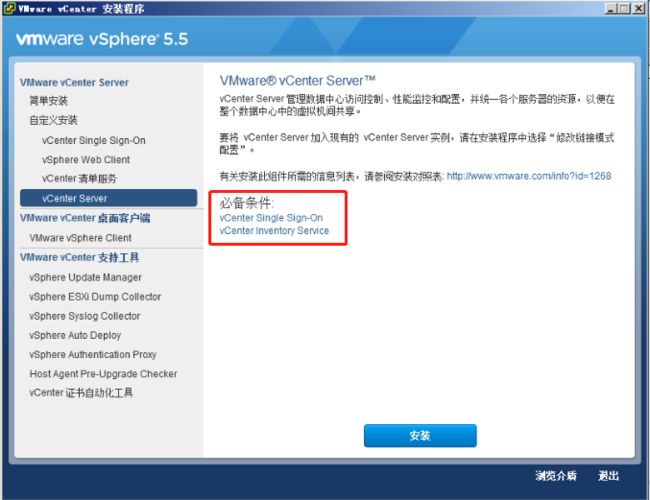

载入安装 ISO 文件,选择自定义安装

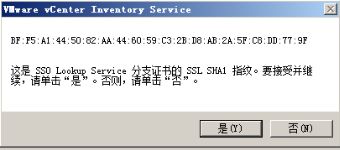

可以看到安装 vCenter Server 需要安装 vCenter Single Sign-On 和 vCenter inventory Service

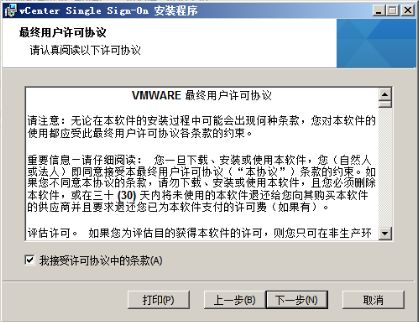

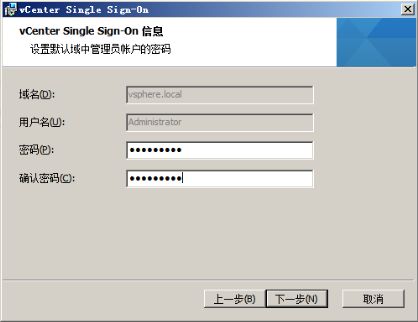

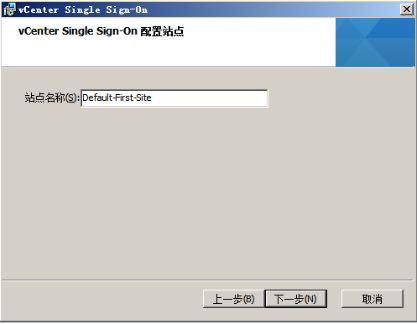

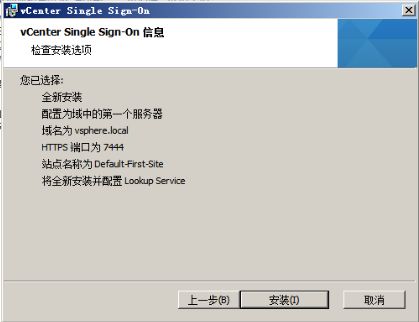

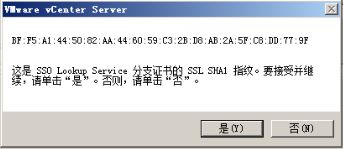

安装 vCenter Single Sign-On

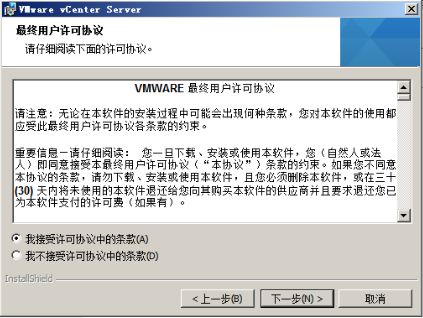

接受协议,后面接受默认值即可

网络接口最好选择静态 IP

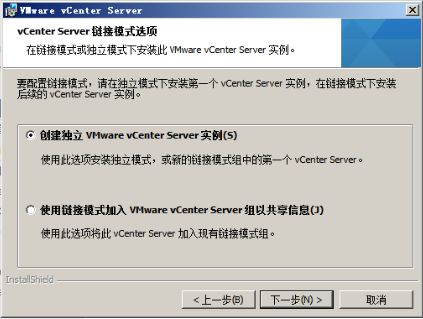

因为是第一次部署,就选择第一个

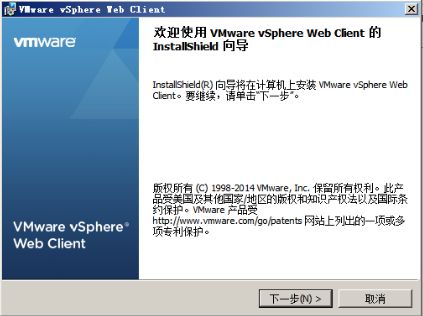

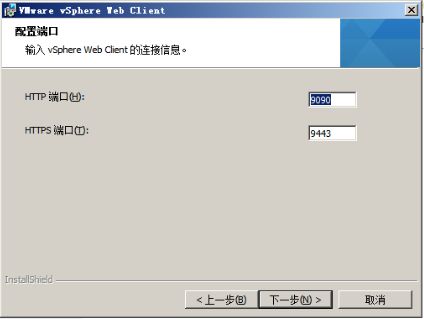

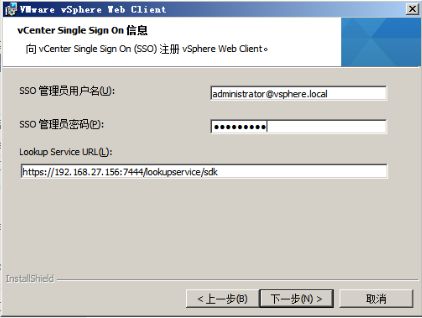

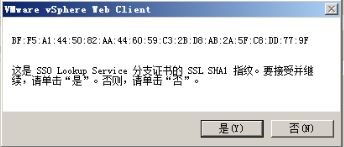

安装 vSphere Web Client

![]()

上一节设置的密码

![]()

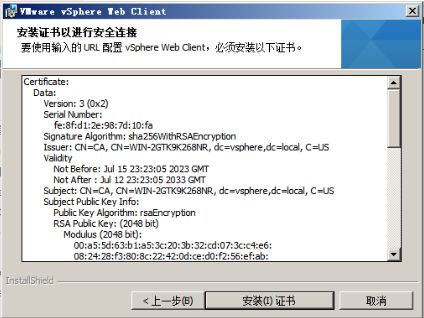

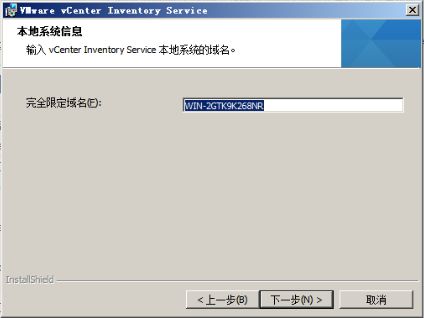

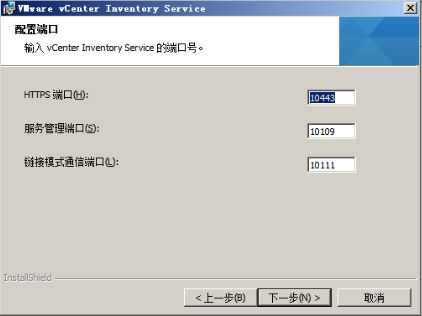

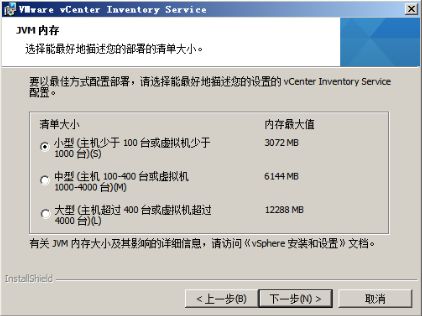

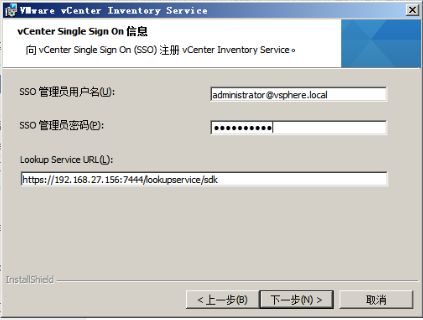

安装 vCenter inventory Service

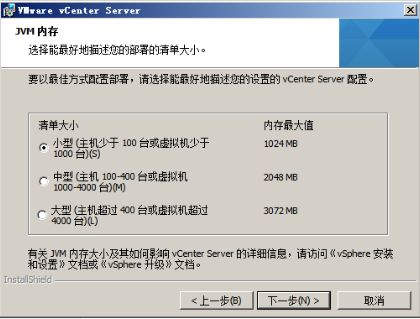

因为少于 100 台虚拟机,所以选择 JVM 内存小即可

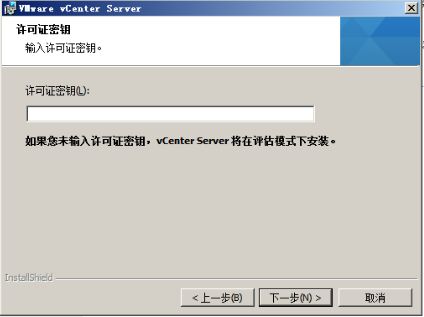

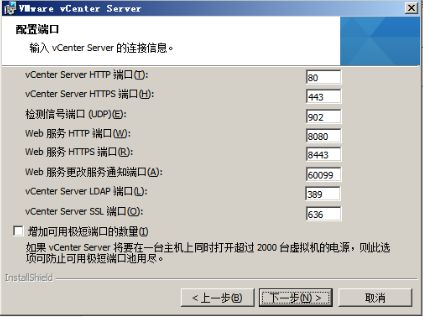

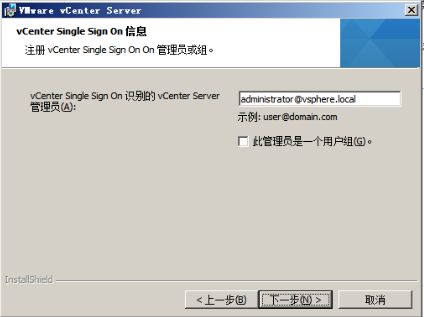

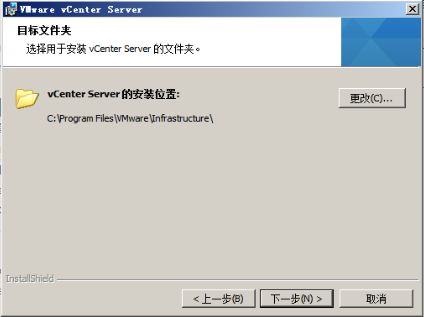

安装 vCenter Service

没有密钥,留空

数据库选择安装 SQL 2008 Express

![]()

6 登录 ESXI 5 建立虚拟机

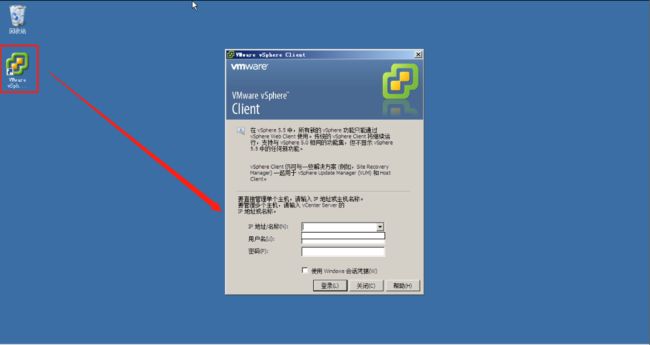

安装 vCenter inventory Client

安装完成后可以使用 Client 登录虚拟机

登录界面如下所示:

现在输入 ESXI5 的 IP 、账号、密码,就可以登录。

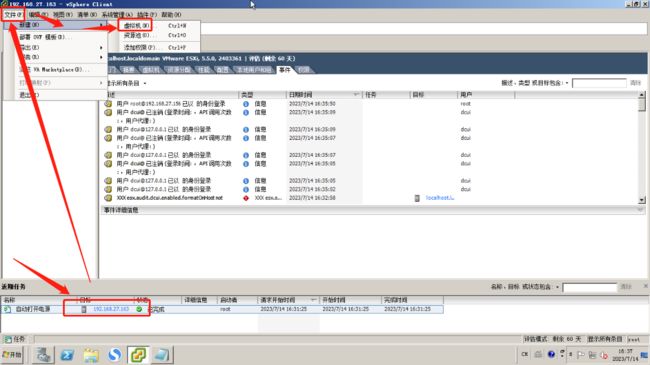

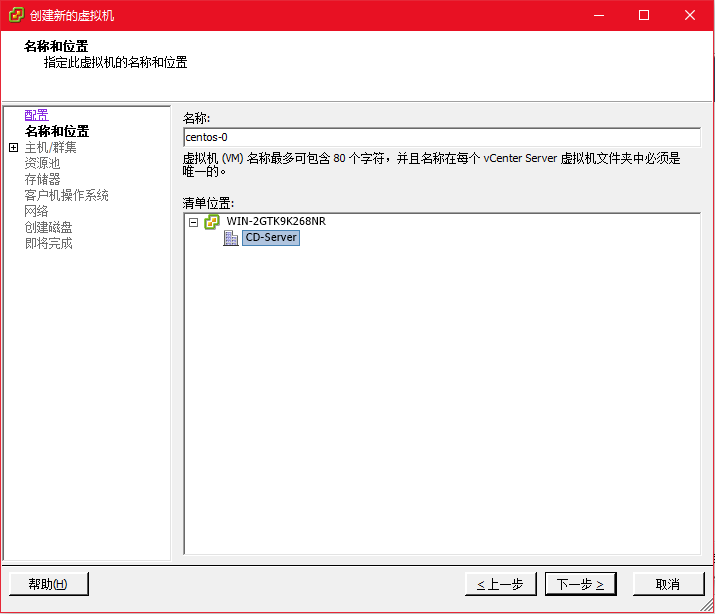

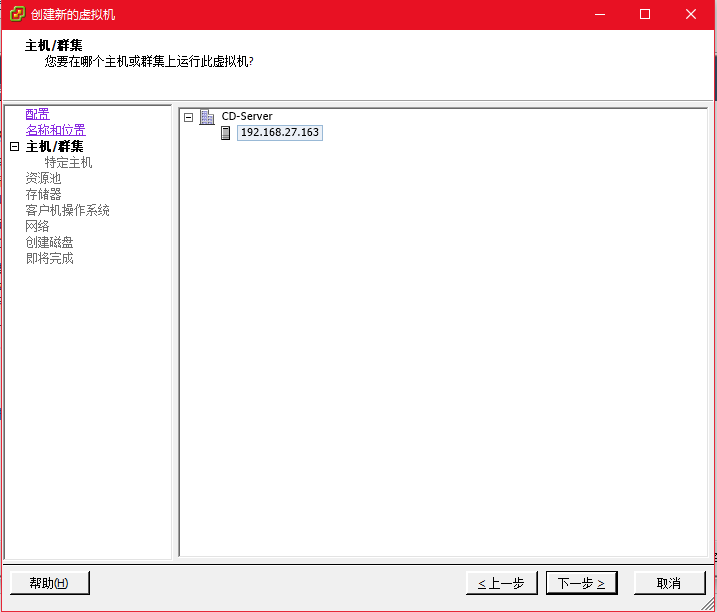

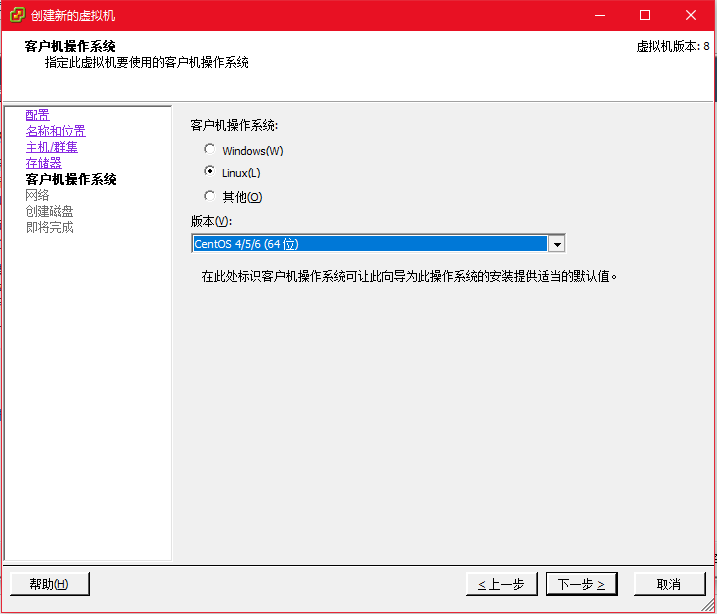

在 ESXI 5 中建立虚拟机

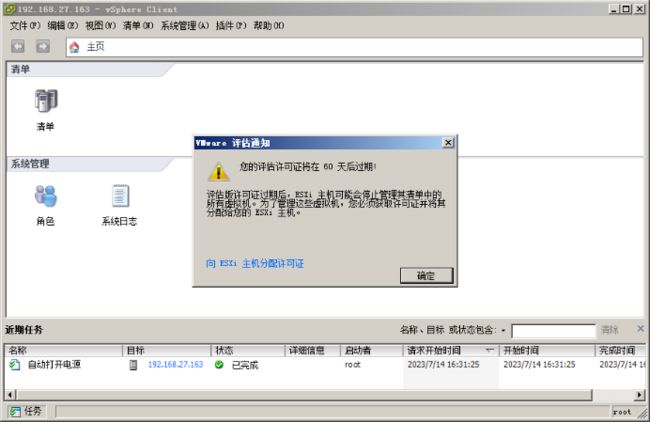

登录后如图所示

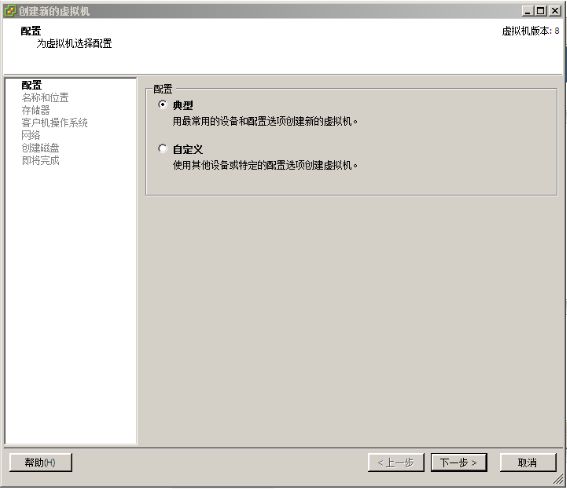

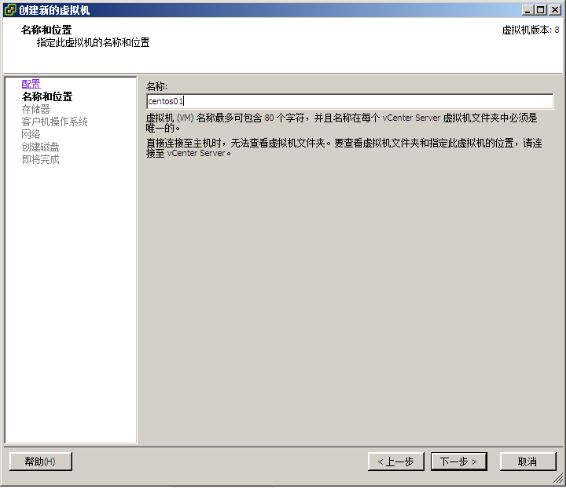

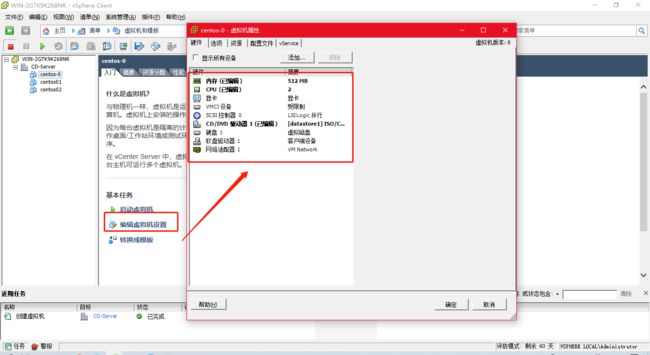

现在使用 vSphere Client 在 ESXI5 上建立虚拟机

这里新建虚拟机的操作与 WM workstation 上一样

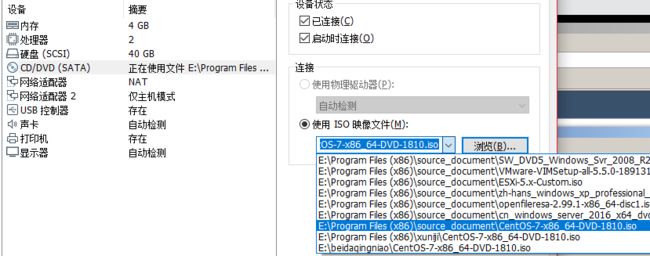

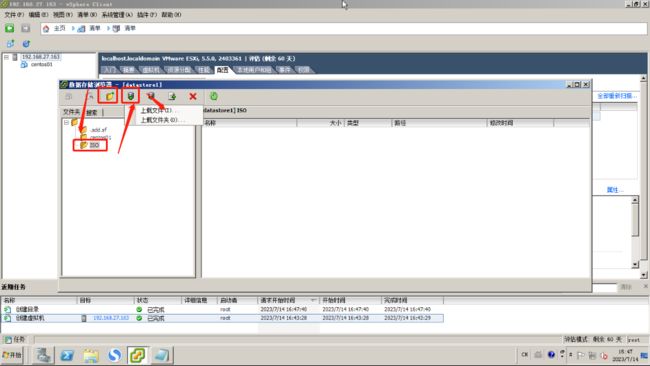

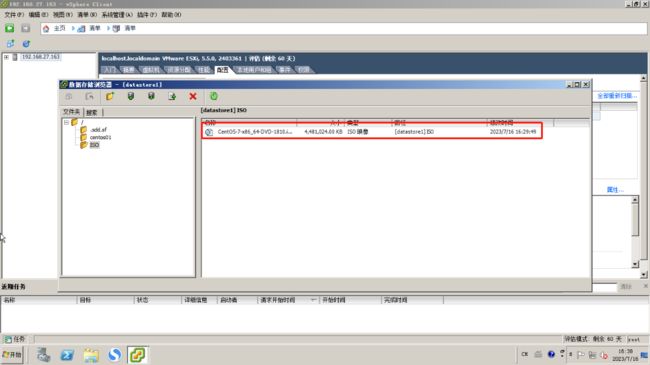

为虚拟机添加 ISO 镜像文件以便安装 Linux

可以在 Windows server 2008 上挂载镜像文件 ,也可以使用共享文件夹将真机上面的文件共享到 Windows 上

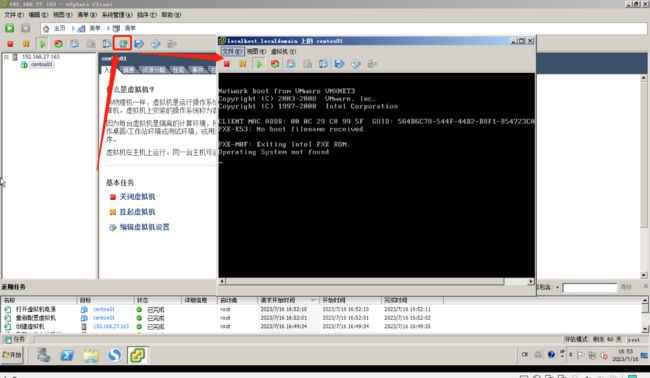

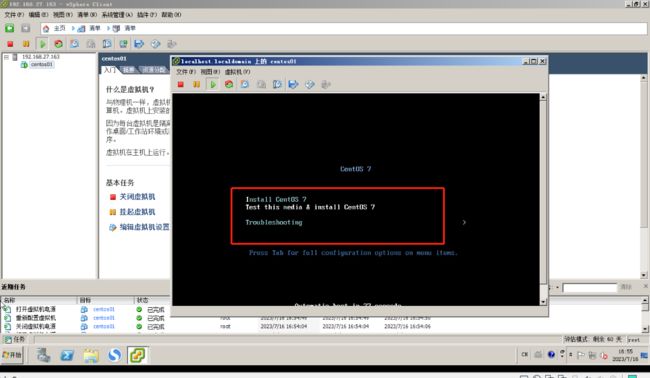

给虚拟机添加镜像文件时,注意要勾选 “打开电源时连接”

vSphere client 上要打开指定虚拟机界面需要去点击启动虚拟机控制台图标

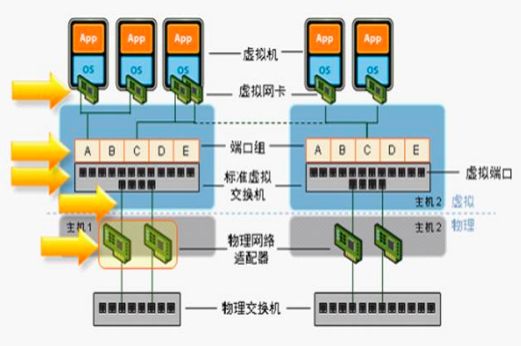

vSphere 网络原理及 vSwitch 简介

在一个物理网络拓扑中,通常都是路由器-交换机-PC 机的连接,不同的服务器和 PC 机,通过交换机的连接而相互连通。

在 VMware vSphere 架构下服务器会虚拟出交换机来供 ESX Host 虚拟机来使用,虚拟交换机有两种,vSwitch 虚拟交换机和 vNetwork 分布式虚拟交换机。

1 ESXI 的网络组成:

-

物理网卡

在 ESXi 中,物理网卡名称都叫 vmnic,第一片物理网卡为 vmnic0,第二片 vmnic1,依此类推。在安装完 ESXI 后,默认会添加第一片网卡 vmnic0。vSphere 的高级功能,必须通过多片网卡来实现。 -

虚拟交换机

vSwitch 由 ESXI 内核提供,为一个虚拟的交换机,用于连接不同的虚拟机及管理界面。vSwitch可由一块或多块 vmnic 组成,不同的 vSwitch 无法使用同一 vmnic。默认会安装第一台虚拟交换机 vSwitch0,用于主控台,虚拟机联机等功能。 -

通信端口(组) port/port group

主要用于提供 Service Console、VmKernel,虚拟端口通信端口组功能 ESX 的所有网络操作都是基于 port/port group 与 vmnic、vSwitch 之间。 -

NIC Team

将不同网卡集成到同个信道上,用于增加速度,failover,负载均衡以及其它功能。

2 vSwitch 配置

VMware vSphere 虚拟出一个或者多个虚拟交换机 vSwitch,vSwitch 提供多个虚拟端口提供给虚拟机来进行联网,同时 vSwitch 通过 VMware vSphere 服务器上的物理网卡来与外部的物理网络进行连接。

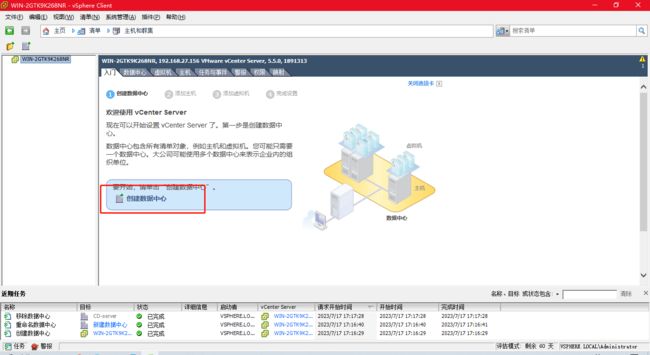

登录到 vCenter server 后,入门中会有提示,需要先新建数据中心

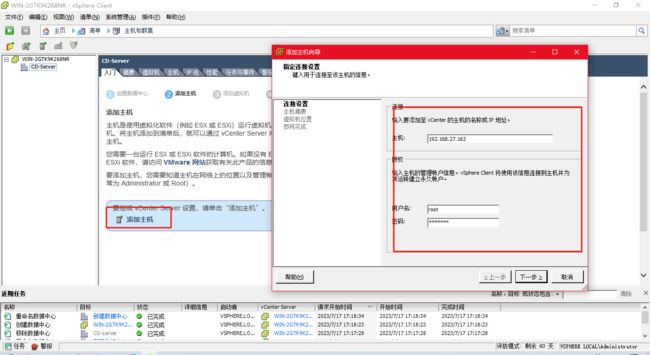

添加 ESXI 主机,根据提示添加即可

因为之前已经建立了虚拟机,默认完成,跳过了第三步

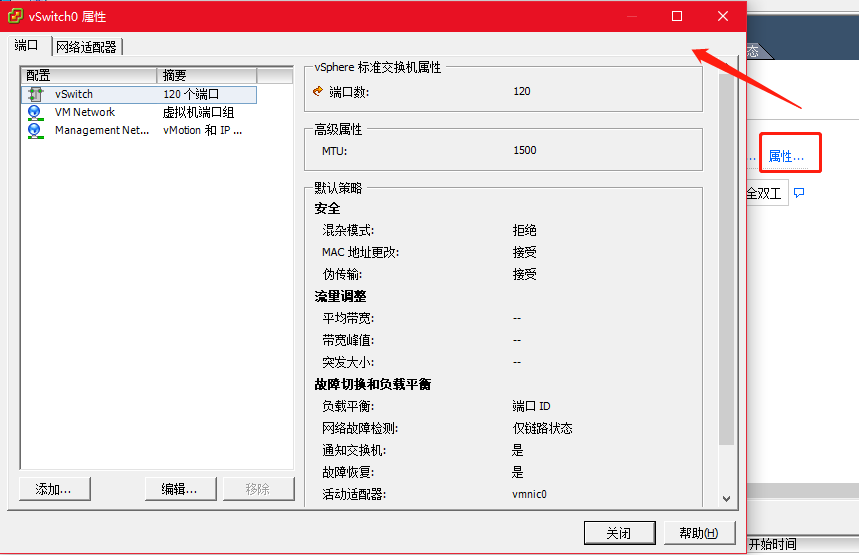

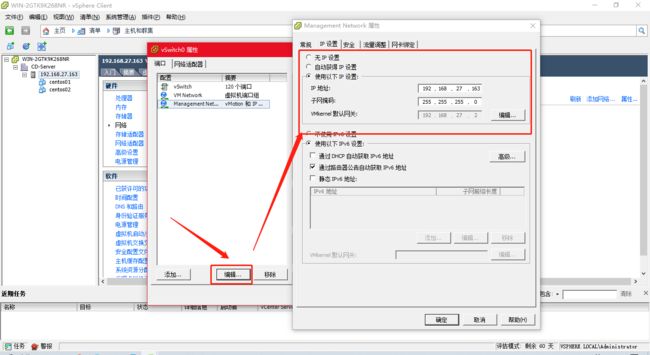

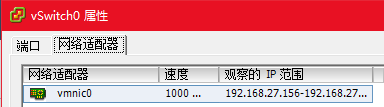

在 VMware vSphere Client 管理 ESXI 的配置(configuration)–网络(Properties)中可以看到虚拟交换机的状况

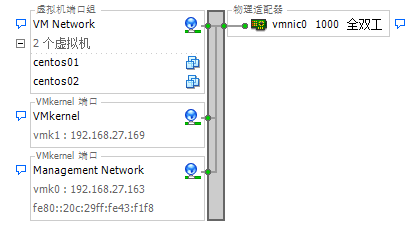

如下图 ESXI 服务器中只建立一个虚拟交换机 vSwitch0,在 vSwitch0 下有 一个 Vm Network,并且有2台虚拟机连接在这个 Vm Network 下,另外还有一个 Management Network(也有称作 Service Console ) ,是这台 ESXI 的管理 IP 地址。

查看 vSwitch0 的属性,可以看到这个 vSwitch 配置了 120 个虚拟端口

虚拟机通信端口组(Virtual Machine)用于让 ESXI 的虚拟机与 switch 连接,可以是物理 switch 或 vSwitch

之前安装 ESXI 的 IP 地址设置,也可以在这里图形化界面设置

在这里可以配置网卡的 vMotion,VLAN ID,FT 等信息,设置网卡流量限制,有多块网卡的情况下可以设置网络的负载均衡

关于网络的负载均衡可以看这篇博客:https://blog.csdn.net/sj349781478/article/details/122416293

3 添加或者删除虚拟交换机所连接的物理网卡

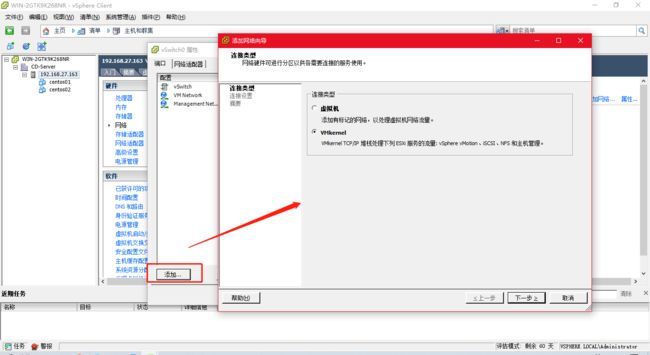

- 添加的虚拟交换机有 3 种:

一是前面我们提到的为虚拟机提供端口的交换机;

二是 VMkernel,用来连接 iSCSI 和 NFS 存储,或者用来做 vMotion;

三是 Service Console 服务控制台,用来配置 IP 管理 ESXI 主机。

添加 VMkernel 的流程

连接类型选择 VMkernel 使用的 vSwitch;

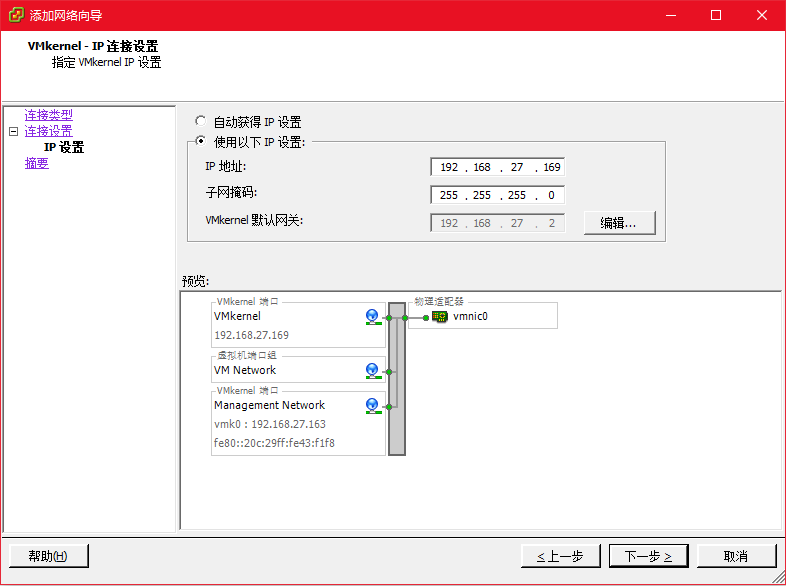

选择要加入 vSwitch0 的网卡,此处由于只有一个 vSwitch,因此默认为 vSwitch0;输入名称及 VLAN ID;

配置 VMkernel 的 IP 地址及网关

确认添加 VMkernel 配置

当然,除了默认的 vSwitch 外我们还可自己添加 vSwitch,但是注意,同一块物理网卡 vmnic 只能配置到一个 vSwitch 上面。选择新建虚拟交换机使用的网卡虚拟交换机的名称及 VLan ID 确认配置即可。完成添加之后可以看到 ESXI 服务器的网络中多了一个 vswitch1 的虚拟交换机。

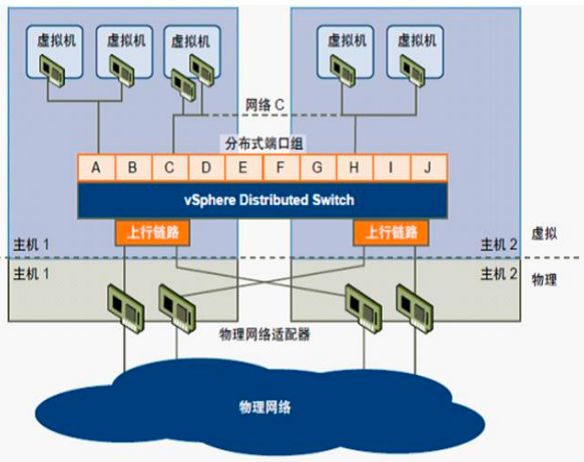

除了标准的虚拟交换机(Standard Switches)外,VMware 还有分布式交换机(Distributed Switches),分布式 vSwitch 可以横跨多个 ESXI Host。使用 Distributed vSwitch 后,多个 ESXI Host 中的 VM 如同连接在同一 vSwitch上一样,vm 可以在任意 ESXI Host 之间迁移。

一个横跨俩个 ESXI Host 的 Distributed vSwitch

理解 vSphere 的网络结构是后续所有高级功能的关键,vSwitch 标准交换机将同一 ESXI HOST 上的不同 VM 连接在一起,而 Distributed vSwitch 则将不同 ESXI HOST 上的不同 VM 连接在同一个虚拟交换机上,使得这些 VM 在不同 ESX HOST 迁移时,就如同一直在同一 vSwitch 端口上一样。

vSphere 高级应用

基本知识点

1 存储简介及配置 openfiler 存储

-

esxi存储:提供主机级别的存储。分本地存储和外部共享存储

- 本地存储:不通过网络即可通讯的内部磁盘或外部磁盘。包括scsi、ide、sata、usb、sas等存储系统多主机间不能共享只能有一个主机访问

- 外部存储:esxi主机通过网络连接的外部存储磁盘或阵列,包括san、iscsi、nfs等存储协议。可以由多个主机共享访问。是vmotion等高级功能的实现基础。

-

Openfiler是一款免费提供NAS(网络附加存储)和iSCSI(Internet Small Computer System Interface)功能的SAN(存储区域网络)服务器系统。它可以为主机提供独立的存储系统,并支持多种连接方式,包括NFS(Network File System)、SMB(Server Message Block)和iSCSI。通过使用HTTPS协议,可以对Openfiler进行管理和访问。

访问方式:https://openfiler服务器ip地址:446/

为什么需要独立存储?

若 A、B 俩台服务器各自单独安装操作系统,文件分别存在各自的硬盘上,若 A、B 任何一台服务器故障,硬盘数据将丢失。

若 A、B 俩台服务器仅安装操作系统,数据存放在独立存储设备中,A、B 任意一台服务器故障,我们可以由另外一台服务器接管应用,修复宕机的服务器进行替换即可,原有数据不会丢失。当然也可以俩台服务器同时跑应用系统,进行负载均衡。

每个 ESX 主机各自均安装了一定的 VM,并且 VM 均保存在独立存储中。若任何一个 ESX 主机宕机,要保证上面的虚拟机继续可用,则需要将其中的的 VM 需要转移到其它 ESX 主机中,由于 ESX 主机的 VM 主机文件保存在共享独立存储中,只需要在其它主机上 COPY 一份 CPU 及内存重新连接主机配置文件即可,即vSphere Vmotion。

配置 Openfiler

安装完毕后,Openfiler 服务器重启,然后出现初始界面,提示通过 https://openfiler-ip:446 进行管理

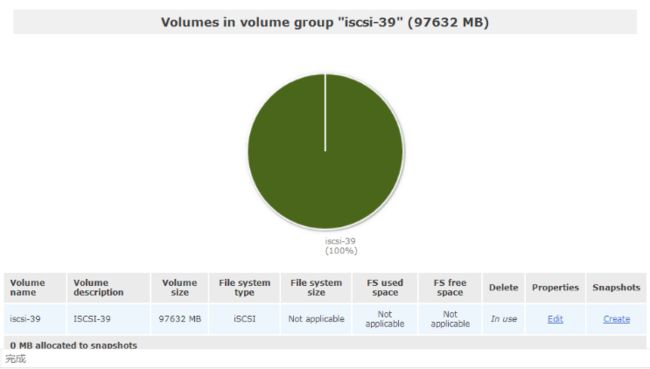

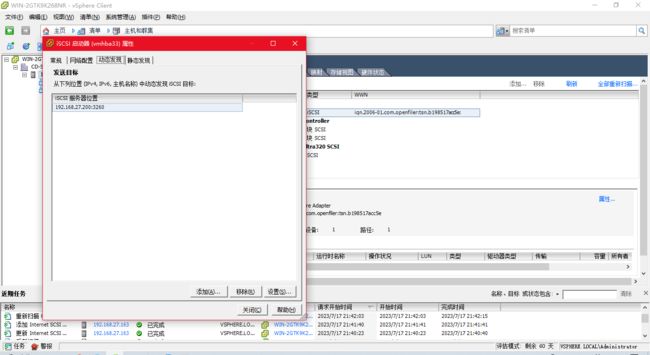

这里已经配置 iscsi

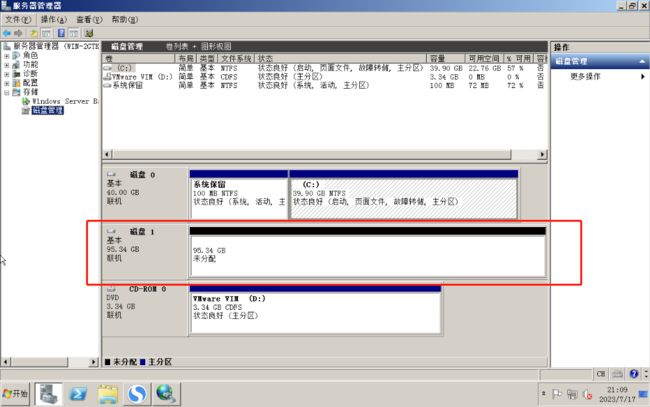

简单测试 openfiler 是否可用,将存储连接到 windows server 2008

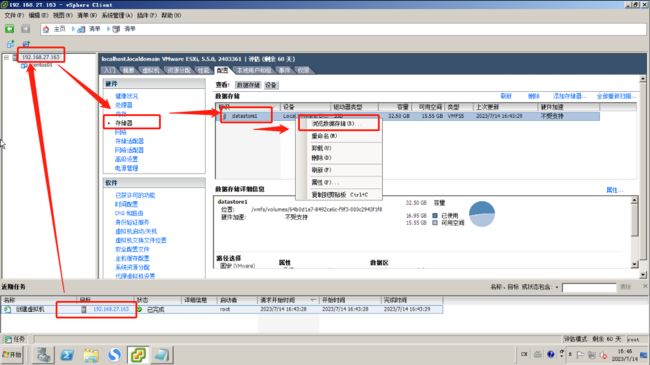

现在到 vSphere Server 中添加看看,首先要添加一个存储适配器,输入 Target IQN 添加后,再在存储器这里添加存储器

添加存储适配器,如果配置错了,可以右键属性中去修改。

动态发现,输入 IP 地址后会去自动寻找 IQN;静态发现需要手动添加 IQN。

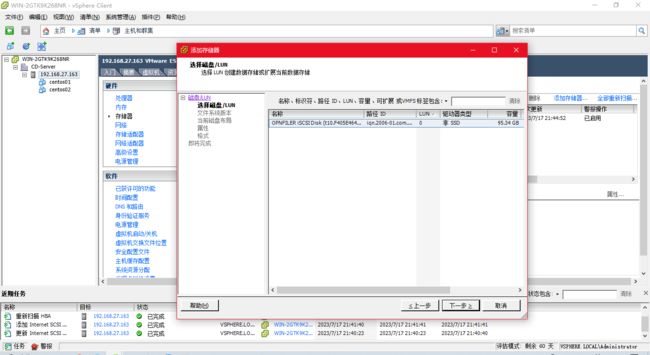

系统会自动识别创建好的 iscsi volume,选择一个要添加的,一直下一步即可完成操作。如果有多个存储就重复操作添加。

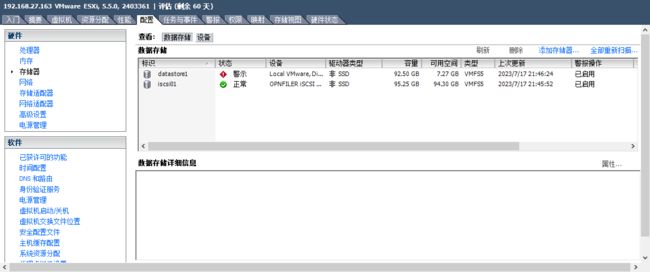

可以看到已经添加成功了。在 cluster 中的 ESX 主机的刷新一下,可以看到刚刚加入的 iscsi volume。

vSphere vMotion,HA,DRS 等高级功能的实现,必须使用多块网卡,并且需要一个或多个独立存储(多个存储用于存储的 vMotion)。在实验环境或者要求不高的生产环境中,我们可以使用 Openfiler 软件实现独立存储,当然也可以使用免费的 NAS 服务器 FreeNas,掌握了独立存储的配置,接下来我们就可以配置 vMotion 了。

2 虚拟机及主机配置文件的创建和模板部署

安装 VMware vSphere 的目的就是在一台物理 ESX 主机上安装很多很多的虚拟机,我们可以通过 VMware vSphere Client 直接管理 VMware vSphere 服务器,也可以通过对 VMware vCenter 的管理来实现对 VMware vSphere 服务器的管理。

在独立存储上建立虚拟机

详细介绍 VMware 厚置备延迟置零,厚置备置零,精简置备的概念及选择使用:

-

厚置备延迟置零(zeroed thick)

以默认的厚格式创建虚拟磁盘。创建过程中为虚拟磁盘分配所需空间。创建时不会擦除物理设备上保留的任何数据,但是以后从虚拟机首次执行写操作时会按需要将其置零。

简单的说就是立刻分配指定大小的空间,空间内数据暂时不清空,以后按需清空。 -

厚置备置零(eager zeroed thick)

创建支持群集功能(如 FaultTolerance)的厚磁盘。在创建时为虚拟磁盘分配所需的空间。与平面格式相反,在创建过程中会将物理设备上保留的数据置零。创建这种格式的磁盘所需的时间可能会比创建其他类型的磁盘长。

简单的说就是立刻分配指定大小的空间,并将该空间内所有数据清空。 -

精简置备(thin)

使用精简置备格式。最初,精简置备的磁盘只使用该磁盘最初所需要的数据存储空间。如果以后精简磁盘需要更多空间,则它可以增长到为其分配的最大容量。

简单的说就是为该磁盘文件指定增长的最大空间,需要增长的时候检查是否超过限额

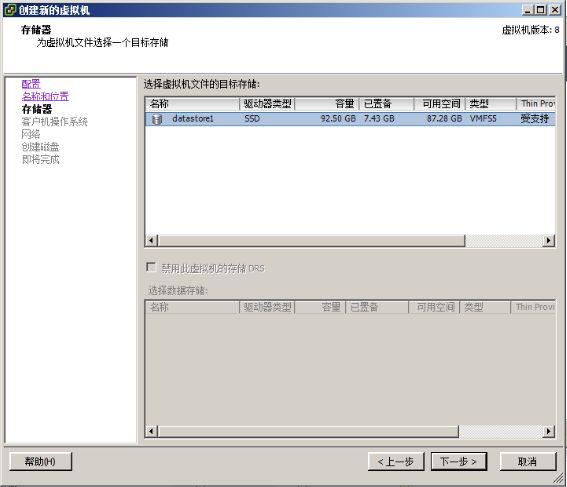

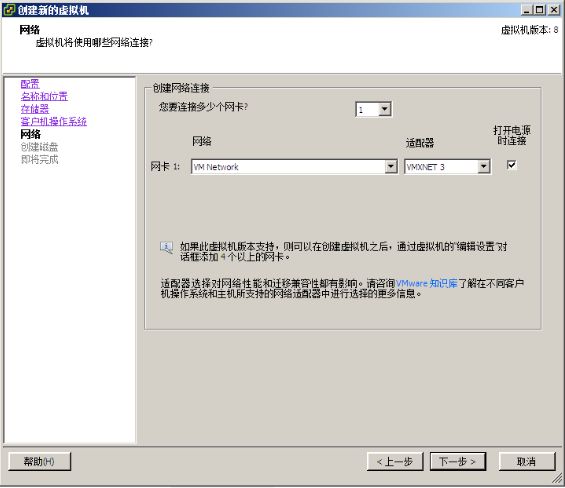

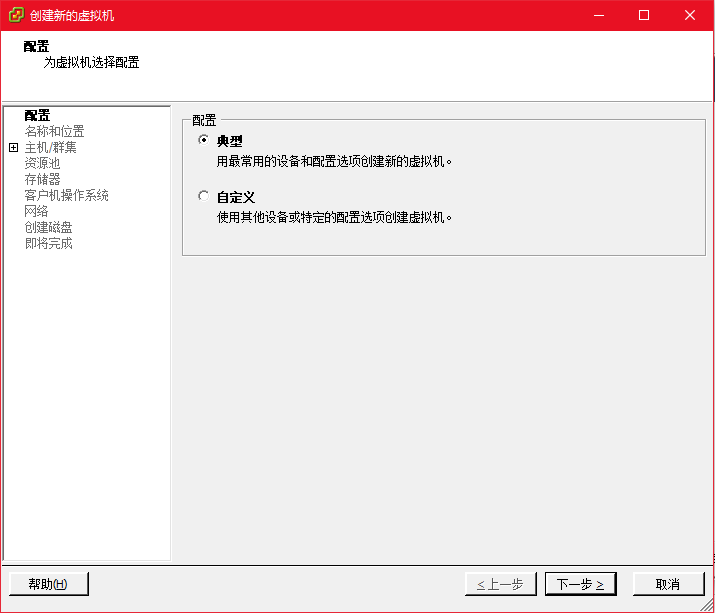

选择新建虚拟机,这里的操作与之前一样

这里选择数据中心和 ESX 主机

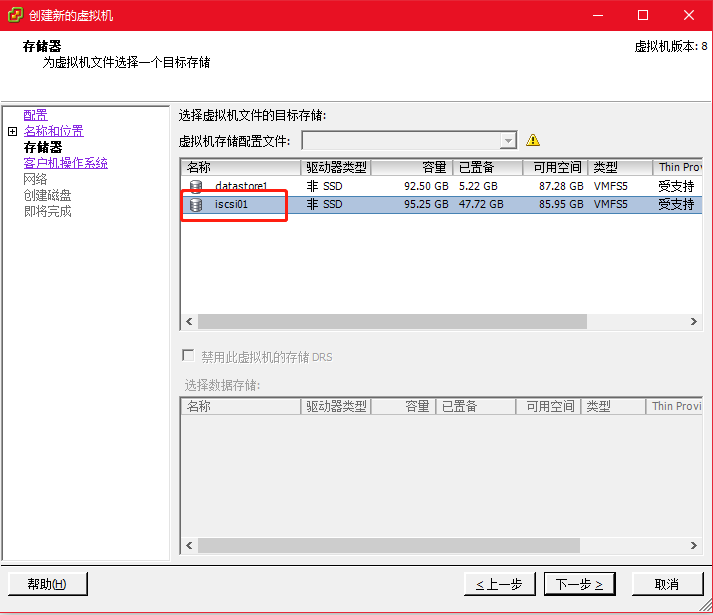

选择虚拟机的存储位置,这里选择刚才建立的独立存储 iscsi01

磁盘选择精简置备

完成后,点击完成,等待状态条读满

修改内存、CPU以及添加镜像文件;完成后开始安装,这里就省略了

模板创建及部署虚拟机

在 WMware Workstation 中我们会经常用到克隆虚拟机,这样如果需要同样系统的虚拟机的话就不必重新安装一遍,只要做一个克隆就可以了。

作为服务器版的 VMware vSphere 自然也有这个功能,另外还有一个从模板部署的功能,这样就可以很方便的部署大量的虚拟机了。

将之前安装好的虚拟机(如果是 windows ,打好系统补丁),安装好需要的软件之后将该虚拟机克隆为模板(也可以转换为模板,转换后原虚拟机不存在,克隆后仍然存在,其它的功能是一样的)。这样可以省掉很多新系统的配置工作。

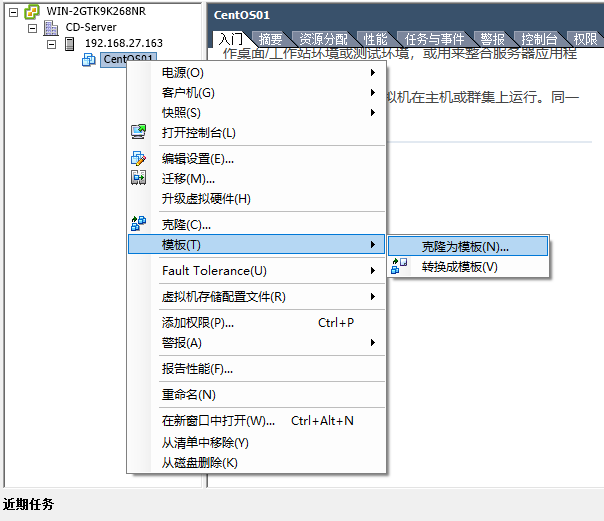

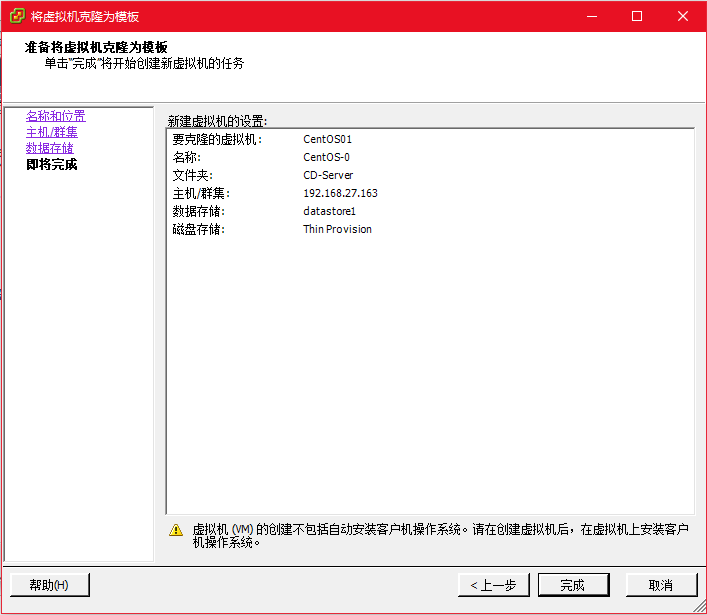

选中虚拟机后,右键克隆-克隆为模板,或者也可以直接转换为模板

创建好模板后,可以就可以通过模板来部署虚拟机了,这样部署虚拟机会节约大量时间,但是部署好新的虚拟机之后我们还不能直接使用这个虚拟机,因为和现有的虚拟机会有计算机名、IP 地址相同,这些需要我们手工修改的。

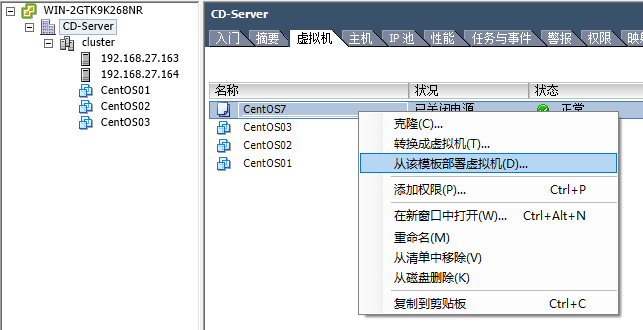

如下图所示,在创建好的虚拟机模板上,右键点击,可以看到一系列的菜单,我们点击从该模板部署虚拟机,即可部署虚拟机,流程同创建虚拟机一样,此处省略。

另外对于 windows 系统来说还有一个 SID 的问题,可以通过系统盘中的 sysprep 进行重新封装生成新的 sid,也可以通过 newsid 第三方软件生成新的 sid。

同样的道理,vSphere 还提供了主机配置文件 Host Profile 的克隆功能,我们可以在 vCenter Server 的主控制台中选择创建特定 ESX 主机的 Host Profile 文件,并且还可以将此配置文件应用到新的 ESX 主机当中,这样就大大节省了我们对 ESX 主机的配置过程。

创建好的 ESX01 主机文件,可以点击编辑,或者右键点击将主机文件附加到主机/群集(必须进入维修模式),套用后根据相应的选项输入配置即可完成。

关于 Host Profile 文件详细可以参考官方文件http://pubs.vmware.com/vsphere-50/index.jsp?topic=/com.vmware.vsphere.doc_50/GUID-553E2EBD-6D19-4873-98FD-265B3A92F1F0.html

从模板部署虚拟机

选择模板–右键–点击从该模板部署虚拟机

部署虚拟机与创建虚拟机的步骤相差不大,这里省略

注意:克隆后的虚拟机系统 ID 号是一样的,为了让系统 ID 号重置,需要运行系统自带的封闭工具 sysprep进行封闭即可解决 SID 重置问题。C:\Windows\System32\Sysprep

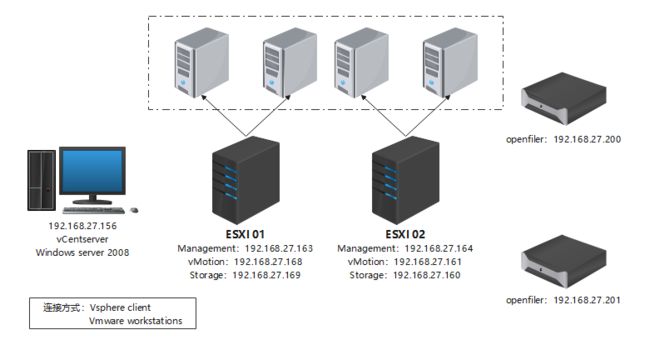

vSphere 高级应用测试环境

vSphere 的 vMotion,HA,FT 等高级应用,必须在多网卡,独立存储的环境中使用。

vsphere 高级功能需要 vcenter server 和共享存储的支持才能实现。vsphere 的高级功能有 vmotion、storage vmotion、vsphere HA、vsphere DRS、存储 DRS、vsphere fault tolerance 等。

-

VMotion

vmotion 是一种可用于将正在运行的虚拟机从一个 esxi 主机迁移到另一个 esxi 主机上,并且不会中断服务的功能。 -

storage vmotion

该功能用于将运行中虚拟机的磁盘和配置文件从一个数据存储移至另一个数据存储,而不会中断服务。 -

vsphere HA

一种使群集具备 high availablity 的功能。若一台主机出现故障,则该主机上运行的所有虚拟机都将立即在同一群集的其他主机上重新启动。

启用群集的 vsphere HA 功能时,需指出希望能够恢复的主机数。

vmware HA 通过在主机出现故障时重新启动虚拟机来为虚拟机提供基本级别的包含。vmware 容错可提供更高级别的可用性,允许用户对任何虚拟机进行保护以防止主机发生数据、事物等故障。

容错使用 esxi 主机平台上的 vmware vlockstep 技术以提供连续可用性。通过确保主虚拟机和辅助虚拟机的状态在虚拟机的指令执行的任何时间点均相同来完成此过程。vlockstep 通过使主虚拟机和辅助虚拟机执行相同顺序的 x86 指令来完成此过程。主虚拟机捕获所有的事件并在辅助虚拟机上进行重放。

如果允许主虚拟机的主机发生故障,则会发生透明故障切换。 -

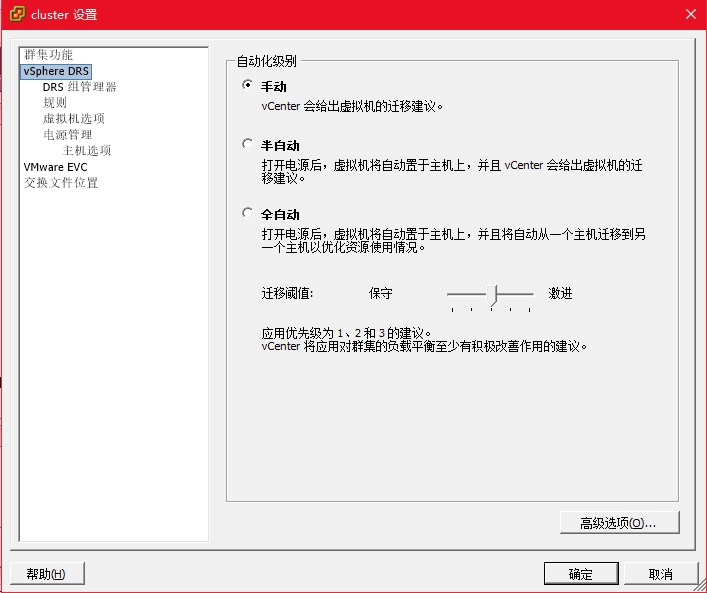

vsphere DRS

vsphere DRS 是一种有助于改善所有主机和资源池之间的资源分配及功能消耗状况的功能。

vsphere DRS 收集群集内所有主机和虚拟机的资源使用情况,并在初始启动虚拟机时给出放置位置建议和负载平衡功能(即,DRS 会尝试通过执行虚拟机的自动迁移vmotion 或提供虚拟机迁移建议提高群集中的资源利用率)。 -

存储 DRS

存储 DRS 是一种可用于将多个数据存储作为单个数据存储群集进行管理的功能。

可以将虚拟磁盘分配给数据存储群集,存储 DRS 会为其找到相应的数据存储。负载平衡器会根据工作负责测量负责初始放置和后续迁移。存储空间平衡和 I/O 平衡可将降低虚拟机性能的空间不足风险和 I/O 瓶颈风险降到最低。 -

vsphere fault tolerance

vsphere FT 通过创建和维护与主虚拟机相同,且可在发生故障切换时随时替换主虚拟机的的辅助虚拟机,来确保虚拟机的连续可用性。目前 vmware 容错的唯一不足是,处于容错的虚拟机只能分配一个 CPU,不支持多 CPU。

1 新建群集

使用 vCenter Client 连接到 vSphere Center Server,并添加 ESX01 与 ESX02 俩台虚拟机。在 vSphere Center Server 主界面中选择创建一个数据中心,并添加一个 cluster 的集群,然后将 ESX01 与 ESX02 俩台虚拟机加入到集群 cluster 当中。

在选择你建立的数据中心后,右键可以新建群集;

添加主机到群集:群集建立之后,直接拖动主机到群集就 OK 了,我这里已经建立好拥有两个主机的群集

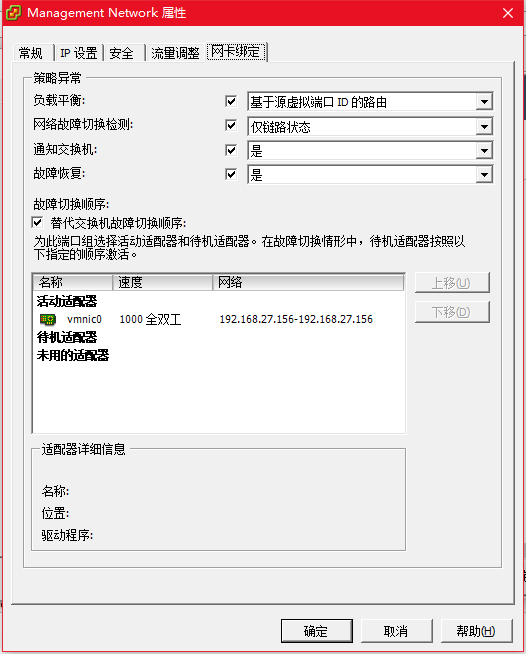

添加 VMkernel 及网络适配器,安装 ESX 后,系统默认创建 vmnic0 和标准交换机 vSwitch0,并在上面创建一个Service Console 及虚拟机网络 VM Network。

![]()

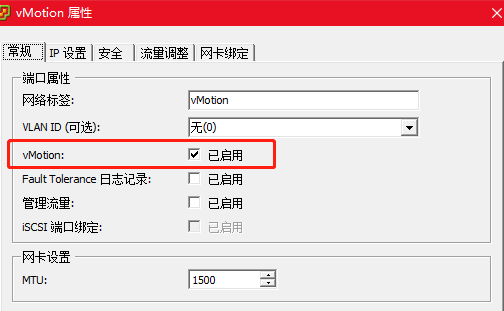

下面我们新建两个 VMKernel,分别为 iSCSI 存储,Vmotion。在ESX01 主界面中选择“配置”—“网络”—vSwitch0“属性”

端口这里选择添加 VMKernel 端口,依次添加命名为 Storage,Vmotion 两个端口;这里我已经添加好了。

vMotion 的端口需要将 vMotion 功能开启。

另一台 ESX02 主机也是同样的方式:

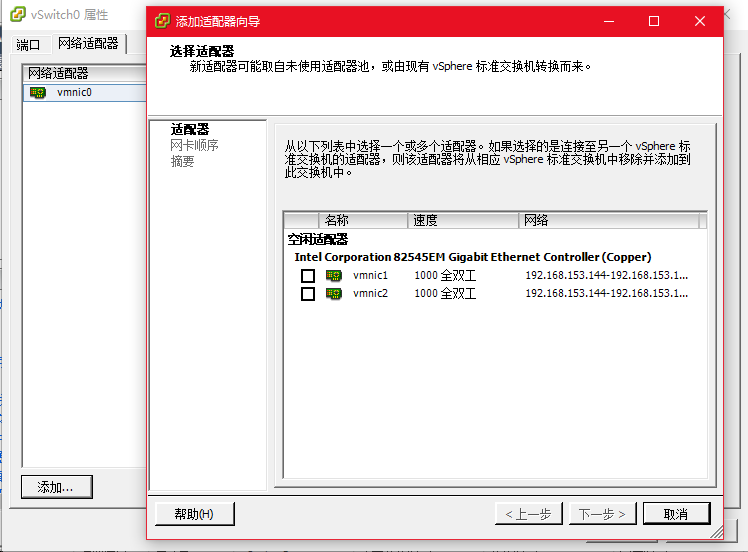

添加适配器,在 ESX01 主界面中选择“配置”—“网络”—vSwitch0“属性”,切换到适配器,添加其它的适配器。

如果是同一网段,全部添加到同一个网络适配器中;如果是不同网段,需要添加另外一个网络适配器。

(这里为了方便我都建立的一个网段)

将 ESX01 与 ESX02 俩台虚拟机连接我们新建好的独立存储

现在新建虚拟机,需要注意的是新建的虚拟机,需要保存在独立存储当中。

至此,实验环境搭建完毕。

2 vMotion 及 Storage vMotion 实战

搭建好了 vSphere 高级应用环境,接下来我们来进行 vMotion 和 SVMotion 测试。

通过 vMotion,可以将正在运行的虚拟机从一台物理服务器移动到另一台物理服务器,而无需中断服务。从而更高效地分配资源。使用 vMotion,可将资源重新动态分配至物理服务器上的虚拟机。

vSphere Storage vMotion 通过 Storage vMotion,可以在数据存储之间迁移虚拟机而无需中断服务。此功能使得管理员可以将虚拟机负载从一个存储阵列迁移到另一阵列,以便执行维护、重新配置 LUN、解决空间问题和升级VMFS 卷。通过无缝迁移虚拟机磁盘,管理员还可以使用 Storage vMotion 优化存储环境来提高性能。

建议俩台进行 vMotion 的 ESX 主机,要有一模一样的配置;另外网络配置也要在同一网段,vSwitch 命名等都要相同,并且一定要安装 vm tools。

官方文献: http://pubs.vmware.com/vsphere50/index.jsp?topic=/com.vmware.vsphere.doc_50/GUID-553E2EBD-6D19-4873-98FD-265B3A92F1F0.html

vMotion 的原理:

- ESX02 克隆 ESX01 中需要转移的虚拟机内存;

- 克隆完毕后,ESX01 中的虚拟机进入等待状态;

- 系统将内存数据切换到 ESX02 中;

- 内存数据切换完毕后,ESX02 中的虚拟机进入激活状态;

- 网卡 MAC 地址重新对应;

- 删除 ESX01 中的虚拟机,完成 vMotion。

1)vMotion

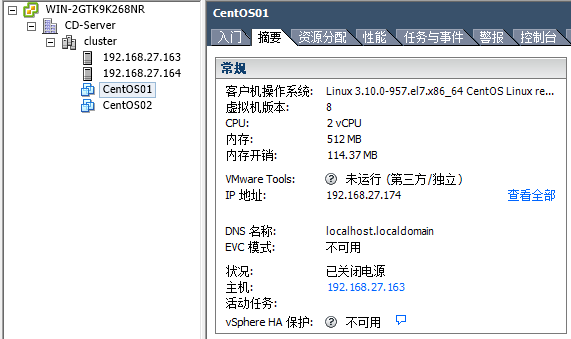

CentOS01 虚拟机在 163 的主机上,现在将其迁移到 164 的主机上面。

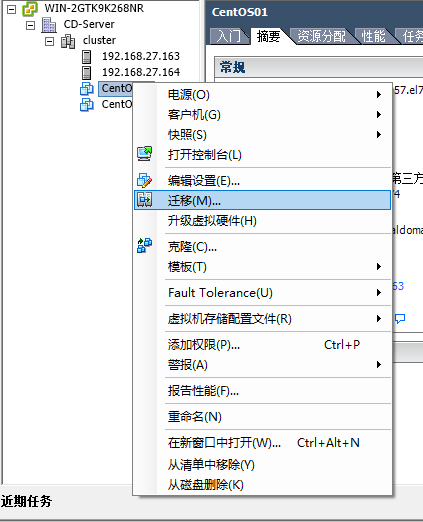

确保 vMotion 已经启用,右键点击一台虚拟机,点击迁移。

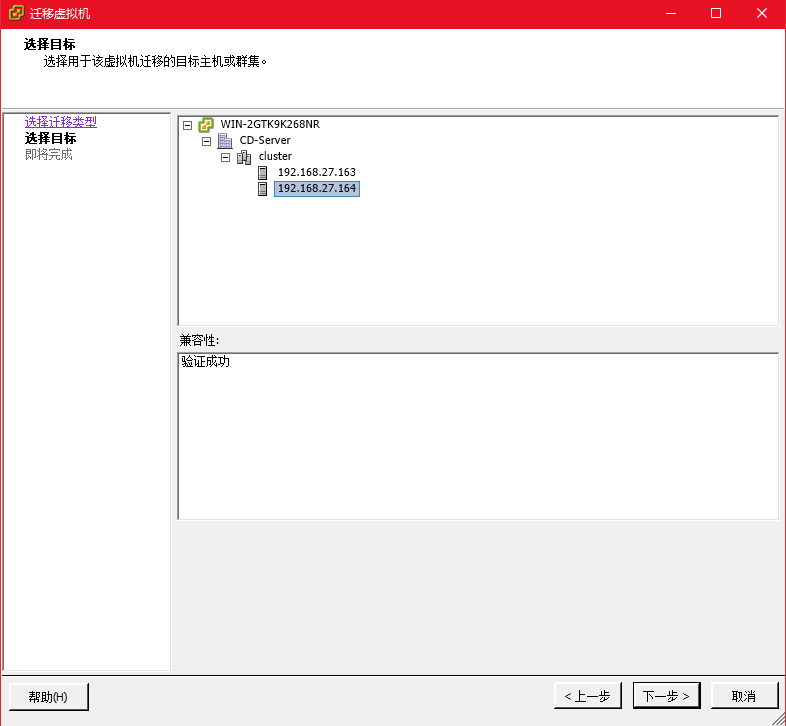

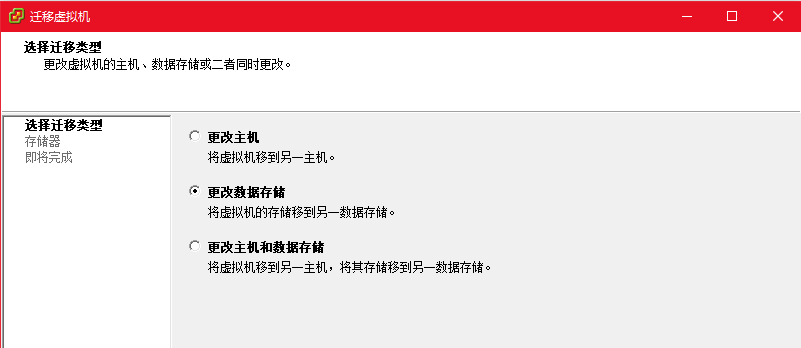

选择要迁移选项,有三个选项,此处我们选择更改主机,由于虚拟机文件放在独立的 iSCSI 上,所以不需要迁移文件,当然也可以同时选择更改数据存储,或者俩者同时(适用于维护的情况)。

选择要迁移到哪个主机

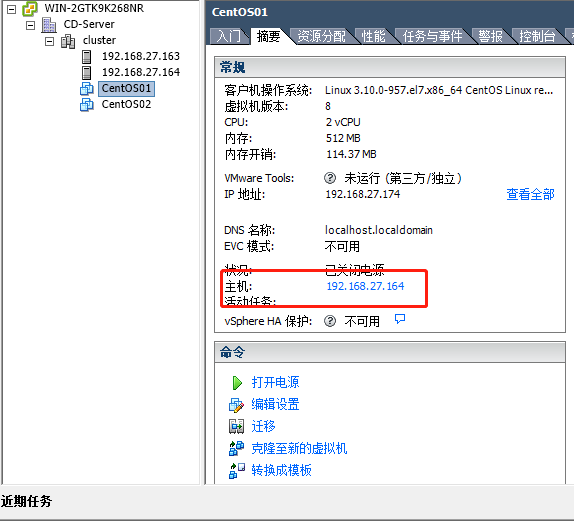

注意查看所属主机,已经迁移成功

2)Storage vMotion

SvMotion 需要俩个或以上存储设备,并且网络连通,而且主机 CPU 必须支持 VMotion。

SvMotion 原理和 VMotion 类似,因为是切换存储,所以并不需要内存的克隆,单纯的文件在不同的存储之间克隆,因此比 VMotion 相对简单。操作同 VMotion 类似,选择更改数据存储即可。

总结:VMotion 是一切高级 VI 架构的基础,ESX 的 DRS,HA,FT 等高级功能,都需要VMotion 来支持,VMotion 操作简单,不过需要强大的硬件来支持,因此,一般较大型的公司或者对 IT 投入比较重视的公司才会使用。但是相对于投入所获得的高稳定性回报是值得的。

3 vSphere DRS 实战

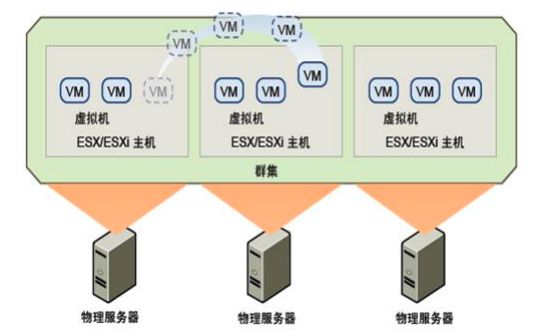

多台 ESX host 组成一个集群 cluster,可以提供相同的高级功能。通常同一机房计算机会放入一个 DataCenter,提供同一功能的多台 ESX 服务器会放入一个集群 cluster 当中。

vSphere Distributed Resource Scheduler(DRS) 的主要功能是将多个 host 构成的的群集 cluster 作为一个计算资源进行管理(主要是 CPU、内存、存储的管理)。可以将虚拟机分配到群集,DRS 会找到运行该虚拟机的相应主机。DRS 放置虚拟机以平衡群集中的负载,并强制执行群集范围内的资源分配策略(如预留、优先级和限制)。打开虚拟机电源时,DRS 在主机上执行虚拟机的初始放置。当群集条件更改(例如,负载和可用资源)时,DRS 可根据需要使用 vMotion 将虚拟机迁移到其他主机。

vSphere DRS 原理图如下,通过观察可以知道,还是利用 Vmotion 的原理,将负荷高的 host 上的 vm 迁移到负荷相对低的 host 上面,以达到资源的合理分配。

DRS 收集群集(Cluster)中所有主机和虚拟机的资源使用情况信息,并在出现以下两种情况之一时给出建议(或迁移虚拟机):

- 初始放置位置 – 当您首次启动群集中的某个虚拟机时,DRS 将放置该虚拟机或提出放置建议。

- 负载平衡 – DRS 会尝试通过执行虚拟机的自动迁移 (VMotion) 或提供虚拟机迁移建议提高群集中的资源利用率。

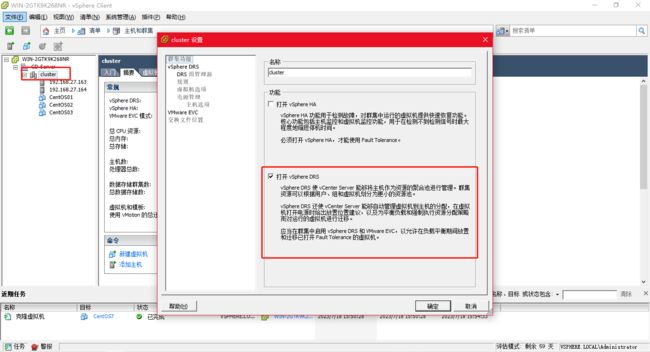

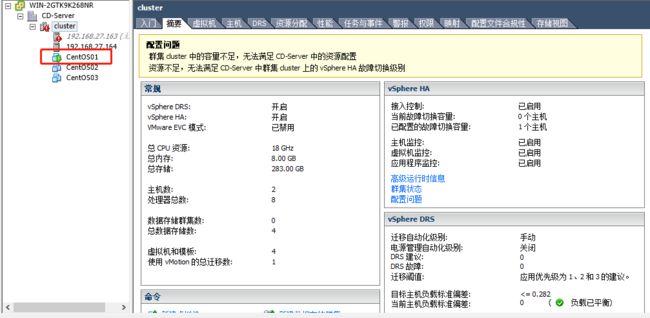

vSphere Cluster 的配置

右键点击数据中心“新建集群”,我这里之前已经建立好了。由于实验环境限制,还是使用俩台 ESX HOST 构建资源池。启用 cluster 的 DRS 功能。

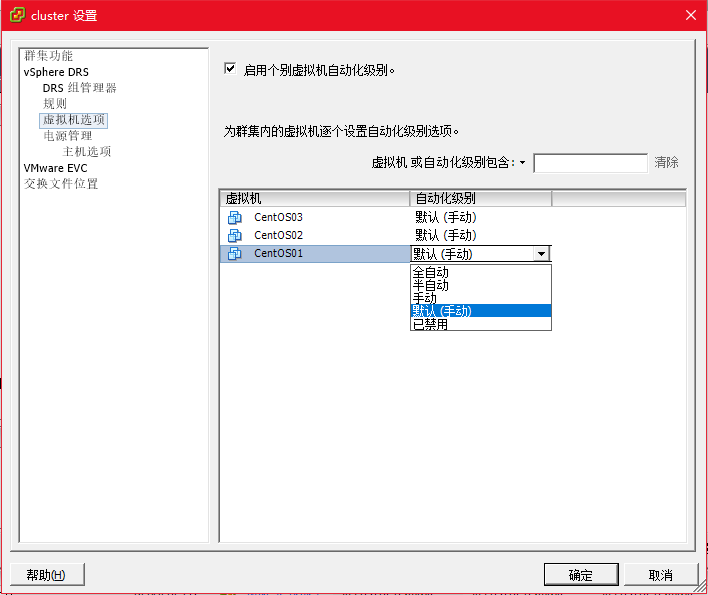

选择 DRS 级别,这里先选择手动,当然也可以选择自动,电源管理选择关闭即可。

虚拟机选项,可以设定特定的虚拟机,不使用 DRS 的默认级别。

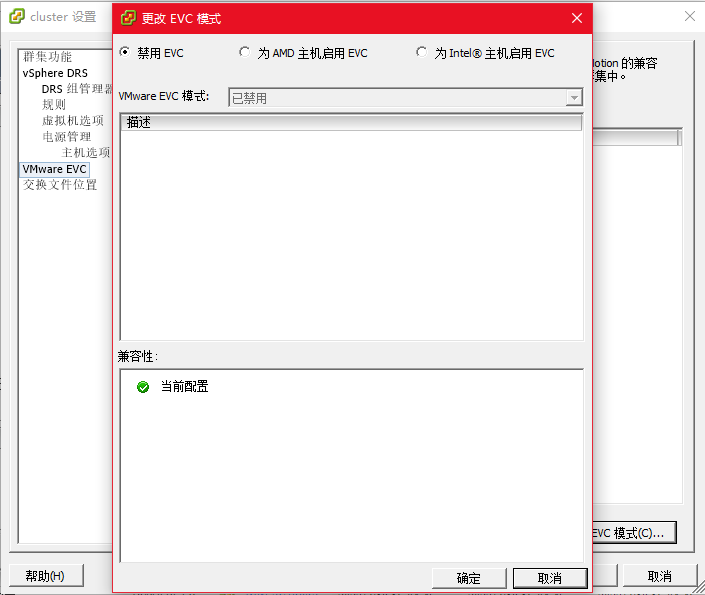

EVC 配置,这里选择不使用。

EVC(Enhanced vMotion Compatibility)是用于在具有不同型号的 Intel 或 AMD 系列 CPU 的主机之间实现虚拟机迁移的功能。它通过将 CPU 功能设置为一个共同的兼容性模式,使得不同型号的 CPU 之间可以相互迁移虚拟机。

然而,需要注意的是,尽管启用了 EVC,仍然无法将 Intel 服务器上的虚拟机迁移至 AMD 主机上。EVC 主要用于在同一CPU 系列内的主机之间实现迁移兼容性,例如在不同型号的 Intel Xeon 处理器之间迁移虚拟机。不同 CPU 架构(如 Intel 和 AMD)之间的迁移是不支持的,因为它们具有不同的指令集和架构。

因此,EVC 用于在具有相同 CPU 系列的主机之间实现虚拟机迁移兼容性,但无法将 Intel 服务器上的虚拟机迁移到 AMD 主机上,因为它们具有不同的 CPU 架构。

添加主机,已经在数据中心的主机可用直接拖动到集群中。

添加完之后可以看到在集群下面有两台 esx 主机和虚拟机,这些虚拟机属于集群而不是某台 esx 服务器

vSphere DRS 测试

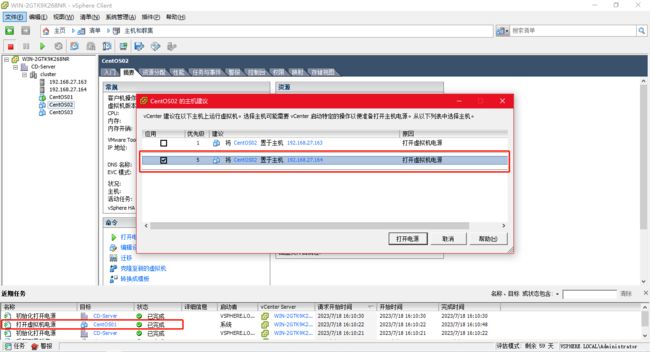

这里 DRS 级别是手动,所以在同一个主机上启动一台虚拟机时后,再启动一台虚拟机,DRS 会建议适合运行这台 VM 的最佳 ESX 主机。注意看优先级,这里仍然选择在 164 主机上启动虚拟机

查看 Cluster 的 DRS 界面,我们可以看到 DRS 已经显示 ESX/ESXi host 负载不均衡,并给出了它的建议:

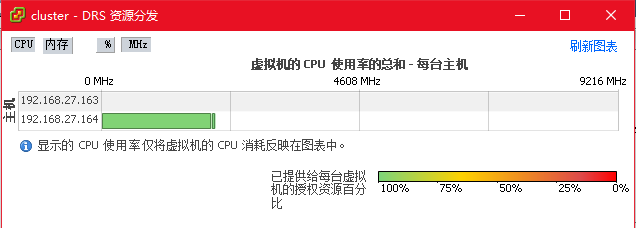

通过查看资源分发图表,从下图的 CPU 和内存的使用率可以看到,164 主机比 163 主机业务繁忙。

注意:在 DRS 栏中,选择应用手动或者半自动状态的 DRS 级别才会显示建议

一段时间后,Cluster 内的两台 Host 性能会得到均衡,DRS 自动把其中一台 VM 使用 vMotion 迁移到了另外一台主机中。

vSphere DRS 规则的设置

为了更加方便的使用,vSphere DRS 还设置了不同的应用规则,比方说限制某些 VM 必须在特定主机运行,或者某两个 VM 不能在同一主机运行等等。

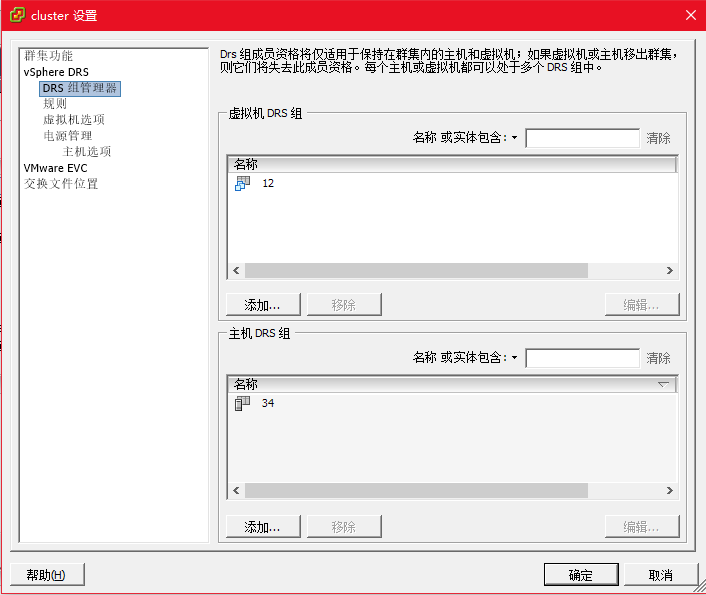

①首先创建一个 DRS 组,然后创建一个虚拟机的 DRS 组。

- 管理 DRS 组

DRS 组是虚拟机与主机间的关联性规则的基本组件。DRS 组可以是虚拟机 DRS 组或主机 DRS 组。 - 虚拟机-虚拟机关联性规则可指定各虚拟机之间的关联性或反关联性。

- 虚拟机与主机间的关联性规则指定一组虚拟机和一组主机之间的关联性关系。必须先创建应用该规则的 DRS 组(一个虚拟机组和一个主机组),然后才能创建虚拟机与主机间的关联性规则。

- 创建 DRS 组时,需要指定属于该组的虚拟机或主机。

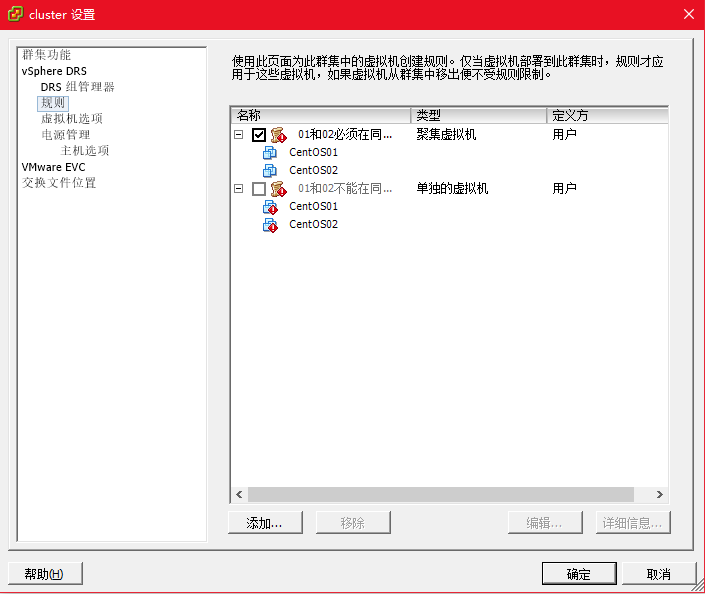

②规则类型

- 单独的虚拟机:指定 DRS 组的 VM 必须分开在不同的主机 DRS 组运行;

- 聚集的虚拟机:指定 DRS 组的 VM 必须分开在相同的主机 DRS 组运行;

- 虚拟机到主机:可以指定特定的 VM 组必须在组中的主机上运行,应在组中的主机上运行,不得在组中的主机上运行,不应在组中的主机上运行。

③使用 DRS 关联性规则

可以创建关联性规则,指定虚拟机之间或虚拟机组和主机组之间的关联性或反关联性。

- DRS 使用以下类型的规则:

- 虚拟机-虚拟机关联性规则

用于指定虚拟机组和主机组之间的关联性或反关联性。关联性规则规定,所选虚拟机 DRS 组的成员可以或必须在特定的主机 DRS 组成员上运行。反关联性规则规定,所选虚拟机 DRS 组的成员不能在特定的主机 DRS 组成员上运行。 - 虚拟机-主机关联性规则

用于指定各个虚拟机之间的关联性或反关联性。指定关联性的规则会使 DRS 尝试将指定的虚拟机一起保留在同一台主机上(例如,出于性能考虑)。根据反关联性规则,DRS 尝试将指定的虚拟机分开,例如,当一台主机出现问题时,将不会同时丢失两台虚拟机。

- 虚拟机-虚拟机关联性规则

如果俩个规则有冲突,那么是无法执行的

总结:Vsphere DRS 通过对 cluster 中的不同 host 的 vm 的管理,合理、有效的将集群中的 CPU、内存等资源进行分配,极大的解放了管理员的工作,这也是 vmware 的高明之处。当然,接下来我们会介绍 vmware HA 以及 FT 的功能,通过一系列的高级,vmware 基本保证了应用的零宕机,大大降低的企业的风险。

4 VMware HA 实战

DRS 的原理,将同一集群的不同主机的资源打包成一个资源池,然后通过 DRS 来管理整个资源池的 CPU 和内存资源

vmware HA 的工作原理:

VMware HA 不间断地监控群集中所有的 ESX Server 主机,并检测故障。放置在每台主机上的代理程序不断向群

集中的其他主机发出"心跳信号","心跳信号"的终止将启动所有受影响的虚拟机在其他主机上的重启过程。 HA

时刻监控群集中是否有足够的资源可用,以便在主机发生故障时能够在其他物理主机上重启虚拟机。利用 ESX

Server 存储堆栈中的锁定技术,可以使虚拟机的安全重启成为可能,它允许多个 ESX Server 同时访问同一虚拟

机文件

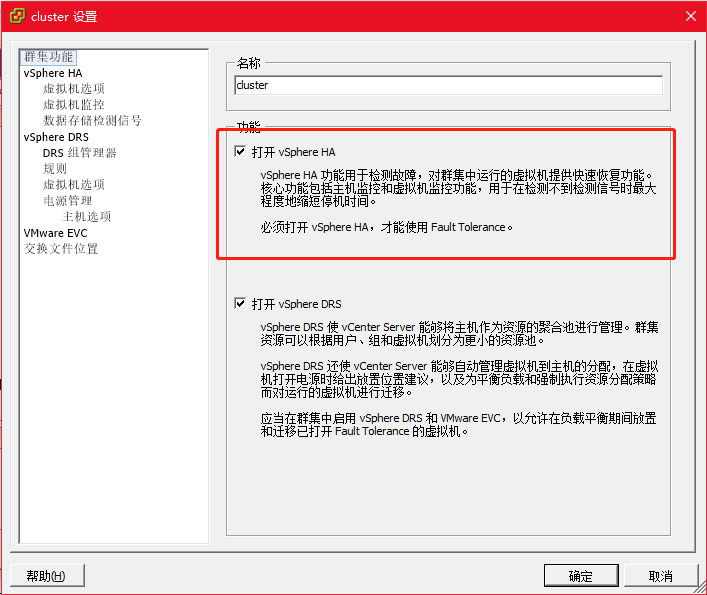

VMware HA 配置

需要两个独立的存储,再添加一个 openfiler

创建 VMware HA 群集

具体设置如下

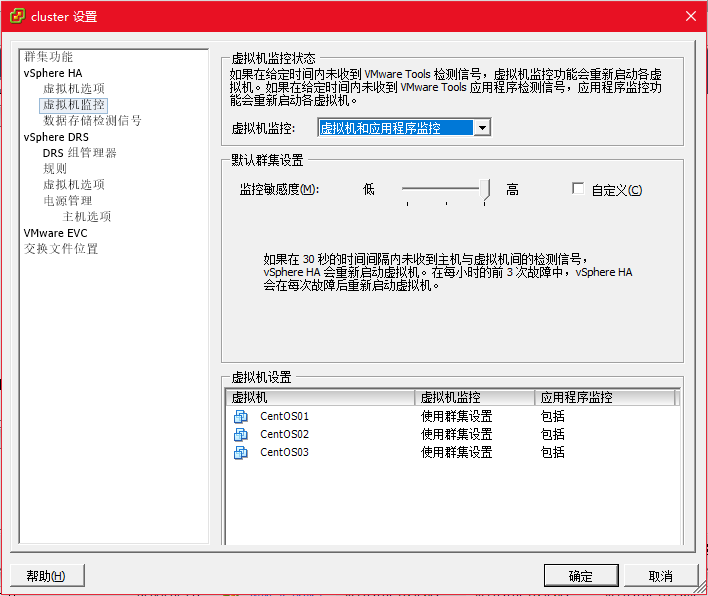

虚拟机监控功能,设置监控主机或者应用程序,我们这里需要监控应用程序 web 服务器。在任何集群/主机上 执

行维护操作时, 请禁用主机监视功能, 默认设置为启用

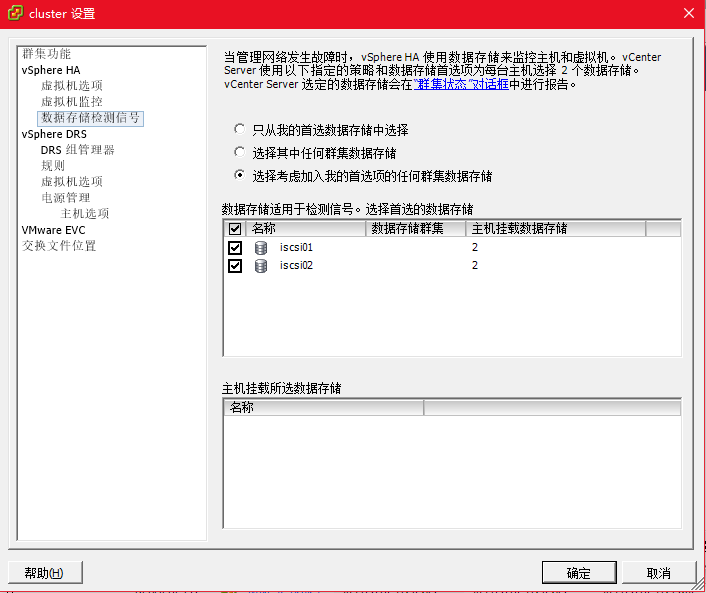

存储的检测配置

设置完成后,群集的属性多了个 HA。

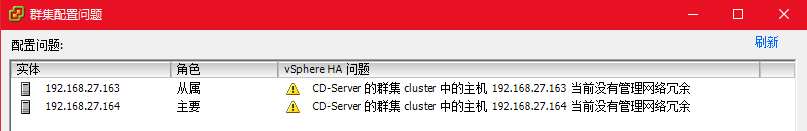

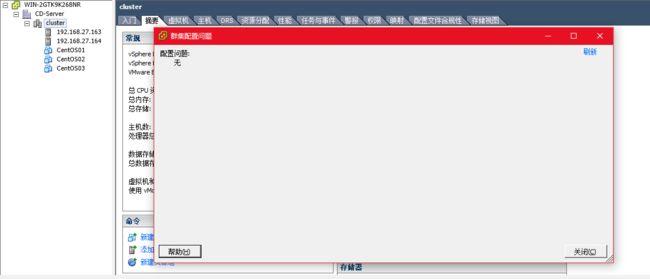

但是主机图标有黄色警告,可以点击配置问题查看警告

提示:没有管理网络冗余,这是因为连个主机都只配置了单网卡,所以没有多余的网络去冗余

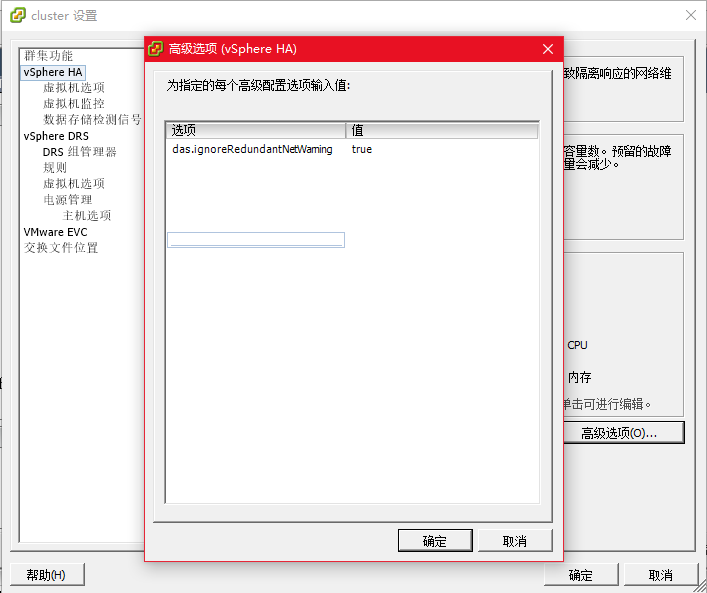

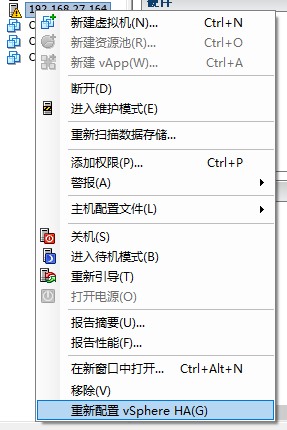

解决方法:进入vcenter—选择群集—编辑设置—Vsphere HA—高级选项—键入das.ignoreRedundantNetWarning,在值中输入true—确定—右键群集中主机—重新配置vsphere HA–报警消失

参考:https://blog.csdn.net/csgd2000/article/details/81178031

当然也可以再配置网卡来解决

VMware HA 测试

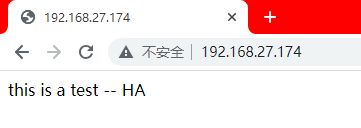

我们通过两个方面可以查看:一是通过建立 web 测试页面,将 CentOS01 所在主机关机后,如果仍然能够访问测试网页(因为 HA 是在另一主机上重启虚拟机,所以 apache 或者 nginx 需要设置为开机启动),则高可用成功;二是观察 vsphere client 上群集提示的状态,以及 CentOS01 是否断开后再启动

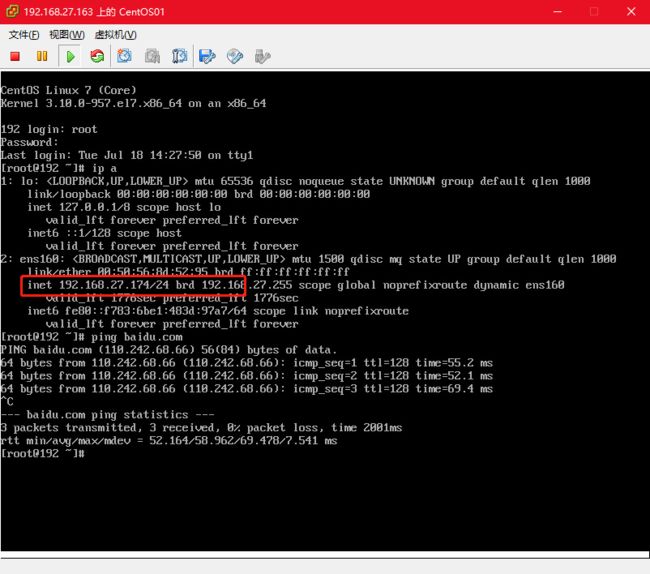

可以正常访问 web 测试页面

现在关闭主机

![]()

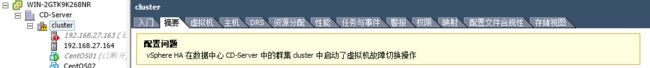

可以看到 163 的主机已经断开,同时 CentOS01 也断开连接。并且提示启动了虚拟机故障切换操作

等待…,可以看到 163 主机仍然断开连接,但是虚拟机已经启动了;使用 vMotion 的迁移数为1.

在真机上一直 ping CentOS01 ,能够看到有一段时间的请求超时,然后又可以 ping 通,说明高可用已经成功

![]()

同时,网页也可以访问。

5 物理主机 Windows 迁移到 ESXI 服务器

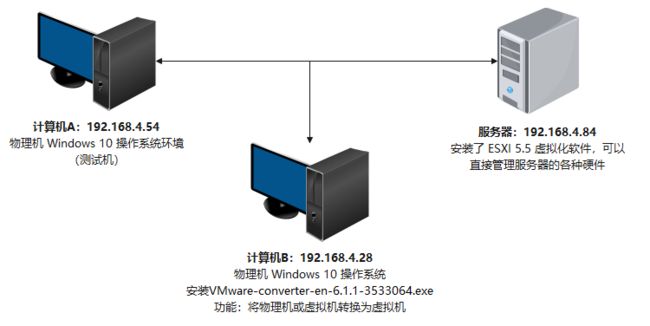

实验环境

转换物理主机时,VMware vCenter Convertaer Standalone 6.1.1 会使用克隆和系统重新配置步骤创建和配置目标虚拟机,以便目标虚拟机能够在 VMware vCenter ESXI 环境中正常工作。由于该迁移过程对源而言为无损操作,此因,转换完成后可继续使用原始源计算机,也称为热克隆。

VMware Converter Standalone 组建只能安装在 Window 操作系统上,VMware Converter Standalone 支持将 Windows 和 Linux 操作系统迁移到 VMware vCenter ESXI 服务器。

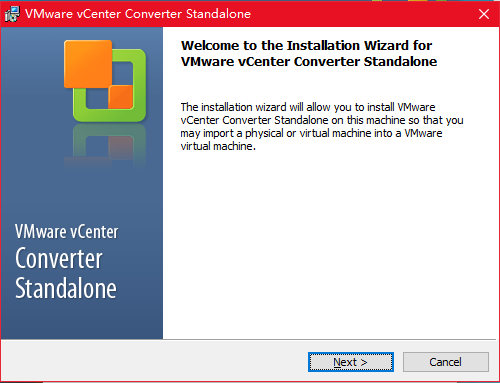

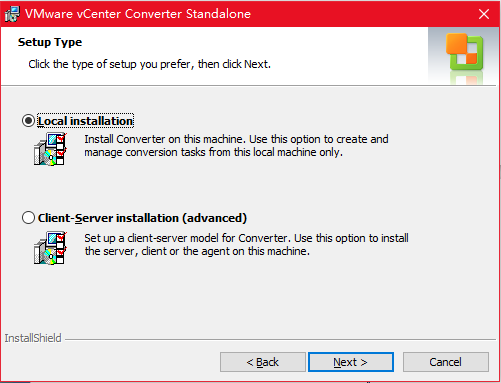

安装 VMware-converter-en-6.1.1-3533064.exe 软件

前往 http://www.vmware.com/cn.html 威睿官网下载 VMware Converter Standalone 6.1.1 版本或其它更高版本

接受默认,一直点击下一步安装即可

热克隆

确保 3 台主机能够互相 ping 通

暂时关闭计算机 A 的防火墙

计算机 A 需要设置管理员密码,并且需要登录管理员用户才有权限进行系统迁移

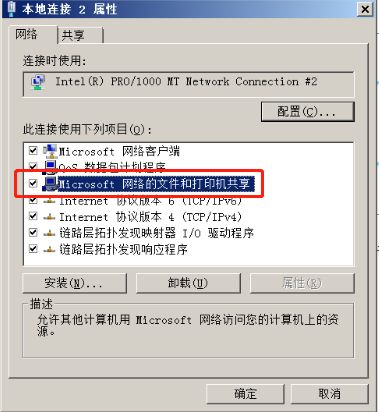

计算机 A 要设置允许共享访问

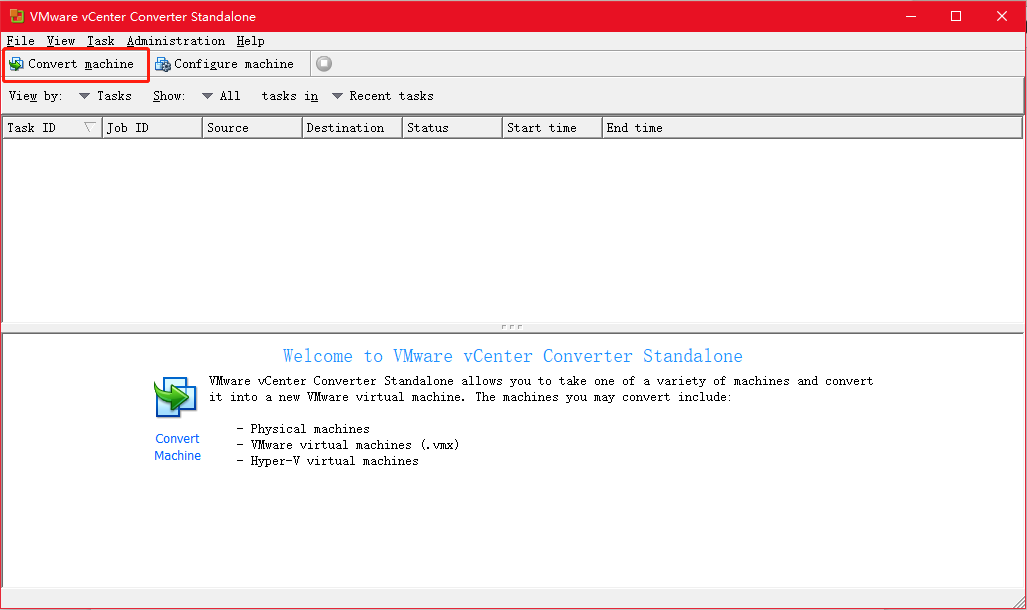

打开 VMware-converter-en-6.1.1 软件,点击 Conver gachine

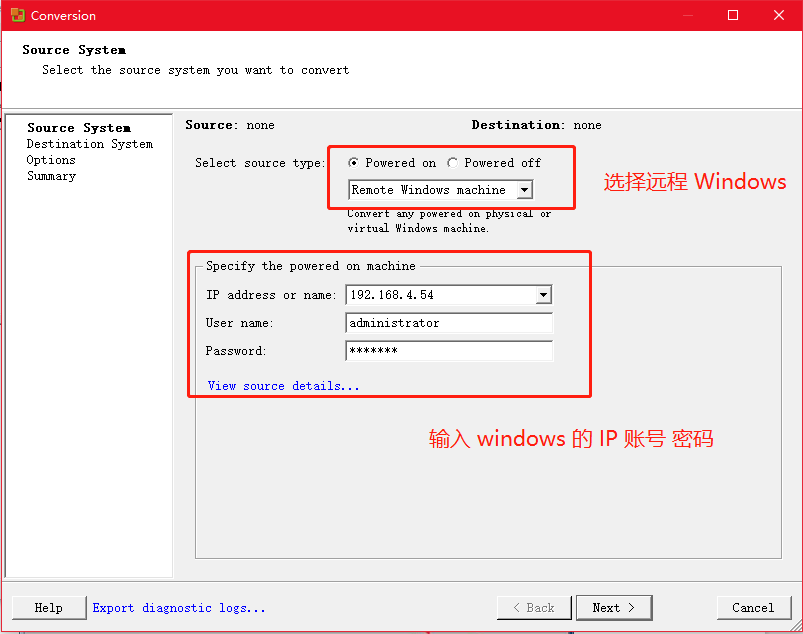

选择远程的 windows 电脑 ---- 输入计算机 A 的 IP 地址 ----- 输入计算 A 的 administrator 管理员用户及密码

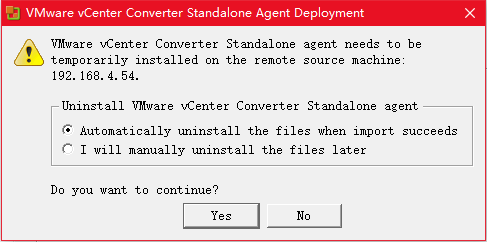

选择成功导入后自动卸载这些文件 — Yes

也就是在迁移时候会为计算机 A 安装代理,在迁移完成后自动卸载

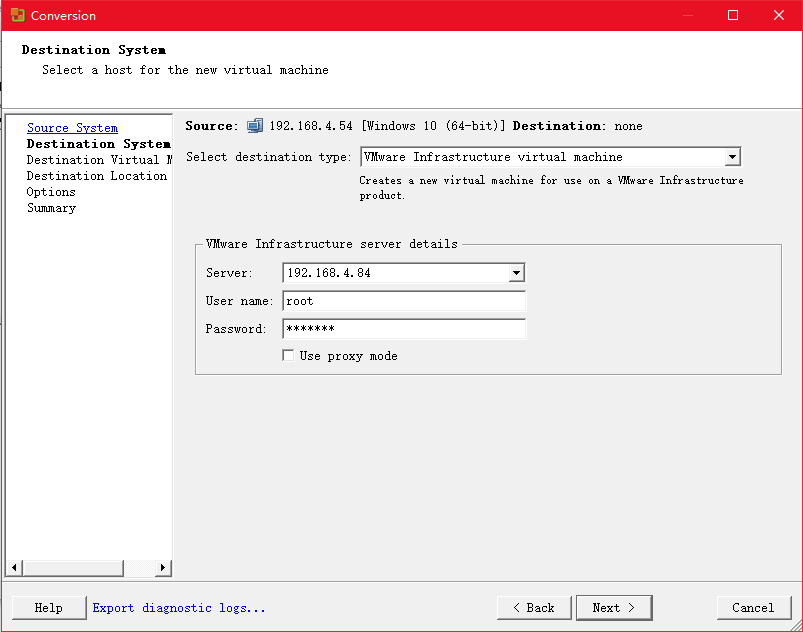

填写服务器 VMware ESXI 5.5 的 IP 地址、用户名、密码

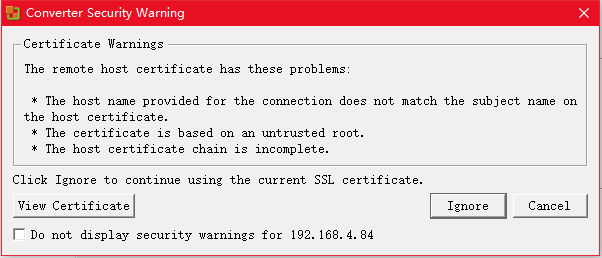

选择 Ignore

自定义迁移的物理服务器名称(建议使用英文命名)

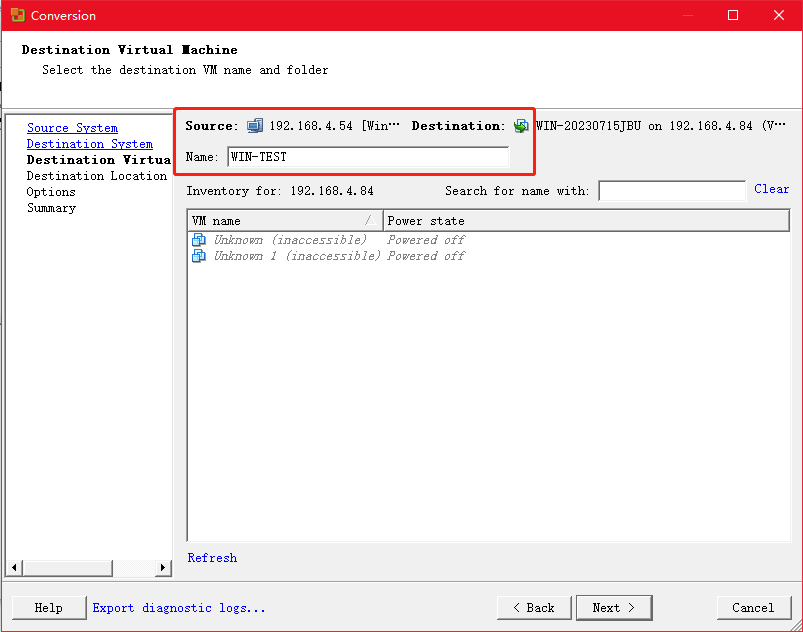

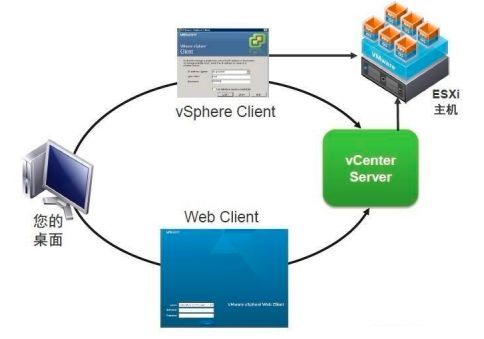

选择服务器 VMware ESXI — 服务器本地磁盘(如果有共享磁盘可以选择) — 选择虚拟机硬件兼容性版本 — Next

![]()

会报错

提示服务器的磁盘不符合计算机 A 磁盘的容量储存,需要进入编缉只保留计算机 A 的 C 盘,其它盘不需要迁

移即可

后面点击完成,等待传输完成即可

进入服务器 VMware ESXI 5 正常启动迁移的 win 系统

6 添加用户角色及分配权限

角色:各种角色定义了对此角色可操作细节的权限组合。

用户权限:用户权限是对 ESXi 5.0 中的对象实例(如 ESXi 5.0 主机,虚拟机,存储,网络等)进行权限的分配。通过在这些对象上绑定“用户+角色”来限定每个用户或用户组可以对此对象的操作权限。

- 创建步骤:

- 先创建角色并分配权限

- 创建用户并分配角色权限

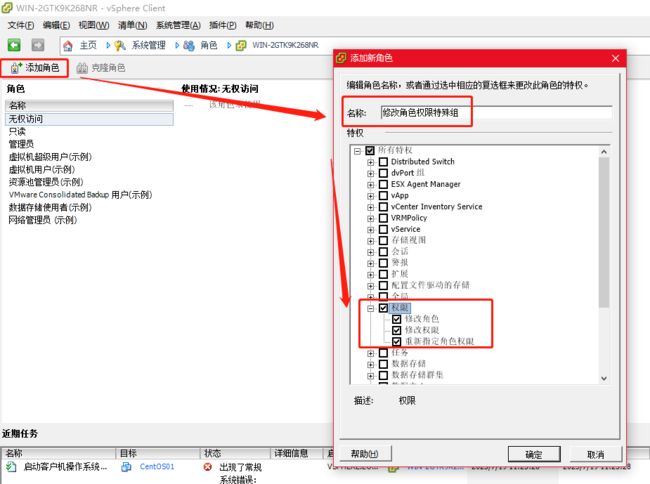

视图 ---- 系统管理 ---- 角色

![]()

添加角色 ---- 自定义角色名称 — 分配角色权限

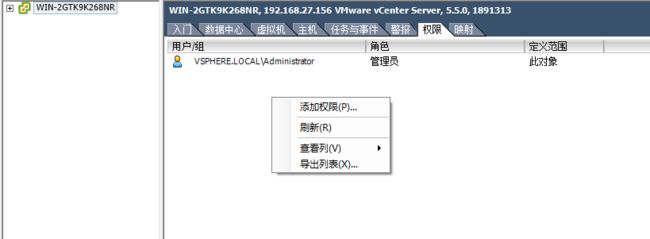

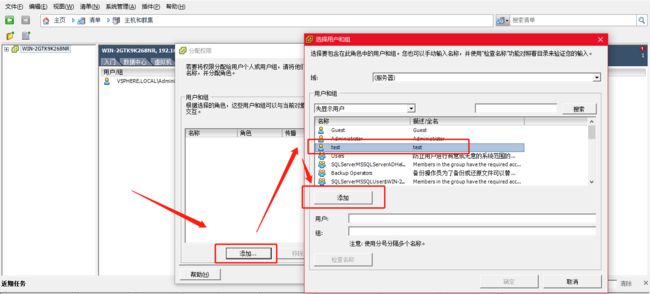

权限 — 添加权限(空白地方点击右键)

选择服务器创建好的本地用户 test

现在可以使用 test 账号登录到 vCenter server

7 VMware workstaion 上传虚拟机到 VMware EXSI 5.5

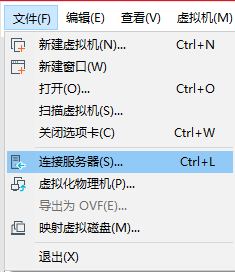

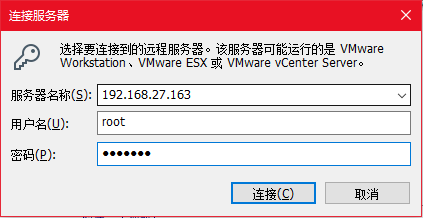

首先在 VMware Workstation 文件 — 连接 VMware EXSI5.5 服务器

输入 VMware EXSI 5.5 服务器地址、用户名和密码

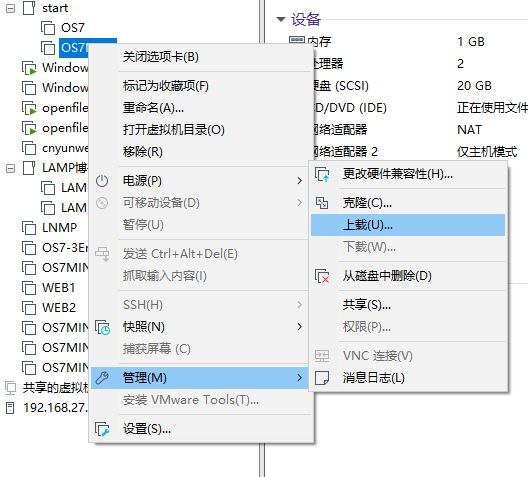

选择虚拟机–右键–选择上载

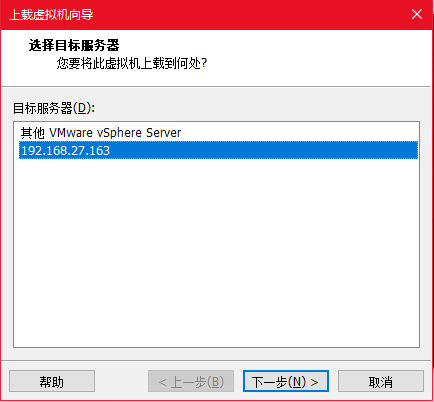

选择服务器

选择存储

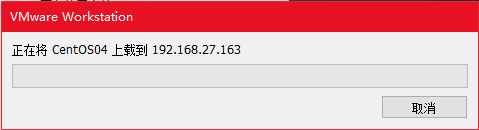

上载的虚拟机可以正常启动

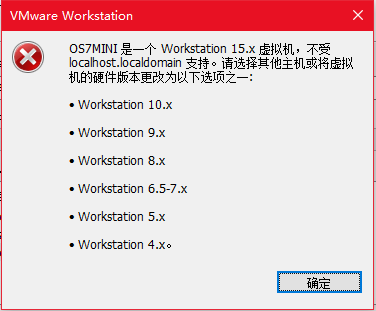

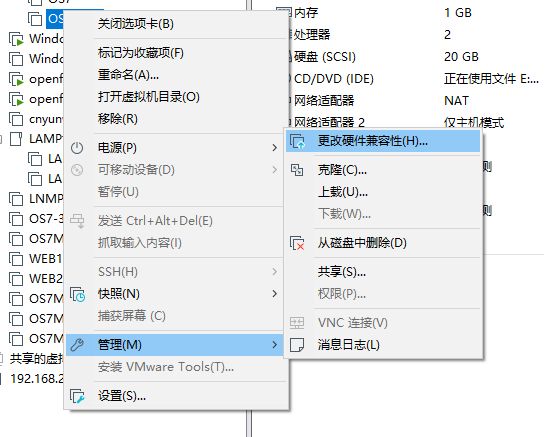

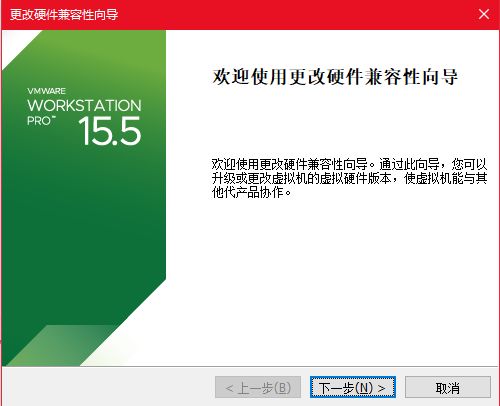

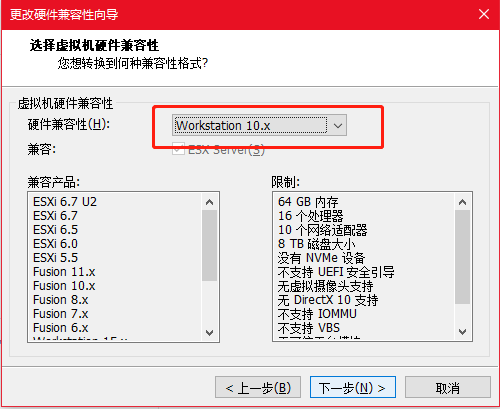

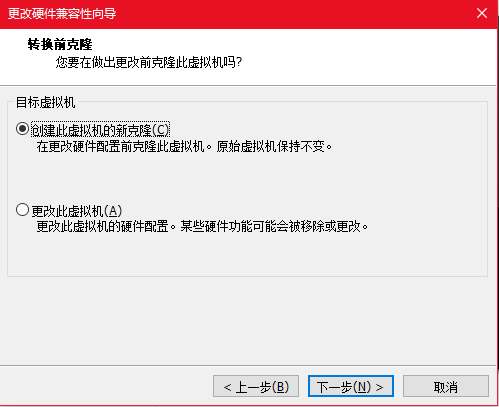

拓展:上载时出现硬件版本的报错

根据报错时的信息更改即可

![]()