【学习笔记、面试准备】机器学习西瓜书要点归纳和课后习题参考答案——第1章

机器学习西瓜书要点归纳

- 第1章 绪论

-

- 1.1 引言

- 1.2基本术语

- 1.3 假设空间

- 1.4 归纳偏好

- 1.5 发展历程

- 1.6 应用现状

- 1.7 阅读材料

- 习题

目录地址

第1章 绪论

1.1 引言

机器学习(machine learning):通过计算、利用经验,改善系统自身性能。

学习算法(learning algorithm):在计算机上从数据产生“模型”的算法。

模型(model)/学习器(learner):从数据中学得的结果。学习算法在给定数据和参数空间的实例化。

1.2基本术语

数据集(data set):数据记录的集合。

样本(sample)/示例(instance):一条数据记录。

属性(attribute)/特征(feature):反映对象在某方面的性质的事项。

属性值(attribute value):属性的取值。

属性空间(attribute space)/样本空间(sample space)/输入空间:属性张成的空间。

一个具体的张的例子是:将两条线段(或向量)在平面内任意“拉伸”、“延长”,使其成为由它们张成的平面三角形的两条边。

假设有两个向量 v 1 = [ 1 , 2 ] \boldsymbol{v_1}=[1,2] v1=[1,2], v 2 = [ 3 , 4 ] \boldsymbol{v_2}=[3,4] v2=[3,4],我们可以通过对它们进行线性组合,得到一个平面上的向量:

v 3 = a v 1 + b v 2 = [ 1 2 ] a + [ 3 4 ] b \boldsymbol{v_3}=a\boldsymbol{v_1}+b\boldsymbol{v_2}=\begin{bmatrix} 1 \\ 2 \end{bmatrix}a + \begin{bmatrix} 3 \\ 4 \end{bmatrix}b v3=av1+bv2=[12]a+[34]b

其中 a , b a,b a,b 是实数系数。此时, v 1 \boldsymbol{v_1} v1 和 v 2 \boldsymbol{v_2} v2 张成了一个平面, v 3 \boldsymbol{v_3} v3 是由这两个向量线性组合而成的新向量,也处于这个平面中。如果我们选择合适的 a a a 和 b b b,就可以让 v 3 \boldsymbol{v_3} v3 位于这个平面上的任意点,从而“张开”整个平面。

维数(dimensionality):每个示例由维数个属性描述。

学习(learning)/训练(training):从数据中学得模型的过程。

训练数据(training data):训练过程中使用的数据。

训练样本(training sample):训练数据的一个样本。

训练集(training set):训练样本组成的集合。

假设(hypothesis):学得模型对应某一种规律。

举例来说,如果我们使用线性回归模型来预测房屋的价格,那么我们的假设可能是关于房屋价格和该地区各种属性(例如房屋面积、楼层、位置等)之间的线性关系。

真相/真实(ground-truth):数据的潜在规律。

预测(prediction):推断结果。

训练集也算

标记(label):示例的结果。

样例(example):拥有标记信息的样本。

例就是示范的意思。

标记空间(label space)/输出空间:标记张成的空间。

分类(classification):预测离散值。

回归(regression):预测连续值。

二分类(binary classification):2个类别的分类。

正类(positive class):二分类的一个类。

反类(negative class):二分类的另一个类。

多分类(multi-class classification):多个类别的分类。

至少2个

测试(testing):使用学得模型预测。

测试样本(testing sample):被预测的样本。

聚类(clustering):把训练集分为若干组。

簇(cluster):聚类的一组。

监督学习(supervised learning):训练有标记信息。

无监督学习(unsupervised learning):训练无标记信息。

泛化(generalization):学得模型适用于新样本的能力。

分布(distribution):随机变量一定范围内所有可能取值的概率情况。

独立同分布(independent and identically distributed,i.i.d.):每个样本是独立在分布上采样获得的。

一次输入一个样本,不管其他信息,故此。

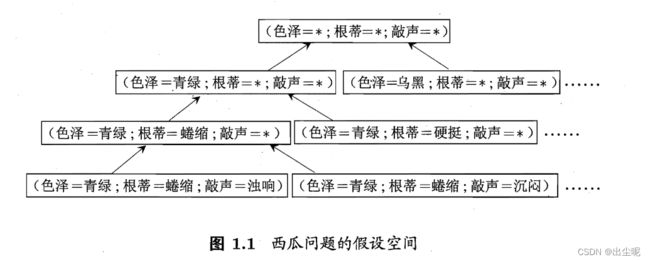

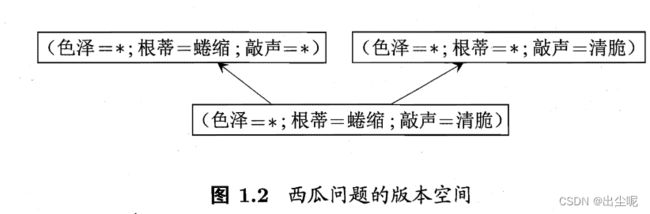

1.3 假设空间

泛化(generalization):特殊到一般。

归纳(induction):泛化过程。

特化(specialization):一般到特殊。

演绎(deduction):特化过程。

归纳学习(inductive learning):“从样例学习”的归纳。

概念(concept):狭义归纳学习要求从训练数据学到的规则。

举例:好瓜是XXX的

匹配(fit):通过训练数据拟合模型的过程。

假设空间:所有假设集合。

版本空间(version space):所有与训练数据一致的假设集合。

1.4 归纳偏好

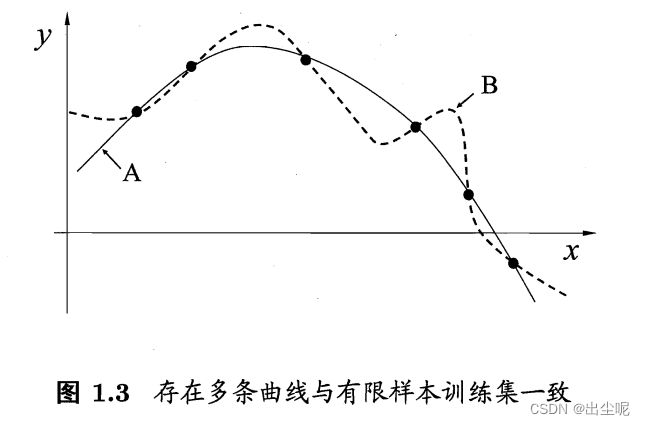

归纳偏好(inductive bias):机器学习算法在学习过程中对某种类型假设的偏好。

奥卡姆剃刀(Occam’s razor)原则:若有多个假设与观察一致,则选最简单的那个。

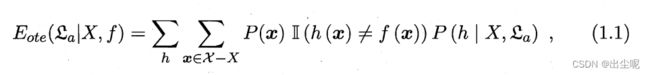

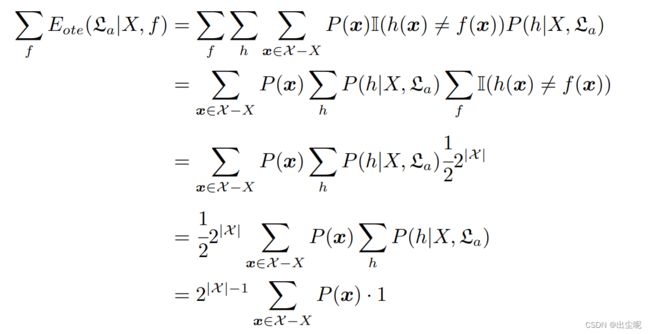

没有免费的午餐(No Free Lunch Theorem,NFL)定理:在所有可能的数据分布上,所有算法的期望性能都是相同的。

(要考虑学习算法自身归纳偏好要和问题相配)

理解:参考这篇

直观上是求期望的具体式子。

理解:参考南瓜书

直观上,当真实分布是均匀随机的,什么算法都是猜。

1.5 发展历程

1.6 应用现状

1.7 阅读材料

习题

参考这里