快速部署ChatGLM-6B大模型实战总结

作者简介:赵辉,区块链技术专家,精通各种联盟链、公链的底层原理,拥有丰富的区块链应用开发经验。

近期,IT界掀起了大模型的热潮,各种百模争霸的局面出现。我对新技术充满热情,积极体验各类 GPT AI 产品,包括领先的 GPT 龙头 ChatGPT,百度的文心一言和文心千帆、阿里的通义千问以及金山的 WPSAI 等。

作为这些产品的忠实测试者之一,我同时也尝试过这些产品的 API 接口,与微信对接,实现了微信聊天机器人。然而,当开源的大模型 ChatGLM 面世时,我却遇到了一些困扰,但幸运的是,腾讯云给了我一个难得的机会。

腾讯云最近推出一项限时特惠活动,仅需72元/15天就能获得计算型 GPU 云服务器,让我有机会亲自体验自建模型和微调训练的过程。我把这份自建模型的乐趣写成文字,分享给你。

服务器

凭手速迅速抢到了一台GPU云服务器,以下是配置信息:

配置环境

下载项目仓库

root@VM-0-17-ubuntu:~# git clone https://github.com/THUDM/ChatGLM-6B

root@VM-0-17-ubuntu:~# cd ChatGLM-6B/构建conda环境

root@VM-0-17-ubuntu:~# conda create --name chatglm python=3.8

root@VM-0-17-ubuntu:~# conda activate chatglm下载依赖

在conda虚拟环境下,下载chatglm需要的依赖文件, 这里需要的时间比较长,需要耐心等待:

root@VM-0-17-ubuntu:~# pip install -r requirements.txt你以为就是上面简单的几句命令吗,中间安装的过程充满了各种异常、困难需要解决,这里不一一列出,如果你去真正做一次,就会深刻体会“知易行难”这句话。

数据模型

下载安装git-lfs

root@VM-0-17-ubuntu:~# apt-get install git-lfs

root@VM-0-17-ubuntu:~# git lfs install下载模型文件

https://github.com/THUDM/ChatGLM-6B 官方网站

从ChatGLM的官方库中下载,将模型文件我放到工程的 ChatGLM-6B/THUDM 目录下面。

root@VM-0-17-ubuntu:~# cd ChatGLM-6B && mkdir THUDM

root@VM-0-17-ubuntu:THUDM# git lfs clone https://huggingface.co/THUDM/chatglm-6b模型文件比较大(25G),这里下载需要的时间很长,请耐心等待,以下是目录下载后模型目录下的文件:

测试

终端运行 Demo

进入ChatGLM-6b工程的根目录。执行python cli_demo.py

终于看到了成果,虽然对于一些知识的回答不准确,但这只是数据问题,程序还是跑起来了。

Web端运行

进入 ChatGLM-6B 工程的根目录,执行如下命令:

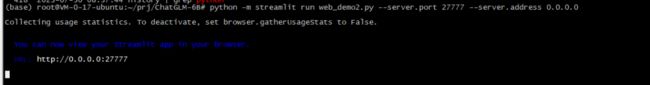

root@VM-0-17-ubuntu:ChatGLM-6B# python -m streamlit run web_demo2.py --server.port 27777 --server.address 0.0.0.0执行成功的效果如下: 打开浏览器可见到如下界面:

打开浏览器可见到如下界面: 跟它对话一下,看看效果:

跟它对话一下,看看效果:

实战总结

经过长达12小时的折腾,终于把公开的模型跑起来,虽然步骤不多,但中间也确实遇到了一些问题,比如系统依赖库缺失,网络环境依赖,下载速度缓慢等,但终究体验了一把模型在自己手上的感觉。使用感觉上,自建模型不如ChatGPT,跟文心一言、WPSAI是差不多,反应速度还可以。

公开的模型跑起来,接下来才是重头戏:微调训练数据,打造属于自己的专有模型,请保持继续关注。有兴趣的小伙伴,欢迎留言交流探讨。

公众号回复“Claude实战”,“ChatGPT实战”,“WPSAI实战”,获取相应的电子书。

码字不易,如果对你有帮助的话,记得「在看」和「分享」,谢谢你!

—扩 展 阅 读—

正在发生或即将发生的AI大模型应用,立帖为证

AI 写作30 秒上手,可别再说写作没思路了

ChatGPT、Claude和Bard,三足鼎立之势已成

WPS Office AI实战总结,智能化办公时代已来

你对 ChatGPT 的所有疑问,看这这一篇文章就够了