Spark学习笔记11:RDD算子

目录

一、RDD算子

二、准备工作

(一)准备文件

1、准备本地系统文件

2、准备HDFS系统文件

(二)启动Spark Shell

1、启动HDFS服务

2、启动Spark服务

3、启动Spark Shell

三、转化算子

(一)映射算子 - map()

1、映射算子功能

2、映射算子案例

A、将rdd1每个元素翻倍得到rdd2

B、将rdd1每个元素平方得到rdd2

1、采用普通函数作为参数传给map()算子

2、用下划线表达式作为参数传给map()算子

C:利用映射算子打印菱形

(二)过滤算子 - filter()

1、过滤算子功能

2、过滤算子案例

a、过滤出列表中的偶数

b、过滤出文件中包含指定字符的行

(三)扁平映射算子 - flatMap()

1、扁平映射算子功能

2、扁平映射算子案例

A、统计文件中单词个数

B、统计不规则二维列表元素个数

1、利用Scala实现

2、利用Spark RDD实现

(四)按键归约算子 - reduceByKey()

1、按键归约算子功能

2、按键归约算子案例

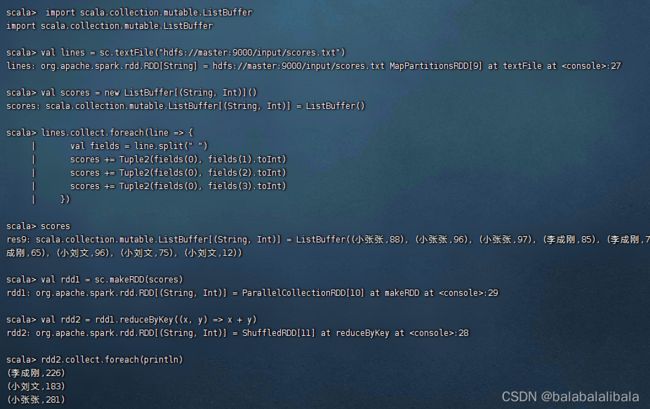

A、在Spark Shell里计算学生总分

B、在IDEA里计算学生总分

C、读取HDFS上的成绩文件

(五)合并算子 - union()

1、合并算子功能

2、合并算子案例

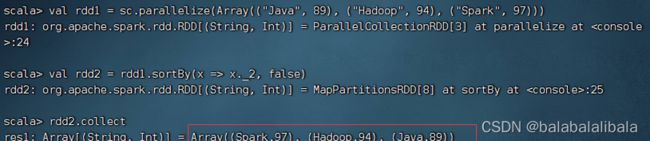

(六)排序算子 - sortBy()

1、排序算子功能

2、排序算子案例

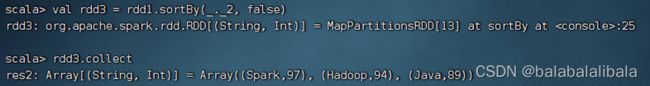

(七)按键排序算子 - sortByKey()

1、按键排序算子功能

2、按键排序算子案例

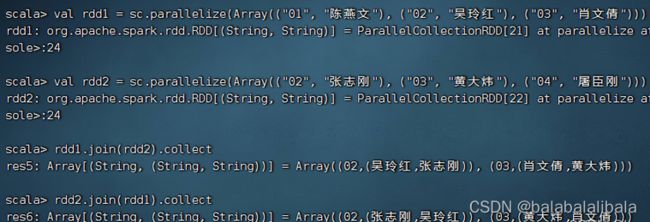

(八)连接算子

1、内连接算子 - join()

(1)内连接算子功能

(2)内连接算子案例

2、左外连接算子 - leftOuterJoin()

(1)左外连接算子功能

(2)左外连接算子案例

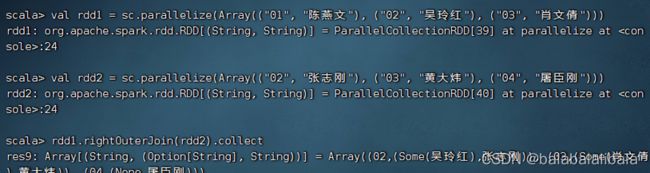

3、右外连接算子 - rightOuterJoin()

(1)右外连接算子功能

(2)右外连接算子案例

4、全外连接算子 - fullOuterJoin()

(1)全外连接算子功能

(2)全外连接算子案例

(九)交集算子 - intersection()

1、交集算子功能

2、交集算子案例

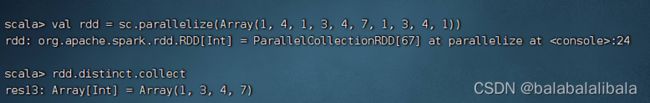

(十)去重算子 - distinct()

1、去重算子功能

2、去重算子案例

(十一)组合分组算子 - cogroup()

1、组合分组算子功能

2、组合分组算子案例

四、行动算子

(一)归约算子 - reduce()

1、归约算子功能

2、归约算子案例

(三)按键计数算子 - countByKey()

1、按键计数算子功能

2、按键计数算子案例

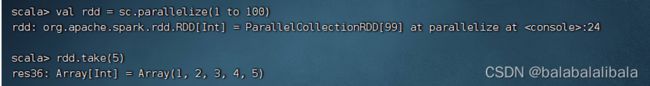

(四)前截取算子 - take(n)

1、前截取算子功能

2、前截取算子案例

(五)遍历算子 - foreach()

1、遍历算子功能

2、遍历算子案例

(六)存文件算子 - saveAsFile()

1、存文件算子功能

2、存文件算子案例

一、RDD算子

- RDD被创建后是只读的,不允许修改。Spark提供了丰富的用于操作RDD的方法,这些方法被称为算子。一个创建完成的RDD只支持两种算子:转化(Transformation)算子和行动(Action)算子。

二、准备工作

(一)准备文件

1、准备本地系统文件

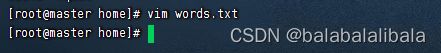

在/home目录里创建words.txt

2、准备HDFS系统文件

将words.txt上传到HDFS系统的/park目录里

(二)启动Spark Shell

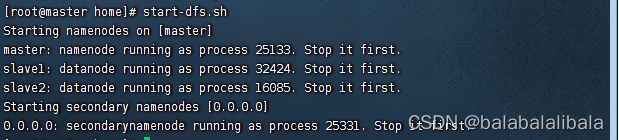

1、启动HDFS服务

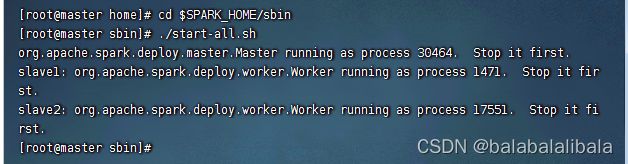

2、启动Spark服务

进入Spark的sbin目录执行命令:./start-all.sh

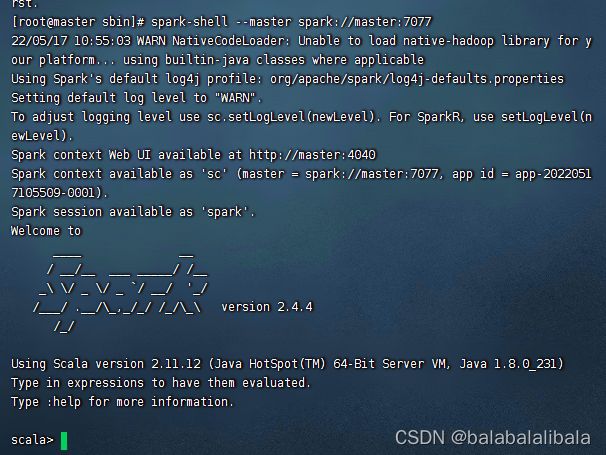

3、启动Spark Shell

执行名命令: spark-shell --master spark://master:7077

三、转化算子

转化算子负责对RDD中的数据进行计算并转化为新的RDD。Spark中的所有转化算子都是惰性的,因为它们不会立即计算结果,而只是记住对某个RDD的具体操作过程,直到遇到行动算子才会与行动算子一起执行。

(一)映射算子 - map()

1、映射算子功能

map()是一种转化算子,它接收一个函数作为参数,并把这个函数应用于RDD的每个元素,最后将函数的返回结果作为结果RDD中对应元素的值。

2、映射算子案例

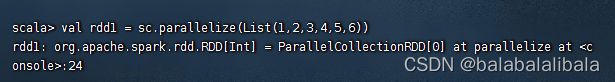

创建一个RDD

A、将rdd1每个元素翻倍得到rdd2

对rdd1应用map()算子,将rdd1中的每个元素平方并返回一个名为rdd2的新RDD

Spark会将RDD中的每个元素传入该函数的参数中,rdd1和rdd2中实际上没有任何数据,因为parallelize()和map()都为转化算子,调用转化算子不会立即计算结果。若需要查看计算结果,则可使用行动算子collect()。

执行rdd2.collect()进行计算,并将结果以数组的形式收集到当前Driver。因为RDD的元素为分布式的,数据可能分布在不同的节点上。

向map()算子传入函数的参数可以用下划线_来代替,并且可以简化成_ * 2

- 把 x => func(x) 简化为 func _ 或 func 的过程称为

eta-conversion - 把 func 或 func _ 展开为 x => func(x) 的过程为

eta-expansion

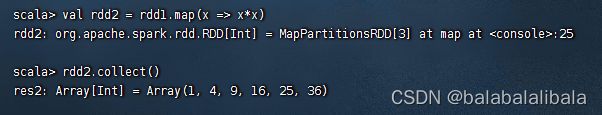

B、将rdd1每个元素平方得到rdd2

1、采用普通函数作为参数传给map()算子

2、用下划线表达式作为参数传给map()算子

- 平方应该是

map(_ * _)

![]()

报错,(_ * _)经过eta-expansion变成普通函数,引入幂函数scala.math.pow,并保证下划线表达式里下划线只出现1次就可以完成。

- rdd2的元素变成了双精度实数,得转化成整数

C:利用映射算子打印菱形

(二)过滤算子 - filter()

1、过滤算子功能

- 通过函数func对源RDD的每个元素进行过滤,并返回一个新的RDD。

2、过滤算子案例

a、过滤出列表中的偶数

基于列表创建RDD,然后利用过滤算子得到偶数构成的新RDD

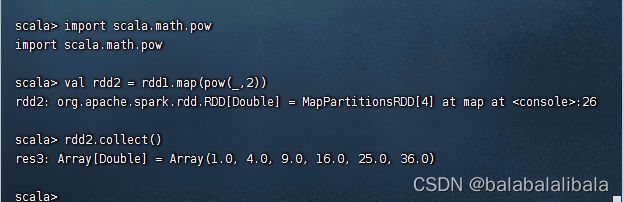

b、过滤出文件中包含指定字符的行

- 读取文件

/park/words.txt生成RDD -lines

- 过滤包含S

park的行生成RDD -sparkLines

- 查看

sparkLines内容

(三)扁平映射算子 - flatMap()

1、扁平映射算子功能

- flatMap()算子与map()算子类似,但是每个传入给函数func的RDD元素会返回0到多个元素,最终会将返回的所有元素合并到一个RDD。

2、扁平映射算子案例

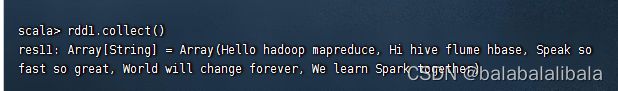

A、统计文件中单词个数

读取文件,生成RDD

按空格拆分,做扁平映射,生成新RDD

- 经过扁平映射,生成的RDD是一个单词构成一个元素

查询单词个数

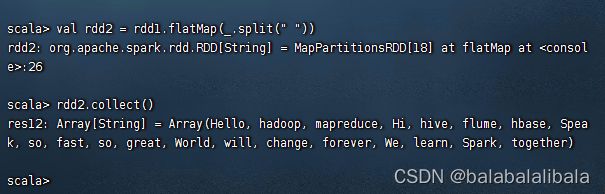

B、统计不规则二维列表元素个数

1、利用Scala实现

2、利用Spark RDD实现

val rdd1 = sc.makeRDD(List(List(7, 8, 1, 5),

List(10, 4, 9),

List(7, 2, 8, 1, 4),

List(21, 4, 7, -4)))

val rdd2 = rdd1.flatMap(x => x.toString.substring(5, x.toString.length - 1).split(", "))

println("元素个数:" + rdd2.count)

查看内容

(四)按键归约算子 - reduceByKey()

1、按键归约算子功能

reduceByKey()算子的作用对像是元素为(key,value)形式(Scala元组)的RDD,使用该算子可以将相同key的元素聚集到一起,最终把所有相同key的元素合并成一个元素。该元素的key不变,value可以聚合成一个列表或者进行求和等操作。最终返回的RDD的元素类型和原有类型保持一致。

2、按键归约算子案例

A、在Spark Shell里计算学生总分

val scores = List(("张钦林", 78), ("张钦林", 90), ("张钦林", 76),

("陈燕文", 95), ("陈燕文", 88), ("陈燕文", 98),

("卢志刚", 78), ("卢志刚", 80), ("卢志刚", 60))

val rdd1 = sc.makeRDD(scores)

val rdd2 = rdd1.reduceByKey((x, y) => x + y)

rdd2.collect.foreach(println)

![]()

B、在IDEA里计算学生总分

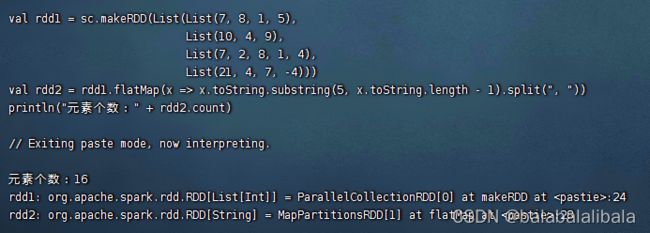

下载安装hadoop-2.7.7

- 下载对应版本的

winutils.exe,放在hadoop安装目录的bin子目录里

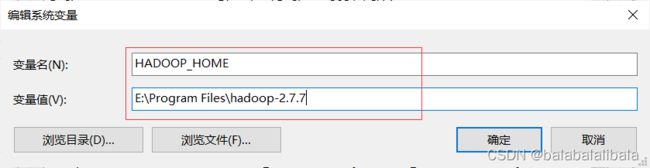

配置环境变量

- 添加系统变量

- 在path里添加%HADOOP_HOME%\bin;

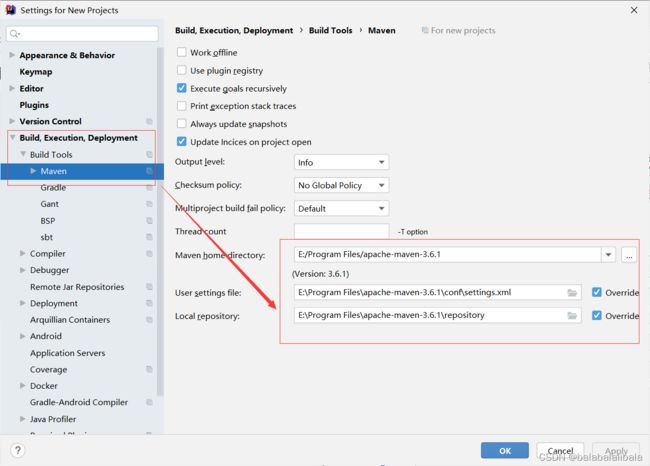

在IDEA里对Maven进行配置

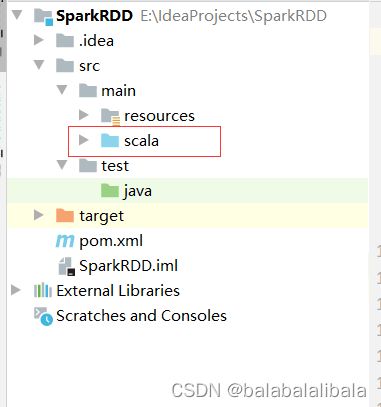

创建Maven项目 - SparkRDD

将java目录重命名为scala

在pom.xml文件里添加依赖和构建插件

4.0.0

net.ydl.rdd

SparkRDD

1.0-SNAPSHOT

org.scala-lang

scala-library

2.12.15

org.apache.spark

spark-core_2.12

2.4.4

src/main/scala

org.apache.maven.plugins

maven-assembly-plugin

3.3.0

jar-with-dependencies

make-assembly

package

single

net.alchim31.maven

scala-maven-plugin

3.3.2

scala-compile-first

process-resources

add-source

compile

scala-test-compile

process-test-resources

testCompile

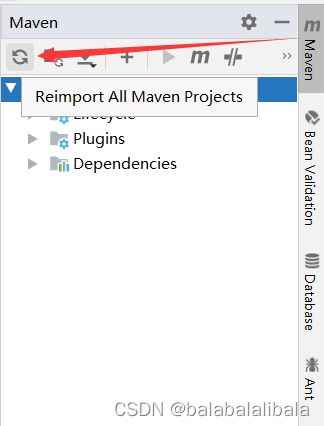

安装Maven依赖

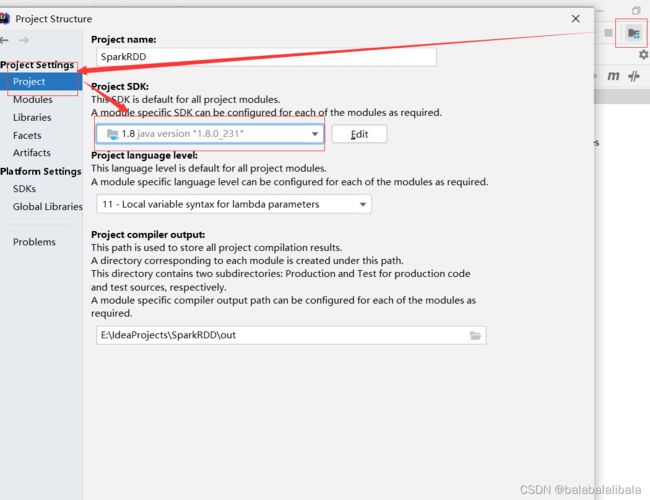

检查JDK

在resource文件夹里创建日志属性文件log4j.properties

log4j.rootLogger=ERROR, stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spark.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

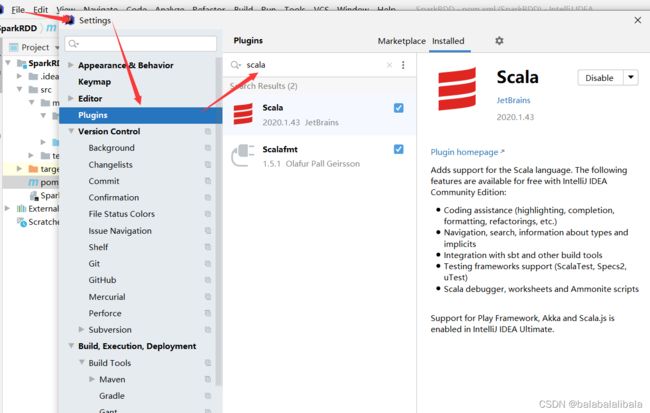

下载Scala插件

创建net.ydl.rdd包,在包里创建CalculateScoreSum单例对象

package net.ydl.rdd

import org.apache.spark.{SparkConf, SparkContext}

object CalculateScoreSum {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("CalculateScoreSum")

.setMaster("local[*]")

// 基于配置创建Spark上下文

val sc = new SparkContext(conf)

// 创建成绩列表

val scores = List(("张钦林", 78), ("张钦林", 90), ("张钦林", 76),

("陈燕文", 95), ("陈燕文", 88), ("陈燕文", 98),

("卢志刚", 78), ("卢志刚", 80), ("卢志刚", 60))

// 基于成绩列表创建RDD

val rdd1 = sc.makeRDD(scores)

// 对成绩RDD进行按键归约处理

val rdd2 = rdd1.reduceByKey((x, y) => x + y)

// 输出归约处理结果

rdd2.collect.foreach(println)

}

}

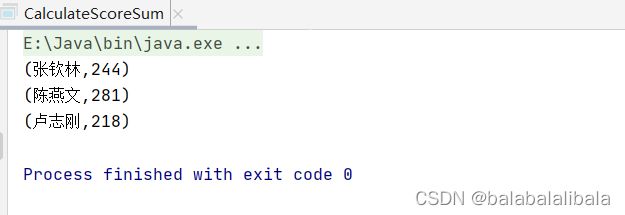

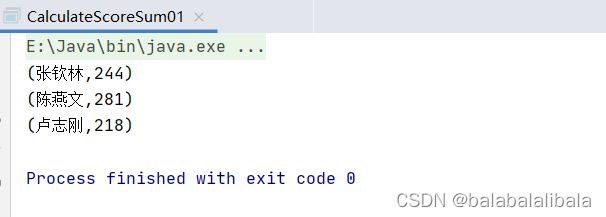

运行

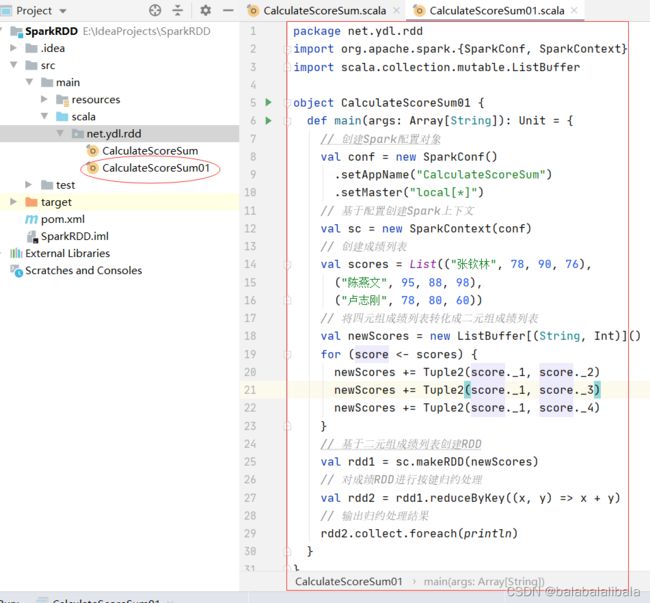

在net.ydl.rdd包里创建CalculateScoreSum01单例对象

package net.ydl.rdd

import org.apache.spark.{SparkConf, SparkContext}

import scala.collection.mutable.ListBuffer

object CalculateScoreSum01 {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("CalculateScoreSum")

.setMaster("local[*]")

// 基于配置创建Spark上下文

val sc = new SparkContext(conf)

// 创建成绩列表

val scores = List(("张钦林", 78, 90, 76),

("陈燕文", 95, 88, 98),

("卢志刚", 78, 80, 60))

// 将四元组成绩列表转化成二元组成绩列表

val newScores = new ListBuffer[(String, Int)]()

for (score <- scores) {

newScores += Tuple2(score._1, score._2)

newScores += Tuple2(score._1, score._3)

newScores += Tuple2(score._1, score._4)

}

// 基于二元组成绩列表创建RDD

val rdd1 = sc.makeRDD(newScores)

// 对成绩RDD进行按键归约处理

val rdd2 = rdd1.reduceByKey((x, y) => x + y)

// 输出归约处理结果

rdd2.collect.foreach(println)

}

}

运行结果

C、读取HDFS上的成绩文件

注意:要打开Master进程

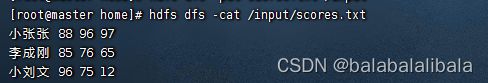

在master虚拟机的/home目录里创建scores.txt文件

将文件上传到/input目录

![]()

查看文件内容

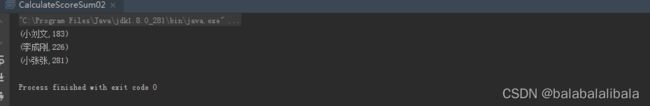

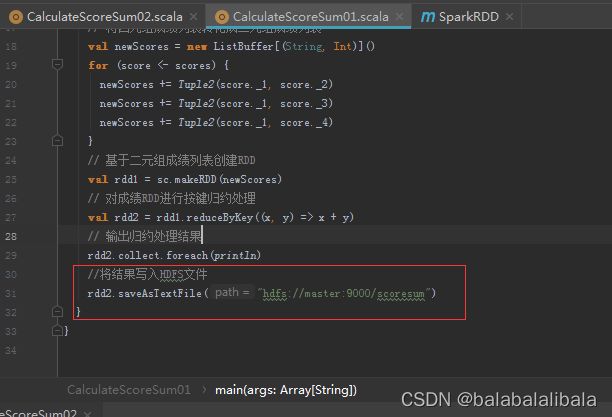

在net.ydl.rdd包里创建CalculateScoreSum02单例对象

package net.ydl.rdd

import org.apache.spark.{SparkConf, SparkContext}

import scala.collection.mutable.ListBuffer

object CalculateScoreSum02 {

def main(args: Array[String]): Unit = {

// 创建Spark配置对象

val conf = new SparkConf()

.setAppName("CalculateScoreSum")

.setMaster("local[*]")

// 基于配置创建Spark上下文

val sc = new SparkContext(conf)

// 读取成绩文件,生成RDD

val lines = sc.textFile("hdfs://master:9000/input/scores.txt")

// 定义二元组成绩列表

val scores = new ListBuffer[(String, Int)]()

// 遍历lines,填充二元组成绩列表

lines.collect.foreach(line => {

val fields = line.split(" ")

scores += Tuple2(fields(0), fields(1).toInt)

scores += Tuple2(fields(0), fields(2).toInt)

scores += Tuple2(fields(0), fields(3).toInt)

})

// 基于二元组成绩列表创建RDD

val rdd1 = sc.makeRDD(scores)

// 对成绩RDD进行按键归约处理

val rdd2 = rdd1.reduceByKey((x, y) => x + y)

// 输出归约处理结果

rdd2.collect.foreach(println)

}

}

运行程序

在Spark Shell完成

将计算结果写入HDFS文件

//将结果写入HDFS文件

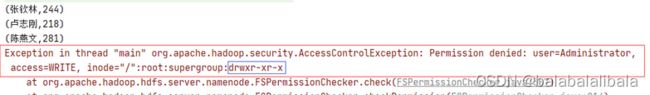

rdd2.saveAsTextFile("hdfs://master:9000/scoresum")运行程序

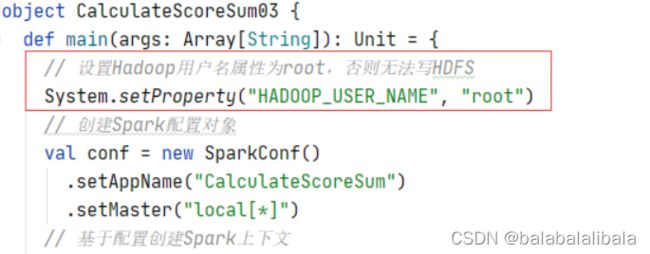

- 如果运行报错,提示没有写入权限

- 设置

HADOOP_USER_NAME属性为root

查看HDFS上生成的文件

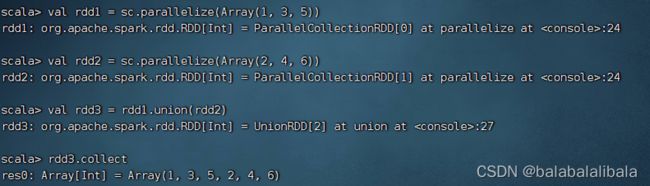

(五)合并算子 - union()

1、合并算子功能

union()算子将两个RDD合并为一个新的RDD,两个RDD中的数据类型要保持一致。

2、合并算子案例

(六)排序算子 - sortBy()

1、排序算子功能

sortBy()算子将RDD中的元素按照某个规则进行排序。该算子的第一个参数为排序函数,第二个参数是一个布尔值,指定升序(默认)或降序。若需要降序排列,则需将第二个参数置为false

2、排序算子案例

在一个数组中存放三个元组,将该数组转为RDD集合,然后对该RDD按照每个元素中的第二个值进行降序排列。

sortBy(x=>x._2,false)也可以直接简化为sortBy(_._2,false)。

(七)按键排序算子 - sortByKey()

1、按键排序算子功能

sortByKey()算子将(key,value)形式的RDD按照key进行排序。默认升序,若需降序排列,则可以传入参数false。

2、按键排序算子案例

将三个二元组构成的RDD按键先降序排列,然后升序排列

(八)连接算子

1、内连接算子 - join()

(1)内连接算子功能

join()算子将两个(key, value)形式的RDD根据key进行连接操作,只返回两个RDD都匹配的内容。

(2)内连接算子案例

2、左外连接算子 - leftOuterJoin()

(1)左外连接算子功能

leftOuterJoin()算子与数据库的左外连接类似,以左边的RDD为基准。Some和None都属于Option类型,Option类型用于表示一个值是可选的(有值或无值)。若确定有值,则使用Some(值)表示该值;若确定无值,则使用None表示该值。

(2)左外连接算子案例

3、右外连接算子 - rightOuterJoin()

(1)右外连接算子功能

rightOuterJoin()算子以右边的RDD为基准(例如rdd1.rightOuterJoin(rdd2),以rdd2为基准)

(2)右外连接算子案例

4、全外连接算子 - fullOuterJoin()

(1)全外连接算子功能

fullOuterJoin()算子与数据库的全外连接类似,相当于对两个RDD取并集,两个RDD的记录都会存在。值不存在的取None。

(2)全外连接算子案例

(九)交集算子 - intersection()

1、交集算子功能

intersection()算子对两个RDD进行交集操作,返回一个新的RDD

2、交集算子案例

(十)去重算子 - distinct()

1、去重算子功能

distinct()算子对RDD中的数据进行去重操作,返回一个新的RDD

2、去重算子案例

(十一)组合分组算子 - cogroup()

1、组合分组算子功能

cogroup()算子对两个(key, value)形式的RDD根据key进行组合,相当于根据key进行并集操作

2、组合分组算子案例

四、行动算子

Spark中的转化算子并不会马上进行运算,而是在遇到行动算子时才会执行相应的语句,触发Spark的任务调度。

(一)归约算子 - reduce()

1、归约算子功能

reduce()算子按照传入的函数进行归约计算

2、归约算子案例

计算 1 + 2 + 3 + … … + 100 1 + 2 + 3 + …… + 100 1+2+3+……+100的值

(三)按键计数算子 - countByKey()

1、按键计数算子功能

- 按键统计RDD键值出现的次数,返回由键值和次数构成的映射

2、按键计数算子案例

使用该List集合创建一个RDD,然后对其进行countByKey()的计算

(四)前截取算子 - take(n)

1、前截取算子功能

返回RDD的前n个元素(同时尝试访问最少的partitions),返回结果是无序的

2、前截取算子案例

(五)遍历算子 - foreach()

1、遍历算子功能

计算 RDD中的每一个元素,但不返回本地

2、遍历算子案例

(六)存文件算子 - saveAsFile()

1、存文件算子功能

- 将RDD数据保存到本地文件或HDFS文件