Hadoop 重启流程

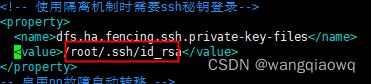

因原有配置密钥目录有误,需要重启Hadoop集群 3个节点,Hadoop版本3.3.2

1、Zookeeper 分别在3个节点重新启动

/opt/apache-zookeeper-3.7.0-bin/bin/zkServer.sh start

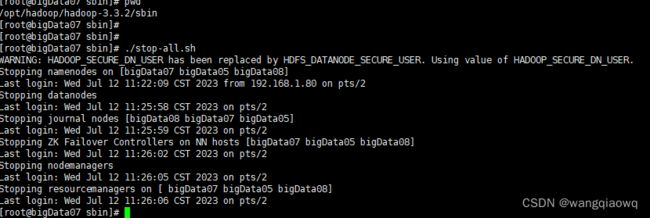

2、主节点 stop-all.sh

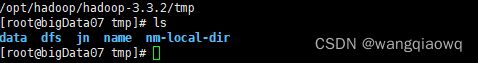

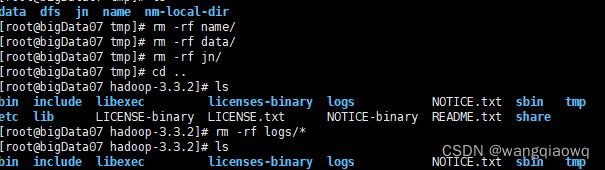

2、主节点删除所有的临时目录 log日志,包含在xml设定的还有默认的

在各个节点删除

rm -rf tmp/name/*

rm -rf tmp/data/*

rm -rf tmp/jn/*

rm -rf logs/*

rm -rf /tmp/hadoop-root-datanode.pid

rm -rf /tmp/hadoop-root-journalnode.pid

rm -rf /tmp/hadoop-root-zkfc.pid

rm -rf /tmp/hadoop-root-resourcemanager.pid

3、主节点 hdfs zkfc -formatZK

hdfs zkfc -formatZK

2)在各个JournalNode节点上,输入以下命令启动journalnode服务

[ root@hadoop102 ~]$ hdfs --daemon start journalnode

[ root@hadoop103 ~]$ hdfs --daemon start journalnode

[ root@hadoop104 ~]$ hdfs --daemon start journalnode

3)在[nn1]上,对其进行格式化,并启动

[ root@hadoop102 ~]$ hdfs namenode -format

[ root@hadoop102 ~]$ hdfs --daemon start namenode

4)在[nn2]和[nn3]上,同步nn1的元数据信息

[ root@hadoop103 ~]$ hdfs namenode -bootstrapStandby

[ root@hadoop104 ~]$ hdfs namenode -bootstrapStandby

5)启动[nn2]和[nn3]

[ root@hadoop103 ~]$ hdfs --daemon start namenode

[ root@hadoop104 ~]$ hdfs --daemon start namenode

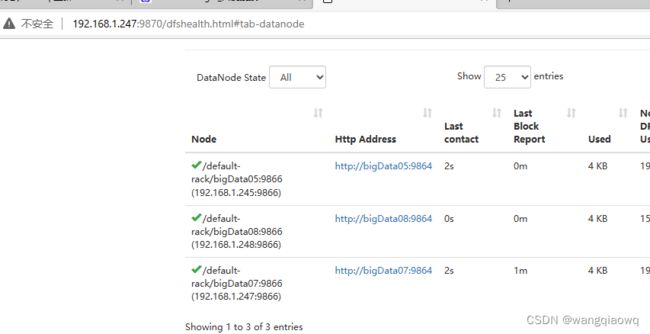

7)在所有节点上,启动datanode

[ root@hadoop102 ~]$ hdfs --daemon start datanode

[ root@hadoop103 ~]$ hdfs --daemon start datanode

[ root@hadoop104 ~]$ hdfs --daemon start datanode

8)格式化zkfc

[ root@hadoop102 ~]$ hdfs zkfc -formatZK

9)在所有nn节点启动zkfc

[ root@hadoop102 ~]$ hdfs --daemon start zkfc

[ root@hadoop103 ~]$ hdfs --daemon start zkfc

[ root@hadoop104 ~]$ hdfs --daemon start zkfc

10)第二次启动可以通过脚本启动和关闭集群

[ root@hadoop102 ~]$ start-dfs.sh

[ root@hadoop102 ~]$ stop-dfs.sh

rm -rf /tmp/hadoop-yarn-root/

启动yarn集群

./start-yarn.sh

启动flink yarn session

./bin/yarn-session.sh -d