- python将网银web工程转换成客户端electron工程案例

银行金融科技

人工智能机器学习DeepSeekelectron

以下是一个将网银Web工程转换为Electron客户端的技术方案,结合Python和Electron实现桌面端增强功能:bash#项目结构webank-electron/├──main/#Electron主进程代码│├──main.js│└──python_server.py├──renderer/#网页渲染进程│└──webank-web/#原始网银Web工程├──package.json└──

- 基于ChatGPT、GIS与Python机器学习的地质灾害风险评估、易发性分析、信息化建库及灾后重建高级实践

weixin_贾

防洪评价风险评估滑坡泥石流地质灾害

第一章、ChatGPT、DeepSeek大语言模型提示词与地质灾害基础及平台介绍【基础实践篇】1、什么是大模型?大模型(LargeLanguageModel,LLM)是一种基于深度学习技术的大规模自然语言处理模型。代表性大模型:GPT-4、BERT、T5、ChatGPT等。特点:多任务能力:可以完成文本生成、分类、翻译、问答等任务。上下文理解:能理解复杂的上下文信息。广泛适配性:适合科研、教育、行

- GitHub项目推荐--基于LLM的开源爬虫项目

惟贤箬溪

穷玩Aigithub爬虫

以下是一些基于大语言模型(LLM,LargeLanguageModel)的开源爬虫项目,它们结合了自然语言处理(NLP)技术与爬虫的功能,能在一定程度上提升爬取的智能化和精度。这些项目可以用于自动化抓取、内容提取、数据分析等任务。1.GPT-3WebScraper简介:这是一个基于OpenAIGPT-3模型的网页抓取工具,利用GPT-3的自然语言理解能力来生成有用的爬虫策略、处理网页内容并提取有价

- PHP与Java的区别分析

Monika Zhang

java架构设计phpjava开发语言

一、语言特点php:一种的像Python的动态弱语言类型的服务器脚本语言,不需要编译代码;它是专为Web开发目的而开发和设计的,而且简单容易上手。Java:是一种通用的面向对象编程语言,属于强势优选语言类型,在执行前必须先正确编译。是面向对象的和人类可读的;支持服务器端和客户端;可用于开发独立应用程序或基于Web的应用程序,上手比PHP难。二、语法1.PHP是一种脚本语言,代码在服务器上执行,而结

- 闭包的概念总结与分析

Monika Zhang

javajava

1定义闭包又称词法闭包闭包最早定义为一种包含和的实体.在计算机科学中,闭包(英语:Closure),又称词法闭包(LexicalClosure)或函数闭包(functionclosures),是引用了自由变量的函数。解释一:闭包是引用了自由变量的函数,这个被引用的变量将和这个函数一同存在。解释二:闭包是函数和相关引用环境组成的实体。注::除了局部变量的其他变量《Python核心编程》对闭包的解释:

- 毕业论文代码实验(Python\MATLAB)基于K-means聚类的EMD-BiLSTM-Attention光伏功率预测模型

清风AI

毕业设计代码实现pythonlstm深度学习神经网络人工智能matlabpytorch

一、项目背景1.1光伏功率预测意义在能源结构转型背景下(国家能源局2025规划),光伏发电渗透率已超过18%。但受天气突变、云层遮挡等因素影响,光伏出力具有显著波动性,导致:电网调度难度增加(±15%功率波动)电力市场交易风险提升光储协同控制效率降低1.2技术挑战多尺度特征耦合:分钟级辐照度变化与小时级天气模式共存非线性映射关系:气象因素与发电功率呈高阶非线性关系数据模态差异:数值天气预报(NWP

- DeepSeek 部署指南 (使用 vLLM 本地部署)

AGI大模型资料分享员

人工智能语言模型学习chatgpt深度学习大模型deepseek

DeepSeek部署指南(使用vLLM本地部署)本文档将指导您如何使用vLLM在本地部署DeepSeek语言模型。我们以deepseek-ai/DeepSeek-R1-Distill-Qwen-7B模型为例进行演示。1、安装Python环境首先,您需要安装Python环境。访问Python官网:https://www.python.org/根据您的操作系统选择安装包:Python官网提供Windo

- Python基础知识点总结

豆芽819

tippython开发语言

1Python简介Python特点:解释型语言:无需编译,逐行执行。动态类型:变量类型在运行时确定。简洁易读:语法接近自然语言,代码简洁。跨平台支持:Windows/Linux/macOS均可运行。应用领域:Web开发、数据分析、人工智能、自动化脚本等。开发环境:推荐使用IDLE、PyCharm、VSCode或JupyterNotebook。2Python数值运算基本运算符:算术:+,-,*,/,

- Python与区块链隐私保护技术:如何在去中心化世界中保障数据安全

Echo_Wish

Python!实战!区块链python去中心化

Python与区块链隐私保护技术:如何在去中心化世界中保障数据安全在区块链世界里,透明性和不可篡改性是两大核心优势,但这也带来了一个悖论——如何在公开账本的同时保障用户隐私?如果你的交易记录对所有人可见,如何防止敏感信息泄露?Python作为区块链开发中最受欢迎的语言之一,提供了强大的工具和库来增强隐私保护。本文将深入探讨区块链的隐私保护技术,并结合Python代码示例,带你了解如何在Web3时代

- 人脸识别的一些代码

饿了就干饭

CV相关人脸识别

1、cv2入门函数imread及其相关操作2、(详解)opencv里的cv2.resize改变图片大小Python3、机器学习之人脸识别face_recognition使用4、使用face_recognition进行人脸校准5、简单的人脸识别通用流程示意图(这个看着写的挺好的)6、face_recognition和图像处理中left、top、right、bottom解释7、使用pillow库对图片

- Python从入门到精通的系统性学习路径

niuTaylor

编程区python学习开发语言

Python从入门到精通的系统性学习路径一、基础语法快速突破1.变量与基础操作#动态类型演示a=10#整型a=3.14#浮点型a="Python"#字符串a=[1,2,3]#列表#格式化输出进阶name="Alice"print(f"{name:*^20}")#居中填充输出:******Alice*******2.运算符优先级实战#常见运算符优先级练习result=5+3*2**2//(4%3)p

- Python技术全景解析:从基础到前沿的深度探索

靠近彗星

python开发语言性能优化个人开发极限编程

目录一、Python为何成为开发者首选?1.核心优势矩阵2.性能进化史二、Python核心应用领域1.数据科学黄金三角2.AI开发新范式三、现代Python进阶技巧1.类型提示革命2.异步编程实战四、Python工程化实践1.现代项目架构2.性能优化矩阵五、Python未来生态展望1.前沿技术融合2.性能革命六、学习路线图1.技能成长路径基础阶段(1-3月)专业方向(3-6月)深度进阶(6-12月

- 如何使用DeepSeek编写测试用例?

海姐软件测试

deepseek大数据测试工具

一、DeepSeek在测试用例设计中的定位DeepSeek作为AI工具,并非直接替代测试设计,而是通过以下方式提升效率:快速生成基础用例框架(等价类、边界值等)智能补充易遗漏场景(如特殊字符、异常流)自动化脚本片段生成(Python/pytest/JUnit等)测试数据构造建议(符合业务规则的Mock数据)二、四步法实战:AI协作编写测试用例Step1:明确需求输入输入质量决定输出质量,需向Dee

- Explore Model-Based Feature Importance

后端

Question1.ExploreModel-BasedFeatureImportanceThroughoutthisquestion,youmayonlyusePython.Foreachsub-question,providecommentary(ifneeded)alongwithscreenshotsofthecodeused.Pleasealsoprovideacopyofthecode

- Python 标准库之 logging 模块

36度道

python系列学习笔记python

1.logging模块简介在软件开发过程中,了解程序的运行状态、记录重要事件以及排查错误是至关重要的。logging模块为Python提供了灵活且强大的日志记录功能。它允许开发者控制日志的输出内容、输出位置(如文件、控制台)、日志级别(用于过滤不同重要程度的日志信息)等,帮助开发者更好地监控和调试程序。2.基本使用简单配置与输出:importlogging#配置日志基本设置logging.basi

- python 标准库之 functools 模块

36度道

python系列学习笔记python

functools模块提供了一系列用于处理函数的工具。其中,像partial可以创建一个新的可调用对象,这个对象固定了原函数的部分参数,有点像给函数穿上了“参数防护服”;reduce能对一个序列进行累积计算,就好比是一个勤劳的小会计,按顺序把序列里的数加起来或者做其他运算;wraps主要用于装饰器,它能帮助装饰器函数保留被装饰函数的元信息,比如函数名、文档字符串等,让被装饰函数“表里如一”。底层原

- Python——函数

生如雪花

Pythonpython

一、十进制小数转换成二进制小数【问题描述】编写程序,输入十进制小数(只考虑正数),把它转换为以字符串形式存储的二进制小数,输出该二进制小数字符串。对于转换得到的二进制小数,小数点后最多保留10位。小数点后不足10位,则输出这些位,尾部不补0;小数点后超出10位,则直接舍弃超出部分。【输入形式】十进制浮点小数【输出形式】对应输入小数的二进制小数字符串。若整数部分或者小数部分为0,则输出0。比如输入0

- Python Web框架 Flask vs Django vs FastAPI

ZengDerby

pythonflaskfastapidjango

如果您需要构建大型的、功能丰富的应用程序,Django可能是一个很好的选择。如果您需要更灵活的框架,可以选择Flask来定制开发。而对于追求极致性能和高并发处理的项目,FastAPI可能是一个更加理想的选择。优缺点Flask在小型项目或微服务理想的选择。Flask灵活且轻量,非常适合快速开发小型应用。Flask是一个非常灵活的框架,它允许您根据项目需求进行定制。您可以根据需要选择合适的插件和扩展。

- python if用法

IT技术土狗

python从入门到入狱python

pythonif用法流程控制流程控制即控制流程,具体指控制程序的执行流程,而程序的执行流程分为三种结构:顺序结构(之前我们写的代码都是顺序结构)、分支结构(用到if判断)、循环结构(用到while与for)1、分支结构分支结构就是根据条件判断的真假去执行不同分支对应的子代码2、为什么需要分支结构人类某些时候需要根据条件来决定做什么事情,比如:如果今天下雨,就带伞所以程序中必须有相应的机制来控制计算

- python与数值有关的问题

cbxjsdg

python

1.复数的问题x=123+456j#后面没加j部分为实数,加j部分为虚数print('实数部分',x.real)#表示实数print('虚数部分',x.imag)#表示虚数2.查看数值的类型a=10b=10.0c=1.99E2#表示1.99*10的二次方的意思,这是科学计数法print('数值为',a,'数值类型为',type(a))print('数值为',b,'数值类型为',type(b))pr

- 【架构设计】前置知识

GIS程序媛—椰子

架构设计架构设计

架构设计是软件开发的进阶技能,需要结合理论知识和实践经验。以下是掌握架构设计所需的前置知识及其重要性,以及学习路径建议:一、基础编程能力1.编程语言与核心概念掌握至少一门主流语言(如Java、Python、C#、Go等),理解其语法、特性及生态。核心概念:面向对象(OOP)、函数式编程(FP)、并发/异步、内存管理等。示例:通过Java理解接口、多态、设计模式。通过Go学习并发模型(Gorouti

- Python, C ++开发家庭开支

Geeker-2025

pythonc++

开发一款**家庭开支数字化记录与结算App**是一个非常有意义的项目,旨在帮助家庭用户高效管理开支、记录消费、分析财务状况,并提供结算和预算管理功能。以下是基于**Python**和**C++**的开发方案,结合两者在数据处理、实时通信和系统开发中的优势。---##1.**项目需求分析**家庭开支数字化记录与结算App的核心功能包括:1.**用户管理**:-用户注册、登录,支持家庭成员管理。2.*

- linux执行python脚本conda库_Pycharm使用远程linux服务器conda/python环境在本地运行的方法(图解))...

weixin_39992462

Pycharm使用远程linux服务器conda/python环境在本地运行的方法(图解))1.首先在PycharmTools->Deployment->Configurations打开新建SFTP输入host:ip地址username密码然后点击TestConnection出现下图,则测试成功因为已经连接成功,这时候已经可以读取远程服务器的目录了:2.选择项目mapping(可以跳过3.在Set

- brew mysql client_Mac安装mysqlclient过程解析

weixin_39630440

brewmysqlclient

尝试在虚拟环境下通过pip安装:pipinstallmysqlclient然后报错:OSError:mysql_confignotfound找到官方文档https://github.com/PyMySQL/mysqlclient-python,解释说安装前需安装另一个模块:brewinstallmysql-connector-c但是报错:查看报错信息,在安装mysql-connector-c前先b

- macos安装python-nodejs_MAC平台基于Python Appium环境搭建过程图解

weixin_39612038

前言最近笔者要为python+appium课程做准备,mac在2019年重新安装了一次系统,这次重新在mac下搭建appium环境,刚好顺带写个文稿给大家分享分享搭建过程。一、环境和所需软件概述1.1目前环境:MacOS(10.15.3)1.2所需软件:jdk-8u91-macosx-x64.dmg(jdk1.8及以上版本应该都可以)android-sdk_r24.4.1-macosx.zip(m

- python接口自动化

全世界最帅的男人

python自动化开发语言

Python是一种非常流行的编程语言,也是许多接口自动化测试框架的首选语言。下面是一个简单的接口自动化测试框架的思路:1.安装必要的库和工具:在Python中,我们可以使用requests库来发送HTTP请求,使用unittest库来编写测试用例,使用HTMLTestRunner库来生成测试报告。此外,我们还需要安装一个代码编辑器,如PyCharm或VSCode。2.创建测试用例:编写测试用例是接

- Python接口自动化

花落同学

Python自动化从入门到放弃python自动化

4接口自动化4.1使用python实现接口自动化如果不了解接口测试可参考https://ke.qq.com/course/4092904使用Python的request库实现接口测试:importjsonimportrequests#使用session管理:#1.可以自动关联set-cookie里面的内容#2.可以加快与服务器的连接速度session=requests.session()#auth

- Python异步编程:从基础到高级

CarlowZJ

python网络数据库

前言在现代软件开发中,异步编程已经成为一种必不可少的技能。Python的异步编程模型(基于asyncio)为开发者提供了一种高效的方式来处理高并发任务,而无需依赖多线程或多进程。异步编程不仅可以提高程序的性能,还能简化并发代码的复杂性。本文将带你从异步编程的基础概念出发,逐步深入到高级应用,帮助你掌握Python异步编程的核心技能。一、异步编程的基础概念1.1什么是异步编程?异步编程是一种编程范式

- 使用Java爬虫按关键字搜索1688商品

小爬虫程序猿

java爬虫开发语言

在电商领域,获取1688商品信息对于市场分析、选品上架、库存管理和价格策略制定等方面至关重要。1688作为国内领先的B2B电商平台,提供了丰富的商品数据。虽然1688开放平台提供了官方API来获取商品信息,但有时使用爬虫技术来抓取数据也是一种有效的手段。本文将介绍如何利用Java按关键字搜索1688商品,并提供详细的代码示例。一、准备工作1.Java开发环境确保你的Java开发环境已经安装了以下必

- python实现接口自动化

一只小H呀の

python自动化开发语言

代码实现自动化相关理论代码编写脚本和工具实现脚本区别是啥?代码:优点:代码灵活方便缺点:学习成本高工具:优点:易上手缺点:灵活度低,有局限性。总结:功能脚本:工具自动化脚本:代码代码接口自动化怎么做的?第一步:python+request+unittest;具体描述?第二步:封装、调用、数据驱动、日志、报告;详细举例:第三步:api\scripts\data\log\report\until…脚本

- Spring4.1新特性——Spring MVC增强

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- mysql 性能查询优化

annan211

javasql优化mysql应用服务器

1 时间到底花在哪了?

mysql在执行查询的时候需要执行一系列的子任务,这些子任务包含了整个查询周期最重要的阶段,这其中包含了大量为了

检索数据列到存储引擎的调用以及调用后的数据处理,包括排序、分组等。在完成这些任务的时候,查询需要在不同的地方

花费时间,包括网络、cpu计算、生成统计信息和执行计划、锁等待等。尤其是向底层存储引擎检索数据的调用操作。这些调用需要在内存操

- windows系统配置

cherishLC

windows

删除Hiberfil.sys :使用命令powercfg -h off 关闭休眠功能即可:

http://jingyan.baidu.com/article/f3ad7d0fc0992e09c2345b51.html

类似的还有pagefile.sys

msconfig 配置启动项

shutdown 定时关机

ipconfig 查看网络配置

ipconfig /flushdns

- 人体的排毒时间

Array_06

工作

========================

|| 人体的排毒时间是什么时候?||

========================

转载于:

http://zhidao.baidu.com/link?url=ibaGlicVslAQhVdWWVevU4TMjhiKaNBWCpZ1NS6igCQ78EkNJZFsEjCjl3T5EdXU9SaPg04bh8MbY1bR

- ZooKeeper

cugfy

zookeeper

Zookeeper是一个高性能,分布式的,开源分布式应用协调服务。它提供了简单原始的功能,分布式应用可以基于它实现更高级的服务,比如同步, 配置管理,集群管理,名空间。它被设计为易于编程,使用文件系统目录树作为数据模型。服务端跑在java上,提供java和C的客户端API。 Zookeeper是Google的Chubby一个开源的实现,是高有效和可靠的协同工作系统,Zookeeper能够用来lea

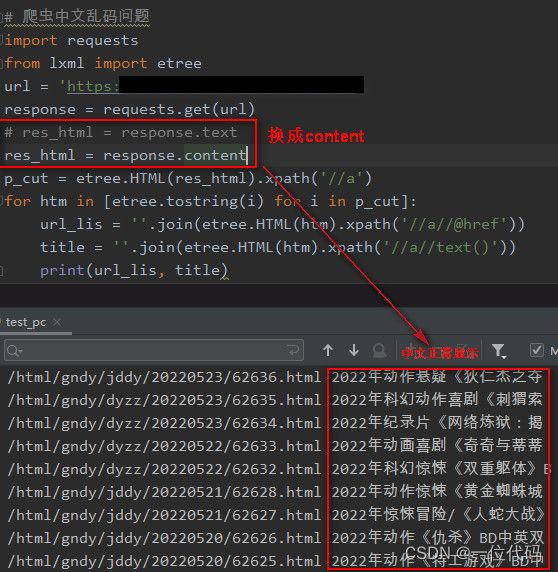

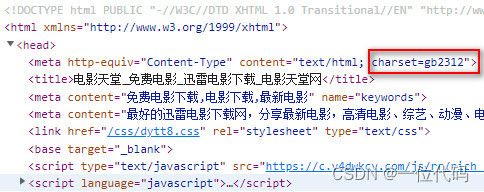

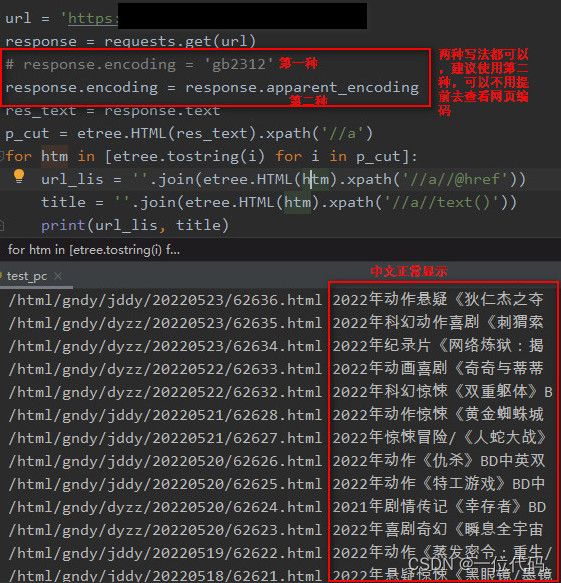

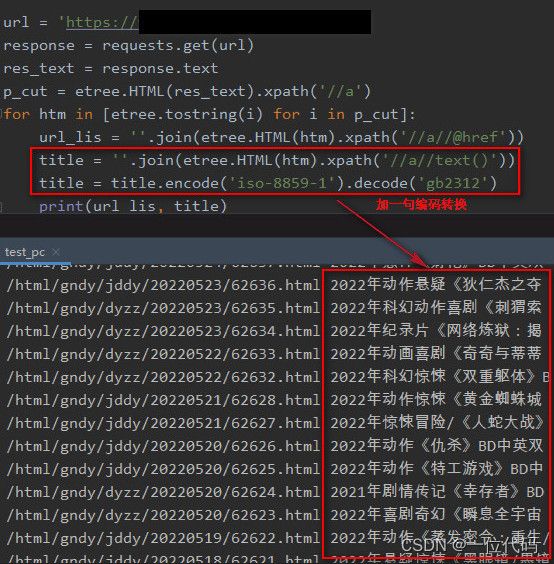

- 网络爬虫的乱码处理

随意而生

爬虫网络

下边简单总结下关于网络爬虫的乱码处理。注意,这里不仅是中文乱码,还包括一些如日文、韩文 、俄文、藏文之类的乱码处理,因为他们的解决方式 是一致的,故在此统一说明。 网络爬虫,有两种选择,一是选择nutch、hetriex,二是自写爬虫,两者在处理乱码时,原理是一致的,但前者处理乱码时,要看懂源码后进行修改才可以,所以要废劲一些;而后者更自由方便,可以在编码处理

- Xcode常用快捷键

张亚雄

xcode

一、总结的常用命令:

隐藏xcode command+h

退出xcode command+q

关闭窗口 command+w

关闭所有窗口 command+option+w

关闭当前

- mongoDB索引操作

adminjun

mongodb索引

一、索引基础: MongoDB的索引几乎与传统的关系型数据库一模一样,这其中也包括一些基本的优化技巧。下面是创建索引的命令: > db.test.ensureIndex({"username":1}) 可以通过下面的名称查看索引是否已经成功建立: &nbs

- 成都软件园实习那些话

aijuans

成都 软件园 实习

无聊之中,翻了一下日志,发现上一篇经历是很久以前的事了,悔过~~

断断续续离开了学校快一年了,习惯了那里一天天的幼稚、成长的环境,到这里有点与世隔绝的感觉。不过还好,那是刚到这里时的想法,现在感觉在这挺好,不管怎么样,最要感谢的还是老师能给这么好的一次催化成长的机会,在这里确实看到了好多好多能想到或想不到的东西。

都说在外面和学校相比最明显的差距就是与人相处比较困难,因为在外面每个人都

- Linux下FTP服务器安装及配置

ayaoxinchao

linuxFTP服务器vsftp

检测是否安装了FTP

[root@localhost ~]# rpm -q vsftpd

如果未安装:package vsftpd is not installed 安装了则显示:vsftpd-2.0.5-28.el5累死的版本信息

安装FTP

运行yum install vsftpd命令,如[root@localhost ~]# yum install vsf

- 使用mongo-java-driver获取文档id和查找文档

BigBird2012

driver

注:本文所有代码都使用的mongo-java-driver实现。

在MongoDB中,一个集合(collection)在概念上就类似我们SQL数据库中的表(Table),这个集合包含了一系列文档(document)。一个DBObject对象表示我们想添加到集合(collection)中的一个文档(document),MongoDB会自动为我们创建的每个文档添加一个id,这个id在

- JSONObject以及json串

bijian1013

jsonJSONObject

一.JAR包简介

要使程序可以运行必须引入JSON-lib包,JSON-lib包同时依赖于以下的JAR包:

1.commons-lang-2.0.jar

2.commons-beanutils-1.7.0.jar

3.commons-collections-3.1.jar

&n

- [Zookeeper学习笔记之三]Zookeeper实例创建和会话建立的异步特性

bit1129

zookeeper

为了说明问题,看个简单的代码,

import org.apache.zookeeper.*;

import java.io.IOException;

import java.util.concurrent.CountDownLatch;

import java.util.concurrent.ThreadLocal

- 【Scala十二】Scala核心六:Trait

bit1129

scala

Traits are a fundamental unit of code reuse in Scala. A trait encapsulates method and field definitions, which can then be reused by mixing them into classes. Unlike class inheritance, in which each c

- weblogic version 10.3破解

ronin47

weblogic

版本:WebLogic Server 10.3

说明:%DOMAIN_HOME%:指WebLogic Server 域(Domain)目录

例如我的做测试的域的根目录 DOMAIN_HOME=D:/Weblogic/Middleware/user_projects/domains/base_domain

1.为了保证操作安全,备份%DOMAIN_HOME%/security/Defa

- 求第n个斐波那契数

BrokenDreams

今天看到群友发的一个问题:写一个小程序打印第n个斐波那契数。

自己试了下,搞了好久。。。基础要加强了。

&nbs

- 读《研磨设计模式》-代码笔记-访问者模式-Visitor

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

import java.util.ArrayList;

import java.util.List;

interface IVisitor {

//第二次分派,Visitor调用Element

void visitConcret

- MatConvNet的excise 3改为网络配置文件形式

cherishLC

matlab

MatConvNet为vlFeat作者写的matlab下的卷积神经网络工具包,可以使用GPU。

主页:

http://www.vlfeat.org/matconvnet/

教程:

http://www.robots.ox.ac.uk/~vgg/practicals/cnn/index.html

注意:需要下载新版的MatConvNet替换掉教程中工具包中的matconvnet:

http

- ZK Timeout再讨论

chenchao051

zookeepertimeouthbase

http://crazyjvm.iteye.com/blog/1693757 文中提到相关超时问题,但是又出现了一个问题,我把min和max都设置成了180000,但是仍然出现了以下的异常信息:

Client session timed out, have not heard from server in 154339ms for sessionid 0x13a3f7732340003

- CASE WHEN 用法介绍

daizj

sqlgroup bycase when

CASE WHEN 用法介绍

1. CASE WHEN 表达式有两种形式

--简单Case函数

CASE sex

WHEN '1' THEN '男'

WHEN '2' THEN '女'

ELSE '其他' END

--Case搜索函数

CASE

WHEN sex = '1' THEN

- PHP技巧汇总:提高PHP性能的53个技巧

dcj3sjt126com

PHP

PHP技巧汇总:提高PHP性能的53个技巧 用单引号代替双引号来包含字符串,这样做会更快一些。因为PHP会在双引号包围的字符串中搜寻变量, 单引号则不会,注意:只有echo能这么做,它是一种可以把多个字符串当作参数的函数译注: PHP手册中说echo是语言结构,不是真正的函数,故把函数加上了双引号)。 1、如果能将类的方法定义成static,就尽量定义成static,它的速度会提升将近4倍

- Yii框架中CGridView的使用方法以及详细示例

dcj3sjt126com

yii

CGridView显示一个数据项的列表中的一个表。

表中的每一行代表一个数据项的数据,和一个列通常代表一个属性的物品(一些列可能对应于复杂的表达式的属性或静态文本)。 CGridView既支持排序和分页的数据项。排序和分页可以在AJAX模式或正常的页面请求。使用CGridView的一个好处是,当用户浏览器禁用JavaScript,排序和分页自动退化普通页面请求和仍然正常运行。

实例代码如下:

- Maven项目打包成可执行Jar文件

dyy_gusi

assembly

Maven项目打包成可执行Jar文件

在使用Maven完成项目以后,如果是需要打包成可执行的Jar文件,我们通过eclipse的导出很麻烦,还得指定入口文件的位置,还得说明依赖的jar包,既然都使用Maven了,很重要的一个目的就是让这些繁琐的操作简单。我们可以通过插件完成这项工作,使用assembly插件。具体使用方式如下:

1、在项目中加入插件的依赖:

<plugin>

- php常见错误

geeksun

PHP

1. kevent() reported that connect() failed (61: Connection refused) while connecting to upstream, client: 127.0.0.1, server: localhost, request: "GET / HTTP/1.1", upstream: "fastc

- 修改linux的用户名

hongtoushizi

linuxchange password

Change Linux Username

更改Linux用户名,需要修改4个系统的文件:

/etc/passwd

/etc/shadow

/etc/group

/etc/gshadow

古老/传统的方法是使用vi去直接修改,但是这有安全隐患(具体可自己搜一下),所以后来改成使用这些命令去代替:

vipw

vipw -s

vigr

vigr -s

具体的操作顺

- 第五章 常用Lua开发库1-redis、mysql、http客户端

jinnianshilongnian

nginxlua

对于开发来说需要有好的生态开发库来辅助我们快速开发,而Lua中也有大多数我们需要的第三方开发库如Redis、Memcached、Mysql、Http客户端、JSON、模板引擎等。

一些常见的Lua库可以在github上搜索,https://github.com/search?utf8=%E2%9C%93&q=lua+resty。

Redis客户端

lua-resty-r

- zkClient 监控机制实现

liyonghui160com

zkClient 监控机制实现

直接使用zk的api实现业务功能比较繁琐。因为要处理session loss,session expire等异常,在发生这些异常后进行重连。又因为ZK的watcher是一次性的,如果要基于wather实现发布/订阅模式,还要自己包装一下,将一次性订阅包装成持久订阅。另外如果要使用抽象级别更高的功能,比如分布式锁,leader选举

- 在Mysql 众多表中查找一个表名或者字段名的 SQL 语句

pda158

mysql

在Mysql 众多表中查找一个表名或者字段名的 SQL 语句:

方法一:SELECT table_name, column_name from information_schema.columns WHERE column_name LIKE 'Name';

方法二:SELECT column_name from information_schema.colum

- 程序员对英语的依赖

Smile.zeng

英语程序猿

1、程序员最基本的技能,至少要能写得出代码,当我们还在为建立类的时候思考用什么单词发牢骚的时候,英语与别人的差距就直接表现出来咯。

2、程序员最起码能认识开发工具里的英语单词,不然怎么知道使用这些开发工具。

3、进阶一点,就是能读懂别人的代码,有利于我们学习人家的思路和技术。

4、写的程序至少能有一定的可读性,至少要人别人能懂吧...

以上一些问题,充分说明了英语对程序猿的重要性。骚年

- Oracle学习笔记(8) 使用PLSQL编写触发器

vipbooks

oraclesql编程活动Access

时间过得真快啊,转眼就到了Oracle学习笔记的最后个章节了,通过前面七章的学习大家应该对Oracle编程有了一定了了解了吧,这东东如果一段时间不用很快就会忘记了,所以我会把自己学习过的东西做好详细的笔记,用到的时候可以随时查找,马上上手!希望这些笔记能对大家有些帮助!

这是第八章的学习笔记,学习完第七章的子程序和包之后