- JSON 与 AJAX

Auscy

jsonajax前端

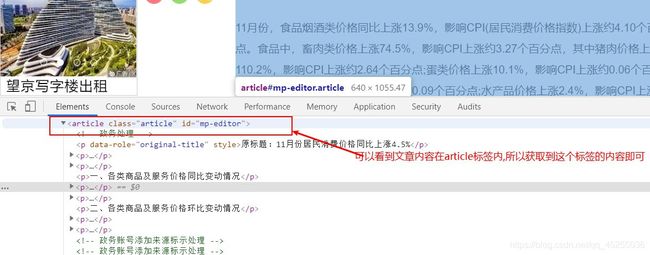

一、JSON(JavaScriptObjectNotation)1.数据类型与语法细节支持的数据类型:基本类型:字符串(需用双引号)、数字、布尔值(true/false)、null。复杂类型:数组([])、对象({})。严格语法规范:键名必须用双引号包裹(如"name":"张三")。数组元素用逗号分隔,最后一个元素后不能有多余逗号。数字不能以0开头(如012会被解析为12),不支持八进制/十六进制

- JavaScript 树形菜单总结

Auscy

microsoft

树形菜单是前端开发中常见的交互组件,用于展示具有层级关系的数据(如文件目录、分类列表、组织架构等)。以下从核心概念、实现方式、常见功能及优化方向等方面进行总结。一、核心概念层级结构:数据以父子嵌套形式存在,如{id:1,children:[{id:2}]}。节点:树形结构的基本单元,包含自身信息及子节点(若有)。展开/折叠:子节点的显示与隐藏切换,是树形菜单的核心交互。递归渲染:因数据层级不固定,

- 精通Canvas:15款时钟特效代码实现指南

烟幕缭绕

本文还有配套的精品资源,点击获取简介:HTML5的Canvas是一个用于绘制矢量图形的API,通过JavaScript实现动态效果。本项目集合了15种不同的时钟特效代码,帮助开发者通过学习绘制圆形、线条、时间更新、旋转、颜色样式设置及动画效果等概念,深化对Canvas的理解和应用。项目中的CSS文件负责时钟的样式设定,而JS文件则包含实现各种特效的逻辑,通过不同的函数或类处理时间更新和动画绘制,提

- 深入剖析OpenJDK 18 GA源码:Java平台最新发展

想法臃肿

本文还有配套的精品资源,点击获取简介:OpenJDK18GA作为Java开发的关键里程碑,提供了诸多新特性和改进。本文章深入探讨了OpenJDK18GA源码,揭示其内部机制,帮助开发者更好地理解和利用这个版本。文章还涵盖了PatternMatching、SealedClasses、Records、JEP395、JEP406和JEP407等特性,以及HotSpot虚拟机、编译器、垃圾收集器、内存模型

- Java大厂面试实录:谢飞机的电商场景技术问答(Spring Cloud、MyBatis、Redis、Kafka、AI等)

Java大厂面试实录:谢飞机的电商场景技术问答(SpringCloud、MyBatis、Redis、Kafka、AI等)本文模拟知名互联网大厂Java后端岗位面试流程,以电商业务为主线,由严肃面试官与“水货”程序员谢飞机展开有趣的对话,涵盖SpringCloud、MyBatis、Redis、Kafka、SpringSecurity、AI等热门技术栈,并附详细解析,助力求职者备战大厂面试。故事设定谢

- 【超硬核】JVM源码解读:Java方法main在虚拟机上解释执行

HeapDump性能社区

java开发语言后端jvm

本文由HeapDump性能社区首席讲师鸠摩(马智)授权整理发布第1篇-关于Java虚拟机HotSpot,开篇说的简单点开讲Java运行时,这一篇讲一些简单的内容。我们写的主类中的main()方法是如何被Java虚拟机调用到的?在Java类中的一些方法会被由C/C++编写的HotSpot虚拟机的C/C++函数调用,不过由于Java方法与C/C++函数的调用约定不同,所以并不能直接调用,需要JavaC

- 算法学习笔记:17.蒙特卡洛算法 ——从原理到实战,涵盖 LeetCode 与考研 408 例题

在计算机科学和数学领域,蒙特卡洛算法(MonteCarloAlgorithm)以其独特的随机抽样思想,成为解决复杂问题的有力工具。从圆周率的计算到金融风险评估,从物理模拟到人工智能,蒙特卡洛算法都发挥着不可替代的作用。本文将深入剖析蒙特卡洛算法的思想、解题思路,结合实际应用场景与Java代码实现,并融入考研408的相关考点,穿插图片辅助理解,帮助你全面掌握这一重要算法。蒙特卡洛算法的基本概念蒙特卡

- Java大厂面试故事:谢飞机的互联网音视频场景技术面试全纪录(Spring Boot、MyBatis、Kafka、Redis、AI等)

来旺

Java场景面试宝典JavaSpringBootMyBatisKafkaRedis微服务AI

Java大厂面试故事:谢飞机的互联网音视频场景技术面试全纪录(SpringBoot、MyBatis、Kafka、Redis、AI等)互联网大厂技术面试不仅考察技术深度,更注重业务场景与系统设计能力。本篇以严肃面试官与“水货”程序员谢飞机的对话,带你体验音视频业务场景下的Java面试全过程,涵盖主流技术栈,并附详细答案解析,助你面试无忧。故事场景设定谢飞机是一名有趣但技术基础略显薄弱的程序员,这次应

- 【前端】jQuery数组合并去重方法总结

在jQuery中合并多个数组并去重,推荐使用原生JavaScript的Set对象(高效简单)或$.unique()(仅适用于DOM元素,不适用于普通数组)。以下是完整解决方案:方法1:使用ES6Set(推荐)//定义多个数组constarr1=[1,2,3];constarr2=[2,3,4];constarr3=[3,4,5];//合并数组并用Set去重constmergedArray=[...

- MySQL Explain 详解:从入门到精通,让你的 SQL 飞起来

引言:为什么Explain是SQL优化的“照妖镜”?在Java开发中,我们常常会遇到数据库性能瓶颈的问题。一条看似简单的SQL语句,在数据量增长到一定规模后,可能会从毫秒级响应变成秒级甚至分钟级响应,直接拖慢整个应用的性能。此时,你是否曾困惑于:为什么这条SQL突然变慢了?索引明明建了,为什么没生效?到底是哪里出了问题?答案就藏在MySQL的EXPLAIN命令里。EXPLAIN就像一面“照妖镜”,

- Java特性之设计模式【责任链模式】

Naijia_OvO

Java特性java设计模式责任链模式

一、责任链模式概述顾名思义,责任链模式(ChainofResponsibilityPattern)为请求创建了一个接收者对象的链。这种模式给予请求的类型,对请求的发送者和接收者进行解耦。这种类型的设计模式属于行为型模式在这种模式中,通常每个接收者都包含对另一个接收者的引用。如果一个对象不能处理该请求,那么它会把相同的请求传给下一个接收者,依此类推主要解决:职责链上的处理者负责处理请求,客户只需要将

- 日历插件-FullCalendar的详细使用

老马聊技术

JavaScript前端javascript

一、介绍FullCalendar是一个功能强大、高度可定制的JavaScript日历组件,用于在网页中显示和管理日历事件。它支持多种视图(月、周、日等),可以轻松集成各种框架,并提供丰富的事件处理功能。二、实操案例具体代码如下:FullCalendar日期选择body{font-family:Arial,sans-serif;margin:20px;}#calendar{max-width:900

- react-native android 环境搭建

环境:macjava版本:Java11最重要:一定要一定要一定要react涉及到很多的依赖下载,gradle和react相关的,第一次安装环境时有外网环境会快速很多。安装nodejs安装react-nativenpminstallreact-native-clinpminstallreact-native创建一个新项目react-nativeinitfirstReact替换gradle下载源rep

- Java 调用 HTTP 接口的 7 种方式:全网最全指南

Java调用HTTP接口的7种方式:全网最全指南在开发过程中,调用HTTP接口是最常见的需求之一。本文将详细介绍Java中7种主流的调用HTTP接口的方式,包括每种工具的优缺点和完整代码实现。1.使用RestTemplateRestTemplate是Spring提供的同步HTTP客户端,适用于传统项目。尽管从Spring5开始被标记为过时,它仍然是许多开发者的首选。示例代码importorg.sp

- Java三年经验程序员技术栈全景指南:从前端到架构,对标阿里美团全栈要求

可曾去过倒悬山

java前端架构

Java三年经验程序员技术栈全景指南:从前端到架构,对标阿里美团全栈要求三年经验是Java程序员的分水岭,技术栈深度决定你成为“业务码农”还是“架构师候选人”。本文整合阿里、美团、滴滴等大厂招聘要求,为你绘制可落地的进阶路线。一、Java核心:从语法糖到JVM底层三年经验与初级的核心差异在于系统级理解,大厂面试常考以下能力:JVM与性能调优内存模型(堆外内存、元空间)、GC算法(G1/ZGC适用场

- javascript高级程序设计第3版——第12章 DOM2与DOM3

weixin_30687587

javascript数据结构与算法ViewUI

12章——DOM2与DOM3为了增强D0M1,DOM级规范定义了一些模块。DOM2核心:为不同的DOM类型引入了一些与XML命名空间有关的方法,还定义了以编程方式创建Document实例的方法;DOM2级样式:针对操作元素的样式而开发;其特性总结:1.每个元素都有一个关联的style对象,可用来确定和修改行内样式;2.要确定某个元素的计算样式,可使用getComgetComputedStyle()

- Java设计模式实战:高频场景解析与避坑指南

mckim_

笔记学习java设计模式

引言设计模式是软件开发的基石,但许多开发者面对23种模式时容易陷入“学完就忘”或“滥用模式”的困境。本文从工业级项目视角出发,精选10种高频设计模式,结合真实代码案例与主流框架应用,帮你建立模式思维,拒绝纸上谈兵。一、创建型模式:告别new的暴力美学1.工厂方法模式(FactoryMethod)核心痛点:对象创建逻辑散落各处,难以统一管理。场景案例:电商平台需要支持多种支付方式(支付宝、微信、银联

- JavaScript 基础09:Web APIs——日期对象、DOM节点

梦想当全栈

JavaScriptjavascript前端开发语言

JavaScript基础09:WebAPIs——日期对象、DOM节点进一步学习DOM相关知识,实现可交互的网页特效能够插入、删除和替换元素节点。能够依据元素节点关系查找节点。一、日期对象掌握Date日期对象的使用,动态获取当前计算机的时间。ECMAScript中内置了获取系统时间的对象Date,使用Date时与之前学习的内置对象console和Math不同,它需要借助new关键字才能使用。1.实例

- 《Java前端开发全栈指南:从Servlet到现代框架实战》

前言在当今Web开发领域,Java依然是后端开发的主力语言,而随着前后端分离架构的普及,Java开发者也需要掌握前端技术栈。本文将全面介绍JavaWeb前端开发的核心技术,包括传统Servlet/JSP体系、现代前端框架集成方案,以及全栈开发的最佳实践。通过本文,您将了解如何构建现代化的JavaWeb应用前端界面。一、JavaWeb前端技术演进1.1传统技术栈Servlet:JavaWeb基础,处

- javaSE面试题---语法基础、面向对象、常用类、集合、多线程、文件和IO

yang_xiao_wu_

java面试开发语言javasejava基础多线程文件和IO

目录语法基础1.jdkjrejvm区别2.基本数据类型3.引用数据类型4.自动类型转换、强制类型转换5.常见的运算符6.&和&&区别7.++--在前和在后的区别8.+=有什么作用9.switch..case中switch支持哪些数据类型10.break和continue区别11.while和dowhile区别12.如何生成一个取值范围在[min,max]之间的随机数13.数组的长度如何获取?数组下

- JAVA 高频八股文 Day03

Conqueror675

java开发语言

12.TCP和Http的区别是什么TCP是传输层协议,负责建立可靠的点对点连接,确保数据有序、完整地传输(如铁路轨道);HTTP是应用层协议,基于TCP构建,定义了Web服务交互的报文格式和规则(如货运订单)。TCP关注数据如何可靠送达,通过三次握手建立连接、流量控制等机制保证传输;HTTP关注传输内容的意义,提供请求/响应语义(GET/POST等)和无状态通信。补充:说一下什么是三次握手四次挥手

- JVM字节码加载与存储中的细节

问题引出:为什么Java定义int型变量为32767时使用的是bipush32767,而定义int型变量为32768时使用的是ldc#4?在Java中,如果这样定义int型变量:publicclassTest{publicstaticvoidmain(String[]args){inti=0;intj=5;intk=6;intm=32768;intn=32767;}}变量对应的字节码文件内容是这样

- JVM与Spring Boot核心解析

AIHacksCash

Java场景面试宝典JavaJVMSpringBoot

我是廖志伟,一名Java开发工程师、《Java项目实战——深入理解大型互联网企业通用技术》(基础篇)、(进阶篇)、(架构篇)清华大学出版社签约作家、Java领域优质创作者、CSDN博客专家、阿里云专家博主、51CTO专家博主、产品软文专业写手、技术文章评审老师、技术类问卷调查设计师、幕后大佬社区创始人、开源项目贡献者。拥有多年一线研发和团队管理经验,研究过主流框架的底层源码(Spring、Spri

- HashMap的Get(),Put()源码解析

Ttang23

哈希算法散列表算法

1、什么是HashMap?HashMap是Java中用于存储键值对(Key-Value)的集合类,它实现了Map接口。其核心特点是:无序性:不保证元素的存储顺序,也不保证顺序恒定不变。唯一性:键(Key)不能重复,若插入重复键会覆盖原有值。允许null:允许一个null键和任意数量的null值。非线程安全:相比HashTable,HashMap不支持同步,性能更高。2.核心数据结构:哈希表(Has

- Java中的Tomcat,开启Web应用腾飞【基础版】

目录一、Tomcat初登场:揭开神秘面纱(一)啥是Tomcat(二)为啥要有Tomcat二、Tomcat的安装与启动:开启第一步(一)下载Tomcat(二)启动Tomcat三、Tomcat的目录结构:探秘内部布局(一)核心目录介绍(二)目录间的协同工作四、部署JavaWeb应用到Tomcat:让应用上线(一)打包Web应用为WAR文件(二)部署WAR文件到Tomcat五、Tomcat的配置优化:让

- Java Web 之 Session 详解

艾伦~耶格尔

java开发语言后端前端session

在JavaWeb开发中,Session就像网站的专属记忆管家,为每个用户保管着重要的信息和状态,确保用户在网站的旅程顺畅无阻。场景一:想象你去一家大型超市购物,推着购物车挑选商品。这个购物车就如同Session,它记录了你的购物信息,方便你在结账时一次性结算。场景二:你在玩一个在线游戏,登录账号后,你的游戏进度、等级、装备等信息都会被保存在Session中,即使你中途关闭游戏,下次登录时依然可以继

- JavaScript之DOM操作与事件处理详解

AA-代码批发V哥

JavaScriptjavascript

JavaScript之DOM操作与事件处理详解一、DOM基础:理解文档对象模型二、DOM元素的获取与访问2.1基础获取方法2.2集合的区别与注意事项三、DOM元素的创建与修改3.1创建与插入元素3.2修改元素属性与样式3.2.1属性操作3.2.2样式操作3.3元素内容的修改四、DOM元素的删除与替换4.1删除元素4.2替换元素五、事件处理:实现页面交互5.1事件绑定的三种方式5.1.1HTML属性

- V少JS基础班之第五弹

V少在逆向

JS基础班javascript开发语言ecmascript

文章目录一、前言二、本节涉及知识点三、重点内容1-函数的定义2-函数的构成1.函数参数详解1)参数个数不固定2)默认参数3)arguments对象(类数组)4)剩余参数(Rest参数)5)函数参数是按值传递的6)解构参数传递7)参数校验技巧(JavaScript没有类型限制,需要手动校验)2.函数返回值详解3-函数的分类1-函数声明式:2-函数表达式:3-箭头函数:4-构造函数:5-IIFE:6-

- Javaweb学习之Vue模板语法(三)

不要数手指啦

vue.js学习前端

目录学习资料前情回顾本期介绍(vue模板语法)文本插值Vue的Attribute绑定使用JavaScript表达式综合实例代码:学习资料Vue.js-渐进式JavaScript框架|Vue.js(vuejs.org)前情回顾项目的创建大家可以看这篇文章Vue学习之项目的创建-CSDN博客本期介绍(vue模板语法)首先,找到我们编写代码的地方找到自己项目的src文件夹,打开之后点击component

- Tomcat:Java Web应用的幕后英雄

互联网动态分析

tomcat

在当今数字化浪潮中,Java作为一门成熟且广泛应用的编程语言,支撑着无数企业级应用和互联网服务的稳定运行。而在JavaWeb开发领域,Tomcat无疑是一个举足轻重的存在,它宛如一位默默耕耘的幕后英雄,为众多Web应用提供了可靠的运行环境。Tomcat的起源与发展Tomcat的故事始于1999年,当时SunMicrosystems(后被Oracle收购)与Apache软件基金会合作,旨在为Java

- java杨辉三角

3213213333332132

java基础

package com.algorithm;

/**

* @Description 杨辉三角

* @author FuJianyong

* 2015-1-22上午10:10:59

*/

public class YangHui {

public static void main(String[] args) {

//初始化二维数组长度

int[][] y

- 《大话重构》之大布局的辛酸历史

白糖_

重构

《大话重构》中提到“大布局你伤不起”,如果企图重构一个陈旧的大型系统是有非常大的风险,重构不是想象中那么简单。我目前所在公司正好对产品做了一次“大布局重构”,下面我就分享这个“大布局”项目经验给大家。

背景

公司专注于企业级管理产品软件,企业有大中小之分,在2000年初公司用JSP/Servlet开发了一套针对中

- 电驴链接在线视频播放源码

dubinwei

源码电驴播放器视频ed2k

本项目是个搜索电驴(ed2k)链接的应用,借助于磁力视频播放器(官网:

http://loveandroid.duapp.com/ 开放平台),可以实现在线播放视频,也可以用迅雷或者其他下载工具下载。

项目源码:

http://git.oschina.net/svo/Emule,动态更新。也可从附件中下载。

项目源码依赖于两个库项目,库项目一链接:

http://git.oschina.

- Javascript中函数的toString()方法

周凡杨

JavaScriptjstoStringfunctionobject

简述

The toString() method returns a string representing the source code of the function.

简译之,Javascript的toString()方法返回一个代表函数源代码的字符串。

句法

function.

- struts处理自定义异常

g21121

struts

很多时候我们会用到自定义异常来表示特定的错误情况,自定义异常比较简单,只要分清是运行时异常还是非运行时异常即可,运行时异常不需要捕获,继承自RuntimeException,是由容器自己抛出,例如空指针异常。

非运行时异常继承自Exception,在抛出后需要捕获,例如文件未找到异常。

此处我们用的是非运行时异常,首先定义一个异常LoginException:

/**

* 类描述:登录相

- Linux中find常见用法示例

510888780

linux

Linux中find常见用法示例

·find path -option [ -print ] [ -exec -ok command ] {} \;

find命令的参数;

- SpringMVC的各种参数绑定方式

Harry642

springMVC绑定表单

1. 基本数据类型(以int为例,其他类似):

Controller代码:

@RequestMapping("saysth.do")

public void test(int count) {

}

表单代码:

<form action="saysth.do" method="post&q

- Java 获取Oracle ROWID

aijuans

javaoracle

A ROWID is an identification tag unique for each row of an Oracle Database table. The ROWID can be thought of as a virtual column, containing the ID for each row.

The oracle.sql.ROWID class i

- java获取方法的参数名

antlove

javajdkparametermethodreflect

reflect.ClassInformationUtil.java

package reflect;

import javassist.ClassPool;

import javassist.CtClass;

import javassist.CtMethod;

import javassist.Modifier;

import javassist.bytecode.CodeAtt

- JAVA正则表达式匹配 查找 替换 提取操作

百合不是茶

java正则表达式替换提取查找

正则表达式的查找;主要是用到String类中的split();

String str;

str.split();方法中传入按照什么规则截取,返回一个String数组

常见的截取规则:

str.split("\\.")按照.来截取

str.

- Java中equals()与hashCode()方法详解

bijian1013

javasetequals()hashCode()

一.equals()方法详解

equals()方法在object类中定义如下:

public boolean equals(Object obj) {

return (this == obj);

}

很明显是对两个对象的地址值进行的比较(即比较引用是否相同)。但是我们知道,String 、Math、I

- 精通Oracle10编程SQL(4)使用SQL语句

bijian1013

oracle数据库plsql

--工资级别表

create table SALGRADE

(

GRADE NUMBER(10),

LOSAL NUMBER(10,2),

HISAL NUMBER(10,2)

)

insert into SALGRADE values(1,0,100);

insert into SALGRADE values(2,100,200);

inser

- 【Nginx二】Nginx作为静态文件HTTP服务器

bit1129

HTTP服务器

Nginx作为静态文件HTTP服务器

在本地系统中创建/data/www目录,存放html文件(包括index.html)

创建/data/images目录,存放imags图片

在主配置文件中添加http指令

http {

server {

listen 80;

server_name

- kafka获得最新partition offset

blackproof

kafkapartitionoffset最新

kafka获得partition下标,需要用到kafka的simpleconsumer

import java.util.ArrayList;

import java.util.Collections;

import java.util.Date;

import java.util.HashMap;

import java.util.List;

import java.

- centos 7安装docker两种方式

ronin47

第一种是采用yum 方式

yum install -y docker

- java-60-在O(1)时间删除链表结点

bylijinnan

java

public class DeleteNode_O1_Time {

/**

* Q 60 在O(1)时间删除链表结点

* 给定链表的头指针和一个结点指针(!!),在O(1)时间删除该结点

*

* Assume the list is:

* head->...->nodeToDelete->mNode->nNode->..

- nginx利用proxy_cache来缓存文件

cfyme

cache

user zhangy users;

worker_processes 10;

error_log /var/vlogs/nginx_error.log crit;

pid /var/vlogs/nginx.pid;

#Specifies the value for ma

- [JWFD开源工作流]JWFD嵌入式语法分析器负号的使用问题

comsci

嵌入式

假如我们需要用JWFD的语法分析模块定义一个带负号的方程式,直接在方程式之前添加负号是不正确的,而必须这样做:

string str01 = "a=3.14;b=2.71;c=0;c-((a*a)+(b*b))"

定义一个0整数c,然后用这个整数c去

- 如何集成支付宝官方文档

dai_lm

android

官方文档下载地址

https://b.alipay.com/order/productDetail.htm?productId=2012120700377310&tabId=4#ps-tabinfo-hash

集成的必要条件

1. 需要有自己的Server接收支付宝的消息

2. 需要先制作app,然后提交支付宝审核,通过后才能集成

调试的时候估计会真的扣款,请注意

- 应该在什么时候使用Hadoop

datamachine

hadoop

原帖地址:http://blog.chinaunix.net/uid-301743-id-3925358.html

存档,某些观点与我不谋而合,过度技术化不可取,且hadoop并非万能。

--------------------------------------------万能的分割线--------------------------------

有人问我,“你在大数据和Hado

- 在GridView中对于有外键的字段使用关联模型进行搜索和排序

dcj3sjt126com

yii

在GridView中使用关联模型进行搜索和排序

首先我们有两个模型它们直接有关联:

class Author extends CActiveRecord {

...

}

class Post extends CActiveRecord {

...

function relations() {

return array(

'

- 使用NSString 的格式化大全

dcj3sjt126com

Objective-C

格式定义The format specifiers supported by the NSString formatting methods and CFString formatting functions follow the IEEE printf specification; the specifiers are summarized in Table 1. Note that you c

- 使用activeX插件对象object滚动有重影

蕃薯耀

activeX插件滚动有重影

使用activeX插件对象object滚动有重影 <object style="width:0;" id="abc" classid="CLSID:D3E3970F-2927-9680-BBB4-5D0889909DF6" codebase="activex/OAX339.CAB#

- SpringMVC4零配置

hanqunfeng

springmvc4

基于Servlet3.0规范和SpringMVC4注解式配置方式,实现零xml配置,弄了个小demo,供交流讨论。

项目说明如下:

1.db.sql是项目中用到的表,数据库使用的是oracle11g

2.该项目使用mvn进行管理,私服为自搭建nexus,项目只用到一个第三方 jar,就是oracle的驱动;

3.默认项目为零配置启动,如果需要更改启动方式,请

- 《开源框架那点事儿16》:缓存相关代码的演变

j2eetop

开源框架

问题引入

上次我参与某个大型项目的优化工作,由于系统要求有比较高的TPS,因此就免不了要使用缓冲。

该项目中用的缓冲比较多,有MemCache,有Redis,有的还需要提供二级缓冲,也就是说应用服务器这层也可以设置一些缓冲。

当然去看相关实现代代码的时候,大致是下面的样子。

[java]

view plain

copy

print

?

public vo

- AngularJS浅析

kvhur

JavaScript

概念

AngularJS is a structural framework for dynamic web apps.

了解更多详情请见原文链接:http://www.gbtags.com/gb/share/5726.htm

Directive

扩展html,给html添加声明语句,以便实现自己的需求。对于页面中html元素以ng为前缀的属性名称,ng是angular的命名空间

- 架构师之jdk的bug排查(一)---------------split的点号陷阱

nannan408

split

1.前言.

jdk1.6的lang包的split方法是有bug的,它不能有效识别A.b.c这种类型,导致截取长度始终是0.而对于其他字符,则无此问题.不知道官方有没有修复这个bug.

2.代码

String[] paths = "object.object2.prop11".split("'");

System.ou

- 如何对10亿数据量级的mongoDB作高效的全表扫描

quentinXXZ

mongodb

本文链接:

http://quentinXXZ.iteye.com/blog/2149440

一、正常情况下,不应该有这种需求

首先,大家应该有个概念,标题中的这个问题,在大多情况下是一个伪命题,不应该被提出来。要知道,对于一般较大数据量的数据库,全表查询,这种操作一般情况下是不应该出现的,在做正常查询的时候,如果是范围查询,你至少应该要加上limit。

说一下,

- C语言算法之水仙花数

qiufeihu

c算法

/**

* 水仙花数

*/

#include <stdio.h>

#define N 10

int main()

{

int x,y,z;

for(x=1;x<=N;x++)

for(y=0;y<=N;y++)

for(z=0;z<=N;z++)

if(x*100+y*10+z == x*x*x

- JSP指令

wyzuomumu

jsp

jsp指令的一般语法格式: <%@ 指令名 属性 =”值 ” %>

常用的三种指令: page,include,taglib

page指令语法形式: <%@ page 属性 1=”值 1” 属性 2=”值 2”%>

include指令语法形式: <%@include file=”relative url”%> (jsp可以通过 include