hadoop安装(window10)

一、下载和winutils

1.下载:http://archive.apache.org/dist/hadoop/core/

官网下载:http://hadoop.apache.org/releases.html (提供最新的几个版本)

https://github.com/steveloughran/winutils(windows安装需要)

如果出现“Bandwidth limit exceeded”-限制下载,可以用迅雷下载,本人直接用迅雷下载;

或者参考:https://blog.csdn.net/docsz/article/details/118520724

二、解压

将tar.gz包解压至D盘根目录:Note:必须用管理员权限解压

三、配置环境变量:

新建系统变量:

变量名:HADOOP_HOME

变量值:你的hadoop位置 E:\hadoop\hadoop-2.8.0\hadoop-2.8.0

编辑Path系统路径 %HADOOP_HOME%\bin

四.编辑hadoop的文件

java 路径不能有空格,采用以下配置方式或者没有空格的目录set JAVA_HOME=C:\PROGRA~1\Java\jdk1.8.0_172;

打开 \etc\hadoop\hadoop-enc.cmd文件,修改JAVA_HOME为你自己的jdk路径 。注意你的JDK安装在Program Files目录下,

名称用名称用\PROGRA~1\Java 否则中间的空格可能会识别失败。

更改为:

五、配置

5.1、配置core-site.xml

修改D:/hadoop-3.0.0/etc/hadoop/

fs.default.name

hdfs://localhost:9000

5.2、修改D:/hadoop-3.0.0/etc/hadoop/ mapred-site.xml配置(是mapred-site.xml.template,去掉template):

mapreduce.framework.name

yarn

5.3、在:/hadoop-3.0.0目录下创建data目录,作为数据存储路径:

5.4、修改D:/hadoop-3.0.0/etc/hadoop/ hdfs-site.xml配置:

dfs.replication

1

dfs.permissions

false

dfs.namenode.name.dir

/D:/hadoop-3.0.0/data/namenode

fs.checkpoint.dir

/D:/hadoop-3.0.0/data/snn

fs.checkpoint.edits.dir

/D:/hadoop-3.0.0/data/snn

dfs.datanode.data.dir

/D:/hadoop-3.0.0/data/datanode

注意:记得把上边地址改为自己电脑hadoop的地址;

5.5、修改D:/hadoop-3.0.0/etc/hadoop/ yarn-site.xml配置:

![]()

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.auxservices.mapreduce.shuffle.class

org.apache.hadoop.mapred.ShuffleHandler

六、bin目录替换

下载:https://github.com/steveloughran/winutils

安装的是3.0.0版本,所以用3.0.0中bin去替换;

将文件D:\job\hadoop\hadoop-2.7.7\bin\hadoop.dll复制到以下位置

D:\job\hadoop\hadoop-2.7.7\sbin

C:\Windows\System32

检查Hadoop是否安装成功:

运行“Hadoop version”,成功如下:

七、启动服务

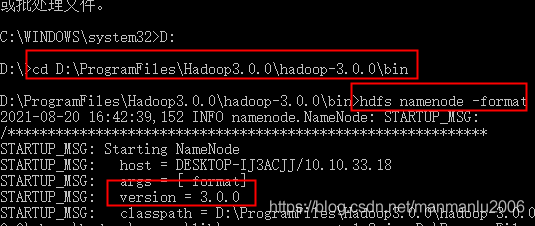

以管理员身份打开命令提示符 打开cmd,cd到安装目录下的bin,并执行命令:

hdfs namenode -format (注意 :-前面有空格)

上图失败,是环境变量问题,或者配置Hadoop环境变量后重新启动;

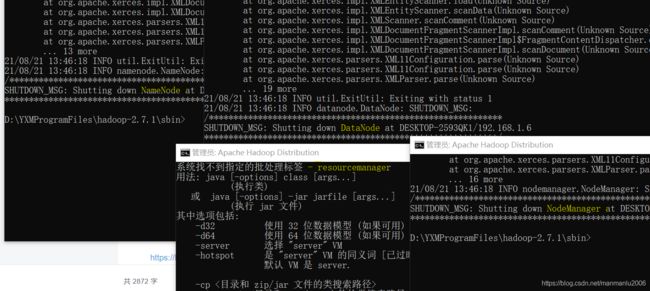

我在自己笔记本重新安装了Hadoop2.7.1,运行如下:(同样的步骤)

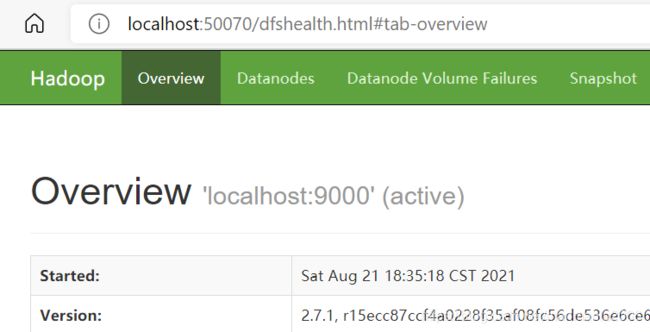

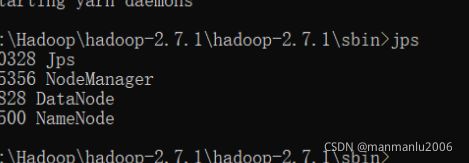

我以为安装成功,运行jps- 命令时,只显示一个进程;我查看了启动窗口,是core-site.xml有错,UTF-8问题,打开文件才发现,是中文错误。重新配置,重新格式化,重新启动,运行成功。如下:

访问http://localhost:50070,访问hadoop的web界面:

我另一台电脑装的hadoop3.0.0,访问50070却打不开, hadoop3需要访问://localhost:9870

在浏览器地址栏中输入:http://localhost:8088查看集群状态 。(或者用http://IP:8088)

------------------------------------------------------------

八、问题

1、java version “1.7.0”

2、Hadoop version “2.7.1”

3、Windows10

同样配置过程,但是查看运行程序,发现resourcemanager未能启动

解决方法

进入bin目录下(注意,不是sbin目录),使用notepad++打开yarn.cmd,选择 编辑–>文档格式转换–>转为Windows格式,保存,重新启动Hadoop,访问成功

————————————————

版权声明:本文为CSDN博主「凯桑嗓子都喊哑了」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/qq_39831963/article/details/108794418

参考:

https://blog.csdn.net/Sylarjyd/article/details/91038732

https://blog.csdn.net/songhaifengshuaige/article/details/79575308

https://codechina.csdn.net/mirrors/steveloughran/winutils?utm_source=csdn_github_accelerator

https://www.cnblogs.com/lcycn/p/8595945.html