Hadoop环境搭建

作者:后端小知识

CSDN个人主页:后端小知识

GZH:

后端小知识欢迎关注点赞收藏⭐️留言

文章目录

-

- Hadoop环境搭建

-

- 前言

- 虚拟机环境准备

- 克隆虚拟机

- 在hadoop102安装JDK

- 在hadoop102安装Hadoop

- Hadoop目录结构

Hadoop环境搭建

前言

最近在网上学习了下Hadoop,顺便记录了下笔记,笔记内容来源于某谷,能够方便大家直接粘贴使用提效,另外在线学习本节会涉及到较多的虚拟机知识和Linux知识,学习后再来阅读更佳额

虚拟机环境准备

这里就默认大家已经安装好VM虚拟机了,并且已经装上了Centos7的镜像了(如果友友们确实有需要的话,私信或者评论区留言,人多的话我也出个教程)

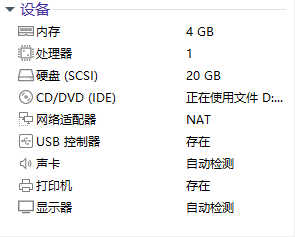

这是我的虚拟机上的设备详情(自己电脑的配置是16+256)

配置虚拟机

首先先ping一下百度,看看虚拟机是否有网络

[root@hadoop102 ~]# ping www.baidu.com

安装epel-release

[root@hadoop102 ~]# yum install -y epel-release

关闭防火墙,关闭防火墙开机自启(这些都是Linux的基本命令额)

[root@hadoop102 ~]# systemctl stop firewalld

[root@hadoop102 ~]# systemctl disable firewalld.service

在/opt目录下创建文件夹

在/opt目录下创建module、software文件夹

[root@hadoop102 ~]# mkdir /opt/module

[root@hadoop102 ~]# mkdir /opt/software

卸载虚拟机自带的JDK

[root@hadoop102 ~]# rpm -qa | grep -i java | xargs -n1 rpm -e --nodeps

- rpm -qa:查询所安装的所有rpm软件包

- grep -i:忽略大小写

- xargs -n1:表示每次只传递一个参数

- rpm -e –nodeps:强制卸载软件

重启虚拟机

reboot

克隆虚拟机

利用模板机hadoop102,克隆一台虚拟机(看你们电脑配置情况进行克隆,配置好的,可以克隆三台):hadoop103

【Tips】克隆前请先关闭hadoop102

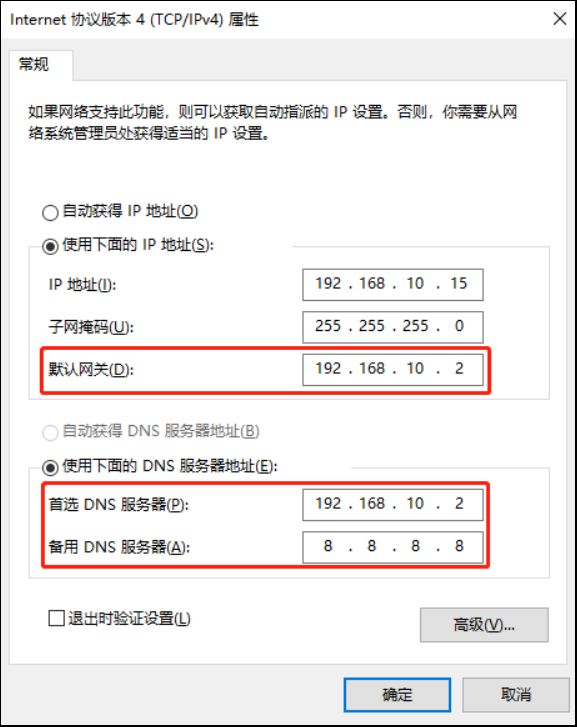

修改克隆机ip,以下hadoop103举例说明

修改克隆虚拟机的静态IP

[root@hadoop103 ~]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

将里面的内容改成

DEVICE=ens33

TYPE=Ethernet

ONBOOT=yes

BOOTPROTO=static

NAME="ens33"

IPADDR=192.168.10.102

PREFIX=24

GATEWAY=192.168.10.2

DNS1=192.168.10.2

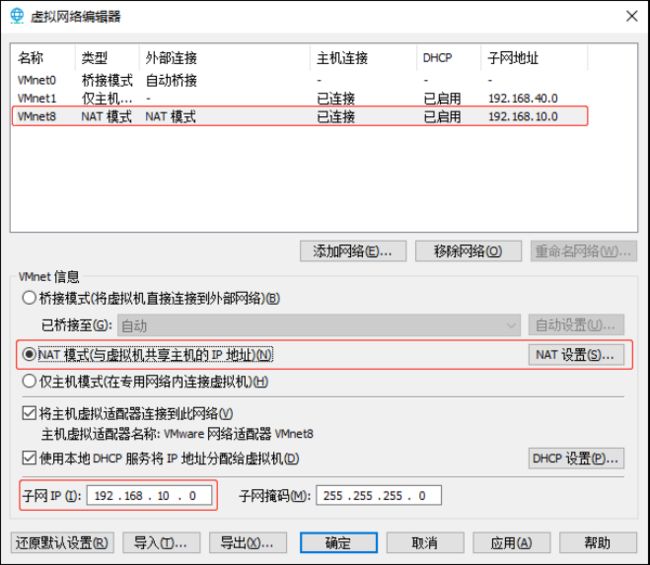

查看Linux虚拟机的虚拟网络编辑器,编辑->虚拟网络编辑器->VMnet8

然后查看Windows系统适配器VMware Network Adapter VMnet8的IP地址

保证Linux系统ifcfg-ens33文件中IP地址、虚拟网络编辑器地址和Windows系统VM8网络IP地址相同。

修改克隆机主机名,以下以hadoop102举例

(1)修改主机名称

[root@hadoop103 ~]# vim /etc/hostname

将里面的内容改为 hadoop103

(2)配置Linux克隆机主机名称映射hosts文件,打开/etc/hosts

[root@hadoop103 ~]# vim /etc/hosts

添加下面的内容

192.168.10.102 hadoop102

192.168.10.103 hadoop103

⚽重启克隆机hadoop103

reboot

修改windows的主机映射文件(hosts文件)

hosts文件路径 C:\Windows\System32\drivers\etc

先把文件复制到桌面去,然后用记事本打开,添加如下内容

192.168.10.102 hadoop102

192.168.10.103 hadoop103

然后将桌面hosts文件覆盖C:\Windows\System32\drivers\etc路径hosts文件

在hadoop102安装JDK

如果需要安装包的友友可以私信博主哟,这里默认大家都有安装包的额

解压JDK到module目录下

[root@hadoop102 software]# tar -zxvf jdk-8u212-linux-x64.tar.gz -C /opt/module/

配置JDK环境变量

在目录 /etc/profile.d/ 下面新建my_env.sh文件

[root@hadoop102 ~]# sudo vim /etc/profile.d/my_env.sh

添加下面的内容

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

保存退出:按ESC,然后 :wq

source一下

[root@hadoop102 ~]# source /etc/profile

测试JDK是否安装成功

java -version

在hadoop102安装Hadoop

Hadoop下载地址:https://archive.apache.org/dist/hadoop/common/hadoop-3.1.3/

解压安装文件到/opt/module下

[root@hadoop102 software]# tar -zxvf hadoop-3.1.3.tar.gz -C /opt/module/

将hadoop添加到环境变量中

(1)打开/etc/profile.d/my_env.sh文件

[root@hadoop102 hadoop-3.1.3]# vim /etc/profile.d/my_env.sh

(2)在后面添加如下内容

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

(3)保存并退出,然后再source下

[root@hadoop102 hadoop-3.1.3]# source /etc/profile

测试是否安装成功

hadoop version

Hadoop目录结构

查看Hadoop目录结构

[root@hadoop102 hadoop-3.1.3]# ll

重要目录

(1)bin目录:存放对Hadoop相关服务(hdfs,yarn,mapred)进行操作的脚本

(2)etc目录:Hadoop的配置文件目录,存放Hadoop的配置文件

(3)lib目录:存放Hadoop的本地库(对数据进行压缩解压缩功能)

(4)sbin目录:存放启动或停止Hadoop相关服务的脚本

(5)share目录:存放Hadoop的依赖jar包、文档、和官方案例

好啦,环境搭建章节就到这儿就结束了额,大家快快行动起来吧

【都看到这了,点点赞点点关注呗,爱你们】

结语

谢谢你的阅读,由于作者水平有限,难免有不足之处,若读者发现问题,还请批评,在留言区留言或者私信告知,我一定会尽快修改的。若各位大佬有什么好的解法,或者有意义的解法都可以在评论区展示额,万分谢谢。

写作不易,望各位老板点点赞,加个关注!

作者:后端小知识

CSDN个人主页:后端小知识

GZH:后端小知识

欢迎关注点赞收藏⭐️留言