红外与可见光图像融合入门教学

红外与可见光图像融合入门教学

- 什么是红外与可见光图像融合

- 论文

-

- DeepFuse

- DenseFuse

- RFN-Nest

- FusionGAN

- DDcGAN

- AttentionFGAN

- GANMcC

- 总结

博主目前马上进入研二阶段,也算是入门了红外与可将光图像领域,正好总结下,以供刚接触该领域的萌新们参考。

如有侵权请联系博主

什么是红外与可见光图像融合

对于我们刚入门的小伙伴,你可能会有一个疑惑,为什么要进行红外与可见光融合?

难道就是给你一张红外,一张可见光,直接无脑融合吗?

显然不是的,这里我们来看下示例图像

首先我们可以看到的是,红外图像中有一个明显的目标信息,何为目标信息?

![]()

这张图中就是人的信息。我们看到的是一个浑身发光的人在奔跑,但是他奔跑的场景是什么? 我们在红外图像中是看不到背景信息的纹理信息的。那么什么是纹理信息? 接下来我们来看一看。

看向可见光图像,在这张图像中你看不到奔跑的人,你甚至回觉得,这和红外图像拍摄的时间绝对不一样,而这正是红外与可见光融合的意义。

看向下图,你发现什么?是不是发现可将光图像中较为清晰的看到叶子的信息,相比于红外图像来说是不是更加清晰,这些内容就被我们称为纹理信息。

了解了这些内容之后,我们就可以说一说红外与可将光图像融合到底是融什么了?

通俗来讲,就是将上文中所描述的目标信息和纹理信息集成在一张图像中,即融合图像。我们希望融合图像应当是有保留红外图像的目标强度信息,同时也会保留可见光图像的纹理信息,如下图。

到了这里,你就对图像融合有一个初步的理解了,这里为了方便大家理解,粗字体描述的内容其实是最开始做红外与可见光图像融合时大家的对其的认知,在你研究了多篇论文之后,你就会发现,红外图像中的纹理信息也是不可或缺的一部分,同时可见光图像也存在一些极其亮的东西,也是我们想要保留的。

接下来一起看看有什么论文吧。

论文

以下论文顺序是我认为还可以的读论文顺序,以供大家参考,每一篇论文的介绍最开始有原文链接和博主自己的论文解读。

DeepFuse

DeepFuse论文链接

DeepFuse论文解读

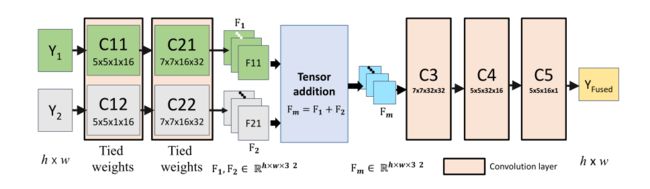

我还是倾向于将这篇论文放在第一篇,很经典的一篇文章,可以从这篇开始读。

DenseFuse

DenseFuse论文链接

DenseFuse论文解读

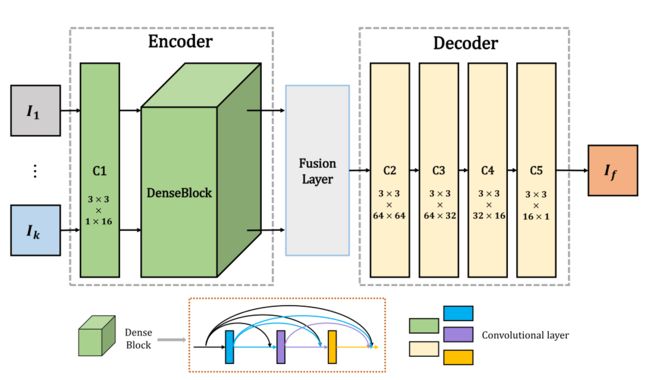

在读完DeepFuse之后就可以开始看DenseFuse了,DenseFuse的网络结构与DeepFuse的很类似,创新的是,DenseFuse将DenseNet整合进了Encoder(解码器)中,这就大大减少了编码过程中的信息损失。

下图这样的网络结构为自动编码器,所谓自动编码器就是有一个编码器(Encoder)一个解码器(Decodeer)和一个中间层(Fusion Layer)。这种网络结构的好处就是可以单独的训练编码器和解码器,在二者训练完成之后,可以再去选择合适的中间层。

分开训练的意义是什么呢?

前期我们所用的数据集的大小是很小的,这就导致了容易过拟合现象的出现。那我们怎么才能提高网络的泛化能力呢?这时候就可以使用哪些数据量很大的数据集先进行编码器和解码器的训练,使其拥有极强的特征提取能力和图像还原能力,然后最后再并入我们的中间层,融合性能就会有很大的提升。

RFN-Nest

RFN-Nest论文链接

RFN-Nest论文解读

此时你可能觉得跳度有点大,因为这篇论文的时间和前两篇相差时间较大,但是你是绝对可以看懂的。如果有问题可以先看看NestFuse,但是博主是直接看的这个,还是可以的。

看下网络结构,你会发现和前面的好像没啥关系,但其实该网络结构依然是自动编码器结构,不同的是编码器和融合层采用多尺度的网络结构,而融合层不再是手动设计的,而是采用神经网络。详细的内容可以参考原文和解读。

FusionGAN

FusionGAN论文链接

FusionGAN论文解读

看了这么多篇基于自动编码器的论文,是不是有点累了,那来换一换,来看一种新的思路。到这了就必须得说一说了,马佳义大佬首次将GAN引入到红外与可将光图像融合的开山之作。只能说无敌。

DDcGAN

DDcGAN论文链接

DDcGAN论文解读

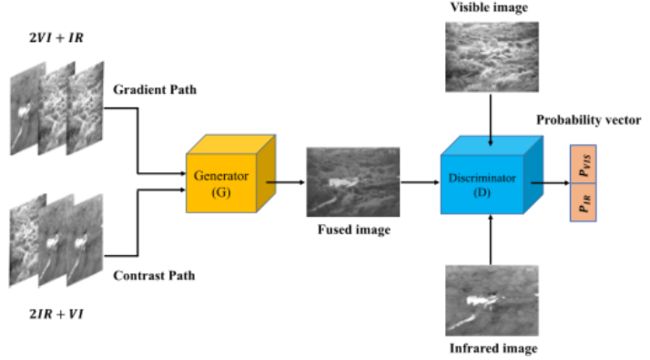

FusionGAN的单鉴别器会导致融合图像中红外与可见光图像的信息的不均衡,因此大佬们又开发一种双鉴别器。旨在促使融合图像中信息更加均衡。

AttentionFGAN

AttentionFGAN论文链接

AttentionFGAN论文解读

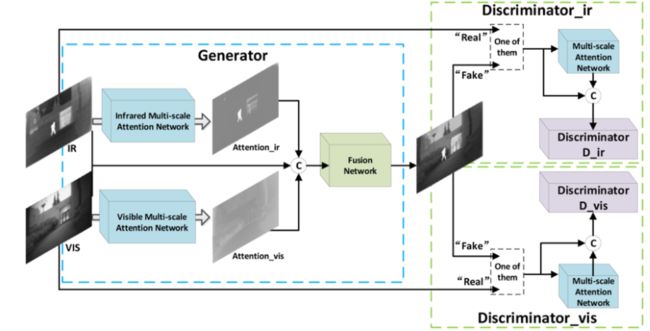

延续了双辨别器的一片论文,引入了注意力机制,通过我们希望注意的区域的特征的对比来判断融合图像中是否包含了可视的纹理信息和红外图像中的目标信息。

GANMcC

GANMcC论文链接

GANMcC论文解读

双鉴别器需要设置一个合理的循环训练策略,一旦策略设置的有问题,也会导致信息的不均衡,而如何设置合理的策略是极其有挑战性的。因此大佬们又开发了多分类鉴别器,基于单鉴别器实现信息的均衡。

总结

时间有限,先介绍这几篇,更多论文解读欢迎关注图像融合专栏。

》》图像融合专栏《《

有图像融合领域的问题欢迎大家私信我,或则公众号联系也可。