人工智能:神经细胞模型到神经网络模型

人工智能领域中的重要流派之一是:从神经细胞模型(Neural Cell Model)到神经网络模型(Neural Network Model)。

一、神经细胞模型

第一个人工神经细胞模型是“MP”模型,它是由麦卡洛克、匹茨合作,于1943年研究成功的,这是关于神经细胞模型的奠基性工作,因而人们认为它是从脑的生物原型出发探讨人工智能的开创性成果。

“MP”模型从微观上对脑的基本单元——神经细胞的下列特性进行了模拟:

1.神经细胞的“兴奋”“抑制”两种状态,认为神经细胞的活动遵守“全或无”定律。

2.神经细胞之间的“突触”联系,分为兴奋型突触、抑制型突触。

3.神经细胞的输入、输出、多输入、单输出。输入称为“树突”,输出称为“轴突”。

4.神经细胞的空间整合作用,对不同输入端传入细胞的神经电脉冲进行信号处理。

5.神经细胞的阈值效应,当输入电脉冲的时空整合结果,使细胞膜电位升高超过阈值时,细胞兴奋,产生输出冲动。

在“MP”模型的基础上,克里纳(S.C.Kleene)等学者进一步发展与完善,研制了带有反馈的闭环神经细胞模型,在神经细胞模型的基本逻辑阈值元件的基础上,发展了“自动机理论”(Automata)。

改进的神经细胞模型,考虑了神经细胞“结构可塑性”,即突触联结系数的可变性,神经细胞之间的联结强度的可调节性。1949年,心理学家荷布(D.O.Hebb)在其著作《组织行为》(Organization Behavior)中指出,当神经细胞参与某种心理活动时,细胞之间的联结通路的信息传导能力将会增强,即所谓“Hebb学习规则”。此外,他还考虑了神经细胞对输入信号的时间整合作用、突触延时、不应期等。利用改进的神经细胞模型,可以研究神经细胞的学习功能、遗传特性、疲劳效应。

二、神经网络模型

在神经细胞模型的基础上,可进一步研究各种神经网络模型,或称为“脑模型”。

50年代末到60年代初,曾出现过人工神经网络或脑模型研究的第一次高潮,例如:

“感知机”(Perceptron),是1957年由罗森勃拉特(F.Rosenblatt)等研制的,具有视觉感知与分类学习功能,最早的、最著名的脑模型。

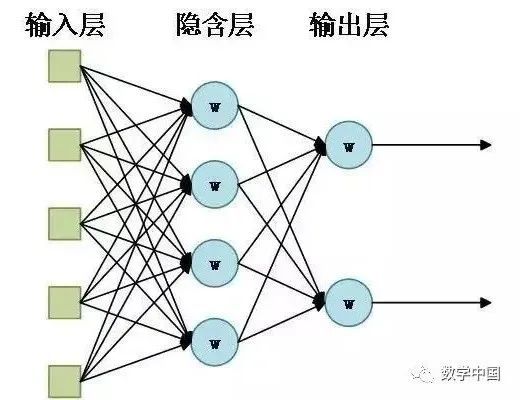

简单感知机为三层结构:

1.输入层:感受神经网络。

2.联系层:中枢神经网络。

3.输出层:效应神经网络。

通过示教学习与样本训练,采用对“刺激—反应”的奖惩方式,感知机可以进行某些简单的文字识别、图像识别、声音识别。

在60年代初期,感知机曾盛行一时,据估计有近百个研究机构和公司,从事各种类型的感知机的研究和开发工作,进行文字、图像、声音识别的实验,例如,Mark I、Mark Ⅱ等。

但是,由于简单感知机在原理和功能上的局限性,对复杂图像的感知能力低,对非线性分类识别问题缺乏有效学习方法,以及受到当时电子技术水平的限制,人们对感知机的过高期望没有得到实现。

1969年,美国麻省理工学院(MIT)出版了关于感知机的专著《Perceptrons:An Introduction to Computational Geometry》,作者为明斯基(M.L.Minsky)等,对简单感知机的研究结果进行了总结与系统的分析,指出简单感知机有严重的缺陷,无法识别线性不可分的模式,即使简单的异或问题,也无能为力。这种批评更促使感知机与神经网络的研究在70年代落入了低潮。

但是,仍有不少学者在困难条件下坚持人工神经网络的研究。例如:1969年,日本学者中野提出了“联想机”(Associatron);1972年,永野研究了“多层学习脑模型”;1973年,福岛提出了“认知机”(Cognitron)。

此外,除了从微观仿生学观点研究上述基于阙逻辑元件的神经网络,还有从宏观仿生学观点研究的人工神经网络,例如:1961年,德国学者斯泰布什(Steinbuch)提出的“学习矩阵”;1963年,李(Lee)提出的“人造神经元”(Artron)“拟神经元”(Neurotron)等。

80年代初期,人工神经网络的研究开始复苏。

1982年,荷普菲尔德(J.Hopfield)提出一种新的全互连型的人工神经网络,被称为“Hopfield网络”,引入所定义的能量函数,成功地求解了计算复杂度为NP完全型的“旅行商”问题。这项突破性的进展,再度唤起了人们对神经网络的研究热情。

1983年,欣顿(J.Hinton)、谢诺夫斯基(T.Sejnowski)研制出“Boltzman机”。基于这种神经网络模型,采用“模拟退火”方法,求解非线性动力学系统的优化问题,可以使系统从局部极小状态跳出,趋向于全局极小状态。

1986年,鲁姆哈特(D.Rumelhart)和麦卡兰德(J.Mc Clelland)发表了他们主编的“PDP”研究报告(Parall Distributing Processing-Explorations in the Microstructures of Cognition),公布了基于人工神经网络的并行分布处理的新进展,提出了关于认知过程的微结构理论。

同时,鲁姆哈特、维伯斯(P.Werbos)等研制出新一代的多层感知机,称之为反向传播神经网络(Back Propagation),简称“BP”网络。其中,在简单感知机上增加了中枢神经网络的联系层数,以构成多层感知机,并且采用反向传播的学习算法,利用反馈信息进行层间误差修正,从而突破了简单感知机的局限性,提高了多层感知机的识别能力,可用于求解非线性感知与复杂模式识别问题。

1986年,人工神经网络的又一项新进展是:自适应共振理论ART,它是由格罗斯伯格(S.Grossberg)、卡彭特(G.Carpenter)提出的。他们所研制的ART神经网络,具有良好的自适应特性。

1987年,首届国际人工神经网络学术大会在美国的圣迭戈(San-Diego)举行,在大会期间成立了国际神经网络协会(International Neural Netuork Society)简称INNS,掀起了人工神经网络研究的第二次高潮。

转自:人工智能:神经细胞模型到神经网络模型