ICCV2023 | 基于动作敏感性学习的时序动作定位

淘天集团-内容理解算法团队与浙江大学杨易教授团队合作的关于视频时序定位的论文被ICCV2023录取。

本文在业界首次将视频帧级别的细粒度信息引入至时序动作定位领域(Temporal Action Localization,TAL),对于时序动作定位任务,在单一标注(single-labeled)、密集标注(dense-labeled)和第一人称视角(egocentric)等类型数据集上,性能普遍超过SOTA。

动机

视频时序动作定位(Temporal Action Localization,TAL)是视频理解领域一个重要的任务。这个任务需要对于给定的视频,识别出其中所有发生的动作,同时定位出每个动作发生的起始时间。视频时序动作定位的方法可以广泛应用于高光检测、行为监控以及短视频分析等领域。

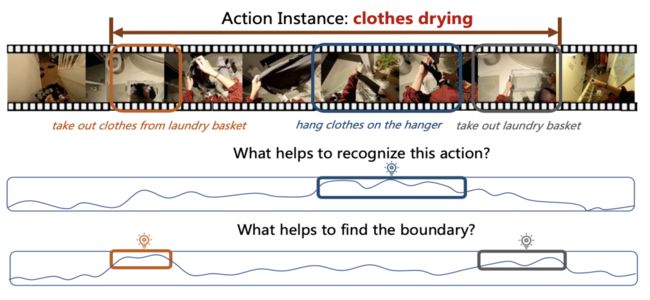

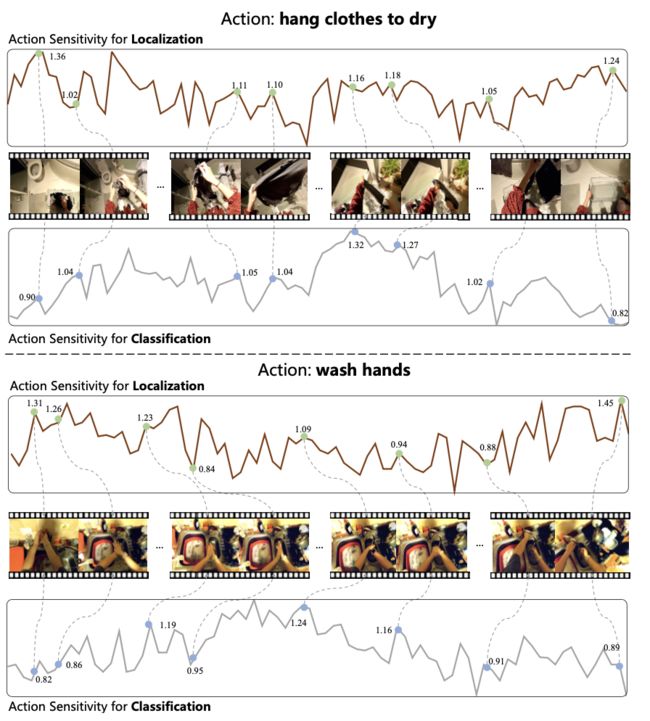

在过去对这个任务的处理中,大多数方法或是建立整体的时序提议,再对其做分类和定位;或是直接对不同帧同等地进行预测。但事实上,我们发现视频中动作内部的帧是有不同重要性的。以图1为例,对于晾衣服动作,描绘“把衣服晾到衣架上”的帧对于识别出这个动作最重要,描绘“拿出衣服”的帧对于定位出这个动作的开始最重要。而一些例如转场或模糊的帧则不具有很高的重要度。

因此我们提出用动作敏感度来表征帧的重要度,提出动作敏感性学习(action sensitivity learning),对于每一帧的动作敏感度进行建模,并将学习到的敏感度应用于损失函数中,以促进模型更关注重要的帧,从而更好的训练。

图1: 晾衣服为案例的动机说明

观察和动机

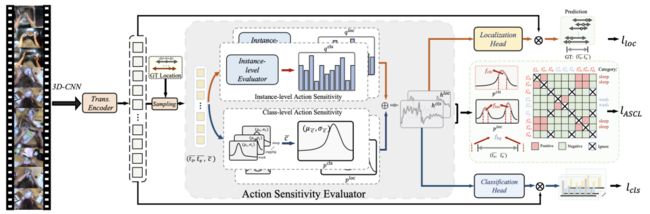

图2:动作敏感性学习框架图

考虑到每种动作都有其本质的行为模式,但这种模式又在不同的场景或行为主体下有不同的偏移,因此我们提出从类别级别和实例级别对动作敏感性进行建模。同时,对于动作定位子任务,由于边界的不确定性和边界附近帧的不同语义信息,最敏感的帧也不一定在边界处,因此我们分别对动作分类和动作定位两个子任务都进行动作敏感性学习。整体的框架图如图2所示。

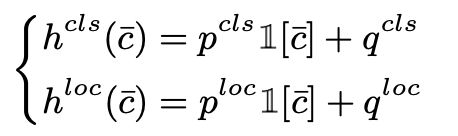

在类别级别的建模中,由于视频本身信息具有连续性,且存在一些关键帧,因此我们提出为每种动作使用一个可学习的高斯分布来建模其类别级别的动作敏感性。具体而言,针对分类子任务的类别级别动作敏感性pcls建模为:

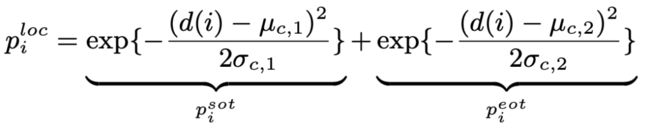

针对定位子任务的类别级别动作敏感性ploc建模为:

其中μc,σc为可学习的参数。

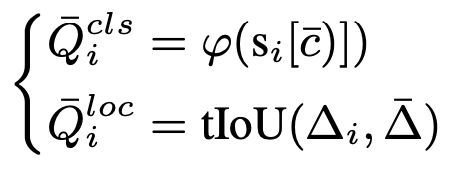

在实例级别的建模中,考虑到重要的帧往往做出的预测质量比较高,模糊帧则相反,因此我们提出建立每一帧的预测质量,用质量来指导实例级别的学习。具体而言,以针对分类子任务的实例级别动作敏感性为例,我们首先通过实例建模网络预测实例级别的动作敏感性结果qcls,之后通过分类分数和时序维度上与真值的重叠度得到质量分数Q:

然后基于MSE损失,学习实例建模网络:

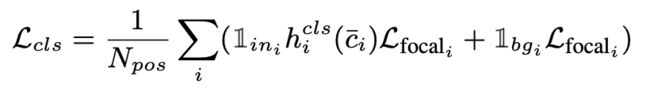

最后我们将类别级别和实例级别的动作敏感度做和,并嵌入到损失函数中:

具体而言,我们对每一帧都通过Focal损失进行分类的学习,对每一个在动作内部的帧都基于DIoU损失进行回归的学习,在此基础上每一帧的损失函数前再乘以学习到的动作敏感度:

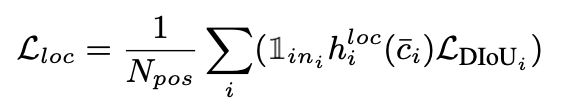

此外,我们还引入了动作敏感度对比学习损失来进一步增强特征,具体而言,我们通过上文的动作敏感性学习,得到针对两个子任务的敏感特征,将这两部分作为正样本,同时将其他不同动作类别以及背景帧作为负样本,基于InfoNCE的形式进行学习:

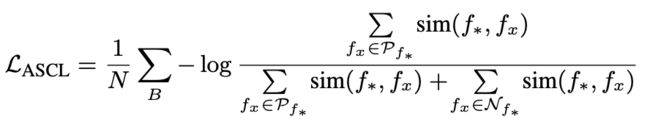

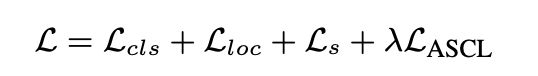

因而最终的损失函数表示为:

实验

我们在3大类共6个数据集上验证了我们的方法,包括:密集标注的MultiThumos和Charades,见表1,我们提出的方法在average mAP指标上大幅超越以往方法。

表1: 在MultiThumos和Charades上的结果

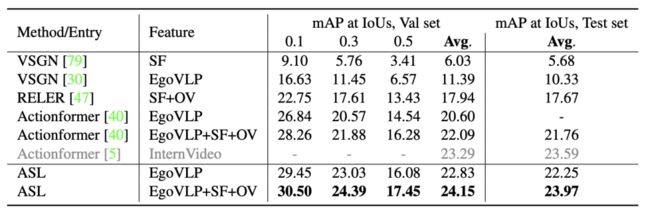

密集标注且第一人称视角的Ego4D-Moment Query,见表2,在使用相同特征且公平对比下,我们的方法同样在验证集和测试集上都优于过去方法。

表2:在Ego4D Moment Queries上的结果

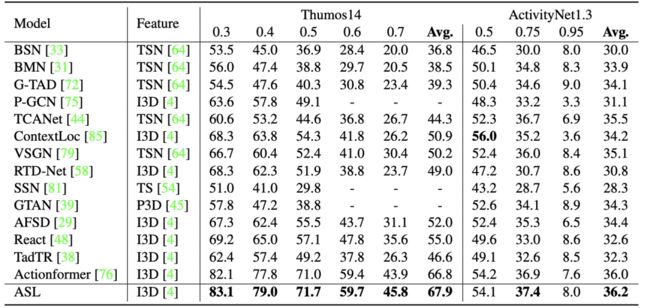

单一标注的Thumos14和ActivityNet,见表3,由于在单一标注数据集上动作实例较少,我们提出方法中的对比学习部分收益较少,但整体仍然优于之前的SOTA方法。

表3:在Thumos和ActivityNet上的结果

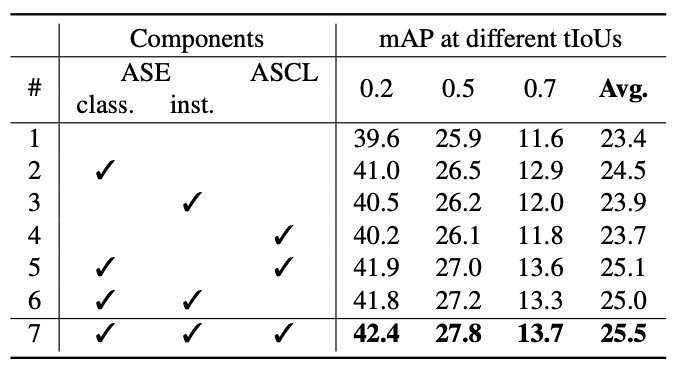

表4展示了部分消融实验结果,ASL结构中类别级别建模、实例级别建模都挖掘了帧之间不同的重要性,进而提升了average mAP指标。而融合了动作敏感性对比学习损失后,进一步增强了特征,获得了最佳性能。

表4:在MultiThumos上的消融实验

图3展示了ASL的可视化结果,表明了我们提出的方法能够找到动作内部一些重要的帧(如描绘“把衣服晾到衣架上”,“水流流经手”的这些帧对于分类子任务具有了较高的重要度),而一些转场、模糊的帧则被赋予了较低的重要度。

图3: 部分可视化结果

总结

本文从挖掘动作内部不同帧的不同重要性入手,提出了动作敏感性学习(ASL)。通过从类别级别和实例级别建模的方式,学习到每一帧的敏感度,并融入进损失函数中,以促进模型更好的训练。同时还提出敏感度对比学习损失,进一步加强特征。本文提出的方法刷新了多个数据集时序动作定位任务的SOTA指标。相关算法将会有助于进一步提高淘宝短视频内容理解的精准性。

Reference

Zhang C L, Wu J, Li Y. Actionformer: Localizing moments of actions with transformers[C]//European Conference on Computer Vision. Cham: Springer Nature Switzerland, 2022: 492-510.

Yeung S, Russakovsky O, Jin N, et al. Every moment counts: Dense detailed labeling of actions in complex videos[J]. International Journal of Computer Vision, 2018, 126: 375-389.

Caba Heilbron F, Escorcia V, Ghanem B, et al. Activitynet: A large-scale video benchmark for human activity understanding[C]//Proceedings of the ieee conference on computer vision and pattern recognition. 2015: 961-970.

Grauman K, Westbury A, Byrne E, et al. Ego4d: Around the world in 3,000 hours of egocentric video[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2022: 18995-19012.

Sigurdsson G A, Gupta A, Schmid C, et al. Charades-ego: A large-scale dataset of paired third and first person videos[J]. arXiv preprint arXiv:1804.09626, 2018.

Damen D, Doughty H, Farinella G M, et al. Scaling egocentric vision: The epic-kitchens dataset[C]//Proceedings of the European conference on computer vision (ECCV). 2018: 720-736.

Yu-Gang Jiang, Jingen Liu, A Roshan Zamir, George Toderici, Ivan Laptev, Mubarak Shah, Rahul Sukthankar. Thumos challenge: Action recognition with a large number of classes. 2014

团队介绍

淘天集团-算法技术-内容理解团队,依托淘天亿级的视频数据,构建完善的内容理解体系,支撑淘宝信息流、逛逛、淘宝直播、点淘等淘系核心业务。团队成员曾多次获得CVPR、ICCV等顶会竞赛冠军,积累的多项多模态理解能力,发布在如NIPS、CVPR、ICCV、ECCV、TPAMI、TIP、MM等顶级和期刊上。

团队介绍

淘天集团-算法技术-内容理解团队,依托淘天亿级的视频数据,构建完善的内容理解体系,支撑淘宝信息流、逛逛、淘宝直播、点淘等淘系核心业务。团队成员曾多次获得CVPR、ICCV等顶会竞赛冠军,积累的多项多模态理解能力,发布在如NIPS、CVPR、ICCV、ECCV、TPAMI、TIP、MM等顶级和期刊上。

¤ 拓展阅读 ¤

3DXR技术 | 终端技术 | 音视频技术

服务端技术 | 技术质量 | 数据算法