互联网大厂造AI芯片,前景如何?

来源|杭派工程师

文|太浪

字节跳动宣布自研AI芯片,百度自研的AI芯片“昆仑”完成独立融资,投后估值达130亿元人民币……最近,AI芯片有点火。

为什么好像一夜之间大家都在造AI芯片?

01

AI 场景遇到算力瓶颈

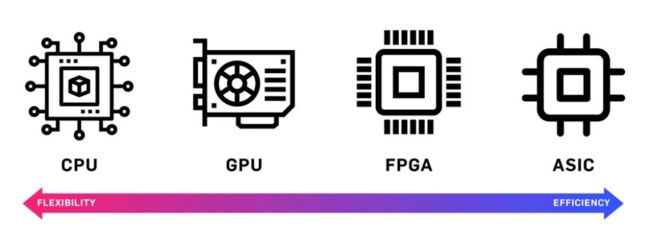

和传统CPU不用,AI芯片被认为是可以高效运行人工智能算法的芯片。

AI发展至今,已有60多年的历史,分别在上世纪50年代(基于符号逻辑的推理证明)、80年代(基于人工规则的专家系统)以及2006年(大数据驱动的深度学习神经网络)掀起热潮,呈螺旋式发展。

算力、算法、数据是AI的三要素,三者相互作用,相互促进。

2007年以前,受限于当时算法和数据等因素,AI对芯片还没有特别强烈的需求,通用的CPU芯片即可提供足够的计算能力。

随着智能手机的普及,3G、4G移动通信网络技术的发展及大规模部署,有力促进了中国移动互联网快速发展,手机游戏、视频应用、移动音乐、购物APP等移动互联网应用普及,带来数据流量的爆发式增长,也对算力提出更高需求。

传统CPU无法高效运行AI算法(尤其是深度学习算法),GPU(图形处理器)芯片取得迅速的发展。因为AI深度学习的模型参数多、数据规模大、计算量大, 而GPU有更多的逻辑运算单元用于处理数据,属于高并行结构,在处理图形数据和复杂算法方面比CPU更有优势。GPU采用并行架构,超过80%部分为运算单元,具备较高性能运算速度。相比较下,CPU仅有20%为运算单元,更多的是逻辑单元。此后一段时间内,GPU代替了CPU,成为当时AI芯片的主流。

然而GPU毕竟只是图形处理器,不是专门用于AI深度学习的芯片在执行AI应用时,其并行结构的性能无法充分发挥,导致能耗高。

与此同时,AI技术的应用日益增长,在教育、医疗、无人驾驶等领域都能看到AI的身影,FPGA芯片和ASIC芯片便出场了。

FPGA,全称“现场可编程门阵列”,其基本原理是在FPGA芯片内集成大量的基本门电路以及存储器,用户可以通过更新FPGA配置文件来定义这些门电路以及存储器之间的连线。可以理解为,FPGA是需要它有哪些功能、它就能有哪些功能的芯片。

ASIC,专用集成电路,是为实现特定要求而定制的芯片。虽然牺牲了通用性,但它无论是在性能、功耗还是体积上,都比FPGA和GPU芯片有优势,特别是在需要芯片同时具备高性能、低功耗、小体积的移动端设备上。但相对开发周期长,功能难以扩展。

虽然FPGA的性能比不上ASIC芯片,价格也比ASIC芯片更高。但在芯片需求还未成规模、深度学习算法需要不断迭代改进的情况下,具备可重构特性的FPGA芯片适应性更强。

还有一点需要明确,这些为加速计算能力而存在的AI芯片,并不能取代CPU。CPU作为核心逻辑处理器,统一进行任务调度。AI加速芯片与CPU往往要协同作业。

CPU在AI时代式微,GPU、FPGA、ASIC这些芯片纷纷闪亮登场后,成就了多家芯片企业。其中,英伟达凭借GPU领域的霸主地位,在过去5年股价飙升20倍,并在2020年7月9日超过英特尔 ,成为全球市值最高的芯片设计企业、世界第三大半导体公司。

02

科技公司布局AI芯片的姿势

当然,在AI芯片这件事上,不再是传统的芯片公司唱独角戏。

谷歌率先举起互联网企业造AI芯片的大旗,发布TPU,亚马逊、微软、阿里巴巴、华为、百度等也纷纷发布各自的AI芯片,包括寒武纪、地平线机器人、燧原科技(被腾讯连投4次)、依图等AI创业公司和海康威视、大华等传统企业也在AI芯片领域布局。

▲谷歌TPU

和传统芯片厂商不同,互联网公司造芯有其独特的优势,他们更接近场景,能够更好地根据场景做针对性的优化。

例如,在阿里巴巴集团内部,仅淘宝就拥有视觉、NLP、搜索推荐等AI场景,平头哥发布的第一款芯片含光800就是视觉AI推理芯片,资料显示,这款芯片创造了两项纪录,推理性能达到78563IPS,能效比500IPS/W,两项指标均为AI推理芯片第一。1颗含光800的算力相当于10颗GPU。

去年6月,含光800正式实现大规模商用,在阿里云上为企业提供AI云服务,目前已应用于视频处理、搜索推荐等场景。

刚刚宣布研发芯片的字节跳动同样拥有大量的AI应用场景。

字节跳动,通过AI算法,让“内容找人”成为常态。除了推荐系统,其广告系统、评论系统,以及内容合规性审核系统,也都是AI技术在背后做支撑。

比如,使用自然语言处理等技术,对文章内容、用户评论等进行分析,进而进行内容推荐和内容审核;将计算机视觉技术用于抖音、火山、FaceU激萌等短视频App上,用来做人脸特效、背景分割、“尬舞机”、内容审核、封面选择、AI剪辑等;利用计算机视觉、语音识别、NLP等技术进行内容审核,发现不良内容、恶意营销等。

这些AI技术的研发与落地应用,都需要底层算力的支持。据悉,仅今日头条一款产品30天的训练模型,数据量就超过4PB,而正常训练一个完整的模型则需要至少一年的数据量48PB。1PB等于2的50次方个字节,在数值上大约等于1000个TB。人类功能记忆的容量预计在1.25TB,这意味着,800个人类记忆才相当于1个PB。更有体感的表述是,假设手机播放MP3的编码速度为平均每分钟1MB,而1首歌曲的平均时长为4分钟,那么1PB歌曲可以连续播放2000年。

过去几年,字节跳动接连推出今日头条、抖音等产品,不断收割流量。无论是精准推荐、精准营销、还是制定定制化的激励方案吸引用户付费/购买,都需要用到AI技术。随之而来的是,要处理的数据量也呈指数级增长。2018年,今日头条每日数据处理量超过50PB、存储数据超过1500PB、评论系统每天的评论数大概有1亿条。数据显示,2017年,字节跳动的服务器数量只有2到3万台,2018年这一数字猛增到17万台。

03

以AI芯片入局的互联网公司已成芯片产业新势力

传统通用芯片称霸数十年,但互联网企业通过AI芯片已拿到芯片研发的入场券,这一阵营的芯片版图必然不仅限于此,他们可以向新型通用芯片(新型CPU)延伸。

在从网上书店转型为云计算巨头的过程中,亚马逊成为全球最大的数据中心服务器芯片买家之一。随着云业务的扩张,该公司越来越专注于设计自己的芯片,而非直接购买它们。

2015年,亚马逊以3.5亿美元的高价收购了以色列一家小型新品设计公司Annapurna Labs,为其数据中心里的硬件设备定制芯片。据悉,Annapurna Labs自被亚马逊收购后,员工规模已经增加了10倍。

亚马逊不仅推出了专注于AI推理的芯片inferentia,还推出了一款新的ARM服务器芯片Graviton,并已迭代到2.0版本。据亚马逊介绍,AWS Graviton 2的速度比以前一代的芯片快7倍,浮点性能是2倍。

在线图片服务商Smugmug通过AWS的服务每天向用户展示数十亿张照片,他们改为使用Graviton芯片上运行的AWS后,将相关成本降低了40%。

阿里平头哥推出基于RISC-V指令集打造的CPU IP核“玄铁910”,用于设计制造高性能端上芯片,应用于5G、人工智能以及自动驾驶等领域。华为推出自研CPU芯片鲲鹏。百度推出通用AI处理器“昆仑”系列。

定制芯片的激增可能会进一步降低高性能计算产品的成本,并激发创新,这对各方来说都是好事。

而且,可以想见的是,在日益激烈的云计算市场竞争中,各自芯片的优势很有可能被拿出来作为卖点。

但这些公司都只负责芯片设计,并不生产自家芯片的生产,因此,它们依赖同一条国际芯片供应链。

自从新冠疫情爆发以来,整个芯片制造业的供应链(从芯片原材料到芯片产能)均受到影响。如果危机持续下去,将减缓这些企业的技术进步速度,进而侵蚀其利润空间。

网易智能开通视频号啦~Tech逆向思维是网易智能旗下专注专注于科技、AI领域大公司大事件、新观点新应用和当下科技热点的科普号。

来!带你换个角度看世界~

最新视频→【中国 5G 比美国领先十倍?基建狂魔超车在哪?】

欢迎大家留言互动,关注我们~

RECOMMEND

“

网易智能有12个不同垂直领域社群等你来

添加智能菌微信:kaiwu_club

”扫码了解更多