【深度学习】Pytorch 系列教程(四):PyTorch数据结构:2、张量操作(Tensor Operations):(1)数学运算:

目录

一、前言

二、实验环境

三、PyTorch数据结构

0、分类

1、张量(Tensor)

2、张量操作(Tensor Operations)

1. 数学运算

a. 基本运算

b. 向量运算

c. 矩阵运算

d. 广义矩阵运算

高阶张量的乘法

卷积

e. 梯度计算

一、前言

ChatGPT:

PyTorch是一个开源的机器学习框架,广泛应用于深度学习领域。它提供了丰富的工具和库,用于构建和训练各种类型的神经网络模型。下面是PyTorch的一些详细介绍:

动态计算图:PyTorch使用动态计算图的方式进行计算,这意味着在运行时可以动态地定义、修改和调整计算图,使得模型的构建和调试更加灵活和直观。

强大的GPU加速支持:PyTorch充分利用GPU进行计算,可以大幅提升训练和推理的速度。它提供了针对GPU的优化操作和内存管理,使得在GPU上运行模型更加高效。

自动求导:PyTorch内置了自动求导的功能,可以根据定义的计算图自动计算梯度。这简化了反向传播算法的实现,使得训练神经网络模型更加便捷。

大量的预训练模型和模型库:PyTorch生态系统中有许多预训练的模型和模型库可供使用,如TorchVision、TorchText和TorchAudio等,可以方便地加载和使用这些模型,加快模型开发的速度。

高级抽象接口:PyTorch提供了高级抽象接口,如

nn.Module和nn.functional,用于快速构建神经网络模型。这些接口封装了常用的神经网络层和函数,简化了模型的定义和训练过程。支持分布式训练:PyTorch支持在多个GPU和多台机器上进行分布式训练,可以加速训练过程,处理大规模的数据和模型。

总体而言,PyTorch提供了一个灵活而强大的平台,使得深度学习的研究和开发更加便捷和高效。它的简洁的API和丰富的功能使得用户可以快速实现复杂的神经网络模型,并在各种任务中取得优秀的性能。

二、实验环境

本系列实验使用如下环境

conda create -n DL python=3.7 conda activate DLpip install torch==1.8.1+cu102 torchvision==0.9.1+cu102 torchaudio==0.8.1 -f https://download.pytorch.org/whl/torch_stable.html

conda install matplotlib关于配置环境问题,可参考前文的惨痛经历:

三、PyTorch数据结构

0、分类

- Tensor(张量):Tensor是PyTorch中最基本的数据结构,类似于多维数组。它可以表示标量、向量、矩阵或任意维度的数组。

- Tensor的操作:PyTorch提供了丰富的操作函数,用于对Tensor进行各种操作,如数学运算、统计计算、张量变形、索引和切片等。这些操作函数能够高效地利用GPU进行并行计算,加速模型训练过程。

- Variable(变量):Variable是对Tensor的封装,用于自动求导。在PyTorch中,Variable会自动跟踪和记录对其进行的操作,从而构建计算图并支持自动求导。在PyTorch 0.4.0及以后的版本中,Variable被废弃,可以直接使用Tensor来进行自动求导。

- Dataset(数据集):Dataset是一个抽象类,用于表示数据集。通过继承Dataset类,可以自定义数据集,并实现数据加载、预处理和获取样本等功能。PyTorch还提供了一些内置的数据集类,如MNIST、CIFAR-10等,用于方便地加载常用的数据集。

- DataLoader(数据加载器):DataLoader用于将Dataset中的数据按批次加载,并提供多线程和多进程的数据预读功能。它可以高效地加载大规模的数据集,并支持数据的随机打乱、并行加载和数据增强等操作。

- Module(模块):Module是PyTorch中用于构建模型的基类。通过继承Module类,可以定义自己的模型,并实现前向传播和反向传播等方法。Module提供了参数管理、模型保存和加载等功能,方便模型的训练和部署。

1、张量(Tensor)

【深度学习】Pytorch 系列教程(一):PyTorch数据结构:1、Tensor(张量):维度(Dimensions)、数据类型(Data Types)_QomolangmaH的博客-CSDN博客https://blog.csdn.net/m0_63834988/article/details/132909219?spm=1001.2014.3001.5501https://blog.csdn.net/m0_63834988/article/details/132909219?spm=1001.2014.3001.5501![]() https://blog.csdn.net/m0_63834988/article/details/132909219?spm=1001.2014.3001.5501

https://blog.csdn.net/m0_63834988/article/details/132909219?spm=1001.2014.3001.5501

2、张量操作(Tensor Operations)

PyTorch提供了丰富的操作函数,用于对Tensor进行各种操作,如数学运算、统计计算、张量变形、索引和切片等。这些操作函数能够高效地利用GPU进行并行计算,加速模型训练过程。

1. 数学运算

a. 基本运算

b. 向量运算

c. 矩阵运算

【深度学习】Pytorch 系列教程(三):PyTorch数据结构:2、张量操作(Tensor Operations):(1)数学运算:基本运算、向量运算、矩阵运算_QomolangmaH的博客-CSDN博客![]() https://blog.csdn.net/m0_63834988/article/details/132910898?spm=1001.2014.3001.5501

https://blog.csdn.net/m0_63834988/article/details/132910898?spm=1001.2014.3001.5501

d. 广义矩阵运算

广义矩阵是指维度大于2的张量,可以进行高阶张量的运算,如高阶张量的乘法、卷积等。

-

高阶张量的乘法

import torch

# 创建两个高阶张量

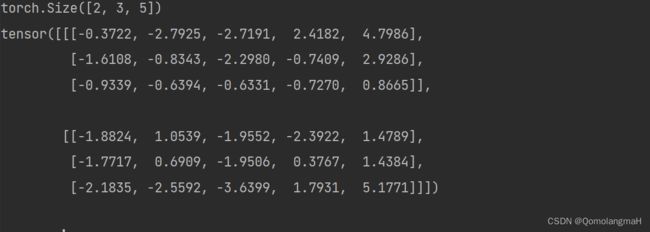

tensor1 = torch.randn((2, 3, 4)) # shape为(2, 3, 4)的张量

tensor2 = torch.randn((4, 5)) # shape为(4, 5)的张量

# 进行高阶张量的乘法运算

result = torch.matmul(tensor1, tensor2)

print(result.shape) # 输出结果的形状输出:

torch.Size([2, 3, 5])-

卷积

import torch

import torch.nn.functional as F

# 定义输入序列和卷积核

input_sequence = torch.tensor([2, 0, 1], dtype=torch.float32)

kernel = torch.tensor([1, 2, 3], dtype=torch.float32)

# 将输入序列和卷积核进行翻转

input_sequence = torch.flip(input_sequence, [0]) # 翻转输入序列

kernel = torch.flip(kernel, [0]) # 翻转卷积核

# 将输入序列和卷积核调整为合适的形状

input_sequence = input_sequence.view(1, 1, -1) # 输入序列的形状: (batch_size, input_channels, sequence_length)

kernel = kernel.view(1, 1, -1) # 卷积核的形状: (output_channels, input_channels, kernel_size)

# 使用conv1d函数进行卷积运算

output = F.conv1d(input_sequence, kernel)

print(output)e. 梯度计算

梯度计算在深度学习中非常重要,它用于优化模型参数和进行反向传播。在PyTorch中,可以使用自动微分(Automatic Differentiation)来计算梯度。

import torch

# 创建一个张量,并设置requires_grad=True以跟踪其梯度

x = torch.tensor(3.0, requires_grad=True)

# 定义一个函数

y = x**2 + 2*x + 1

# 计算梯度

y.backward()

# 打印梯度

print(x.grad)输出:

tensor(8.) 在上面的示例中,我们创建了一个张量x,并将requires_grad设置为True,以便PyTorch跟踪它的梯度。然后,我们定义了一个函数y,它是x的平方加上2乘以x再加上1。接下来,我们调用y.backward()来计算梯度。最后,我们打印出x.grad来获取x的梯度,其值为8.0。

通过使用自动微分,PyTorch可以自动计算复杂函数的梯度,这对于训练神经网络和优化模型参数非常有用。可以在模型训练过程中使用梯度来更新参数,并实现反向传播算法。