hbase 集群搭建

hbase 集群搭建

- 1、安装步骤

-

- 1.1、安装 zookeeper 集群

- 1.2、下载/解压 hbase

- 1.3、修改配置文件

-

- 1.3.1、hbase-env.sh

- 1.3.2、hbase-site.xml

- 1.3.3、regionservers

- 1.3.4、backup-masters

- 1.4、hadoop 配置文件分发 hbase

- 1.5、 hbase 分发安装到各节点

- 1.6、同步时间

- 1.7、 配置环境变量

- 2、集群启动

-

- 2.1、启动 zookeeper 集群

- 2.2、启动 hdfs 集群

- 2.3、 启动 hbase 集群

- 2.4、 验证集群

1、安装步骤

1.1、安装 zookeeper 集群

点击进入 安装 zookeeper 集群。

1.2、下载/解压 hbase

(1)找到官网下载 hbase 安装包 hbase-1.2.6-bin.tar.gz,这里给大家提供一个下载地址:

http://mirrors.hust.edu.cn/apache/hbase/

对应版本的官方文档:

http://hbase.apache.org/1.2/book.html

(2)下面这是本人使用的版本 hbase-1.6.0-bin.tar.gz(hbase-1.6.0-src.tar.gz) ,里面也有 1.2.6 版本文件:

链接:https://pan.baidu.com/s/1KEAE8UpIDHG9egP51zPsoQ

提取码:pyf3

(3)上传安装包到服务器,并解压到对应的安装目录:

tar -zxvf hbase-1.2.6-bin.tar.gz -C /home/hadoop/apps/

1.3、修改配置文件

进入 Hbase 解压目录中配置文件目录下,Linux 下 pwd 命令查看当前所在全路径:

cd /home/hadoop/apps/hbase-1.2.6/conf

1.3.1、hbase-env.sh

(1)编辑文件:

vi hbase-env.sh

(2)修改这两个地方:

# 表示修改为自己的 jdk 目录

export JAVA_HOME=/home/hadoop/apps/jdk1.8.0_73

# 表示不引用 hbase 自带的 zookeeper,用我们自己安装的

export HBASE_MANAGES_ZK=false

(3)Linux下 vi / vim 编辑命令 :wq 保存退出。

1.3.2、hbase-site.xml

(1)编辑文件:

vi hbase-site.xml

(2)增加以下配置:

<configuration>

<property>

<name>hbase.rootdirname>

<value>hdfs://myha01/hbasevalue>

property>

<property>

<name>hbase.cluster.distributedname>

<value>truevalue>

property>

<property>

<name>hbase.zookeeper.quorumname>

<value>hadoop03:2181,hadoop04:2181,hadoop05:2181value>

property>

configuration>

(3)保存退出。

1.3.3、regionservers

(1)编辑文件:

vi regionservers

(2)修改添加节点信息:

hadoop02

hadoop03

hadoop04

hadoop05

1.3.4、backup-masters

(1)修改 backup-masters(自行创建),指定备用的主节点,该文件是不存在的,先自行创建:

vi backup-masters

(2)添加备用的主节点地址:

hadoop05

1.4、hadoop 配置文件分发 hbase

此步是最重要一步,要把 hadoop 的 hdfs-site.xml 和 core-site.xml 放到 hbase-1.2.6/conf 下:

cp ~/apps/hadoop-2.7.5/etc/hadoop/core-site.xml ~/apps/hbase-1.2.6/conf/

cp ~/apps/hadoop-2.7.5/etc/hadoop/hdfs-site.xml ~/apps/hbase-1.2.6/conf/

1.5、 hbase 分发安装到各节点

scp -r /home/hadoop/apps/hbase-1.2.6 hadoop@hadoop03:/home/hadoop/apps/

scp -r /home/hadoop/apps/hbase-1.2.6 hadoop@hadoop04:/home/hadoop/apps/

scp -r /home/hadoop/apps/hbase-1.2.6 hadoop@hadoop05:/home/hadoop/apps/

1.6、同步时间

HBase 集群对于时间的同步要求的比 HDFS 严格,所以,集群启动之前千万记住要进行时间同步,要求相差不要超过 30s。

查看时间:

# 第一种

date

# 第二种

date -R

# 第三种

date "+%Y-%m-%d %H:%M:%S"

修改时区:

# 第一种

sudo cp /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

# 第二种

sudo ln -sf /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

自动更新时间:

# 第一种

sudo ntpdate ntp.aliyun.com

# 第二种

sudo ntpdate ntp.sjtu.edu.cn

1.7、 配置环境变量

(1)编辑环境配置文件(想用哪种配置方式就随意):

# 第一种

vi ~/.bashrc

# 第二种

vi /etc/profile

(2)添加两行:

export HBASE_HOME=/home/hadoop/apps/hbase-1.2.6

export PATH=$PATH:$HBASE_HOME/bin

(3)保存退出!!!

(4)别忘了使配置生效,执行:

# 第一种

source ~/.bashrc

# 第二种

source /etc/profile

2、集群启动

启动顺序别搞错了!!!!!!

2.1、启动 zookeeper 集群

在每个节点上都执行启动命令:

zkServer.sh start

2.2、启动 hdfs 集群

在 hdfs 集群 namenode 节点机器(HA 集群的话选其中一个 namenode 节点就可以了) 上执行启动命令:

start-dfs.sh

2.3、 启动 hbase 集群

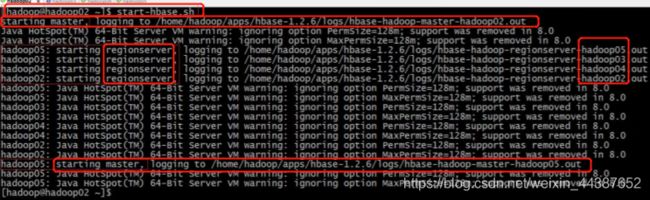

保证 ZooKeeper 集群和 HDFS 集群启动正常的情况下启动 HBase 集群,除了在配置的备用主节点 hadoop05 上启动之外,其余节点都可以启动(一个节点执行就可以了),启动命令:

start-hbase.sh

观看启动日志可以看到:

(1)首先在命令执行节点启动 master;

(2)然后分别在 hadoop02,hadoop03,hadoop04,hadoop05 启动 regionserver;

(3)然后在 backup-masters 文件中配置的备用主节点 hadoop05 上再启动一个 master 主进程。

2.4、 验证集群

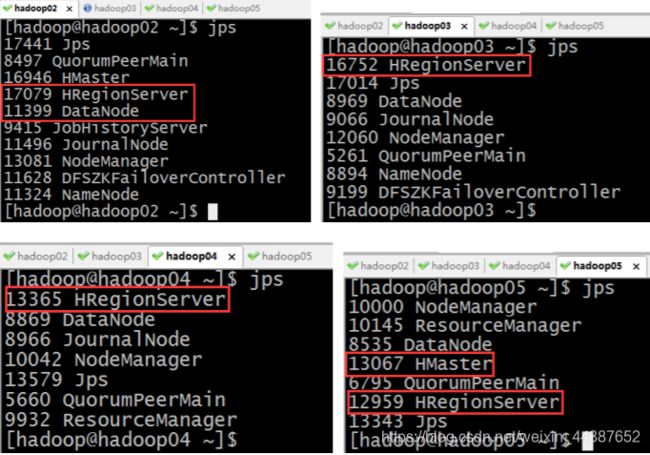

(1)检查各进程是否启动正常:主节点和备用节点都启动 HMaster 进程,各从节点都启动 HRegionServer 进程。

按照对应的配置信息各个节点应该要启动的进程如上图所示。

(2)通过访问浏览器页面,格式为”主节点:16010”:

http://hadoop02:16010/

(3)如果有节点相应的进程没有启动,那么可以手动启动:

hbase-daemon.sh start master

hbase-daemon.sh start regionserver