LVS负载均衡群集

- LVS负载均衡群集

-

- 一、群集应用概述

-

- 1、群集的含义

- 2、问题

- 3、解决方法

- 二、群集分类

-

- 1、群集类型

-

- 1.1、负载均衡群集(LB)

- 1.2、高可用群集(HA)

- 1.3、高性能运算群集(HPC)

- 三、负载均衡群集架构

-

- 1、负载均衡的结构

- 四、LVS负载均衡群集工作模式分析

-

- 1、群集的负载调度技术工作模式

-

- 1.1、NAT模式(地址转换)

- 1.2、TUN模式(IP隧道)

- 1.3、DR模式(直接路由)

- 五、关于LVS虚拟服务器

-

- 1、ip_vs模块

- 2、LVS的负载调度算法

- 3、ipvsadm工具

- 4、LVS-NAT部署

-

- 1)部署共享存储

- 2)配置节点服务器

- 3)配置负载调度器

-

- (1)添加网卡

- (2)修改客户端网卡配置

- (3)开启调度器ip转发功能

- (4)修改节点服务器网关地址

- (5)配置SNAT规则

- (6)加载LVS内核模块

- (7)安装ipvsadm管理工具

- (8)配置负载分配策略

- 4)客户端测试效果

- 5、补充知识

LVS负载均衡群集

一、群集应用概述

1、群集的含义

Cluster,集群、群集

由多台主机构成,都干同一件事,但对外只表现为一个整体,只提供一个访问入口(域名或IP地址),相当于一台大型计算机。

2、问题

互联网应用中,随着站点对硬件性能、响应速度、服务稳定性、数据可靠性等要求越来越高,单台服务器已经无法满足负载均衡及高可用的要求。

3、解决方法

- 使用价格昂贵的小型机、大型机

- 使用多台相对廉价的普通服务器构建服务群集

通过整合多台服务器,使用LVS来达到服务器的高可用和负载均衡,并以同一个IP地址对外提供相同的服务。

二、群集分类

1、群集类型

负载均衡群集

高可用群集

高性能运算群集

1.1、负载均衡群集(LB)

-

提高应用系统的响应能力、尽可能处理更多的访问请求、减少延迟为目标,获得高并发、高负载(LB)的整体性能

典型代表:软件类:LVS、Nginx、HAProxy 等 硬件类:F5、绿盟

-

LB的负载分配依赖于主节点的分流算法,将来自客户机的访问请求分担给多个服务器节点,从而缓解整个系统的负载压力。例如,“DNS轮询”“ “反向代理”等

1.2、高可用群集(HA)

-

提高应用系统的可靠性、尽可能地减少中断时间为目标,确保服务的连续性,达到高可用(HA)的容错效果(通常使用N个9来代表高可用的指标)

典型代表:keepalived heartbeat

-

HA的工作方式包括双工和主从两种模式,双工即所有节点同时在线;主从则只有主节点在线,但当出现故障时从节点能自动切换为主节点。例如,“故障切换”“双机热备”等

1.3、高性能运算群集(HPC)

- 以提高应用系统的CPU运算速度、扩展硬件资源和分析能力为目标,获得相当于大型、超级计算机的高性能运算(HPC)能力

- 高性能依赖于“分布式运算”、“并行计算”,通过专用硬件和软件将多个服务器的CPU 内存等资源整合在一起,实现只有大型、超级计算机才具备的计算能力。例如,“云计算”“网格计算”等

- 通过云计算或分布式计算获取高性能的CPU、内存等资源,来提高整体运算能力

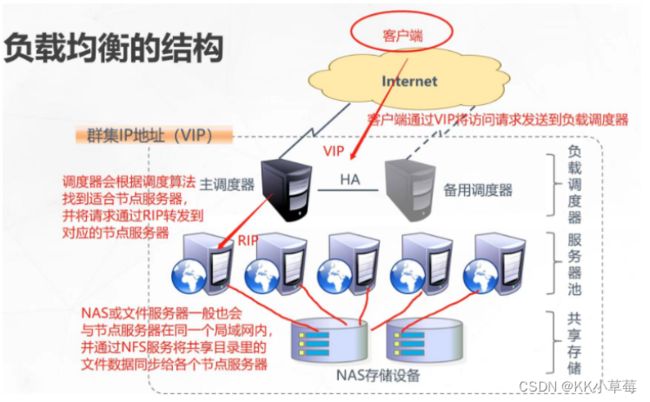

三、负载均衡群集架构

1、负载均衡的结构

-

第一层,负载调度器

访问整个群集系统的唯一入口,对外使用所有服务器共有的VIP地址,也称为群集 IP地址。通常会配置主、备两台调度器实现热备份,当主调度器失效以后能够平滑替换至备用调度器,确保高可用性。

-

第二层,服务器池

群集所提供的应用服务、由服务器池承担,其中每个节点具有独立的RIP地址(真实IP),只处理调度器分发过来的客户机请求。当某个节点暂时失效时,负载调度器的容错机制会将其隔离,等待错误排除以后再重新纳入服务器池。

-

第三层,共享存储

为服务器池中的所有节点提供稳定、一致的文件存取服务,确保整个群集的统一性。共享存储可以使用NAS设备,或者提供NFS共享服务的专用服务器。

四、LVS负载均衡群集工作模式分析

1、群集的负载调度技术工作模式

- 地址转换

- IP隧道

- 直接路由

1.1、NAT模式(地址转换)

- Network AddressTranslation,简称NAT模式

- 类似于防火墙的私有网络结构,负载调度器作为所有服务器节点的网关,即作为客户端的访问入口,也是各节点回应客户端的访问出口,也就是说调度器会承载双向数据流量的负载压力,可能会成为整个群集的性能瓶颈。

- 由于节点服务器都处于内网环境,使用私网IP地址,与负载调度器位于同一个物理网络,安全性要优于其他两种方式

1.2、TUN模式(IP隧道)

- IPTunnel,简称TUN模式

- 采用开放式的网络结构,负载调度器仅作为客户端的访问入口,各节点通过各自的Internet连接直接回应客户端,而不再经过负载调度器。

- 由于节点服务器需要部署在不同位置的公网环境中,需要具有独立的公网IP,调度器与节点服务器是通过专用的IP隧道实现相互通信的,因此IP隧道模式的成本较高、安全性较低,且IP隧道需要额外的封装和解封装,性能会受到一定的影响。

1.3、DR模式(直接路由)

- Direct Routing,简称DR模式

- 采用半开放式的网络结构,调度器仅作为客户端的访问入口,节点服务器的响应消息是直接返回给客户端的,不需要经过调度器(与NAT模式的区别),但各节点并不是分散在各地,而是与调度器位于同一个物理网络。

- 负载调度器与各节点服务器是部署在同一个物理网络内,因此不需要建立专用的IP隧道。(与TUN模式的区别)

五、关于LVS虚拟服务器

- 针对Linux内核开发的负载均衡解决方案

- LVS实际上相当于基于IP地址的虚拟化应用,为基于IP地址和内容请求分发的负载均衡提出了一种高效的解决方法。

- 官方网站:http://www.linuxvirtualserver.org/

- LVS只能支持四层代理,并且LVS不能进行端口转换

1、ip_vs模块

LVS现在已成为Linux内核的一部分,默认编译为ip_vs模块,必要时能够自动调用。

modprobe ip_vs

#加载ip_vs模块

cat /proc/net/ip_vs

#查看当前系统中ip_vs模块的版本信息

#查看linux系统支持多少种ip_vs模块

cd /usr/lib/modules/3.10.0-693.el7.x86_64/kernel/net/netfilter/ipvs

ls

#ip_vs的模块

#怎么加载ip_vs的所有模块?

cd /usr/lib/modules/3.10.0-693.el7.x86_64/kernel/net/netfilter/ipvs

#用for循环,把所有模块遍历一遍

for i in `/usr/lib/modules/3.10.0-693.el7.x86_64/kernel/net/netfilter/ipvs`

do

k=`echo $i | awk -F.'{print $1}'`

#用k去获取每一次遍历后获得的模块名

modprode $k

#再用modprode加载每个模块

done

2、LVS的负载调度算法

LVS调度器常见算法(均衡策略)?

LVS调度器用的调度方法基本分为两类:

固定调度算法:rr,wrr,dh,sh

rr:轮询算法,将请求依次分配给不同的rs节点,即Rs节点中均摊分配。适合于Rs所有节点处理性能接近的情况。

wrr:加权轮训调度,依据不同RS的权值分配任务。权值较高的RS将优先获得任任务,并且分配到的连接数将比权值低的RS更多。相同权值的RS得到相同数目的连接数。

dh:目的地址哈希调度(destination hashing)以目的地址为关键字查找一个个静态hash表来获得所需RS。

sh:源地址哈希调度(source hashing)以源地址为关键字查找一个静态hash表来获得需要的RS。

动态调度算法:wlc,lc,lblc

wlc:加权最小连接数调度,假设各台RS的权值依次为wi,当前tcp连接数依次为Ti,依次去Ti/wi为最小的RS作为下一个分配的RS。

lc:最小连接数调度(least-connection),IPVS表存储了所有活动的连接。 LB会比较将连接请求发送到当前连接最少的RS。

lblc:基于地址的最小连接数调度(locality-based least-connection):将来自同一个目的地址的请求分配给同一台RS,此时这台服务器是尚未满负荷的。否则就将这个请求分配给连接数最小的Rs,并以它作为下一次分配的首先考虑。

3、ipvsadm工具

ipvsadm 工具选项说明:

-A:添加虚拟服务器

-D:删除整个虚拟服务器

-s:指定负载调度算法(轮询:rr、加权轮询:wrr、最少连接:lc、加权最少连接:wlc)

-a:表示添加真实服务器(节点服务器)

-d:删除某一个节点

-t:指定 VIP地址及 TCP端口

-r:指定 RIP地址及 TCP端口

-m:表示使用 NAT群集模式

-g:表示使用 DR模式

-i:表示使用 TUN模式

-w:设置权重(权重为 0 时表示暂停节点)

-p 60:表示保持长连接60秒(默认关闭连接保持)

-l:列表查看 LVS 虚拟服务器(默认为查看所有)

-n:以数字形式显示地址、端口等信息,常与“-l”选项组合使用。ipvsadm -ln

4、LVS-NAT部署

实验环境:

LVS调度器作为Web服务器池的网关,LVS两块网卡,分别连接内外网,使用轮询(rr)调度算法。

NFS共享服务器:192.168.210.103(7-3)

LVS负载调度器(双网卡):192.168.210.104(7-4)

内网关ens33:192.168.210.104

外网关ens36:12.0.0.10

Web服务器池:节点服务器1:192.168.210.105(7-5)

节点服务器2:192.168.210.106(7-6)

客户端:192.168.210.107

1)部署共享存储

7-3(192.168.210.103)

systemctl stop firewalld.service

setenforce 0

#关闭防火墙

yum install rpcbind nfs-utils -y

#安装rpcbind nfs-utils

systemctl start rpcbind.service

systemctl start nfs.service

#开启服务

mkdir /opt/kkk1 /opt/kkk2

#创建两个共享目录

echo 'this is kkk1 test web page!' > /opt/kkk1/test.html

echo 'this is kkk2 test web page!' > /opt/kkk2/test.html

#准备两个页面

ls /opt/kkk1

ls /opt/kkk2

#查看是否生成test.html文件

cat /opt/kkk1/test.html

cat /opt/kkk2/test.html

#查看文件内容

vim /etc/exports

#添加共享目录

/opt/kkk1 192.168.210.0/24(rw,sync,no_root_squash)

/opt/kkk2 192.168.210.0/24(rw,sync,no_root_squash)

#sync:同时同步到内存和硬盘当中

#async:先同步到内存,内存再统一刷到磁盘中

#no_root_squash:如果客户端的root用户进行写入的话不进行降权

exportfs -rv

#发布共享

showmount -e

#查看共享文件

sync和async的区别?

async的写入效率比较高,但是不是很安全

sync的io消耗比较大,读写效率变慢

2)配置节点服务器

7-5(192.168.210.105)

yum install -y httpd

#安装apache服务

vim /etc/httpd/conf/httpd.conf

#修改配置文件

ServerName www.bkg.com:80

#修改主机名

KeepAlive off

#在最后一行添加,LVS只能支持四层代理转发,四层代理转发会受到长连接的影响,为了保证饰演的流畅性,要关闭长连接

mount 192.168.210.103:/opt/kkk1 /var/www/html/

#把7-3服务器/opt/kkk1挂载到7-5服务器的/var/www/html/

df -hT

#查看挂载

cd /var/www/html/

ls

#去/var/www/html/查看是否有test.html

cat test.html

#查看文件内容

systemctl start httpd

#开启apache服务

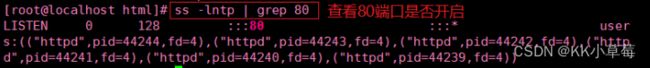

ss -lntp | grep 80

#查看80端口是否开启

7-6(192.168.210.106)

cd /etc/yum.repos.d/

mkdir bak

mv *.repo bak

vim nginx.repo

[nginx]

name=nginx repo

baseurl=http://nginx.org/packages/centos/$releasever/$basearch/

gpgcheck=1

enabled=1

gpgkey=https://nginx.org/keys/nginx_signing.key

module_hotfixes=true

yum install nginx -y

#yum安装nginx

vim /etc/nginx/nginx.conf

keepalive_timeout 0;

#关闭长连接

systemctl start nginx

#开启nginx服务

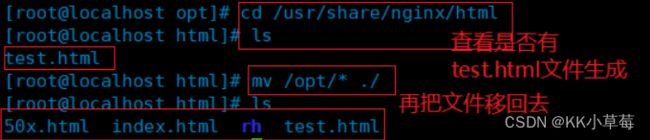

cd /usr/share/nginx/html

ls

mv * /opt/

#把/usr/share/nginx/html目录下的文件移到opt目录下

cd /opt/

mount 192.168.210.103:/opt/kkk2 /usr/share/nginx/html

##把7-3服务器/opt/kkk1挂载到7-6服务器的/usr/share/nginx/html目录

df -hT

#查看挂载

cd /usr/share/nginx/html

ls

#查看是否有test.html文件

mv /opt/* ./

ls

#再把文件移回到/usr/share/nginx/html目录

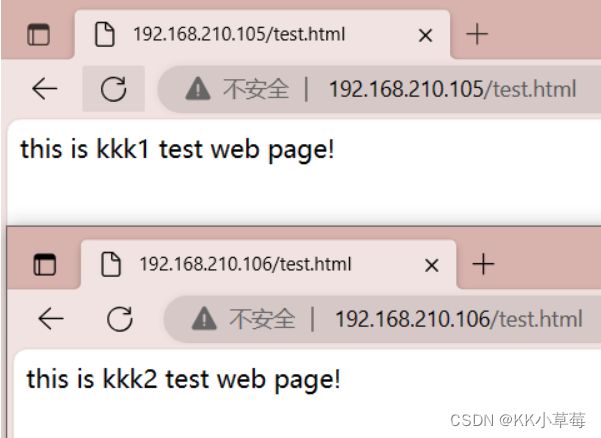

#在浏览器访问

http://192.168.210.105/test.html

http://192.168.210.106/test.html

3)配置负载调度器

(1)添加网卡

7-4(192.168.210.104)

#先添加一个网卡

systemctl stop firewalld.service

setenforce 0

#关闭防火墙

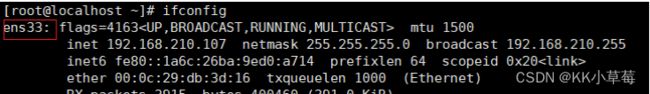

ifconfig

#查看网卡

cd /etc/sysconfig/network-scripts/

cp ifcfg-ens33 ifcfg-ens36

vim ifcfg-ens36

#设置网卡地址,注释掉网关和DNS

NAME=ens36

DEVICE=ens36

ONBOOT=yes

IPADDR=12.0.0.10

NETMASK=255.255.255.0

vim ifcfg-ens33

#注释掉网关和DNS

#GATEWAY=192.168.210.2

#DNS1=8.8.8.8

#DNS2=218.2.135.1

systemctl restart network

#重启网卡

ifconfig

#查看网卡

(2)修改客户端网卡配置

7-7

ifconfig

#查看网卡

vim /etc/sysconfig/network-scripts/ifcfg-ens33

IPADDR=12.0.0.120

GATEWAY=12.0.0.10

#网关与调度器的ip地址一致

systemctl restart network

#重启网卡

ifconfig

#查看网卡

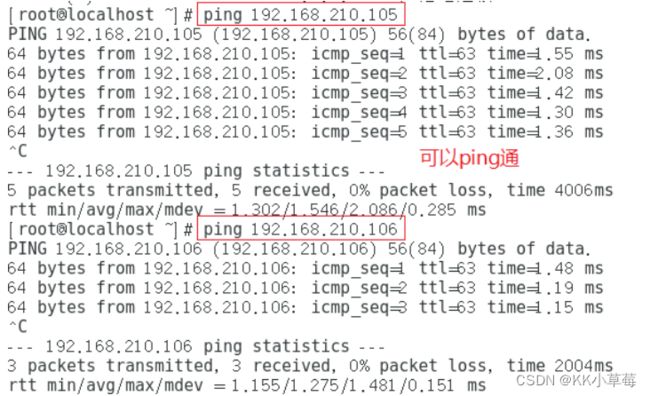

ping 12.0.0.10

ping 192.168.210.104

#测试是否能ping通调度器中的两个网卡地址

ping 192.168.210.105

#ping节点服务器ping不通,因为没有开启LVS的ip转发功能,网关地址没有改成LVS服务器的IP地址

(3)开启调度器ip转发功能

7-4(192.168.210.104)

vim /etc/sysctl.conf

#开启LVS的ip转发功能

net.ipv4.ip_forward=1

sysctl -p

#加载

(4)修改节点服务器网关地址

7-5,7-6

vim /etc/sysconfig/network-scripts/ifcfg-ens33

GATEWAY=192.168.210.104

#把节点服务器1的网关地址改成LVS服务器的IP地址

systemctl restart network

#重启网卡

7-7(12.0.0.120)

ping 192.168.210.105

ping 192.168.210.106

#可以ping通

(5)配置SNAT规则

#内网主机要与外网通信,配置SNAT

7-4

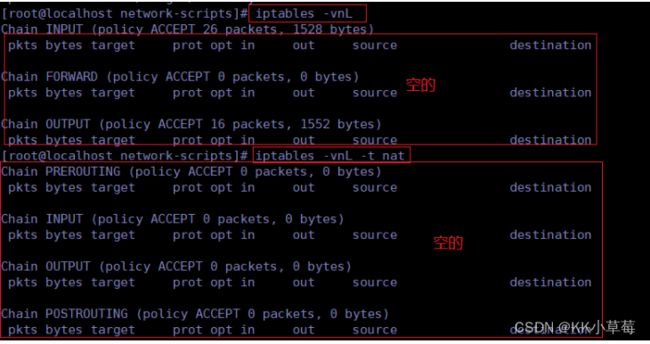

iptables -nL

#查看默认规则

iptables -F

#如果有默认规则就清空

iptables -F -t nat

#删除表

iptables -nL -t nat

#查看是否清空

iptables -t nat -A POSTROUTING -s 192.168.210.0/24 -o ens36 -j SNAT --to 12.0.0.10

#添加SNAT

iptables -nL -t nat

#查看是否添加SNAT

(6)加载LVS内核模块

cd /usr/lib/modules/3.10.0-693.el7.x86_64/kernel/net/netfilter/ipvs

for i in `/usr/lib/modules/3.10.0-693.el7.x86_64/kernel/net/netfilter/ipvs`

do

k=`echo $i | awk -F.'{print $1}'`

modprode $k

done

#加载所有ip_vs模块

cat /proc/net/ip_vs

#查看 ip_vs版本信息

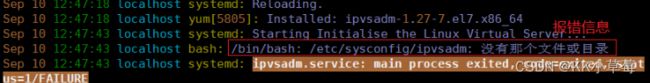

(7)安装ipvsadm管理工具

yum install -y ipvsadm

#安装ipvsadm工具

systemctl start ipvsadm

#开启ipvsadm,启动失败

vim /var/log/messages

#查看日志报错信息

touch /etc/sysconfig/ipvsadm

ll /etc/sysconfig/ipvsadm

#创建ipvsadm文件

ipvsadm-save > /opt/ipvsadm

#启动服务前须保存负载分配策略

systemctl start ipvsadm

#重新开启

systemctl status ipvsadm

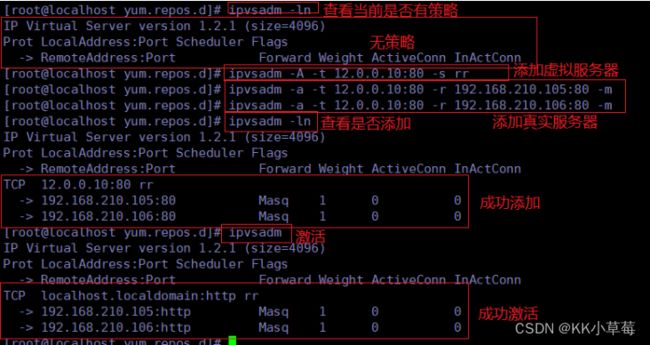

(8)配置负载分配策略

ipvsadm -ln

#查看当前是否有策略,如果有,就ipvsadm -C清空一下

ipvsadm -A -t 12.0.0.10:80 -s rr

#添加虚拟服务器

ipvsadm -a -t 12.0.0.10:80 -r 192.168.210.105:80 -m

ipvsadm -a -t 12.0.0.10:80 -r 192.168.210.106:80 -m

#添加真实服务器

ipvsadm -ln

#查看当前策略

ipvsadm

#激活

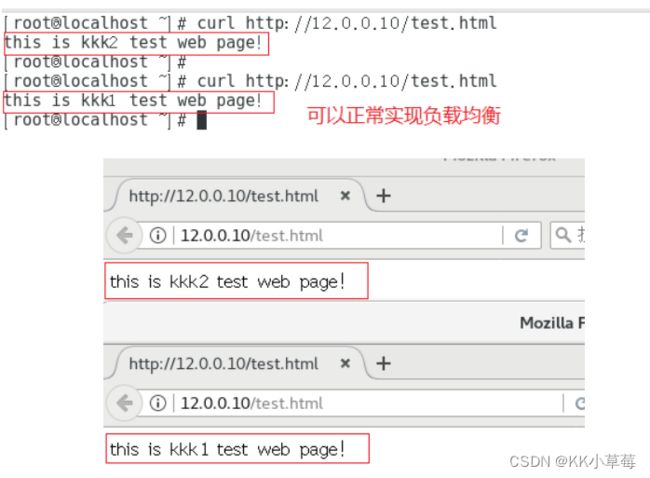

4)客户端测试效果

7-7

curl http://12.0.0.10/test.html

#可以正常实现负载均衡

#在内置浏览器测试

http://12.0.0.10/test.html

#不断刷新浏览器测试负载均衡效果

5、补充知识

7-4

ipvsadm-save > /opt/ipvsadm

#启动服务前须保存负载分配策略

ipvsadm -d -t 12.0.0.10:80 -r 192.168.210.105:80

#删除群集中某一节点服务器

ipvsadm -a -t 12.0.0.10:80 -r 192.168.210.105:80

#用-a添加回来

ipvsadm -D -t 12.0.0.10:80

#删除整个虚拟服务器

#恢复LVS策略

cd /opt/

ls

cat ipvsadm

ipvsadm-restore < /opt/ipvsadm

#重定向输入这个文件,导入就可以恢复

ipvsadm -ln

#查看当前策略

ipvsadm

#激活