Linux:GlusterFS 集群

GlusterFS介绍

1)Glusterfs是一个开源的分布式文件系统,是Scale存储的核心,能够处理千数量级的客户端.在传统的解决 方案中Glusterfs能够灵活的结合物理的,虚拟的和云资源去体现高可用和企业级的性能存储.

2)Glusterfs通过TCP/IP或InfiniBand RDMA网络链接将客户端的存储资块源聚集在一起,使用单一的全局命名空间来管理数据,磁盘和内存资源.

3)Glusterfs基于堆叠的用户空间设计,可以为不同的工作负载提供高优的性能.

4)Glusterfs支持运行在任何标准IP网络上标准应用程序的标准客户端,如下图1所示,用户可以在全局统一的命名空间中使用NFS/CIFS等标准协议来访问应用数据.

Glusterfs主要特征

扩展性和高性能

高可用

全局统一命名空间

弹性hash算法

弹性卷管理

基于标准协议

工作原理:

1) 首先是在客户端, 用户通过glusterfs的mount point 来读写数据, 对于用户来说,集群系统的存在对用户是完全透明的,用户感觉不到是操作本地系统还是远端的集群系统。

2) 用户的这个操作被递交给 本地linux系统的VFS来处理。

3) VFS 将数据递交给FUSE 内核文件系统:在启动 glusterfs 客户端以前,需要想系统注册一个实际的文件系统FUSE,如上图所示,该文件系统与ext3在同一个层次上面, ext3 是对实际的磁盘进行处理, 而fuse 文件系统则是将数据通过/dev/fuse 这个设备文件递交给了glusterfs client端。所以, 我们可以将 fuse文件系统理解为一个代理。

4) 数据被fuse 递交给Glusterfs client 后, client 对数据进行一些指定的处理(所谓的指定,是按照client 配置文件据来进行的一系列处理, 我们在启动glusterfs client 时需要指定这个文件。

5) 在glusterfs client的处理末端,通过网络将数据递交给 Glusterfs Server,并且将数据写入到服务器所控制的存储设备上。

常用卷类型

分布(distributed)

复制(replicate)

条带(striped)

基本卷:

(1) distribute volume:分布式卷

(2) stripe volume:条带卷

(3) replica volume:复制卷

复合卷:

(4) distribute stripe volume:分布式条带卷

(5) distribute replica volume:分布式复制卷

(6) stripe replica volume:条带复制卷

(7) distribute stripe replicavolume:分布式条带复制卷

分布卷

条带卷

复制卷

分布式条带卷

分布式复制卷

模拟环境介绍

这里我们使用5个服务器,前4个用于搭建各种卷,第五个用于测试,将前面搭建好的卷挂载到第五台进行测试

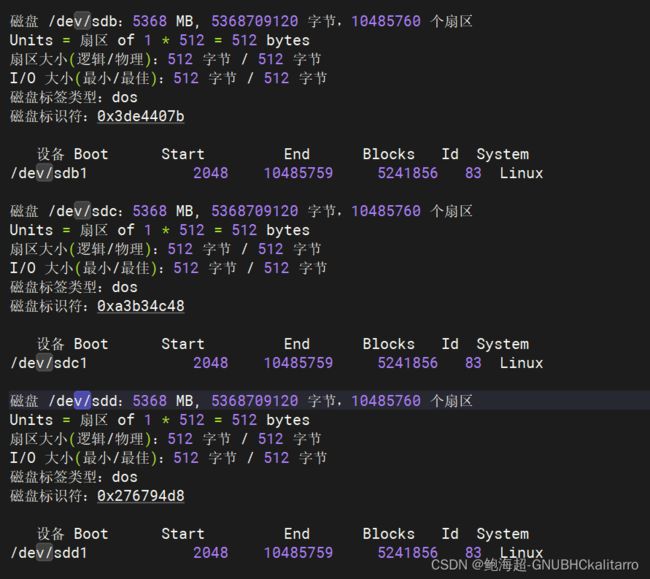

| 第一台 192.168.254.1 添加4块硬盘,每个硬盘为5G大小 并为他们分1个区 格式为ext4 分别为/dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1 主机名为 : tarro1 |

| 第二台 192.168.254.2 添加4块硬盘,每个硬盘为5G大小 并为他们分1个区 格式为ext4 分别为/dev/sdb1 /dev/sdc1 /dev/sdd1 /dev/sde1 主机名为 : tarro2 |

| 第三台 192.168.254.3 添加3块硬盘,每个硬盘为5G大小 并为他们分1个区 格式为ext4 分别为/dev/sdb1 /dev/sdc1 /dev/sdd1 主机名为 : tarro3 |

| 第四台 192.168.254.1 添加3块硬盘,每个硬盘为5G大小 并为他们分1个区 格式为ext4 分别为/dev/sdb1 /dev/sdc1 /dev/sdd1 主机名为 : tarro4 |

第五台用于测试,但是也要安装glusterfs组件,我们到最后测试时候再部署

第一台服务器上的设置(192.168.254.1)

hostnamectl set-hostname tarro1vim /etc/hosts

在最后插入

192.168.254.1 tarro1

192.168.254.2 tarro2

192.168.254.3 tarro3

192.168.254.4 tarro4yum -y install glusterfs glusterfs-server glusterfs-fuse glusterfs-rdma然后去设置硬盘,每个硬盘只需要分一个,在根下再创建一个对应磁盘号的目录,比如/dev/sdb1就在根创建一个/b 让后把 /dev/sdb1 挂载到 /b

如果你还对fdisk不太熟悉可看一下这篇文章

Linux:磁盘管理 | 查看 磁盘,创建分区,格式化文件系统,添加&开启swap交换系统 ,格式化硬盘后进行挂载 ,挂载光盘, 挂载USB ,取消挂载(卸载),开机自动挂载_linux取消挂载_鲍海超-GNUBHCkalitarro的博客-CSDN博客![]() https://blog.csdn.net/w14768855/article/details/130772080?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522169529100316800186547894%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=169529100316800186547894&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~rank_v31_ecpm-2-130772080-null-null.nonecase&utm_term=fdisk&spm=1018.2226.3001.4450

https://blog.csdn.net/w14768855/article/details/130772080?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522169529100316800186547894%2522%252C%2522scm%2522%253A%252220140713.130102334.pc%255Fblog.%2522%257D&request_id=169529100316800186547894&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~rank_v31_ecpm-2-130772080-null-null.nonecase&utm_term=fdisk&spm=1018.2226.3001.4450

mkdir /b /c /d /emkfs -t ext4 /dev/sdb1mkfs -t ext4 /dev/sdc1mkfs -t ext4 /dev/sdd1mkfs -t ext4 /dev/sde1mount /dev/sdb1 /bmount /dev/sdc1 /cmount /dev/sdd1 /dmount /dev/sde1 /evim /etc/fstab

最后面插入

/dev/sdb1 /b ext4 defaults 0 0

/dev/sdc1 /c ext4 defaults 0 0

/dev/sdd1 /d ext4 defaults 0 0

/dev/sde1 /e ext4 defaults 0 0systemctl start glusterd.servicesystemctl enable glusterd.service第二台服务器上的设置(192.168.254.2)

跟第一台的配置基本相同

hostnamectl set-hostname tarro2vim /etc/hosts

在最后插入

192.168.254.1 tarro1

192.168.254.2 tarro2

192.168.254.3 tarro3

192.168.254.4 tarro4yum -y install glusterfs glusterfs-server glusterfs-fuse glusterfs-rdmamkfs -t ext4 /dev/sdb1mkfs -t ext4 /dev/sdc1mkfs -t ext4 /dev/sdd1mkfs -t ext4 /dev/sdd1mount /dev/sdb1 /bmount /dev/sdc1 /cmount /dev/sdd1 /dmount /dev/sde1 /evim /etc/fstab

最后面插入

/dev/sdb1 /b ext4 defaults 0 0

/dev/sdc1 /c ext4 defaults 0 0

/dev/sdd1 /d ext4 defaults 0 0

/dev/sde1 /e ext4 defaults 0 0systemctl start glusterd.servicesystemctl enable glusterd.service第三台服务器上的设置(192.168.254.3)

hostnamectl set-hostname tarro3vim /etc/hosts

在最后插入

192.168.254.1 tarro1

192.168.254.2 tarro2

192.168.254.3 tarro3

192.168.254.4 tarro4yum -y install glusterfs glusterfs-server glusterfs-fuse glusterfs-rdmamkdir /b /c /dmkfs -t ext4 /dev/sdb1mkfs -t ext4 /dev/sdc1mkfs -t ext4 /dev/sdd1mount /dev/sdb1 /bmount /dev/sdc1 /cmount /dev/sdd1 /dvim /etc/fstab

插入

/dev/sdb1 /b ext4 defaults 0 0

/dev/sdc1 /c ext4 defaults 0 0

/dev/sdd1 /d ext4 defaults 0 0systemctl start glusterdsystemctl enable glusterd第四台服务器上的设置(192.168.254.4)

hostnamectl set-hostname tarro4vim /etc/hosts

在最后插入

192.168.254.1 tarro1

192.168.254.2 tarro2

192.168.254.3 tarro3

192.168.254.4 tarro4yum -y install glusterfs glusterfs-server glusterfs-fuse glusterfs-rdmamkdir /b /c /dmkfs -t ext4 /dev/sdb1mkfs -t ext4 /dev/sdc1mkfs -t ext4 /dev/sdd1mount /dev/sdb1 /bmount /dev/sdc1 /cmount /dev/sdd1 /dvim /etc/fstab

插入

/dev/sdb1 /b ext4 defaults 0 0

/dev/sdc1 /c ext4 defaults 0 0

/dev/sdd1 /d ext4 defaults 0 0systemctl start glusterdsystemctl enable glusterd部署GlusterFS

部署基础集群环境

由于我们要部署的是集群,我们只需在一个上面设置让他们相互认识,那4个上面就会都有了

随便在一个上面操作,4个都会一起工作一起变化

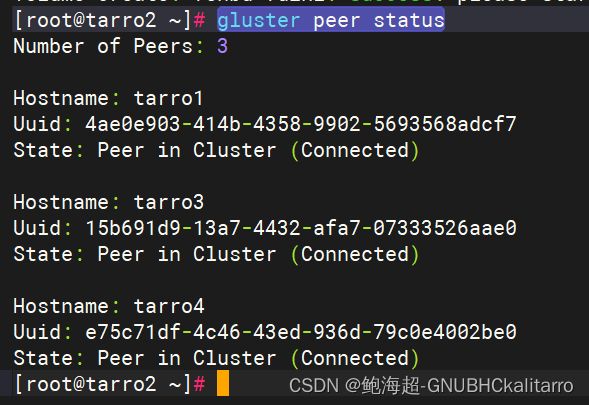

gluster peer probe tarro1gluster peer probe tarro2gluster peer probe tarro3gluster peer probe tarro4随便在一个上面进行了设置,这时我们去查看他们有没有相互认识

在1上面查看

gluster peer status在2上面查看

在3和4上面也是一样的,这时集群就部署好了

查看群组内有几个主机

gluster peer status只要在群集的所有主机能相互看见那就是部署成功了

distribute ---- 分布

stripe ---- 条带

replaction ---- 复制

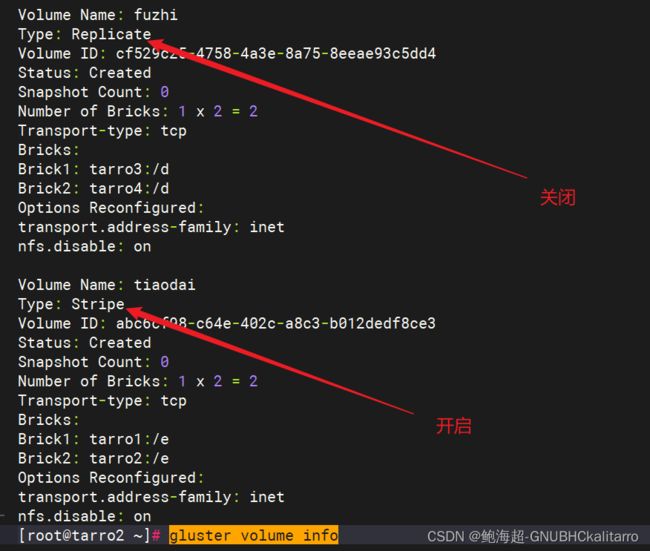

部署卷

我们使用tarro1的 /d 和 tarro2 /d 去组建分布卷

tarro1 /e 和 tarro2 /e 去组件条带卷

tarro3 /d 和 tarro4 /d 组件复制卷

tarro1 /b tarro2 /b tarro3 /b tarro4 /b 组建分布式条带卷

tarro1 /c tarro2 /c tarro3 /c tarro4 /c 组建分布式复制卷

创建分布卷

随便一个服务器上做就行,现在他们是一个集群都相互认识

gluster volume create fenbu tarro1:/d tarro2:/d force创建条带卷

gluster volume create tiaodai stripe 2 tarro1:/e tarro2:/e force创建复制卷

gluster volume create fuzhi replica 2 tarro3:/d tarro4:/d force组建分布式条带卷

gluster volume create fenbu-tiaodai stripe 2 tarro1:/b tarro2:/b tarro3:/b tarro4:/b force组建分布式复制卷

gluster volume create fenbu-fuzhi replica 2 tarro1:/c tarro2:/c tarro3:/c tarro4:/c force查看创建过的卷

gluster volume info这个是查看全部也可以单独查看

gluster volume info 卷名称

开启卷,关闭卷,删除卷

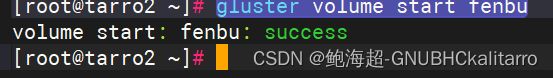

每个卷创建好了并不能直接使用,要开启后才能使用

gluster volume start 卷名

gluster volume start fenbu关闭卷

gluster volume stop 卷名

gluster volume stop fenbu删除卷

删除卷之前必须保持卷的关闭,只有卷关闭了,没有挂载使用的情况下才能删除

gluster volume delete 卷名挂载卷(设置第五台服务器进行测试)

在挂载之前保持所有卷为开启状态

gluster volume info现在去第五台服务器上进行搭建和测试

yum -y install glusterfs glusterfs-fusemkdir -p /tarro/{fenbu,tiaodai,fuzhi,fenbu-tiaodai,fenbu-fuzhi}vim /etc/hosts

插入

192.168.254.1 tarro1

192.168.254.2 tarro2

192.168.254.3 tarro3

192.168.254.4 tarro4现在就可以去挂载了

挂载分布卷

mount -t glusterfs tarro1:fenbu /tarro/fenbu由于是一个集群,tarro1:fenbu 和 tarro2:fenbu ,tarro3:fenbu , tarro4:fenbu 是一样的

挂载条带卷

mount -t glusterfs tarro1:tiaodai /tarro/tiaodai/挂载复制卷

mount -t glusterfs tarro1:fuzhi /tarro/fuzhi/挂载分布式条带卷

mount -t glusterfs tarro1:fenbu-tiaodai /tarro/fenbu-tiaodai/挂载分布式复制卷

mount -t glusterfs tarro1:fenbu-fuzhi /tarro/fenbu-fuzhi/挂载成功

vim /etc/fstab

插入

tarro1:fenbu /tarro/fenbu glusterfs defaults,_netdev 0 0

tarro1:tiaodai /tarro/tiaodai glusterfs defaults,_netdev 0 0

tarro1:fuzhi /tarro/fuzhi glusterfs defaults,_netdev 0 0

tarro1:fenbu-tiaodai /tarro/fenbu-tiaodai glusterfs defaults,_netdev 0 0

tarro1:fenbu-fuzhi /tarro/fenbu-fuzhi glusterfs defaults,_netdev 0 0reboot重启一下,如果依然自动挂载,那么就成功了

测试各种卷效果

cp -rf /var/log/messages ./test1.log

cp -rf /var/log/messages ./test2.log

cp -rf /var/log/messages ./test3.log

cp -rf /var/log/messages ./test4.log

cp -rf /var/log/messages ./test5.logcp test*.log /tarro/fenbu

cp test*.log /tarro/tiaodai/

cp test*.log /tarro/fuzhi

cp test*.log /tarro/fenbu-tiaodai/

cp test*.log /tarro/fenbu-fuzhi

我们现在把各种卷放进了,每个挂载点,单个文件夹为423K

我们去每个卷合成的目录看

分布卷

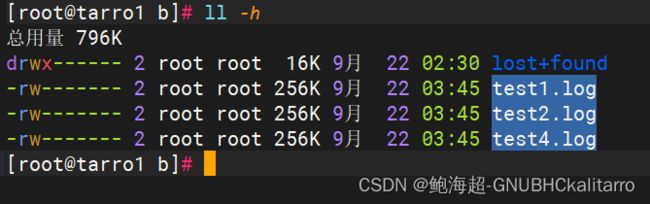

在tarro1的/d上看到了 1 2 4

tarro2/d 看到了3 5 他们的文件大小没有变

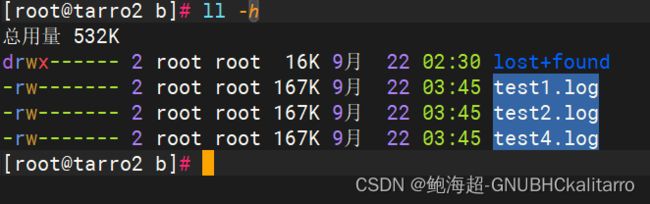

条带卷

tarro1 /e 上面 1-5都有 但是文件大小只有一半

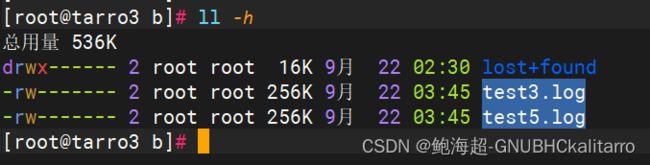

复制卷

tarro3和4的文件内容是一样的

分布式条带卷

tarro1

tarro2

tarro3

tarro4

这个就是把有个备份的,其次保证性能

分布式复制卷

tarro2

tarro3

tarro4

这个和上面那个一样多了个备份的

这几个没有那个最好,只有在适合的环境使用最适合的卷才是最好的