[python]-专利爬虫-SooPAT

目的

课题需要研究下专利信息,想把专利导出到excel,于是点击“Excel批量导出”,

![[python]-专利爬虫-SooPAT_第1张图片](http://img.e-com-net.com/image/info8/9e0ea851240c4d14b276fcaaeea0e289.jpg)

结果需要充值信仰。![[python]-专利爬虫-SooPAT_第2张图片](http://img.e-com-net.com/image/info8/2d67d9bb6f914ebb8748e5fedc09d3ca.jpg)

土豪朋友本文到这里结束了,请回吧…

…

恩,我接着讲,本着自己动手丰衣足食的原则,用python自己爬一爬。

网页分析

网页url规律

如果想爬多个网页,需要分析下多个网页的URL的规律。

对比下多个网页的URL,每个网页的规律显而易见。本例链接

![[python]-专利爬虫-SooPAT_第3张图片](http://img.e-com-net.com/image/info8/e32a6f3c5dc140068fa81d50f642d5c5.png)

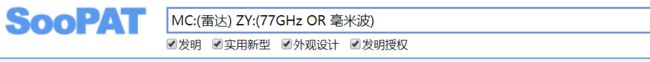

URL关键字

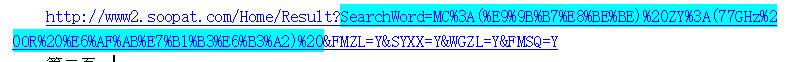

通过观察搜索结果的URL,分析关键字“MC:(雷达)ZY:(77GHz OR 毫米波)”在URL中位置(有个关键字SearchWord),

利用urllib中的quote和parse进行验证(对比上图中的url)。

![[python]-专利爬虫-SooPAT_第4张图片](http://img.e-com-net.com/image/info8/371068d4d4d342e1894603f57fdc30d8.jpg)

因此可以将搜索使用的关键字作为函数参数,便于其他关键字搜索。

其中关键字中MC(名称)、ZY(摘要)可以参考SooPat的表格检索相关内容。

![[python]-专利爬虫-SooPAT_第5张图片](http://img.e-com-net.com/image/info8/7ea317605080470686713da4ee7d614b.jpg)

内容分析

接下来就是分析需要爬取的内容,浏览器F12,查看网页代码。

![[python]-专利爬虫-SooPAT_第6张图片](http://img.e-com-net.com/image/info8/e9d42cebf8c942468a2a3e1d030ecd7d.jpg)

首先找到每一条专利信息所对应的代码,关键信息:div标签 ,style属性【用区别于上一行(非专利信息)】。

继续往下找标题信息,定位到h2标签。从中提取包括专利类型、名称、申请号等信息;

![[python]-专利爬虫-SooPAT_第7张图片](http://img.e-com-net.com/image/info8/efd2b77d996049ddb5101e55a8cb3c3f.jpg)

从span标签可以提取申请人、分类号、摘要内容等相关信息,通过class属性可以轻松区分内容。

![[python]-专利爬虫-SooPAT_第8张图片](http://img.e-com-net.com/image/info8/92822ec8670b467f809c498e2dcdb9f0.jpg)

数据保存

想要的信息特征都有了,现在就是通过BeautifulSoup来一勺尝一尝。

接下来的问题就是存储,使用xlwt模块将数据保存在excel中。

到此所有内容分析完毕,上硬菜…

代码分享

# -*- coding: UTF-8 -*-

from bs4 import BeautifulSoup

import requests

import sys

from attr import attributes

import xlwt

from urllib.request import quote

from urllib import parse

g_sheet = None

g_file