深度学习log-链路追踪-Spring Cloud Sleuth and ZipKin

引言

学习log,公司需要做标品,参考当前链路追踪框架以便于降低运维成本,提高标品逼格,原文连接:传送

文章目录

-

- 引言

- 微服务架构下的问题

- Sleuth简介

-

- 相关概念

- 链路追踪Sleuth入门案例

- Zipkin的概述

-

- Zipkin Server的部署和配置

- 基于消息中间件收集数据

-

- RabbitMQ的安装与启动

-

- 服务端启动

- 存储跟踪数据

-

- 准备数据库

- 配置启动服务端

微服务架构下的问题

在大型系统的微服务化构建中,一个系统会被拆分成许多模块。这些模块负责不同的功能,组合成系统,最终可以提供丰富的功能。在这种架构中,一次请求往往需要涉及到多个服务。互联网应用构建在不同的软件模块集上,这些软件模块,有可能是由不同的团队开发、可能使用不同的编程语言来实现、有可能部署在了几千台服务器,横跨多个不同的数据中心,也就意味着这种架构形式也会存在一些问题:

如何快速发现问题?

如何判断故障影响范围?

如何梳理服务依赖以及依赖的合理性?

如何分析链路性能问题以及实时容量规划?

分布式链路追踪(Distributed Tracing) 就是将一次分布式请求还原成调用链路,进行日志记录、性能监控,并将一次分布式请求的调用情况集中展示。比如各个服务节点上的耗时、请求具体到达哪台机器上、每个服务节点的请求状态等等。

目前业界比较流行的链路追踪系统如:Twitter的Zipkin、阿里的鹰眼、美团的Mtrace、大众点评的cat等,大部分都是基于google发表的Dapper(http://bigbully.github.io/Dapper-translation/)。Dapper阐述了分布式系统,特别是微服务架构中链路追踪的概念、数据表示、埋点、传递、收集、存储与展示等技术细节。

Sleuth简介

Spring Cloud Sleuth 主要功能就是在分布式系统中提供追踪解决方案,并且兼容支持了 zipkin,只需要在pom文件中引入相应的依赖即可。

相关概念

Spring Cloud Sleuth 为Spring Cloud提供了分布式追踪的解决方案,它大量借用了Google Dapper的设计。

先来了解一下Sleuth中的术语和相关概念,Spring Cloud Sleuth采用的是Google的开源项目Dapper的专业术语。

-

Span:基本工作单元,例如,在一个新建的span中发送一个RPC等同于发送一个回应请求给RPC,span通过一个64位ID唯一标识,trace以另一个64位ID表示,span还有其他数据信息,比如摘要、时间戳事件、关键值注释(tags)、span的ID、以及进度ID(通常是IP地址),span在不断的启动和停止同时记录了时间信息,当你创建了一个span,你必须在未来的某个时刻停止它。

-

Trace:一系列spans组成的一个树状结构,例如,如果你正在跑一个分布式大数据工程,你可能需要创建一个trace。

-

Annotation:用来及时记录一个事件的存在,一些核心annotations用来定义一个请求的开始和结束。

Annotation介绍:

cs - Client Sent:客户端发起一个请求,这个annotion描述了这个span的开始。

sr - Server Received:服务端获得请求并准备开始处理它,如果将其sr减去cs时间戳便可得到网络延迟。

ss - Server Sent:注解表明请求处理的完成(当请求返回客户端),如果ss减去sr时间戳便可得到服务端需要的处理请求时间。

cr - Client Received:表明span的结束,客户端成功接收到服务端的回复,如果cr减去cs时间戳便可得到客户端从服务端获取回复的所有所需时间。

链路追踪Sleuth入门案例

接下来通过之前博客中的项目案例整合Sleuth,完成入门案例的编写。

配置依赖

修改相关微服务工程的pom.xml引入Sleuth依赖。

<!--sleuth链路追踪-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-sleuth</artifactId>

<version>2.2.0.RELEASE</version>

</dependency>`

修改配置文件

修改相关微服务工程的application.yml添加日志级别。

logging:

level:

root: INFO

org.springframework.web.servlet.DispatcherServlet: DEBUG

org.springframework.cloud.sleuth: DEBUG

每个相关微服务都需要添加如上的配置,启动微服务并调用url之后,在相关微服务的控制台中可以观察到sleuth的日志输出。

其中cf81c50b403b3ee7是TraceId,后面跟着的cf81c50b403b3ee7是SpanId,依次调用有一个全局的TraceId,将调用链路串起来,仔细分析每个微服务的日志,不难看出请求的具体过程。

查看日志文件并不是一个很好的方法,当微服务越来越多日志文件也会越来越多,通过Zipkin可以将日志聚合,并进行可视化展示和全文检索。

Zipkin的概述

Zipkin 是 Twitter 的一个开源项目,它基于 Google Dapper 实现,它致力于收集服务的定时数据,以解决微服务架构中的延迟问题,包括数据的收集、存储、查找和展现。 我们可以使用它来收集各个服务器上请求链路的跟踪数据,并通过它提供的 REST API 接口来辅助我们查询跟踪数据以实现对分布式系统的监控程序,从而及时地发现系统中出现的延迟升高问题并找出系统性能瓶颈的根源。除了面向开发的 API 接口之外,它也提供了方便的 UI 组件来帮助我们直观的搜索跟踪信息和分析请求链路明细,比如:可以查询某段时间内各用户请求的处理时间等。Zipkin 提供了可插拔数据存储方式:In-Memory、MySql、Cassandra 以及 Elasticsearch。

上图展示了 Zipkin 的基础架构,它主要由 4 个核心组件构成:

- Collector:收集器组件,它主要用于处理从外部系统发送过来的跟踪信息,将这些信息转换为

- Zipkin 内部处理的 Span 格式,以支持后续的存储、分析、展示等功能。

- Storage:存储组件,它主要对处理收集器接收到的跟踪信息,默认会将这些信息存储在内存中,

我们也可以修改此存储策略,通过使用其他存储组件将跟踪信息存储到数据库中。- RESTful API:API 组件,它主要用来提供外部访问接口。比如给客户端展示跟踪信息,或是外接

系统访问以实现监控等。- Web UI:UI 组件,基于 API 组件实现的上层应用。通过 UI 组件用户可以方便而有直观地查询和

分析跟踪信息。

Zipkin 分为两端,一个是 Zipkin 服务端,一个是 Zipkin 客户端,客户端也就是微服务的应用。客户端会配置服务端的 URL 地址,一旦发生服务间的调用的时候,会被配置在微服务里面的 Sleuth 的监听器监听,并生成相应的 Trace 和 Span 信息发送给服务端。

发送的方式主要有两种,一种是 HTTP 报文的方式,还有一种是消息总线的方式如 RabbitMQ。不论哪种方式,我们都需要:

- 一个 Eureka 服务注册中心。

- 一个 Zipkin 服务端。

- 多个微服务,且这些微服务中配置 Zipkin 客户端。

Zipkin Server的部署和配置

Zipkin Server下载

从spring boot 2.0开始,官方就不再支持使用自建Zipkin Server的方式进行服务链路追踪,而是直接提供了编译好的 jar 包来给我们使用,可以从官方网站下载(https://search.maven.org/remote_content?g=io.zipkin.java&a=zipkin-server&v=LATEST&c=exec),这里我们使用的是zipkin-server-2.12.9-exec.jar。

Zipkin Server启动

在命令行输入 java -jar zipkin-server-2.12.9-exec.jar 启动 Zipkin Server,Zipkin Server的启动参数可以通过官方提供的yml配置文件查找。

默认Zipkin Server的请求端口为 9411,在浏览器输入 http://127.0.0.1:9411 即可进入到Zipkin Server的管理后台。

客户端Zipkin+Sleuth整合

通过查看日志分析微服务的调用链路并不是一个很直观的方案,结合zipkin可以很直观地显示微服务之间的调用关系。

- 客户端添加依赖(客户端指的是需要被追踪的微服务)

<!--zipkin依赖-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-zipkin</artifactId>

<version>2.2.0.RELEASE</version>

</dependency>

- 修改客户端配置文件

spring:

zipkin:

base-url: http://127.0.0.1:9411/ #zipkin server的请求地址

sender:

type: web #请求方式,默认以http的方式向zipkin server发送追踪数据

sleuth:

sampler:

probability: 1.0 #采样的百分比

指定了zipkin server的地址,接下来指定需采样的百分比,默认为0.1,即10%,这里配置1,是记录全部的sleuth信息,是为了收集到更多的数据(仅供测试用)。在分布式系统中,过于频繁的采样会影响系统性能,所以这里配置需要采用一个合适的值。

测试

启动Zipkin Service和每个相关的微服务,通过浏览器发送一次微服务请求。打开Zipkin Servic控制台,我们可以根据条件追踪每次请求调用过程。

单击查找按钮,查看请求调用过程。

单击该trace可以看到请求的细节。

基于消息中间件收集数据

在默认情况下,Zipkin客户端和服务端之间是使用HTTP请求的方式进行通信(即同步的请求方式),在网络波动,Server端异常等情况下可能存在信息收集不及时的问题。Zipkin支持与rabbitMQ整合完成异步消息传输。

RabbitMQ的安装与启动

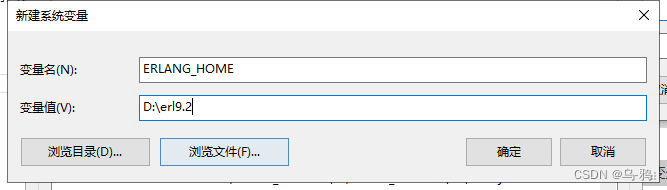

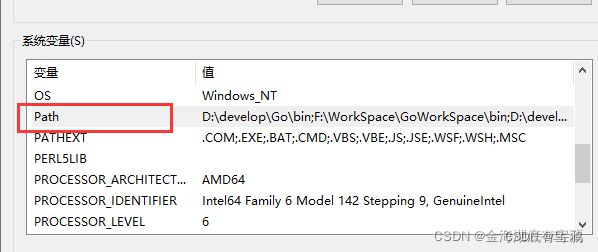

由于RabbitMQ底层使用Erlang语言实现的,RabbitMQ需要安装Windows 支持的64位版本的Erlang,所以我们在使用RabbitMQ之前要先安装并配置Erlang,

- Erlang下载及配置

下载地址: https://www.erlang.org/downloads,根据自己OS版本选择下载版本。

Windows示例:

下载完成后会得到一个可执行文件,双击打开,选择安装路径后一路继续确认,直到安装完成。

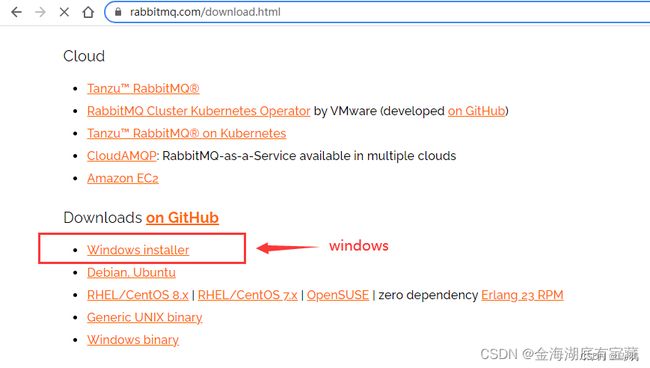

- RabbitMQ下载

下载地址: https://www.rabbitmq.com/download.html,在下载页面选择适合的下载方式,windows下可以选择以.exe可执行文件的方式下载:

下载完成后会得到一个可执行文件,双击打开,选择安装路径后一路继续确认,直到安装完成。

![]() - RabbitMQ启动

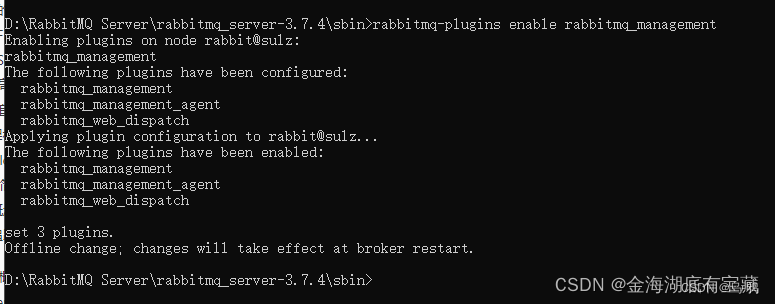

- RabbitMQ启动

RabbitMQ安装完成后,由于RabbitMQ默认禁用了管理界面,需要通过命令重新开启管理界面,以管理员模式打开CMD,进入RabbitMQ安装目录的sbin文件夹路径下,输入并执行rabbitmq-plugins enable rabbitmq_management命令。

开启管理界面后,再启动RabbitMQ,点击windows按键,单击RabbitMQ Sercive - start应用启动RabbitMQ 。

在地址栏输入http://localhost:15672/即可访问RabbitMQ网页控制台,默认账号密码均为:guest。

服务端启动

java -jar zipkin-server-2.12.9-exec.jar --RABBIT_ADDRESSES=127.0.0.1:5672

- RABBIT_ADDRESSES : 指定RabbitMQ地址

- RABBIT_USER: 用户名(默认guest)

- RABBIT_PASSWORD : 密码(默认guest)

在控制台中输入以上命令启动Zipkin Server,启动成功之后,打开RabbitMQ的控制台可以看到多了一个Queue,其中 zipkin 就是为我们自动创建的Queue队列。

客户端配置

- 配置依赖

在相关的微服务中导入spring-rabbit 依赖,是Spring提供的对rabbit的封装,客户端会根据配置自动的生产消息并发送到目标队列中。

<!--sleuth链路追踪-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-sleuth</artifactId>

<version>2.2.0.RELEASE</version>

</dependency>

<!--zipkin依赖-->

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-zipkin</artifactId>

<version>2.2.0.RELEASE</version>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-sleuth-zipkin</artifactId>

<version>2.2.0.RELEASE</version>

</dependency>

<dependency>

<groupId>org.springframework.amqp</groupId>

<artifactId>spring-rabbit</artifactId>

<version>2.2.0.RELEASE</version>

</dependency>

- 配置消息中间件RabbitMQ地址等信息

在相关的微服务的application.yml配置文件中,修改消息的投递方式改为rabbit,并添加rabbitmq的相关配置。

spring:

zipkin:

# base-url: http://127.0.0.1:9411/ #zipkin server的请求地址

sender:

type: rabbit #请求方式

sleuth:

sampler:

probability: 1.0 #采样的百分比

rabbitmq:

host: localhost

port: 5672

username: guest

password: guest

listener: # 这里配置了重试策略

direct:

retry:

enabled: true

simple:

retry:

enabled: true

测试

关闭Zipkin Server,并调用请求。打开RabbitMQ网页管理后台可以看到,消息已经推送到RabbitMQ。当Zipkin Server启动时,会自动的从RabbitMQ获取消息并消费,展示追踪数据可以看到如下效果:

- 请求的耗时时间不会出现突然耗时特长的情况。

- 当ZipkinServer不可用时(比如关闭、网络不通等),追踪信息不会丢失,因为这些信息会保存在RabbitMQ服务器上,直到Zipkin服务器可用时,再从Rabbitmq中取出这段时间的信息。

存储跟踪数据

Zipkin Server默认时间追踪数据信息保存到内存,这种方式不适合生产环境。因为一旦Service关闭重启或者服务崩溃,就会导致历史数据消失。Zipkin支持将追踪数据持久化到mysql数据库或者存储到elasticsearch中。这里已mysql为例。

准备数据库

可以从官网找到Zipkin Server持久mysql的数据库脚本。

/*

SQLyog Ultimate v11.33 (64 bit)

MySQL - 5.5.58 : Database - zipkin

*********************************************************************

*/

/*!40101 SET NAMES utf8 */;

/*!40101 SET SQL_MODE=''*/;

/*!40014 SET @OLD_UNIQUE_CHECKS=@@UNIQUE_CHECKS, UNIQUE_CHECKS=0 */;

/*!40014 SET @OLD_FOREIGN_KEY_CHECKS=@@FOREIGN_KEY_CHECKS, FOREIGN_KEY_CHECKS=0 */;

/*!40101 SET @OLD_SQL_MODE=@@SQL_MODE, SQL_MODE='NO_AUTO_VALUE_ON_ZERO' */;

/*!40111 SET @OLD_SQL_NOTES=@@SQL_NOTES, SQL_NOTES=0 */;

CREATE DATABASE /*!32312 IF NOT EXISTS*/`zipkin` /*!40100 DEFAULT CHARACTER SET utf8 */;

USE `zipkin`;

/*Table structure for table `zipkin_annotations` */

DROP TABLE IF EXISTS `zipkin_annotations`;

CREATE TABLE `zipkin_annotations` (

`trace_id_high` bigint(20) NOT NULL DEFAULT '0' COMMENT 'If non zero, this means the trace uses 128 bit traceIds instead of 64 bit',

`trace_id` bigint(20) NOT NULL COMMENT 'coincides with zipkin_spans.trace_id',

`span_id` bigint(20) NOT NULL COMMENT 'coincides with zipkin_spans.id',

`a_key` varchar(255) NOT NULL COMMENT 'BinaryAnnotation.key or Annotation.value if type == -1',

`a_value` blob COMMENT 'BinaryAnnotation.value(), which must be smaller than 64KB',

`a_type` int(11) NOT NULL COMMENT 'BinaryAnnotation.type() or -1 if Annotation',

`a_timestamp` bigint(20) DEFAULT NULL COMMENT 'Used to implement TTL; Annotation.timestamp or zipkin_spans.timestamp',

`endpoint_ipv4` int(11) DEFAULT NULL COMMENT 'Null when Binary/Annotation.endpoint is null',

`endpoint_ipv6` binary(16) DEFAULT NULL COMMENT 'Null when Binary/Annotation.endpoint is null, or no IPv6 address',

`endpoint_port` smallint(6) DEFAULT NULL COMMENT 'Null when Binary/Annotation.endpoint is null',

`endpoint_service_name` varchar(255) DEFAULT NULL COMMENT 'Null when Binary/Annotation.endpoint is null',

UNIQUE KEY `trace_id_high` (`trace_id_high`,`trace_id`,`span_id`,`a_key`,`a_timestamp`) COMMENT 'Ignore insert on duplicate',

KEY `trace_id_high_2` (`trace_id_high`,`trace_id`,`span_id`) COMMENT 'for joining with zipkin_spans',

KEY `trace_id_high_3` (`trace_id_high`,`trace_id`) COMMENT 'for getTraces/ByIds',

KEY `endpoint_service_name` (`endpoint_service_name`) COMMENT 'for getTraces and getServiceNames',

KEY `a_type` (`a_type`) COMMENT 'for getTraces',

KEY `a_key` (`a_key`) COMMENT 'for getTraces',

KEY `trace_id` (`trace_id`,`span_id`,`a_key`) COMMENT 'for dependencies job'

) ENGINE=InnoDB DEFAULT CHARSET=utf8 ROW_FORMAT=COMPRESSED;

/*Data for the table `zipkin_annotations` */

/*Table structure for table `zipkin_dependencies` */

DROP TABLE IF EXISTS `zipkin_dependencies`;

CREATE TABLE `zipkin_dependencies` (

`day` date NOT NULL,

`parent` varchar(255) NOT NULL,

`child` varchar(255) NOT NULL,

`call_count` bigint(20) DEFAULT NULL,

UNIQUE KEY `day` (`day`,`parent`,`child`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8 ROW_FORMAT=COMPRESSED;

/*Data for the table `zipkin_dependencies` */

/*Table structure for table `zipkin_spans` */

DROP TABLE IF EXISTS `zipkin_spans`;

CREATE TABLE `zipkin_spans` (

`trace_id_high` bigint(20) NOT NULL DEFAULT '0' COMMENT 'If non zero, this means the trace uses 128 bit traceIds instead of 64 bit',

`trace_id` bigint(20) NOT NULL,

`id` bigint(20) NOT NULL,

`name` varchar(255) NOT NULL,

`parent_id` bigint(20) DEFAULT NULL,

`debug` bit(1) DEFAULT NULL,

`start_ts` bigint(20) DEFAULT NULL COMMENT 'Span.timestamp(): epoch micros used for endTs query and to implement TTL',

`duration` bigint(20) DEFAULT NULL COMMENT 'Span.duration(): micros used for minDuration and maxDuration query',

UNIQUE KEY `trace_id_high` (`trace_id_high`,`trace_id`,`id`) COMMENT 'ignore insert on duplicate',

KEY `trace_id_high_2` (`trace_id_high`,`trace_id`,`id`) COMMENT 'for joining with zipkin_annotations',

KEY `trace_id_high_3` (`trace_id_high`,`trace_id`) COMMENT 'for getTracesByIds',

KEY `name` (`name`) COMMENT 'for getTraces and getSpanNames',

KEY `start_ts` (`start_ts`) COMMENT 'for getTraces ordering and range'

) ENGINE=InnoDB DEFAULT CHARSET=utf8 ROW_FORMAT=COMPRESSED;

/*Data for the table `zipkin_spans` */

/*!40101 SET SQL_MODE=@OLD_SQL_MODE */;

/*!40014 SET FOREIGN_KEY_CHECKS=@OLD_FOREIGN_KEY_CHECKS */;

/*!40014 SET UNIQUE_CHECKS=@OLD_UNIQUE_CHECKS */;

/*!40111 SET SQL_NOTES=@OLD_SQL_NOTES */;

配置启动服务端

java -jar zipkin-server-2.12.9-exec.jar --STORAGE_TYPE=mysql --MYSQL_HOST=127.0.0.1 --MYSQL_TCP_PORT=3306 --MYSQL_DB=zipkin --MYSQL_USER=root --MYSQL_PASS=root`

- STORAGE_TYPE : 存储类型

- MYSQL_HOST: mysql主机地址

- MYSQL_TCP_PORT:mysql端口

- MYSQL_DB: mysql数据库名称

- MYSQL_USER:mysql用户名

- MYSQL_PASS :mysql密码

配置好zipkin service服务端之后,在浏览器调用url请求,到数据库查看会发现数据已经持久化到mysql中,即使关闭重启 zipkin service,历史数据也不会消失。

最后致谢,侵权联系删除