Redis入门到精通

Redis入门到精通

-

- 1.1.redis概述

- 1.2 什么是NoSql?

- 1.3 NoSql与传统数据库的比较

- 1.4 在什么场景下使用NoSql

- 1.5 NoSql的数据模型

- 1.6 NoSql数据库的分类

- 1.7 linux安装redis

- 1.8 docker安装redis

- 2.redis必备命令

-

- 2.1 键命令

- 2.2 修改键

- 2.3 键的序列化

- 2.4 键的生存时间

- 2.5 键值对操作

- 2.6 删除键

- 2.7 HyperLogLog命令

- 2.8 脚本命令

- 2.9 客户端与服务器

- 2.10 配置选项

- 2.11 复制

- 2.12 调试

- 3.redis五种数据类型

-

- 3.1 String 类型

- 3.2 HASH 类型

- 3.3 list 数据类型

- 3.4 set 数据类型

- 3.5 sorted set 数据类型

- 4.redis数据库

-

- 4.1 redis数据库的切换

- 4.2 redis删除策略

-

- 4.2.1 定期删除策略

- 4.2.2 惰性删除策略

- 4.2.3 定期删除策略

- 4.2.4 Redis过期删除策略

-

- 4.2.4.1 定期删除

- 4.2.4.2 懒惰删除

- 4.2.4.3 aof/rdb和复制功能对过期键的处理

- 4.3 redis数据库通知

- 5.redis通信协议

-

- 5.1 网络层

- 5.2 请求

- 5.3 新版统一请求协议

- 5.4 回复

- 5.5 状态回复

- 5.6 错误回复

- 5.7 整数回复

- 5.8 批量回复

- 5.9 多条批量回复

- 5.10 多条批量回复中的空元素

- 5.11 多命令和流水线

- 5.12内联命令

- 5.13 高性能 Redis 协议分析器

- 6.redis客户端与服务器

-

- 6.1.redis客户端

-

- 6.1.1 客户端名称,套接字,标志和时间

- 6.1.2 客户端缓冲区

- 6.1.3 客户端的 authenticated 属性

- 6.1.4 客户端的 argv 和 argc 属性

- 6.1.5 关闭客户端

- 6.2 redis服务器

-

- 6.2.1 服务器处理命令请求

- 6.2.2 服务器发送命令

- 6.2.3 服务器执行命令

- 6.2.4 服务器返回命令结果

- 6.3 服务器函数

-

- 6.3.1 serverCron 函数

- 6.3.2 trackOperationsPerSecond 函数

- 6.3.3 sigtermHandler 函数

- 6.3.4 clientsCron 函数

- 6.3.5 databasesCron 函数

- 6.4 服务器属性

-

- 6.4.1 cronloops 属性

- 6.4.2 rdb_child_pid 与 aof_child_pid 属性

- 6.4.3 stat_peak_memory 属性

- 6.4.4 lruclock 属性

- 6.4.5 mstime 与 unixtime 属性

- 6.4.6 aof_rewrite_scheduled 属性

- 6.5 Redis 服务器的启动过程

-

- 6.5.1 服务器状态结构的初始化

- 6.5.2 相关配置参数的加载

- 6.5.3 服务器数据结构的初始化

- 6.5.4 数据库状态的处理

- 6.5.5 执行服务器的循环事件

- 7.redis底层数据结构

-

- 7.1 Redis 简单动态字符串

-

- 7.1.1 SDS 的实现原理

- 7.1.2 SDS API 函数

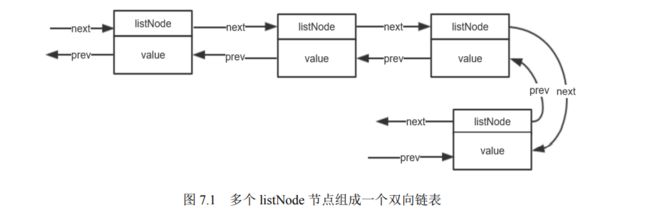

- 7.2 Redis 链表

-

- 7.2.1 Redis 链表实现原理

- 7.2.2 链表 API 函数

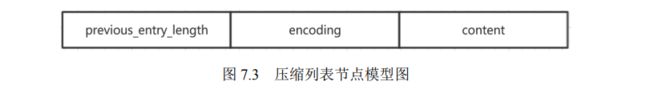

- 7.3 Redis 压缩列表

-

- 7.3.1 压缩列表的实现原理

- 7.3.2 压缩列表 API 函数

- 7.4 Redis 快速列表

-

- 7.4.1 快速列表的实现原理

- 7.4.2 快速列表 API 函数

- 7.5 Redis 字典

-

- 7.5.1 字典的实现原理

- 7.5.2 字典 API 函数

- 7.6 Redis 整数集合

-

- 7.6.1 整数集合的实现原理

- 7.6.2 整数集合 API 函数

- 7.7 Redis 跳表

-

- 7.7.1 跳表的实现原理

- 7.7.2 跳表 API 函数

- 7.8 Redis 中的对象

-

- 7.8.1 对象类型

- 7.8.2 对象的编码方式

- 8.排序

-

- 8.1 SORT 排序命令

- 8.2 升序(ASC)与降序(DESC)

- 8.3 BY 参数的使用

- 8.4 LIMIT 参数的使用

- 8.5 GET 与 STORE 参数的使用

- 8.6 多参数执行顺序

- 9.Redis 事务

-

- 9.1 Redis 事务简介

- 9.2 Redis 事务的 ACID 特性

-

- 9.2.1 事务的原子性

- 9.2.2 事务的一致性

- 9.2.3 事务的隔离性

- 9.2.4 事务的持久性

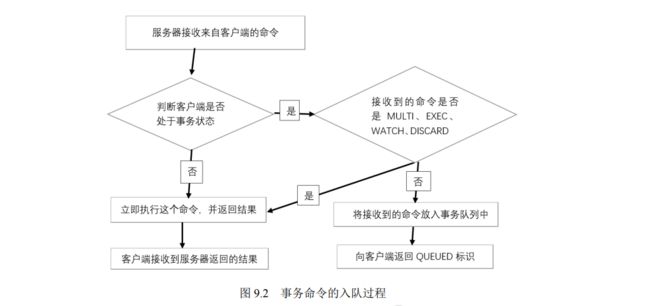

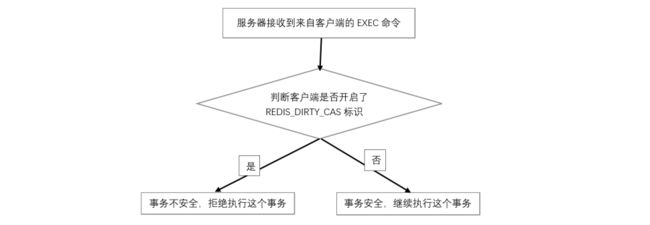

- 9.3 Redis 事务处理

-

- 9.3.1 事务的实现过程

- 9.3.2 悲观锁和乐观锁

- 9.3.3 事务的 WATCH 命令

- 10.消息订阅

-

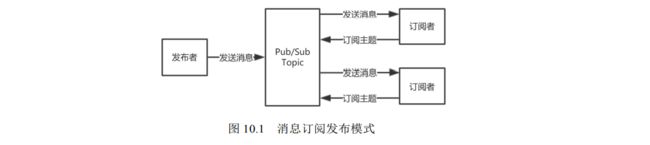

- 10.1 消息订阅发布概述

- 10.2 消息订阅发布实现

-

- 10.2.1 消息订阅发布模式命令

- 10.2.2 消息订阅功能之订阅频道

- 10.2.3 消息订阅功能之订阅模式

- 10.3 Redis 消息队列

-

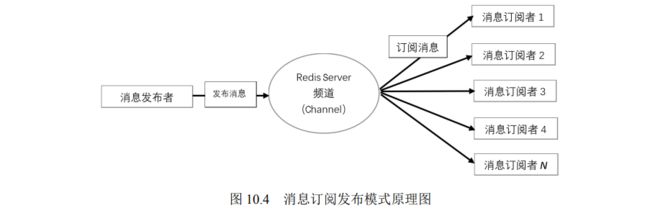

- 10.3.1 消息订阅发布模式的原理

- 10.3.2 消息生产者/消费者模式的原理

- 11.redis持久化

-

- 11.1 Redis 持久化操作概述

-

- 11.2.1 AOF 持久化的配置

- 11.2.2 AOF 持久化的实现

- 11.2.3 AOF 文件重写

- 11.2.5 AOF 持久化的优劣

- 11.3 Redis 持久化机制 RDB

-

- 11.3.1 RDB 持久化

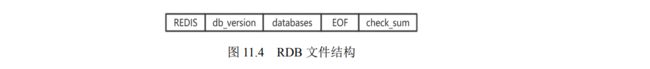

- 11.3.2 RDB 文件

- 11.3.3 RDB 文件的创建与加载

- 11.3.4 创建与加载 RDB 文件时服务器的状态

- 11.3.5 RDB 持久化的配置

- 11.3.6 RDB 持久化的优劣

- 11.4 AOF 持久化与 RDB 持久化抉择

- 12.redis 集群

-

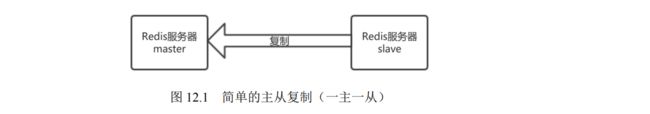

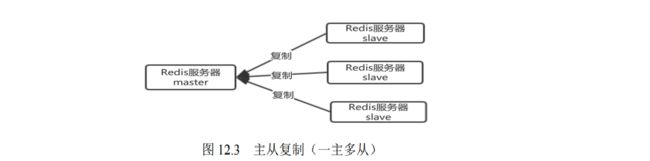

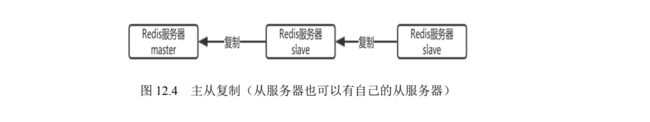

- 12.1 Redis 集群的主从复制模式

-

- 12.1.1 什么是主从复制

- 12.1.2 主从复制配置

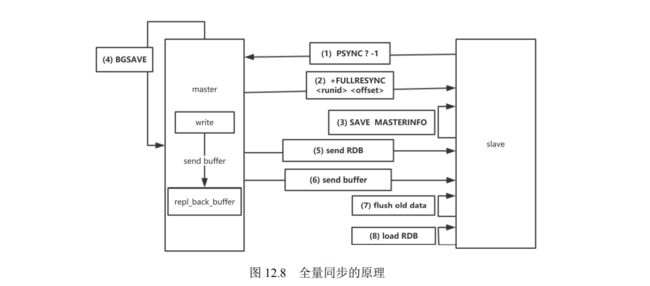

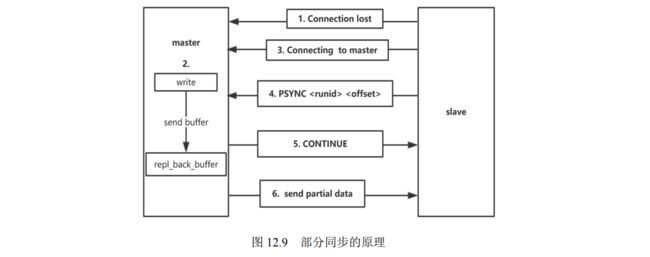

- 12.1.3 复制功能的原理

- 12.1.4 复制功能的实现步骤

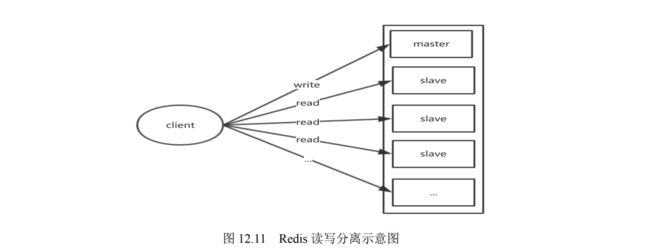

- 12.1.5 Redis 读写分离

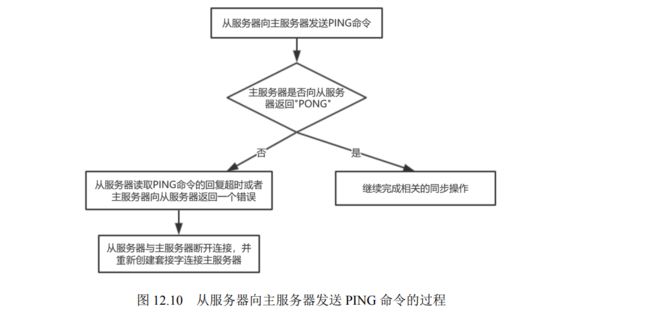

- 12.1.6 Redis 心跳机制

- 12.2 Redis 集群的高可用哨兵模式

-

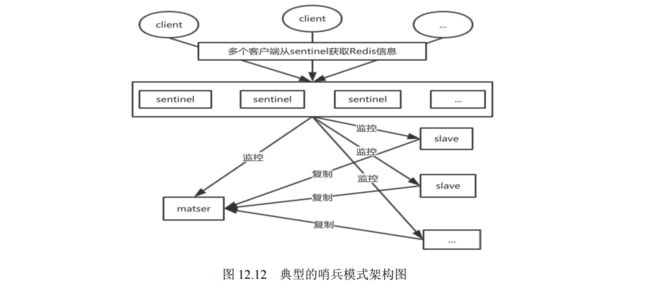

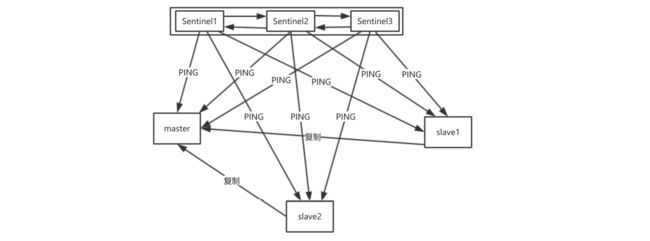

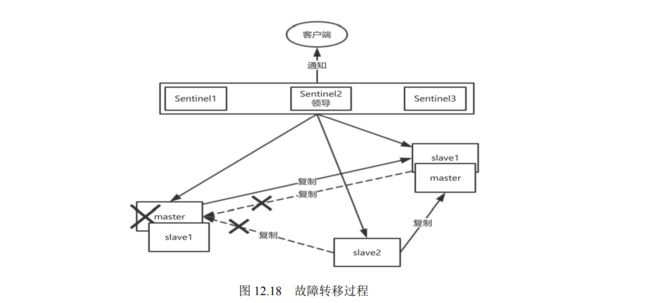

- 12.2.1 什么是高可用哨兵模式

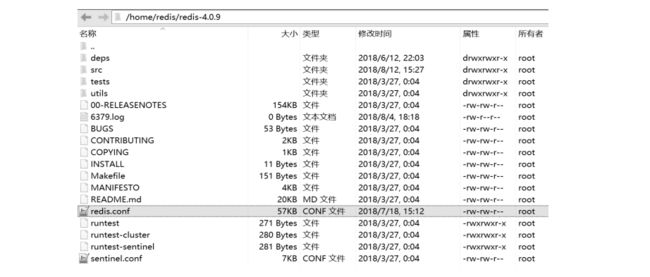

- 12.2.2 哨兵模式的配置

- 12.2.3 Sentinel 的配置选项

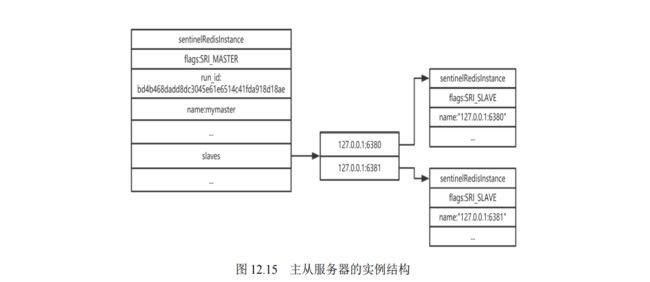

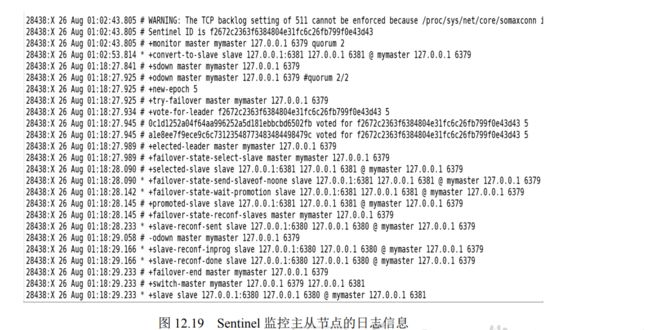

- 12.2.4 哨兵模式的实现原理

- 12.2.5 选择“合适”的 slave 节点作为 master 节点

- 12.2.6 Sentinel 的下线状态

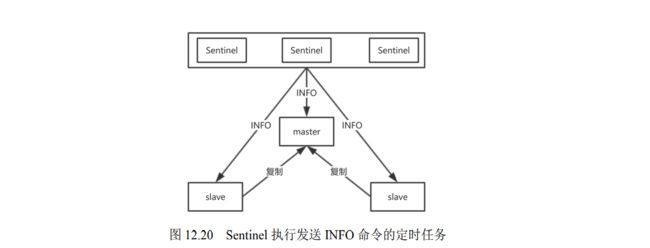

- 12.2.7 Sentinel 内部的定时任务

- 12.3 Redis 集群搭建

-

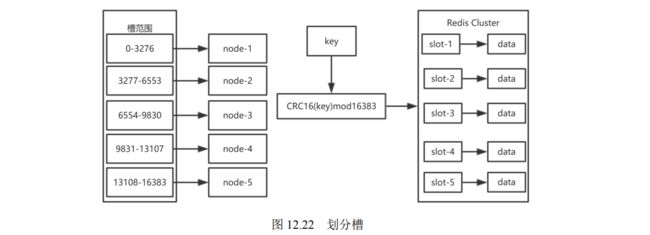

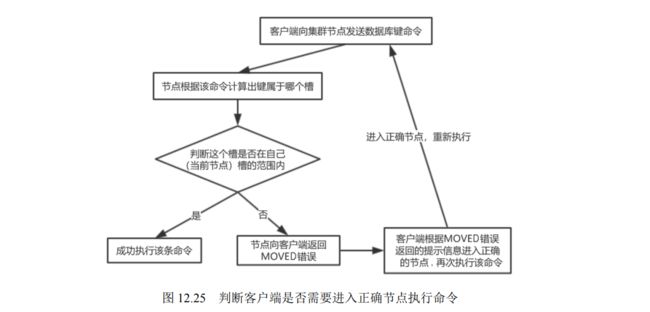

- 12.3.1 什么是 Redis 集群

- 12.3.2 集群中的节点和槽

- 12.3.3 集群搭建

- 12.3.4 使用 Redis 集群

- 12.3.5 集群中的错误

- 12.3.6 集群的消息

- 13.redis实战

-

- 13.1 java连接redis

1.概述与安装

1.1.redis概述

Redis:REmote DIctionary Server(远程字典服务器)是完全开源免费的,用C语言编写的,遵守BSD协议,是一个高性能的(key/value)分布式内存数据库,基于内存运行 并支持持久化的NoSQL数据库,是当前最热门的NoSql数据库之一,也被人们称为数据结构服务器。

Redis 与其他 key - value 缓存产品有以下三个特点:

Redis支持数据的持久化,可以将内存中的数据保持在磁盘中,重启的时候可以再次加载进行使用

Redis不仅仅支持简单的key-value类型的数据,同时还提供list,set,zset,hash等数据结构的存储

Redis支持数据的备份,即master-slave模式的数据备份

redis能做什么?

1.内存存储和持久化:redis支持异步将内存中的数据写到硬盘上,同时不影响继续服务

2.取最新N个数据的操作,如:可以将最新的10条评论的ID放在Redis的List集合里面

3.模拟类似于HttpSession这种需要设定过期时间的功能

4.发布、订阅消息系统

5.定时器、计数器

1.2 什么是NoSql?

NoSql不仅仅是SQL,他是Not Only SQL的缩写,也是众多非关系数据库的简称,NoSql和关系型数据库一样,都是用来存储数据的仓库。

1.为什么需要NoSql?

随着互联网的高速发展,数据量,访问量呈爆发式的增长,人们对QQ,微信,微博,网上购物等软件使用的依赖度增高,如 聊天记录,商品信息,微博信息存储在哪里呢?如果全存储在关系型数据库中。然后传统的关系型数据库面对这些大数据量的信息存储,以及事项高访问,高并发,高吞吐量,就会暴露出问题难以克服的问题。为了海量数据的高速缓存存储,NoSQL由此诞生。

2.NoSql的出现解决了高并发读写的问题

web2.0 动态网站需要根据用户的需求来生成动态页面,和提供动态信息,而且无法使用动态页面的静态话技术,因此数据库的并发负载会非常的高,比如微博,朋友圈的实时更新,会出现每秒上万次的读写请求。关系型数据库在每秒上万的SQL查询中还能应对自如,但是如果是每秒上万次的SQL写操作时,就难以招架了,普通BBS系统网站也存在高并发读写的需求,比如实时统计在线人数,记录热门帖子之类的,当面对这些需求的时候,传统的关系型数据库就会出现很大的问题。

3.NoSql的出现解决了海量数据的高效率存储和访问问题

面对实时产生的大量数据的存储与查询,关系型数据库是难以应对的,会显得效率非常的低,而利用NoSql的高效存储和查询能力,就能解决这个问题。

4.NoSql事项了高可用性以及高维护性

在基于web的架构中,关系型数据库难以进行横向扩展,当一个网站系统的用户量和访问量与日俱增的时候,数据库没有办法像web服务器或应用服务器那样通过添加跟多的硬件来搭建负载均衡的服务器,对于很多24小时不间断的非圆舞曲网站来说,对数据库系统的升级和维护是一个非常折磨人的事情,往往需要停机和数据迁移。

随着NoSql的出现,解决了大规模数据库集中和数据种类不同所带来的各种问题,尤其是大数据实现起来非常困难。

NoSql有如下特点:

- 容易扩展,方便失业,数据直接没有关系

- 数据模型非常灵活多变,无需提前为存储的字段建立映射关系,随时可以存储自定义的数据格式

- 适合大数据量,高性能的存储

- 具有高并发,读写,高可用性

1.3 NoSql与传统数据库的比较

相信大家对传统关系型数据库都不陌生,我们常常使用的关系型数据库有MySql,Oracle,Sql Server,SQLite,DB2,Teradata,Infomix,Sybase,PostreSQL,Access,FoxPro等等

我们现在通过以下几个方面来比较NoSql与传统关系型数据库

1.使用成本:

NoSql:NoSql使用简单,容易搭建,大部分是开源软件,比较廉价,任何人都可以免费使用。

关系型数据库:相对于NoSql来说,关系型数据库需要安装和部署,开源的比较少,使用成本比较昂贵,尤其是Oracle数据库,需要花大量资金购买,使用成本比较高。

2.存储形式:

NoSql:NoSql 具有丰富的存储形式,如key-value的形式,图表结构,文档形式,列簇等,因此他可以存储各种数据类型

关系型数据库:关系型数据库采用的关系模型来存储数据,他是行列结构,通过行与列的二元形式表示处理,数据之间有很强大的关联性,采用二维表的结果来进行持久化存储。

3.查询速度:

NoSql:NoSql将数据存储在系统的缓存中,存储在内存,不需要Sql解析,因此查询速度非常的快

关系型数据库:关系型数据库将数据存储在系统的硬盘中,在查询的时候需要经过SQL层的解析,然后读入内存,实现查询,因此查询效率比较低。

4.扩展性:

NoSql:NoSql去掉了传统关系型数据库表与字段之间的关系,实现了真正意义上的扩展,他采用了键值对的形式进行存储,消除了数据之间的耦合性,因此容易扩展。

关系型数据库:由于关系数据库采用了关系数据模型来存储数据,数据与数据直接的关联性非常强,存在耦合性,因此不容易扩展,尤其是存在多表连接的情况,查询机制的限制,使得扩展很难实现。

5.是否支持ACID:

ACID特性指的是数据库事务执行的要素,包含了原子性,一致性,隔离性,持久性

NoSql:NoSql一般不支持事,他具有最终一致性

关系型数据库:支持ACID的特性,具有严格的数据库一致性

6.是否支持SQL语句

NoSql:SQL语句在NoSql中是不支持的,NoSql没有声明性的查询预约,并且没有预定义的模式。

关系型数据库:关系型数据库支持SQL,也支持复查的查询,SQL是结构化数据语言,数据操纵语言,数据定义语言。

NoSql与传统关系型数据库是互补的关系,对方的劣势就是自己的优势,反之亦然。

1.4 在什么场景下使用NoSql

NoSql的使用场景比较广泛,下面简单说一下比较合适使用NoSql的几个场景。

- 对于大数据量,高并发的存储系统相关应用

- 对于一些数据模型比较简单的相关应用

- 对于数据一致性不是很高的业务场景

- 对于指定的key来映射一些复制的业务环境

- 对于一些大型的日志信息存储

- 存储用户信息,大型上传的电商购物车,会话等

- 对于多数据源的数据存储

- 对于容易辩护,热点高频信息,关键字等信息存储

以上这些场景都可以使用NoSql进行存储,NoSql还有很多其他的应用。

1.5 NoSql的数据模型

我们清楚,关系型数据库的数据模型由数据结构,数据操作以及完整性约束条件组成,同样,NoSql也有其他相关的数据模型。NoSql的4种数据模型如下:

1.键值对类型数据:

键值对数据模型就是采用key-value的形式进行存储,将数据存储在一张hash表中,这张hash表具有一个特定的key一个特定指向数据的指针。键值对存储中的值可以是任意类型的值,比如: 数字,字符串,也可以是对象在对象中的新键值对。

2.列数据模型:

列数据类型是将数据按照列簇的形式来统一进行存储,通常用于存储分布式系统的海量数据,他也有键指向多个列,由数据库的列簇来统一安排。

3.文档数据模型:

文档数据模型以文档的形式进行存储,他是键值对数据模型的升级版,是版本化的文档,他可以使用模式来指定某个文档的结构,通常采用特定格式来存储半结构化的文档,最常使用的存储格式是XML,JSON,每个文档都是自包含的数据单元,是一系列数据项的集合。

4.图数据类型:

图数据模型采用图结构形式来存储数据,他是键值对数据模型的升级版,他是最复杂的NoSql,常被用于存储一些社交网络关系,使用与存储高度互联网的数据,他由多个节点和多条边组成,节点表示实体,边表示两个实体之间的关系。

其中,键值对数据模型,列数据模型,文档数据模型,统称为聚合模型,他们有一个共同的特点,可以把一组相互关联的对象看在是一个整体的单元来操作,通常把这个单元称为一个聚合。

1.6 NoSql数据库的分类

NoSql数据库大致可以分为四大类:

1.键值对存储数据库:

主要采用键值对形式存储的数据的数据库,典型的有redis,memcached,voldemort,brekeley,tokyiCabiney等,采用该类数据库做存储时,需要定义数据结构(半结构)才能进行存。

2.面向列存储数据库:

主要按照列存储的一类数据库,典型代表有HBase,Cassandra,Riak等,采用该类数据库存储数据时,需要定义数据结构(半结构)才能进行存。

3.面向文档数据库:

主要用于存储文档的一类数据库,文档是它最小的单元,同一张表中存储的文档属性是多样化的,数据可以采用XML,JSON,JSONB等多种格式存储,典型代表:MongoDB,CouchDb,RavenDB等,采用该类数据库存储数据的时候,不需要定义数据结构(非结构化)就可以进行存储。

4.面向图形数据库:

主要用于存储图片信息的一类数据库,典型代表:Neo4j,InfoGrid,Infinite,Graph等。目前NoSql数据库的使用场景非常广泛,很多企业都会根据自己的业务场景来使用各类NoSql数据库,或者混合使用他们。

各类NoSql数据类型比较:

1.7 linux安装redis

安装redis:

redis中文官网

切换到 /opt目录下 ,新建一个redis目录依次执行以下命令,在/usr/local/bin下新建一个目录redis_config,将redis.config文件复制到这个目录

1: yum install wget

2: wget https://github.com/redis/redis/archive/6.2-rc2.tar.gz --no-check-certificate

3:tar -zxvf 6.2-rc2.tar.gz

4: yum install gcc-c++

5:gcc -v 查看gcc版本

6:make (cd到解压后的redis文件下执行)

7: make install

8:redis默认的安装路径: /usr/local/bin

启动redis:

redis-server redis.config配置文件路径

redis-cli -p 6379

解决redis中文乱码:redis-cli --raw

ps -ef | grep redis 查看redis是否成功启动

redis默认端口号:6379

redis 共有15个数据库 select 索引号 :切换到指定数据库 (索引从0开始 ) 默认打开的就是第一个数据库

get key 获取指定k的值 set key 设置指定k的值

keys * 列出当前数据库的 所有k keys k? 列出k开头的k字段

flushdb :清空当前数据库的所有key

flushall : 清空所有数据库中的key

设置redis密码

1、vim redis.conf 修改requirepass的值 (设置redis密码)

2.config set requirepass admin (设置redis密码)

设置密码后需要执行: auth password 才能操作 redis

1.8 docker安装redis

# 下载

docker run -p 3307:3306 -v /usr/local/mysql/conf:/etc/mysql/conf.d -v /usr/local/mysql/data:/var/lib/mysql -e MYSQL_ROOT_PASSWORD=123456 --name mysql mysql:8.0.1

# 运行

docker run \

--name mysql -d \

-p 3307:3306 \

--privileged=true \

-v /usr/local/mysql/conf:/etc/mysql/conf.d \

-v/usr/local/mysql/data:/var/lib/mysql \

-e MYSQL_ROOT_PASSWORD=admin \

mysql:8.0.1

2.redis必备命令

2.1 键命令

1. EXISTS(查询键是否存在)

描述:查询键是否存在,如果存在返回1,不存在返回0

# 命令格式 EXISTS key [key ...]

exists user_id

2. KEYS(查找键)

描述:用于查询指定的模式所有的key 参数可以使用类似正则的方式

# 命令格式: KEYS pattern

# 查询当前数据库中所有的key

keys *

# 查询出 redis radis rxdis 等,?:表示一个占位符

keys r?dis

# 表示匹配 rdis,redis,reedis等 *:表示占位一个或多个字符

keys r*dis

# 表示匹配radis和redis []:表示满足其中一个选项即可

3. OBJECT(查询键的对象)

描述:用于查询给定key的redis对象,该指令主要用于在除错,或者为了节省空间而对于key使用特色编码的情况下

# 命令格式: OBJECT subcommand [arguments [arguments ...]]

REFCOUNT:指定key所存储的引用次数

ENCODING:返回指定key底层所使用的数据结构

IDLETIME:返回指定key存储以来的空闲时间,以秒为单位

4.RANDOMKEY(返回随机key)

描述:从当前数据库中随机返回一个key,并且不会去删除这个key

# 命令格式:RANDOMKEY

2.2 修改键

1.RENAME(修改键的名称)

描述:将指定key进行重命名,如果这个newkey存在的话,新值会覆盖掉旧值

#命令格式:RENAME kye newkey

2.(RENAMENX)修改键的名称

描述:将指定key进行重命名,只有当这个newkey不存在的时候,才可以重命名成功。如果key不存在返回错误

#命令格式:RENAMENX key newkey

2.3 键的序列化

1.DUMP(序列化键)

描述:序列化指定的key,并且返回被序列化之后的值,反正我们可以使用 RESTORE 命令来反序列化这个key

# 命令格式: DUMP key

使用DUMP命令序列化生成的值具有如下特点:

- 这个值具有64位的校验和,用于检测错误,RESTORE 命令在反序列之前,会先检查校验和

- 这个值的编码格式和RDB的编码格式保持一致

- RDB版本会被编码在序列化值中,如果redis版本不同,那么这个rdb文件会存在不兼容的问题,redis也就无法对这个值进行返序列化

- 这个序列化的值中没有生存信息

2.RESTORE(反序列化)

描述:用于将给定的值进行返序列化操作,并且关联一个key,ttl用于给key设置过期时间,单位为毫秒,如果设置为0就表示永不过期,

如果key已经存在,并且给定了REPLACE参数,则将会新值覆盖旧值,如果key已经存在,而没有设置REPLACE参数,则将会返回一个错误,当序列化成功的时候,返回一个ok。

# 命令格式: RESTORE key ttl serialized-value [REPLACE] [ABSTTL] [IDLETIME seconds] [FREQ frequency]

2.4 键的生存时间

1.PTTL(获取键的生存时间,毫秒)

描述:用于以毫秒的形式返回key的生存时间,如果key不存在,返回-2,如果key存在,但是没有设置过期时间,返回-1

# 命令格式: PTTL key

2.TTL(获取键的生存时间,秒)

描述:用于以毫秒的形式返回key的生存时间,如果key不存在,返回-2,如果key存在,但是没有设置过期时间,返回-1

# 命令格式: TTL key

3.EXPIRE(设置键的生存时间,秒)

描述:该指令用于设置key的生存时间,当key的生存时间为0的时候,这个key会被删除掉

# 命令格式: EXPIRE key seconds

4.PEXPIRE(设置键的生存时间,毫秒)

描述:该指令用于设置key的生存时间,当key的生存时间为0的时候,这个key会被删除掉

# 命令格式: PEXPIRE key milliseconds

5.EXPIREAT(设置键的生存时间,时间戳)

描述:该指令用于设置key的生存时间,当key的生存时间为0的时候,这个key会被删除掉

# 命令格式: EXPIREAT key timestamp

2.5 键值对操作

1.MIGRATE(转移键值到远程目标数据库)

描述:该命令将key原子性的移动到目标数据库中一旦移动成功,就会生成当前数据库中的key

- timout 表示超时时间,单位为毫秒

- host 目标主机地址

- port 目标主机端口号

- auth 目标主机密码

- key 移动过去的key是什么?

- copy 参数设置了的时候,表示移动完毕后,不用在源数据库中删除

- replace 表示在移动到目标数据库的过程中,如果目标数据库指定的key已经存在,那么就进行覆盖操作

# 命令格式: MIGRATE host port key| destination-db timeout [COPY] [REPLACE] [AUTH password] [KEYS key]

2.MOVE(转移键值对到本地目标数据库)

描述:将当前数据库中的key转移到指定db数据库中,如果当前数据库中没有指定的key,那么move什么也不做,如果当前数据库和给定的数据库中存在相同的key,move命令不起效果。

# 命令格式: MOVE key db

2.SORT(对键值对进行排序)

描述:SORT命令主要用于排序,他返回或保存给定的列表,集合,有序集合中经过排序的元素,默认以数字作为对象,值会被解析成double类型的浮点数,然后进行比较。

# 命令格式: SORT key [BY pattern] [LIMIT offset count] [GET pattern [GET pattern ...]] [ASC|DESC] [ALPHA] [STORE destination]

4.TYPE(获取键值对应的类型)

描述:用于返回key 所对应值的类型

# 命令格式:TYPE key

2.6 删除键

1.DEL(删除键)

描述:该命令可以删除一个或多个指定的key,如果这个key不存在的话会被忽略掉,执行成功后返回删除成功的数量

# 命令格式:DEL key [key...]

2.PERSIST(删除键的生存时间)

描述:用于删除给定key的生存时间,将这个带有生存时间的key,转换为一个不带生存时间的key,永不过期。

# 命令格式: PERSIST key

2.7 HyperLogLog命令

HyperLogLog 是redis用来做技术统计的算法,当redis数据库中数据库特别大的时候,使用HyperLogLog命令来计算相关奇数时,他具有所需空间固定,所占空间小的优点,在redis中每个HyperLogLogkey只需要12kb,就可以计算接近2^64个不同的基数,HyperLogLog不会存储输入的元素,他仅仅只是通过输入的元素来计算基数,因此他不会返回输入的元素。

什么是基数?

也就是说比如像{1,2,3,4,4,5},这样一个数据集,去掉重复后为:{1,2,3,4,5},那么这个数据集的基数就为:5

1.PFADD(添加键值对到HyperLogLog中)

描述:该命令将一个或多个指定的key添加到HyperLogLog中,HyperLogLog内部可能会更新添加进来的key,来反映一个不同唯一元素估计数量,这个数量就是集合的基数。如果HyperLogLog估计近似基数在命令执行后发生了变化,那么命令就返回1,否则返回.,这个给定的key不存在,那么命令先会创建一个空的HyperLogLog,再执行命令。

在执行PFADD命令时,我们可以只设置key,而不设置这个key对应的元素,PFADD命令在执行时,如给定的键已经是一个HyperLogLog,那么这个命令将上面也不做,如果给定的键不存在,那么该命令会先创建一个空的HyperLogLog,然后在返回1、

返回值:如果HyperLogLog内部更新了返回1 ,否则返回0

#命令格式: PFADD key element [element ...]

2.PFCOUNT(获取HyperLogLog基数)

描述:PFCOUNT 指令后面可以跟多个key,当PFCOUNT key [key …]命令作用于单个键时,返回存储在给定键的HyperLogLog的近似基数,如果键不存在,则返回0;当PFCOUNT key [key …]命令作用于多个键时,返回所给定HyperLogLog的并集的近似基数,这个近似基数是通过将索引给定HyperLogLog合并至一个临时HyperLogLog来计算得出的。使用PFCOUNT并不是精准的,而是一个带有0.81%标准错误的近似值。

# 命令格式:PFCOUNT key [key …]

3.PFMERGE (合并HyperLogLog)

描述:将多个HyperLogLog合并到一个HyperLogLog中,合并后HyperLogLog的基数接近于所有输入HyperLogLog的可见集合的并集,合并后得到的HyperLogLog会被存储在destkey键里面,如果该键不存在,那么命令在执行之前,会先为该键创建一个空的HyperLogLog。

# 命令格式:PFMERGE destkey sourcekey [sourcekey …]

2.8 脚本命令

redis脚本使用Lua解释器来执行,使用redis脚本,可以一次性将多个请求命令发送出去,以减少网络开销,使用redis脚本可以实现原子操作,redis会将整个脚本作为一个整体去执行,中间不会去执行其他的指令,以此保证原子性,使用redis可以达到复用的目的,所以其他客户端可以复用这个脚本。

1.SCRIPT LOAD(将脚本添加到缓存)

描述:将脚本 script 添加到脚本缓存中,但并不立即执行这个脚本。返回给定script的SHA1校验和

# 命令格式: SCRIPT LOAD script

2.SCRIPT EXISTS (检测指定脚本是否存在)

描述:给定一个或多个脚本的 SHA1 校验和,返回一个包含 0 和 1 的列表,表示校验和所指定的脚本是否已经被保存在缓存当中。

返回值:一个列表,包含 0 和 1 ,前者表示脚本不存在于缓存,后者表示脚本已经在缓存里面了。 列表中的元素和给定的 SHA1 校验和保持对应关系,比如列表的第三个元素的值就表示第三个 SHA1 校验和所指定的脚本在缓存中的状态。

# 命令格式: SCRIPT EXISTS script

3.EVAL(对脚本求值)

描述:从 Redis 2.6.0 版本开始,通过内置的 Lua 解释器,可以使用 EVAL 命令对 Lua 脚本进行求值。

script 参数是一段 Lua 5.1 脚本程序,它会被运行在 Redis 服务器上下文中,这段脚本不必(也不应该)定义为一个 Lua 函数。

numkeys 参数用于指定键名参数的个数。

键名参数 key [key …] 从 EVAL 的第三个参数开始算起,表示在脚本中所用到的那些 Redis 键(key),这些键名参数可以在 Lua 中通过全局变量 KEYS 数组,用 1 为基址的形式访问( KEYS[1] , KEYS[2] ,以此类推)。

在命令的最后,那些不是键名参数的附加参数 arg [arg …] ,可以在 Lua 中通过全局变量 ARGV 数组访问,访问的形式和 KEYS 变量类似( ARGV[1] 、 ARGV[2] ,诸如此类)。

# 命令格式: EVAL script numkeys key [key ...] arg [arg ...]

4.EVALSHA (对缓存中的脚本求值)

描述:根据给定的 sha1 校验码,对缓存在服务器中的脚本进行求值。

将脚本缓存到服务器的操作可以通过 SCRIPT LOAD script 命令进行。

这个命令的其他地方,比如参数的传入方式,都和 EVAL script numkeys key [key …] arg [arg …] 命令一样。

#命令格式:EVALSHA sha1 numkeys key [key …] arg [arg …]

5.SCRIPT KILL(杀掉或清除正在执行的脚本)

描述:杀死当前正在运行的 Lua 脚本,当且仅当这个脚本没有执行过任何写操作时,这个命令才生效。

这个命令主要用于终止运行时间过长的脚本,比如一个因为 BUG 而发生无限 loop 的脚本,诸如此类。

SCRIPT KILL 执行之后,当前正在运行的脚本会被杀死,执行这个脚本的客户端会从 EVAL script numkeys key [key …] arg [arg …] 命令的阻塞当中退出,并收到一个错误作为返回值。

另一方面,假如当前正在运行的脚本已经执行过写操作,那么即使执行 SCRIPT KILL ,也无法将它杀死,因为这是违反 Lua 脚本的原子性执行原则的。在这种情况下,唯一可行的办法是使用 SHUTDOWN NOSAVE 命令,通过停止整个 Redis 进程来停止脚本的运行,并防止不完整(half-written)的信息被写入数据库中。

# 命令格式:SCRIPT KILL

6.SCRIPT FLUSH(清除缓存中的lua脚本)

描述:清除所有 Lua 脚本缓存。

# 命令格式:SCRIPT FLUSH

2.9 客户端与服务器

1.AUTH (账号登录)

描述:

通过设置配置文件中 requirepass 项的值(使用命令 CONFIG SET requirepass password ),可以使用密码来保护 Redis 服务器。

如果开启了密码保护的话,在每次连接 Redis 服务器之后,就要使用 AUTH 命令解锁,解锁之后才能使用其他 Redis 命令。

如果 AUTH 命令给定的密码 password 和配置文件中的密码相符的话,服务器会返回 OK 并开始接受命令输入。

另一方面,假如密码不匹配的话,服务器将返回一个错误,并要求客户端需重新输入密码。

# 命令格式 : AUTH password

2.QUIT(关闭与服务端的连接)

描述:请求服务器关闭与当前客户端的连接。

一旦所有等待中的回复(如果有的话)顺利写入到客户端,连接就会被关闭。

# 命令格式:QUIT

3.INFO (返回服务端信息)

描述:以一种易于解释(parse)且易于阅读的格式,返回关于 Redis 服务器的各种信息和统计数值。

通过给定可选的参数 section ,可以让命令只返回某一部分的信息:

-

server部分记录了 Redis 服务器的信息,它包含以下域:redis_version: Redis 服务器版本redis_git_sha1: Git SHA1redis_git_dirty: Git dirty flagos: Redis 服务器的宿主操作系统arch_bits: 架构(32 或 64 位)multiplexing_api: Redis 所使用的事件处理机制gcc_version: 编译 Redis 时所使用的 GCC 版本process_id: 服务器进程的 PIDrun_id: Redis 服务器的随机标识符(用于 Sentinel 和集群)tcp_port: TCP/IP 监听端口uptime_in_seconds: 自 Redis 服务器启动以来,经过的秒数uptime_in_days: 自 Redis 服务器启动以来,经过的天数lru_clock: 以分钟为单位进行自增的时钟,用于 LRU 管理

-

clients部分记录了已连接客户端的信息,它包含以下域:connected_clients: 已连接客户端的数量(不包括通过从属服务器连接的客户端)client_longest_output_list: 当前连接的客户端当中,最长的输出列表client_longest_input_buf: 当前连接的客户端当中,最大输入缓存blocked_clients: 正在等待阻塞命令(BLPOP、BRPOP、BRPOPLPUSH)的客户端的数量

-

memory部分记录了服务器的内存信息,它包含以下域:used_memory: 由 Redis 分配器分配的内存总量,以字节(byte)为单位used_memory_human: 以人类可读的格式返回 Redis 分配的内存总量used_memory_rss: 从操作系统的角度,返回 Redis 已分配的内存总量(俗称常驻集大小)。这个值和top、ps等命令的输出一致。used_memory_peak: Redis 的内存消耗峰值(以字节为单位)used_memory_peak_human: 以人类可读的格式返回 Redis 的内存消耗峰值used_memory_lua: Lua 引擎所使用的内存大小(以字节为单位)mem_fragmentation_ratio:used_memory_rss和used_memory之间的比率mem_allocator: 在编译时指定的, Redis 所使用的内存分配器。可以是 libc 、 jemalloc 或者 tcmalloc 。

在理想情况下,

used_memory_rss的值应该只比used_memory稍微高一点儿。当

rss > used,且两者的值相差较大时,表示存在(内部或外部的)内存碎片。内存碎片的比率可以通过

mem_fragmentation_ratio的值看出。当

used > rss时,表示 Redis 的部分内存被操作系统换出到交换空间了,在这种情况下,操作可能会产生明显的延迟。Because Redis does not have control over how its allocations are mapped to memory pages, high

used_memory_rssis often the result of a spike in memory usage.当 Redis 释放内存时,分配器可能会,也可能不会,将内存返还给操作系统。

如果 Redis 释放了内存,却没有将内存返还给操作系统,那么

used_memory的值可能和操作系统显示的 Redis 内存占用并不一致。查看

used_memory_peak的值可以验证这种情况是否发生。 -

persistence部分记录了跟RDB持久化和AOF持久化有关的信息,它包含以下域:loading: 一个标志值,记录了服务器是否正在载入持久化文件。rdb_changes_since_last_save: 距离最近一次成功创建持久化文件之后,经过了多少秒。rdb_bgsave_in_progress: 一个标志值,记录了服务器是否正在创建 RDB 文件。rdb_last_save_time: 最近一次成功创建 RDB 文件的 UNIX 时间戳。rdb_last_bgsave_status: 一个标志值,记录了最近一次创建 RDB 文件的结果是成功还是失败。rdb_last_bgsave_time_sec: 记录了最近一次创建 RDB 文件耗费的秒数。rdb_current_bgsave_time_sec: 如果服务器正在创建 RDB 文件,那么这个域记录的就是当前的创建操作已经耗费的秒数。aof_enabled: 一个标志值,记录了 AOF 是否处于打开状态。aof_rewrite_in_progress: 一个标志值,记录了服务器是否正在创建 AOF 文件。aof_rewrite_scheduled: 一个标志值,记录了在 RDB 文件创建完毕之后,是否需要执行预约的 AOF 重写操作。aof_last_rewrite_time_sec: 最近一次创建 AOF 文件耗费的时长。aof_current_rewrite_time_sec: 如果服务器正在创建 AOF 文件,那么这个域记录的就是当前的创建操作已经耗费的秒数。aof_last_bgrewrite_status: 一个标志值,记录了最近一次创建 AOF 文件的结果是成功还是失败。

如果 AOF 持久化功能处于开启状态,那么这个部分还会加上以下域:

aof_current_size: AOF 文件目前的大小。aof_base_size: 服务器启动时或者 AOF 重写最近一次执行之后,AOF 文件的大小。aof_pending_rewrite: 一个标志值,记录了是否有 AOF 重写操作在等待 RDB 文件创建完毕之后执行。aof_buffer_length: AOF 缓冲区的大小。aof_rewrite_buffer_length: AOF 重写缓冲区的大小。aof_pending_bio_fsync: 后台 I/O 队列里面,等待执行的fsync调用数量。aof_delayed_fsync: 被延迟的fsync调用数量。

-

stats部分记录了一般统计信息,它包含以下域:total_connections_received: 服务器已接受的连接请求数量。total_commands_processed: 服务器已执行的命令数量。instantaneous_ops_per_sec: 服务器每秒钟执行的命令数量。rejected_connections: 因为最大客户端数量限制而被拒绝的连接请求数量。expired_keys: 因为过期而被自动删除的数据库键数量。evicted_keys: 因为最大内存容量限制而被驱逐(evict)的键数量。keyspace_hits: 查找数据库键成功的次数。keyspace_misses: 查找数据库键失败的次数。pubsub_channels: 目前被订阅的频道数量。pubsub_patterns: 目前被订阅的模式数量。latest_fork_usec: 最近一次fork()操作耗费的毫秒数。

-

replication: 主/从复制信息role: 如果当前服务器没有在复制任何其他服务器,那么这个域的值就是master;否则的话,这个域的值就是slave。注意,在创建复制链的时候,一个从服务器也可能是另一个服务器的主服务器。

如果当前服务器是一个从服务器的话,那么这个部分还会加上以下域:

master_host: 主服务器的 IP 地址。master_port: 主服务器的 TCP 监听端口号。master_link_status: 复制连接当前的状态,up表示连接正常,down表示连接断开。master_last_io_seconds_ago: 距离最近一次与主服务器进行通信已经过去了多少秒钟。master_sync_in_progress: 一个标志值,记录了主服务器是否正在与这个从服务器进行同步。

如果同步操作正在进行,那么这个部分还会加上以下域:

master_sync_left_bytes: 距离同步完成还缺少多少字节数据。master_sync_last_io_seconds_ago: 距离最近一次因为 SYNC 操作而进行 I/O 已经过去了多少秒。

如果主从服务器之间的连接处于断线状态,那么这个部分还会加上以下域:

master_link_down_since_seconds: 主从服务器连接断开了多少秒。

以下是一些总会出现的域:

connected_slaves: 已连接的从服务器数量。

对于每个从服务器,都会添加以下一行信息:

slaveXXX: ID、IP 地址、端口号、连接状态

-

cpu部分记录了 CPU 的计算量统计信息,它包含以下域:used_cpu_sys: Redis 服务器耗费的系统 CPU 。used_cpu_user: Redis 服务器耗费的用户 CPU 。used_cpu_sys_children: 后台进程耗费的系统 CPU 。used_cpu_user_children: 后台进程耗费的用户 CPU 。

-

commandstats部分记录了各种不同类型的命令的执行统计信息,比如命令执行的次数、命令耗费的 CPU 时间、执行每个命令耗费的平均 CPU 时间等等。对于每种类型的命令,这个部分都会添加一行以下格式的信息:cmdstat_XXX:calls=XXX,usec=XXX,usecpercall=XXX

-

cluster部分记录了和集群有关的信息,它包含以下域:cluster_enabled: 一个标志值,记录集群功能是否已经开启。

-

keyspace部分记录了数据库相关的统计信息,比如数据库的键数量、数据库已经被删除的过期键数量等。对于每个数据库,这个部分都会添加一行以下格式的信息:dbXXX:keys=XXX,expires=XXX

除上面给出的这些值以外, section 参数的值还可以是下面这两个:

all: 返回所有信息default: 返回默认选择的信息

当不带参数直接调用 INFO 命令时,使用 default 作为默认参数。

#命令格式 : info [selection]

4.SHUTDOWN (停止客户端)

SHUTDOWN 命令执行以下操作:

- 停止所有客户端

- 如果有至少一个保存点在等待,执行 SAVE 命令

- 如果 AOF 选项被打开,更新 AOF 文件

- 关闭 redis 服务器(server)

如果持久化被打开的话, SHUTDOWN 命令会保证服务器正常关闭而不丢失任何数据。

另一方面,假如只是单纯地执行 SAVE 命令,然后再执行 QUIT 命令,则没有这一保证 —— 因为在执行 SAVE 之后、执行 QUIT 之前的这段时间中间,其他客户端可能正在和服务器进行通讯,这时如果执行 QUIT 就会造成数据丢失。

SAVE 和 NOSAVE 修饰符

通过使用可选的修饰符,可以修改 SHUTDOWN 命令的表现。比如说:

- 执行

SHUTDOWN SAVE会强制让数据库执行保存操作,即使没有设定(configure)保存点 - 执行

SHUTDOWN NOSAVE会阻止数据库执行保存操作,即使已经设定有一个或多个保存点(你可以将这一用法看作是强制停止服务器的一个假想的 ABORT 命令)

返回值:执行失败时返回错误。 执行成功时不返回任何信息,服务器和客户端的连接断开,客户端自动退出。

# 命令格式:SHUTDOWN [SAVE|NOSAVE]

5.TIME(返回当前服务器时间)

描述:返回当前服务器时间。一个包含两个字符串的列表: 第一个字符串是当前时间(以 UNIX 时间戳格式表示),而第二个字符串是当前这一秒钟已经逝去的微秒数。

# 命令格式: TIME

6.CLIENT GETNAME(返回当前连接的名称)

描述:返回 CLIENT SETNAME 命令为连接设置的名字。

因为新创建的连接默认是没有名字的, 对于没有名字的连接, CLIENT GETNAME 返回空白回复。

返回值 : 如果连接没有设置名字,那么返回空白回复; 如果有设置名字,那么返回名字。

# 命令格式:CLIENT GETNAME

7.CLIENT KILL(关闭指定客户端连接)

描述:关闭地址为 ip:port 的客户端。

ip:port 应该和 CLIENT LIST 命令输出的其中一行匹配。

因为 Redis 使用单线程设计,所以当 Redis 正在执行命令的时候,不会有客户端被断开连接。

如果要被断开连接的客户端正在执行命令,那么当这个命令执行之后,在发送下一个命令的时候,它就会收到一个网络错误,告知它自身的连接已被关闭。

# 命令格式:CLIENT KILL ip:port

8.CLIENT LIST(返回所有服务器连接到客户端的信息)

描述:以人类可读的格式,返回所有连接到服务器的客户端信息和统计数据。

返回值:

命令返回多行字符串,这些字符串按以下形式被格式化:

- 每个已连接客户端对应一行(以

LF分割) - 每行字符串由一系列

属性=值形式的域组成,每个域之间以空格分开

以下是域的含义:

addr: 客户端的地址和端口fd: 套接字所使用的文件描述符age: 以秒计算的已连接时长idle: 以秒计算的空闲时长flags: 客户端 flag (见下文)db: 该客户端正在使用的数据库 IDsub: 已订阅频道的数量psub: 已订阅模式的数量multi: 在事务中被执行的命令数量qbuf: 查询缓冲区的长度(字节为单位,0表示没有分配查询缓冲区)qbuf-free: 查询缓冲区剩余空间的长度(字节为单位,0表示没有剩余空间)obl: 输出缓冲区的长度(字节为单位,0表示没有分配输出缓冲区)oll: 输出列表包含的对象数量(当输出缓冲区没有剩余空间时,命令回复会以字符串对象的形式被入队到这个队列里)omem: 输出缓冲区和输出列表占用的内存总量events: 文件描述符事件(见下文)cmd: 最近一次执行的命令

客户端 flag 可以由以下部分组成:

O: 客户端是 MONITOR 模式下的附属节点(slave)S: 客户端是一般模式下(normal)的附属节点M: 客户端是主节点(master)x: 客户端正在执行事务b: 客户端正在等待阻塞事件i: 客户端正在等待 VM I/O 操作(已废弃)d: 一个受监视(watched)的键已被修改,EXEC命令将失败c: 在将回复完整地写出之后,关闭链接u: 客户端未被阻塞(unblocked)A: 尽可能快地关闭连接N: 未设置任何 flag

文件描述符事件可以是:

r: 客户端套接字(在事件 loop 中)是可读的(readable)w: 客户端套接字(在事件 loop 中)是可写的(writeable)

# 命令格式:CLIENT LIST

9.CLIENT SETNAME (为当前连接分配一个名称)

描述:

以人类可读的格式,返回所有连接到服务器的客户端信息和统计数据。为当前连接分配一个名字。

这个名字会显示在 CLIENT LIST 命令的结果中, 用于识别当前正在与服务器进行连接的客户端。

举个例子, 在使用 Redis 构建队列(queue)时, 可以根据连接负责的任务(role), 为信息生产者(producer)和信息消费者(consumer)分别设置不同的名字。

名字使用 Redis 的字符串类型来保存, 最大可以占用 512 MB 。 另外, 为了避免和 CLIENT LIST 命令的输出格式发生冲突, 名字里不允许使用空格。

要移除一个连接的名字, 可以将连接的名字设为空字符串 “” 。

使用 CLIENT GETNAME 命令可以取出连接的名字。

新创建的连接默认是没有名字的。

设置成功时返回 OK 。

# 命令格式: CLIENT SETNAME connection-name

2.10 配置选项

1.CONFIG SET(动态调整redis服务器配置)

描述:

CONFIG SET 命令可以动态地调整 Redis 服务器的配置(configuration)而无须重启。

你可以使用它修改配置参数,或者改变 Redis 的持久化(Persistence)方式。

CONFIG SET 可以修改的配置参数可以使用命令 CONFIG GET * 来列出,所有被 CONFIG SET 修改的配置参数都会立即生效。

关于 CONFIG SET 命令的更多消息,请参见命令 CONFIG GET 的说明。

返回值:

当设置成功时返回 OK ,否则返回一个错误。

# 命令格式: CONFIG SET parameter value

2.CONFIG GET (获取redis服务器配置)

描述:

CONFIG GET 命令用于取得运行中的 Redis 服务器的配置参数(configuration parameters),在 Redis 2.4 版本中, 有部分参数没有办法用 CONFIG GET 访问,但是在最新的 Redis 2.6 版本中,所有配置参数都已经可以用 CONFIG GET 访问了。

CONFIG GET 接受单个参数 parameter 作为搜索关键字,查找所有匹配的配置参数,其中参数和值以“键-值对”(key-value pairs)的方式排列。

比如执行 CONFIG GET s* 命令,服务器就会返回所有以 s 开头的配置参数及参数的值:

# 命令格式:CONFIG GET parameter

3.CONFIG RESETSTAT(命令统计)

重置 INFO 命令中的某些统计数据,包括:

- Keyspace hits (键空间命中次数)

- Keyspace misses (键空间不命中次数)

- Number of commands processed (执行命令的次数)

- Number of connections received (连接服务器的次数)

- Number of expired keys (过期key的数量)

- Number of rejected connections (被拒绝的连接数量)

- Latest fork(2) time(最后执行 fork(2) 的时间)

- The

aof_delayed_fsynccounter(aof_delayed_fsync计数器的值)

# 命令格式:CONFIG RESETSTAT

4.CONFIG REWRITE(配置文件同步)

描述:

CONFIG REWRITE 命令对启动 Redis 服务器时所指定的 redis.conf 文件进行改写: 因为 CONFIG_SET 命令可以对服务器的当前配置进行修改, 而修改后的配置可能和 redis.conf 文件中所描述的配置不一样, CONFIG REWRITE 的作用就是通过尽可能少的修改, 将服务器当前所使用的配置记录到 redis.conf 文件中。

重写会以非常保守的方式进行:

- 原有

redis.conf文件的整体结构和注释会被尽可能地保留。 - 如果一个选项已经存在于原有

redis.conf文件中 , 那么对该选项的重写会在选项原本所在的位置(行号)上进行。 - 如果一个选项不存在于原有

redis.conf文件中, 并且该选项被设置为默认值, 那么重写程序不会将这个选项添加到重写后的redis.conf文件中。 - 如果一个选项不存在于原有

redis.conf文件中, 并且该选项被设置为非默认值, 那么这个选项将被添加到重写后的redis.conf文件的末尾。 - 未使用的行会被留白。 比如说, 如果你在原有

redis.conf文件上设置了数个关于save选项的参数, 但现在你将这些save参数的一个或全部都关闭了, 那么这些不再使用的参数原本所在的行就会变成空白的。

即使启动服务器时所指定的 redis.conf 文件已经不再存在, CONFIG REWRITE 命令也可以重新构建并生成出一个新的 redis.conf 文件。

另一方面, 如果启动服务器时没有载入 redis.conf 文件, 那么执行 CONFIG REWRITE 命令将引发一个错误。

原子性重写

对 redis.conf 文件的重写是原子性的, 并且是一致的: 如果重写出错或重写期间服务器崩溃, 那么重写失败, 原有 redis.conf 文件不会被修改。 如果重写成功, 那么 redis.conf 文件为重写后的新文件。

返回值

一个状态值:如果配置重写成功则返回 OK ,失败则返回一个错误。

代码示例

以下是执行 CONFIG REWRITE 前, 被载入到 Redis 服务器的 redis.conf 文件中关于 appendonly 选项的设置:

2.11 复制

1.SYNC(命令)

描述:用于复制功能(replication)的内部命令。

# 命令格式:SYNC

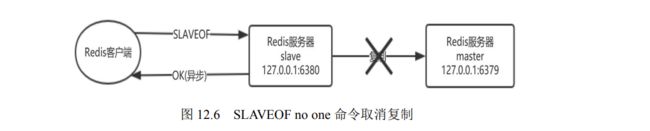

2.SLAVEOF(修改复制)

描述:SLAVEOF 命令用于在 Redis 运行时动态地修改复制(replication)功能的行为。

通过执行 SLAVEOF host port 命令,可以将当前服务器转变为指定服务器的从属服务器(slave server)。

如果当前服务器已经是某个主服务器(master server)的从属服务器,那么执行 SLAVEOF host port 将使当前服务器停止对旧主服务器的同步,丢弃旧数据集,转而开始对新主服务器进行同步。

另外,对一个从属服务器执行命令 SLAVEOF NO ONE 将使得这个从属服务器关闭复制功能,并从从属服务器转变回主服务器,原来同步所得的数据集不会被丢弃。

利用“SLAVEOF NO ONE 不会丢弃同步所得数据集”这个特性,可以在主服务器失败的时候,将从属服务器用作新的主服务器,从而实现无间断运行。

成功返回ok

# 命令格式:SLAVEOF

3.ROLE(查看主从角色)

描述:返回实例在复制中担任的角色, 这个角色可以是 master 、 slave 或者 sentinel 。 除了角色之外, 命令还会返回与该角色相关的其他信息, 其中:

- 主服务器将返回属下从服务器的 IP 地址和端口。

- 从服务器将返回自己正在复制的主服务器的 IP 地址、端口、连接状态以及复制偏移量。

- Sentinel 将返回自己正在监视的主服务器列表。

# 命令格式:ROLE

4.SYNC(用于复制功能)

描述:用于复制功能(replication)的内部命令。

# 命令格式:SYNC

5.PSYNC(用于复制功能)

描述:用于复制功能(replication)的内部命令。

# 命令格式:PSYNC master_run_id offset

2.12 调试

1.PING(测试连通性)

描述:使用客户端向 Redis 服务器发送一个 PING ,如果服务器运作正常的话,会返回一个 PONG 。

通常用于测试与服务器的连接是否仍然生效,或者用于测量延迟值。

# 命令格式:PING

2.ECHO (打印信息)

描述:打印一个特定的信息 message ,测试时使用。

# 命令格式:ECHO

3.SLOWLOG(查看日志)

描述:

什么是 SLOWLOG?

Slow log 是 Redis 用来记录查询执行时间的日志系统。

查询执行时间指的是不包括像客户端响应(talking)、发送回复等 IO 操作,而单单是执行一个查询命令所耗费的时间。

另外,slow log 保存在内存里面,读写速度非常快,因此你可以放心地使用它,不必担心因为开启 slow log 而损害 Redis 的速度。

设置 SLOWLOG

Slow log 的行为由两个配置参数(configuration parameter)指定,可以通过改写 redis.conf 文件或者用 CONFIG GET 和 CONFIG SET 命令对它们动态地进行修改。

第一个选项是 slowlog-log-slower-than ,它决定要对执行时间大于多少微秒(microsecond,1秒 = 1,000,000 微秒)的查询进行记录。

比如执行以下命令将让 slow log 记录所有查询时间大于等于 100 微秒的查询:

CONFIG SET slowlog-log-slower-than 100

而以下命令记录所有查询时间大于 1000 微秒的查询:

CONFIG SET slowlog-log-slower-than 1000

另一个选项是 slowlog-max-len ,它决定 slow log 最多能保存多少条日志, slow log 本身是一个 FIFO 队列,当队列大小超过 slowlog-max-len 时,最旧的一条日志将被删除,而最新的一条日志加入到 slow log ,以此类推。

以下命令让 slow log 最多保存 1000 条日志:

CONFIG SET slowlog-max-len 1000

使用 CONFIG GET 命令可以查询两个选项的当前值:

查看 slow log

要查看 slow log ,可以使用 SLOWLOG GET 或者 SLOWLOG GET number 命令,前者打印所有 slow log ,最大长度取决于 slowlog-max-len 选项的值,而 SLOWLOG GET number 则只打印指定数量的日志。

日志的唯一 id 只有在 Redis 服务器重启的时候才会重置,这样可以避免对日志的重复处理(比如你可能会想在每次发现新的慢查询时发邮件通知你)。

查看当前日志的数量

使用命令 SLOWLOG LEN 可以查看当前日志的数量。

请注意这个值和 slower-max-len 的区别,它们一个是当前日志的数量,一个是允许记录的最大日志的数量。

清空日志

使用命令 SLOWLOG RESET 可以清空 slow log 。

# 命令格式:SLOWLOG subcommand [argument]

4.MONITOR(实时打印接收命令)

描述:实时打印出 Redis 服务器接收到的命令,调试用。

# 命令格式: MONITOR

5.DEBUG SEGFAULT(让 Redis 崩溃)

描述:执行一个不合法的内存访问从而让 Redis 崩溃,仅在开发时用于 BUG 模拟。

# 命令格式: DEBUG SEGFAULT

5.DEBUG OBJECT(查看key相关信息)

描述:当 key 存在时,返回有关信息。 当 key 不存在时,返回一个错误。

# 命令格式:DEBUG OBJECT key

3.redis五种数据类型

-

String(字符串)

- string是redis最基本的类型,你可以理解成与Memcached一模一样的类型,一个key对应一个value。

- string类型是二进制安全的。意思是redis的string可以包含任何数据。比如jpg图片或者序列化的对象 。

- string类型是Redis最基本的数据类型,一个redis中字符串value最多可以是512M

-

Hash(哈希,类似java里的Map)

- Redis hash 是一个键值对集合。

- Redis hash是一个string类型的field和value的映射表,hash特别适合用于存储对象。

- 类似Java里面的Map

-

List(列表)

- Redis 列表是简单的字符串列表,按照插入顺序排序。你可以添加一个元素导列表的头部(左边)或者尾部(右边)。

- 它的底层实际是个链表

-

Set(集合)

- Redis的Set是string类型的无序集合。它是通过HashTable实现实现的

- Zset(sorted set:有序集合)

- Redis zset 和 set 一样也是string类型元素的集合,且不允许重复的成员。

- 不同的是每个元素都会关联一个double类型的分数。

- redis正是通过分数来为集合中的成员进行从小到大的排序。zset的成员是唯一的,但分数(score)却可以重复。

-

Sorted Set

- Redis的Sorted Set是string类型的有序集合。但是原生可以重复

- 每个元素对应一个double类型的分数,redis就是通过这个对应的分数来进行从小到大排序的

- 有序集合采用hash表实现,增加,删除,查询,效率特别高,复杂度为o(1)

- 能存储的最大元素个数是 2^32-1个元素

3.1 String 类型

字符串是redis中最基本的数据类型,他是二进制安全的任何形式的字符串都可以存储,包括二进制数据,序列化后的数据,JSON对象,甚至是一张base64编码后的图片,String类型的键最大能存储512KB的数据。string类型的数据也是开发中使用频率最高的,我们来看下基础的一些操作。

| 命令 | 描述 |

|---|---|

| SET key value [EX seconds|PX milliseconds] [NX|XX] [KEEPTTL] | 设置指定key的value 。EX:设置key的过期时间为多少秒,PX:设置key的过期时间为多少毫秒,NX:当key不存在时,才对key进行操作,XX当key存在时才对其进行操作 |

| GET key | 获取指定key的value |

| append key value | 往指定key中添加字符串 |

| MGET key1 [key2…] | 获取所有(一个或多个)给定 key 的值,这个命令是原子性的,所有的key都会在同一时间内更新 |

| SETNX key value | 只有在 key 不存在时设置 key 的值 |

| STRLEN key | 返回 key 所储存的字符串值的长度 |

| APPEND key value | 如果 key 已经存在并且是一个字符串, APPEND 命令将指定的 value 追加到该 key 原来值(value)的末尾 |

| DECRBY key decrement | key 所储存的值减去给定的减量值(decrement) |

| INCRBY key increment | 将 key 所储存的值加上给定的增量值(increment) |

| DECR key | 将 key 中储存的数字值减一 |

| INCR key | 将 key 中储存的数字值增一 |

| INCRBY key increment | 将key存储的value增量increment,如果key不存在,被初始化为0,INCRBY操作的值在64位(bit)的有符号表示范围内 |

| INCRBYFLOAT key increment | 将 key 所储存的值加上给定的浮点增量值(increment) |

| DECRFLOAT key | 将 key 所储存的值减去给定的浮点减量值(increment) |

| MSETNX key value [key value …] | 同时设置一个或多个 key-value 对,当且仅当所有给定 key 都不存在 |

| GETRANGE key start end | 获取键的子字符串值,start从0开始,end取负值的时候,-1表示最后一个字符串,-2表示倒数第二个字符串 |

| SETRANGE key offset value | 从指定的位置(offset)开始,将key值替换为新的字符串 |

| SETBIT key offset value | 指定所存储的字符串值设置或清除指定偏移量上的位,value为 1 或 0,offset设置的值必须大于或等于0,如果其他位没有设置。默认填充为0,大小限制为 512MB,offset的范围是 2^32 |

| GETBIT key offset | 获取键的偏移量值 |

| BITCOUNT key [start end] | 统计位图中位为1的数量,start表示起始位置,end表示结束位置,如果没有指定start和end,那么表示统计整个bit标志位为1的数量 |

| SETEX key seconds value | setex是一个原子性的命令,他设置value和设置生存时间是在同一时间完成的。seconds:秒 |

| PSETEX key milliseconds value | 设置键值对的同时,指定过期时间。milliseconds:毫秒 |

| GETSET key value | 为指定建设置新的value,并且返回原来的value |

| BITOP operation destkey key [key …] | 对一个保存二进制位的字符串进行位运算,operation可以是:AND(求逻辑并),OR(求逻辑或),NOT(求逻辑非),XOR(求逻辑异或),计算完毕后将结果保存到destkey中,返回保存到destkey中的字符串长度 |

3.2 HASH 类型

redis类型的hash是一个string类型的域和值映射表,hash类型常常用于存储对象类型的数据每个hash表可以存储2^32-1个键值对,也就是40多亿的一个数据。

| 命令 | 描述 |

|---|---|

| HSET key field value [field value …] | 使用HEST命令将哈希表key中的filed的值设置为value,当这个key不存在时,将会创建一个新的hash表进行HSET操作,如果key已经存在,那么就进行覆盖 |

| HGET key field | 获取哈希表key中的filed值 |

| HSETNX key field value | 使用HSETNX命令相当于filed不存在时,会将哈希表中filed的值设置为value,如果已经存在,那么这个命令无效。 |

| HGETALL key | 获取hash表中所有的filed和值,此时哈希表返回的长度是哈希表长度的两倍,如果这个key不存在,返回空列表 |

| HMGET key field [field …] | 获取指定哈希表的多个字段值,如果key不存在将会当做空哈希表返回nil,如果指定filed不存在,也会返回nil |

| HKEYS key | 获取指定hash表的所有filed |

| HVALS key | 获取哈希表中所有的value |

| HLEN key | 统计哈希表中所有的filed数量 |

| HSTRLEN key field | 统计哈希表中某个filed的字符串长度 |

| HINCRBY key field increment | 为哈希表中的filed增减一个increment值,increment可以是一个负整数,也可以是一个正整数,负数代表减,正数代表增加,如果key不存在创建一个新的哈希表,如果filed不存在,新建一个filed,并且初始化为0,继续执行HINCRBY操作,返回执行完HINCRBY的值 |

| HINCRBYFLOAT key field increment | 为哈希表中的filed增减一个increment值,increment可以是一个负浮点数,也可以是一个正浮点数,负浮点数代表减,正浮点数代表增加,如果key不存在创建一个新的哈希表,如果filed不存在,新建一个filed,并且初始化为0,继续执行HINCRBY操作,返回执行完HINCRBY的值 |

| HDEL key field [field …] | 删除哈希表中的filed,可以指定多个filed进行同时删除 |

| HEXISTS key field | 检测哈希表中是否有这个filed,有的话返回1,没有的话返回0 |

3.3 list 数据类型

redis的list可以看成一个简单的字符串列表,按照插入顺序进行排序,添加的时候可以从头部添加或尾部添加,也可以看成是一个简单的队列,一个列表大约可以存放2^32-1个元素。

| 命令 | 描述 |

|---|---|

| LPUSH key element [element …] | 将多个value按照顺序插入到列表头部,如果key不存在,则创建一个新的列表然后进行插入 |

| RPUSH key element [element …] | 将多个value按照顺序插入到列表尾部,如果key不存在,则创建一个新的列表然后进行插入 |

| LINSERT key BEFORE|AFTER pivot element | 向列表中插入一个值,可以是在pivot之前或之后,key不存在时,列表无效 |

| LPUSHX key element [element …] | 将一个value插入到列表头部,此时key必须存在 |

| RPUSHX key element [element …] | 将一个value插入到列表尾部部,此时key必须存在 |

| LSET key index element | 修改列表指定索引位置的元素,索引从0开始,如果key为空则返回错误 |

| LLEN key | 统计列表的长度 |

| LINDEX key index | 获取指定列表索引位置的元素,ndex为0表示第一个元素,index为-1表示最后一个元素。为-2表示倒数第二个 |

| LRANGE key start stop | 获取指定列表范围内的元素,start为0表示第一个元素,stop为-1表示最后一个元素。为-2表示倒数第二个 |

| LPOP key | 返回并删除列表头部元素 |

| RPOP key | 返回并删除列表尾部元素 |

| BRPOP key [key …] timeout | 在指定时间内删除列表的尾部元素,时间单位为秒,当这个列表内没有可删除的元素时,该命令会阻塞,一直等到有可删除的元素为止 |

| BLPOP key [key …] timeout | 在指定时间内删除列表的头部元素,时间单位为秒,当这个列表内没有可删除的元素时,该命令会阻塞,一直等到有可删除的元素为止 |

| LREM key count value | 根据count参数删除列表中与指定value相等的元素,如果count=0:删除列表中所有与指定value相同的元素,count>0:从列表头部开始搜索删除列表中所有与指定value相同的元素,count<0:从列表尾部开始搜索删除列表中所有与指定value相同的元素 |

| LTRIM key start stop | 表示对一个列表进行修剪,比如去掉不必要的空格,让列表key值保留指定区间内的元素,不在这个区间内的元素会被删除,start和stop的值超出列表长度位置不会出现错误,如果参数strt比stop大,那么将会清空整个列表,如果stop比整个列表的值还大,那么redis会将这个stop作为这个列表的最大下标值 |

| RPOPLPUSH source destination | 将元素移动到另外一个列中,这个操作是原子性的,会将source中的最后一个元素作为返回值,这个被返回的元素会被插入到destination的头部,当source不存在的时候,将会返回一个nil值,同时后面的操作不执行,如果source和destination是同一个列表,那么列表尾元素将会移动到头部,并且返回该元素,这就是列表的旋转操作 |

| BRPOPLPUSH source destination timeout | 将元素移动到另外一个列中,timeout单位为秒,如果设置为0表示阻塞时间可以无限延长,如果在指定时间内没有任何元素被弹出,则返回nil和等待时长,如果返回的是一个列表,那么列表中的第一个元素是被弹出元素的值,第二个元素是等待时长 |

队列安全:

有时候list经常被看成一个队列来使用,用于在不同程序中进行传输消息,一个客户端通过LPUSH的命令将消息放到列表中,然后另外一个程序通过RPOP或BRPOP命令将元素取出使用,但是这个会容易出现消息丢失的情况,消息被一个客户端取走,但是他未能正确的处理掉这条消息,然后就宕机了,此时消息已经被消费掉,这个消息就丢失掉了。我们可以使用RPOPLPUSH 命令来解决,可以把元素放到一个备份列表,当取出的客户端正常处理完流程,我们在备份列表中删除就可以了,这样就可以避免消息丢失的情况。

循环列表:

我们可以使用RPOPLPUSH 实现循环链表,使用相同的key作为RPOPLPUSH 的参数,客户端采用逐个获取元素列表的方式,取出队列中的元素,这样就避免掉了使用LRANGE命令那样取出列表中所有的元素,当有多哥客户端对同一个列表进行旋转操作来获取不同的元素,直到所有的元素被取完,这个循环列表可以正常工作,还有客户端向列表尾部添加新元素时,这个列表也能正常工作。

基于以上的两种操作,我们可以借助redis服务监控系统,在事项短时间内不断处理一些消息。

3.4 set 数据类型

redis的数据类型集合set是string类型的无需集合。集合中的元素无序且不重复,每个元素都是唯一的,集合通过hash表来实现的,所以使用集合进行增加,删除,查询操作的效率都是特别高的,复杂度为O(1),一个集合能存储的最大数据容量为 2^32-1个元素。

| 命令 | 描述 |

|---|---|

| SADD key member [member …] | 将一个或多个元素添加到这个集合中,如果这个集合中已经存在这个元素,那么这个元素将会被忽略掉,如果key集合不存在,那么就创建一个集合,这个集合只包含这里设置menber元素 |

| SMOVE source destination member | 移动集合元素到另一个集合中,静集合source红的member元素移动到destination中,如果集合source不存在,或者source集合中不存在member元素,则smove命令不会生效,将返回0。如果destination集合中已经包含member元素,那么只会删除掉source中的member,并不会去移动,如果移动成功返回1,移动失败返回0 |

| SUNIONSTORE destination key [key …] | 将多个集合保存到另一个集合中,最终是取这些多个集合的交集然后存储到destination集合中,如果存储成功,返回destination的长度 |

| SISMEMBER key member | 判断某个元素是否存储在集合中,如果存在,则返回1,不存在返回0 |

| SCARD key | 获取集合中元素的数量 |

| SMEMBERS key | 获取集合中所有的元素 |

| SRANDMEMBER key [count] | 随机返回集合中的元素,如果不指定count,那么随机返回集合中的一个元素,如果指定的是一个正整数并且小于集合的基数,则返回一个列表,如果指定的是一个负整数,返回的元素可能是一个重复多次的数组,这个数组的长度是count的绝对值 |

| SUNION key [key …] | 获取多个集合中的元素,返回的是所有key集合的并集,如果集合key不存在当做空集进行处理 |

| SDIFF key [key …] | 获取多个集合的并集,该集合是给定集合之间的差集,集合key不存在就视为是空集合 |

| SDIFFSTORE destination key [key …] | 获取多个集合差集的元素个数,将获取到的元素保存到destination中,这个集合是给定的多个集合key元素的差集,如果集合destination已经存在,则会被新的集合覆盖,如果给定key集合是一个不是多个,那么这个destination集合就是给定的集合key本身 |

| SINTER key [key …] | 获取多个集合元素的交集,如果给定的多个指定集合key中有一个是空集合,那么执行该命令的结果就是一个空集合 |

| SINTERSTORE destination key [key …] | 获取多个集合交集的元素个数,获取给定的集合key的所有元素,保存到destination中,如果destination已经存在则会被覆盖掉,执行完毕后返回destination中的成员数量 |

| SPOP key [count] | 随机删除集合中的一个或多个元素,如果是一个空集合返回nil |

| SREM key member[ member …] | 删除集合key中的一个或多个元素,该命令在执行过程中,会忽略掉不存在的member元素,如果key不是集合类型,则返回错误信息 |

3.5 sorted set 数据类型

redis的数据类型有序集合 sorte也是string类型的集合,有序集合中不存在重复的元素,每个解中的每个元素都对应一个double的分数,redis就是通过这个元素对应的分数来进行大到小的排序,集合中的元素是唯一的,但是元素的分数不是唯一的,可以重复。

有序几个采用hash表事项,当面对增加,删除,查询,操作的时候。时间复杂度为O(1)有序集合所能存储的元素最大个数是 2^32-1个。

| 命令 | 描述/ |

|---|---|

| ZADD key [NX|XX] [CH] [INCR] score member [score member …] | 将一个或读个元素添加到集合中,如果集合中已经存在某个member。那么只需要更新改member的score值,然后重新插入member,以此来确保member元素在正确的位置上。socre可以是一个整数也可以是一个浮点数,添加完毕后返回添加成功的元素数量 |

| ZINCRBY key increment member | 给指定key集合的member元素增加increment分数,increment如果是正数那么就加上对应的分数,如果是负数就减去对应的分数,如果指定的key不存在,则该命令等价于ZADD key increment member |

| ZCARD key | 获取指定key集合中元素的个数,当key不存在时返回0 |

| ZCOUNT key min max | 获取score值在 min-max直接的元素(默认包含score等于min或max) |

| ZLEXCOUNT key min max | 获取指定key集合 source在 min-max之间的元素数量,其中(:表示开区间,[表示闭区间 |

| ZRANGE key start stop [WITHSCORES] | 获取指定区间内的元素(升序),返回的元素按照score从小到大进行排列,start 从0开始,stop -1表示最后一个元素,-2表示倒数第二个元素,超出集合下标范围内集合不会出现错误,当start的值大于stop的值的时候,什么也不做,返回一个空集合,如果stop大于集合的最大下标时,redis会将这个值作为集合的新下标,可以使用WITHSCORES来选择是否返回对应的分数 |

| ZREVRANGE key start stop [WITHSCORES] | 反会指定key集合中区间内的元素,返回的元素按照score从大到小进行排列,start 从0开始,stop -1表示最后一个元素,-2表示倒数第二个元素,超出集合下标范围内集合不会出现错误,当start的值大于stop的值的时候,什么也不做,返回一个空集合,如果stop大于集合的最大下标时,redis会将这个值作为集合的新下标,可以使用WITHSCORES来选择是否返回对应的分数 |

| ZSCORE key member | 获取集合中指定member的score,如果集合中的member不存在则返回nil |

| ZRANGEBYLEX key min max [LIMIT offset count] | 返回指定key集合中score在min-max之间的元素,1.分数必须相同! 如果有序集合中的成员分数有不一致的,返回的结果就不准。 2.成员字符串作为二进制数组的字节数进行比较。 3.默认是以ASCII字符集的顺序进行排列。如果成员字符串包含utf-8这类字符集(比如:汉字)的内容,就会影响返回结果,所以建议不要使用。 4.默认情况下, “max” 和 “min” 参数前必须加 “[” 符号作为开头。”[” 符号与成员之间不能有空格, 返回成员结果集会包含参数 “min” 和 “max” 。 5.“max” 和 “min” 参数前可以加 “(” 符号作为开头表示小于, “(” 符号与成员之间不能有空格。返回成员结果集不会包含 “max” 和 “min” 成员。 可以使用 “-” 和 “+” 表示得分最小值和最大值 |

| ZRANGEBYSCORE key min max [WITHSCORES] [LIMIT offset count] | 返回指定key集合中score在min-max之间的元素,集合中的元素按照score值从小到大进行排序,当你不知道min和max的具体参数时,可以使用 -inf表示最小值,+inf表示最大值,也可以在参数前面加上 ( 表示开区间,(默认是闭区间),当具有相同score的元素时,有序集合元素会按照字典进行排序,可以添加参数 WITHSCORES来表示需要返回分数 |

| ZRANK key member | 获取集合key中member的排名,集合会按照从小到大进行排序,score最小的元素排名为0 |

| ZREVRANK key member | 获取集合key中member的排名,集合会按照从大到小进行排序,score最大的元素排名为0 |

| ZINTERSTORE destination numkeys key [key …] [WEIGHTS weight] [AGGREGATE SUM|MIN|MAX] | 用于计算给定一个key或多个key的交集,其中给定key的数量必须和numkeys相等,在默认情况下交集结果的某个元素的score的值是给定所有集合中的该元素的score值之和,计算结果为destination集合中元素的数量 |

| ZUNIONSTORE destination numkeys key [key …] [WEIGHTS weight] [AGGREGATE SUM|MIN|MAX] | 用于计算给定一个key或多个key的并集,其中给定key的数量必须和numkeys相等,在默认情况下交集结果的某个元素的score的值是给定所有集合中的该元素的score值之和,计算结果为destination集合中元素的数量。使用WEIGHTS可以给所有的集合指定一个乘数,每个集合的所有元素的score在攒底给聚合函数的时候,都会乘以这个数(weight),如果没有指定,默认为1。AGGREGATE的选项:SUM:将所有有序集合中某个元素的score值作为结果集中该元素的score,MIN:这种聚合方式可以将所有集合中某个元素的最小score值作为结果集中该元素的score,MAX:这种聚合方式可以将所有集合中某个元素的最大score值作为结果集中该元素的score |

| ZREM key member [member …] | 删除有序集合中的多个元素,返回删除成功的元素数量 |

| ZREMRANGEBYLEX key min max | 删除集合中 score的值介于 min-max之间score值相同的元素 |

| ZREMRANGEBYRANK key start stop | 删除有序集合在指定排名区间内的元素,start表示开始排名。stop表示结束排名,其中包含start和stop |

| ZREMRANGEBYSCORE key min max | 删除有序集合key中,所有score值介于min到max之间的元素(包含min和max),返回被删除的元素数量 |

4.redis数据库

4.1 redis数据库的切换

redis数据库保存在redis服务器状态server.sh/redosServer结构db数组中,这个数组中的每个元素都是一个server.sh/redosServer结构,而每个redisDb结构就代表一个数据库。

Redis服务器状态有一个dbnum属性,该属性用于在启动redis服务器时,决定创建多少个数据库。redis服务器的database选项决定了dbnum属性的值,在默认的情况下,dbnum的值为16,也就是redis在启动redis服务器的时候,会创建(0-15)个数据库,我们可以通过select index 的方式来进行选择操作具体的某个数据库,index的取值范围默认是(0-15)

在redis服务器内部,有一个db属性,这个属性是客户端状态redisClient中的属性,他是一个执行redisDb结构的指针,用于记录当前客户端操作的目标数据库,redisClient.db指针指向redisServer.db数组中的某个元素,增被指向的元素就是客户端的目标数据库,我们在启动redis服务器与客户端时,默认的目标数据库是0号,这个客户端指向的也是0号数据库。

4.2 redis删除策略

4.2.1 定期删除策略

概念:在设置键的过期时间的同时,创建一个定时器,让定时器在键的过期时间来临时,立即执行对键的删除操作。(创建定时器删除)

优点:

- 对内存最友好:通过使用定时器,可以保证过期的键会尽可能快地被删除,释放所占内存

缺点:

- 对cpu最不友好:在过期键比较多的情况下,删除过期键这一行为可能会占用相当一部分cpu的时间,对服务器的响应时间和吞吐量造成影响。

4.2.2 惰性删除策略

概念:放任键的过期不管,但是每次从键空间中获取键时,都检查取得的键是否过期,如果过期的话,就删除该键;如果没有过期,就返回该键。(使用的时候删除)

优点:

- 对cpu最友好:只有在取出键的时候才会对过期键进行检查,即不需要cpu定期扫描,也不需要创建大量的定时器。

缺点:

- 对内存最不友好:如果一个键已经过期,但是后面不会被访问到的话,那么就一直保留在数据库中。如果这样的键过多,无疑会占用很大的内存。

4.2.3 定期删除策略

概念:每隔一段时间,程序就对数据库进行一次检查,删除里面过期的键。至于要删除多少过期键,以及要检查多少个数据库,则有算法决定。(定期扫描删除)

优点:

- 定期删除每隔一段时间执行一次过期键操作,并通过限制删除操作执行的时长和频率来减少删除操作对cpu时间的影响;

- 通过删除过期键,能有效的减少因为过期键而带来的内存浪费

缺点:难以确定删除操作执行的时长和频率

- 如果删除操作执行得太频繁,或者执行的时间太长,定期删除策略就会退化成定时删除,以至于占用太多cpu的执行时间;

- 如果删除操作执行的时间太少,或执行时间太短,定期删除策略又会和惰性删除一样,出现内存浪费。

4.2.4 Redis过期删除策略

redis实际使用的过期键删除策略是定期删除策略和惰性删除策略:

redis 会将每个设置了过期时间的 key 放入到一个独立的字典中,以后会定时遍历这个字典来删除到期的 key。除了定时遍历之外,它还会使用惰性策略来删除过期的 key,所谓惰性策略就是在客户端访问这个 key 的时候,redis 对 key 的过期时间进行检查,如果过期了就立即删除。定时删除是集中处理,惰性删除是零散处理。

通过配合使用这两种删除策略,服务器可以很好地合理使用cpu时间和避免浪费内存空间之间取得平衡。

4.2.4.1 定期删除

Redis 默认会每秒进行十次过期扫描,过期扫描不会遍历过期字典中所有的 key,而是采用了一种简单的贪心策略。

- 从过期字典中随机 20 个 key;

- 删除这 20 个 key 中已经过期的 key;

- 如果过期的 key 比率超过 1/4,那就重复步骤 1;

同时,为了保证过期扫描不会出现循环过度,导致线程卡死现象,算法还增加了扫描时间的上限,默认不会超过 25ms。

如果某一时刻,有大量key同时过期,Redis 会持续扫描过期字典,造成客户端响应卡顿,因此设置过期时间时,就尽量避免这个问题,在设置过期时间时,可以给过期时间设置一个随机范围,避免同一时刻过期。

a. 如何配置定期删除执行时间间隔

redis的定时任务默认是每秒执行10次,如果要修改这个值,可以在redis.conf中修改hz的值。

redis.conf中,hz默认设为10,提高它的值将会占用更多的cpu,当然相应的redis将会更快的处理同时到期的许多key,以及更精确的去处理超时。 hz的取值范围是1~500,通常不建议超过100,只有在请求延时非常低的情况下可以将值提升到100。

b. 单线程的redis,如何知道要运行定时任务?

redis是单线程的,线程不但要处理定时任务,还要处理客户端请求,线程不能阻塞在定时任务或处理客户端请求上,那么,redis是如何知道何时该运行定时任务的呢?

Redis 的定时任务会记录在一个称为最小堆的数据结构中。这个堆中,最快要执行的任务排在堆的最上方。在每个循环周期,Redis 都会将最小堆里面已经到点的任务立即进行处理。处理完毕后,将最快要执行的任务还需要的时间记录下来,这个时间就是接下来处理客户端请求的最大时长,若达到了该时长,则暂时不处理客户端请求而去运行定时任务。

4.2.4.2 懒惰删除

过期键的惰性删除删除策略由db.c/expireIfNeeded函数实现,所有读写数据库的Redis命令在执行之前都会调用expireIfNeed函数对输入键进行检查:

- 如果键已经过期,那么expireIfNeeded函数将键删除

- 如果键未过期,那么expireIfNeeded函数不做操作

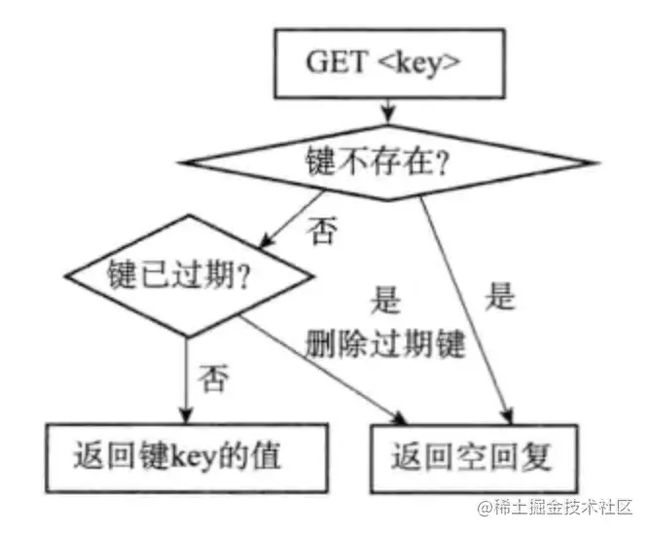

命令调用expireIfNeeded函数过程如下图

另外因为每个被访问的键都可能被删除,所以每个命令都必须能同时处理键存在以及不存在的情况。 下图表示get命令的执行过程

4.2.4.3 aof/rdb和复制功能对过期键的处理

rdb

- 生成rdb文件:生成时,程序会对键进行检查,过期键不放入rdb文件。

- 载入rdb文件:载入时,如果以主服务器模式运行,程序会对文件中保存的键进行检查,未过期的键会被载入到数据库中,而过期键则会忽略;如果以从服务器模式运行,无论键过期与否,均会载入数据库中,过期键会通过与主服务器同步而删除。

aof

- 当服务器以aof持久化模式运行时,如果数据库中的某个键已经过期,但它还没有被删除,那么aof文件不会因为这个过期键而产生任何影响;当过期键被删除后,程序会向aof文件追加一条del命令来显式记录该键已被删除。

- aof重写过程中,程序会对数据库中的键进行检查,已过期的键不会被保存到重写后的aof文件中。

复制

当服务器运行在复制模式下时,从服务器的过期删除动作由主服务器控制:

- 主服务器在删除一个过期键后,会显式地向所有从服务器发送一个del命令,告知从服务器删除这个过期键;

- 从服务器在执行客户端发送的读命令时,即使碰到过期键也不会将过期键删除,而是继续像处理未过期的键一样来处理过期键;

- 从服务器只有在接到主服务器发来的del命令后,才会删除过期键。

4.3 redis数据库通知

1.事件描述

键空间通知使得客户端可以通过订阅频道或模式, 来接收那些以某种方式改动了 Redis 数据集的事件。

以下是一些键空间通知发送的事件的例子:

- 所有修改键的命令。

- 所有接收到 [LPUSH key value value …] 命令的键。

0号数据库中所有已过期的键。

事件通过 Redis 的订阅与发布功能(pub/sub)来进行分发, 因此所有支持订阅与发布功能的客户端都可以在无须做任何修改的情况下, 直接使用键空间通知功能。

因为 Redis 目前的订阅与发布功能采取的是发送即忘(fire and forget)策略, 所以如果你的程序需要可靠事件通知(reliable notification of events), 那么目前的键空间通知可能并不适合你: 当订阅事件的客户端断线时, 它会丢失所有在断线期间分发给它的事件。

未来将会支持更可靠的事件分发, 这种支持可能会通过让订阅与发布功能本身变得更可靠来实现, 也可能会在 Lua 脚本中对消息(message)的订阅与发布进行监听, 从而实现类似将事件推入到列表这样的操作。

2.事件的类型

对于每个修改数据库的操作,键空间通知都会发送两种不同类型的事件。分别是键空间通知和键事件通知。

比如说,对 0 号数据库的键 mykey 执行 [DEL key key …] 命令时, 系统将分发两条消息, 相当于执行以下两个 PUBLISH channel message 命令:

PUBLISH __keyspace@0__:mykey del

PUBLISH __keyevent@0__:del mykey

订阅第一个频道 __keyspace@0__:mykey 可以接收 0 号数据库中所有修改键 mykey 的事件, 而订阅第二个频道 __keyevent@0__:del 则可以接收 0 号数据库中所有执行 del 命令的键。

以 keyspace 为前缀的频道被称为键空间通知(key-space notification), 而以 keyevent 为前缀的频道则被称为键事件通知(key-event notification)。

当 del mykey 命令执行时:

- 键空间频道的订阅者将接收到被执行的事件的名字,在这个例子中,就是

del。 - 键事件频道的订阅者将接收到被执行事件的键的名字,在这个例子中,就是

mykey。

3.配置

因为开启键空间通知功能需要消耗一些 CPU , 所以在默认配置下, 该功能处于关闭状态。

可以通过修改 redis.conf 文件, 或者直接使用 CONFIG SET 命令来开启或关闭键空间通知功能:

- 当

notify-keyspace-events选项的参数为空字符串时,功能关闭。 - 另一方面,当参数不是空字符串时,功能开启。

notify-keyspace-events 的参数可以是以下字符的任意组合, 它指定了服务器该发送哪些类型的通知:

| 字符 | 发送的通知 |

|---|---|

K |

键空间通知,所有通知以 __keyspace@ 为前缀 |

E |

键事件通知,所有通知以 __keyevent@ 为前缀 |

g |

DEL 、 EXPIRE 、 RENAME 等类型无关的通用命令的通知 |

$ |

字符串命令的通知 |

l |

列表命令的通知 |

s |

集合命令的通知 |

h |

哈希命令的通知 |

z |

有序集合命令的通知 |

x |

过期事件:每当有过期键被删除时发送 |

e |

驱逐(evict)事件:每当有键因为 maxmemory 政策而被删除时发送 |

A |

参数 g$lshzxe 的别名 |

输入的参数中至少要有一个 K 或者 E , 否则的话, 不管其余的参数是什么, 都不会有任何通知被分发。

举个例子, 如果只想订阅键空间中和列表相关的通知, 那么参数就应该设为 Kl , 诸如此类。

将参数设为字符串 "AKE" 表示发送所有类型的通知。

4.命令产生的通知

以下列表记录了不同命令所产生的不同通知:

- [DEL key key …] 命令为每个被删除的键产生一个

del通知。 - RENAME key newkey 产生两个通知:为来源键(source key)产生一个

rename_from通知,并为目标键(destination key)产生一个rename_to通知。 - EXPIRE key seconds 和 EXPIREAT key timestamp 在键被正确设置过期时间时产生一个

expire通知。当 EXPIREAT key timestamp 设置的时间已经过期,或者 EXPIRE key seconds 传入的时间为负数值时,键被删除,并产生一个del通知。 - [SORT key BY pattern] [LIMIT offset count] [GET pattern [GET pattern …]] [ASC | DESC] [ALPHA] [STORE destination] 在命令带有

STORE参数时产生一个sortstore事件。如果STORE指示的用于保存排序结果的键已经存在,那么程序还会发送一个del事件。 - [SET key value EX seconds] [PX milliseconds] [NX|XX] 以及它的所有变种(SETEX key seconds value 、 SETNX key value 和 GETSET key value)都产生

set通知。其中 SETEX key seconds value 还会产生expire通知。 - [MSET key value key value …] 为每个键产生一个

set通知。 - SETRANGE key offset value 产生一个

setrange通知。 - INCR key 、 DECR key 、 INCRBY key increment 和 DECRBY key decrement 都产生

incrby通知。 - INCRBYFLOAT key increment 产生

incrbyfloat通知。 - APPEND key value 产生

append通知。 - [LPUSH key value value …] 和 LPUSHX key value 都产生单个

lpush通知,即使有多个输入元素时,也是如此。 - [RPUSH key value value …] 和 RPUSHX key value 都产生单个

rpush通知,即使有多个输入元素时,也是如此。 - RPOP key 产生

rpop通知。如果被弹出的元素是列表的最后一个元素,那么还会产生一个del通知。 - LPOP key 产生

lpop通知。如果被弹出的元素是列表的最后一个元素,那么还会产生一个del通知。 - LINSERT key BEFORE|AFTER pivot value 产生一个

linsert通知。 - LSET key index value 产生一个

lset通知。 - LTRIM key start stop 产生一个

ltrim通知。如果 LTRIM key start stop 执行之后,列表键被清空,那么还会产生一个del通知。 - RPOPLPUSH source destination 和 BRPOPLPUSH source destination timeout 产生一个

rpop通知,以及一个lpush通知。两个命令都会保证rpop的通知在lpush的通知之前分发。如果从键弹出元素之后,被弹出的列表键被清空,那么还会产生一个del通知。 - HSET hash field value 、 HSETNX hash field value 和 HMSET 都只产生一个

hset通知。 - HINCRBY 产生一个

hincrby通知。 - HINCRBYFLOAT 产生一个

hincrbyfloat通知。 - HDEL 产生一个

hdel通知。如果执行 HDEL 之后,哈希键被清空,那么还会产生一个del通知。 - [SADD key member member …] 产生一个

sadd通知,即使有多个输入元素时,也是如此。 - [SREM key member member …] 产生一个

srem通知,如果执行 [SREM key member member …] 之后,集合键被清空,那么还会产生一个del通知。 - SMOVE source destination member 为来源键(source key)产生一个

srem通知,并为目标键(destination key)产生一个sadd事件。 - SPOP key 产生一个

spop事件。如果执行 SPOP key 之后,集合键被清空,那么还会产生一个del通知。 - [SINTERSTORE destination key key …] 、 [SUNIONSTORE destination key key …] 和 [SDIFFSTORE destination key key …] 分别产生

sinterstore、sunionostore和sdiffstore三种通知。如果用于保存结果的键已经存在,那么还会产生一个del通知。 - ZINCRBY key increment member 产生一个

zincr通知。(译注:非对称,请注意。) - [ZADD key score member [score member] [score member] …] 产生一个

zadd通知,即使有多个输入元素时,也是如此。 - [ZREM key member member …] 产生一个

zrem通知,即使有多个输入元素时,也是如此。如果执行 [ZREM key member member …] 之后,有序集合键被清空,那么还会产生一个del通知。 - ZREMRANGEBYSCORE key min max 产生一个

zrembyscore通知。(译注:非对称,请注意。)如果用于保存结果的键已经存在,那么还会产生一个del通知。 - ZREMRANGEBYRANK key start stop 产生一个

zrembyrank通知。(译注:非对称,请注意。)如果用于保存结果的键已经存在,那么还会产生一个del通知。 - [ZINTERSTORE destination numkeys key key …] [WEIGHTS weight [weight …]] [AGGREGATE SUM|MIN|MAX] 和 [ZUNIONSTORE destination numkeys key key …] [WEIGHTS weight [weight …]] [AGGREGATE SUM|MIN|MAX] 分别产生

zinterstore和zunionstore两种通知。如果用于保存结果的键已经存在,那么还会产生一个del通知。 - 每当一个键因为过期而被删除时,产生一个

expired通知。 - 每当一个键因为

maxmemory政策而被删除以回收内存时,产生一个evicted通知。

5.过期通知的发送时间

Redis 使用以下两种方式删除过期的键:

- 当一个键被访问时,程序会对这个键进行检查,如果键已经过期,那么该键将被删除。

- 底层系统会在后台渐进地查找并删除那些过期的键,从而处理那些已经过期、但是不会被访问到的键。

当过期键被以上两个程序的任意一个发现、 并且将键从数据库中删除时, Redis 会产生一个 expired 通知。

Redis 并不保证生存时间(TTL)变为 0 的键会立即被删除: 如果程序没有访问这个过期键, 或者带有生存时间的键非常多的话, 那么在键的生存时间变为 0 , 直到键真正被删除这中间, 可能会有一段比较显著的时间间隔。

因此, Redis 产生 expired 通知的时间为过期键被删除的时候, 而不是键的生存时间变为 0 的时候。

5.redis通信协议

Redis 协议在以下三个目标之间进行折中:

- 易于实现

- 可以高效地被计算机分析(parse)

- 可以很容易地被人类读懂

RESP协议

Redis 是一个 CS 架构的软件,通信一般分两步(不包括 pipeline 和 PubSub):

- 客户端(client)向服务端(server)发送一条命令

- 服务端解析并执行命令,返回响应结果给客户端

因此客户端发送命令的格式、服务端响应结果的格式必须有一个规范,这个规范就是通信协议。

而在 Redis 中采用的是 RESP(Redis Serialization Protocol)协议:

- Redis 1.2 版本引入了 RESP 协议

- Redis 2.0 版本中成为与 Redis 服务端通信的标准,称为 RESP2

- Redis 6.0 版本中,从 RESP2 升级到了 RESP3 协议,增加了更多数据类型并且支持 6.0 的新特性–客户端缓存

但目前,默认使用的依然是 RESP2 协议,也是我们要学习的协议版本(以下简称 RESP)。

在 RESP 中,通过首字节的字符来区分不同数据类型,常用的数据类型包括 5 种:

-

单行字符串:首字节是‘+’,后面跟上单行字符串,以 CRLF(“\r\n”)结尾。例如返回"OK":“+OK\r\n”

-

错误(Errors):首字节是‘-’,与单行字符串格式一样,只是字符串是异常信息,例如:“-Error message\r\n”

-

数值:首字节是‘:’,后面跟上数字格式的字符串,以 CRLF 结尾。例如:“:10\r\n”

-

多行字符串:首字节是‘$’,表示二进制安全的字符串,最大支持 512MB:

- 如果大小为 0,则代表空字符串:“$0\r\n\r\n”

- 如果大小为 -1,则代表不存在:“$-1\r\n”

-

数组:首字节是

‘*’,后面跟上数组元素个数,再跟上元素,元素数据类型不限:

5.1 网络层

客户端和服务器通过 TCP 连接来进行数据交互, 服务器默认的端口号为 6379 。

客户端和服务器发送的命令或数据一律以 \r\n (CRLF)结尾。

5.2 请求

Redis 服务器接受命令以及命令的参数。

服务器会在接到命令之后,对命令进行处理,并将命令的回复传送回客户端。

5.3 新版统一请求协议

新版统一请求协议在 Redis 1.2 版本中引入, 并最终在 Redis 2.0 版本成为 Redis 服务器通信的标准方式。

你的 Redis 客户端应该按照这个新版协议来进行实现。

在这个协议中, 所有发送至 Redis 服务器的参数都是二进制安全(binary safe)的。

以下是这个协议的一般形式:

*<参数数量> CR LF

$<参数 1 的字节数量> CR LF

<参数 1 的数据> CR LF

...

$<参数 N 的字节数量> CR LF

<参数 N 的数据> CR LF

举个例子, 以下是一个命令协议的打印版本:

3

$3

SET

$5

mykey

$7

myvalue

这个命令的实际协议值如下:

"*3\r\n$3\r\nSET\r\n$5\r\nmykey\r\n$7\r\nmyvalue\r\n"

稍后我们会看到, 这种格式除了用作命令请求协议之外, 也用在命令的回复协议中: 这种只有一个参数的回复格式被称为批量回复(Bulk Reply)。

统一协议请求原本是用在回复协议中, 用于将列表的多个项返回给客户端的, 这种回复格式被称为多条批量回复(Multi Bulk Reply)。

一个多条批量回复以 * 为前缀, 后跟多条不同的批量回复, 其中 argc 为这些批量回复的数量。

5.4 回复

Redis 命令会返回多种不同类型的回复。

通过检查服务器发回数据的第一个字节, 可以确定这个回复是什么类型:

- 状态回复(status reply)的第一个字节是

"+" - 错误回复(error reply)的第一个字节是

"-" - 整数回复(integer reply)的第一个字节是

":" - 批量回复(bulk reply)的第一个字节是

"$" - 多条批量回复(multi bulk reply)的第一个字节是

"*"

5.5 状态回复

一个状态回复(或者单行回复,single line reply)是一段以 "+" 开始、 "\r\n" 结尾的单行字符串。

以下是一个状态回复的例子:

+OK

客户端库应该返回 "+" 号之后的所有内容。 比如在在上面的这个例子中, 客户端就应该返回字符串 "OK" 。

状态回复通常由那些不需要返回数据的命令返回,这种回复不是二进制安全的,它也不能包含新行。

状态回复的额外开销非常少,只需要三个字节(开头的 "+" 和结尾的 CRLF)。

5.6 错误回复

错误回复和状态回复非常相似, 它们之间的唯一区别是, 错误回复的第一个字节是 "-" , 而状态回复的第一个字节是 "+" 。

错误回复只在某些地方出现问题时发送: 比如说, 当用户对不正确的数据类型执行命令, 或者执行一个不存在的命令, 等等。

一个客户端库应该在收到错误回复时产生一个异常。

以下是两个错误回复的例子:

-ERR unknown command 'foobar'

-WRONGTYPE Operation against a key holding the wrong kind of value

在 "-" 之后,直到遇到第一个空格或新行为止,这中间的内容表示所返回错误的类型。

ERR 是一个通用错误,而 WRONGTYPE 则是一个更特定的错误。 一个客户端实现可以为不同类型的错误产生不同类型的异常, 或者提供一种通用的方式, 让调用者可以通过提供字符串形式的错误名来捕捉(trap)不同的错误。

不过这些特性用得并不多, 所以并不是特别重要, 一个受限的(limited)客户端可以通过简单地返回一个逻辑假(false)来表示一个通用的错误条件。

5.7 整数回复

整数回复就是一个以 ":" 开头, CRLF 结尾的字符串表示的整数。

比如说, ":0\r\n" 和 ":1000\r\n" 都是整数回复。

返回整数回复的其中两个命令是 INCR key 和 LASTSAVE 。 被返回的整数没有什么特殊的含义, INCR key 返回键的一个自增后的整数值, 而 LASTSAVE 则返回一个 UNIX 时间戳, 返回值的唯一限制是这些数必须能够用 64 位有符号整数表示。

整数回复也被广泛地用于表示逻辑真和逻辑假: 比如 EXISTS key 和 SISMEMBER key member 都用返回值 1 表示真, 0 表示假。

其他一些命令, 比如 [SADD key member member …] 、 [SREM key member member …] 和 SETNX key value , 只在操作真正被执行了的时候, 才返回 1 , 否则返回 0 。

以下命令都返回整数回复: SETNX key value 、 [DEL key key …] 、 EXISTS key 、 INCR key 、 INCRBY key increment 、 DECR key 、 DECRBY key decrement 、 DBSIZE 、 LASTSAVE 、 RENAMENX key newkey 、 MOVE key db 、 LLEN key 、 [SADD key member member …] 、 [SREM key member member …] 、 SISMEMBER key member 、 SCARD key 。

5.8 批量回复

服务器使用批量回复来返回二进制安全的字符串,字符串的最大长度为 512 MB 。

客户端:GET mykey

服务器:foobar

服务器发送的内容中:

- 第一字节为

"$"符号 - 接下来跟着的是表示实际回复长度的数字值

- 之后跟着一个 CRLF

- 再后面跟着的是实际回复数据

- 最末尾是另一个 CRLF

对于前面的 GET key 命令,服务器实际发送的内容为:

"$6\r\nfoobar\r\n"

如果被请求的值不存在, 那么批量回复会将特殊值 -1 用作回复的长度值, 就像这样:

客户端:GET non-existing-key

服务器:$-1

这种回复称为空批量回复(NULL Bulk Reply)。

当请求对象不存在时,客户端应该返回空对象,而不是空字符串: 比如 Ruby 库应该返回 nil , 而 C 库应该返回 NULL (或者在回复对象中设置一个特殊标志), 诸如此类。

5.9 多条批量回复

像 LRANGE key start stop 这样的命令需要返回多个值, 这一目标可以通过多条批量回复来完成。

多条批量回复是由多个回复组成的数组, 数组中的每个元素都可以是任意类型的回复, 包括多条批量回复本身。

多条批量回复的第一个字节为 "*" , 后跟一个字符串表示的整数值, 这个值记录了多条批量回复所包含的回复数量, 再后面是一个 CRLF 。

客户端: LRANGE mylist 0 3

服务器: *4

服务器: $3

服务器: foo

服务器: $3

服务器: bar

服务器: $5

服务器: Hello

服务器: $5

服务器: World

在上面的示例中,服务器发送的所有字符串都由 CRLF 结尾。

正如你所见到的那样, 多条批量回复所使用的格式, 和客户端发送命令时使用的统一请求协议的格式一模一样。 它们之间的唯一区别是:

- 统一请求协议只发送批量回复。

- 而服务器应答命令时所发送的多条批量回复,则可以包含任意类型的回复。

以下例子展示了一个多条批量回复, 回复中包含四个整数值, 以及一个二进制安全字符串:

*5\r\n

:1\r\n

:2\r\n

:3\r\n

:4\r\n

$6\r\n

foobar\r\n

在回复的第一行, 服务器发送 *5\r\n , 表示这个多条批量回复包含 5 条回复, 再后面跟着的则是 5 条回复的正文。

多条批量回复也可以是空白的(empty), 就像这样:

客户端: LRANGE nokey 0 1

服务器: *0\r\n

无内容的多条批量回复(null multi bulk reply)也是存在的, 比如当 [BLPOP key key …] timeout 命令的阻塞时间超过最大时限时, 它就返回一个无内容的多条批量回复, 这个回复的计数值为 -1 :

客户端: BLPOP key 1

服务器: *-1\r\n

客户端库应该区别对待空白多条回复和无内容多条回复: 当 Redis 返回一个无内容多条回复时, 客户端库应该返回一个 null 对象, 而不是一个空数组。

5.10 多条批量回复中的空元素

多条批量回复中的元素可以将自身的长度设置为 -1 , 从而表示该元素不存在, 并且也不是一个空白字符串(empty string)。

当 [SORT key BY pattern] [LIMIT offset count] [GET pattern [GET pattern …]] [ASC | DESC] [ALPHA] [STORE destination] 命令使用 GET pattern 选项对一个不存在的键进行操作时, 就会发生多条批量回复中带有空白元素的情况。

以下例子展示了一个包含空元素的多重批量回复:

服务器: *3

服务器: $3

服务器: foo

服务器: $-1

服务器: $3

服务器: bar

其中, 回复中的第二个元素为空。

对于这个回复, 客户端库应该返回类似于这样的回复:

["foo", nil, "bar"]

5.11 多命令和流水线

客户端可以通过流水线, 在一次写入操作中发送多个命令:

- 在发送新命令之前, 无须阅读前一个命令的回复。

- 多个命令的回复会在最后一并返回。

5.12内联命令

当你需要和 Redis 服务器进行沟通, 但又找不到 redis-cli , 而手上只有 telnet 的时候, 你可以通过 Redis 特别为这种情形而设的内联命令格式来发送命令。

以下是一个客户端和服务器使用内联命令来进行交互的例子:

客户端: PING

服务器: +PONG

以下另一个返回整数值的内联命令的例子:

客户端: EXISTS somekey

服务器: :0

因为没有了统一请求协议中的 "*" 项来声明参数的数量, 所以在 telnet 会话输入命令的时候, 必须使用空格来分割各个参数, 服务器在接收到数据之后, 会按空格对用户的输入进行分析(parse), 并获取其中的命令参数。

5.13 高性能 Redis 协议分析器

尽管 Redis 的协议非常利于人类阅读, 定义也很简单, 但这个协议的实现性能仍然可以和二进制协议一样快。

因为 Redis 协议将数据的长度放在数据正文之前, 所以程序无须像 JSON 那样, 为了寻找某个特殊字符而扫描整个 payload , 也无须对发送至服务器的 payload 进行转义(quote)。

程序可以在对协议文本中的各个字符进行处理的同时, 查找 CR 字符, 并计算出批量回复或多条批量回复的长度, 就像这样:

#include 得到了批量回复或多条批量回复的长度之后, 程序只需调用一次 read 函数, 就可以将回复的正文数据全部读入到内存中, 而无须对这些数据做任何的处理。

在回复最末尾的 CR 和 LF 不作处理,丢弃它们。

Redis 协议的实现性能可以和二进制协议的实现性能相媲美, 并且由于 Redis 协议的简单性, 大部分高级语言都可以轻易地实现这个协议, 这使得客户端软件的 bug 数量大大减少。

6.redis客户端与服务器

redis数据库采用I/O多路复用技术实现文件处理器,服务器采用单线程单进程的方式来处理客户端发送过来的请求命令,他同时与多个客户端建立网络通信连接,服务器会与他相连接的客户端创建对应的redis.sh/redisClient结构,在这个结构中保存了当前客户端相关属性以及执行操作。

6.1.redis客户端

6.1.1 客户端名称,套接字,标志和时间

客户端的属性大致可以分为2类,一类是redis特定功能相关的属性,另一类是通用属性,也就是客户端执行什么命令或进行扫什么操作,都会与这些属性相关。

1.名字属性

在默认情况下redis连接到服务端的客户端是没有名字的,我们可以通过CLIENT setname 来进行设置。

127.0.0.1:6379> client list

id=79 addr=127.0.0.1:59216 fd=7 name= age=149949 idle=0 flags=N db=0 sub=0 psub=0 multi=-1 qbuf=26 qbuf-free=32742 obl=0 oll=0 omem=0 events=r cmd=client user=default

2.套接字属性

客户端套接字由客户端状态的fd属性记录,他记录了客户端正在使用的套接字相关描述符,不同类型的客户端,fd属性也是不同的,他的值如果是-1表示这个客户端是一个伪客户端,来源是lua脚本或aof文件的,也可能是大于-1的整数。大于-1表示这是一个普通的客户端,查看连接到服务器的所有客户端,可以使用如下命令:

127.0.0.1:6379> CLIENT list

id=79 addr=127.0.0.1:59216 fd=7 name= age=150192 idle=0 flags=N db=0 sub=0 psub=0 multi=-1 qbuf=26 qbuf-free=32742 obl=0 oll=0 omem=0 events=r cmd=client user=default

返回值

addr : 客户端的地址和端口

fd : 套接字所使用的文件描述符

age : 以秒计算的已连接时长

idle : 以秒计算的空闲时长

flags : 客户端 flag

db : 该客户端正在使用的数据库 ID

sub : 已订阅频道的数量

psub : 已订阅模式的数量

multi : 在事务中被执行的命令数量

qbuf : 查询缓冲区的长度(字节为单位, 0 表示没有分配查询缓冲区)

qbuf-free : 查询缓冲区剩余空间的长度(字节为单位, 0 表示没有剩余空间)

obl : 输出缓冲区的长度(字节为单位, 0 表示没有分配输出缓冲区)

oll : 输出列表包含的对象数量(当输出缓冲区没有剩余空间时,命令回复会以字符串对象的形式被入队到这个队列里)

omem : 输出缓冲区和输出列表占用的内存总量

events : 文件描述符事件

cmd : 最近一次执行的命令

客户端 flag 可以由以下部分组成:

O : 客户端是 MONITOR 模式下的附属节点(slave)

S : 客户端是一般模式下(normal)的附属节点

M : 客户端是主节点(master)

x : 客户端正在执行事务

b : 客户端正在等待阻塞事件

d : 一个受监视(watched)的键已被修改, EXEC 命令将失败

c : 在将回复完整地写出之后,关闭链接

u : 客户端未被阻塞(unblocked)

A : 尽可能快地关闭连接

N : 未设置任何 flag

文件描述符事件可以是:

r : 客户端套接字(在事件 loop 中)是可读的(readable)

w : 客户端套接字(在事件 loop 中)是可写的(writeable)

查看示例:

redis-cli -h 127.0.0.1 -p 6379 -a 123456 CLIENT LIST | awk '{printf "%-32s| %-16s| %-16s| %-16s| %-16s| %-16s| %s\n", $2,$5,$6,$7,$12,$16,$18}'

3.标志属性

标记属性用来记录客户端的角色,以及客户端目前所处的状态。

flags 属性的取值可以是单个标志,也可以是多个二进制或的组合标志,具体如下。

单个标志:flags=<flag>

组合标志:flags=<flag1>|<flag2>|<flag3>|…

标志使用常量来表示。Redis 所具有的所有标志都定义在 redis.h 文件中。

记录客户端角色的标志有如下几个。

● 在利用 Redis 主从服务器实现复制时,主从服务器会相互成为对方的客户端,也就是从服务器是主服务器的客户端,同时主服务器也是从服务器的客户端。Redis 使用REDIS_MASTER 标志来表示这个客户端是主服务器,而使用 REDIS_SLAVE 标志来表示另一个客户端是从服务器。

● Redis 使用 REDIS_LUA_CLIENT 标志来表示该客户端是一个专门用于处理 Lua 脚本的伪客户端,它主要用于执行 Lua 脚本中包含的 Redis 命令。

● Redis 使用 REDIS_PRE_PSYNC 标志来表示该客户端是一个低于 Redis 2.8 版本的从服务器,此时,对应的主服务器不能使用 PSYNC 命令实现与从服务器的数据同步。只有当 REDIS_SLAVE 标志处于打开状态时,才能使用 REDIS_PRE_PSYNC 标志。

记录客户端当前状态的标志有如下几个。

● REDIS_ASKING 标志表示客户端向运行在集群模式下的服务器节点发送了 ASKING 命令。

● REDIS_CLOSE_ASAP 标志表示客户端的输出缓冲区过大,超出了服务器所允许的范围。当服务器在下一次执行 serverCron 函数时,会关闭这个输出缓冲区过大的客户端,以此来保证服务器的稳定性不受这个客户端影响。在关闭的时候,存储在这个缓冲区中的数据也会被删除,并且不会给客户端返回任何信息。

● REDIS_CLOSE_AFTER_REPLY 标志表示客户端给服务器发送的命令请求中有错误的协议内容,或者用户在客户端中执行了 CLIENT kill 命令。此时服务器会将客户端输出缓冲区中存储的所有数据内容发送给客户端,然后关闭这个客户端。

● REDIS_DIRTY_CAS 标志表示事务使用 WATCH 命令监视的数据库键已经被修改。

● REDIS_DIRTY_EXEC 标志表示事务在命令入队时出现错误。

REDIS_DIRTY_CAS 和 REDIS_DIRTY_EXEC 标志的出现都表示 Redis 事务的安全性已被破坏。只要这两个标志中的任何一个被打开,EXEC 命令都会执行失败。而只有在客户端打开了 REDIS_MULTI 标志的情况下,才能使用这两个标志。

● REDIS_MULTI 标志表示客户端正处于执行事务的状态中。

● REDIS_MONITOR 标志表示客户端正处于执行 MONITOR 命令的状态中。

● REDIS_FORCE_AOF 标志表示让服务器将当前正在执行的命令强制写入 AOF 文件中。在执行 PUBSUB 命令时,会使客户端打开 REDIS_FORCE_AOF 标志。

● REDIS_FORCE_REPL 标志表示强制让主服务器将当前正在执行的命令复制给所有与它连接的从服务器。当执行 SCRIPT LOAD 命令时,会使客户端同时开启 REDIS_FORCE_AOF 和 REDIS_FORCE_REPL 标志。如果要实现主从服务器可以正确地载入 SCRIPT LOAD 命令指定的脚本,那么服务器必须使用 REDIS_FORCE_REPL 标志,让主服务器强制将 SCRIPT LOAD 命令分发给相应的从服务器。

● REDIS_UNIX_SOCKET 标志表示服务器连接客户端使用的是 UNIX 套接字。

● REDIS_BLOCKED 标志表示客户端正处于被 BRPOP、BLPOP 等命令阻塞的状态中。

● REDIS_UNBLOCKED 标志表示客户端不再阻塞,它从 REDIS_BLOCKED 标志的阻塞状态中脱离出来。只有在 REDIS_BLOCKED 标志被打开的情况下,才能使用 REDIS_UNBLOCKED 标志。

● REDIS_MASTER_FORCE_REPLY 标志:在主从服务器进行命令交互的过程中,从服务器需要向主服务器发送 REPLICATION ACK 命令。但是,在发送此命令之前,从服务器必须开启主服务器对应的客户端的 REDIS_MASTER_FORCE_REPLY 标志;否则主服务器会拒绝执行从服务器发送的 REPLCATION ACK 命令。

4.时间属性

● ctime 属性:该属性记录了客户端被创建的时间。利用这个时间可以计算出这个客户端与服务器相连接的时间,单位为秒。在执行 CLIENT list 命令后,返回的 age 域记录了连接秒数

● lastinteraction 属性:该属性记录了客户端与服务器最后一次交互的时间。交互就是两者之间互相发送命令请求与返回结果。利用 lastinteraction 属性可以计算出客户端的空转时间,也就是在进行最后一次交互之前过去了多少时间,单位为秒。CLIENT list 命令返回的 idle 域记录了这个时间。当 idle 的值为 0 时,表示空转时间为 0 秒。

● obuf_soft_limit_reached_time 属性:该属性记录了客户端输出缓冲区第一次达到软性限制的时间

6.1.2 客户端缓冲区

服务器采用软性限制(Soft Limit)和硬性限制(Hard Limit)两种模式来限制客户端缓 冲区的大小。

-

软性限制 如果软性限制所设置的大小小于输出缓冲区的大小,且输出缓冲区的大小不大于硬性限 制所设置的大小,那么服务器会使用客户端状态结构的 obuf_soft_limit_reached_time 属性来 记录客户端达到软性限制的起始时间。之后服务器会继续监视客户端,如果这个缓冲区的大 小一直超出软性限制,并且持续时间超过服务器设定的时长,那么服务器将会关闭这个客户 端。相反地,如果输出缓冲区的大小在指定时间范围之内没有超过软性限制,那么这个客户 端不会被关闭,并且 obuf_soft_limit_reached_time 属性的值也会被设置为 0。 130∣从零开始学 Redis

-

硬性限制

当输出缓冲区的大小超过了硬性限制的大小时,这个客户端会被立即关闭。 我们可以使用 client-output-buffer-limit 选项来为普通客户端、从服务器客户端或执行消 息订阅发布功能的客户端设置软性限制和硬性限制,

具体的格式如下:

client-output-buffer-limit

比如:

client-output-buffer-limit normal 0 0 0 #设置普通客户端的硬性限制和软性限制均为 0,表示这

个客户端的输出缓冲区不限制大小

client-output-buffer-limit slave 512mb 128mb 120 #设置从服务器客户端的硬性限制为 512MB,

软性限制为 128MB,软性限制的时长为 120 秒

client-output-buffer-limit pubsub 64mb 64mb 100 #设置执行消息订阅发布功能的客户端的硬性

限制和软性限制均为 64MB,软性限制的时长为 100 秒

客户端的缓冲区分为输入缓冲区和输出缓冲区

● 输入缓冲区:用于保存客户端发送的命令请求。输入缓冲区的大小是动态变化的, 它会根据输入的内容动态缩小或增大。1GB 是输入缓冲区的最大大小。如果输入缓 冲区的大小超过了 1GB,那么这个客户端将会被关闭。

● 输出缓冲区:用于保存执行客户端请求命令返回的结果或返回值。每个客户端都有 两个输出缓冲区,一个输出缓冲区的大小是固定的,另一个输出缓冲区的大小是可 变的。

-

固定输出缓冲区:用于保存那些长度比较小的返回值,比如常见的 OK、或 者一些短字符串、整数值及错误值等。

-

可变输出缓冲区:用于保存那些长度比较大的返回值,比如一个长度比较大的字 符串、大列表、大集合等。 buf 和 bufpos 属性组成了客户端固定大小的缓冲区。

buf 属性是一个字节数组,数组大小为 REDIS_REPLY_CHUNK_BYTES 字节。REDIS_ REPLY_CHUNK_BYTES 常量的默认值为 16×1024,即 buf 数组的默认大小为 16KB。 bufpos 属性记录了 buf 数组到目前为止已经使用的字节数量。

当 buf 数组已经存满或者回复因为太大而没有办法存入 buf 数组时,服务器就会使用 可变大小的缓冲区。

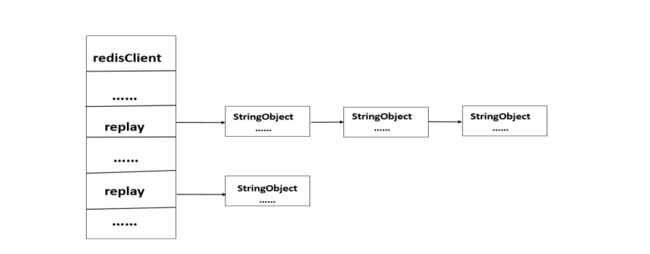

链表 reply 和一个或多个字符串对象组成可变大小的输出缓冲区。通过使用链表来连接 多个字符串对象,服务器可以为客户端保存一个非常长的命令返回值,而不会受到大小的 限制。如图 6.1 所示为可变大小的输出缓冲区。

如图所示:可变大小缓冲区

6.1.3 客户端的 authenticated 属性

authenticated 属性是客户端身份验证属性,用于记录客户端是否通过了身份验证。这个属性的值为 0 和 1,默认值为 0。

当 authenticated 属性值为 0 时,表示这个客户端的身份验证失败,没有通过。而当authenticated 属性值为 1 时,表示这个客户端的身份验证通过了。只有当服务器启用了客户端身份验证功能时,才能使用 authenticated 属性。如果服务器启用了客户端身份验证功能,同时 authenticated 属性值为 0,那么对于客户端发送过来的所有命令,服务器都不会执行,除 AUTH 命令外。而如果服务器没有启动客户端身份验证功能,同时 authenticated 属性值为 0,那么服务器不会拒绝执行客户端发送过来的命令。

当 authenticated 属性值为 0 时,服务器除执行 AUTH 命令之外,将会拒绝执行客户端

发送过来的其他所有命令。操作如下:

127.0.0.1 6379>PING

(error) NOAUTH Authentication required

127.0.0.1 6379>DEL name

(error) NOAUTH Authentication required

当客户端使用 AUTH 命令成功进行身份验证之后,authentication 属性值将会变为 1,

此时服务器不会拒绝执行客户端发送过来的任何命令,并且会返回相应的结果。

6.1.4 客户端的 argv 和 argc 属性

argv 属性:这是一个数组,数组中的每个元素都是一个字符串对象,其中 argv[0]是要执行的命令,而之后的其他元素是传给这个命令的参数。

argc 属性:用于记录 argv 属性的数组长度。当客户端向服务器发送命令时,服务器会将接收到的命令保存到客户端状态的querybuf 属性中。保存之后,服务器会分析这个命令的内容,并将分析得出的命令参数及

命令参数的个数分别保存到 argv 和 argc 属性中,如图

6.1.5 关闭客户端

在这里再介绍一下普通客户端被关闭的几种方式。

● 当客户端执行了 CLIENT kill 命令时,客户端会被关闭。

● 当客户端进程被杀死时,客户端将会断开与服务器的连接,从而客户端被关闭。

● 当客户端向服务器发送的命令是错误协议格式时,客户端会被关闭。

● 当客户端发送的命令请求的大小超过了输入缓冲区的限制大小时,客户端会被关闭。

● 当发送给客户端的命令执行后返回结果的大小超过了输出缓冲区的限制大小时,客 户端也会被关闭。

● 当为服务器设置了 timeout 参数值,同时客户端的空转时间又超过了 timeout 参数值 时,客户端将会被关闭。而如果这个客户端是主服务器,而从服务器被 BLPOP、 BRPOP 等相关命令阻塞,或者从服务器正在执行与订阅发布相关的命令,此时就算 客户端的空转时间超过了 timeout 参数值,这个客户端也不会被关闭。

6.2 redis服务器

Redis 服务器实现与多个客户端的连接,并处理这些客户端发送过来的请求,同时保存 客户端执行命令所产生的数据到数据库中。Redis 服务器依靠资源管理器来维持自身的运 转,其主要作用是管理 Redis 服务。本节将讲解 Redis 服务器处理命令的过程,以及与服务 器相关的属性、函数的用法,来进一步熟悉 Redis 服务器的工作过程

6.2.1 服务器处理命令请求

在一条命令从客户端发送到服务器端,到服务器处理完这条命令请求,然后返回结果 的这一过程中,客户端与服务器需要完成一系列的操作。

比如,我们向客户端发送了一条命令:SET city “beijing”;服务器接收到命令请求,处 理完之后返回 OK。在这一过程中,客户端与服务器需要完成以下几个步骤。

(1)用户将命令 SET city "beijing"输入客户端,客户端接收到此命令。

(2)客户端将这条命令请求发送给服务器。

(3)服务器接收到客户端发送过来的命令请求并处理它,在数据库中进行操作,这里 的操作为添加新键值对,成功之后返回 OK。

(4)服务器将命令结果 OK 返回给客户端。

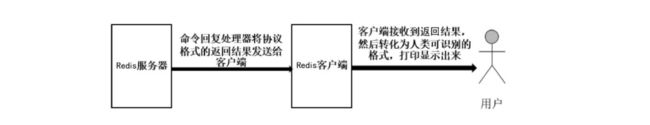

(5)客户端接收到服务器返回的命令结果 OK,然后将这个结果展示给用户。 这个过程如图 6.3 所示。

6.2.2 服务器发送命令

Redis 客户端将一条命令请求发送给服务器,也就是说,服务器的命令请求来源于客户端。当用户将一条命令输入客户端后,客户端会先将接收到的命令转化为服务器可以识别的协议格式,然后利用连接到服务器的套接字,将转化为合法协议格式的命令请求发送给服务器。这一过程如图

SET city "beijing"

客户端接收到这条命令之后,会将这条命令转化为服务器可以识别的协议格式。

*3\r\n$3\r\nSET\r\n$3\r\ncity\r\n$5\r\nbeijing\r\n

转化之后,将这个协议内容发送给服务器。

6.2.3 服务器执行命令

当服务器接收到客户端传递过来的协议数据时,客户端与服务器之间的连接套接字就会变得可读,此时,服务器将会调用命令请求处理器执行以下过程。

(1)服务器读取套接字中协议格式的命令请求,然后将读取到的命令请求保存到客户

端状态的输入缓冲区中。

(2)对输入缓冲区中的命令请求进行分析,获取命令请求参数及参数个数,分别保存

到客户端状态的 argv 和 argc 属性中。

(3)调用命令执行器,执行客户端发送过来的命令请求。

命令执行器在执行客户端发送过来的命令请求的过程中,会先根据客户端状态的argv[0]参数,在命令表(Command Table)中查找参数所指定的命令,并将查找到的命令保存到客户端状态的 cmd 属性中,然后进行相关的判断,比如,判断客户端状态的 cmd 指针是否指向 NULL,或者检查客户端的身份,判断是否验证通过等,最后调用命令的实现函数执行相关命令,这就是命令执行器的执行过程。

命令表是一个字典,用于存放 Redis 的命令,字典的键就是一个个命令的名字,比如

“set”“sadd”“zadd”等;而字典的值是一个个 redisCommand 结构,而每个 redisCommand

结构记录了对应命令的实现信息。redisCommand 结构具有多个属性,具体如下。

● name 属性:表示命令的名字,比如 SET、GET,它是 char *类型的。

● proc 属性:它是一个函数指针,用于指向命令的实现函数,比如,指向 SET 命令的实现函数 setCommand,它是 redisCommandProc *类型的,而 redisCommandProc 类型的定义为 typedef void redisCommandProc(redisClient *c)。

● arity 属性:它是一个 int 类型的整数,表示命令参数的个数,用于判断命令请求的格式是否正确。如果 arity 属性的值是一个负数-N,则表示命令参数的数量大于等于 N。请注意,这里所说的参数个数包含命令的名字本身,比如,SET city “beijing”,这条命令的参数个数是 3,分别是“SET”“city”“beijing”。

● sflags 属性:它是一个 char *类型的字符串形式的标识值,具有多个标识符,用于记录这个命令所具有的属性。

● flags 属性:它是一个 int 类型的整数,是对 sflags 标识进行分析得出的二进制标识,这个二进制标识由程序自动生成。当服务器对命令标识进行检查时,使用的是 flags属性。

● calls 属性:该属性用于统计服务器共执行了多少次这个命令,它是一个 long long 类型的整数。

● milliseconds 属性:该属性用于统计服务器执行这个命令所耗费的总时长,它是一个long long 类型的整数。每个 Redis 命令都有其对应的 redisCommand 结构,都有上面的相关属性。

sflags 属性所具有的标识符具体如下:

● a:属性值为 a,表示这个命令是一个 Redis 管理命令。相关的命令有 SAVE、BGSAVE、 SHUTDOWN 等。

● l:属性值为 l,表示这个命令常用于服务器载入数据的过程中。相关的命令有 INFO、 PUBLISH、SUBSCRIBE 等。

● m:属性值为 m,说明这个命令在执行的过程中可能会占用大量内存。在执行之前, 需要判断服务器的内存大小及使用情况,如果服务器的内存资源不足,则将会拒绝 执行这个命令。相关的命令有 SET、SADD、APPEND、RPUSH、LPUSH 等。

● M:属性值为 M,表示这个命令在 Redis 监视器模式下不会被自动传播。相关的命 令有 EXEC。

● p:属性值为p,说明这个命令与Redis的消息订阅发布功能相关。相关的命令有PUBLISH、 PUBSUB、PSUBSCRIBE、PUNSUBSCRIBE、SUBSCRIBE、UNSUBSCRIBE 等。

● r:属性值为 r,只读,说明这是一个只读命令,用于获取相关数据,它不会修改数 据库。相关的命令有 GET、STRLEN、EXISTS 等。

● R:属性值为 R,说明这是一个随机命令,在处理相同的数据集和相同的参数时, 得到的结果是随机的。相关的命令有 SPOP、SSCAN、RANDOMKEY 等。

● s:属性值为 s,表示在 Lua 脚本中不能使用该命令。相关的命令有 BLPOP、BRPOP、 SPOP、BRPOPLPUSH 等。

● S:属性值为 S,表示这个命令在 Lua 脚本中可以使用。在 Lua 脚本中使用这个命令 时,输出的结果会被排序,也就是输出的结果是有序的。相关的命令有 KEYS、 SUNION、SDIFF、SINTER、SMEMBERS 等。

● t:属性值为 t,表示这个命令允许从服务器在带有过期数据时使用。相关的命令有 PING、INFO、SLAVEOF 等。

● w:属性值为 w,可写,说明这是一个写入命令,它可以修改数据库。相关的命令 有 SET、DEL、RPUSH 等。

6.2.4 服务器返回命令结果

命令执行器在执行完相关的实现函数之后,服务器会接着做一些后续工作,然后将命令结果返回给客户端。

服务器所做的后续工作具体过程如下。

(1)在命令执行的过程中会耗费一些时间,需要同步到该命令所对应的 redisCommand

结构中。修改 milliseconds 属性的值,同时将 redisCommand 结构中的 calls 计数器的值加 1。

(2)如果这台服务器启动了慢查询日志功能,那么慢查询日志模块会判断是否需要为

刚执行完的命令添加一条慢查询日志。

(3)如果这台服务器启用了 AOF 持久化功能,那么 AOF 持久化模块会将这条执行完的命令请求写入 AOF 缓冲区里。

(4)如果有其他从服务器正在同步备份当前这台服务器的数据,那么这台服务器会将刚执行完的命令请求转发给与它相连的从服务器。

当服务器完成上述相关后续工作的处理之后,会调用命令回复处理器,此时客户端的套接字变为可写状态。服务器调用命令回复处理器将保存在客户端输出缓冲区中的协议格式的返回结果发送给客户端,客户端接收到返回结果之后,会转化为人类可识别的格式,打印给用户看。

当命令回复处理器将返回结果成功发送给客户端之后,它会删除客户端状态的输出缓冲区,为下一条命令请求的执行腾出空间。

上述这个服务器返回结果到客户端的过程如图 6.5 所示。

前面我们用到了 SET 命令,在执行 SET city "beijing"命令之后,也就是在服务器调用命令执行器之后,会返回一个协议格式的 OK,存入客户端状态的输出缓冲区中,然后服务器调用命令回复处理器将协议格式的命令结果“+OK\r\n”发送给客户端,客户端成功接收并把它转化为“OK\n”,接着打印显示出来。

以上就是 Redis 服务器与客户端交互执行一条命令请求的过程。

6.3 服务器函数

服务器的正常运行离不开底层相关函数的执行。下面介绍几个与 Redis 服务器相关的 函数,看看它们是如何调用执行的,来进一步了解 Redis 服务器的运行过程。

6.3.1 serverCron 函数

serverCron 函数是 Redis 服务器中的一个重要函数。在默认情况下,每隔 100 毫秒执行 一次 serverCron 函数,它负责管理服务器的资源,并维持服务器的正常运行。在执行 serverCron 函数的过程中会调用相关的子函数,如 trackOperationsPerSecond 、 SigtermHandler、clientsCron、databasesCron 等函数,来实现对 Redis 服务器资源的管理。

6.3.2 trackOperationsPerSecond 函数

trackOperationsPerSecond 函数是 serverCron 函数的一个子函数,它以每 100 毫秒一次 的频率被执行,采用抽样计算的方式,计算并记录服务器在最近 1 秒内处理的命令请求数 量。可以通过 INFO stats 命令来查看。在返回的结果中,instantaneous_ops_per_sec 属性记 录了服务器在最近 1 秒内处理的命令请求数量。INFO stats 命令操作如下所示

127.0.0.1:6379> INFO stats

# Stats

total_connections_received:3

total_commands_processed:9

instantaneous_ops_per_sec:0

total_net_input_bytes:252

total_net_output_bytes:31451

instantaneous_input_kbps:0.00

instantaneous_output_kbps:0.00

rejected_connections:0

sync_full:0

sync_partial_ok:0

sync_partial_err:0

expired_keys:0

expired_stale_perc:0.00

expired_time_cap_reached_count:0

evicted_keys:0

keyspace_hits:0

keyspace_misses:0

pubsub_channels:0

pubsub_patterns:0

latest_fork_usec:0

migrate_cached_sockets:0

slave_expires_tracked_keys:0

active_defrag_hits:0

active_defrag_misses:0

active_defrag_key_hits:0

active_defrag_key_misses:0

其中,instantaneous_ops_per_sec 属性的值为 0,表示在最近 1 秒内服务器没有处理任何命令请求。instantaneous_ops_per_sec 属性的值是通过计算 REDIS_OPS_SEC_SAMPLES次取样的平均值来计算的,是一个估算值,并不能很准确地统计出服务器在最近 1 秒内处理的命令请求数量。关于这个估算值的计算,感兴趣的读者可以自行查阅相关资料。

6.3.3 sigtermHandler 函数

sigtermHandler 函数是一个 Redis 服务器进程的 SIGTERM 信号关联处理器。在 Redis服务器启动的时候会调用执行 sigtermHandler 函数,它负责在服务器接收到 SIGTERM 信号时,打开服务器状态的 shutdown_asap 标识。

在每次执行服务器资源管理函数 serverCron 的时候,都会先对服务器状态的shutdown_asap 属性的值进行判断,再决定是否关闭服务器。当 shutdown_asap 属性的值为1 时,关闭服务器;当 shutdown_asap 属性的值为 0 时,什么也不做。

6.3.4 clientsCron 函数

clientsCron 函数在每次执行服务器资源管理函数 serverCron 时被调用,它会对一定数量的客户端进行如下检查。

● 检查这个客户端与服务器的连接是否已经超时。如果连接已经超时(在很长一段时间内,客户端与服务器之间没有进行交互),则释放这个客户端的连接。

● 检查这个客户端的输入缓存区的大小,以便对服务器的内存进行管理。如果客户端在上一次执行命令请求后,输入缓冲区的大小超过了一定的限制,那么程序会释放这个客户端的输入缓存区,然后重新为这个客户端创建一个默认大小的输入缓冲区,以此来防止客户端的输入缓冲区消耗更多内存。

6.3.5 databasesCron 函数

databasesCron 函数在每次执行 serverCron 函数时被调用,它的作用是对服务器中的部分数 据库进行检查,查找出过期的键,然后删除它们,并对 Redis 数据字典进行相关的收缩操作等。

6.4 服务器属性

服务器相关属性在服务器运行过程中扮演着重要的角色,它们会与服务器相关函数结 合起来,共同维持服务器的正常运行。服务器的相关属性具体如下

6.4.1 cronloops 属性

cronloops 属性是一个计数器,用于记录服务器的 serverCron 函数被执行的次数,是一个 int 类型的整数。每执行一次 serverCron 函数,cronloops 属性的值就加 1。

6.4.2 rdb_child_pid 与 aof_child_pid 属性

rdb_child_pid 和 aof_child_pid 属性用于检查 Redis 服务器持久化操作的运行状态,它们记录执行 BGSAVE 和 BGREWRITEAOF 命令的子进程的 ID。也常常使用这两个属性来

判断 BGSAVE 和 BGREWRITEAOF 命令是否正在被执行。当执行 serverCron 函数时,会检查 rdb_child_pid 和 aof_child_pid 属性的值,只要其中一个属性的值不等于-1,程序就会调用一次 wait3 函数来判断子进程是否发送信号到服务器中。

如果没有信号到达,则表示服务器持久化操作没有完成,程序不做任何处理。而如果有信号到达,那么,针对 BGSAVE 命令,表示新的 RDB 文件已经成功生成;针对BGREWRITEAOF 命令,表示新的 AOF 文件生成完毕,然后服务器继续执行相应的后续操作。比如,将旧的 RDB 文件或 AOF 文件替换为新的 RDB 文件或 AOF 文件。另外,当 rdb_child_pid 和 aof_child_pid 属性的值都为-1 时,表示此时的服务器没有执行持久化操作,这时程序会做出如下判断。

(1)判断 BGREWRITEAOF 命令的执行是否被延迟了。如果被延迟了,则重新执行一次 BGREWRITEAOF 命令。

(2)判断是否满足服务器的自动保存条件。如果满足服务器的自动保存条件,并且服务器没有执行其他持久化操作,那么服务器将开始执行 BGSAVE 命令。

(3)判断是否满足服务器设置的 AOF 重写条件。如果条件满足,同时服务器没有执行其他持久化操作,那么服务器将重新执行 BGREWRITEAOF 命令。服务器执行持久化操作的过程如图

6.4.3 stat_peak_memory 属性

stat_peak_memory 属性用于记录 Redis 服务器的内存峰值大小。在每次执行 serverCro

函数时,程序都会检查服务器当前内存的使用情况,并与 stat_peak_memory 属性保存的上一次内存峰值大小进行比较。如果当前的内存峰值大小大于 stat_peak_memory 属性保存的值,就将当前最新的内存峰值大小赋给 stat_peak_memory 属性。在执行 INFO memory 命令后,返回的 used_memory_peak 和 used_memory_peak_human属性分别以两种格式记录了服务器的内存峰值大小。在执行 INFO memory 命令后,返回的

结果如下所示:

127.0.0.1:6379> INFO memory

# Memory

used_memory:871216

used_memory_human:850.80K

used_memory_rss:2703360

used_memory_rss_human:2.58M

used_memory_peak:871216

used_memory_peak_human:850.80K

used_memory_peak_perc:100.01%

used_memory_overhead:853560

used_memory_startup:786472

used_memory_dataset:17656

used_memory_dataset_perc:20.83%

total_system_memory:16725729280

total_system_memory_human:15.58G

used_memory_lua:37888

used_memory_lua_human:37.00K

maxmemory:0

maxmemory_human:0B

maxmemory_policy:noeviction

mem_fragmentation_ratio:3.10

mem_allocator:jemalloc-4.0.3

active_defrag_running:0

lazyfree_pending_objects:0

6.4.4 lruclock 属性

lruclock 属性是一种服务器时间缓存,它记录了服务器的 LRU 时钟。在默认情况下,serverCron 函数会以每 10 秒一次的频率更新 lruclock 属性的值。LRU 时钟不是实时的,它只是一个模糊的估计值。

Redis 的每个对象都有一个 lru 属性,该属性记录了这个对象最后一次被命令访问的时间。使用 lruclock 属性的值减去 lru 属性的值,就能计算出这个对象的空转时间。可以使用 INFO server 命令的 lru_clock 属性来查看当前 LRU 时钟的时间,操作如下:

127.0.0.1:6379> INFO server

# Server

redis_version:4.0.9

redis_git_sha1:00000000

第 6 章 Redis 客户端与服务器∣141

redis_git_dirty:0

redis_build_id:c706c7a026bd863d

redis_mode:standalone

os:Linux 2.6.32-431.el6.x86_64 x86_64

arch_bits:64

multiplexing_api:epoll

atomicvar_api:sync-builtin

gcc_version:4.4.7

process_id:25154

run_id:047838576c9b61b823008a5d7d462bd1fb36d459

tcp_port:6379

uptime_in_seconds:2379

uptime_in_days:0

hz:10

lru_clock:13975323

executable:/home/redis/redis-4.0.9/src/./redis-server

config_file:

6.4.5 mstime 与 unixtime 属性

mstime 和 unixtime 属性记录了服务器当前的时间。在默认情况下,serverCron 函数会以每 100 毫秒一次的频率更新 mstime 和 unixtime 属性,它们记录的时间值并不是最准确的。

6.4.6 aof_rewrite_scheduled 属性

aof_rewrite_scheduled 属性用于记录服务器中 BGREWRITEAOF 命令执行是否被延迟。当aof_rewrite_scheduled 属性的值为 1 时,表示执行 BGREWRITEAOF 命令超时了。在服务器执行 BGSAVE 命令时,如果客户端发送了 BGREWRITEAOF 命令请求,那么服务器在接收到命令请求之后,会将 BGREWRITEAOF 命令延迟到 BGSAVE 命令执行成功后再执行。

在每次执行 serverCron 函数时,都会判断 BGSAVE 或 BGREWRITEAOF 命令是否正在被执行。如果它们没有被执行,同时 aof_rewrite_scheduled 属性的值为 1,那么被延迟的BGREWRITEAOF 命令将会被执行。

6.5 Redis 服务器的启动过程

一台 Redis 服务器从启动到能够接收客户端的命令请求,需要经过一系列的初始化和 设置过程,大致需要经过以下几步。

6.5.1 服务器状态结构的初始化

服务器状态结构的初始化会创建一个 struct redisServer 类型的实例变量 server 作为服务器的状态,同时为结构中的其他属性设置默认值。由 redis.c/initServerConfig 函数来初始化server 变量。initServerConfig 函数的主要任务是设置服务器的运行 ID、默认运行频率、默认配置文件路径、运行架构、默认端口、默认 RDB 持久化条件和 AOF 持久化条件及初始化 LRU 时钟,同时创建命令表,为服务器的后续运行做好准备。initServerConfig 函数设置的服务器属性都是最基本的,这些属性的值都是一些整数、浮点数或字符串值。该函数除创建命令表之外,并不会创建其他,比如,它不会创建数据库。

6.5.2 相关配置参数的加载

在服务器的 initServerConfig 函数完成 server 变量的初始化后,就会开始加载配置参数,同时根据用户指定的配置参数,对 server 变量的属性进行修改。比如,我们在启动 Redis 服务器之前,修改 redis.conf 配置文件,修改的内容如下:

#修改数据库的默认数量为 20 个

databases 20

#关闭 RDB 文件的压缩功能

rdbcompression no

在修改完配置文件之后,启动服务器,服务器中的数据库数量就会变为 20 个,同时 RDB 持久化压缩功能就会被关闭。

6.5.3 服务器数据结构的初始化

在加载完相关配置参数之后,服务器会调用 initServer 函数为以下服务器数据结构分配内存及设置初始化值。

● server.clients 链表:该链表用于记录所有与服务器相连的客户端的状态结构,链表的每个节点都包含一个 redisClient 结构的实例。

● server.pubsub_channels 字典:该字典用于保存频道订阅消息。

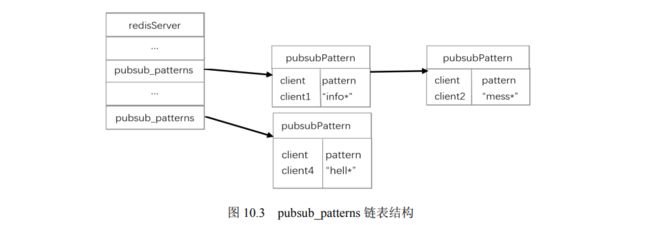

● server.pubsub_patterns 链表:该链表用于保存模式订阅消息。

● server.lua 属性:该属性用于执行 Lua 脚本的运行环境。

● server.slowlog 属性:该属性用于保存慢查询日志。

服务器在初始化的过程中,分别调用了 initServerConfig 和 initServer 函数,其中,initServerConfig 函数主要用于初始化一些基本属性,initServer 函数主要用于初始化一些数据结构。在初始化的过程中,要考虑到用户的输入情况,所以服务器必须先加载用户输入的配置信息,再按照用户的意愿来初始化相关的数据结构。而如果在执行 initServerConfig函数时就对数据结构进行初始化,此时用户恰好修改了和数据结构有关的服务器状态属性,那么服务器又要重新修改已创建的数据结构。为了避免此类情况的发生,服务器将初始化过程拆分为两步。

服务器的 initServer 函数除初始化数据结构之外,还执行以下相关操作。

● 设置服务器的进程信号处理器。

● 初始化服务器的后台 I/O 模块,为 I/O 操作做准备。

● 创建相关的共享对象。这些共享对象在服务器中常常用到,比如,创建返回值为“OK”或“ERR”的字符串对象,创建包含整数 1~10000 的字符串对象等。这些共享对象的创建避免了服务器的反复创建。

● 打开服务器的监听端口,并为监听套接字关联连接应答事件处理器,等待服务器正式运行时接收客户端的连接。

● 为 serverCron 函数创建时间事件,等待服务器正式运行时执行 serverCron 函数。

● 为 AOF 文件的写入做好准备。如果已经打开了 AOF 持久化功能,那么直接打开已

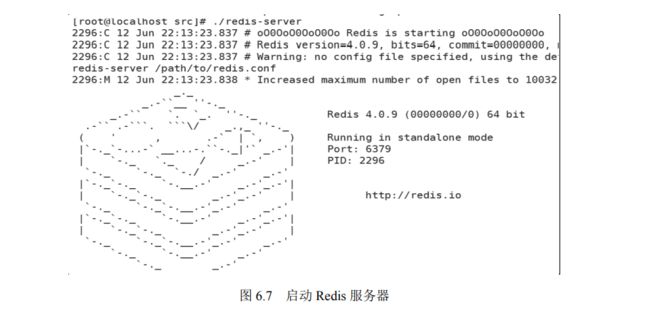

经存在的 AOF 文件;如果 AOF 文件不存在,则创建一个新的 AOF 文件,并打开它。当 initServer 函数执行完这些操作之后,服务器将会采用 ASCII 字符在日志中打印出Redis 的图标,以及 Redis 的版本号、端口号等信息,如图 6.7 所示。

6.5.4 数据库状态的处理

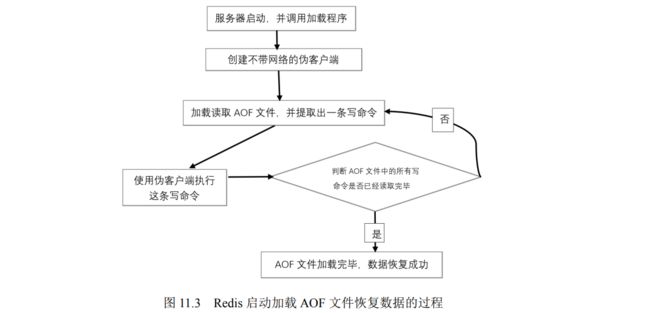

当服务器的 initServer 函数完成初始化工作之后,需要加载 RDB 文件或 AOF 文件,并按照文件记录的相关内容来还原数据库状态。根据是否启用了 AOF 持久化功能,服务器加载数据时所使用的目标文件也会不同。

● 如果 AOF 持久化功能被开启了,服务器就会使用 AOF 文件来还原数据库状态

● 如果 AOF 持久化功能没有被开启,服务器就会使用 RDB 文件来还原数据库状态。 服务器在完成数据库状态还原之后,就会打印出加载目标文件及还原数据库状态所用 的时间。日志信息如下: 20990:M 11 Jun 07:44:57.165 * DB loaded from disk: 0.000 seconds

6.5.5 执行服务器的循环事件

最后,服务器打印出如下日志:

20990:M 11 Jun 07:44:57.165 * Ready to accept connections

至此,表示服务器已经成功启动了,它将开始执行服务器的循环事件,并开始接收客户端的命令请求。到这里, Redis 客户端与服务器的相关知识点就讲解完了,相信读者已经有了深入的了解。加油!你的付出不会白费,它将会以另一种形式回报给你!

7.redis底层数据结构

本章将深入 Redis 的底层实现,讲解 Redis 中字符串、链表、字典、对象的底层实现原 理,剖析它们底层实现的数据结构,帮助读者熟悉它们的实现过程、相关的 API,以及对 象的编码方式等。

7.1 Redis 简单动态字符串

我们已经知道,Redis 数据库是由 C 语言编写实现的,它底层实现的代码具有 C 语言的特点及语法。C 语言中具有字符串数据类型,Redis 数据库中也有。但是 Redis 数据库并没有直接使用 C 语言中的字符串表示,而是自己重新构建了一种名为简单动态字符串(SDS)的抽象类型,并将其用作 Redis 的默认字符串表示。

7.1.1 SDS 的实现原理

在 Redis 中,C 语言字符串通常用作字符串字面量,用在对字符串值不需要修改的地方,比如打印日志。当 Redis 需要一个可以被修改的字符串值时,它就会使用 SDS 来表示字符串值。Redis 数据库采用 SDS 实现底层字符串值的键值对。执行以下命令:

127.0.0.1:6379>SET userName "liuhefei"

OK

在将字符串 userName 的值添加到 Redis 数据库的过程中,会创建一个新的键值对,这个键值对的键是一个字符串对象,其底层实现是一个保存着字符串“userName”的 SDS;而这个键值对的值也是一个字符串对象,其底层实现是一个保存着字符串“liuhefei”的 SDS。

SDS 不仅可以用来保存数据库中的字符串值,还可以用于实现 AOF 模块下的 AOF 缓冲区(Buffer),以及实现客户端状态的输入缓冲区。

SDS 是一个 C 语言结构体,位于 Redis 安装包的 src 目录下,每个 sds.h/sdshdr 结构表

示一个 SDS 值,它的底层源代码如下:

typedef char *sds;

/* Note: sdshdr5 is never used, we just access the flags byte directly.

* However is here to document the layout of type 5 SDS strings. */

struct __attribute__ ((__packed__)) sdshdr5 {

unsigned char flags; /* 3 lsb of type, and 5 msb of string length */

char buf[];

};

struct __attribute__ ((__packed__)) sdshdr8 {

uint8_t len; /* used */

uint8_t alloc; /* excluding the header and null terminator */

unsigned char flags; /* 3 lsb of type, 5 unused bits */

char buf[];

};

struct __attribute__ ((__packed__)) sdshdr16 {

uint16_t len; /* used */

uint16_t alloc; /* excluding the header and null terminator */

unsigned char flags; /* 3 lsb of type, 5 unused bits */

char buf[];

};

struct __attribute__ ((__packed__)) sdshdr32 {

uint32_t len; /* used */

uint32_t alloc; /* excluding the header and null terminator */

unsigned char flags; /* 3 lsb of type, 5 unused bits */

char buf[];

};

struct __attribute__ ((__packed__)) sdshdr64 {

uint64_t len; /* used */

uint64_t alloc; /* excluding the header and null terminator */

unsigned char flags; /* 3 lsb of type, 5 unused bits */

char buf[];

};