linux基础命令

前言:本文章仅用作学习记录,如有侵权请联系删除。

准备工作:

1,安装VMwareworkstation,安装教程可自行百度一个,这里不做记录。

链接:https://pan.baidu.com/s/1cWCVDYG3H7fplXtYPqCgBQ

提取码:oaaw

2,centos7 安装(文件过大,这里不附带链接了)

3,客户端连接工具(可选xshell,Termius)

链接:https://pan.baidu.com/s/1gejoBZfB1Dfcj0aetm-Hxw

提取码:n4nv

正文

-- Linux基础:C:\Users\张沈\AppData\Local\Programs\Termius

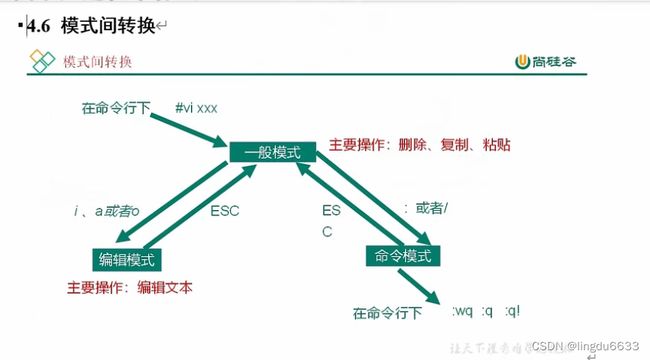

1.vim 的三种模式:

1.1一般模式

以 vi 打开一个档案就直接进入一般模式了(这是默认的模式)。在这个模式中, 你可

以使用『上下左右』按键来移动光标,你可以使用『删除字符』或『删除整行』来处理档

案内容, 也可以使用『复制、粘贴』来处理你的文件数据。

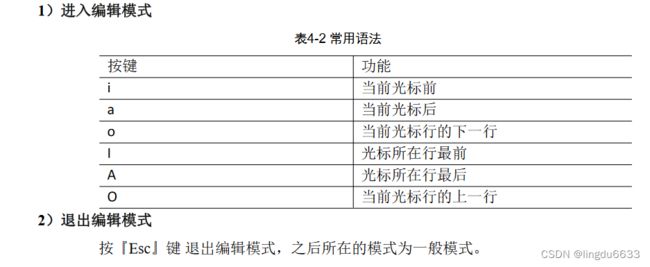

1.2编辑模式

在一般模式中可以进行删除、复制、粘贴等的动作,但是却无法编辑文件内容的!要

等到你按下『i, I, o, O, a, A』等任何一个字母之后才会进入编辑模式。

注意了!通常在Linux中,按下这些按键时,在画面的左下方会出现『INSERT或

REPLACE』的字样,此时才可以进行编辑。而如果要回到一般模式时, 则必须要按下

『Esc』这个按键即可退出编辑模式。

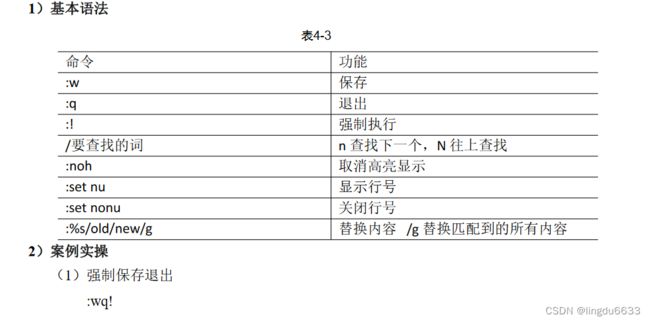

1.3指令模式

在一般模式当中,输入『 : / ?』3个中的任何一个按钮,就可以将光标移动到最底下那

一行。

在这个模式当中, 可以提供你『搜寻资料』的动作,而读取、存盘、大量取代字符、

离开 vi 、显示行号等动作是在此模式中达成的!

2.linux系统管理:

2.1Linux 中的进程和服务

计算机中,一个正在执行的程序或命令,被叫做“进程”(process)。

启动之后一只存在、常驻内存的进程,一般被称作“服务”(service)。

2.2服务管理

service 服务名 start | stop |· restart | status --centos6

systemctl start | stop | restart | status 服务名--centos7(重点掌握)

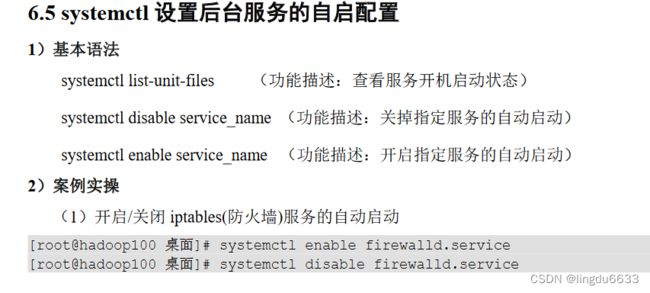

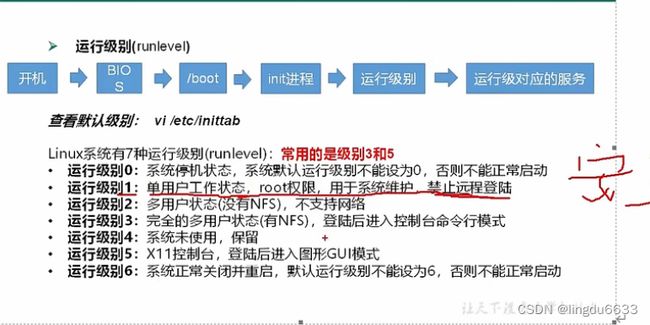

2.3Linux运行级别

3:常用命令文件目录类

Shell 可以看作是一个命令解释器,为我们提供了交互式的文本控制台界面。我们可以

通过终端控制台来输入命令,由 shell 进行解释并最终交给内核执行。 本章就将分类介绍

常用的基本 shell 命令。

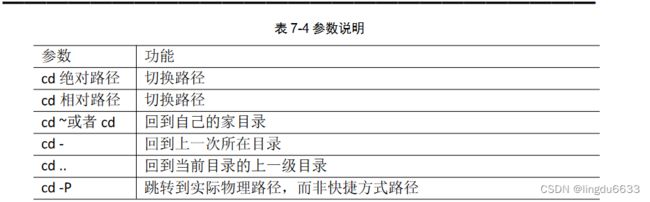

3.1查看切换目录操作

显示当前目录:[root@hadoop101 ~]# pwd

![]()

3.2创建目录

1)创建一个目录

[root@hadoop101 ~]# mkdir xiyou

[root@hadoop101 ~]# mkdir xiyou/mingjie

(2)创建一个多级目录

[root@hadoop101 ~]# mkdir -p xiyou/dssz/meihouwang

3.3删除目录

删除空目录:[root@hadoop101 ~]# rmdir xiyou/dssz/meihouwang

创建文件:[root@hadoop101 ~]# touch xiyou/dssz/sunwukong.txt

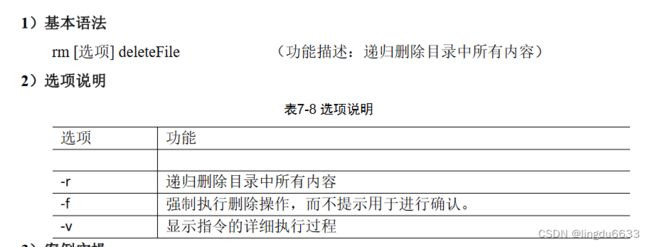

删除非空目录:rm -r 非空目录 会提示

删除非空目录:rm -rf 非空目录 不会提示直接删除

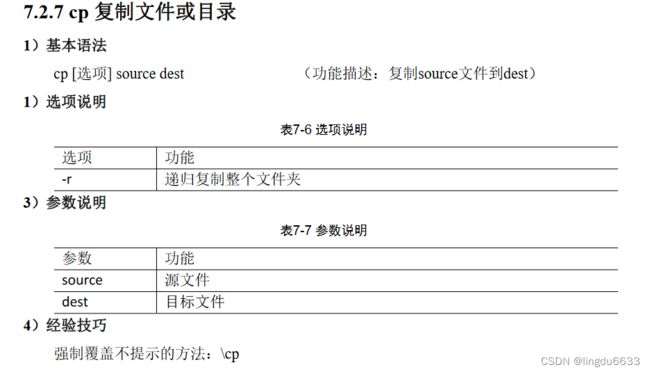

3.4复制文件

root@hadoop101 ~]# cp xiyou/dssz/suwukong.txt xiyou/mingjie/

[root@hadoop101 ~]# cp -r xiyou/dssz/ ./

3.5移动文件

1)基本语法

(1)mv oldNameFile newNameFile (功能描述:重命名)

(2)mv /temp/movefile /targetFolder (功能描述:移动文件)

2)案例实操

(1)重命名

[root@hadoop101 ~]# mv xiyou/dssz/suwukong.txt xiyou/dssz/houge.txt

(2)移动文件

[root@hadoop101 ~]# mv xiyou/dssz/houge.txt ./

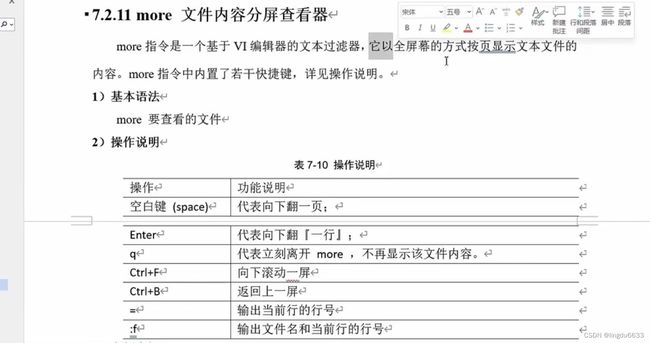

3.6查看文件内容

[atguigu@hadoop101 ~]$ cat -n houge.txt

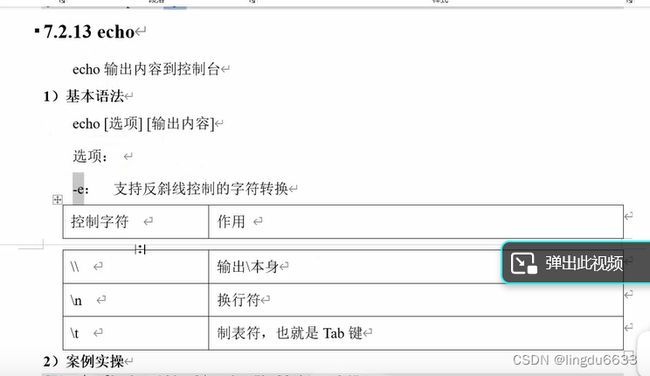

[atguigu@hadoop101 ~]$ echo “hello\tworld”

hello\tworld

[atguigu@hadoop101 ~]$ echo -e “hello\tworld”

hello world

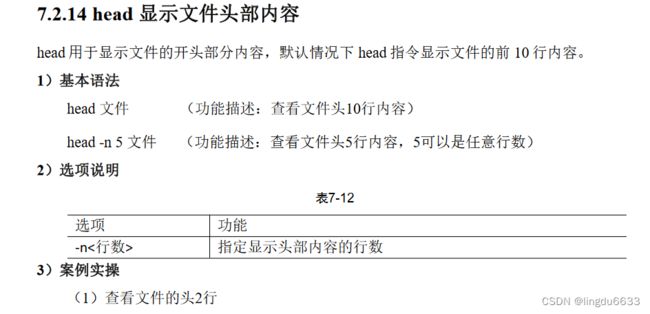

[root@hadoop101 ~]# head -n 2 smartd.conf

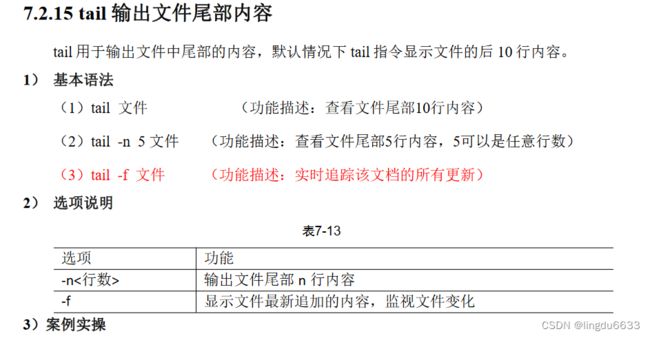

(1)查看文件尾 1 行内容

[root@hadoop101 ~]# tail -n 1 smartd.conf

(2)实时追踪该档的所有更新

[root@hadoop101 ~]# tail -f houge.txt

[root@hadoop101 ~]# mv houge.txt xiyou/dssz/

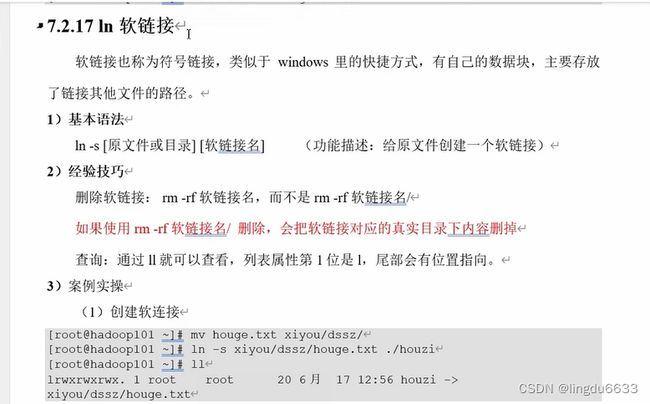

[root@hadoop101 ~]# ln -s xiyou/dssz/houge.txt ./houzi

[root@hadoop101 ~]# ll

lrwxrwxrwx. 1 root root 20 6 月 17 12:56 houzi ->

xiyou/dssz/houge.txt

(2)删除软连接(注意不要写最后的/)

[root@hadoop101 ~]# rm -rf houzi

(3)进入软连接实际物理路径

[root@hadoop101 ~]# ln -s xiyou/dssz/ ./dssz

[root@hadoop101 ~]# cd -P dssz/

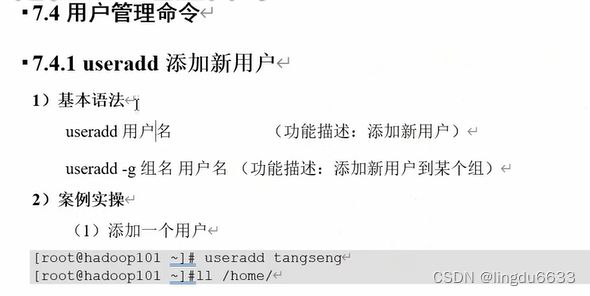

4:用户管理命令

查看创建的用户:cat /etc/passwd

[root@hadoop101 ~]# useradd tangseng

[root@hadoop101 ~]#ll /home/ --查看新用户是否已经存在

设置用户密码:

[root@hadoop101 ~]# passwd tangseng

(1)查看用户是否存在

[root@hadoop101 ~]#id tangseng

查看创建了哪些用户:

[root@hadoop101 ~]# cat /etc/passwd

切换用户:

su 用户名称 (功能描述:切换用户,只能获得用户的执行权限,不能获得环境变量)

su - 用户名称 (功能描述:切换到用户并获得该用户的环境变量及执行权限)

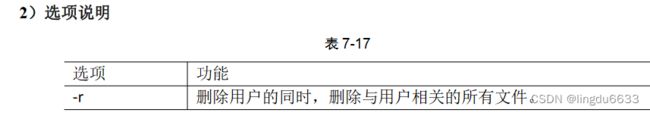

删除用户:

基本语法

(1)userdel 用户名 (功能描述:删除用户但保存用户主目录)

(2)userdel -r 用户名 (功能描述:用户和用户主目录,都删除)

查看用户信息:

(1)whoami (功能描述:显示自身用户名称)

(2)who am i (功能描述:显示登录用户的用户名以及登陆时间)

2)案例实操

(1)显示自身用户名称

[root@hadoop101 opt]# whoami

(2)显示登录用户的用户名

[root@hadoop101 opt]# who am i

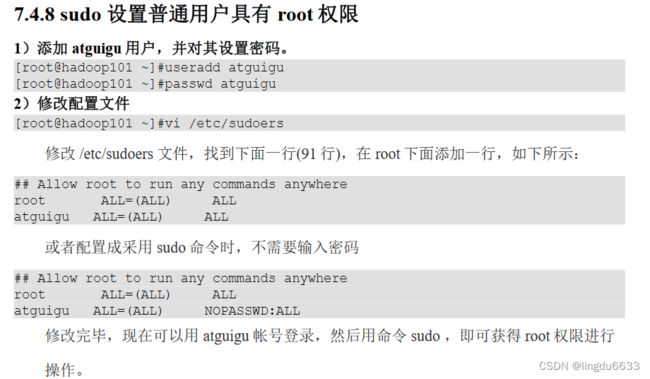

注意修改用户权限的是时候需要先对 /etc/sudoers文件夹权限做更改。

1.增加对etc/sudoers文件的修改权限 输入命令“chmod u+w /etc/sudoers

2.vim /etc/sudoers 修改内如按照上面即可。

3.收回etc/sudoers的修改权限,录入命令 "chmod u-w /etc/sudoers

4.测试 su user1 sudo ls -al 出现内容即可,如果显示此事将被记录则失败。

修改用户组:usermod -g 用户组 用户名

[root@hadoop101 opt]# usermod -g root zhubajie

该用户添加到 root组里面之后,su root 直接 ll 查看即可,不用加sudo.

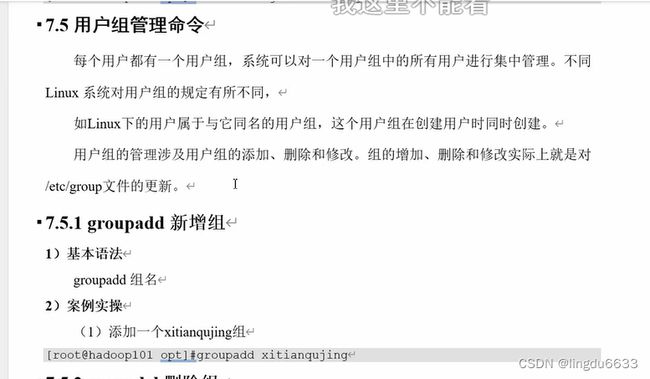

(1)添加一个xitianqujing组

[root@hadoop101 opt]#groupadd xitianqujing

(1)删除xitianqujing组

[root@hadoop101 opt]# groupdel xitianqujing

修改组名:groupmod -n 新组名 老组名

[root@hadoop101 ~]# groupmod -n xitian xitianqujing

查看有多少组名:

[root@hadoop101 atguigu]# cat /etc/group

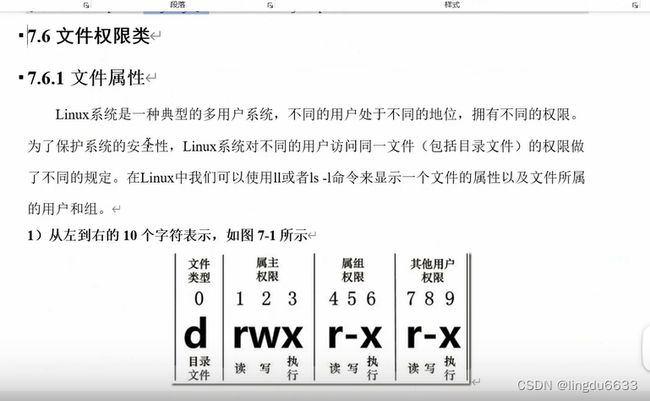

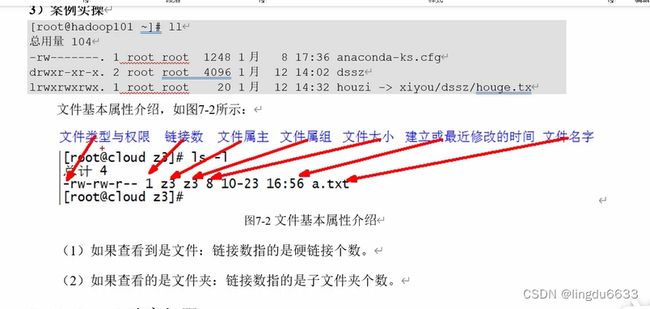

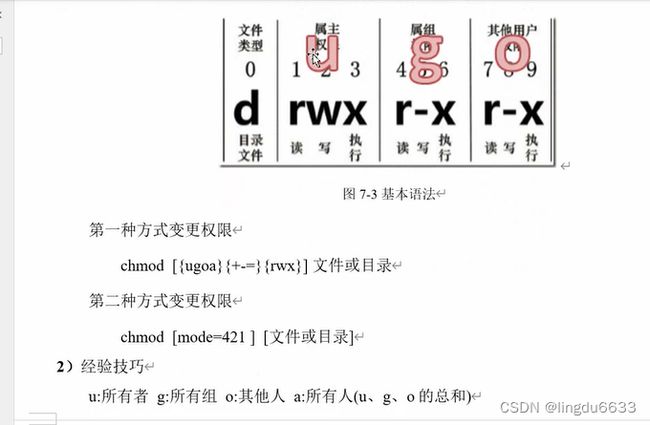

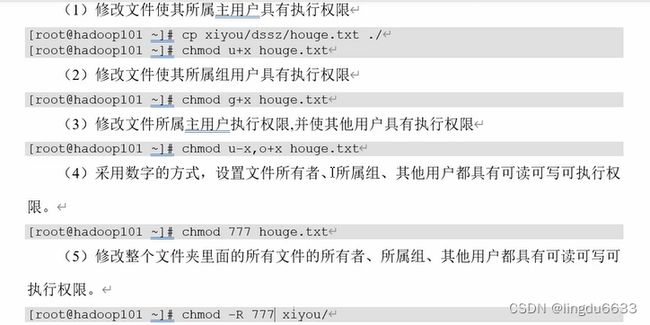

5.文件权限类

chmod u+rwx a.txt 所属主加权限

chmod g+rwx a.txt 所属组加权限

chmod o+rwx a.txt 其他用户

chmod a+rwx a.txt 所有用户

文件权限的赋予是用root用户操作,目的是给用户或者组赋予文件的读写执行权限。

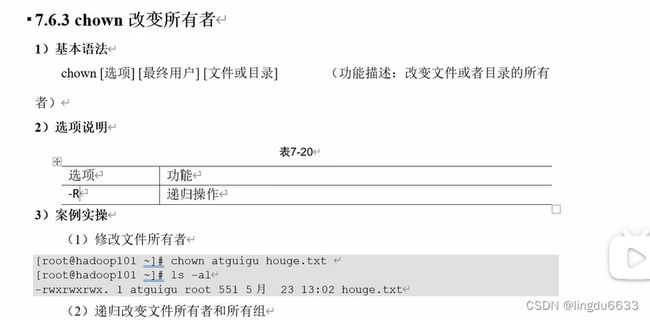

[root@hadoop101 xiyou]# chown -R atguigu:atguigu xiyou/

chgrp 改变所属组

1)基本语法

chgrp [最终用户组] [文件或目录] (功能描述:改变文件或者目录的所属组)

[root@hadoop101 ~]# chgrp root houge.txt

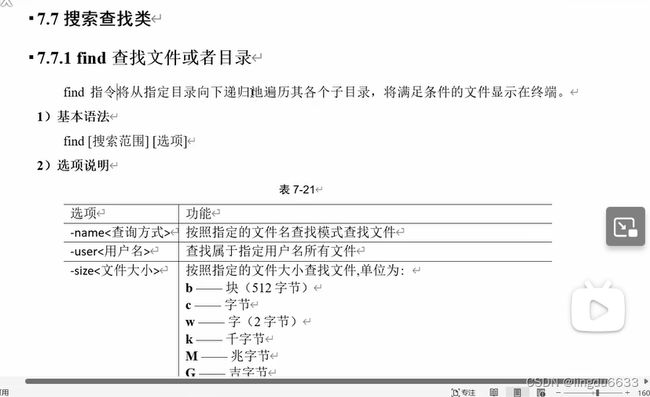

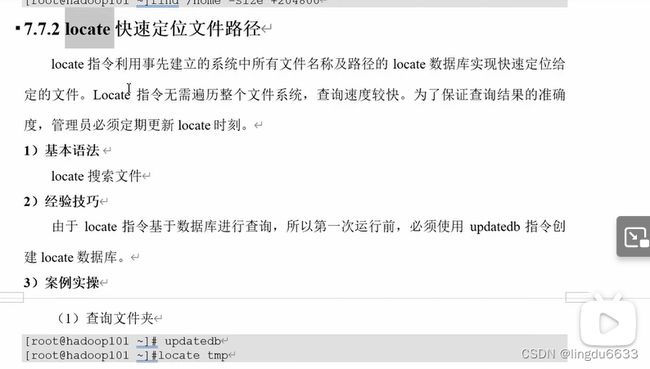

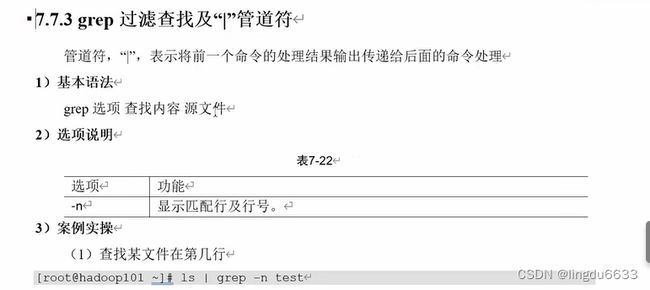

6.文件查找

(1)按文件名:根据名称查找/目录下的filename.txt文件。

[root@hadoop101 ~]# find xiyou/ -name "*.txt"

(2)按拥有者:查找/opt目录下,用户名称为-user的文件

[root@hadoop101 ~]# find xiyou/ -user atguigu

(3)按文件大小:在/home目录下查找大于200m的文件(+n 大于 -n小于 n等于)

[root@hadoop101 ~]find /home -size +204800

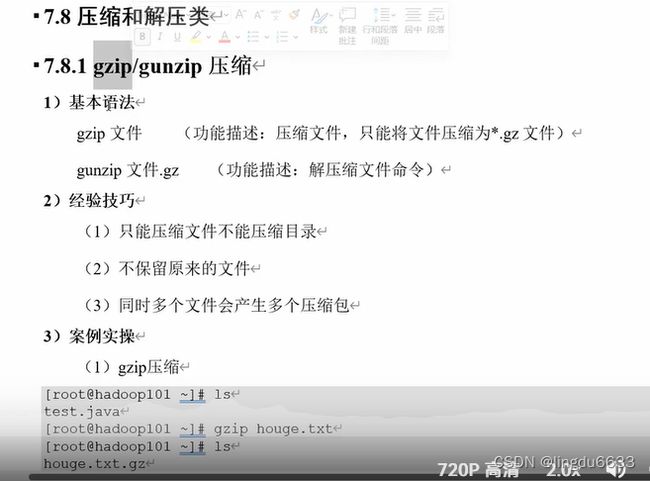

7.压缩解压命令

(1)gzip压缩

[root@hadoop101 ~]# ls

test.java

[root@hadoop101 ~]# gzip houge.txt

[root@hadoop101 ~]# ls

houge.txt.gz

(2)gunzip解压缩文件

[root@hadoop101 ~]# gunzip houge.txt.gz

[root@hadoop101 ~]# ls

houge.txt

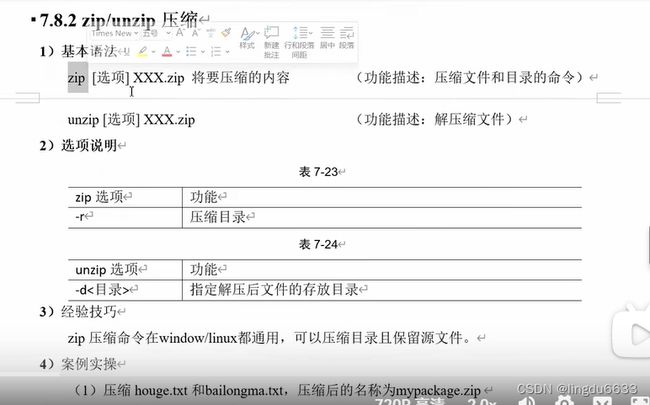

1)压缩 houge.txt 和bailongma.txt,压缩后的名称为mypackage.zip

[root@hadoop101 opt]# touch bailongma.txt

[root@hadoop101 ~]# zip mypackage.zip houge.txt bailongma.txt

adding: houge.txt (stored 0%)

adding: bailongma.txt (stored 0%)

[root@hadoop101 opt]# ls

houge.txt bailongma.txt mypackage.zip

(2)解压 mypackage.zip

[root@hadoop101 ~]# unzip mypackage.zip

Archive: houma.zip

extracting: houge.txt

extracting: bailongma.txt

[root@hadoop101 ~]# ls

houge.txt bailongma.txt mypackage.zip

(3)解压mypackage.zip到指定目录-d

[root@hadoop101 ~]# unzip mypackage.zip -d /opt

[root@hadoop101 ~]# ls /opt/

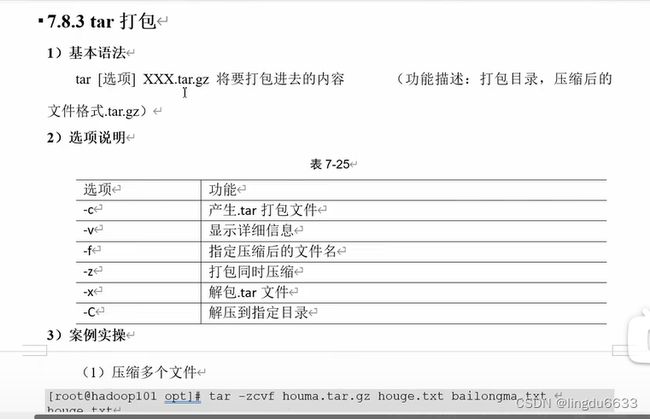

(1)压缩多个文件

[root@hadoop101 opt]# tar -zcvf houma.tar.gz houge.txt bailongma.txt

houge.txt

bailongma.txt

[root@hadoop101 opt]# ls

houma.tar.gz houge.txt bailongma.txt

(2)压缩目录

[root@hadoop101 ~]# tar -zcvf xiyou.tar.gz xiyou/

xiyou/

xiyou/mingjie/

xiyou/dssz/

xiyou/dssz/houge.txt

(3)解压到当前目录

[root@hadoop101 ~]# tar -zxvf houma.tar.gz

(4)解压到指定目录

[root@hadoop101 ~]# tar -zxvf xiyou.tar.gz -C /opt

[root@hadoop101 ~]# ll /opt/

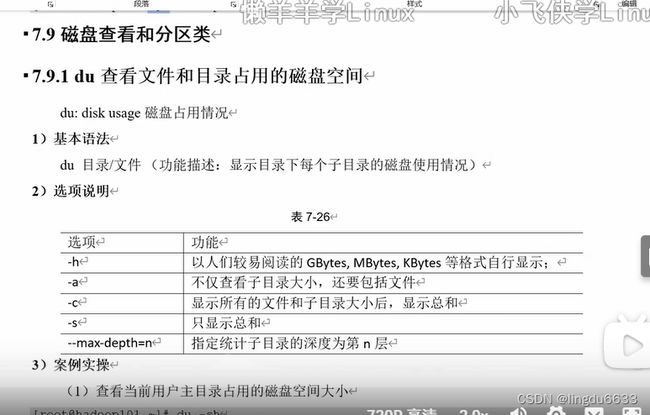

[root@hadoop101 ~]# du -sh

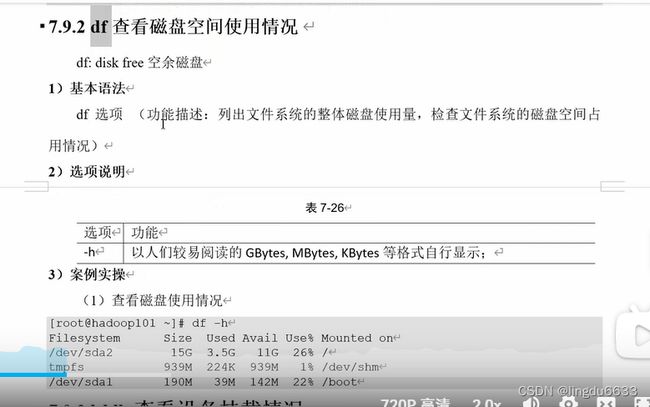

1)查看磁盘使用情况

[root@hadoop101 ~]# df -h

Filesystem Size Used Avail Use% Mounted on

/dev/sda2 15G 3.5G 11G 26% /

tmpfs 939M 224K 939M 1% /dev/shm

/dev/sda1 190M 39M 142M 22% /boot

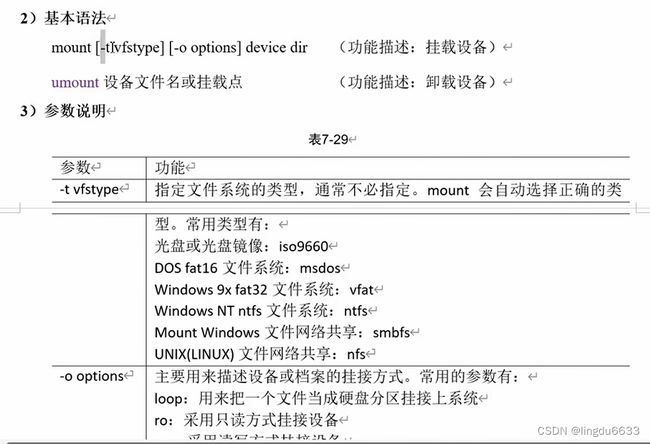

1)挂载光盘镜像文件

[root@hadoop101 ~]# mkdir /mnt/cdrom/ 建立挂载点

[root@hadoop101 ~]# mount -t iso9660 /dev/cdrom /mnt/cdrom/ 设备/dev/cdrom

挂载到 挂载点 : /mnt/cdrom 中

[root@hadoop101 ~]# ll /mnt/cdrom/

(2)卸载光盘镜像文件

[root@hadoop101 ~]# umount /mnt/cdrom

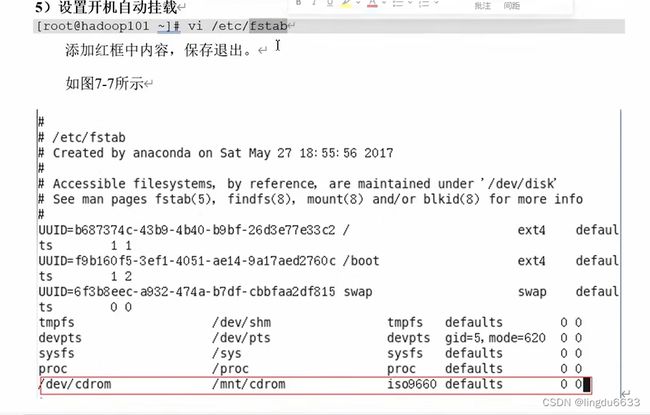

5)设置开机自动挂载

[root@hadoop101 ~]# vi /etc/fstab

Mount /dev/cdrom /mnt/cdrom

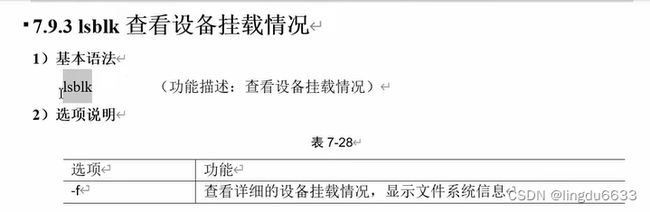

Lsblk

Umount /dev/cdrom

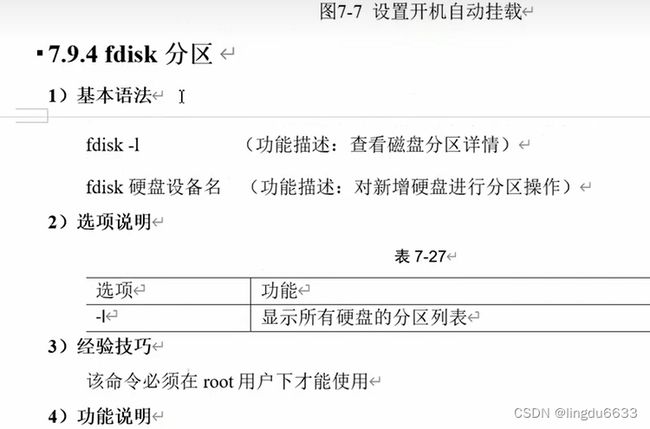

(1)Linux 分区

Device:分区序列

Boot:引导

Start:从X磁柱开始

End:到Y磁柱结束

Blocks:容量

Id:分区类型ID

System:分区类型

(2)分区操作按键说明

m:显示命令列表

p:显示当前磁盘分区

n:新增分区

w:写入分区信息并退出

q:不保存分区信息直接退出

1)查看系统分区情况

[root@hadoop101 /]# fdisk -l

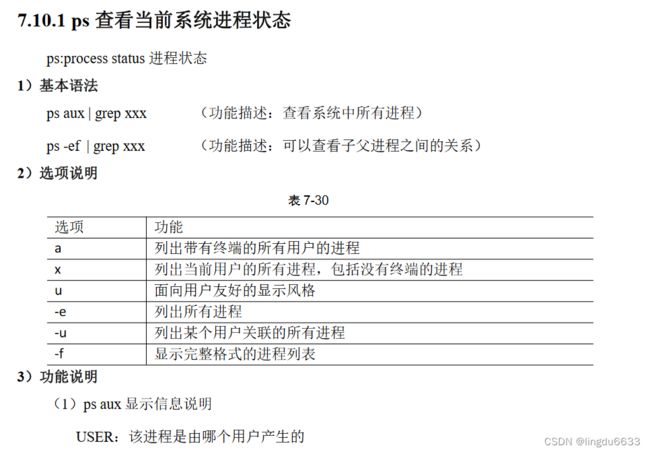

8.进程管理类

进程是正在执行的一个程序或命令,每一个进程都是一个运行的实体,都有自己的地

址空间,并占用一定的系统资源。

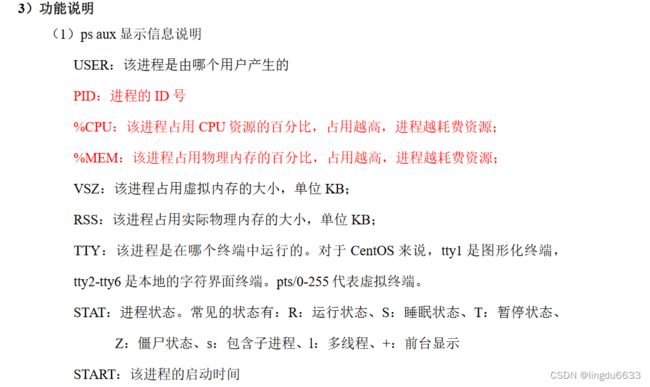

(2)ps -ef 显示信息说明

UID:用户 ID

PID:进程 ID

PPID:父进程 ID

C:CPU 用于计算执行优先级的因子。数值越大,表明进程是 CPU 密集型运算,

执行优先级会降低;数值越小,表明进程是 I/O 密集型运算,执行优先级会提高

STIME:进程启动的时间

TTY:完整的终端名称

TIME:CPU 时间

CMD:启动进程所用的命令和参数

4)经验技巧

如果想查看进程的 CPU 占用率和内存占用率,可以使用 aux;

如果想查看进程的父进程 ID 可以使用 ef;

5)案例实操

[root@hadoop101 datas]# ps aux

[root@hadoop101 datas]# ps -ef

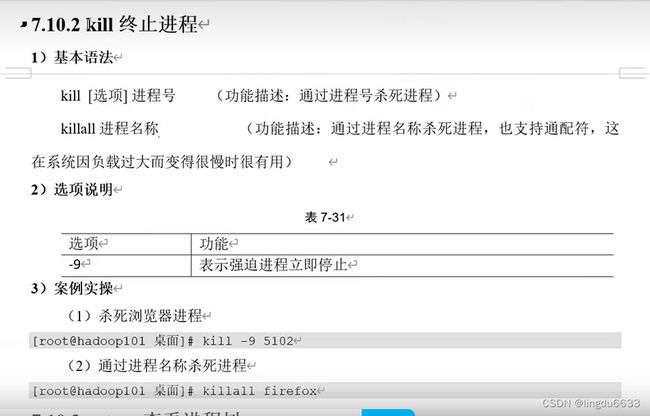

(1)杀死浏览器进程

[root@hadoop101 桌面]# kill -9 5102

(2)通过进程名称杀死进程

[root@hadoop101 桌面]# killall firefox

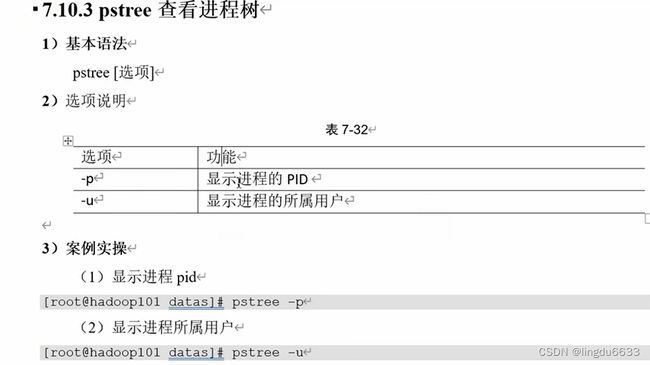

1)显示进程 pid

[root@hadoop101 datas]# pstree -p

(2)显示进程所属用户

[root@hadoop101 datas]# pstree -u

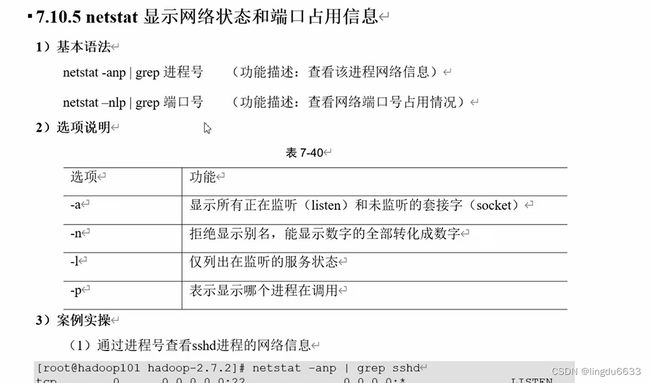

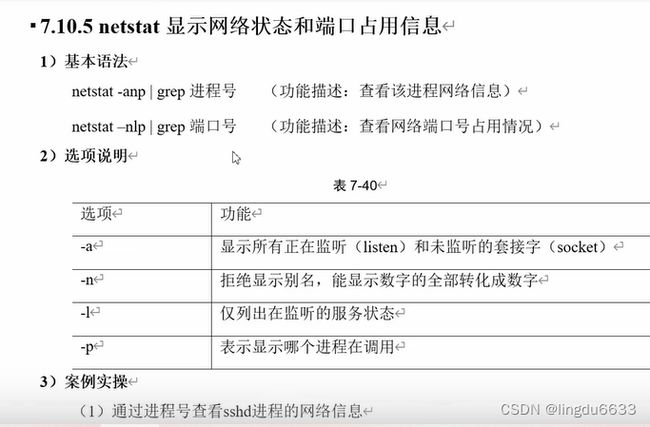

[root@hadoop101 hadoop-2.7.2]# netstat -anp | grep sshd

(2)查看某端口号是否被占用

[root@hadoop101 桌面]# netstat -nltp | grep 22

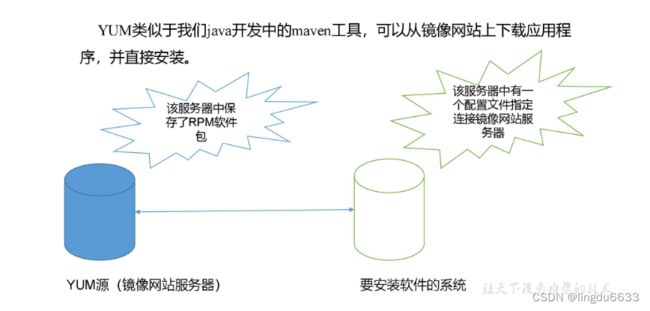

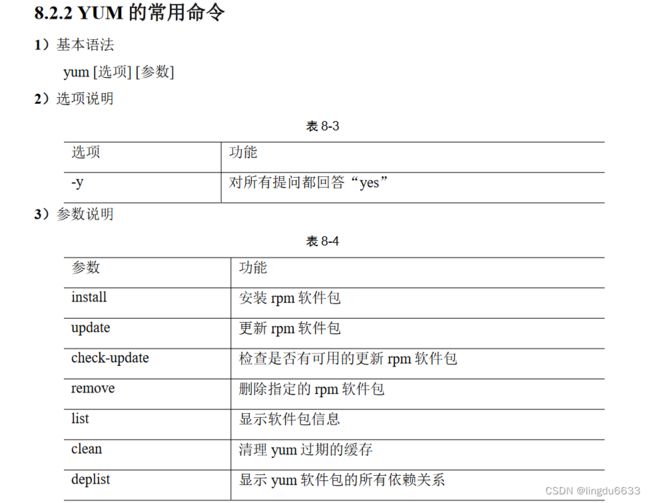

9.yum

(1)采用 yum 方式安装 firefox

[root@hadoop101 ~]#yum -y install firefox

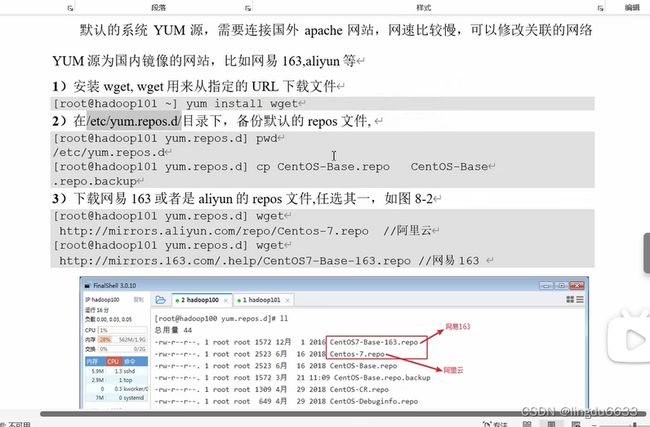

8.2.3 修改网络 YUM 源

默认的系统 YUM 源,需要连接国外 apache 网站,网速比较慢,可以修改关联的网络

YUM 源为国内镜像的网站,比如网易 163,aliyun 等

1)安装 wget, wget 用来从指定的 URL 下载文件

[root@hadoop101 ~] yum install wget

2)在/etc/yum.repos.d/目录下,备份默认的 repos 文件,

[root@hadoop101 yum.repos.d] pwd

/etc/yum.repos.d

[root@hadoop101 yum.repos.d] cp CentOS-Base.repo CentOS-Base

.repo.backup

3)下载网易 163 或者是 aliyun 的 repos 文件,任选其一,如图 8-2

[root@hadoop101 yum.repos.d] wget

http://mirrors.aliyun.com/repo/Centos-7.repo //阿里云

[root@hadoop101 yum.repos.d] wget

http://mirrors.163.com/.help/CentOS7-Base-163.repo //网易 163