【具身智能综述1】A Survey of Embodied AI: From Simulators to Research Tasks

论文标题:A Survey of Embodied AI: From Simulators to Research Tasks

论文作者:Jiafei Duan, Samson Yu, Hui Li Tan, Hongyuan Zhu, Cheston Tan

论文原文:https://arxiv.org/abs/2103.04918

论文出处:IEEE Transactions on Emerging Topics in Computational Intelligence

论文被引:101(10/20/2023)

论文代码:–

Summary

Abstract

从“internet AI”时代到“embodied AI”时代出现了一种新兴的范式转变,其中AI算法和智能体(agent)不再从主要主要来自互联网的图像、视频或文本数据集中学习。取而代之的是,它们通过与环境的互动,从类似人类的自我中心感知(egocentric perception)中学习。因此,对支持各种具身人工智能(embodied AI)研究任务的具身人工智能模拟器(simulators)的需求大幅增长。人们对具身人工智能的兴趣与日俱增,这有利于人们对人工通用智能(AGI)的更大追求,但目前还没有对这一领域进行全面的综述。本文旨在为具身人工智能领域提供一份从模拟器到研究的百科全书式综述报告。通过用我们提出的七大特点评估目前的九种具身人工智能模拟器,本文旨在了解这些模拟器在具身人工智能研究中的应用及其局限性。最后,本文概述了具身人工智能的三大研究任务–视觉探索,视觉导航和具身问答(QA),涵盖了最先进的方法、评估指标和数据集。最后,本文将根据对该领域的综述所获得的新见解,为选择任务模拟器提出建议,并为该领域的未来发展方向提出建议。

I. INTRODUCTION

最近,深度学习、强化学习、计算机图形学和机器人学领域取得的进展,使人们对开发通用人工智能系统的兴趣与日俱增。因此,人们开始从互联网人工智能(Internet AI)转向具身人工智能(Embodied AI)。互联网人工智能侧重于从互联网上的图像、视频和文本数据集中学习,而具身人工智能则使人工智能体能够通过与周围环境的互动来学习。具身人工智能认为,真正的智能可以从智能体(Agent)与环境的交互(interaction)中产生[1]。但就目前而言,具身人工智能是将视觉、语言和推理等传统智能概念融入人工具身,以帮助解决虚拟环境中的人工智能问题。

随着人们对具身人工智能的兴趣与日俱增,旨在忠实再现物理世界的具身人工智能模拟器也取得了重大进展。这些模拟世界可作为虚拟试验台,在将具身人工智能框架部署到真实世界之前对其进行训练和测试。这些具身人工智能模拟器还有助于收集基于任务的数据集[2]、[3],而在现实世界中收集这些数据集是非常乏味的,因为要复制与虚拟世界相同的环境需要大量的人工劳动。虽然在具身人工智能领域有几篇综述论文[4]-[6],但它们大多已经过时,因为它们都是在现代深度学习时代(2009 年左右开始)之前发表的[7]-[10]。据我们所知,目前只有一篇关于评估具身导航的综述论文 [11] 。

为了解决当代关于具身人工智能这一新兴领域的综合综述论文匮乏的问题,我们提出了这篇关于具身人工智能领域(从模拟器到研究任务)的综述论文。本文涵盖了过去四年中开发的以下九种具身人工智能模拟器:

- DeepMind Lab [12]

- AI2-THOR [13]

- CHALET [14]

- VirtualHome [15]

- VRKitchen [16]

- Habitat-Sim [17]

- iGibson [18]

- SAPIEN [19]

- ThreeDWorld [20]

所选模拟器是为通用智能任务而设计的,与游戏模拟器[21]不同,后者仅用于训练强化学习智能体。这些具身人工智能模拟器在计算机模拟中提供了现实世界的真实再现,主要采用房间或公寓的配置,为环境提供某种形式的约束。这些模拟器大多由物理引擎、Python API 和可在环境中控制或操纵的人工智能体组成。

具身人工智能模拟器催生了一系列潜在的具身人工智能研究任务,如视觉探索(visual exploration)、视觉导航(visual navigation)和具身QA(embodied QA)。我们将重点讨论这三个任务,因为大多数现有的具身人工智能论文[11]、[22]、[23]要么集中在这些任务上,要么利用为这些任务引入的模块来为视听导航等更复杂的任务建立模型。这三种任务之间的联系也越来越复杂。视觉探索是视觉导航中非常有用的组成部分[22]、[24],并可用于现实情况[25]、[26],而具身QA则进一步涉及建立在视觉和语言导航基础上的复杂QA能力。由于语言是一种常见的模态,而视觉QA又是人工智能领域的热门任务,因此具身QA自然是具身人工智能的一个发展方向。本文所讨论的这三项任务已在九种仿真人工智能模拟器中的至少一种中实现。不过,本文将不涉及 Sim2Real [27]-[29] 和物理世界中的机器人技术。

这些模拟器是根据计算机视觉与模式识别会议(CVPR)上的具身人工智能年度研讨会[30]的具身人工智能挑战赛中的具身人工智能模拟器挑选出来的。研究任务则来自对这些模拟器的直接引用。

为此,我们将通过回顾该领域从模拟器到研究的发展历程,对具身人工智能模拟器和研究进行一次当代的全面综述。在第一节中,本文概述了本综述报告的概览结构。在第二部分,本文对九种具身人工智能模拟器进行了基准测试,以了解它们在逼真度、可扩展性、交互性等方面的表现,从而了解它们在具身人工智能研究中的应用。最后,在模拟器的基础上,本文将在第三节中对具身人工智能的三个主要研究任务–视觉探索、视觉导航和具身问题解答(QA)–进行综述,内容包括最新方法、评估和数据集。最后,本文将在第四部分建立模拟器、数据集和研究任务之间的相互联系,以及具身人工智能模拟器和研究方面的现有挑战。本综述报告全面审视了新兴的具身人工智能领域,并进一步揭示了该领域的新见解和新挑战。此外,通过本文,我们试图帮助人工智能研究人员为他们感兴趣的研究任务选择理想的具身人工智能模拟器。

II. SIMULATORS FOR EMBODIED AI

在本节中,将在补充材料中介绍具身人工智能模拟器的背景,并在 II-A 节中对具身人工智能模拟器的特点进行比较和讨论。

A. Embodied AI Simulators

本节介绍了九种具身人工智能模拟器的背景: DeepMind Lab、AI2-THOR、SAPIEN、VirtualHome、VRKitchen、ThreeDWorld、CHALET、iGibson 和 Habitat-Sim。有关各模拟器的更多详情,读者可参阅补充材料。在本节中,本文将根据七项技术特征,对九种具身人工智能模拟器进行全面比较。参考文献[13]、[20]和[31],本文选择这七项技术特征作为评估具身人工智能模拟器的主要特征,因为它们涵盖了准确复制环境、交互和物理世界状态所需的基本方面,从而为测试具身智能提供了合适的测试平台。请参阅表 I,这七个特征分别是:环境、物理、物体类型、物体属性、控制器、动作和多智能体。

环境(Environment):构建人工智能模拟器环境的方法主要有两种:基于游戏的场景构建(G)和基于世界的场景构建(W)。如图 1 所示,基于游戏的场景由三维资产构建,而基于世界的场景则由真实世界的物体和环境扫描构建。

- 完全由三维资产构建的三维环境通常具有内置的物理特性和物体类别,与真实世界扫描环境的三维网格相比,这些特性和类别具有良好的分割性。对三维资产进行清晰的物体细分后,就很容易将其建模为具有可移动关节的铰接物体,如 PartNet [32] 中提供的三维模型。

- 相比之下,真实世界的环境和物体扫描提供了更高的保真度和更准确的真实世界表现,有利于更好地将智能体性能从模拟转移到真实世界。如表 I 所示,除 Habitat-Sim 和 iGibson 外,大多数模拟器都有基于游戏的场景,因为基于世界的场景构建需要更多资源。

物理学(Physics):模拟器不仅需要构建逼真的环境,还需要模拟真实世界物理特性的智能体与物体或物体与物体之间的逼真交互。我们研究了模拟器的物理特性,并将其大致分为基本物理特性(B)和高级物理特性(A)。参照图 2,基本物理特性包括碰撞(collision),刚体动力学(rigid-body dynamics)和重力建模(gravity modelling),而高级物理特性包括布(cloth)、流体(fluid)和软体物理(soft-body physics)。由于大多数人工智能模拟器在构建基于游戏的场景时都内置了物理引擎,因此它们都具备基本的物理功能。另一方面,对于像 ThreeDWorld 这样的模拟器,其目标是了解复杂的物理环境如何影响人工智能体在环境中的决策,因此它们配备了更高级的物理特征。对于侧重于交互式导航任务的模拟器来说,基本的物理特征一般就足够了。

物体类型(Object Type):如图 3 所示,用于创建模拟器的物体主要有两种来源。

- 第一种是数据集驱动环境,其中的物体主要来自现有的物体数据集,如 SUNCG 数据集[33]、Matterport3D 数据集[34]和 Gibson 数据集[35]。

- 第二类是资产驱动环境,其中的物体来自网络,如 Unity 3D 游戏资产存储。

这两种来源的区别在于物体数据集的可持续性。数据集驱动型物体的收集成本高于资产驱动型物体,因为任何人都可以在线贡献三维物体模型。不过,与数据集驱动型物体相比,资产驱动型物体更难确保三维物体模型的质量。根据我们的研究,基于游戏的人工智能模拟器更倾向于从资产库中获取物体数据集,而基于世界的模拟器则倾向于从现有的三维物体数据集中导入物体数据集。

物体属性(Object Property):有些模拟器只支持具有基本交互性(如碰撞)的物体。而高级模拟器则能使物体具有更精细的交互性,如多状态变化(multiple-state changes)。例如,当苹果被切片时,它会发生状态变化,变成苹果片。因此,我们将这些不同层次的物体交互分为具有可交互物体(interact-able objects,I)和多状态物体(multiple-state objects,M)的模拟器。参照表 I,一些模拟器(如 AI2-THOR 和 VRKitchen)可实现多种状态变化,为了解物体在真实世界中如何反应和改变状态提供了一个平台。

控制器(Controller):参见图 4,用户与模拟器之间有不同类型的控制器接口,从直接 Python API 控制器(P),虚拟机器人控制器(R)到虚拟现实控制器(V)。具身机器人允许与现有的现实世界机器人(如 Universal Robot 5(UR5)和 TurtleBot V2)进行虚拟交互,并可直接使用 ROS 界面进行控制。虚拟现实控制器接口可提供更身临其境的人机交互,并便于使用现实世界中的对应设备进行部署。例如,iGibson 和 AI2-THOR 等主要用于视觉导航的模拟器也配备了虚拟机器人控制器,以方便分别部署到 iGibson’s Castro [36] 和 RoboTHOR [37] 等现实世界中。

行动(Action):在具身人工智能模拟器中,人工智能智能体的行动能力存在复杂程度的差异,从只能执行初级导航操纵到通过虚拟现实界面执行更高级的人机交互行动。本文将它们分为机器人操纵的三个层次:导航(Navigation,N),原子动作(atomic action,A)和人机交互(human-computer interaction,H)。

- 导航是最底层,是所有具身人工智能模拟器的共同特征[38]。它由智能体在虚拟环境中的导航能力定义。

- 原子动作为人工智能智能体提供了对感兴趣的物体进行基本离散操作的手段,在大多数人工智能模拟器中都能找到。

- 人机交互是虚拟现实控制器的成果,因为它能让人类控制虚拟智能体与模拟世界实时学习和互动[16]。

大多数基于导航的大型模拟器,如 AI2-THOR、iGibson 和 HabitatSim,往往具有导航、原子动作和 ROS [13],[17],[35],这使它们能够在执行点导航或物体导航等任务时更好地控制和操纵环境中的物体。另一方面,ThreeDWorld 和 VRKitchen 等模拟器[16],[20] 属于人机交互类别,因为它们的构造是为了提供高度逼真的物理模拟和多种状态变化。这只有通过人机交互才能实现,因为在与这些虚拟物体进行交互时,需要人类级别的灵巧性(dexterity)。

多智能体(Multi-agent):参考表 I,由于目前涉及多智能体强化学习的研究很少,只有少数模拟器(如 AI2-THOR、iGibson 和 ThreeDWorld)配备了多智能体设置。一般来说,模拟器需要有丰富的物体内容,然后才能构建出用于对抗和协作训练的多智能体特征[39],[40]。由于缺乏多智能体支持的模拟器,在这些具身人工智能模拟器中利用多智能体特征的研究任务也较少。

对于基于强化学习的多机器人训练,目前仍在 OpenAI Gym 环境中进行 [41]。有两种不同的多智能体设置。

- 第一种是 ThreeDWorld [20]中的 avatar-based (AT)的多智能体,允许人工智能体和模拟头像之间进行交互。

- 第二种是 AI2-THOR [13]中基于用户(U)的多智能体,它可以扮演双重学习网络的角色,通过与模拟中的其他人工智能体互动学习,以完成共同的任务 [42]。

B. Comparison of Embodied AI Simulators

根据这七个特征和艾伦人工智能研究所(Allen Institute of Artificial Intelligence)[31]关于具身人工智能的研究,我们提出了模拟器的第二套评估特征。如表一所示,它包括三个关键特征:逼真度(realism),可扩展性(scalability)和交互性(interactivity)。

- 三维环境的逼真度可归因于模拟器的环境和物理特性。环境模拟现实世界的物理外观,而物理模拟现实世界中复杂的物理属性。

- 三维环境的可扩展性可归因于物体类型。对于数据集驱动的物体,可通过收集更多现实世界的三维扫描数据来扩展;对于资产驱动的物体,可通过购买更多三维资产来扩展。

- 交互性可归因于物体属性、控制器、动作和多智能体。

根据具身人工智能模拟器的次要评价特征,表 I 中的七个主要特征和图 6,具备上述三个次要特征的模拟器(如AI2-THOR、iGibson和Habitat-Sim)更受欢迎,并被广泛用于各种具身人工智能研究任务。此外,我们还对所有具身人工智能模拟器进行了全面的定量比较,以比较每个模拟器的环境配置和技术性能。环境配置功能在很大程度上取决于模拟器创建者建议的应用,而其他功能,如技术规格和渲染性能,则在很大程度上取决于创建时使用的模拟引擎。与其他模拟器相比,AI2-THOR 具有最大的环境配置,而 Habitat-Sim 和 iGibson 则在图形渲染性能方面名列前茅。表 II 所示的这一量化性能基准进一步证明了这三种化身人工智能模拟器的优越性和复杂性。这些对具身人工智能模拟器的比较进一步加强了本文所确立的七个主要评估指标和三个次要评估指标的重要性,有助于为研究任务选择理想的模拟器。

III. RESEARCH IN EMBODIED AI

在本节中,我们将讨论依赖于上一节中综述的九种具身人工智能模拟器的各种具身人工智能研究任务。近来具身人工智能研究的增长有多种动因。从认知科学和心理学的角度来看,具身假说[1]认为,智能产生于与环境的互动,是感觉运动活动的结果[66]。直观地说,人类并不只是通过互联网人工智能范式来学习,在这种范式中,大多数经验都是随机和被动的(即外部策划的)。人类还通过主动感知、运动、互动和交流来学习。从人工智能的角度来看,与传统方法相比,目前的具身人工智能研究任务由于涉及到学习,因此可以使机器人能力(如绘图和导航)在未知环境中具有更强的泛化能力[44],对传感器噪声也具有更强的鲁棒性。由于深度、语言[59]和音频[67]等各种模式可以通过基于学习的方法轻松整合,因此具身人工智能还具有灵活性,并可能带来更高的性能。

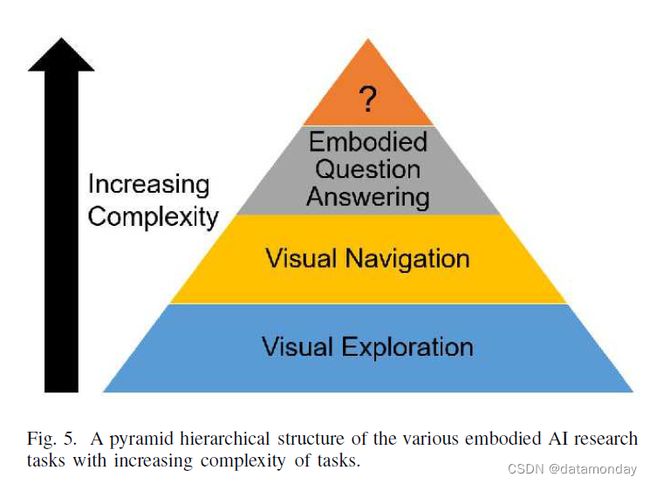

具身人工智能研究任务的三大类型是视觉探索、视觉导航和具身QA。我们将把重点放在这三种任务上,因为大多数现有的具身人工智能论文都集中在这些任务上,或者利用为这些任务引入的模块来为更复杂的任务(如视听导航)建立模型。从探索到QA,任务的复杂性不断增加。我们将先从视觉探索开始,然后是视觉导航,最后是体现式QA。如图 5 所示,这些任务中的每一个都是下一个任务的基础,形成了一个具身人工智能研究任务的金字塔结构,进一步表明了具身人工智能的自然发展方向。我们将重点介绍每个任务的重要方面,从摘要、方法、评估指标到数据集。这些任务的详细信息见表 III。

A. Visual Exploration

在视觉探索中[24],[68],智能体通常通过运动和感知收集三维环境信息,以更新其内部环境模型[11],[22],这可能对视觉导航(visual navigation)等下游任务有用[24],[25],[69]。这样做的目的是尽可能提高效率(例如,尽可能减少步骤)。内部模型可以是拓扑图(topological graph map)[26]、语义图(semantic map)[46]、占位图(occupancy map)[45]或空间记忆(spatial memory)[70], [71]等形式。这些基于图的架构(map-based architectures)可以捕捉几何图形和语义,与反应式(reactive)和递归神经网络策略[72]相比,可以实现更高效的策略学习和规划[45]。视觉探索通常在导航任务之前或同时进行。

- 在第一种情况下,视觉探索会建立内部记忆,作为下游导航任务中路径规划的先验。在导航开始前,智能体可在一定预算(如有限的步数)内自由探索环境[11]。

- 在后一种情况下,智能体在导航未见过的测试环境时构建地图[48],[73],[74],这使得它与下游任务结合得更加紧密。

在本节中,我们将以现有的可视化探索研究论文[22],[24]为基础,纳入更多最新的研究成果和方向。

在传统的机器人技术中,探索是通过被动或主动的同步定位和绘图(simultaneous localisation and mapping,SLAM)[24], [45]来完成的,以建立环境地图。然后将该地图与定位和路径规划一起用于导航任务。SLAM 的研究非常深入 [75],但纯粹的几何方法仍有改进的余地。由于它们依赖于传感器,因此容易受到测量噪声的影响[24],需要进行大量的微调。另一方面,基于学习的方法通常使用 RGB 和/或深度传感器,对噪声具有更强的鲁棒性 [24], [44]。此外,视觉探索中基于学习的方法允许人工智能结合语义理解(如环境中的物体类型)[45],并以无监督的方式归纳其先前所见环境的知识,以帮助理解新环境。这就减少了对人类的依赖,从而提高了效率。

学会以地图的形式创建有用的内部环境模型,可以提高机器人的性能[45],无论是在完成任务之前(即未指定的下游任务)还是与下游任务同时进行,都是如此。智能探索对于需要探索随时间动态发展的新环境的智能体也特别有用[76],例如救援机器人和深海探索机器人。

1)方法:在本节中,视觉探索中的非基准方法通常被形式化为部分观测马尔可夫决策过程(POMDP)[77]。POMDP 可以用一个 7 元组(S, A, T, R, Ω, O, γ)来表示,其中包含状态空间 S、行动空间 A、transition distribution T、奖励函数 R、观察空间 Ω、观察分布 O 和discount factor γ ∈ [0, 1]。一般来说,这些方法被视为 POMDP 中的特定奖励函数[22]。

基线(Baselines)。视觉探索有几种常见的基线[22]。对于随机行动 [17],智能体从所有行动的均匀分布中采样。对于前向行动,它总是选择前向行动。对于前向行动+,行为体选择前向行动,但如果发生碰撞则向左转。对于前沿探索(frontier-exploration),它使用地图[24], [78]迭代访问自由空间和未探索空间之间的边缘。

好奇心(Curiosity)。在好奇心方法中,智能体寻找难以预测的状态。预测误差被用作强化学习的奖励信号 [79], [80]。这种方法侧重于内在奖励和动机,而不是来自环境的外部奖励,这在外部奖励稀少的情况下是有益的 [81]。

- 通常有一个前向动力学模型,可使损失最小化: L ( s ^ t + 1 , s t + 1 ) L(\hat{s}_{t+1}, s_{t+1}) L(s^t+1,st+1)。在这种情况下, s ^ t + 1 \hat{s}_{t+1} s^t+1 是预测的下一个状态,如果智能体处于状态 s t s_t st 时采取行动,而 s t + 1 s_{t+1} st+1 则是智能体最终实际进入的下一个状态。

- 好奇心的实际考虑因素已在最近的研究中列出[79],例如使用近端策略优化(Proximal Policy Optimization,PPO)进行策略优化。

在最近的研究中,好奇心已被用于生成语义地图等更高级的地图[43]。

- 随机性对好奇心方法提出了严峻的挑战,因为前向动力学模型可以利用随机性[79]获得高预测误差(即高回报)。这可能是由于 “noisy-TV” 问题或智能体行动执行过程中的噪声等因素造成的[81]。

- 一种建议的解决方案是使用反动力学模型 [68],该模型能估算出智能体从之前的状态 st-1 到当前状态 st 所采取的行动 at-1,从而帮助智能体了解其行动在环境中能控制什么。虽然这种方法试图解决环境造成的随机性问题,但它可能不足以解决智能体行动造成的随机性问题。其中一个例子是,智能体使用遥控器随机更换电视频道,使其在没有进展的情况下积累奖励。

- 为了专门解决这个更具挑战性的问题,最近提出了一些方法。随机蒸馏网络 [82] 是一种预测随机初始化神经网络输出的方法,因为答案是其输入的确定性函数。

- 另一种方法是分歧探索(Exploration by Disagreement)[81],即激励智能体探索行动空间,该行动空间与一系列前向动力学模型的预测之间存在最大的分歧或差异。这些模型收敛到平均值,从而降低了集合的方差,防止其陷入随机性陷阱。

覆盖(Coverage)。在覆盖方法中,智能体试图最大限度地增加其直接观察到的目标数量。通常情况下,这就是在环境中看到的区域[22], [24], [44]。由于机器人使用的是以自我为中心的观测方法,因此必须根据可能存在障碍的三维结构进行导航。

- 最近的一种方法结合了传统方法和基于学习的方法 [44]。该方法使用分析路径规划器(analytical path planners)和学习型 SLAM 模块,后者可维护空间地图,以避免端到端策略训练中的高样本复杂性。该方法还包括噪声模型,以提高物理逼真度,从而提高现实世界机器人技术的通用性。

- 另一项最新成果是场景记忆Transformer,它在其策略网络中的场景记忆[72]上使用了从Transformer模型[83]改编而来的自我注意机制。场景记忆嵌入并存储所有遇到的观察结果,与需要归纳偏差的地图式记忆相比,具有更大的灵活性和可扩展性。

重构(Reconstruction)。在重构方法中,智能体试图从观察到的视图中重建其他视图。过去的工作主要集中在 360 度全景图和 CAD 模型的像素重建上 [84], [85],这些通常是由人类拍摄的照片组成的数据集 [45]。最近的研究已将这种方法应用于具身人工智能,这种人工智能更为复杂,因为模型必须根据智能体的自我中心观察和对自身传感器的控制(即主动感知)进行场景重建。

- 在最近的一项工作中,智能体利用其自中心 RGB-D 观察结果重建可见区域以外的占用状态,并随着时间的推移汇总其预测结果,形成精确的占用图(occupancy map)[45]。占用预测是一项像素分类任务,在摄像机前方 V x V 个单元的局部区域中,每个单元都被赋予被探索和占用的概率。与覆盖方法相比,预测占用状态可以让智能体处理无法直接观察到的区域。

- 另一项最新研究侧重于语义重建而非像素重建[22]。该智能体旨在预测 “门” 等语义概念是否出现在采样查询位置。使用 K-means 方法,查询位置的真正重构概念是与其特征表示最接近的 J 个聚类中心点。如果智能体获得的视图能帮助它预测采样查询视图的真正重构概念,那么它就会得到奖励。

2)评估指标:访问目标(targets visited)的数量。我们考虑了不同类型的目标,如区域 [44], [86] 和有趣的物体 [72], [87]。访问面积指标有几种变体,如以 m2 为单位的绝对覆盖面积和场景中已探索区域的百分比。

对下游任务的影响。视觉探索性能还可以通过其对视觉导航等下游任务的影响来衡量。这一评估指标类别在近期的研究中较为常见。利用视觉探索输出(即地图)的下游任务包括图像导航[26]、[73]、点导航[11]、[44]和物体导航[53]、[54]、[56]。有关这些导航任务的更多详情,请参阅第 III-B 节。

3)数据集:在视觉探索方面,一些流行的数据集包括 Matterport3D 和 Gibson V1。Matterport3D 和 Gibson V1 都是逼真的 RGB 数据集,其中包含深度和语义分割等对具身人工智能有用的信息。Habitat-Sim 模拟器允许使用这些具有额外功能(如可配置的智能体和多个传感器)的数据集。Gibson V1 还增强了交互和真实机器人控制等功能,形成了 iGibson。不过,像第二节中提到的那些最新的三维模拟器都可以用于视觉探索,因为它们至少都能提供 RGB 观测。

B. Visual Navigation

在视觉导航中,智能体可在有或没有外部先验或自然语言指令的情况下,在三维环境中向目标导航。这项任务使用了许多类型的目标,如点、物体、图像 [88]、[89] 和区域 [11]。本文将重点讨论点和物体作为视觉导航的目标,因为它们是最常见、最基本的目标。它们可以进一步与感知输入和语言等规范相结合,从而构建出更复杂的视觉导航任务,如带有先验的导航、视觉与语言导航,甚至是具身QA(Embodied QA)。

- 在点导航[49]中,智能体的任务是导航到一个特定的点。

- 在物体导航[38]、[52]中,智能体的任务是导航到一个特定类别的物体。

经典的导航方法[90]通常由人工设计的子组件组成,如定位,映射[91],路径规划[92],[93]和运动。具身人工智能中的视觉导航旨在从数据中学习这些导航系统,以减少特定情况下的手工工程,从而便于与数据驱动学习方法(如问题解答[23])性能优越的下游任务整合。还有一些混合方法[44],旨在将两者的优点结合起来。如前文第二节所述,基于学习的方法对传感器测量噪声的鲁棒性更强,因为它们使用 RGB 和/或深度传感器,并能结合对环境的语义理解。此外,这些方法还能让智能体在无监督的情况下,将其对以前所见环境的了解用于帮助理解新环境,从而减少人力。

近年来,随着研究的增加,在基本的点导航和物体导航任务中也组织了视觉导航挑战赛,以确定基准并加速人工智能的发展[38]。最著名的挑战赛有 iGibson Sim2Real Challenge、Habitat Challenge [36] 和 RoboTHOR Challenge。对于每项挑战,我们将介绍 2020 年版本的挑战,也就是截至本文发表时的最新版本。在所有三项挑战中,智能体都仅限于以自我为中心的 RGB-D 观察。

- 对于 2020 年的 iGibson Sim2Real 挑战赛,具体任务是点导航。73 个高质量的 Gibson 3D 场景用于训练,而 Castro 场景,即真实世界公寓的重建,将用于训练、开发和测试。有三种情况:环境中没有障碍物,包含智能体可以互动的障碍物,和/或有其他移动智能体。

- 对于 Habitat Challenge 2020,既有点导航任务,也有物体导航任务。点导航任务使用 Gibson 数据集分割的 Gibson 3D 场景,而物体导航任务使用原始数据集[11],[34]规定的 61/11/18 训练/验证/测试屋分割的 90 个 Matterport3D 场景。

- 对于 RoboTHOR Challenge 2020,只有物体导航任务。训练和评估分为三个阶段。

- 第一阶段,在 60 个模拟公寓中对机器人进行训练,并在另外 15 个模拟公寓中验证其性能。

- 在第二阶段,智能体将在四个模拟公寓及其真实世界的对应物上进行评估,以测试其在真实世界中的通用性。

- 在最后一个阶段,将在 10 个真实世界的公寓中对智能体进行评估。

在本节中,我们将以现有的视觉导航综述论文[11],[23]和[74]为基础,纳入更多最新作品。

1)分类:在最近的视觉导航文献中,点导航(Point Navigation)一直是最基础、最流行的任务之一[44]。在点导航中,智能体的任务是导航到离特定点一定固定距离内的任何位置[11]。一般来说,智能体在环境中的原点(0,0,0)初始化,固定目标点由相对于原点/初始位置的三维坐标(x,y,z)指定[11]。为了顺利完成任务,人工智能体需要具备多种技能,如视觉感知(visual perception),事件记忆构建(episodic memory construction),推理/规划(reasoning/planning)和导航(navigation)。人工智能体通常配有 GPS 和指南针,可以获取其位置坐标,并隐含其相对于目标位置的方位[17], [49]。目标的相对目标坐标可以是静态的(即只在事件开始时给出一次),也可以是动态的(即在每个时间步给出)[17]。最近,由于室内环境中的定位功能不完善,Habitat Challenge 2020 转向了更具挑战性的任务[47],即在没有 GPS 和指南针的情况下进行基于 RGBD 的在线定位。

近期文献中出现了许多基于学习的点导航方法。

- 其中较早的一篇论文[74]采用端到端方法,在现实的自主导航环境中(即没有ground-truth maps和ground-truth agent’s poses的未知环境),利用不同的感官输入解决点导航问题。

- 基础导航算法是Direct Future Prediction(DFP)[94],其中相关输入(如彩色图像、深度图和最近四次观测的行动)由适当的神经网络(如用于感官输入的卷积网络)处理,并连接到双流全连接行动预期网络(two-stream fully connected action-expectation network)中。输出是对所有行动和未来时间步骤的未来测量预测(future measurement predictions)。

作者还引入了 Belief DFP (BDFP),旨在通过在未来测量预测中引入类似于中间地图的表征,使 DFP 的黑箱策略更具可解释性。其灵感来自神经网络中的注意力机制,以及强化学习中的后继表征(successor representations)[95],[96]和特征[97]。实验表明,BDFP 在大多数情况下优于 DFP,经典导航方法通常优于基于 RGB-D 输入的学习方法。[98]提供了一种更模块化的方法。对于点导航,SplitNet 的架构由一个视觉编码器和多个解码器组成,用于不同的辅助任务(如自我运动预测)和策略。这些解码器旨在学习有意义的表征。采用相同的 PPO 算法[99]和行为克隆训练(behavioral cloning training),SplitNet 可在以前未见过的环境中超越同类端到端方法。

另一项研究提出了一种模块化架构,用于在室内环境中同时进行地图绘制和目标驱动导航[48]。在这项工作中,作者在 MapNet [71] 的基础上增加了具有语义特征的 2.5D 记忆,并为导航策略训练了一个 LSTM。他们的研究表明,在以前未见过的环境中,这种方法优于不带地图的 LSTM 策略 [100]。

随着 2019 年 Habitat Challenge 及其标准化评估、数据集和传感器设置的推出,最近的方法已通过 2019 年 Habitat Challenge 进行了评估。第一项工作来自 Habitat Challenge 背后的团队,采用了 PPO 算法,actor-critic 模型结构和 CNN,为视觉输入生成嵌入。后续工作提供了一个 “存在证明(existence proof)”,即在模拟的未知环境中,拥有 GPS,指南针和巨大学习步数(25 亿步数,而 Habitat 的第一个 PPO 工作只有 7500 万步数)的智能体可以在点导航任务中取得近乎完美的结果[47]。具体来说,最佳智能体的性能是最短路径oracle的 3-5%。这项工作使用了一种改进的 PPO 算法,即分散分布式近端策略优化(Decentralized Distributed Proximal Policy Optimization,DD-PPO),该算法具有广义优势估计功能[101],适用于资源密集型模拟环境中的分布式强化学习。在每一个时间步,智能体都会接收一个以自我为中心的观测值(深度或 RGB),通过 CNN 获取嵌入信息,利用 GPS 和指南针更新目标位置,使之与其当前位置相对应,然后最终输出下一个行动和价值函数的估计值。实验结果表明,智能体在很长一段时间内都在不断改进,其结果几乎与shortest-path oracle的结果一致。

接下来的工作旨在改进这一资源密集型工作,通过辅助任务提高采样和时间效率[49]。这项工作使用与前一项工作相同的 DD-PPO 基准架构,增加了三项辅助任务:动作条件对比预测编码(action conditional contrastive predictive coding,CPC-A)[102],inverse dynamics[68]和temporal distance estimation。作者尝试了不同的表征组合方式。在 4000 万帧的情况下,性能最好的智能体达到了与前人工作相同的性能 5.5 倍的速度,甚至还提高了性能。Habitat Challenge 2019 的 RGB 和 RGBD 两个赛道的获胜者 [44] 提供了一种混合解决方案,它结合了经典方法和基于学习的方法,因为基于端到端学习的方法计算成本高昂。这项工作以模块化方式将学习纳入 “classic navigation pipeline”,从而将避障和控制知识隐含地纳入低级导航(low-level navigation)。该架构由 learned Neural SLAM 模块,全局策略,局部策略和 analytical path planner 组成。Neural SLAM 模块利用观测和传感器预测地图和智能体姿态估计值。全局策略始终将目标坐标输出为长期目标,并通过分析路径规划器将其转换为短期目标。最后,对局部策略进行训练,使其导航至该短期目标。模块化设计和分析规划的使用有助于大大减少训练过程中的搜索空间。

物体导航(Object Navigation)是最直接的任务之一,但也是人工智能中最具挑战性的任务之一。物体导航的基本思想是在一个未开发的环境中导航到一个由其标签指定的物体[38]。智能体将在一个随机位置初始化,任务是在该环境中找到一个物体类别的实例。物体导航通常比点导航更为复杂,因为它不仅需要许多相同的技能,如视觉感知和事件记忆(episodic memory)构建,还需要语义理解。这些都使得物体导航任务更具挑战性,但同时也更有价值。

物体导航任务可以通过适应(adapting)来演示或学习,这有助于在没有任何直接监督的环境中实现导航的泛化。这项工作[51]通过元强化学习(meta-reinforcement learning)方法实现了这一点,因为智能体学习了一种自监督的交互损失,这有助于鼓励有效的导航。传统的导航方法会在推理过程中冻结智能体的学习模型,与之不同的是,这项工作允许智能体以自我监督的方式学习自我调整,并在事后调整或纠正错误。这种方法可以防止智能体在意识到并做出必要纠正之前犯下过多错误。另一种方法是在执行导航规划之前学习物体之间的关系。这项工作[53]实现了一个物体关系图(object relation graph,ORG),它不是来自外部的先验知识,而是在视觉探索阶段建立的知识图。该图由物体关系组成,如类别接近度(category closeness)和空间相关性(spatial correlations)。

有先验的导航侧重于以多模态输入(如知识图谱或音频输入)的形式注入语义知识或先验,或在可见和不可见的环境中帮助训练人工智能智能体的导航任务。过去的研究[57]表明,人工智能智能体可以利用与人类类似的语义/功能先验知识,帮助智能体学习导航,并在看不见的环境中找到看不见的物体。这样的例子利用了这样一种理解,即对于感兴趣的物品,例如在厨房中寻找苹果,人类会倾向于从合理的位置开始搜索。这些知识被编码到图网络中,并在深度强化学习框架中进行训练。

还有其他利用人类先验的例子,例如人类能够感知并捕捉音频信号模态与物体物理位置之间的对应关系,从而执行导航以到达信号源。在这项工作[103]中,人工智能体采集多种感官观测数据,如目标物体的视觉和声音信号,并找出从其起始位置到声音来源的最短导航轨迹。这项工作通过视觉感知映射器(visual perception mapper),声音感知模块和动态路径规划器来实现。

视觉语言导航(Vision-and-Language Navigation,VLN)是一种让智能体学习按照自然语言指令在环境中导航的任务。这项任务的挑战在于同时感知视觉场景和语言。VLN 仍然是一项具有挑战性的任务,因为它要求智能体根据过去的行动和指令预测未来的行动[11]。此外,机器人可能无法将其轨迹与自然语言指令无缝对接。虽然视觉语言导航和视觉问题解答(VQA)看似相似,但这两项任务却有很大不同。这两项任务都可以表述为基于视觉的序列到序列转码问题。不过,VLN 序列要长得多,需要不断输入视觉数据,并能操纵摄像机视角,而 VQA 只需输入一个问题并生成答案。现在,我们能够向机器人发出自然语言指令,并期望它们执行任务 [2],[3],[58]。这些都得益于用于联合解释视觉和自然语言输入的递归神经网络方法[58]和数据集的进步,这些方法和数据集旨在简化在三维环境中导航和执行任务时基于任务的指令过程。

辅助推理导航(Auxiliary Reasoning Navigation)框架是 VLN 的一种方法[59]。它解决了四个辅助推理任务:轨迹复述(trajectory retelling),进度估计(progress estimation),角度预测(angle prediction)和跨模态匹配(cross-modal matching)。智能体学会对之前的行动进行推理,并预测任务的未来信息。

视觉-对话导航(Vision-dialog navigation)是 VLN 的最新扩展,其目的是训练机器人发展与人类进行持续自然语言对话的能力,以帮助其导航。目前在这一领域开展的工作[60]使用了跨模态记忆网络(Cross-modal Memory Network,CMN),通过独立的语言记忆和视觉记忆模块来记忆和理解与过去导航行动相关的有用信息,并进一步利用这些信息做出导航决策。

2)评估指标(Evaluation Metrics):视觉导航使用主要评价指标[11]:

- 1)(反归一化)路径长度加权成功率(success weighted by (normalized inverse) path length,SPL)可定义为: 1 N ∑ i = 1 N S i l i m a x ( p i , l i ) \frac{1}{N} \sum^N_{i=1} S_i \frac{l_i}{max(p_i,l_i)} N1∑i=1NSimax(pi,li)li。 S i S_i Si 是第 i 集的成功指标, p i p_i pi 是智能体的路径长度, l i l_i li 是最短路径长度, N N N 是 episodes 数。值得注意的是,以路径长度加权计算成功率存在一些已知问题[38]。

- 2)成功率:是指智能体在预算时间内到达目标的事件数[74]。

除上述两个指标外,还有其他一些不太常见的评价指标[11],[48],[52],[54],[74],即:

- 3)路径长度比(path length ratio),即预测路径与最短路径长度之比,仅对成功的情节进行计算;

- 4)成功距离/导航误差(distance to success/navigation error),分别测量智能体的最终位置与最近物体或目标位置周围的成功阈值边界之间的距离。

除上述四个指标外,还有两个指标用于评估 VLN 智能体。它们是

- 1)oracle success rate,即智能体沿轨迹停在离目标最近点的比率;

- 2)轨迹长度(trajectory length)。一般来说,对于 VLN 任务,最佳指标仍然是 SPL,因为它考虑到了所走的路径,而不仅仅是目标。

对于视觉-对话导航,除了成功率和oracle成功率外,还使用了另外两个指标:

- 1)目标进度(goal progress),即智能体向目标位置前进的平均进度;

- 2)oracle path success rate,即智能体沿最短路径停在离目标最近点的成功率。

3)数据集:与视觉探索一样,Matterport3D 和 Gibson V1 是最受欢迎的数据集。值得注意的是,Gibson V1 中的场景较小,通常具有较短的情节(从起始位置到目标位置的 GDSP 较低)。此外,还使用 AI2-THOR 模拟器/数据集。

与其他视觉导航任务不同,VLN 需要一种不同的数据集。大多数 VLN 作品都使用了 Matterport3D 模拟器的 Room-to-Room(R2R)数据集 [104]。该数据集包含 21,567 条导航指令,平均长度为 29 个单词。在视觉-对话导航[59]中,使用了 Cooperative Vision-and-Dialog Navigation(CVDN)[105]数据集。该数据集包括 Matterport3D 模拟器中的 2,050 次人机对话和 7,000 多条轨迹。

C. Embodied Question Answering

在最近的具身人工智能模拟器中,具身问题解答(embodied question answering,QA)任务是通用智能系统领域的一大进步。要在物理具身状态下执行 QA,人工智能智能体需要具备广泛的人工智能能力,如视觉识别、语言理解、问题解答、常识推理、任务规划和目标驱动导航等。因此,具身问答可以说是目前具身人工智能研究中最繁重、最复杂的任务。

1)分类:对于具身QA(EQA)而言,一个通用框架将任务分为两个子任务:导航任务和QA任务。导航模块是必不可少的,因为在回答相关问题之前,智能体需要探索环境,查看物体。例如,[61] 提出了规划器-控制器导航模块(Planner-Controller Navigation Module,PACMAN),该模块由导航模块的分层结构组成,规划器负责选择行动(方向),控制器负责决定每次行动后移动的距离。一旦智能体决定停止,QA模块就会利用其路径上的帧序列来执行。导航模块和视觉问题解答模块首先进行单独训练,然后由 REINFORCE [106] 进行联合训练。文献[62]和[63]利用神经模块化控制(Neural Modular Control,NMC)进一步改进了 PACMAN 模型,在该模型中,higher-level master policy提出语义子目标,由子策略执行。

多目标具身QA(Multi-target embodied QA,MT-EQA)[63] 是一种更复杂的具身QA任务,它研究的是包含多个目标的问题,例如 “卧室里的苹果比客厅里的橘子大吗?”,这样智能体就必须导航到 "卧室 "和 “客厅”,定位 "苹果 "和 “橘子”,然后进行比较来回答问题。

交互式问题解答(Interactive Question Answering,IQA)[64] 是另一项在 AI2-THOR 环境中解决具身问题解答任务的工作。IQA 是 EQA 的延伸,因为要成功回答某些问题(例如,要回答 "冰箱里有鸡蛋吗?"这个存在性问题,智能体需要打开冰箱),智能体必须与物体进行交互。[64]建议使用分层交互记忆网络(Hierarchical Interactive Memory Network,HIMN),这是一种分层控制器,可帮助系统在多个时间尺度上进行操作、学习和推理,同时降低每个子任务的复杂性。以自我为中心的空间门控循环单元(Egocentric Spatial Gated Recurrent Unit,GRU)作为记忆单元,用于保留环境的空间和语义信息。规划器模块(planner module)将控制其他模块,如运行 A 搜索以找到通往目标的最短路径的导航器,执行旋转以检测新图像的扫描器,调用执行操作以改变环境状态的操纵器,以及最后回答向人工智能智能体提出的问题的回答器*。文献[65]从多智能体角度研究了 IQA,即多个智能体共同探索交互场景以回答问题。[65]提出了多层结构和语义记忆作为场景记忆,由多个智能体共享,首先重建三维场景,然后执行 QA。

2)评估指标:具身QA和IQA涉及两个子任务:1) 导航,2) 问题解答,这两个子任务的评估基于不同的指标。

导航性能通过以下方面进行评估:

- 1)导航终止时与目标的距离,即导航误差 (dT);

- 2)从初始位置到最终位置与目标距离的变化,即目标进度(d∆);

- 3)在整个事件(episode)中任何一点与目标的最小距离(dmin);

- 4)在达到最大事件长度之前,智能体为回答问题而终止导航的事件百分比(%stop);

- 5)智能体在包含目标物体的房间内终止导航的问题百分比(%rT);

- 6)智能体至少有一次进入包含目标物体的房间的问题百分比(%re);

- 7)目标物体交并比(IoU);

- 8)基于 IoU 的命中精度(hT);

- 9)事件长度(episode length),即轨迹长度(trajectory length)。

指标(1),(2)和(9)也用作视觉导航任务的评估指标。

QA性能通过以下方面进行评估:

- 1)真实答案在预测中的平均排名 (mean rank,MR);

- 2)准确率。

3)数据集:EQA[61]数据集基于House3D,House3D是流行的SUNCG[33]数据集的一个子集,具有合成的房间和布局,类似于Replica数据集[107]。House3D 将 SUNCG 的静态环境转换为虚拟环境,在虚拟环境中,智能体可以在物理限制条件(如不能穿过墙壁或物体)下进行导航。为了测试智能体在语言基础、常识推理和导航方面的能力,[61] 使用 CLEVR [108] 中的一系列功能程序来合成有关物体及其属性(如颜色、存在性、位置和相对介词)的问题和答案。总共有 750 个环境中的 5,000 个问题,涉及 7 种独特房间类型中的 45 个独特物体。

对于 MT-EQA[63],作者介绍了 MT-EQA 数据集,该数据集包含 6 种类型的组合问题,可比较多个目标(物体/房间)之间的物体属性(颜色、大小、距离)。

对于 IQA [64],作者对一个大型数据集 IQUAD V1 进行了注释,该数据集由 75,000 道选择题组成。与 EQA 数据集类似,IQUAD V1 也有关于物体存在、计数和空间关系的问题。

IV. INSIGHTS AND CHALLENGES

A. Insights into Embodied AI

图 6 中的相互联系反映了模拟器对研究任务的适用性。根据图 6,Habitat-Sim 和 iGibson 都支持视觉探索研究任务和一系列视觉导航任务,这表明高保真的重要性,而高保真来自基于世界的场景模拟器。然而,由于一些模拟器具有明显的独特特征,更适合用于深度强化学习等非具身人工智能独立任务,因此它们目前没有与任何具身研究任务相连接。尽管如此,它们仍然符合被归类为具身人工智能模拟器的标准。

相反,诸如具身问题解答和有先验的视觉导航等研究任务,由于这些任务的交互性质,需要具身人工智能模拟器具有多状态物体属性。因此,AI2-THOR 无疑是首选模拟器。最后,VLN 是目前唯一没有使用九种具身人工智能模拟器中任何一种,而是使用 Matterport3D 模拟器 [104] 的研究任务。这是因为以前的 VLN 工作不需要模拟器具有交互功能,因此使用 Matterport3D 模拟器就足够了。然而,随着 VLN 任务的进一步发展,我们可以预期在 VLN 任务中需要交互,因此需要使用具身人工智能模拟器。此外,与传统的强化学习模拟环境[41]、[109]侧重于特定任务的训练不同,具身人工智能模拟器提供了一个训练环境,可训练与物理世界中类似的各种不同任务。

此外,基于第三节中对具身人工智能研究任务所做的综述,我们提出了一个金字塔结构,其中每个具身人工智能研究任务都对下一个任务有所帮助。例如,视觉探索有助于视觉导航的发展,而视觉导航又有助于创建具身QA。这种层层递进的方法也与任务的复杂性不断增加相关联。基于具身人工智能研究的可预见趋势,我们假设具身人工智能研究金字塔的下一个进步是基于任务的交互式问题解答(Task-based Interactive Question Answering,TIQA),其目的是将任务与回答具体问题相结合。例如,这类问题可以是 “鸡蛋煮熟需要多长时间?柜子里有苹果吗?” 这些都是传统方法无法回答的问题[61], [64]。它们需要具身智能体执行与问题相关的特定任务,以获得新的见解,而这些见解对于回答这些QA问题至关重要。

我们假设的 TIQA 智能体可以执行一系列普通家庭任务,这使它们能够推断出有用的环境信息,而这些信息对于帮助它们得出 QA 问题的答案至关重要。TIQA 可能是实现任务规划通用化和在模拟中开发通用人工智能的关键,这些人工智能随后可以部署到现实世界中。

B. Challenges in Embodied AI Simulators

目前的具身人工智能模拟器在功能和逼真度方面都已达到一定水平,使其有别于用于强化学习的传统模拟器。尽管具身人工智能模拟器的差异越来越大,但具身人工智能模拟器在逼真度、可扩展性和交互性等方面仍面临着一些挑战。

逼真性(Realism)。它侧重于模拟器的保真度和物理特性。具有高视觉保真度和逼真物理特性的模拟器受到机器人界的追捧,因为它们为导航和交互任务等各种机器人任务提供了理想的测试平台[110],[111]。然而,目前还缺乏同时拥有基于世界的场景和先进物理特性的人工智能模拟器。

就保真度而言,基于世界场景的模拟器在模拟真实任务时无疑会优于基于游戏的场景模拟器[27], [112]。尽管如此,目前只有 Habitat-Sim [17] 和 iGibson [18] 是基于世界的场景模拟器。这种基于世界的场景模拟器的匮乏是具身人工智能智能体从模拟到现实任务的瓶颈,进一步阻碍了具身人工智能研究在现实世界中的应用。在物理学方面,基于物理学的预测模型的进一步发展[113]-[115]强调了具有先进物理学功能的具身人工智能模拟器的重要性,因为这些模拟器为训练具身人工智能智能体执行具有复杂物理交互的任务提供了理想的试验平台[2],[3],[116]。尽管需要基于先进物理特性的人工智能模拟器,但目前只有 ThreeDWorld [20] 一种模拟器符合这一标准。因此,具有高级物理特性(如布料、流体和软体物理)的具身人工智能模拟器严重缺乏。我们相信,三维重建技术和物理引擎[117]-[119]的进步将提高具身人工智能的逼真度。

可扩展性(Scalability)。与基于图像的数据集[7],[120]不同,这些数据集可以很容易地从众包或互联网中获得。收集大规模基于世界的三维场景数据集和三维物体资产的方法和工具十分匮乏[121]-[123]。这些三维场景数据集对于构建各种具身人工智能模拟器至关重要。目前收集真实三维场景数据集的方法需要通过摄影测量[124](如 Matterport 三维扫描仪、Meshroom[125])或甚至移动三维扫描应用来扫描物理房间。然而,要收集大规模三维物体和场景扫描数据,这些应用在商业上并不可行。这主要是由于用于摄影测量的三维扫描仪成本高昂且无法使用。因此,可扩展性的瓶颈在于开发大规模收集高保真三维物体或场景扫描的工具。基于三维学习的方法[126],[127]旨在通过单张或几张图像,甚至通过场景生成方法[128]渲染三维物体网格,希望随着这些方法的进一步发展,我们将能够扩大大规模三维数据集的收集过程。

交互性(Interactivity)。在具身人工智能模拟器中,与功能物体进行细粒度操作交互的能力对于复制人类与真实世界物体的交互至关重要[129]。大多数基于游戏的场景模拟器[13]、[16]、[19]、[20]都提供了细粒度物体操作功能和符号交互功能(例如, 操作)或简单的 “点选” 功能。然而,由于基于游戏的场景模拟器的性质,与细粒度物体操作相比,在这种环境下执行的许多研究任务都会选择符号交互功能[3],只有少数研究任务同时使用这两种功能[2],[130]。

另一方面,基于世界的场景模拟器[17]、[18]中的智能体拥有粗略的运动控制能力,而不是符号交互能力。然而,这些模拟器中的物体属性主要是表面上的可交互性,可以进行粗略的运动控制,但缺乏多状态物体类,即物体的状态变化数量。因此,有必要在物体属性中的物体功能和具身人工智能智能体在环境中执行动作的复杂性之间取得平衡。

毫无疑问,AI2-THOR[13]、iGibson[18]和 Habitat-Sim [17]等主流模拟器确实为推进各自的具身人工智能研究提供了极佳的环境。不过,它们也有自己的优势和局限性需要克服。随着计算机图形学和计算机视觉的发展,以及创新性真实世界数据集的引入,从真实到模拟的领域适应是改进具身人工智能模拟器的明确途径之一。真实到模拟的概念围绕着捕捉真实世界的信息,如触觉感知[131]、人类水平的运动控制[132]和音频输入[133],以及视觉感官输入,并将它们整合在一起,以开发更逼真的具身人工智能模拟器,从而有效地连接物理世界和虚拟世界。

C. Challenges in Embodied AI Research

具身人工智能研究任务的复杂度不断提高,从 “互联网人工智能” 到三维模拟环境中的自主具身学习智能体,其中包含多种传感器模式和潜在的长轨迹[22],[34]。这使得智能体的记忆和内部表征变得极为重要 [11],[22],[56]。长轨迹和多种输入类型也表明,强大的记忆架构非常重要,它能让机器人专注于环境中的重要部分。近年来,人们使用了许多不同类型的记忆,如递归神经网络,基于注意力的记忆架构,anticipated occupancy maps,occupancy maps和semantic maps,其中有些论文压倒性地强调了其记忆架构的新颖性。然而,众所周知,递归神经网络在捕捉具身人工智能中的长期依赖关系方面存在局限性[56],[72],但由于缺乏以记忆架构为重点的研究,目前还很难就哪种记忆类型更好达成一致[11]。

在具身人工智能研究任务中,复杂性也在不断增加,从视觉探索发展到 VLN 和具身QA,分别增加了语言理解和QA等新内容。每个新组件都会导致人工智能智能体的训练难度和训练时间呈指数级增长,尤其是目前的方法往往完全基于学习。这种现象导致了两种有希望的进步,以减少搜索空间和样本复杂度,同时提高鲁棒性:结合经典算法和基于学习的算法的混合方法 [44],[74] 和先验知识的结合 [23],[57]。此外,对于更复杂的任务来说,消融研究更难管理[31],因为具身人工智能中的每个新组件都会添加到现有的组件集上,而具身人工智能模拟器在功能和问题上差异很大,因此更难测试其对智能体性能的贡献。此外,研究任务的数量也在迅速增加。因此,虽然一些基本任务(如视觉探索)受到了更多的关注,从而有更多的方法来解决它们,但像 MT-EQA 这样的较新,较小众的任务却很少有人关注。新任务通常会在方法,评估指标[22],输入类型和模型组件等重要方面引入新的考虑因素,如表 III 所示,因此与视觉探索等简单任务相比,需要进行更多的评估。

最后,人们缺乏对多智能体设置(multi-agent set-ups)的关注,而多智能体设置有助于完成有用的新任务[65]。缺乏关注的原因可能是直到最近才出现具有多智能体功能的模拟器。用于协作和通信的多智能体系统在现实世界中非常普遍 [134],[135],但目前受到的关注相对较少 [31]。最近,具有多智能体功能的模拟器越来越多[13],[20],[55],但对多智能体的支持(如对多智能体算法的支持)是否足够仍有待观察。

CONCLUSION

最近在具身人工智能模拟器方面取得的进展是具身人工智能研究取得进展的主要推动力。为了了解具身人工智能模拟器和研究的趋势与差距,本文对具身人工智能模拟器和研究进行了当代的全面概述。本文综述了九种具身人工智能模拟器及其在服务和推动具身人工智能研究任务最新创新方面的联系。通过对九种具身人工智能模拟器的七项特征进行基准测试,我们试图了解它们在真实性、可扩展性和交互性方面的表现,从而了解它们在具身人工智能研究中的应用。我们从方法、评估指标和数据集方面,对支持具身人工智能研究金字塔的三大任务–视觉探索、视觉导航和具身QA–进行了研究。这样做的目的是对现有的方法进行回顾和基准测试,以便在各种具身人工智能模拟器中处理这些类别的具身人工智能研究任务。此外,本文还揭示了模拟器、数据集和研究任务之间的深刻关系。有了本文的帮助,初涉这一领域的人工智能研究人员就能为自己的研究任务选择最合适的具身人工智能模拟器,并为推动具身人工智能领域的发展做出贡献。