基于显著性的无人机多光谱图像语义杂草检测与分类

Saliency-Based Semantic Weeds Detection and Classification Using UAV Multispectral Imaging(2023)

- 摘要

- 1、介绍

- 2、相关工作

-

- 2.1 监督学习

- 2.2 半监督学习

- 2.3 无监督学习

- 3、方法

- 3.1 贡献

-

- 3.2 PC/BC-DIM NEURAL NETWORK(预测编码/有偏竞争-分裂输入调制)

- 4、结论

- 5、算法流程

新词1:栽培杂草控制

解释1:栽培杂草控制是指在农田或园艺区域中采取一系列措施来减少或消除杂草对作物生长的竞争。

新词2:显著图

解释2:显著图(Salient Map)是指通过图像处理和分析技术生成的一幅图像,用于表示原始图像中像素的显著性程度。显著图可以帮助我们理解和关注图像中最重要、最引人注目的区域。这个显著图反映了图像中每个像素的显著性程度,即其对于区分作物和杂草的重要程度。

根据PC/BC-DIM方法的描述,显著部分指的是显著图中被认为是重要、引人注目的部分,即与作物相关的区域。而非显著部分则指显著图中被认为是不显著、不重要的部分,即与杂草相关的区域。通过对显著图进行阈值化或其他分割算法,可以将显著部分和非显著部分分离开来,从而将杂草作为非显著部分进行进一步的处理或移除。

摘要

杂草泛滥对农作物造成损害,限制了农业生产。传统的杂草控制方法依赖于农药,这需要劳动密集的做法。提出了利用多光谱图像进行杂草检测的各种方法。基于机器视觉的杂草检测方法需要提取大量的多光谱纹理特征,增加了计算量。度神经网络用于基于像素的杂草分类,但这些基于深度神经网络的杂草检测方法的缺点是需要大量的图像数据集进行网络训练,尤其对于多光谱图像,需要耗费大量的时间和资源。这些方法还需要一个基于图形处理器(GPU)的系统,因为计算成本很高。

在本文中,我们提出了一种新的杂草检测模型来解决这些问题,因为它不需要任何形式的监督训练使用标签图像和多光谱纹理特征提取。该模型可以在基于CPU的系统上运行,从而降低了系统的计算成本。

利用预测编码/有偏竞争分裂输入调制(PC/BC-DIM)神经网络确定多光谱融合显著性图,进而用于显著性作物预测和杂草检测。该模型的平均精度为94.38%,均方误差为0.086,均方根误差为0.291。

1、介绍

为了减少农民的劳动强度,有必要对杂草进行准确的检测和分类,以便对特定区域的杂草进行选择性杂草处理,从而优化除草剂喷洒。传统除草方法有机械除草、人工除草和化学除草。人工除草方法经济适用于小面积土地,但对于公顷土地,这种方法效率不高。

栽培杂草控制方法包括作物轮作和利用竞争性牧草品种等技术。

机械除草涉及到耕作、割草和覆盖等方法。这种方法是缓慢的,需要适当的天气和土地条件来实施。

化学除草技术由于除草剂的使用对水生生物和陆生生物有生命威胁而产生有害影响。

生物杂草清除方法,如病原体和节肢动物使用,但这些是昂贵的和失败的,因为它对特定的杂草的特殊性。

现代的杂草检测方法是基于计算机视觉或机器学习算法。传统的基于机器视觉的杂草检测方法包括使用不同的特征提取技术,包括纹理特征、颜色特征、光谱特征、形状特征、多特征融合等,然后通过合适的分类器进行分类。作物和杂草具有不同的叶片纹理特征,利用这些纹理信息可以区分杂草和作物。该鲁棒光谱特征可用于杂草检测,包括利用杂草反射率将其与作物区分开来。可见光谱、近红外光谱、多光谱、高光谱和荧光光谱图像可用于杂草检测。基于颜色特征的杂草检测方法依赖于作物杂草的色差,该方法的主要优点是颜色特征对尺度、大小和位置变化不敏感。RGB图像的颜色特征包括:标准差、偏度和均值等统计指标,用于提取有用的杂草特征,并对作物进行分类。

一些基于颜色的杂草检测方法包括将RGB颜色空间转换为其他颜色空间,以区别于作物,如:将RGB颜色空间转换为Hue, saturation, and intensity (HIS)空间。基于颜色特征的杂草检测方法在某些条件下并不有效,因为杂草颜色的季节性变化、叶片病害以及光照条件的不同会导致杂草检测的不准确。多特征融合方法利用多特征提高模型在非理想环境条件下的精度和稳定性。

传统的基于机器视觉的方法易于理解和实现,而基于深度学习的杂草检测方法比人工的特征提取过程更准确,提取特征的效率更高。深度神经网络具有独特的网络结构,利用高层次和低层次的视觉信息进行杂草检测。空间和语义特征差异是深度神经网络杂草检测的重要组成部分。

由于农作物和杂草的对比度较低,利用视觉图像进行杂草检测是一项具有挑战性的任务。

基于机器视觉的杂草检测方法包括:基于对象的杂草检测模型和基于像素的杂草检测模型。基于像素的杂草检测方法适用于类间分类任务,能够准确检测出作物和杂草任意生长阶段的杂草,但计算成本很高。基于对象的杂草检测方法依赖于植物的空间、光谱和形态信息。与基于像素的方法相比,该方法的计算量较小,但对杂草检测任务的视觉图像要求较高。该方法既不适合作物生长初期的杂草检测,也不适合杂草检测。

2、相关工作

2.1 监督学习

Pérez等人在[2]中使用基于对象的图像分析(OBIA)方法和支持向量机(SVM)分类器对向日葵和玉米作物进行杂草测绘和分类。该模型对玉米作物的平均精度为79±1.96%,对向日葵作物的平均精度为95.5±2.09%。Inkyu等人在[3]中提出了一种基于CNN的深度神经网络(deep neural network, DNN),命名为SegNet,用于杂草检测,解决了作物与杂草边界不清导致基于对象的杂草检测不准确的问题。[4]中提出的方法考虑了作物与杂草叶片无明显重叠时的杂草检测情况。将Haar小波变换(HWT)方法用于观察空间域有用的特征,与其他变换方法相比,HWT方法具有更大的特征检测潜力。主成分分析(PCA)也被用作降低输入图像维数的必要步骤。这项工作使用了多层感知机(MP)神经网络作为分类器,总体分类准确率为89.3%。在[5]中,分类类型视觉显著性模型被用来解决不同作物和杂草叶片形状的分类问题。采用视觉注意分类模型与支持向量机相结合的方法对阔叶作物和窄叶杂草进行分类。融合颜色、方向和强度特征来计算显著性图。Barrero和Perdomo[6]提出了一种融合低分辨率多光谱和高分辨率RGB图像的模型,以获得稻田中禾本科杂草的有效识别特征。利用RGB、归一化植被差指数(NDVI)和归一化绿红差指数(NGRDI)图像,采用监督学习的方法训练具有隐藏层的MP网络。该模型的一个局限性是大量的纹理描述符计算需要较高的计算开销。对玉米和杂草生长早期的杂草分类和检测问题进行了讨论。采用 Hough 变换(HT)对正交灰化图像进行行间杂草检测,并利用 OBIA 和随机森林(RF)相结合的方法对土壤、杂草和玉米进行半自动分类。HT 检测到的行间杂草进行了标记,并作为分类器的训练数据。该方法的总体分类精度为0.945,Kappa 系数值为0.912。该方法的局限性在于杂草的分割过程高度依赖于几何特征,因此需要对参数进行仔细的选择才能进行有效的分割。由于纹理和几何特征的提取,该方法的计算成本也很高。

Kantipudi等人[8]通过对原始RGB植被图像进行切片,提出了一种杂草检测模型,该模型利用带有滑动窗口的CNN对子图像进行利用。该模型的目标是在作物生长早期发现杂草,以提高作物产量和减少除草剂的使用。该杂草检测模型所涉及的过程是:图像提取,根据给定的标注图像对各子图像进行标注,然后训练CNN。与该模型相关的另一个限制是,必须仔细选择窗口大小,因为错误的窗口大小选择可能会导致杂草检测率进一步下降。当杂草与作物叶片重叠且距离较近时,由于无法区分杂草与作物,该模型的杂草检测变得更加具有挑战性和关键性。Farooq等人在[9]中使用Gabor filter、Histogram of Oriented Gradient (HoG)和Local Binary Pattern (LBP)作为形状和纹理特征提取方法,训练一个基于支持向量机的系统进行杂草检测和分类。该系统对11个近红外和16个可见光波段的高光谱图像进行了综合识别,最大识别精度达到80.90%。Farooq等人在[10]中解决了低分辨率和多分辨率图像的杂草检测问题。采用超像素局部二值模式(SPLBP)提取局部纹理特征,采用CNN提取空间和光谱特征。将提取的特征串接作为SVM分类器的输入,然后对杂草进行分类。结果表明,与非超像素局部二值模式相比,采用FCNN的SPLBP信息对杂草数据集的平均分类精度为91.47 ~ 96.7%。该方法可以检测出形状和纹理不同的杂草,但其主要的缺点是计算量大,特征提取需要大量的计算。在[11]中提出了三种杂草检测模型,其中包括支持向量机(SVM) ,You Only Look once-version 3(YOLO-v3)和基于区域的卷积神经网络(rCNN)。这些方法的性能指标 F1得分分别为88% 、94% 和94% ,杂草检测准确率分别为79% 、89% 和89% 。基于 HOGSVM 模型的杂草检测方法具有较低的处理能力,具有较好的性价比。使用 RCNN 模型进行杂草检测可以获得最高的准确与精密。与 RCNN 和 HOG-SVM 相比,基于 YOLO 的杂草检测是一种快速检测方法。所有引进的杂草检测技术都存在杂草被高估和低估的问题。基于 YOLO-V3的杂草检测模型没有考虑模型边缘,因为它在估计作物附近的杂草时会造成误差。在文献[12]中,使用改进的通用网络(U-net)进行语义杂草分割,并计算各自场映射的杂草密度。该方法对绿色植物的分割准确率为93.5% ,杂草密度平方平均数误差为0.03。一个基于图形处理器的系统被用于基于梯度下降法(GD)的培训,然后测试提出的方法。该模型具有较高的精度,可以作为地面事实用于大面积精确杂草评价算法的开发,但该方法可能会积累不精确分割作物的误差。基于多任务语义分割-卷积神经网络(MTS-CNN)的杂草检测方法是针对由于交叉熵损失和骰子损失引起的作物和杂草分割问题而开发的[27]。利用 BoniRob 数据库、 CWFID 数据库和 MIOU 值分别为0.9164、0.8372和0.8260的水稻苗和杂草数据库进行了作物和杂草分割的实验研究。提出的算法需要配备 Jetson 图形处理器的高规格计算单元,需要学习数百万个自由参数。结合SesameWeedNet-2卷积神经网络(CNN),提出了一种基于图像拼接的杂草分类方法。与基于像素的分割和分类方法相比,该方法处理了不同光照因子和土壤类型的问题,计算成本较低,但算法的执行仍需要基于gpu的系统,且需要学习大量的树参数。利用飞行器采集的芝麻数据集,杂草和植物的分类精度达到96.7%。

2.2 半监督学习

Hu等人提出了一种新的基于图像的深度学习体系结构,称为Graph Weed Network (GWN),使用DeepWeeds数据集可以达到最高的98.1%的精度。其目标是从从复杂的牧场采集的RGB图像中识别多种类型的杂草。GWN可以看作是一种减少复杂标注任务的半监督学习方法。与其他的图像分类方法相比,这种方法需要更多的杂草检测或分割的努力,因此,该系统的高计算成本是不可避免的。Jiang et al.[14]提出了一种基于CNN的图卷积网络(GCN)的半监督杂草检测方法,利用有限的带标签数据集和未带标签的图像。基于gcn -残差神经网络101 (GCN-ResNet101)的模型对4种不同杂草数据集的识别准确率分别为97.80%、99.37%、98.93%和96.51%。Kerdegari et al.[15]利用半监督生成对抗网络(semi-supervised generative adversarial network, GAN)解决了监督杂草检测方法需要大量训练数据的问题。它使用了一个多类全卷积神经网络分类器,并对甜菜田捕获的多光谱图像进行像素级分类。结果表明,50%标记数据的NIR+RED输入通道的F1值约为0.85,优于单通道图像。模型的局限性是使用了三个通道作为输入(NIR+RED+NDVI),但在标记数据更大的情况下不能改善结果和训练。Xie等人在[16]中提出了一种狗牙根上的nut莎草杂草检测模型,解决了训练数据不准确和不充分的问题,需要花费昂贵的人工图像标记任务。将基于骨架的nutsedge weed probability map (NSPM)作为输入输入Faster region convolutional neural network (R-CNN),并将合成数据与原始数据相结合进行网络训练,以获得较好的训练效果。Faster R-CNN优于其Mask R-CNN,假阴性率为0.4%,标签时间可大幅减少至95%。该方法的缺点是在网络训练时需要对原始图像数据集进行人工标记,这是一项耗时的任务。

2.3 无监督学习

ang等人[17]利用无监督k-mean特征学习和CNN提出了一种杂草检测模型。该方法结合多层、精细化和利用CNN参数作为大豆幼苗杂草检测的预训练过程,并替代了传统CNN参数的随机初始化权值。该方法的准确率达到了92.89%,高于随机初始化的CNN。Inkyu等人提出了一种作物/杂草分割和映射框架,该框架处理了使用DNN[18]从无人机(UAV)获得的多光谱图像。在多光谱图像的小区域上利用正色特征图进行杂草检测。通过对多光谱正交点图像的精确比对,将图像输入深度神经网络进行分类。利用RGB、红外和NDVI图像的颜色组合进行杂草检测。采用平铺多光谱图像作为密集语义分割框架的输入。将检测到的杂草的曲线下面积作为性能指标,该方法的值高达0.78。由于多光谱图像的高计算负荷和DNN处理阶段都是在基于GPU的系统上进行训练和测试的。当正色特征图大到足以引起GPU内存问题时,主要问题就出现了,但是使用滑动窗口方法避免了这个问题。由于高海拔数据集的地面样本距离有限,使用DNN计算精确的植被图是不简单的。其他具有挑战性的问题包括由于低采样、高保真图像和多光谱图像对齐导致的分辨率损失。

3、方法

3.1 贡献

本研究提出的基于PC/BC-DIM神经网络模型解决了基于对象和基于像素的杂草检测方法的难题。该模型不需要任何形式的网络训练,也不需要提取大量的纹理或几何特征。利用微型飞行器(MAV)采集的多光谱图像数据库,在RGB范围内获取肉眼无法捕捉到的作物和杂草的准确信息。提出的PC/BC-DIM神经网络确定作物和杂草图像的显著图,并从显著图的显著和非显著部分分离出杂草作为非显著部分。将所提出的杂草检测方法的检测结果与现有的杂草检测方法进行了比较,发现该方法在准确率和计算成本方面都优于现有的方法。

贡献:

- 一种基于显著性的智能农业语义杂草检测方法。

- 基于cpu的高效、准确的杂草检测模型。

- 训练自由杂草检测分类计算模型。

该模型具有三方面的创新性,它解决了杂草在外观和光照条件有变化的情况下,利用多光谱图像进行基于纹理的特征提取和分类的问题,而且计算成本非常低。

这项工作的一个主要贡献是,提出的基于PC/BC-DIM网络的方法不需要训练任何自由参数,因为它使用基于数学预定义的固定Gabor滤波器的权值来计算图像中存在的作物显著性信息。

此外,该模型的计算成本不高,并且可以在CPU系统上执行,因此对杂草检测具有一定的计算经济性。

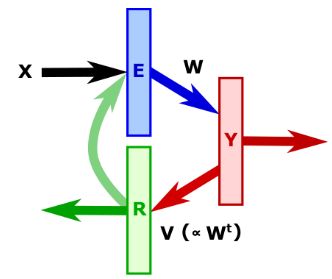

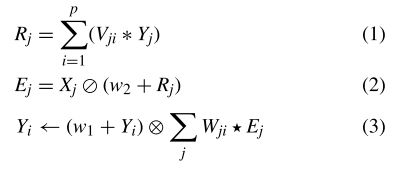

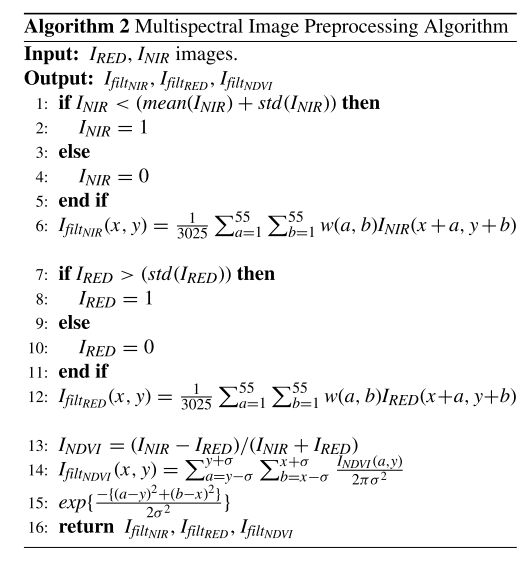

。PC/BC-DIM神经网络的结构。矩形框表示神经元群体,箭头表示每个群体的活动流程。矩形框E表示误差神经元的种群,R表示重构神经元的种群,Y表示预测神经元的种群。来自外部环境的输入X激活了错误神经元群体,如方程2所示。误差神经元的响应激活方程3所示的预测神经元,相应地激活方程1所示的重构神经元的种群。

3.2 PC/BC-DIM NEURAL NETWORK(预测编码/有偏竞争-分裂输入调制)

PC/BC-DIM是一种分层神经网络,采用预测编码(PC)[19]和有偏竞争(BC)[20]理论,使用具有稳定动态特性的分裂输入调制(DIM)[21]。

在PC/BC-DIM方法中,涉及到三个名词:预测编码(Predictive Coding,PC)、有偏竞争(Biased Competition,BC)和分裂输入调制(Divisive Input Modulation,DIM)。

预测编码(Predictive Coding,PC):预测编码是一种神经信息处理理论,用于模拟大脑中信息处理的机制。该理论认为,大脑通过对外界输入进行预测,并不断修正预测错误来生成对外界的感知。在PC/BC-DIM方法中,预测编码被应用于神经网络的设计中,用于模拟大脑的信息处理过程,帮助生成显著图并分离作物和杂草。

有偏竞争(Biased Competition,BC):有偏竞争是一种神经网络模型,用于描述大脑中神经元之间的相互竞争和选择机制。在有偏竞争中,不同的神经元代表不同的特征或概念,它们之间相互竞争以决定哪些特征或概念受到注意和强调。在PC/BC-DIM方法中,有偏竞争被用于确保显著图中作物和杂草之间的竞争关系,以提高杂草的分割和分离效果。

分裂输入调制(Divisive Input Modulation,DIM):分裂输入调制是一种神经网络中的机制,用于调节和调整神经元之间的输入。在DIM中,输入信号被分裂成不同的部分,并通过调制因子进行加权和调节。在PC/BC-DIM方法中,分裂输入调制被应用于神经网络中,用于调整和优化输入的特征表示,以增强作物和杂草的区分度和显著性。

PC/BC-DIM 网络基于类似于在皮层中进行的感知推理的概念[22] ,预测神经元的反应依赖于初级视觉皮层 V1区域的预测误差[23]。视知觉是通过感官驱动的信息交互,在大脑皮层使用 PC 模型实现自上而下的期望。一个带有偏向竞争的预测编码模型在[20]中被推导和发展,以模拟一些视知觉过程,如显著性检测。

PC/BC-DIM网络中的预测神经元的反应依赖于初级视觉皮层V1区域的预测误差。这意味着网络通过比较输入信号与预测信号之间的差异来生成预测误差,并使用这些误差来调整预测神经元的反应。这种机制类似于大脑皮层中的感知推理过程,其中期望信号与感知信号之间的差异驱动了信息的处理和调整。

PC/BC-DIM网络中的偏向竞争的预测编码模型(BC)是在前人的研究基础上推导和发展出来的。该模型通过竞争机制来选择和强调不同的特征,以实现类似于视知觉过程中的显著性检测。这种模型结合了自上而下的期望信号和竞争机制,以实现对图像中显著区域的检测和提取。

本研究利用PC/BC-DIM网络模拟视觉皮层的显著性检测过程,从感觉视觉信息中确定显著性信息。利用PC/BC-DIM网络计算多光谱输入图像的显著性图,进而进行杂草检测。该网络采用迭代过程,减小了输入的传感器数据与网络预测的传感器输入之间的误差。所提出的网络由三个神经元群体组成,即重构神经元®、错误神经元(E)和预测神经元(Y)。这些神经群体的激活函数如式1、2和3所示。

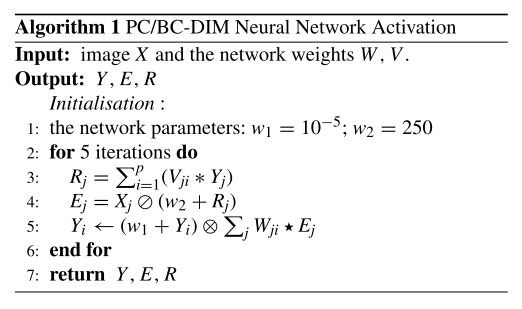

本文提出的算法主要有两个方面,一是利用多光谱输入图像的统计信息进行预处理,二是利用pc /BC-DIM网络计算多光谱通道的显著性特征图。

将预处理后的输入图像X提供给PC/BC-DIM网络,该网络具有固定的预定义权值W, V,以确定在预测神经元y的输出处计算出的显著图。计算显著性信息所使用的PC/BC-DIM网络的激活过程如算法1所示。每个多光谱图像通过PC/BC-DIM网络计算特定光谱中的显著图。

多光谱杂草分类面临的主要挑战包括:多光谱图像中杂波背景的消除,以提取有用信息;选择合适的籽粒大小增强仅显著作物信息的对比。算法2描述了在将多光谱图像作为输入呈现给PC/BC-DIM网络之前,对其进行预处理的完整过程。对近红外通道图像进行预处理,INIR用强度阈值取其均值和标准差值,RED通道图像IRED用强度阈值取其标准差值去除背景。利用强度平滑核对预处理后的近红外和红通道图像进行空间滤波,增强了图像显著信息的对比度,使图像平滑。这种平均滤波器保留了视觉信息的细节,并提高了图像中作物的显著性。平均内核大小是根据经验选择的,并将本工作中报告的结果的值设置为[55,55]。阈值NIR和RED通道图像经过空间平滑处理后得到滤波后的NIR通道图像IfiltNIR,和滤波后的RED通道图像ifilred。近红外波段图像和红波段图像可用于估算植被活力或NDVI指数INDVI。它提供了图像中植被区域是否存在的重要信息,并补偿了光照变化、地表坡度等不同因素的影响。NDVI的活力或指数图像可以通过以下方法计算:

![]()

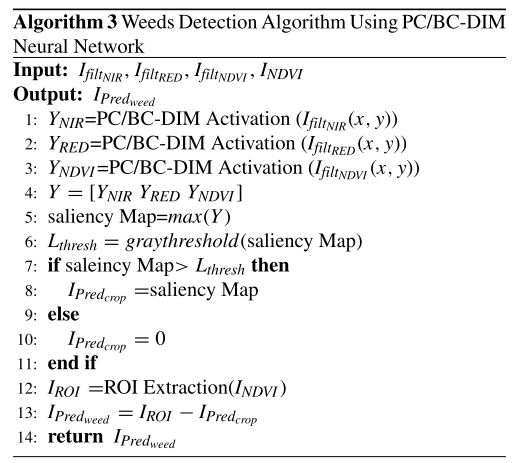

算法3详细介绍了杂草的检测和分类过程。与杂草相比,作物更占优势,因此这个视觉权重图包含了显著作物比杂草的改进和增强的外观,因为它代表了显著像素强度水平的显著性。PC/BC-DIM网络可有效计算预测神经元响应的NIR、(IfiltNIR)、RED、(IfiltRED)显著性特征图,以及NDVI、IfiltNDVI、频带图像预处理后的结果,从而定位显著性作物和非显著性杂草。融合显著性特征图、Yi、ofeach通道图像,计算其最大值,确定各波段的融合显著性映射。显著性图的阈值Lthresh是通过基于平均值或Otsu的阈值技术获得的,而Otsu的方法在为每幅图像减少类内方差的同时,自动选择一个合适的阈值水平,从而检测和识别显著性作物区域。基于Otsu方法和基于均值的方法对融合显著性输出图像进行阈值化处理,实现了显著性作物和非显著性杂草的分类。

对NDVI图像进行阈值化提取感兴趣区域(region of interest, ROI),同时包含农作物和杂草的信息。本研究采用0.2的阈值提取ROI。提取的感兴趣区域图像可用于农作物和杂草的分割。在提取的感兴趣区域图像上对连通分量进行斑点检测,去除比斑点大小的连通分量更小的图像分量,进一步细化了分割后的杂草和作物信息。这种丢弃小点的操作称为开区操作。本文对NDVI阈值图像进行斑点检测,最小连通分量为200个,剔除二值图像中小于200个连通分量的分量。从斑点检测后得到的图像中减去预测的显著作物图像IPredcrop, IROI既包含作物又包含杂草,从而分离出杂草IPredweed。算法3给出了使用PC/BC-DIM神经网络进行杂草检测和分类的完整过程。

作物和杂草的检测完全依赖于作物的显著性。对PC/BC-DIM网络中预处理多光谱图像的显著性特征图进行融合,并利用Otsu和基于平均值的方法对融合后的映射进行阈值处理。提取的ROI图像减去阈值显著图,将检测到的杂草与预测的作物图像分离。

本文提出的杂草检测模型采用固定的、预定义的网络权值,不需要进行任何网络训练,因此本文提出的模型的学习时间为零,而所有基于gpu的杂草检测方法都需要大量的训练时间和大量的训练图像。所提出的杂草检测模型在其网络结构中没有任何配置层,因此它消除了仔细配置层的需要。此外,大多数先进的杂草检测模型都使用监督学习来开发杂草检测模型的网络内部体验。

4、结论

本文提出了一种新的基于显著性的杂草检测模型,该模型在杂草检测精度、计算成本、功率需求和网络训练等性能指标方面都优于现有的方法。

该模型的核心功能单元为PC/BC-DIM神经网络结构,能够预测和检测显著和非显著目标。

该模型利用近红外和红通道图像的统计信息对多光谱图像进行预处理,并利用这两种光谱图像计算NDVI图像。

将这些多光谱图像作为PC/BC-DIM神经网络的输入,并在网络的输出端预测融合的显著性图。

该融合预测图谱用于检测不显著杂草。

该模型的平均精度大于94.38%,均方误差为0.086,位居目前最先进的杂草检测模型之首。

此外,提出的杂草检测模型具有较低的假阳性率和较高的真阴性率,提供了较好的预测结果。

作为未来的工作,我们将努力提高所提出的杂草检测模型的准确性。

5、算法流程

上述三个算法结合起来进行杂草检测的方法属于计算机视觉领域中的图像处理和图像分割方法。这种方法利用多光谱图像的特征和神经网络的激活来提取杂草和作物区域,并进行杂草掩码的预测。其中,算法1是多光谱图像的预处理算法,对输入的红光、近红外光和计算得到的NDVI图像进行滤波和阈值化处理。算法2是基于PC/BC-DIM神经网络的杂草检测算法,利用该网络提取输入图像的特征并生成显著图。算法3则是根据显著图和阈值进行杂草和作物的分割,并得到最终的杂草掩码。

这种方法结合了图像处理、特征提取和神经网络技术,通过对多光谱图像进行预处理和分析,可以有效地区分杂草和作物区域,提供一种自动化的杂草检测方法。这种方法在农业领域具有广泛的应用,可以帮助农民识别和管理田间作物的杂草问题,提高农作物的产量和质量。

因此,可以将这三个算法归类为图像处理和计算机视觉领域的方法,而不是深度学习方向的方法。这些算法利用图像处理技术和特征提取方法来处理多光谱图像,通过阈值化、滤波和特征激活等步骤来实现杂草检测。尽管没有涉及深度学习网络的训练过程,但仍然可以在计算机视觉领域中使用这些方法进行杂草检测任务。

在杂草检测领域,上述算法可以归类为基于多光谱图像和图像处理的传统方法。这些方法主要依赖于图像的预处理、特征提取和阈值化等技术,以实现杂草和作物的区分和检测。

具体来说,算法1对多光谱图像进行预处理,包括滤波和阈值化操作,以增强图像特征和减少噪声。算法2则利用PC/BC-DIM神经网络对预处理后的图像进行特征提取和激活,生成显著图。最后,算法3通过显著图和阈值的比较,进行杂草和作物的分割,得到杂草掩码。

尽管算法2中使用了神经网络,但它的主要目的是进行特征提取和激活,并未涉及网络的训练过程。因此,这些算法更符合传统的图像处理方法,通过对图像进行预处理、特征提取和分割等步骤来实现杂草检测任务