安装配置Hbase

目录

安装配置Hbase

一,测试Hadoop安装

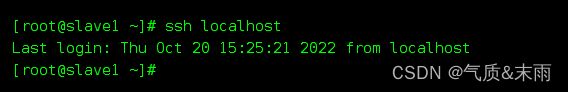

1、测试免密登录 master slave1 slave2 都要配置

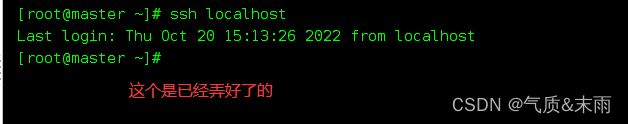

输入命令ssh localhost

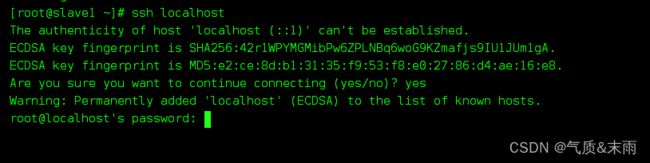

没有好的是这个样子需要输密码

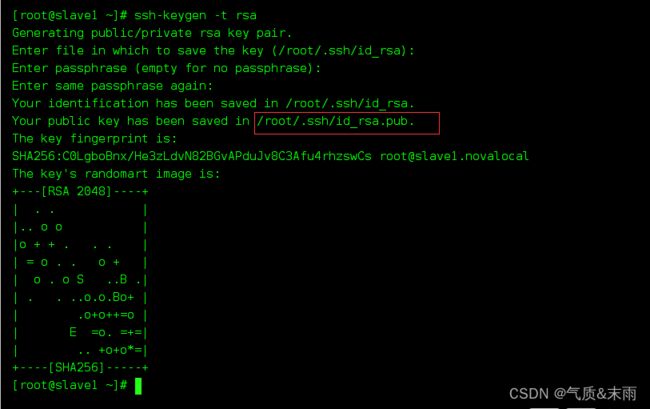

输入命令ssh-keygen -t rsa 会生成两个秘钥

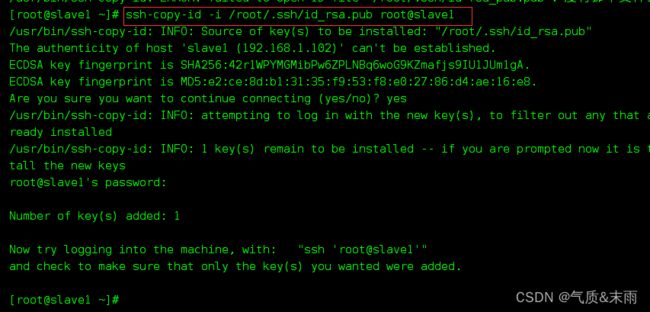

输入下面的命令,然后还有上面框中的路径

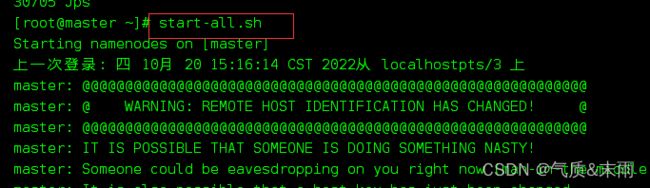

启动hbase 输入命令 start-all.sh 这个是启动所有

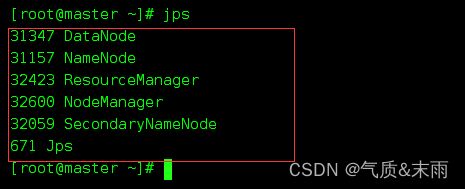

输入命令jps 查看进程 之前启动了进程 有六个是对的,如果没有启动只有一个jps

slave1 slave2 两个从节点 分别有三个进程

二、安装Hbase

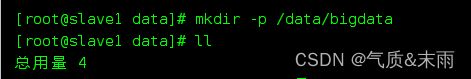

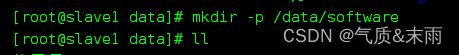

1,新建/data/software 和 /data/spftware 两个文件

输入命令 mkdir -p /data/software mkdir -p /data/bigdata

查看文件 ll 已经有了这两个文件夹了

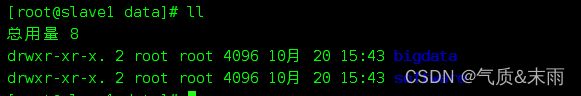

拷贝hbase2.5 到 /data/software 文件下 我这里是用的xftp 软件

2、安装hbase

输入命令 tar -zxvf hbase-2.5.0-bin.tar.gz -C /data/bigdata 解压到/data/bigdata文件下

3、配置环境

输入命令 创建超链接 ln -s hbase-2.5.0-bin.tar\(1\).gz hbase

![]()

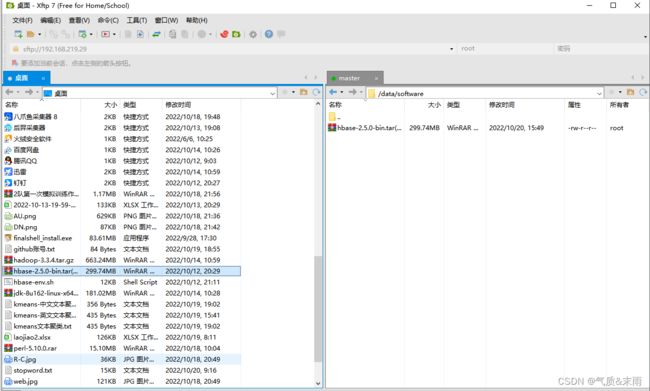

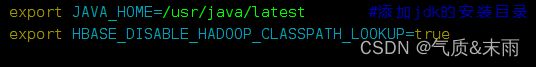

4,配置环境变量 /etc/profile 文件下 或者 /.bashrc

输入命令 vim /etc/profile,添加这两行变量

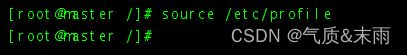

存盘退出之后,执行 source /etc/profile 注意: 此命令只能暂时生效,想完全生效得重启

修改hbase-env.sh 输入命令 vim /data/bigdata/hbase-2.5.0/conf/hbase-env.sh

![]()

进入之后,添加以下两行变量

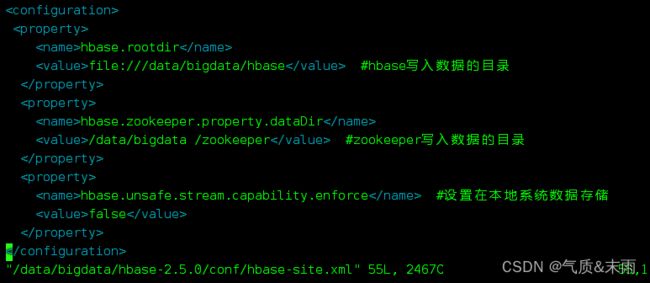

hbase 有三种模式,单机模式的修改如下, 修改hbase-site.xml(Hbase的主要配置文件)

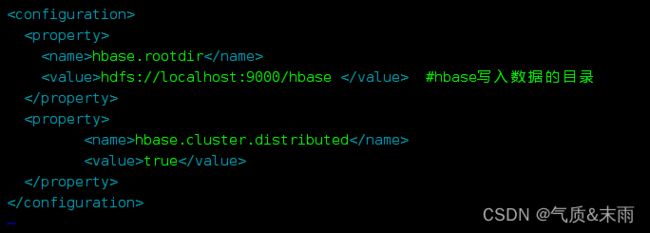

分布式分为伪分布式和完全分布式,伪分布式的修改如下, 修改hbase-site.xml(Hbase的主要配置文件)

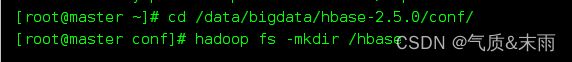

创建Hbase目录 输入命令 hadoop fs –mkdir /hbase 注意还是在刚刚配置的那个文件同一文件下

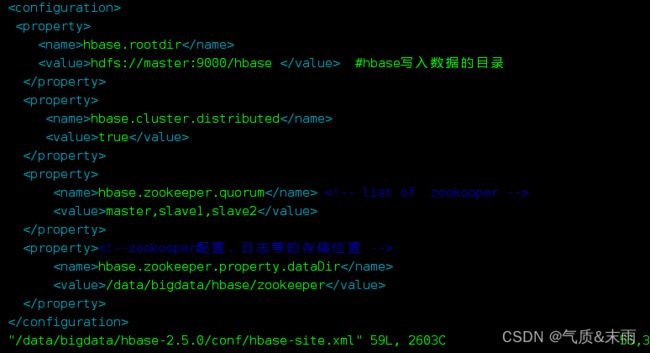

完全分布式模式修改如下 修改hbase-site.xml(Hbase的主要配置文件)

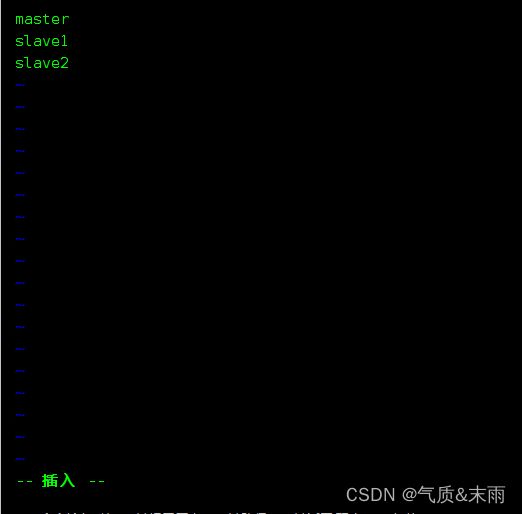

修改regionservers文件 去掉localhost 改为 master slave1 slave2

![]()

5、配置其他两个节点

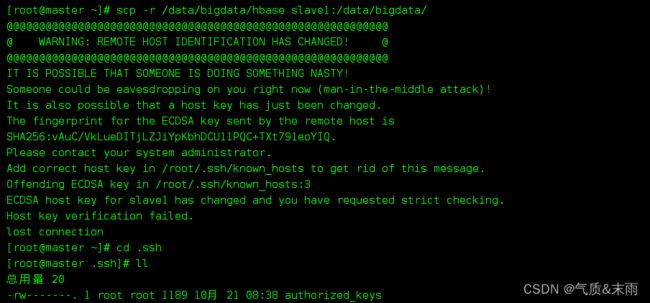

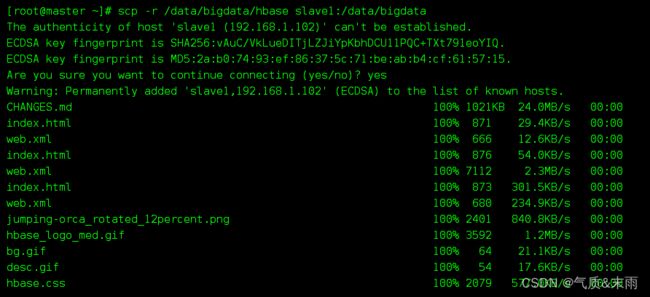

把在master上配置好的hbase,通过远程命令复制slave1、slave2对应的位置,输入命令

scp -r /data/bigdata/hbase slave1:/data/bigdata

scp -r /data/bigdata/hbase slave2:/data/bigdata

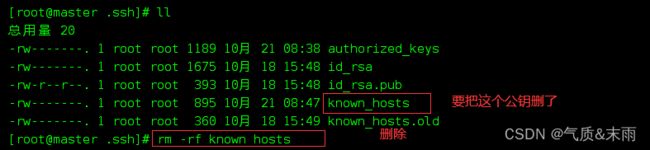

可能会出现一种错误,是因为公钥,私钥发生了变化,每一次的连接都记录在了上面,

输入命令 rm -rf known_hosts,把之前的公钥给删了

然后再执行命令,把master配置好的hbase分发给 slave1,slave2,就成功了

6、Hbase服务的启动与验证

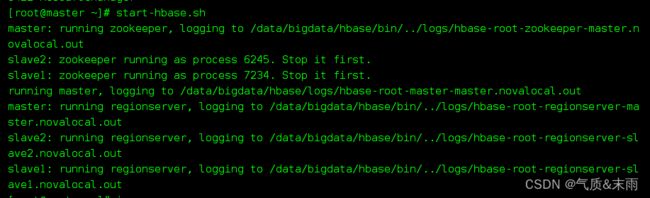

输入命令 start-hbase.sh 启动hbase 的服务

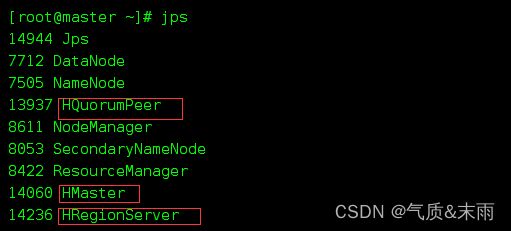

然后输入命令 查看进程 jps 有9个了 ,多出来的这三个是刚才启动了hbase 服务

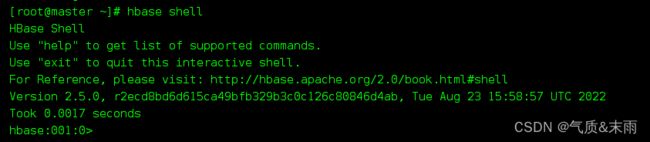

输入命令 hbase shell 启动Hbase

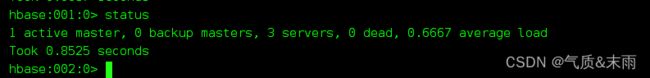

通用命令 status: 提供hbase的状态,例如服务器的数量

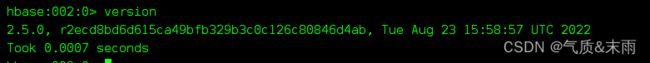

version: 提供当前Hbase 版本

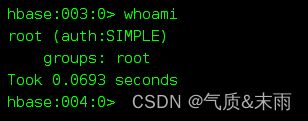

whoami: 提供有关用户的信息