linux安装Hadoop、hbase

目录

一、创建hadoop用户

(1)首先按 ctrl+alt+t 打开终端窗口,输入如下命令创建新用户 :

(2)切换账户,使用Hadoop账户登录登录以后需要更新一下apt

(3)安装好ssh服务

二、安装java

1.下载jdk

2.为jdk创建目录

3.为jdk压缩

4.配置环境

5.键盘i进行编写,在这个文件的开头位置,添加如下几行内容

6.让.bashrc文件的配置立即生效

7.使用如下命令查看是否安装成功出现版本号安装成功:

三、安装hadoop

1.下载

2.压缩

3.修改目录以及修改目录权限

4.查看安装是否成功

5.测试(跳过)

6.hadoop伪分布式安装

(1)修改core-site.xml文件

(3)执行初始化(只需初始化一次不然namenode后面开启不了)

四、安装hbase

1.下载

2.压缩

3.修改目录名称以及修改权限

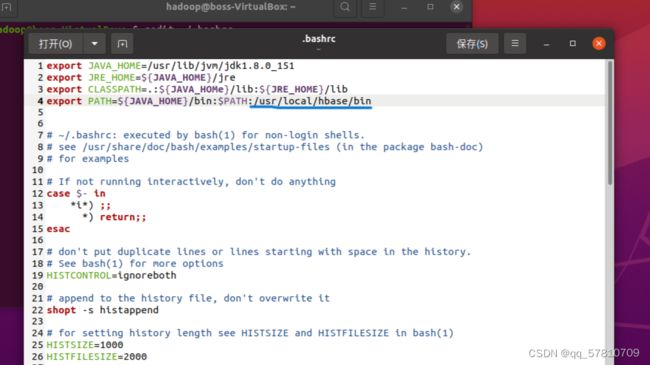

4.环境配置

5. 添加HBase权限

6查看版本号

7.hbase单机模式的配置

(9)退出ctrl+z,输入命令行

一、创建hadoop用户

(1)首先按 ctrl+alt+t 打开终端窗口,输入如下命令创建新用户 :

$ sudo useradd –m hadoop –s /bin/bash

接着使用如下命令设置密码,可简单设置为 hadoop

$ sudo passwd hadoop

可为 hadoop 用户增加管理员权限,方便部署,避免一些对新手来说比较棘手的权限问题:

$ sudo adduser hadoop sudo

(2)切换账户,使用Hadoop账户登录登录以后需要更新一下apt

$sudo apt-get update

使用Ubuntu操作系统中可以用vim编译器来建立文件和修改文件,需要安装一下

$sudo apt-get install vim

(3)安装好ssh服务

$sudo apt-get install ssh openssh-server

此时登入需要密码可以通过然后输入yes并通过密码登入

$ssh localhost

创建ssh-key,将密钥加入授权,此操作前先退出ssh登录

$exit

$cd ~/.ssh/

$ssh-keygen -t rsa

$cat ./id_rsa.pub >> ./authorized_keys //一直回车

然后即可无密码验证登录了,如下(如果进行了下面操作要记得exit退出要不然下面会出问题):

$ssh localhost

二、安装java

1.下载jdk

wget https://repo.huaweicloud.com/java/jdk/8u151-b12/jdk-8u151-linux-x64.tar.gz

2.为jdk创建目录

$cd /usr/lib

$sudo mkdir jvm //用来存放jdk

3.为jdk压缩,jdk的路径在你下载中我移动到了主目录下

$ cd ~

$ tar -zxf jdk-8u151-linux-x64.tar.gz -C /usr/lib/jvm

4.配置环境

$vim ~/.bashrc

5.键盘i进行编写,在这个文件的开头位置,添加如下几行内容

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_151

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

编辑完·esc退出输入:再按wq保存并退出

6.让.bashrc文件的配置立即生效

$source ~/.bashrc

7.使用如下命令查看是否安装成功出现版本号安装成功:

$java -version

三、安装hadoop

1.下载

wget https://repo.huaweicloud.com/apache/hadoop/common/hadoop-3.1.3/hadoop-3.1.3.tar.gz

2.压缩,hadoop的路径在你下载中我移动到了主目录下

$ sudo tar -zxf hadoop-3.1.3.tar.gz -C /usr/local

3.修改目录以及修改目录权限

$cd /usr/local/

$sudo mv ./hadoop-3.1.3/ ./hadoop # 将文件夹名改为hadoop

$sudo chown -R hadoop:hadoop ./hadoop # 修改文件权限

4.查看安装是否成功

$ cd /usr/local/hadoop

$./bin/hadoop version

5.测试(跳过)

6.hadoop伪分布式安装

(1)修改core-site.xml文件

$ cd /usr/local/hadoop

$gedit .//etc/hadoop/core-site.xml

在

hadoop.tmp.dir

file:/opt/hadoop/tmp

location to store temporary files

fs.defaultFS

hdfs://localhost:9000

(2) 修改hdfs-site.xml

$gedit .//etc/hadoop/hdfs-site.xml

dfs.replication

1

dfs.namenode.name.dir

file:/usr/local/hadoop/tmp/dfs/name

dfs.datanode.data.dir

file:/usr/local/hadoop/tmp/dfs/data

(3)执行初始化(只需初始化一次不然namenode后面开启不了)

$cd /usr/local/hadoop

$./bin/hdfs namenode -format

启动HDFS,出现四个完成

$cd /usr/local/hadoop

$./sbin/start-dfs.sh

$jps

四、安装hbase

1.下载

wget https://repo.huaweicloud.com/apache/hbase/2.5.0/hbase-2.5.0-bin.tar.gz

2.压缩,hbase的路径在你下载中我移动到了主目录下

$cd ~

$sudo tar -zxf hbase-2.5.0-bin.tar.gz -C /usr/local

3.修改目录名称以及修改权限

$cd /usr/local

$sudo mv ./hbase-2.5.0 ./hbase

$sudo chown -R hadoop ./hbase

4.环境配置

$gedit ~/.bashrc

如果没有引入过PATH请在~/.bashrc文件尾行添加如下内容:

export PATH=$PATH:/usr/local/hbase/bin

如果已经引入过PATH请在export PATH这行追加/usr/local/hbase/bin

保存然后关闭, 再执行source命令使立即生效

$source ~/.bashrc

5. 添加HBase权限

$cd /usr/local

$sudo chown -R hadoop ./hbase

6查看版本号

$ /usr/local/hbase/bin/hbase version

7.hbase单机模式的配置

(1)修改/usr/local/hbase/conf/hbase-env.sh

$gedit /usr/local/hbase/conf/hbase-env.sh

(2)添加内容如下图,保存并关闭

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_151

export HBASE_MANAGES_ZK=true

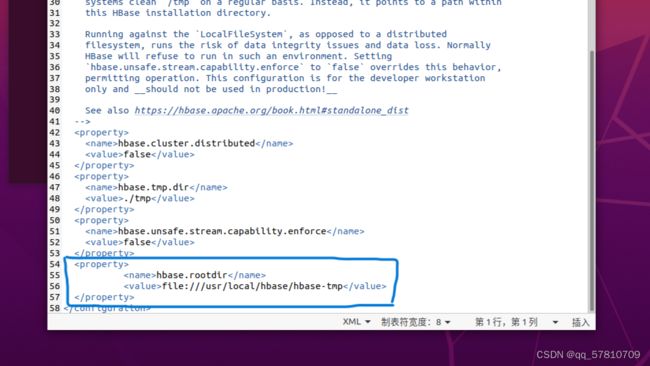

(3)修改/usr/local/hbase/conf/hbase-site.xml

$gedit /usr/local/hbase/conf/hbase-site.xml

(4)

hbase.rootdir

file:///usr/local/hbase/hbase-tmp

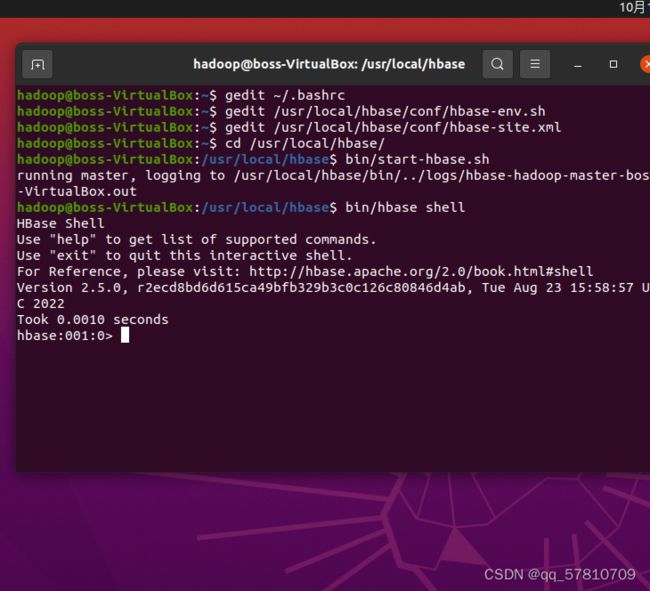

(8)启动HBase(先启动HDFS)

$cd /usr/local/hbase

$bin/start-hbase.sh

$bin/hbase shell

(9)退出ctrl+z,输入命令行

$bin/stop-hbase.sh

镜像源内包含hadoop,hive,mysql,hbase,spark

使用virtualbox虚拟机导入即可,mysql的账户为hive密码为hive

所有软件装在hadoop用户中镜像登入密码为123456

链接:https://pan.quark.cn/s/d55cd79cc336