使用Java API操作HDFS

目录

一、导入新课

二、新课讲解

(一)了解HDFS Java API

1、HDFS常见类与接口

2、FileSystem的常用方法

(二)编写Java程序访问HDFS

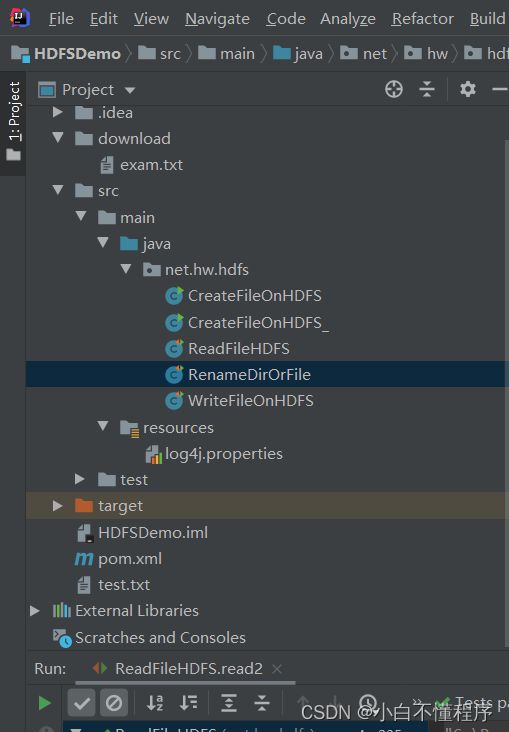

1、创建Maven项目

2、添加相关依赖

3、创建日志属性文件

4、启动集群HDFS服务

5、在HDFS上创建文件

6、写入HDFS文件

(1)将数据直接写入HDFS文件

(2)将本地文件写入HDFS文件

7、读取HDFS文件

(1)读取HDFS文件直接在控制台显示

(2)读取HDFS文件,保存为本地文件

8、重命名目录或文件

(1)重命名目录

(2)重命名文件

9、显示文件列表

(1)显示指定目录下文件全部信息

(2)显示指定目录下文件路径和长度信息

10、获取文件块信息

11、创建目录

12、判断目录或文件是否存在

13、判断Path指向目录还是文件

14、删除目录或文件

(1)删除文件

(2)删除目录

(3)删除目录或文件

三、总结本章知识点

一、导入新课

- 上一节对HDFS的Shell操作进行了详细的讲解,而HDFS Shell本质上就是对Java API的应用。本节课将针对HDFS Java API操作进行详细讲解。

二、新课讲解

- 由于Hadoop是使用Java语言编写的,因此可以使用Java API操作Hadoop文件系统。HDFS Shell本质上就是对Java API的应用,通过编程的形式操作HDFS,其核心是使用HDFS提供的Java API构造一个访问客户端对象,然后通过客户端对象对HDFS上的文件进行操作(增、删、改、查)。

(一)了解HDFS Java API

1、HDFS常见类与接口

- Hadoop整合了众多文件系统,HDFS只是这个文件系统的一个实例。

| 类或接口 | 功能描述 |

| org.apache.hadoop.fs.FileSystem | 一个通用文件系统的抽象基类,可被分布式文件系统继承。 |

| org.apache.hadoop.fs.FileStatus | 文件状态接口,用于向客户端展示系统中文件和目录的元数据。具体包括文件大小、块大小、副本信息、所有者、修改时间等,可通过FileSystem.listStatus()方法获得具体的实例对象。 |

| org.apache.hadoop.fs.FileDataInputStream | 文件输入流,用于读取Hadoop文件。 |

| org.apache.hadoop.fs.FileDataOutputStream | 文件输出流,用于写Hadoop文件。 |

| org.apache.hadoop.fs.Configuration | 访问配置项,所有配置项的值,如果在core-site.xml中有对应的配置,则以core-site.xml为准。 |

| org.apache.hadoop.fs.Path | 路径,用于表示Hadoop文件系统中的一个文件或一个目录的路径。 |

| org.apache.hadoop.fs.PathFilter | 路径过滤器接口,通过实现方法PathFilter.accept(Path path)来判断是否接收路径path表示的文件或目录。 |

2、FileSystem的常用方法

- FileSystem对象的一些方法可以对文件进行操作

| 方法名 | 功能描述 |

| copyFromLocalFile(Path src, Path dst) | 从本地磁盘复制文件到HDFS |

| copyToLocalFile(Path src, Path dst) | 从HDFS复制文件到本地磁盘 |

| mkdirs(Path f) | 建立子目录 |

| rename(Path src, Path dst) | 重命名文件或文件夹 |

| delete(Path f) | 删除指定文件 |

(二)编写Java程序访问HDFS

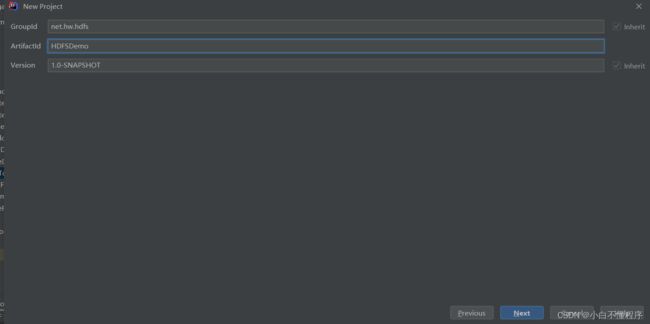

1、创建Maven项目

- 创建Maven项目 - HDFSDemo

- 单击next

- 单击【Finish】按钮

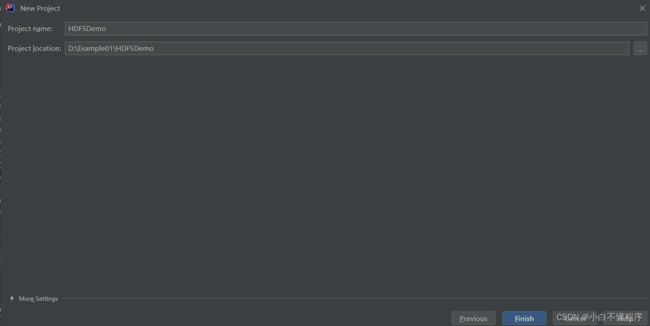

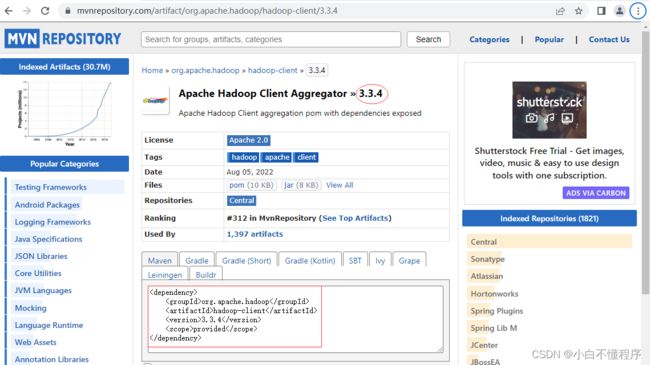

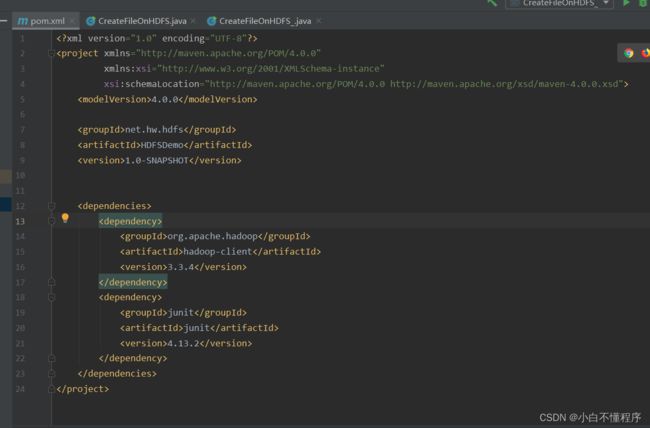

2、添加相关依赖

- 在

pom.xml文件里添加hadoop和junit依赖

org.apache.hadoop

hadoop-client

3.3.4

junit

junit

4.13.2

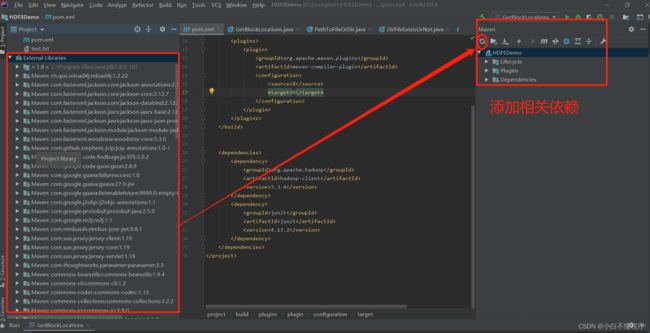

- Maven Repository(Maven仓库)- https://mvnrepository.com/

- 搜索

hadoop

- 单击

hadoop-client超链接

- 单击

3.3.4超链接

3、创建日志属性文件

log4j.rootLogger=stdout, logfile

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/hdfs.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%n

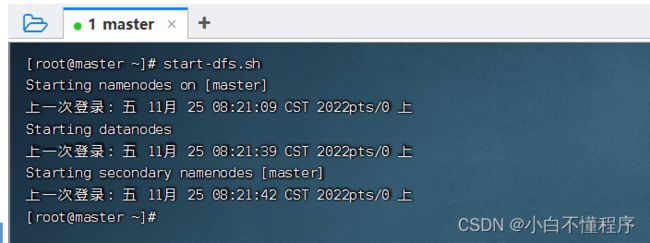

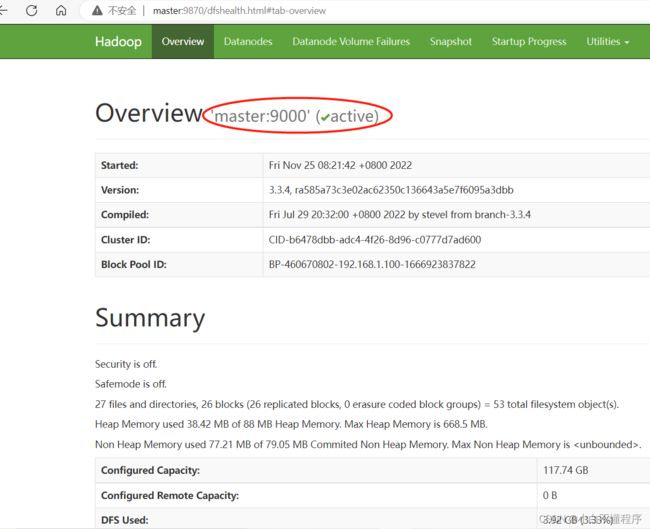

4、启动集群HDFS服务

- 在主节点上执行命令:

start-dfs.sh

- 在Hadoop WebUI界面查看

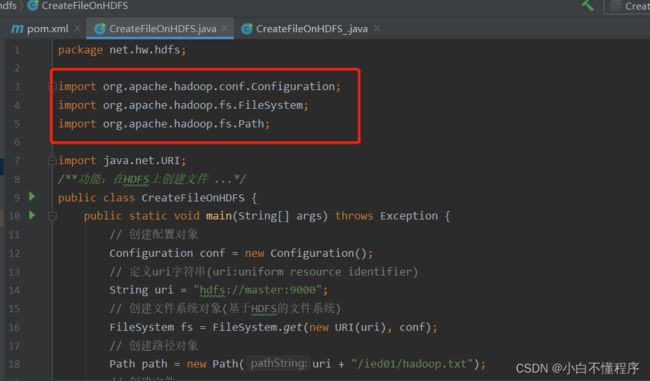

5、在HDFS上创建文件

- 在HDFS Shell里利用

hdfs dfs -touchz命令可以创建时间戳文件 - 任务:在

/ied01目录创建hadoop.txt文件

- 创建

net.hw.hdfs包,在包里创建CreateFileOnHDFS类

![]()

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import java.net.URI;

/**功能:在HDFS上创建文件 ...*/

public class CreateFileOnHDFS {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义uri字符串(uri:uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象

Path path = new Path(uri + "/ied01/hadoop.txt");

// 创建文件

boolean result = fs.createNewFile(path);

// 根据返回值判断文件是否创建成功

if (result) {

System.out.println("文件[" + path + "]创建成功!");

} else {

System.out.println("文件[" + path + "]创建失败!");

}

}

}

- 注意:导包千万不要导错了

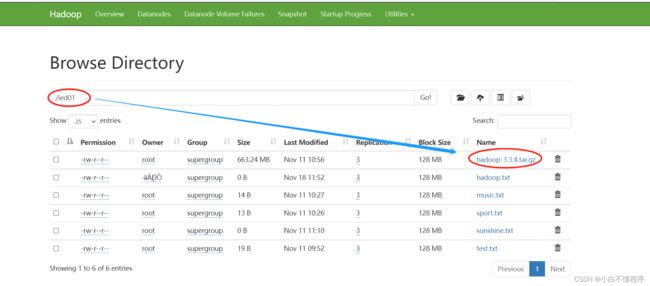

- 查看运行结果

- 利用HDFS集群WebUI查看

- 在/ied01目录里确实创建了一个0字节的hadoop.txt文件,有点类似于Hadoop Shell里执行hdfs dfs -touchz /ied01/hadoop.txt命令的效果,但是有一点不同,hdfs dfs -touchz命令重复执行,不会失败,只是不断改变该文件的时间戳。

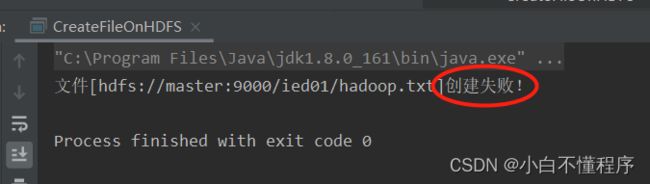

- 再次运行程序,由于

hadoop.txt已经存在,此时会提示用户创建失败

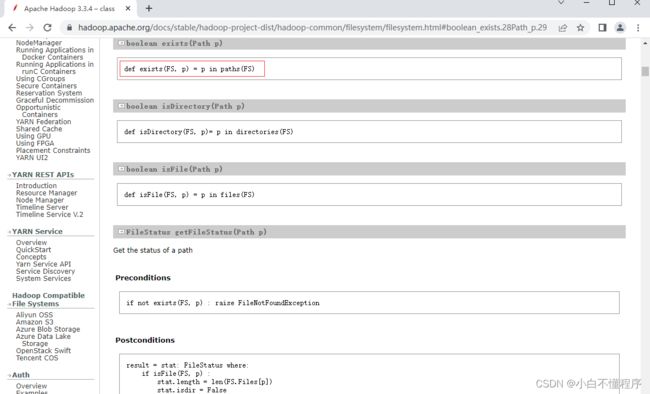

- 能否事先判断文件是否存在呢?我们去查看Hadoop FileSystem API文档

https://hadoop.apache.org/docs/stable/hadoop-project-dist/hadoop-common/filesystem/filesystem.html

- 查看

exists(Path path)方法

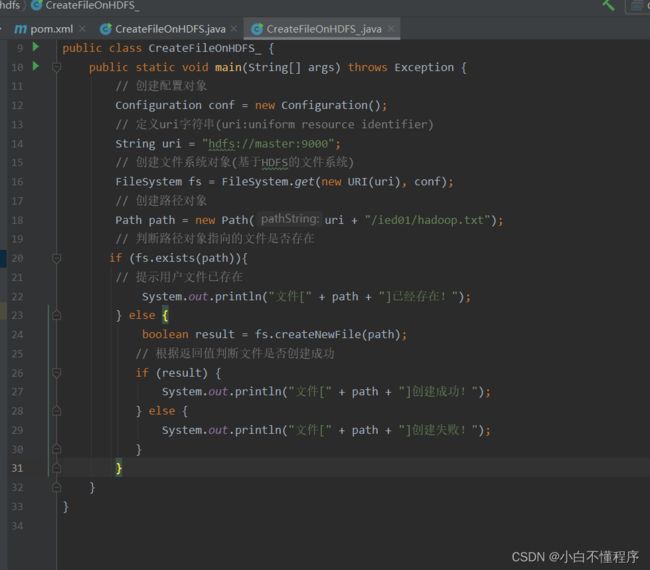

- 新建

CreateFileOnHDFS_类,事先判断文件是否存在

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import java.io.IOException;

import java.net.URI;

public class CreateFileOnHDFS_ {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义uri字符串(uri:uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象

Path path = new Path(uri + "/ied01/hadoop.txt");

// 判断路径对象指向的文件是否存在

if (fs.exists(path)){

// 提示用户文件已存在

System.out.println("文件[" + path + "]已经存在!");

} else {

try {

boolean result = fs.createNewFile(path);

// 根据返回值判断文件是否创建成功

if (result) {

System.out.println("文件[" + path + "]创建成功!");

} else {

System.out.println("文件[" + path + "]创建失败!");

}

} catch (IOException e) {

System.err.println("异常信息:"+ e.getMessage());

}

}

}

}

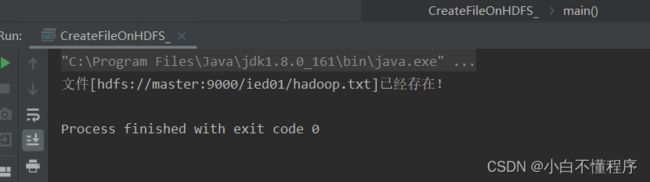

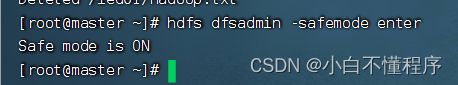

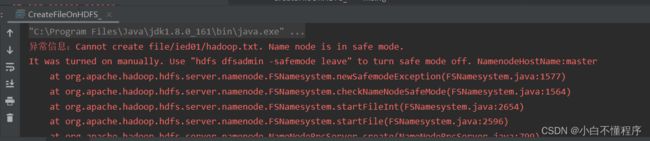

- 执行命令:

hdfs dfsadmin -safemode enter

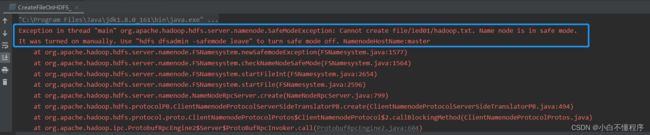

- 此时,再运行程序,查看结果,抛出

SafeModeException异常

- 下面,修改程序,来处理这个可能会抛出的安全模式异常

![]()

- 运行程序,查看结果

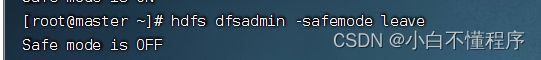

- 关闭安全模式,执行命令:

hdfs dfsadmin -safemode leave

- 再运行程序,查看效果

6、写入HDFS文件

- 类似于HDFS Shell里的

hdfs dfs -put命令

- 在

net.hw.hdfs包里创建WriteFileOnHDFS类

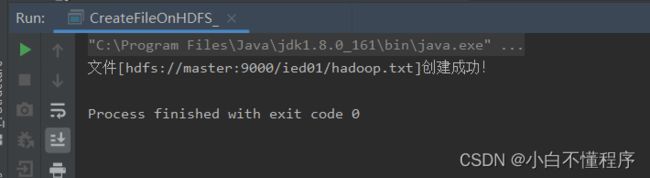

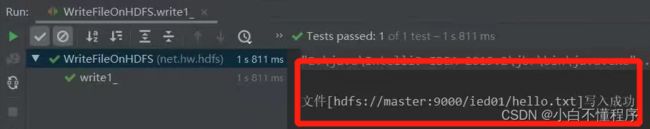

(1)将数据直接写入HDFS文件

- 任务:创建

write1()方法 - 运行write1()测试方法,查看结果

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataOutputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;import java.net.URI;

/**

* 功能:写入HDFS文件

* 日期:2022年11月30日

*/

public class WriteFileOnHDFS {

@Test

public void write1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf);

// 创建路径对象(指向文件)

Path path = new Path(uri + "/ied01/hello.txt");

// 创建文件系统数据字节输出流(出水管:数据从程序到文件)

FSDataOutputStream out = fs.create(path);

// 通过字节输出流向文件写数据

out.write("Hello Hadoop World".getBytes());// 提示用户写文件成功

System.out.println("文件[" + path + "]写入成功!");

// 关闭文件系统数据字节输出流

out.close();

// 关闭文件系统对象

fs.close();

}

}

- 运行

write1()测试方法,查看结果,抛出RemoteException异常,三个数据节点都在运行,但是无法写入数据

- 修改代码,设置数据节点主机名属性,如下图所示

- 运行程序,查看结果

- 利用HDFS集群WebUI查看hello.txt文件

(2)将本地文件写入HDFS文件

- 在项目根目录创建一个文本文件test.txt

- 创建write2()方法

@Test

public void write2() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向目录或文件)

Path path = new Path(uri + "/ied01/exam.txt");

// 创建文件系统数据字节输出流对象

FSDataOutputStream out = fs.create(path);

// 创建文件字符输入流对象

FileReader fr = new FileReader("test.txt");

// 创建缓冲字符输入流对象

BufferedReader br = new BufferedReader(fr);

// 定义行字符串

String nextLine = "";

// 通过循环读取缓冲字符输入流

while ((nextLine = br.readLine()) != null) {

// 在控制台输出读取的行

System.out.println(nextLine);

// 通过文件系统数据字节输出流对象写入指定文件

out.write(nextLine.getBytes());

}

// 关闭文件系统字节输出流

out.close();

// 关闭缓冲字符输入流

br.close();

// 关闭文件字符输入流

fr.close();

// 提示用户写入文件成功

System.out.println("本地文件[test.txt]成功写入[" + path + "]!");

}

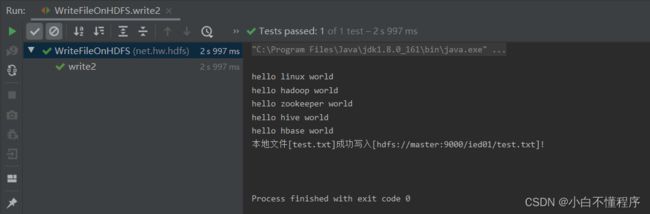

- 运行write2()测试方法,查看结果

- 查看

/ied01/exam.txt内容

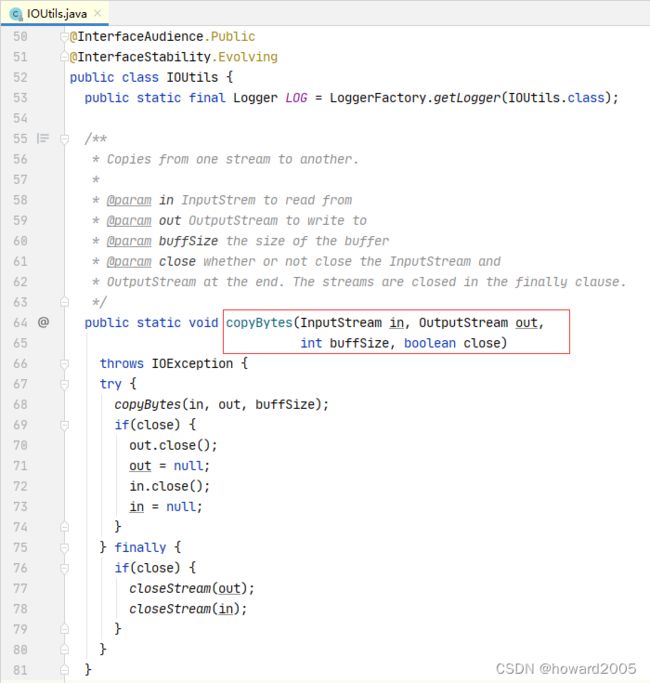

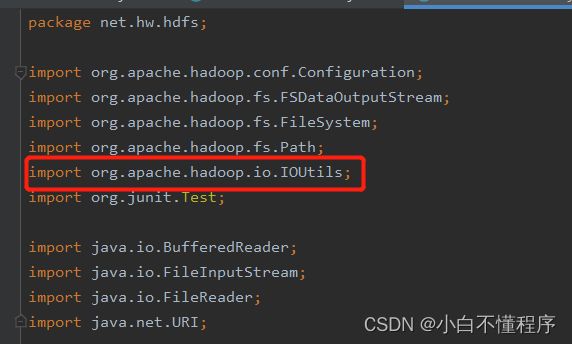

- 其实这个方法的功能就是将本地文件复制(上传)到HDFS,有没有更简单的处理方法呢?有的,通过使用一个工具类IOUtils来完成文件的相关操作。(转载华老师图片)

- 编写write3()方法

@Test

public void write3() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向目录或文件)

Path path = new Path(uri + "/ied01/test.txt");

// 创建文件系统数据字节输出流对象

FSDataOutputStream out = fs.create(path);

// 创建文件字节输入流对象

FileInputStream in = new FileInputStream("test.txt");

// 利用IOUtils类提供的字节拷贝方法来复制文件

IOUtils.copyBytes(in, out, conf);

// 关闭文件字节输入流

in.close();

// 关闭文件系统数据字节输出流

out.close();

// 关闭文件系统

fs.close();

// 提示用户写入文件成功

System.out.println("本地文件[test.txt]成功写入[" + path + "]!");

}

- 注意导包问题

- 运行write3()测试方法,查看结果

- 查看/ied01/test.txt内容

7、读取HDFS文件

- 在

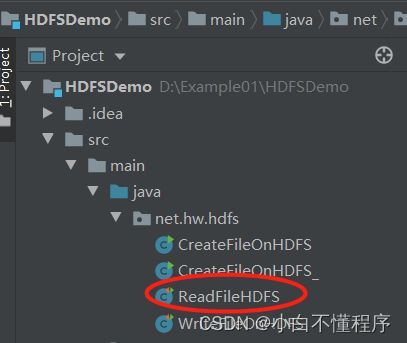

net.hw.hdfs包里创建ReadFileOnHDFS类

(1)读取HDFS文件直接在控制台显示

-

准备读取

hdfs://master:9000/ied01/test.txt文件

- 编写

read1()方法

import org.apache.hadoop.conf.Configuration; import org.apache.hadoop.fs.FSDataInputStream; import org.apache.hadoop.fs.FileSystem; import org.apache.hadoop.fs.Path; import org.junit.Test; import java.io.BufferedReader; import java.io.InputStreamReader; import java.net.URI; public class ReadFileOnHDFS { @Test public void read1() throws Exception{ //创建配置对象 Configuration conf = new Configuration(); //设置数据节点主机名属性 conf.set("dfs.client.use.datanode.hostname", "true"); //定义uri字符串 String uri = "hdfs://master:9000"; //创建文件系统对象 FileSystem fs = FileSystem.get(new URI(uri), conf, "root"); //创建路径对象(文件或目录) Path path = new Path(uri + "/ied01/test.txt"); // 创建文件系统数据字节输入流对象 FSDataInputStream in = fs.open(path); //创建缓冲字符输入流对象,提高读取效率(字节流-->字符流-->缓冲流) BufferedReader br = new BufferedReader(new InputStreamReader(in)); //定义字符串 String nextLine = ""; //在控制台输出读取的内容 while ((nextLine = br.readLine())!= null){ //在控制台输出读取的内容 System.out.println(nextLine); } //关闭缓冲字符输入流 br.close(); //关闭文件系统数据字节输出流 in.close(); //关闭文件系统 fs.close(); }}

- 运行

read1()测试方法,查看结果

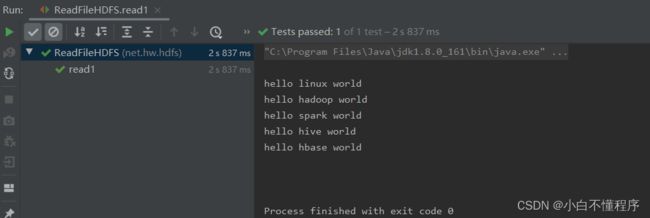

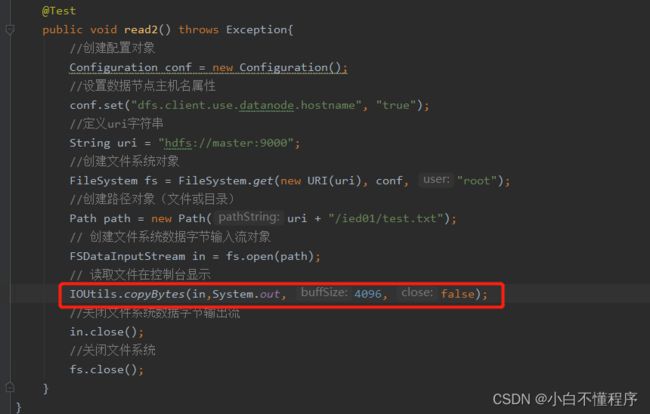

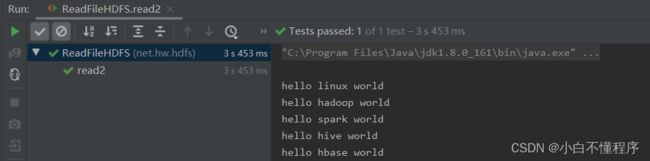

- 其实,我们可以使用

IOUtils类来简化代码,创建read2()测试方法

- 再运行

read2()测试方法,查看结果

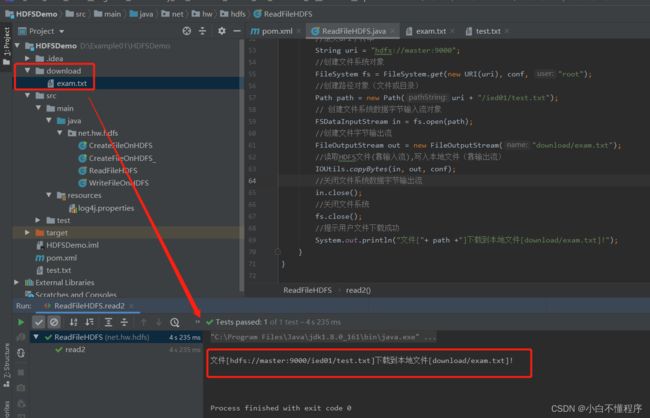

(2)读取HDFS文件,保存为本地文件

-

任务:将

/ied01/test.txt下载到项目下download目录里 -

创建

download目录,在HDFSDemo直接创建文件download,否则运行时,将无法找到系统文件路径。

- 创建

read2()方法,(我是将原本的read2修改后的结果!未新建新的read2,也可以将其改名为其他的名字。) - 运行

read2()测试方法,查看结果

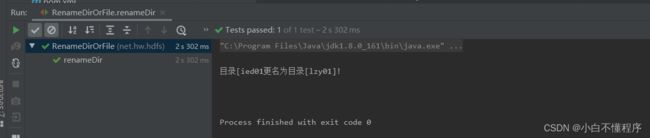

8、重命名目录或文件

- 相当于Shell里的

hdfs dfs -mv命令 - 在

net.hw.hdfs包里创建RenameDirOrFile类

(1)重命名目录

- 任务:将

/ied01目录更名为/lzy01 - 编写

renameDir()方法

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;import java.net.URI;

public class RenameDirOrFile {

@Test

public void renameDir() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建源路径对象

Path sourcePath = new Path("/ied01");

// 创建目标路径对象

Path targetPath = new Path("/lzy01");

// 利用文件系统对象重命名目录

fs.rename(sourcePath, targetPath);

// 关闭文件系统

fs.close();

// 提示用户目录更名成功

System.out.println("目录[" + sourcePath.getName() + "更名为目录[" + targetPath.getName() + "]!");

}

}

- 运行

renameDir()方法,查看结果

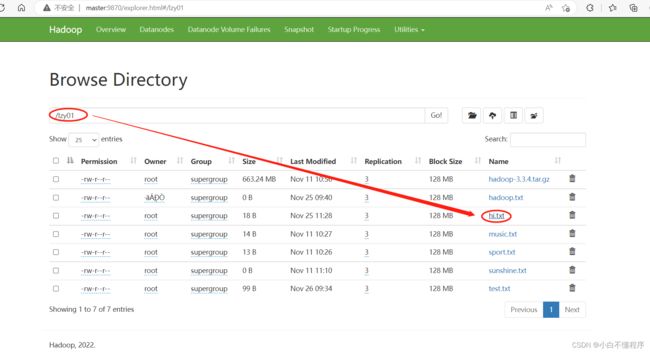

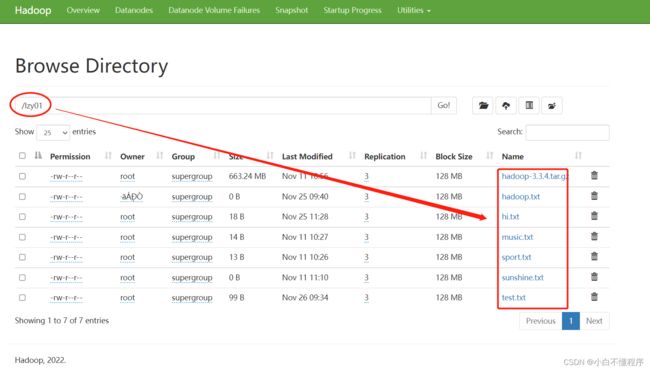

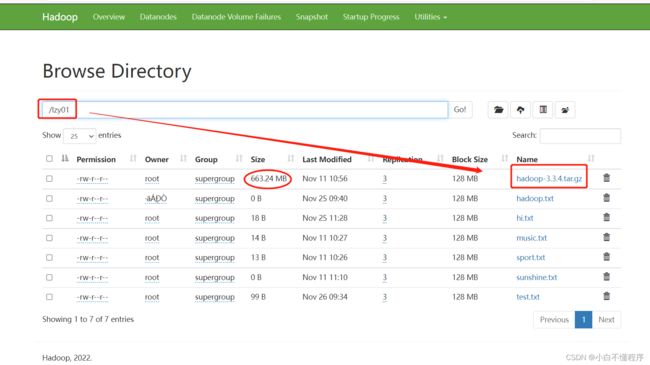

- 利用Hadoop WebUI界面查看

(2)重命名文件

- 任务:将

lzy01目录下的test.txt重命名为test2.txt。

- 编写

renameFile()方法

@Test

public void renameFile() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义统一资源标识符(uri: uniform resource identifier)

String uri = "hdfs://master:9000";

// 创建文件系统对象(基于HDFS的文件系统)

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建源路径对象(指向文件)

Path sourcePath = new Path(uri + "/lzy01/hello.txt");

// 创建目标路径对象(指向文件)

Path destinationPath = new Path(uri + "/lzy01/hi.txt");

// 利用文件系统对象重命名文件

fs.rename(sourcePath, destinationPath);

// 关闭文件系统

fs.close();

// 提示用户文件更名成功

System.out.println("文件[" + sourcePath.getName() + "]更名为文件[" + destinationPath.getName() + "]!");

}

- 运行

renameFile()测试方法,查看结果

- 利用Hadoop WebUI界面查看

9、显示文件列表

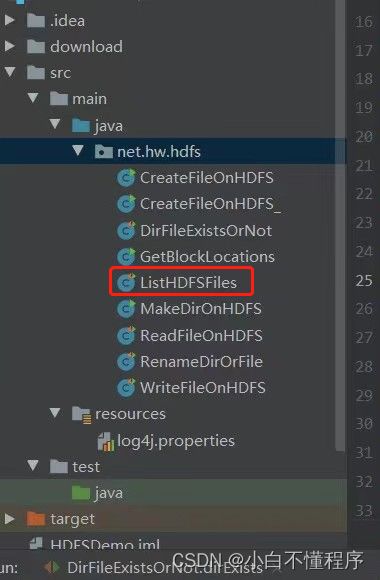

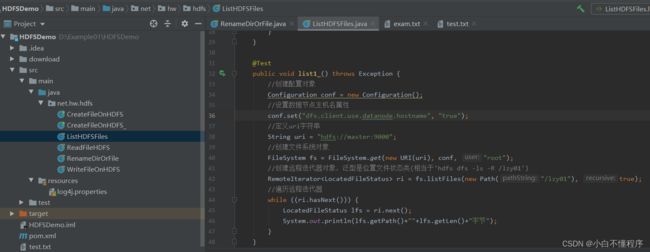

- 在net.hw.hdfs包里创建ListHDFSFiles类

(1)显示指定目录下文件全部信息

- 任务:显示/lzy01目录下的文件列表

- 编写list1()方法

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.LocatedFileStatus;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.fs.RemoteIterator;

import org.junit.Test;import java.net.URI;

/**

* 功能:显示文件列表

* 日期:2022年11月26日

*/

public class ListHDFSFiles {

@Test

public void list1() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建远程迭代器对象,泛型是位置文件状态类(相当于`hdfs dfs -ls -R /lzy01`)

RemoteIteratorri = fs.listFiles(new Path("/lzy01"), true);

// 遍历远程迭代器

while (ri.hasNext()) {

System.out.println(ri.next());

}

}

}

- 运行list1()测试方法,查看结果

- 上述文件状态对象封装的有关信息,可以通过相应的方法来获取,比如getPath()方法就可以获取路径信息,getLen()方法就可以获取文件长度信息……

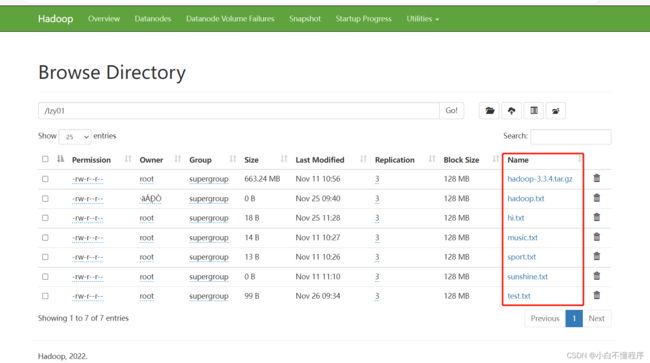

(2)显示指定目录下文件路径和长度信息

- 编写list2()方法

@Test

public void list2() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建远程迭代器对象,泛型是位置文件状态类(相当于`hdfs dfs -ls -R /lzy01`)

RemoteIteratorri = fs.listFiles(new Path("/lzy01"), true);

// 遍历远程迭代器

while (ri.hasNext()) {

LocatedFileStatus lfs = ri.next();

System.out.println(lfs.getPath() + " " + lfs.getLen() + "字节");

}

}

- 运行list2()测试方法,查看结果,(做的过程中,我将其方法改成了list_())

- 对照Hadoop WebUI上给出的文件长度信息

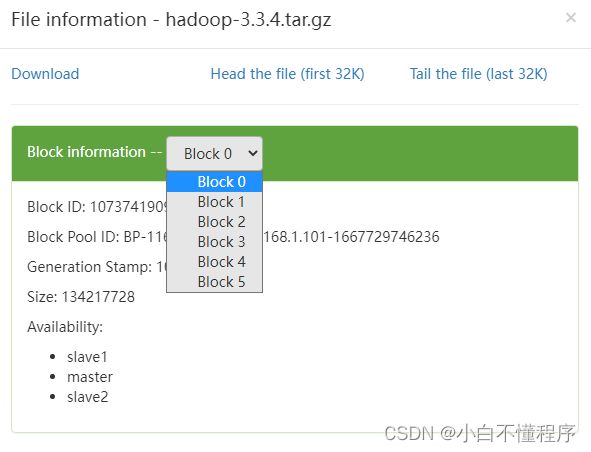

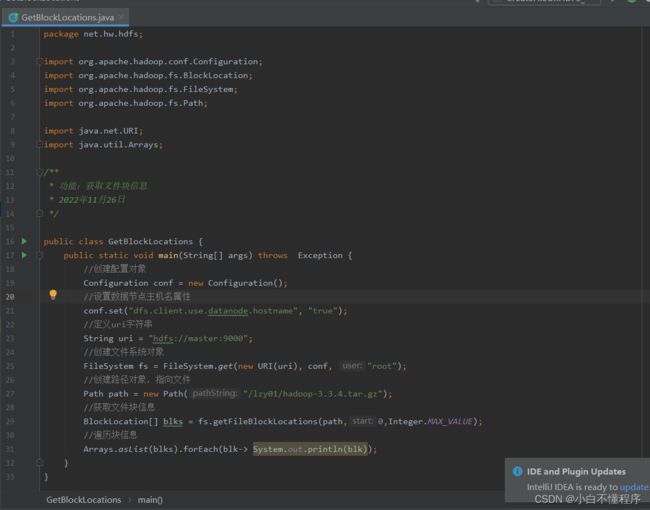

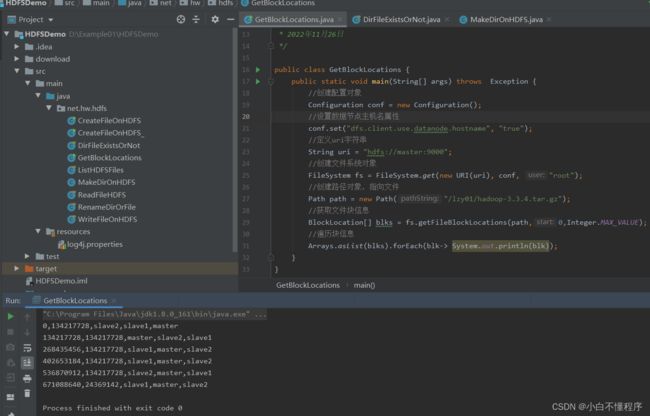

10、获取文件块信息

- 任务:获取/lzy01/hadoop-3.3.4.tar.gz文件块信息

- hadoop压缩包会分割成6个文件块

- 在net.hw.hdfs包里创建GetBlockLocations类

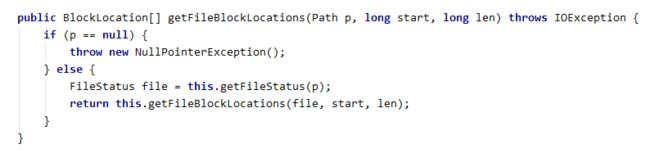

- 用到getFileBlockLocations()方法来获取物理切块信息

参数1:文件路径

参数2:起点

参数3:长度

- 编写代码,获取文件块信息

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.BlockLocation;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;import java.net.URI;

import java.util.Arrays;/**

* 功能:获取文件块信息

* 日期:2022年11月26日

*/

public class GetBlockLocations {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象,指向文件

Path path = new Path("/lzy01/hadoop-3.3.4.tar.gz");

// 获取文件块信息

BlockLocation[] blks = fs.getFileBlockLocations(path, 0, Integer.MAX_VALUE);

// 利用Lambda表达式遍历块信息

Arrays.asList(blks).forEach(blk -> System.out.println(blk));

}

}

- 运行程序,查看结果(切点位置,块大小,块存在位置)

- 由此可见,hadoop-3.3.4.tar.gz被hadoop物理切分成6块,前5块长度均为134217728字节(128MB),第6块长度为24369142字节(23.24MB)。

11、创建目录

- 任务:在HDFS上创建/ied01目录

- 在net.hw.hdfs包里创建MakeDirOnHDFS类

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;import java.net.URI;

/**

* 功能:在HDFS上创建目录

* 日期:2022年11月26日

*/

public class MakeDirOnHDFS {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象,指向目录

Path path = new Path("/ied01");

// 利用文件系统创建指定目录

boolean result = fs.mkdirs(path);

// 判断目录是否创建成功

if (result) {

System.out.println("目录[" + path + "]创建成功!" );

} else {

System.out.println("目录[" + path + "]创建失败!" );

}

}

}

- 运行程序,查看结果

- 利用Hadoop WebUI界面查看

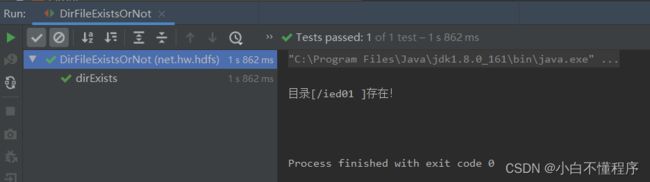

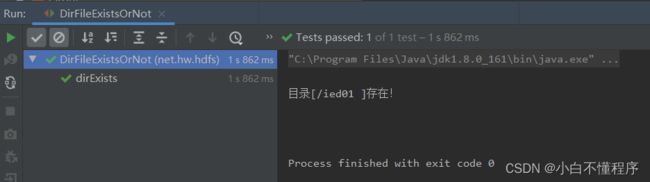

12、判断目录或文件是否存在

- 任务:判断HDFS上/ied01目录是否存在,判断/ied01/hadoop.txt文件是否存在

- 在net.hw.hdfs包里创建DirFileExistsOrNot类

- 编写dirExists()方法

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;import java.net.URI;

/**

* 功能:判断目录或文件是否存在

* 日期:2022年11月26日

*/

public class DirFileExistsOrNot {

@Test

public void dirExists() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象,指向目录

Path path = new Path("/ied01");

// 判断目录是否存在

if (fs.exists(path)) {

System.out.println("目录[" + path + "]存在!");

} else {

System.out.println("目录[" + path + "]不存在!");

}

}

}

- 运行程序,查看结果

- 修改代码,再测试

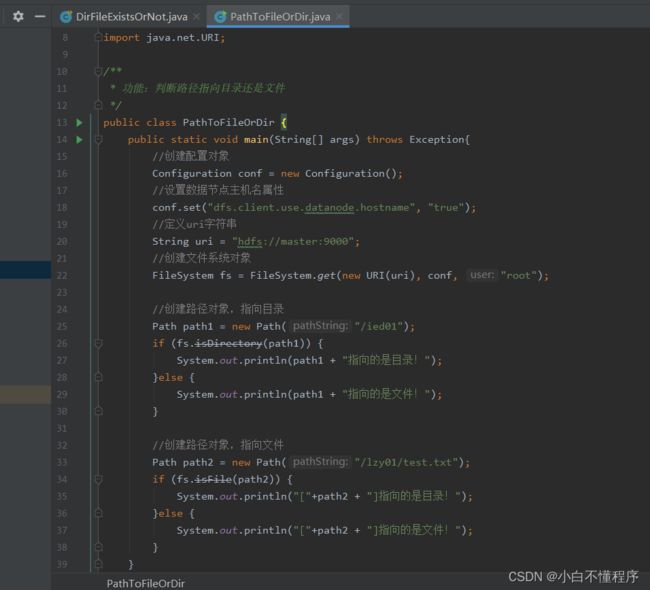

13、判断Path指向目录还是文件

- 在net.hw.hdfs包里创建PathToFileOrDir类

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;import java.net.URI;

/**

* 功能:判断路径指向目录还是文件

* 日期:2022年11月26日

*/

public class PathToFileOrDir {

public static void main(String[] args) throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");// 创建路径对象,指向目录

Path path1 = new Path("/ied01");

if (fs.isDirectory(path1)) {

System.out.println("[" + path1 + "]指向的是目录!");

} else {

System.out.println("[" + path1 + "]指向的是文件!");

}// 创建路径对象,指向文件

Path path2 = new Path("/lzy01/test.txt");

if (fs.isFile(path2)) {

System.out.println("[" + path2 + "]指向的是文件!");

} else {

System.out.println("[" + path2 + "]指向的是目录!");

}

}

}

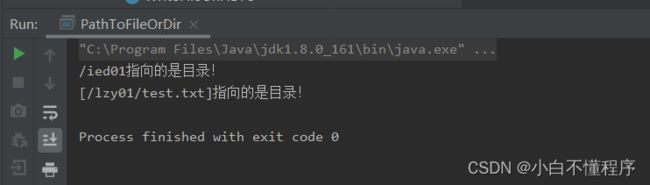

- 运行程序,查看结果

14、删除目录或文件

- 类似于HDFS Shell里的

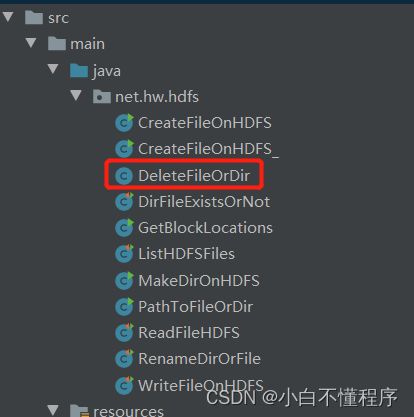

hdfs dfs -rmdir和hdfs dfs -rm -r命令 - 在

net.hw.hdfs包里创建DeleteFileOrDir类

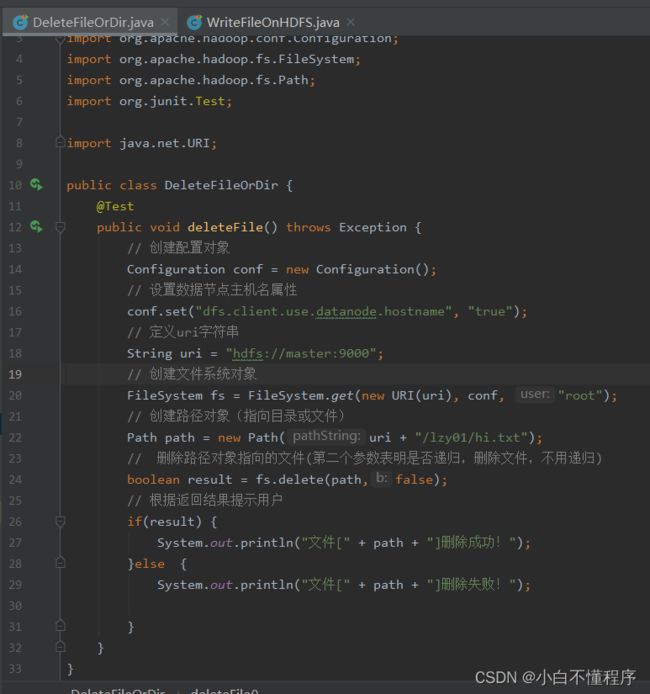

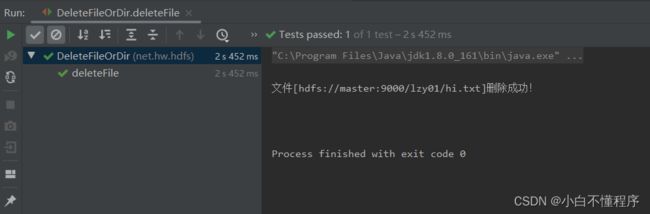

(1)删除文件

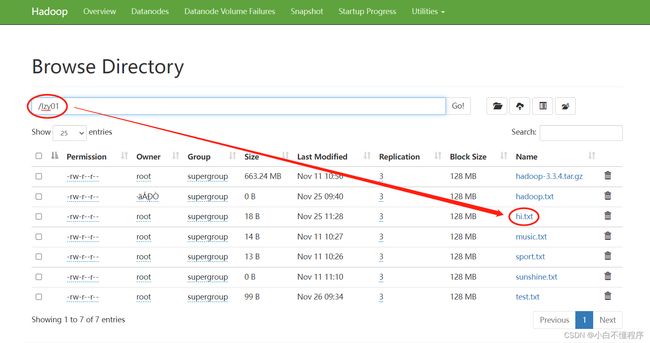

- 任务:删除

/lzy01/hi.txt文件

- 编写

deleteFile()方法

package net.hw.hdfs;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.junit.Test;

import java.net.URI;

public class DeleteFileOrDir {

@Test

public void deleteFile() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向目录或文件)

Path path = new Path(uri + "/lzy01/hi.txt");

// 删除路径对象指向的文件(第二个参数表明是否递归,删除文件,不用递归)

boolean result = fs.delete(path, false);

// 根据返回结果提示用户

if (result) {

System.out.println("文件[" + path + "]删除成功!");

} else {

System.out.println("文件[" + path + "]删除失败!")

}

}

}

- 运行

deleteFile()测试方法,查看结果

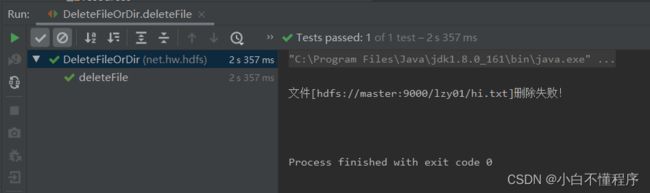

- 再运行

deleteFile()测试方法,查看结果

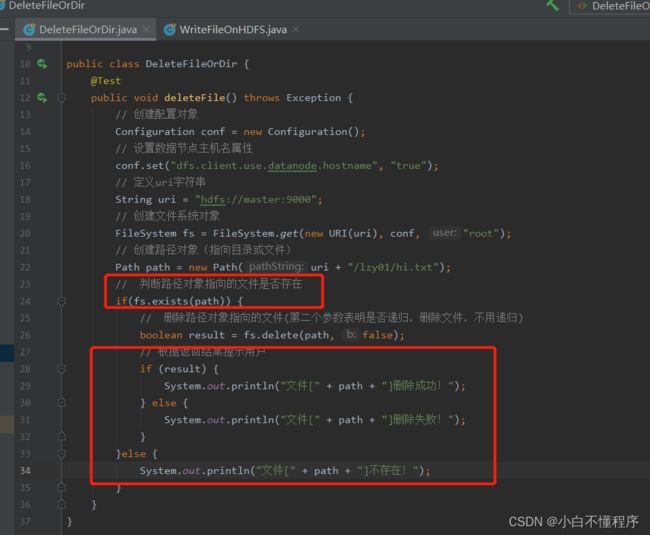

- 可以在删除文件之前,判断文件是否存在,需要修改代码

@Test public void deleteFile() throws Exception { // 创建配置对象 Configuration conf = new Configuration(); // 设置数据节点主机名属性 conf.set("dfs.client.use.datanode.hostname", "true"); // 定义uri字符串 String uri = "hdfs://master:9000"; // 创建文件系统对象 FileSystem fs = FileSystem.get(new URI(uri), conf, "root"); // 创建路径对象(指向目录或文件) Path path = new Path(uri + "/lzy01/hi.txt"); // 判断路径对象指向的文件是否存在 if(fs.exists(path)) { // 删除路径对象指向的文件(第二个参数表明是否递归,删除文件,不用递归) boolean result = fs.delete(path, false); // 根据返回结果提示用户 if (result) { System.out.println("文件[" + path + "]删除成功!"); } else { System.out.println("文件[" + path + "]删除失败!"); } }else { System.out.println("文件[" + path + "]不存在!"); } }}

- 此时运行

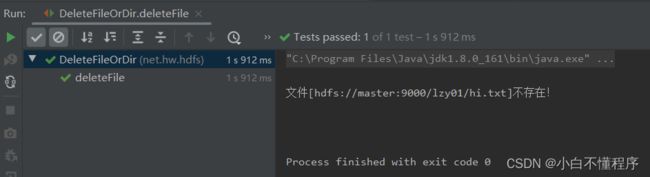

deleteFile()测试方法,查看结果

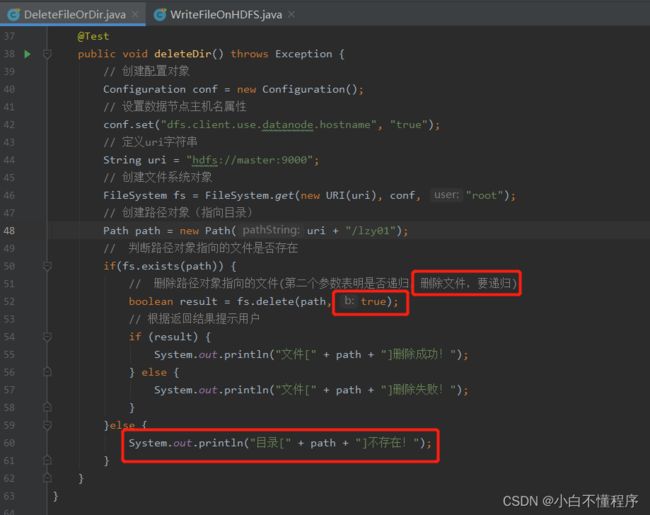

(2)删除目录

- 任务:删除

/lzy01目录 - 编写

deleteDir()方法

@Test

public void deleteDir() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 创建路径对象(指向目录)

Path path = new Path(uri + "/lzy01");

// 判断路径对象指向的文件是否存在

if(fs.exists(path)) {

// 删除路径对象指向的文件(第二个参数表明是否递归,删除文件,要递归)

boolean result = fs.delete(path, true);

// 根据返回结果提示用户

if (result) {

System.out.println("文件[" + path + "]删除成功!");

} else {

System.out.println("文件[" + path + "]删除失败!");

}

}else {

System.out.println("目录[" + path + "]不存在!");

}

}

}

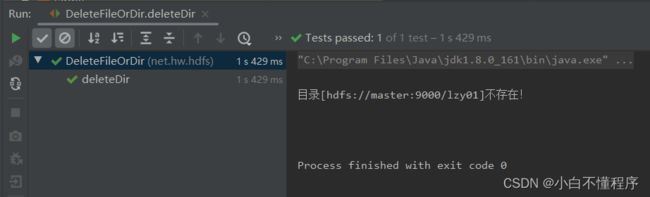

- 运行

deleteDir()方法,查看结果

- 再运行

deleteDir()方法,查看结果

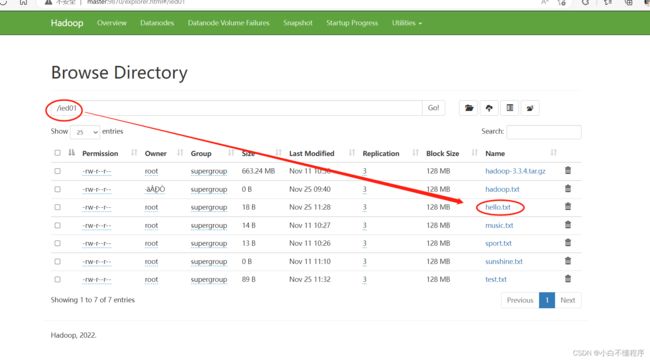

(3)删除目录或文件

- 进行三个层面的判断:判断类型(目录或文件)、判断是否存在、判断删除是否成功。

- 任务:删除

/ied02/exam.txt文件和lzy01目录

- 编写

delete()方法

@Test

public void delete() throws Exception {

// 创建配置对象

Configuration conf = new Configuration();

// 设置数据节点主机名属性

conf.set("dfs.client.use.datanode.hostname", "true");

// 定义uri字符串

String uri = "hdfs://master:9000";

// 创建文件系统对象

FileSystem fs = FileSystem.get(new URI(uri), conf, "root");

// 定义随机对象

Random random = new Random();

// 产生随机整数

int choice = random.nextInt(100) % 2;

// 定义路径字符串

String[] strPath = {"/ied02/exam.txt","/lzy01"};

//定义路径对象(指向目录或文件)

Path path = new Path(uri+strPath[choice]);

//文件类型:目录或文件

String type = "";

if (fs.isDirectory(path)){

type = "目录";

}else {

type = "文件";

}

// 判断存在性

if(fs.exists(path)){

// 删除路径对象指向的文件或目录

boolean result = fs.delete(path,true);

// 判断删除是否成功

if (result){

System.out.println(type+"["+path+"]删除成功!");

}else {

System.out.println(type+"["+path+"]删除失败!");

}

}else {

System.out.println(type + "["+path+"]不存在!");

}

}

}

- 运行

delete()测试方法,查看结果(运行结果为随机)

- 再次运行,查看结果

- 再次运行,查看结果

![]()

三、总结本章知识点

- 学会创建Maven项目

- 在idea添加相关的依赖

- 创建日志性文件

- 会在HDFS上创建文件

- 会写入并读取文件

- 会重命名目录或文件

-

显示文件列表

-

能够获取文件块信息

-

创建目录和判断目录或文件是否存在

-

能够判断path是指向文件还是目录

-

最后能够删除目录或文件

本章节结束!