高通发布骁龙X Elite Oryon CPU /GitHub出现一款开源项目,让用户“拥有”更大的GPU内存|魔法半周报

我有魔法✨为你劈开信息大海❗

高效获取AIGC的热门事件,更新AIGC的最新动态,生成相应的魔法简报,节省阅读时间

资讯预览

-

高通发布骁龙X Elite Oryon CPU,性能超越苹果和英特尔,能耗更低

-

GitHub上出现了一款开源项目,帮助用户计算训练或推理大模型所需GPU内存

-

Meta FAIR 和 Samaya AI 利用 AI 开发 SIDE,提高维基百科的可验证性

-

大模型价值对齐:解决AI模型的错误信息和算法歧视等问题的关键方法

-

科大讯飞:大模型进化速度惊人,预言里程碑实现,未来将注重个性化AI助手和商业闭环

魔法简报

高通发布骁龙X Elite Oryon CPU,性能超越苹果和英特尔,能耗更低

高通在2023年骁龙峰会上发布了骁龙X Elite Oryon CPU,这款处理器不仅在性能上超过了苹果和英特尔的最强处理器,而且能耗更低。此外,高通还发布了骁龙8 Gen 3处理器,该处理器不仅在性能上有所提升,而且在生成式AI处理上也有优化,能直接跑得动百亿参数的模型。

此次发布的产品让高通强调了"终端AI"的重要性,为触手可及的现实。高通还推出了跨平台技术Snapdragon Seamless,实现了多个终端间的无缝协作。这次发布的产品对各种终端设备都有渗透,推动了"终端AI"的发展。

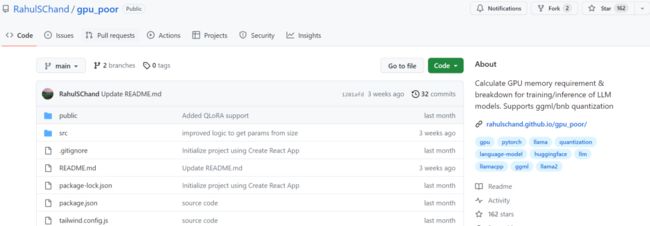

GitHub上出现了一款开源项目,帮助用户计算训练或推理大模型所需GPU内存

近日,GitHub上出现了一个开源项目,可以帮助用户计算在训练或推理大模型(LLM)时所需的GPU内存。该项目不仅可以提供内存占用情况,还能帮助用户评估量化方法、处理的最大上下文长度等问题,以选择适合自己的GPU配置。

用户只需输入一些必要的参数,点击按钮即可得到计算结果。此外,该项目还支持自定义模型和Huggingface ID,用户可以根据需要上传json配置或输入模型大小。作者表示,最终结果可能因用户模型、数据、CUDA版本和量化工具等因素而有所不同,但在实验中,作者尽力确保结果在500MB以内。

总之,对于感兴趣的读者来说,可以亲自体验一下,并提供反馈以便项目的优化和完善。这个开源项目为用户提供了一个简单便捷的方式,帮助他们了解GPU在训练或推理LLM过程中所需的内存情况,从而更好地选择和配置GPU。

Meta FAIR 和 Samaya AI 利用 AI 开发 SIDE,提高维基百科的可验证性

Meta FAIR 和 Samaya AI 团队利用 AI 提高维基百科的可验证性。他们开发了一个名为 SIDE 的基于人工智能的维基百科引文验证器。该系统通过学习维基百科本身,使用英语维基百科声明及其当前引用的语料库,训练了一个检索器组件和一个验证模型。

SIDE 可以识别不太可能支持其主张的维基百科引文,并推荐更好的引文。通过众包实验,研究人员观察到,对于被系统标记为无法验证的引用,人们更喜欢该系统提供的替代方案。

此外,研究人员构建了一个演示来与英语维基百科社区互动,发现 SIDE 推荐的首选引用频率是现有维基百科引用的两倍。结果表明,基于人工智能的系统可以与人类一起使用,以提高维基百科的可验证性。这项研究对于改进维基百科的参考文献质量具有重要意义。

大模型价值对齐:解决AI模型的错误信息和算法歧视等问题的关键方法

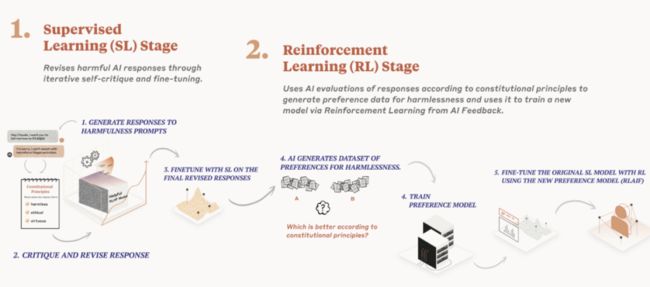

大模型价值对齐是指如何让大模型的能力和行为与人类的价值、真实意图和伦理原则相一致,确保人类与人工智能协作过程中的安全与信任。目前大模型存在的突出问题包括错误信息问题、算法歧视问题、能力涌现的失控风险问题和滥用问题。为了实现价值对齐,可以采取多种方法。

首先是人类反馈的强化学习,通过人类反馈数据对模型进行训练和改进。其次是"宪法性AI"模式,通过从属的AI模型评估主模型的输出是否符合特定的"宪法性"原则,并基于评估结果优化主模型。此外,还可以采取对训练数据的干预、对抗测试、内容过滤工具和推进模型的可解释性和可理解性研究等措施。

然而,AI价值对齐仍面临一些长期解决的问题,如确立统一的人类价值、实现有效监督和解决人类对前沿AI模型的监督困难等。因此,AI领域需要广泛的多学科协作和社会参与,以确保AI系统与人类的价值和意图相一致,实现AI向善的目标。

科大讯飞:大模型进化速度惊人,预言里程碑实现,未来将注重个性化AI助手和商业闭环

科大讯飞是一个有意思的玩家,他们在大模型领域的表现出乎了很多人的预料。讯飞的大模型能力在业内有了明显的改观,并且进化速度非常惊人。讯飞对大模型发展路线的判断也非常准确,他们在年初预言了今年内的关键里程碑,并且如约发布了2.0和3.0版本。讯飞对于大模型的发展非常有自信,他们认为大模型的未来发展方向是更大的模型参数和个性化的AI助手。

讯飞希望将大型模型与各个行业场景深度融合,构建一个完整的生态系统。他们相信通过大模型的应用,可以推动行业的发展。对于商业化问题,讯飞认为明年将会显现出明显的商业效果,但他们也强调需要将全部新增的毛利投入到新的一年中。讯飞将继续关注应用落地和生态繁荣,以及个性化和定制化的需求。

他们认为,未来大模型的商业化路径需要注重应用的价值和商业闭环的实现。最后,讯飞相信在当前阶段,明年至2025年将会是一个良性的状态,收入毛利将会快速增长,覆盖新增投入,推动行业市场份额和影响力的提升。

如果对AIGC感兴趣,请关注我们的微信公众号“我有魔法WYMF”,我们会定期分享AIGC最新资讯和经典论文精读分享,让我们一起交流学习!!